<a href="https://www.ultralytics.com/glossary/model-deployment">モデルデプロイメントのベストプラクティス

はじめに

モデルのデプロイは、コンピュータビジョンプロジェクトにおける重要なステップであり、開発段階から現実世界のアプリケーションへとモデルを移行させるものです。 モデルのデプロイオプションは様々で、クラウドデプロイはスケーラビリティと容易なアクセスを提供し、エッジデプロイはモデルをデータソースに近づけることでレイテンシを削減し、ローカルデプロイはプライバシーと制御を確保します。 適切な戦略の選択は、速度、セキュリティ、スケーラビリティのバランスを取りながら、アプリケーションのニーズによって異なります。

見る: AIモデルを最適化およびデプロイする方法:ベストプラクティス、トラブルシューティング、およびセキュリティに関する考慮事項

モデルのデプロイは、モデルのパフォーマンスの有効性と信頼性に大きな影響を与える可能性があるため、ベストプラクティスに従うことも重要です。このガイドでは、モデルのデプロイをスムーズ、効率的、かつ安全にする方法に焦点を当てます。

モデルのデプロイオプション

多くの場合、モデルがトレーニング、評価、およびテストされた後、クラウド、エッジ、ローカルデバイスなどのさまざまな環境に効果的にデプロイするために、特定の形式に変換する必要があります。

YOLO26を使用すると、デプロイのニーズに応じてモデルをさまざまな形式にエクスポートできます。たとえば、YOLO26をONNXにエクスポートすることは簡単で、フレームワーク間でモデルを転送するのに最適です。より多くの統合オプションを検討し、異なる環境間でのスムーズなデプロイを確実にするには、当社のモデル統合ハブをご覧ください。

デプロイ環境の選択

コンピュータビジョンモデルをどこにデプロイするかを選択するかは、複数の要因によって異なります。環境が異なれば、独自の利点と課題があるため、ニーズに最適なものを選択することが重要です。

クラウド展開

クラウド展開は、迅速なスケールアップと大量のデータ処理を必要とするアプリケーションに最適です。AWS、Google Cloud、Azureなどのプラットフォームを使用すると、トレーニングから展開までモデルを簡単に管理できます。これらのプラットフォームは、AWS SageMaker、Google AI Platform、Azure Machine Learningなどのサービスを提供し、プロセス全体を支援します。

ただし、クラウドの使用は、特にデータ使用量が多い場合、コストがかかる可能性があり、ユーザーがデータセンターから遠い場合は、レイテンシの問題に直面する可能性があります。コストとパフォーマンスを管理するには、リソースの使用を最適化し、データプライバシー規則への準拠を徹底することが重要です。

エッジ展開

エッジ展開は、リアルタイム応答と低遅延を必要とするアプリケーション、特にインターネットアクセスが制限されている場所やアクセスできない場所で有効です。スマートフォンやIoTガジェットのようなエッジデバイスにモデルをデプロイすることで、高速処理が保証され、データがローカルに保持されるため、プライバシーが強化されます。エッジでのデプロイは、クラウドに送信されるデータが削減されるため、帯域幅も節約できます。

ただし、エッジデバイスは処理能力が限られていることが多いため、モデルを最適化する必要があります。TensorFlow LiteやNVIDIA Jetsonのようなツールが役立ちます。利点がある一方で、多数のデバイスの保守と更新は困難な場合があります。

ローカル環境へのデプロイ

ローカル環境へのデプロイは、データのプライバシーが重要な場合や、インターネットアクセスが不安定または利用できない場合に最適です。ローカルサーバーまたはデスクトップでモデルを実行すると、完全に制御でき、データを安全に保つことができます。また、サーバーがユーザーの近くにある場合は、レイテンシーを短縮できます。

ただし、ローカルでのスケーリングは困難な場合があり、メンテナンスに時間がかかる可能性があります。コンテナ化にはDocker、管理にはKubernetesなどのツールを使用すると、ローカルデプロイメントをより効率的に行うことができます。すべてをスムーズに実行するには、定期的な更新とメンテナンスが必要です。

効率的なデプロイメントのためのコンテナ化

コンテナ化は、モデルとそのすべての依存関係をコンテナと呼ばれる標準化されたユニットにパッケージ化する強力なアプローチです。この手法により、異なる環境間で一貫したパフォーマンスが保証され、デプロイメントプロセスが簡素化されます。

モデルデプロイメントにDockerを使用する利点

Dockerが、機械学習のデプロイメントにおけるコンテナ化の業界標準になった理由はいくつかあります。

- 環境の一貫性: Dockerコンテナは、モデルとそのすべての依存関係をカプセル化し、開発、テスト、および本番環境全体で一貫した動作を保証することにより、「私のマシンでは動作する」という問題を解消します。

- 分離:コンテナはアプリケーションを互いに分離し、異なるソフトウェアバージョンまたはライブラリ間の競合を防ぎます。

- 移植性: DockerコンテナはDockerをサポートするあらゆるシステムで実行できるため、変更なしでさまざまなプラットフォームにモデルを簡単にデプロイできます。

- スケーラビリティ: コンテナは需要に基づいて簡単にスケールアップまたはスケールダウンでき、Kubernetesのようなオーケストレーションツールはこのプロセスを自動化できます。

- バージョン管理:Dockerイメージはバージョン管理できるため、変更をtrackし、必要に応じて以前のバージョンにロールバックできます。

YOLO26デプロイのためのDockerの実装

YOLO26モデルをコンテナ化するには、必要なすべての依存関係と構成を指定するDockerfileを作成できます。以下に基本的な例を示します。

FROM ultralytics/ultralytics:latest

WORKDIR /app

# Copy your model and any additional files

COPY ./models/yolo26.pt /app/models/

COPY ./scripts /app/scripts/

# Set up any environment variables

ENV MODEL_PATH=/app/models/yolo26.pt

# Command to run when the container starts

CMD ["python", "/app/scripts/predict.py"]

このアプローチにより、モデルのデプロイがさまざまな環境で再現可能かつ一貫性のあるものとなり、デプロイプロセスにつきものの「自分のマシンでは動く」という問題を大幅に軽減できます。

モデルの最適化手法

コンピュータービジョンモデルを最適化すると、特にエッジデバイスのようなリソースが限られた環境にデプロイする場合に、効率的に実行できるようになります。モデルを最適化するための主要な手法をいくつかご紹介します。

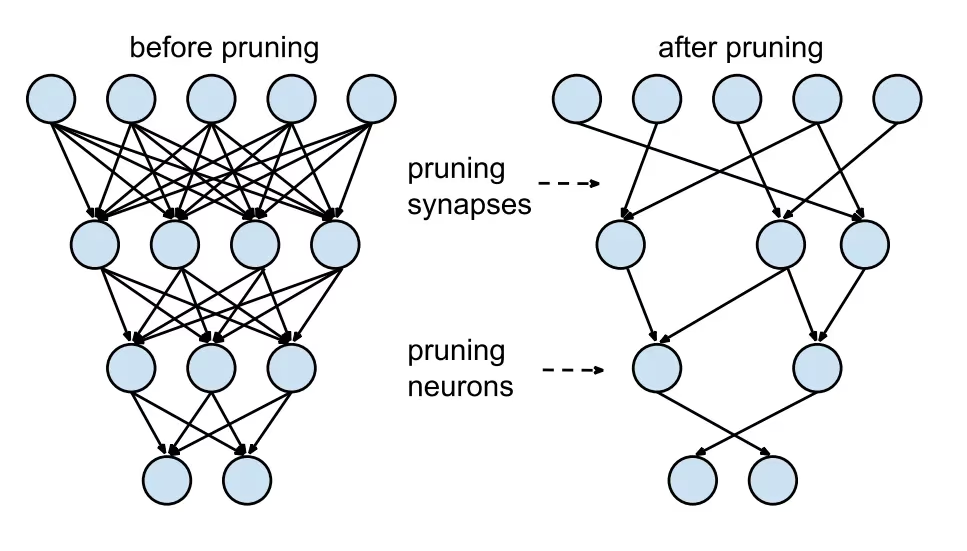

モデルの枝刈り

Pruning(枝刈り)は、最終的な出力への貢献が少ない重みを削除することで、モデルのサイズを縮小します。精度に大きな影響を与えることなく、モデルをより小さく、より高速にします。Pruningでは、不要なパラメータを特定して排除し、計算能力をあまり必要としない、より軽量なモデルを実現します。これは、リソースが限られたデバイスにモデルをデプロイする場合に特に役立ちます。

モデルの量子化

量子化は、モデルの重みとアクティベーションを高い精度(32 ビット浮動小数点など)から低い精度(8 ビット整数など)に変換します。モデルサイズを縮小することで、推論が高速化されます。量子化対応トレーニング(QAT)は、量子化を考慮してモデルをトレーニングする方法であり、トレーニング後の量子化よりも精度を高く維持できます。トレーニング段階で量子化を処理することにより、モデルはより低い精度に適応することを学習し、計算需要を削減しながらパフォーマンスを維持します。

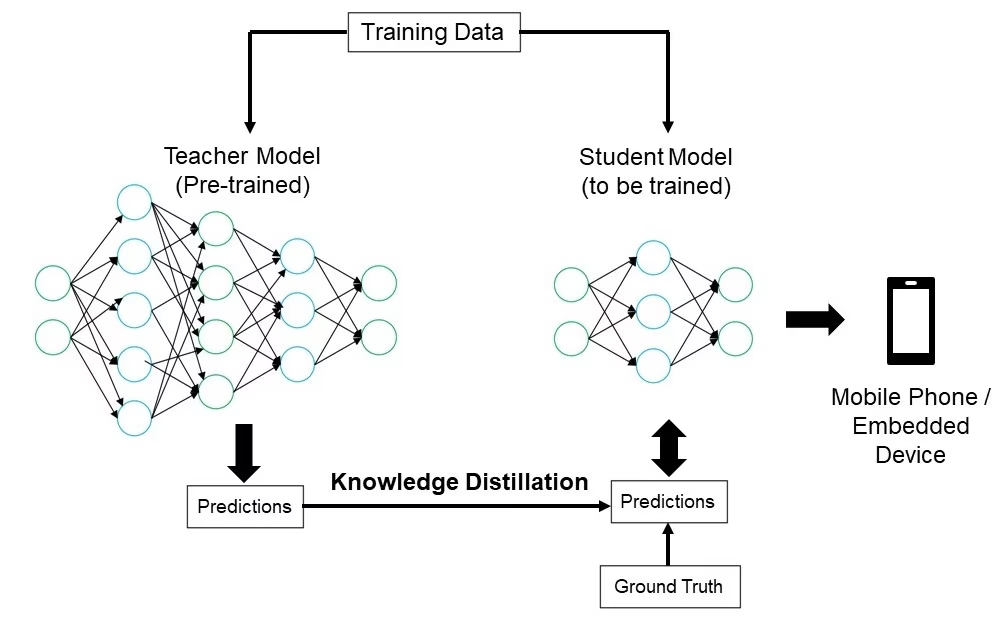

知識蒸留

知識蒸留とは、より大きく複雑なモデル(教師)の出力を模倣するように、より小さくシンプルなモデル(生徒)を訓練することです。生徒モデルは教師の予測を近似することを学習し、教師の精度の多くを保持するコンパクトなモデルになります。この技術は、リソースが限られたエッジデバイスへの展開に適した効率的なモデルを作成するのに役立ちます。

デプロイメントに関する問題のトラブルシューティング

コンピュータービジョンモデルのデプロイ中に課題に直面する可能性がありますが、一般的な問題と解決策を理解することで、プロセスを円滑に進めることができます。デプロイの問題を解決するための一般的なトラブルシューティングのヒントとベストプラクティスを以下に示します。

デプロイ後、モデルの精度が低下する

モデルのデプロイ後に精度が低下するのは、イライラさせられることがあります。この問題は、さまざまな要因に起因する可能性があります。問題を特定して解決するための手順を以下に示します。

- データの整合性の確認: モデルがデプロイ後に処理するデータが、トレーニングに使用したデータと一貫性があることを確認してください。データ分布、品質、または形式の違いは、パフォーマンスに大きな影響を与える可能性があります。

- 前処理手順を検証する: トレーニング中に適用されたすべての前処理手順が、デプロイメント中にも一貫して適用されることを確認します。これには、画像のリサイズ、ピクセル値の正規化、およびその他のデータ変換が含まれます。

- モデルの環境を評価する: デプロイメント中に使用されるハードウェアおよびソフトウェア構成が、トレーニング中に使用されたものと一致していることを確認します。ライブラリ、バージョン、およびハードウェア機能の違いにより、不一致が生じる可能性があります。

- モデル推論の監視: 推論パイプラインのさまざまな段階で入力と出力をログに記録し、異常をdetectします。データ破損やモデル出力の不適切な処理などの問題を特定するのに役立ちます。

- モデルのエクスポートと変換の確認: モデルを再度エクスポートし、変換プロセスがモデルの重みとアーキテクチャの整合性を維持していることを確認します。

- Test with a Controlled Dataset: 制御されたデータセットを使用してテスト環境にモデルをデプロイし、トレーニングフェーズの結果と比較します。問題がデプロイ環境にあるのか、データにあるのかを特定できます。

YOLO26をデプロイする際、いくつかの要因がモデルの精度に影響を与える可能性があります。TensorRTのような形式にモデルを変換すると、重み量子化やレイヤー融合などの最適化が行われ、わずかな精度損失が発生する可能性があります。FP32(単精度)の代わりにFP16(半精度)を使用すると、推論は高速化されますが、数値精度エラーが発生する可能性があります。また、Jetson Nanoのようなハードウェアの制約、例えばCUDAコア数の減少やメモリ帯域幅の低下は、パフォーマンスに影響を与える可能性があります。

推論に予想以上の時間がかかっています

機械学習モデルをデプロイする際は、効率的に実行されることが重要です。推論に予想以上に時間がかかる場合は、ユーザーエクスペリエンスとアプリケーションの有効性に影響を与える可能性があります。問題を特定して解決するための手順を以下に示します。

- ウォームアップ実行を実装する: 初期の実行には、セットアップのオーバーヘッドが含まれることが多く、レイテンシの測定が歪む可能性があります。レイテンシを測定する前に、数回のウォームアップ推論を実行してください。これらの初期実行を除外することで、モデルのパフォーマンスをより正確に測定できます。

- 推論エンジンの最適化: 推論エンジンが特定のGPUアーキテクチャに合わせて完全に最適化されていることを再確認してください。ハードウェアに合わせて調整された最新のドライバーとソフトウェアバージョンを使用して、最大限のパフォーマンスと互換性を確保してください。

- 非同期処理を使用する: 非同期処理は、ワークロードをより効率的に管理するのに役立ちます。非同期処理技術を使用して、複数の推論を同時に処理し、負荷を分散して待ち時間を短縮します。

- 推論パイプラインのプロファイリング: 推論パイプラインのボトルネックを特定することで、遅延の原因を特定できます。プロファイリングツールを使用して推論プロセスの各ステップを分析し、非効率なレイヤーやデータ転送の問題など、重大な遅延を引き起こす段階を特定して対処します。

- 適切な精度を使用する: 必要以上に高い精度を使用すると、推論時間が遅くなる可能性があります。FP32(全精度)の代わりに、FP16(半精度)などの低い精度を使用することを試してください。FP16は推論時間を短縮できますが、モデルの精度に影響を与える可能性があることにも注意してください。

YOLO26をデプロイする際にこの問題に直面している場合、YOLO26はメモリ容量の少ないデバイス向けのYOLO26n(nano)や、より強力なGPU向けのYOLO26x(extra-large)など、さまざまなモデルサイズを提供していることを考慮してください。ハードウェアに適したモデルバリアントを選択することで、メモリ使用量と処理時間のバランスを取ることができます。

入力画像のサイズは、メモリ使用量と処理時間に直接影響することにも留意してください。解像度を下げるとメモリ使用量が減り、推論が高速化されますが、解像度を上げると精度が向上しますが、より多くのメモリと処理能力が必要になります。

モデル展開におけるセキュリティに関する考慮事項

デプロイメントのもう1つの重要な側面はセキュリティです。機密データと知的財産を保護するためには、デプロイされたモデルのセキュリティが非常に重要です。安全なモデルのデプロイメントに関連して、従うことができるいくつかのベストプラクティスを以下に示します。

安全なデータ伝送

クライアントとサーバー間で送信されるデータの安全性を確保することは、不正な当事者による傍受やアクセスを防ぐために非常に重要です。TLS(Transport Layer Security)のような暗号化プロトコルを使用して、送信中のデータを暗号化できます。誰かがデータを傍受したとしても、それを読むことはできません。また、ソースから宛先までデータを保護するエンドツーエンドの暗号化を使用することもできます。これにより、途中の誰もデータにアクセスできなくなります。

アクセス制御

不正使用を防ぐため、モデルとそのデータにアクセスできるユーザーを制御することが不可欠です。モデルにアクセスしようとするユーザーまたはシステムのIDを検証するために強力な認証方法を使用し、多要素認証 (MFA) で追加のセキュリティを検討してください。ロールベースのアクセス制御 (RBAC) を設定して、ユーザーロールに基づいてアクセス許可を割り当て、必要なもののみにアクセスできるようにします。モデルとそのデータへのすべてのアクセスと変更をtrackするために詳細な監査ログを保持し、不審なアクティビティを発見するためにこれらのログを定期的にレビューしてください。

モデルの難読化

モデルのリバースエンジニアリングや誤用から保護するには、モデルの難読化を行うことができます。これには、ニューラルネットワークの重みやバイアスなどのモデルパラメータを暗号化して、許可されていない個人がモデルを理解または変更することを困難にすることが含まれます。レイヤーやパラメータの名前を変更したり、ダミーレイヤーを追加したりして、モデルのアーキテクチャを難読化することもでき、攻撃者がリバースエンジニアリングすることをより困難にします。セキュアエンクレーブや信頼できる実行環境(TEE)などのセキュアな環境でモデルを提供することも、推論中に追加の保護レイヤーを提供できます。

仲間とアイデアを共有する

コンピュータビジョンの愛好家のコミュニティに参加することは、問題を解決し、より速く学習するのに役立ちます。つながり、助けを得て、アイデアを共有するためのいくつかの方法を以下に示します。

コミュニティリソース

- GitHub Issues: YOLO26 GitHubリポジトリを探索し、「Issues」タブを使用して質問したり、バグを報告したり、新機能を提案したりできます。コミュニティとメンテナーは非常に活発で、いつでもサポートする準備ができています。

- Ultralytics Discordサーバー: Ultralytics Discordサーバーに参加して、他のユーザーや開発者とチャットしたり、サポートを受けたり、あなたの経験を共有しましょう。

公式ドキュメント

- Ultralytics YOLO26 ドキュメント: 様々なコンピュータービジョンプロジェクトに関する詳細なガイドと役立つヒントについては、公式YOLO26ドキュメントをご覧ください。

これらのリソースを使用すると、課題を解決し、コンピュータービジョンコミュニティの最新のトレンドとプラクティスを常に把握できます。

結論と次のステップ

コンピュータービジョンモデルをデプロイする際に従うべきいくつかのベストプラクティスについて説明しました。データを保護し、アクセスを制御し、モデルの詳細を難読化することで、機密情報を保護しながら、モデルをスムーズに実行し続けることができます。また、ウォームアップ実行、エンジンの最適化、非同期処理、パイプラインのプロファイリング、適切な精度を選択するなどの方策を使用して、精度低下や推論の遅延などの一般的な問題に対処する方法についても説明しました。

モデルのデプロイ後、次のステップはアプリケーションの監視、保守、およびドキュメント化です。定期的な監視は問題の迅速な発見と修正に役立ち、保守はモデルを最新の状態に保ち、機能させ、適切なドキュメントはすべての変更と更新を追跡します。これらのステップは、コンピュータービジョンプロジェクトの目標を達成するのに役立ちます。

よくある質問

Ultralytics YOLO26を使用して機械学習モデルをデプロイするためのベストプラクティスは何ですか?

機械学習モデル、特にUltralytics YOLO26を使用したモデルのデプロイには、効率性と信頼性を確保するためのいくつかのベストプラクティスがあります。まず、クラウド、エッジ、ローカルなど、ニーズに合ったデプロイ環境を選択します。リソースが制約された環境での効率的なデプロイのために、プルーニング、量子化、知識蒸留などの手法を用いてモデルを最適化します。異なる環境間での一貫性を確保するために、Dockerによるコンテナ化の使用を検討してください。最後に、パフォーマンスを維持するために、データの整合性と前処理ステップがトレーニングフェーズと一致していることを確認します。より詳細なガイドラインについては、モデルのデプロイオプションも参照できます。

Ultralytics YOLO26モデルで一般的なデプロイの問題をトラブルシューティングするにはどうすればよいですか?

デプロイメントに関する問題のトラブルシューティングは、いくつかの重要なステップに分解できます。モデルの精度がデプロイ後に低下する場合は、データの一貫性を確認し、前処理の手順を検証し、トレーニング中に使用したハードウェア/ソフトウェア環境と一致していることを確認してください。推論時間が遅い場合は、ウォームアップ実行を実行し、推論エンジンを最適化し、非同期処理を使用し、推論パイプラインをプロファイルします。これらのベストプラクティスの詳細なガイドについては、デプロイメントに関する問題のトラブルシューティングを参照してください。

Ultralytics YOLO26の最適化は、エッジデバイスでのモデルパフォーマンスをどのように向上させますか?

エッジデバイス向けにUltralytics YOLO26モデルを最適化するには、モデルサイズを削減するためのプルーニング、重みを低精度に変換するための量子化、より大きなモデルを模倣する小さなモデルをトレーニングするための知識蒸留などの手法を使用します。これらの手法により、計算能力が限られたデバイスでもモデルが効率的に動作します。TensorFlow LiteやNVIDIA Jetsonのようなツールは、これらの最適化に特に役立ちます。これらの手法の詳細については、モデル最適化のセクションでご確認ください。

Ultralytics YOLO26を使用して機械学習モデルをデプロイする際のセキュリティ上の考慮事項は何ですか?

機械学習モデルの展開において、セキュリティは最重要事項です。TLSなどの暗号化プロトコルを使用して、安全なデータ伝送を確保してください。強力な認証やロールベースのアクセス制御(RBAC)など、堅牢なアクセス制御を実装してください。モデルのパラメータを暗号化したり、信頼できる実行環境(TEE)のような安全な環境でモデルを提供したりするなどのモデル難読化技術は、追加の保護を提供します。詳細なプラクティスについては、セキュリティに関する考慮事項を参照してください。

Ultralytics YOLO26モデルに最適なデプロイ環境を選択するにはどうすればよいですか?

Ultralytics YOLO26モデルに最適なデプロイ環境の選択は、アプリケーションの特定のニーズによって異なります。クラウドデプロイはスケーラビリティとアクセスの容易さを提供し、大量のデータを扱うアプリケーションに最適です。エッジデプロイは、TensorFlow Liteのようなツールを使用して、リアルタイム応答を必要とする低レイテンシのアプリケーションに最適です。ローカルデプロイは、厳格なデータプライバシーと制御が必要なシナリオに適しています。各環境の包括的な概要については、デプロイ環境の選択に関するセクションをご確認ください。