クイックスタートガイド: NVIDIA DGX SparkとUltralytics YOLO26

この包括的なガイドでは、NVIDIAのコンパクトなデスクトップAIスーパーコンピューターであるNVIDIA DGX SparkにUltralytics YOLO26をデプロイするための詳細な手順を説明します。さらに、この強力なシステム上でのYOLO26の能力を示すパフォーマンスベンチマークも紹介しています。

注

このガイドは、UbuntuベースのDGX OSを実行するNVIDIA DGX Spark Founders Editionでテストされています。最新のDGX OSリリースでも動作すると予想されます。

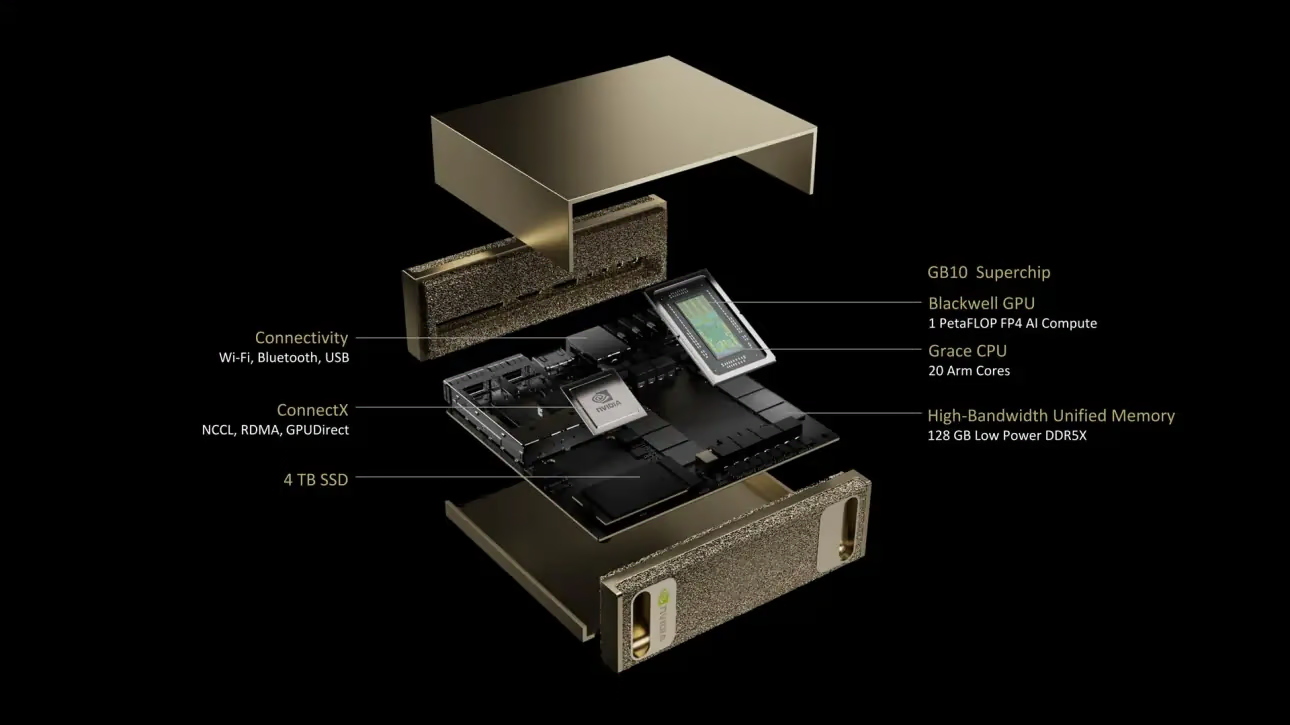

NVIDIA DGX Sparkとは?

NVIDIA DGX Sparkは、NVIDIA GB10 Grace Blackwell Superchipを搭載したコンパクトなデスクトップAIスーパーコンピューターです。FP4精度で最大1 petaFLOPのAIコンピューティング性能を提供し、デスクトップフォームファクターで強力なAI機能を必要とする開発者、研究者、データサイエンティストにとって理想的です。

主な仕様

| 仕様 | 詳細 |

|---|---|

| AIパフォーマンス | 最大1 PFLOP (FP4) |

| GPU | 第5世代Tensorコア、第4世代RTコアを搭載したNVIDIA Blackwellアーキテクチャ |

| CPU | 20コアArmプロセッサ(10 Cortex-X925 + 10 Cortex-A725) |

| メモリ | 128 GB LPDDR5x ユニファイドシステムメモリ、256ビットインターフェース、4266 MHz、273 GB/s帯域幅 |

| ストレージ | 自己暗号化機能付き1 TBまたは4 TB NVMe M.2 |

| ネットワーク | 1x RJ-45 (10 GbE)、ConnectX-7 Smart NIC、Wi-Fi 7、Bluetooth 5.4 |

| 接続性 | 4x USB Type-C、1x HDMI 2.1a、HDMIマルチチャンネルオーディオ |

| ビデオ処理 | 1x NVENC、1x NVDEC |

DGX OS

NVIDIA DGX OSは、DGXシステム上でAI、機械学習、および分析アプリケーションを実行するための、安定した、テスト済みでサポートされているオペレーティングシステム基盤を提供するカスタマイズされたLinuxディストリビューションです。以下が含まれます:

- AIワークロード向けに最適化された堅牢なLinux基盤

- NVIDIAハードウェア向けに事前設定されたドライバーとシステム設定

- セキュリティアップデートとシステムメンテナンス機能

- 広範なNVIDIAソフトウェアエコシステムとの互換性

DGX OSは定期的なリリーススケジュールに従い、通常、年に2回(2月と8月頃)アップデートが提供され、メジャーリリース間には追加のセキュリティパッチが提供されます。

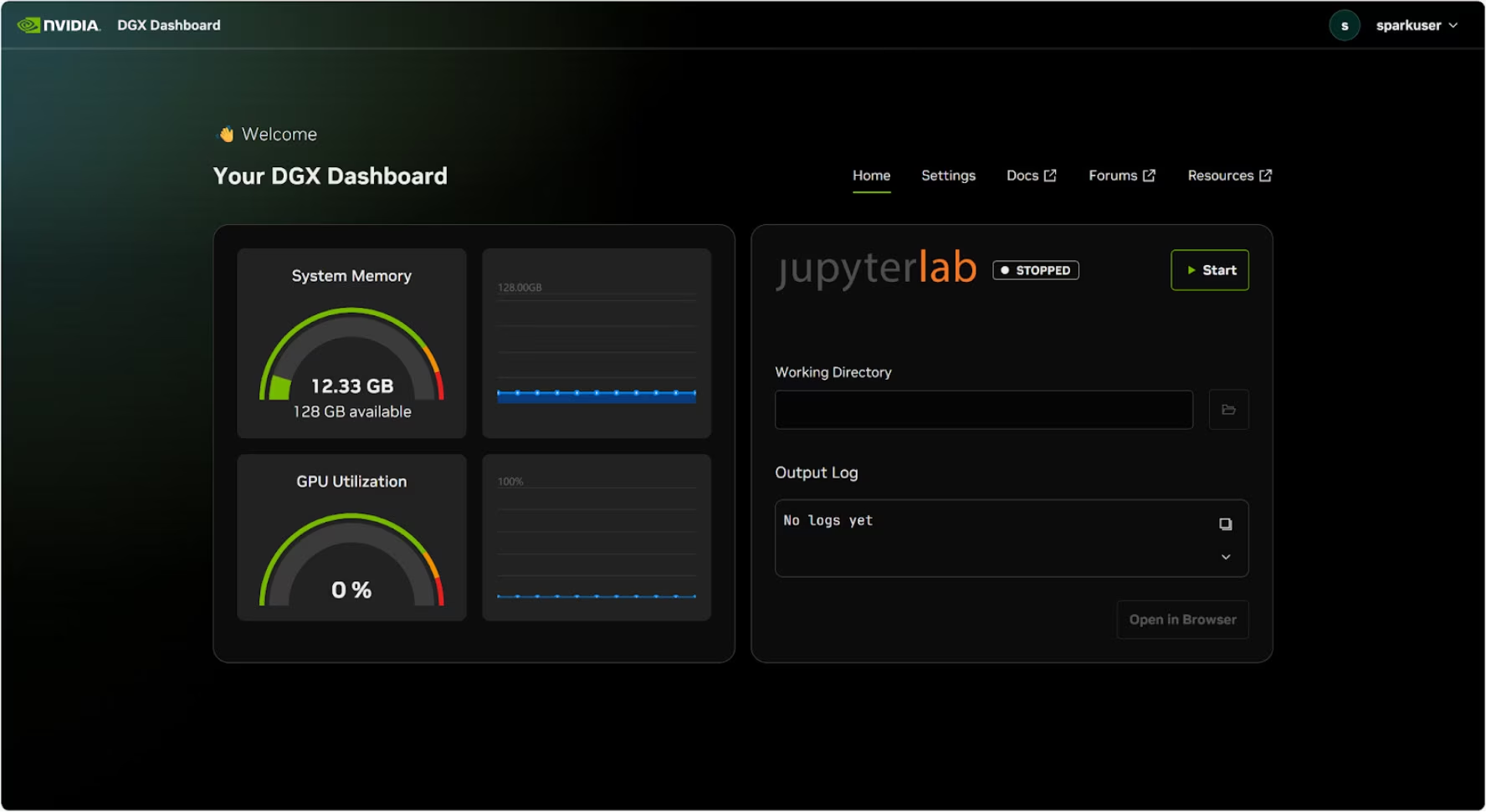

DGXダッシュボード

DGX Sparkには、以下の機能を提供する組み込みのDGX Dashboardが付属しています:

- リアルタイムシステム監視:システムの現在の運用メトリクスの概要

- システムアップデート:ダッシュボードから直接アップデートを適用する機能

- システム設定:デバイス名やその他の設定を変更

- 統合JupyterLab:開発用のローカルJupyter Notebookにアクセス

ダッシュボードへのアクセス

Ubuntuデスクトップの左下隅にある「Show Apps」ボタンをクリックし、「DGX Dashboard」を選択してブラウザで開きます。

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

NVIDIA Syncに接続後、「DGX Dashboard」ボタンをクリックしてダッシュボードを開きます。 http://localhost:11000.

統合JupyterLab

ダッシュボードには統合されたJupyterLabインスタンスが含まれており、起動時に仮想環境を自動的に作成し、推奨パッケージをインストールします。各ユーザーアカウントには、JupyterLabアクセス用の専用ポートが割り当てられます。

Dockerを使ったクイックスタート

NVIDIA DGX SparkでUltralytics YOLO26を始める最も速い方法は、ビルド済みのDockerイメージを使用することです。Jetson AGX Thor (JetPack 7.0)をサポートするのと同じDockerイメージが、DGX OSを搭載したDGX Sparkで動作します。

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

これが完了したら、NVIDIA DGX SparkでのTensorRTの使用セクションにスキップしてください。

ネイティブインストールから開始

Dockerを使用しないネイティブインストールの場合、以下の手順に従ってください。

Ultralyticsパッケージのインストール

ここでは、オプションの依存関係と共にDGX SparkにUltralyticsパッケージをインストールし、PyTorchモデルを他の異なる形式にエクスポートできるようにします。主にNVIDIA TensorRTエクスポートに焦点を当てます。これは、TensorRTを使用することでDGX Sparkから最大限のパフォーマンスを引き出すことができるためです。

パッケージリストの更新、pipのインストール、および最新バージョンへのアップグレード

sudo apt update sudo apt install python3-pip -y pip install -U pipインストール

ultralyticsオプションの依存関係を含む pip パッケージpip install ultralytics[export]デバイスを再起動

sudo reboot

PyTorchとTorchvisionのインストール

上記のUltralyticsのインストールでは、torchとTorchvisionがインストールされます。しかし、pip経由でインストールされたこれらのパッケージは、CUDA 13を搭載したDGX SparkのARM64アーキテクチャに完全に最適化されていない可能性があります。そのため、CUDA 13互換バージョンをインストールすることをお勧めします。

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

情報

NVIDIA DGX SparkでPyTorch 2.9.1を実行する際、以下の問題に遭遇する可能性があります UserWarning CUDAを初期化する際(例:実行中 yolo checks, yolo predictなど):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

この警告は無視しても問題ありません。この問題を恒久的に解決するため、PyTorch PR #164590 で修正が提出されており、PyTorch 2.10 リリースに含まれる予定です。

インストール onnxruntime-gpu

The onnxruntime-gpu PyPIでホストされているパッケージには aarch64 ARM64システム用のバイナリです。そのため、このパッケージを手動でインストールする必要があります。このパッケージは一部のエクスポートに必要です。

ここでは、ダウンロードしてインストールします onnxruntime-gpu 1.24.0 with Python3.12 サポート。

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

NVIDIA DGX SparkでTensorRTを使用する

Ultralyticsがサポートするすべてのモデルエクスポート形式の中で、TensorRTはNVIDIA DGX Spark上で最高の推論パフォーマンスを提供するため、デプロイメントにはTensorRTを強く推奨します。セットアップ手順と高度な使用法については、専用のTensorRT統合ガイドを参照してください。

モデルをTensorRTに変換して推論を実行

PyTorch形式のYOLO26nモデルは、エクスポートされたモデルで推論を実行するためにTensorRTに変換されます。

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

注

モデルを異なる形式でエクスポートする際の追加引数にアクセスするには、エクスポートページをご覧ください。

NVIDIA DGX Spark YOLO11ベンチマーク

Ultralyticsチームは、YOLO11のベンチマークを複数のモデル形式で実行し、速度と精度を測定しました。対象形式はPyTorch、TorchScript、ONNX、OpenVINO、TensorRT、TF SavedModel、TF GraphDef、TF Lite、MNN、NCNN、ExecuTorchです。ベンチマークはNVIDIA DGX Spark上で、FP32 精度、デフォルトの入力画像サイズ640で実行されました。

詳細な比較表

以下の表は、5つの異なるモデル(YOLO11n、YOLO11s、YOLO11m、YOLO11l、YOLO11x)について、複数の形式でのベンチマーク結果を示しており、各組み合わせにおけるステータス、サイズ、mAP50-95(B)メトリック、および推論時間を提供します。

パフォーマンス

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT(FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT(FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT(INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT(FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT(FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT(INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT(FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT(FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT(INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT(FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT(FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT(INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT(FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT(FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT(INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Ultralytics 8.3.249でベンチマークを実施

結果の再現

上記Ultralyticsのベンチマークをすべてのエクスポート形式で再現するには、次のコードを実行します:

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

なお、ベンチマーク結果は、システムの正確なハードウェアおよびソフトウェア構成、ならびにベンチマーク実行時のシステムの現在のワークロードによって異なる場合があります。最も信頼性の高い結果を得るには、多数の画像を含むデータセットを使用してください (例: )。 data='coco.yaml' (5000の検証画像)。

NVIDIA DGX Sparkのベストプラクティス

NVIDIA DGX Sparkを使用する際には、YOLO26を最大限のパフォーマンスで実行するために、いくつかのベストプラクティスに従う必要があります。

システムパフォーマンスの監視

NVIDIAの監視ツールを使用してGPUとCPUの使用率をtrackします:

nvidia-smiメモリ使用量の最適化

128GBのユニファイドメモリを搭載したDGX Sparkは、大規模なバッチサイズとモデルを処理できます。スループット向上のため、バッチサイズの増加を検討してください:

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)FP16またはINT8でTensorRTを使用

最高のパフォーマンスを得るには、FP16またはINT8精度でモデルをエクスポートします:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

システムアップデート(Founders Edition)

DGX Spark Founders Editionを最新の状態に保つことは、パフォーマンスとセキュリティにとって非常に重要です。NVIDIAは、システムOS、ドライバー、およびファームウェアを更新するための2つの主要な方法を提供しています。

DGX Dashboardの使用(推奨)

DGX Dashboardは、互換性を確保しながらシステムアップデートを実行するための推奨される方法です。これにより、以下のことが可能になります:

- 利用可能なシステムアップデートの表示

- セキュリティパッチとシステムアップデートのインストール

- NVIDIAドライバーとファームウェアのアップデートの管理

手動システムアップデート

上級ユーザーの場合、ターミナル経由で手動でアップデートを実行できます:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

警告

アップデートを実行する前に、システムが安定した電源に接続されており、重要なデータがバックアップされていることを確認してください。

次のステップ

さらなる学習とサポートについては、Ultralytics YOLO26 ドキュメントを参照してください。

よくある質問

NVIDIA DGX SparkにUltralytics YOLO26をどのようにデプロイしますか?

NVIDIA DGX SparkへのUltralytics YOLO26のデプロイは簡単です。迅速なセットアップのためにビルド済みのDockerイメージを使用するか、必要なパッケージを手動でインストールすることができます。各アプローチの詳細な手順は、Quick Start with DockerおよびStart with Native Installationのセクションで確認できます。

NVIDIA DGX Spark上でYOLO26からどのようなパフォーマンスを期待できますか?

GB10 Grace Blackwell Superchipのおかげで、YOLO26モデルはDGX Spark上で優れたパフォーマンスを発揮します。TensorRT形式は最高の推論パフォーマンスを提供します。異なるモデルサイズと形式における具体的なベンチマーク結果については、Detailed Comparison Tableセクションをご確認ください。

DGX Spark上でYOLO26にTensorRTを使用すべき理由は何ですか?

TensorRTは、その最適なパフォーマンスにより、DGX Spark上にYOLO26モデルをデプロイする上で強く推奨されます。Blackwell GPUの機能を活用して推論を高速化し、最大の効率と速度を保証します。詳細については、Use TensorRT on NVIDIA DGX Sparkセクションをご覧ください。

YOLO26に関して、DGX SparkはJetsonデバイスと比較してどうですか?

DGX Sparkは、Jetson AGX Thorの2070 TFLOPSおよび128GBメモリと比較して、最大1 PFLOPのAI性能と128GBのユニファイドメモリを備え、Jetsonデバイスよりも大幅に高い計算能力を提供します。DGX SparkはデスクトップAIスーパーコンピューターとして設計されており、Jetsonデバイスはエッジデプロイメント向けに最適化された組み込みシステムです。

DGX SparkとJetson AGX Thorで同じDockerイメージを使用できますか?

はい!その ultralytics/ultralytics:latest-nvidia-arm64 Dockerイメージは、NVIDIA DGX Spark (DGX OS搭載) と Jetson AGX Thor (JetPack 7.0搭載) の両方をサポートしています。これは、どちらもCUDA 13と類似のソフトウェアスタックを備えたARM64アーキテクチャを使用しているためです。