Краткое руководство по началу работы: NVIDIA DGX Spark с Ultralytics YOLO26

Это исчерпывающее руководство содержит подробное описание развертывания Ultralytics YOLO26 на NVIDIA DGX Spark, компактном настольном суперкомпьютере с ИИ от NVIDIA. Кроме того, в нем представлены результаты сравнительных тестов производительности, демонстрирующие возможности YOLO26 на этой мощной системе.

Примечание

Это руководство было протестировано с NVIDIA DGX Spark Founders Edition, работающим под управлением DGX OS на базе Ubuntu. Ожидается, что оно будет работать с последними выпусками DGX OS.

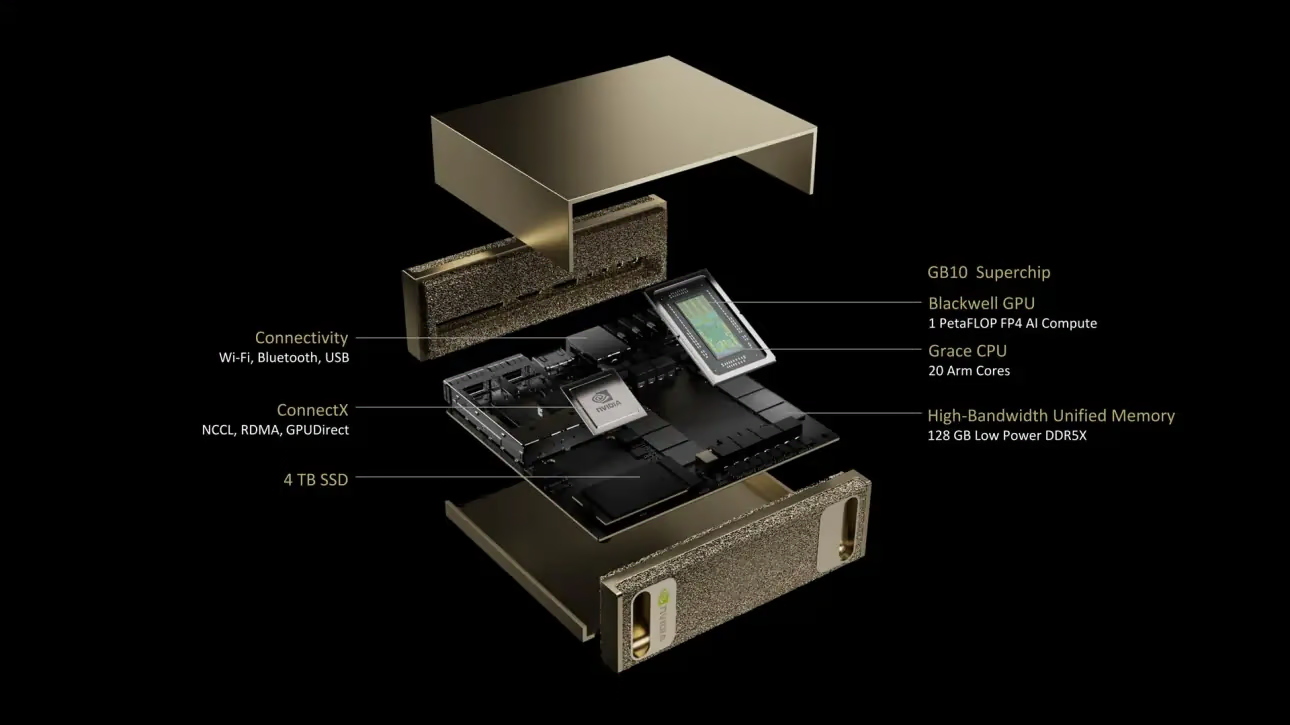

Что такое NVIDIA DGX Spark?

NVIDIA DGX Spark — это компактный настольный суперкомпьютер для ИИ, работающий на базе суперчипа NVIDIA GB10 Grace Blackwell. Он обеспечивает до 1 петафлопса вычислительной производительности ИИ с точностью FP4, что делает его идеальным для разработчиков, исследователей и специалистов по данным, которым требуются мощные возможности ИИ в настольном форм-факторе.

Ключевые характеристики

| Характеристики | Подробности |

|---|---|

| Производительность ИИ | До 1 PFLOP (FP4) |

| GPU | Архитектура NVIDIA Blackwell с тензорными ядрами 5-го поколения, ядрами RT 4-го поколения |

| CPU | 20-ядерный процессор Arm (10 Cortex-X925 + 10 Cortex-A725) |

| Память | 128 ГБ унифицированной системной памяти LPDDR5x, 256-битный интерфейс, 4266 МГц, пропускная способность 273 ГБ/с |

| Хранилище | 1 ТБ или 4 ТБ NVMe M.2 с самошифрованием |

| Сетевые возможности | 1x RJ-45 (10 GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| Интерфейсы | 4x USB Type-C, 1x HDMI 2.1a, многоканальный звук HDMI |

| Обработка видео | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS — это специализированный дистрибутив Linux, который обеспечивает стабильную, протестированную и поддерживаемую основу операционной системы для запуска приложений ИИ, машинного обучения и аналитики на системах DGX. Он включает:

- Надежная основа Linux, оптимизированная для рабочих нагрузок ИИ

- Предварительно настроенные драйверы и системные параметры для оборудования NVIDIA

- Обновления безопасности и возможности обслуживания системы

- Совместимость с более широкой программной экосистемой NVIDIA

DGX OS придерживается регулярного графика выпуска обновлений, которые обычно предоставляются два раза в год (примерно в феврале и августе), с дополнительными исправлениями безопасности между основными выпусками.

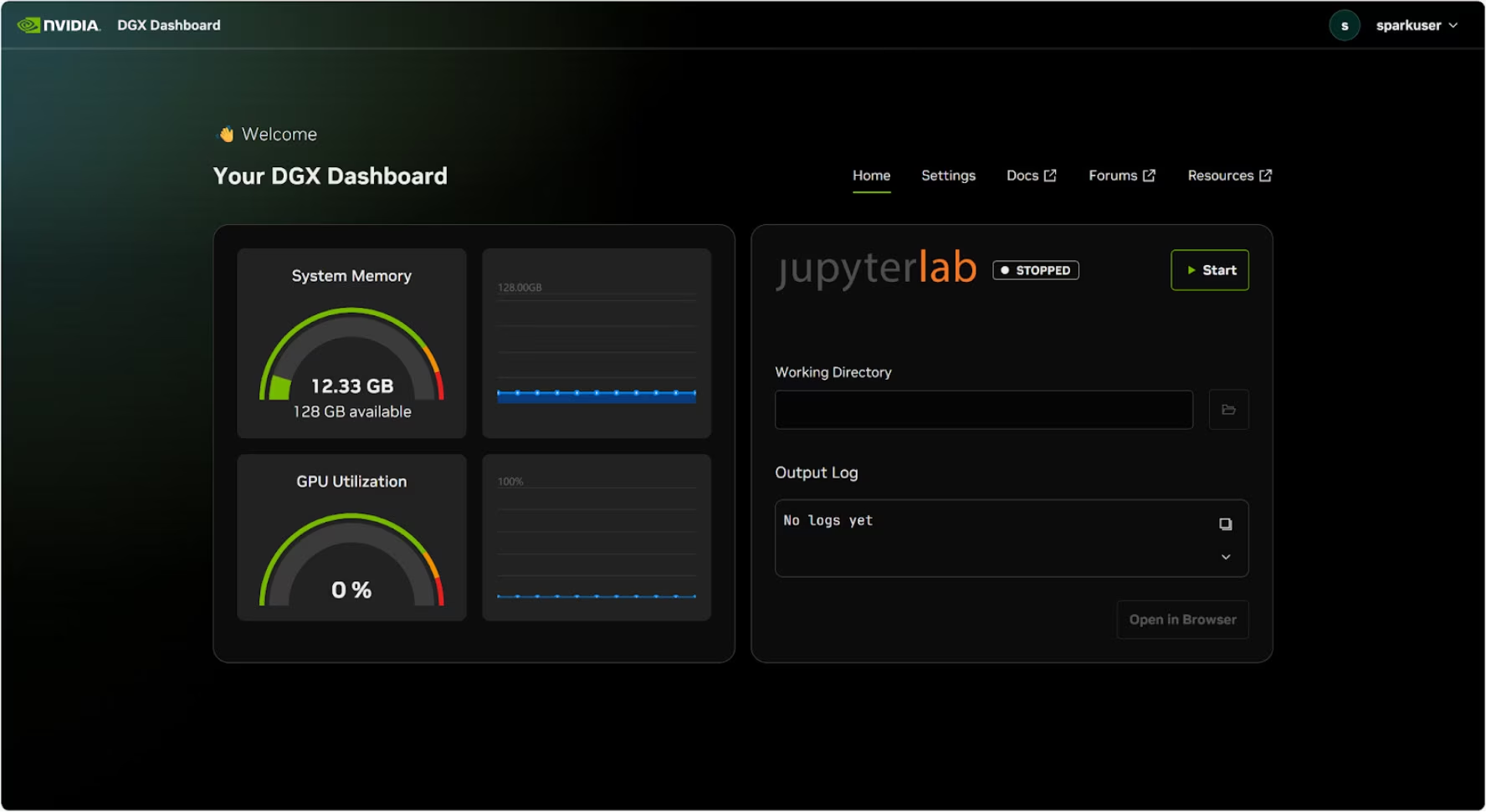

Панель управления DGX

DGX Spark поставляется со встроенной панелью управления DGX, которая предоставляет:

- Мониторинг системы в реальном времени: Обзор текущих операционных метрик системы

- Обновления системы: Возможность применять обновления непосредственно из панели управления

- Настройки системы: Изменение имени устройства и других конфигураций

- Интегрированный JupyterLab: Доступ к локальным Jupyter Notebooks для разработки

Доступ к панели управления

Нажмите кнопку «Показать приложения» в левом нижнем углу рабочего стола Ubuntu, затем выберите «DGX Dashboard», чтобы открыть его в браузере.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

После подключения через NVIDIA Sync нажмите кнопку «DGX Dashboard», чтобы открыть панель управления по адресу http://localhost:11000.

Интегрированный JupyterLab

Панель управления включает интегрированный экземпляр JupyterLab, который автоматически создает виртуальное окружение и устанавливает рекомендуемые пакеты при запуске. Каждой учетной записи пользователя назначается выделенный порт для доступа к JupyterLab.

Быстрый старт с Docker

Самый быстрый способ начать работу с Ultralytics YOLO26 на NVIDIA DGX Spark — это запуск с использованием предварительно собранных образов Docker. Тот же образ Docker, который поддерживает Jetson AGX Thor (JetPack 7.0), работает на DGX Spark с DGX OS.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

После этого перейдите к разделу «Использование TensorRT на NVIDIA DGX Spark».

Начало с собственной установки

Для нативной установки без Docker выполните следующие шаги.

Установка пакета Ultralytics

Здесь мы установим пакет Ultralytics на DGX Spark с опциональными зависимостями, чтобы мы могли экспортировать модели PyTorch в другие форматы. Мы сосредоточимся в основном на экспорте в NVIDIA TensorRT, поскольку TensorRT обеспечит максимальную производительность DGX Spark.

Обновите список пакетов, установите pip и обновите до последней версии

sudo apt update sudo apt install python3-pip -y pip install -U pipУстановите

ultralyticsпакет pip с необязательными зависимостямиpip install ultralytics[export]Перезагрузите устройство

sudo reboot

Установка PyTorch и Torchvision

Вышеуказанная установка Ultralytics установит Torch и Torchvision. Однако эти пакеты, установленные через pip, могут быть не полностью оптимизированы для архитектуры ARM64 DGX Spark с CUDA 13. Поэтому мы рекомендуем устанавливать версии, совместимые с CUDA 13:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Информация

При запуске PyTorch 2.9.1 на NVIDIA DGX Spark вы можете столкнуться со следующим UserWarning при инициализации CUDA (например, при запуске yolo checks, yolo predict, и т.д.):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

Это предупреждение можно безопасно игнорировать. Для постоянного решения этой проблемы было отправлено исправление в PyTorch PR #164590, которое будет включено в выпуск PyTorch 2.10.

Установите onnxruntime-gpu

Параметр onnxruntime-gpu пакет, размещенный в PyPI, не имеет aarch64 бинарные файлы для систем ARM64. Поэтому нам нужно вручную установить этот пакет. Этот пакет необходим для некоторых видов экспорта.

Здесь мы скачаем и установим onnxruntime-gpu 1.24.0 с Python3.12 поддержкой.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

Использование TensorRT на NVIDIA DGX Spark

Среди всех форматов экспорта моделей, поддерживаемых Ultralytics, TensorRT обеспечивает высочайшую производительность инференса на NVIDIA DGX Spark, что делает его нашей главной рекомендацией для развертываний. Инструкции по настройке и расширенному использованию см. в нашем специальном руководстве по интеграции TensorRT.

Преобразование модели в TensorRT и запуск вывода

Модель YOLO26n в формате PyTorch преобразуется в TensorRT для выполнения инференса с экспортированной моделью.

Пример

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Примечание

Посетите страницу экспорта, чтобы получить доступ к дополнительным аргументам при экспорте моделей в различные форматы.

Тесты NVIDIA DGX Spark YOLO11

Бенчмарки YOLO11 были проведены командой Ultralytics на нескольких форматах моделей, измеряя скорость и точность: PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. Бенчмарки были запущены на NVIDIA DGX Spark с точностью FP32 и размером входного изображения по умолчанию 640.

Подробная сравнительная таблица

В таблице ниже представлены результаты бенчмарков для пяти различных моделей (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) в различных форматах, показывающие статус, размер, метрику mAP50-95(B) и время инференса для каждой комбинации.

Производительность

| Формат | Статус | Размер на диске (МБ) | mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| Формат | Статус | Размер на диске (МБ) | mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| Формат | Статус | Размер на диске (МБ) | mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| Формат | Статус | Размер на диске (МБ) | mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| Формат | Статус | Размер на диске (МБ) | mAP50-95(B) | Время инференса (мс/изобр.) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Протестировано с Ultralytics 8.3.249

Воспроизведение наших результатов

Чтобы воспроизвести вышеуказанные тесты Ultralytics для всех форматов экспорта, запустите этот код:

Пример

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Обратите внимание, что результаты бенчмаркинга могут варьироваться в зависимости от точной аппаратной и программной конфигурации системы, а также от текущей загрузки системы во время выполнения бенчмарков. Для получения наиболее надежных результатов используйте набор данных с большим количеством изображений, например, data='coco.yaml' (5000 изображений для проверки).

Рекомендации по использованию NVIDIA DGX Spark

При использовании NVIDIA DGX Spark следует придерживаться нескольких рекомендаций для обеспечения максимальной производительности при запуске YOLO26.

Мониторинг производительности системы

Используйте инструменты мониторинга NVIDIA для track использования GPU и CPU:

nvidia-smiОптимизация использования памяти

Благодаря 128 ГБ унифицированной памяти DGX Spark может обрабатывать большие размеры пакетов и модели. Рассмотрите возможность увеличения размера пакета для повышения пропускной способности:

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)Используйте TensorRT с FP16 или INT8

Для достижения наилучшей производительности экспортируйте модели с точностью FP16 или INT8:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

Обновления системы (Founders Edition)

Поддержание актуальности вашей DGX Spark Founders Edition критически важно для производительности и безопасности. NVIDIA предлагает два основных метода обновления системной ОС, драйверов и прошивки.

Использование панели управления DGX (рекомендуется)

The DGX Dashboard — это рекомендуемый способ выполнения системных обновлений, обеспечивающий совместимость. Он позволяет:

- Просмотр доступных системных обновлений

- Установка исправлений безопасности и системных обновлений

- Управление обновлениями драйверов и прошивки NVIDIA

Ручные обновления системы

Для опытных пользователей обновления могут быть выполнены вручную через терминал:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

Предупреждение

Перед выполнением обновлений убедитесь, что ваша система подключена к стабильному источнику питания и вы создали резервные копии важных данных.

Следующие шаги

Для дальнейшего изучения и поддержки см. документацию Ultralytics YOLO26.

Часто задаваемые вопросы

Как развернуть Ultralytics YOLO26 на NVIDIA DGX Spark?

Развертывание Ultralytics YOLO26 на NVIDIA DGX Spark не представляет сложности. Вы можете использовать предварительно собранный образ Docker для быстрой настройки или вручную установить необходимые пакеты. Подробные шаги для каждого подхода можно найти в разделах Быстрый старт с Docker и Начало работы с нативной установкой.

Какую производительность можно ожидать от YOLO26 на NVIDIA DGX Spark?

Модели YOLO26 демонстрируют отличную производительность на DGX Spark благодаря суперчипу GB10 Grace Blackwell. Формат TensorRT обеспечивает наилучшую производительность инференса. Конкретные результаты сравнительных тестов для различных размеров и форматов моделей приведены в разделе Подробная сравнительная таблица.

Почему мне следует использовать TensorRT для YOLO26 на DGX Spark?

TensorRT настоятельно рекомендуется для развертывания моделей YOLO26 на DGX Spark благодаря его оптимальной производительности. Он ускоряет инференс, используя возможности GPU Blackwell, обеспечивая максимальную эффективность и скорость. Подробнее см. в разделе Использование TensorRT на NVIDIA DGX Spark.

Как DGX Spark соотносится с устройствами Jetson для YOLO26?

DGX Spark предлагает значительно большую вычислительную мощность, чем устройства Jetson, с производительностью ИИ до 1 PFLOP и 128 ГБ унифицированной памяти, по сравнению с 2070 TFLOPS и 128 ГБ памяти Jetson AGX Thor. DGX Spark разработан как настольный суперкомпьютер для ИИ, в то время как устройства Jetson — это встраиваемые системы, оптимизированные для развертывания на периферии.

Могу ли я использовать один и тот же образ Docker для DGX Spark и Jetson AGX Thor?

Да! Образ ultralytics/ultralytics:latest-nvidia-arm64 Docker поддерживает как NVIDIA DGX Spark (с DGX OS), так и Jetson AGX Thor (с JetPack 7.0), поскольку оба используют архитектуру ARM64 с CUDA 13 и аналогичными программными стеками.