Ultralytics YOLO26

Обзор

Ultralytics YOLO26 — это новейшая эволюция в серии YOLO детекторов объектов в реальном времени, разработанная с нуля для периферийных и маломощных устройств. Она представляет собой оптимизированную конструкцию, которая устраняет ненужную сложность, интегрируя при этом целевые инновации для обеспечения более быстрого, легкого и доступного развертывания.

Попробуйте Ultralytics

Исследуйте и запускайте модели YOLO26 непосредственно на Ultralytics .

Архитектура YOLO26 руководствуется тремя основными принципами:

- Простота: YOLO26 — это нативная сквозная модель, которая выдает прогнозы напрямую, без необходимости в подавлении немаксимумов (NMS). Благодаря устранению этого этапа постобработки вывод становится быстрее, легче и проще в развертывании в реальных системах. Этот новаторский подход был впервые разработан в YOLOv10 Ао Вангом в Университете Цинхуа и получил дальнейшее развитие в YOLO26.

- Эффективность развертывания: Сквозная конструкция исключает целый этап конвейера, значительно упрощая интеграцию, снижая задержку и делая развертывание более надежным в различных средах.

- Инновации в обучении: YOLO26 представляет оптимизатор MuSGD, гибрид SGD и Muon — вдохновленный прорывами Moonshot AI Kimi K2 в обучении LLM. Этот оптимизатор обеспечивает повышенную стабильность и более быструю сходимость, перенося достижения в оптимизации из языковых моделей в компьютерное зрение.

- Оптимизации для конкретных задач: YOLO26 представляет целенаправленные улучшения для специализированных задач, включая потери семантической сегментации и многомасштабные прото-модули для Сегментации, оценку остаточного логарифмического правдоподобия (RLE) для высокоточной оценки Pose, а также оптимизированное декодирование с угловой потерей для решения проблем границ в OBB.

В совокупности эти инновации обеспечивают семейство моделей, которое достигает более высокой точности на небольших объектах, обеспечивает бесшовное развертывание и работает до 43% быстрее на CPU, что делает YOLO26 одной из самых практичных и удобных для развертывания моделей YOLO на сегодняшний день для сред с ограниченными ресурсами.

Основные характеристики

Удаление DFL

Модуль Distribution Focal Loss (DFL), хотя и эффективен, часто усложнял экспорт и ограничивал совместимость оборудования. YOLO26 полностью удаляет DFL, упрощая вывод и расширяя поддержку периферийных устройств и устройств с низким энергопотреблением.Сквозной вывод без NMS

В отличие от традиционных детекторов, которые используют NMS в качестве отдельного этапа постобработки, YOLO26 является изначально сквозной. Прогнозы генерируются напрямую, что снижает задержку и делает интеграцию в производственные системы более быстрой, легкой и надежной.ProgLoss + STAL

Улучшенные функции потерь повышают точность обнаружения, с заметными улучшениями в распознавании мелких объектов, что является критически важным требованием для IoT, робототехники, аэрофотосъемки и других периферийных приложений.Оптимизатор MuSGD

Новый гибридный оптимизатор, сочетающий в себе SGD с Muon. Вдохновленный Kimi K2 от Moonshot AI, MuSGD внедряет передовые методы оптимизации из обучения LLM в компьютерное зрение, обеспечивая более стабильное обучение и более быструю сходимость.До 43% более быстрый вывод на CPU

Специально оптимизированный для периферийных вычислений, YOLO26 обеспечивает значительно более быстрый вывод на CPU, гарантируя производительность в реальном времени на устройствах без GPU.Улучшения сегментации экземпляров

Представляет потери семантической сегментации для улучшения сходимости модели и обновленный прото-модуль, который использует многомасштабную информацию для превосходного качества масок.Точная оценка позы

Интегрирует оценку остаточного логарифмического правдоподобия (RLE) для более точной локализации ключевых точек и оптимизирует процесс декодирования для увеличения скорости инференса.Уточненное декодирование OBB

Вводит специализированную угловую функцию потерь для повышения точности detect квадратных объектов и оптимизирует декодирование OBB для решения проблем разрывов границ.

Поддерживаемые задачи и режимы

YOLO26 основывается на универсальном диапазоне моделей, созданном предыдущими выпусками Ultralytics YOLO, предлагая расширенную поддержку для различных задач компьютерного зрения:

| Модель | Имена файлов | Задача | Инференс | Валидация | Обучение | Экспорт |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | Обнаружение | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | Сегментация экземпляров | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | Поза/Ключевые точки | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | Ориентированное обнаружение | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | Классификация | ✅ | ✅ | ✅ | ✅ |

Эта унифицированная структура гарантирует, что YOLO26 применим для detect в реальном времени, segment, классификации, оценки позы и detect ориентированных объектов — и все это с поддержкой обучения, проверки, inference и экспорта.

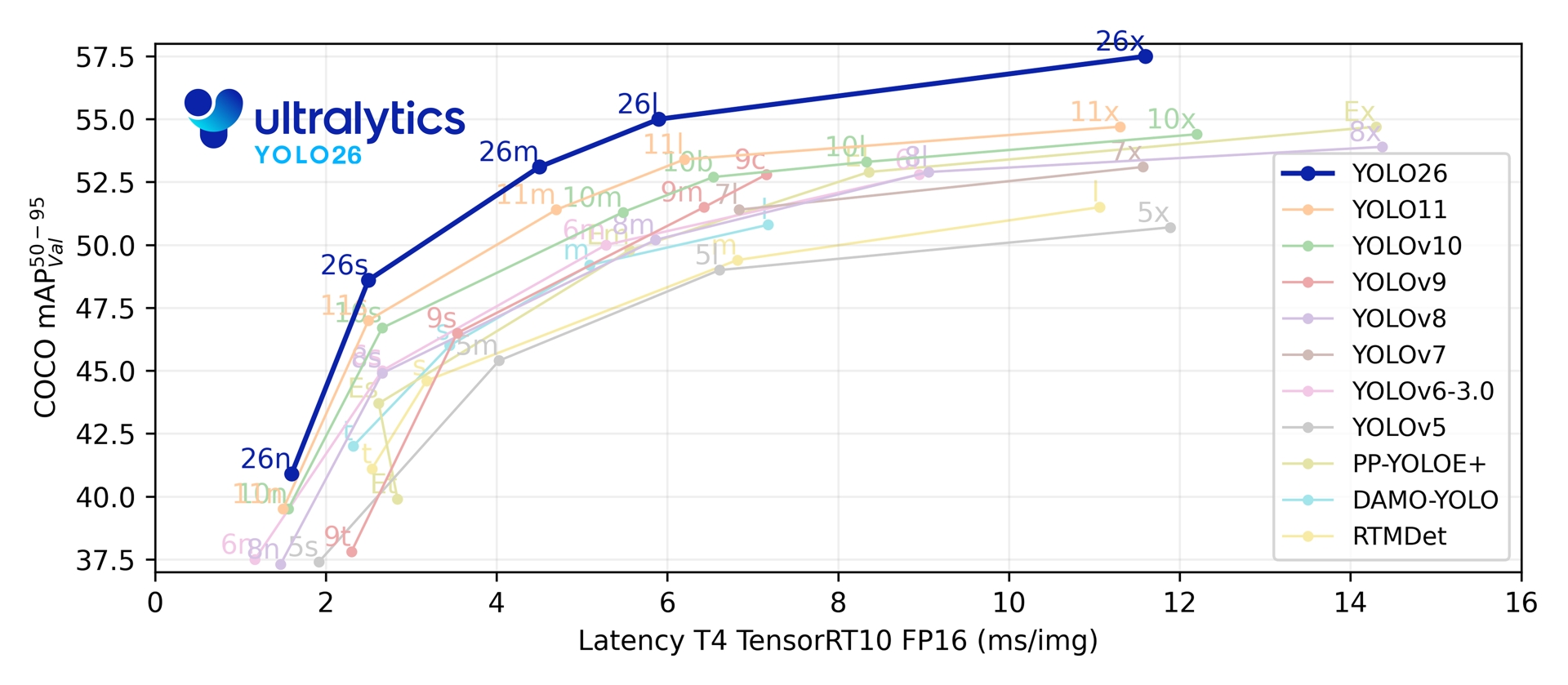

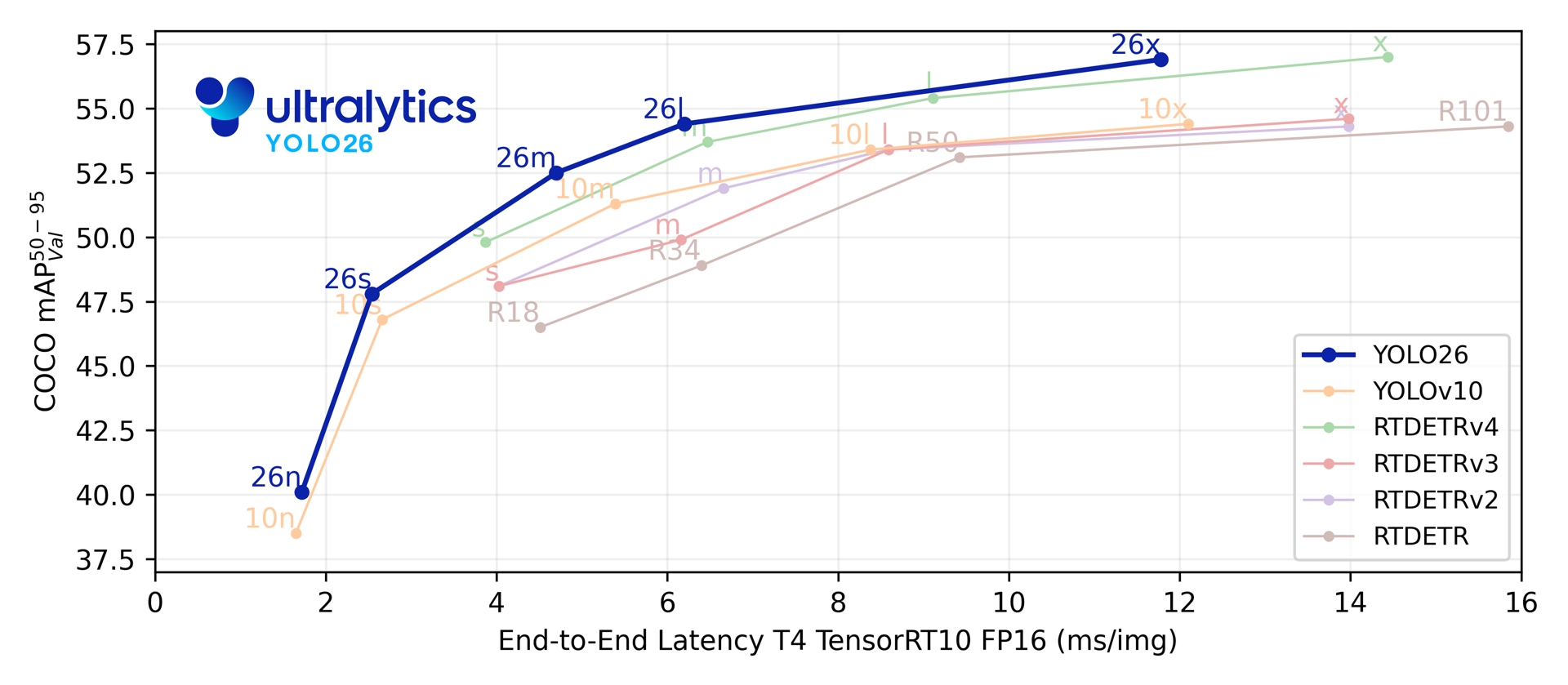

Метрики производительности

Производительность

См. документацию по detect для примеров использования этих моделей, обученных на COCO, которые включают 80 предварительно обученных классов.

| Модель | размер (пиксели) | mAPval 50-95 | mAPval 50-95(e2e) | Скорость CPU ONNX (мс) | Скорость T4 TensorRT10 (мс) | параметры (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

См. документацию по сегментации для примеров использования этих моделей, обученных на COCO, которые включают 80 предобученных классов.

| Модель | размер (пиксели) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | Скорость CPU ONNX (мс) | Скорость T4 TensorRT10 (мс) | параметры (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

См. документацию по классификации для примеров использования этих моделей, обученных на ImageNet, которые включают 1000 предобученных классов.

| Модель | размер (пиксели) | acc top1 | acc top5 | Скорость CPU ONNX (мс) | Скорость T4 TensorRT10 (мс) | параметры (M) | FLOPs (B) при 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

См. документацию по оценке позы для примеров использования этих моделей, обученных на COCO, которые включают 1 предобученный класс — 'person'.

| Модель | размер (пиксели) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Скорость CPU ONNX (мс) | Скорость T4 TensorRT10 (мс) | параметры (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

См. документацию по ориентированному detect для примеров использования этих моделей, обученных на DOTAv1, которые включают 15 предобученных классов.

| Модель | размер (пиксели) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | Скорость CPU ONNX (мс) | Скорость T4 TensorRT10 (мс) | параметры (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

Параметры и значения FLOPs относятся к объединенной модели после model.fuse(), который объединяет слои Conv и BatchNorm и удаляет вспомогательную головку обнаружения «один ко многим». Предварительно обученные контрольные точки сохраняют полную архитектуру обучения и могут показывать более высокие показатели.

Примеры использования

В этом разделе представлены простые примеры обучения и инференса YOLO26. Полную документацию по этим и другим режимам смотрите на страницах документации Predict, Train, Val и Export.

Обратите внимание, что приведенный ниже пример предназначен для моделей YOLO26 Detect для обнаружения объектов. Для дополнительных поддерживаемых задач смотрите документацию по Segment, Classify, OBB и Pose.

Пример

PyTorch предварительно обученные *.pt модели, а также конфигурационные *.yaml файлы могут быть переданы в YOLO() class для создания экземпляра модели в Python:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

Для непосредственного запуска моделей доступны команды CLI:

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

Архитектура с двумя головками

YOLO26 имеет архитектуру с двумя головками, что обеспечивает гибкость для различных сценариев развертывания:

- Один на один (по умолчанию): Создает сквозные прогнозы без NMS, выводя

(N, 300, 6)с максимальным количеством 300 обнаружений на изображение. Эта головка оптимизирована для быстрого вывода и упрощенного развертывания. - Головка «один ко многим»: Генерирует традиционные YOLO , требующие NMS , выводя

(N, nc + 4, 8400)гдеnc— количество классов. Такая головка обычно обеспечивает немного более высокую точность за счет дополнительной обработки.

Вы можете переключаться между головками во время экспорта, прогнозирования или проверки:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

Выбор зависит от ваших требований к развертыванию: используйте головку «один к одному» для максимальной скорости и простоты или головку «один ко многим», когда точность является главным приоритетом.

YOLOE-26: Сегментация экземпляров с открытым словарем

YOLOE-26 интегрирует высокопроизводительную архитектуру YOLO26 с возможностями открытого словаря серии YOLOE. Он обеспечивает обнаружение и сегментацию любого класса объектов в реальном времени с использованием текстовых подсказок, визуальных подсказок или режима без подсказок для инференса с нулевым выстрелом, эффективно устраняя ограничения обучения с фиксированными категориями.

Используя сквозную архитектуру YOLO26 без NMS, YOLOE-26 обеспечивает быстрый инференс в открытом мире. Это делает его мощным решением для граничных приложений в динамических средах, где объекты интереса представляют собой широкий и развивающийся словарь.

Производительность

Примеры использования этих моделей, обученных на наборах данных Objects365v1, GQA и Flickr30k, смотрите в документации YOLOE.

| Модель | размер (пиксели) | Тип подсказки | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | параметры (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | Текстовый/Визуальный | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | Текстовый/Визуальный | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | Текстовый/Визуальный | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | Текстовый/Визуальный | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | Текстовый/Визуальный | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

Примеры использования этих моделей, обученных на наборах данных Objects365v1, GQA и Flickr30k, смотрите в документации YOLOE.

| Модель | размер (пиксели) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | параметры (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

Пример использования

YOLOE-26 поддерживает как текстовые, так и визуальные подсказки. Использование подсказок просто — достаточно передать их через predict метод, как показано ниже:

Пример

Текстовые подсказки позволяют указывать классы, которые вы хотите detect, с помощью текстовых описаний. Следующий код показывает, как можно использовать YOLOE-26 для detect людей и автобусов на изображении:

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Визуальные подсказки позволяют направлять модель, показывая ей визуальные примеры целевых классов, а не описывая их текстом.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE-26 включает варианты без подсказок, которые поставляются со встроенным словарем. Эти модели не требуют никаких подсказок и работают как традиционные модели YOLO. Вместо того чтобы полагаться на предоставленные пользователем метки или визуальные примеры, они detect объекты из предопределенного списка из 4585 классов на основе набора тегов, используемого Recognize Anything Model Plus (RAM++).

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Для углубленного изучения методов подсказок, обучения с нуля и полных примеров использования посетите документацию YOLOE.

Цитирование и благодарности

Публикация Ultralytics YOLO26

Ultralytics не публиковала официальную исследовательскую статью для YOLO26 из-за быстро развивающегося характера моделей. Вместо этого мы сосредотачиваемся на предоставлении передовых моделей и упрощении их использования. Для получения последних обновлений о функциях, архитектурах и использовании YOLO посетите наш репозиторий GitHub и документацию.

Если вы используете YOLO26 или другое программное обеспечение Ultralytics в своей работе, пожалуйста, сошлитесь на него следующим образом:

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI в ожидании. YOLO26 доступна по лицензиям AGPL-3.0 и Enterprise.

Часто задаваемые вопросы

Каковы основные улучшения в YOLO26 по сравнению с YOLO11?

- Удаление DFL: Упрощает экспорт и расширяет совместимость с периферийными устройствами

- Сквозной вывод без NMS: Устраняет NMS для более быстрого и простого развертывания

- ProgLoss + STAL: Повышает точность, особенно для мелких объектов.

- Оптимизатор MuSGD: Объединяет SGD и Muon (вдохновлен Kimi K2 от Moonshot) для более стабильного и эффективного обучения

- До 43% более быстрый вывод на CPU: Значительное повышение производительности для устройств только с CPU

Какие задачи поддерживает YOLO26?

YOLO26 — это унифицированное семейство моделей, обеспечивающее комплексную поддержку для множества задач компьютерного зрения:

- Обнаружение объектов

- Сегментация экземпляров

- Классификация изображений

- Оценка позы

- Детектирование ориентированных объектов (OBB)

Каждый вариант размера (n, s, m, l, x) поддерживает все задачи, а также версии с открытым словарем через YOLOE-26.

Почему YOLO26 оптимизирован для развертывания на периферии?

YOLO26 обеспечивает передовую производительность на периферийных устройствах благодаря:

- До 43% более быстрый вывод на CPU

- Уменьшенный размер модели и занимаемый объем памяти

- Архитектура упрощена для совместимости (нет DFL, нет NMS)

- Гибкие форматы экспорта, включая TensorRT, ONNX, CoreML, TFLite и OpenVINO

Как начать работу с YOLO26?

Модели YOLO26 были выпущены 14 января 2026 года и доступны для скачивания. Установите или обновите ultralytics пакет и загрузите модель:

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

См. раздел Примеры использования для инструкций по обучению, валидации и экспорту.