Hızlı Başlangıç Rehberi: NVIDIA DGX Spark ile Ultralytics YOLO26

Bu kapsamlı rehber, Ultralytics YOLO26'yı NVIDIA'nın kompakt masaüstü yapay zeka süper bilgisayarı olan NVIDIA DGX Spark üzerinde dağıtmak için ayrıntılı bir yol haritası sunar. Ek olarak, bu güçlü sistemde YOLO26'nın yeteneklerini göstermek için performans kıyaslamalarını sergiler.

Not

Bu rehber, Ubuntu tabanlı DGX OS çalıştıran NVIDIA DGX Spark Founders Edition ile test edilmiştir. En son DGX OS sürümleriyle çalışması beklenmektedir.

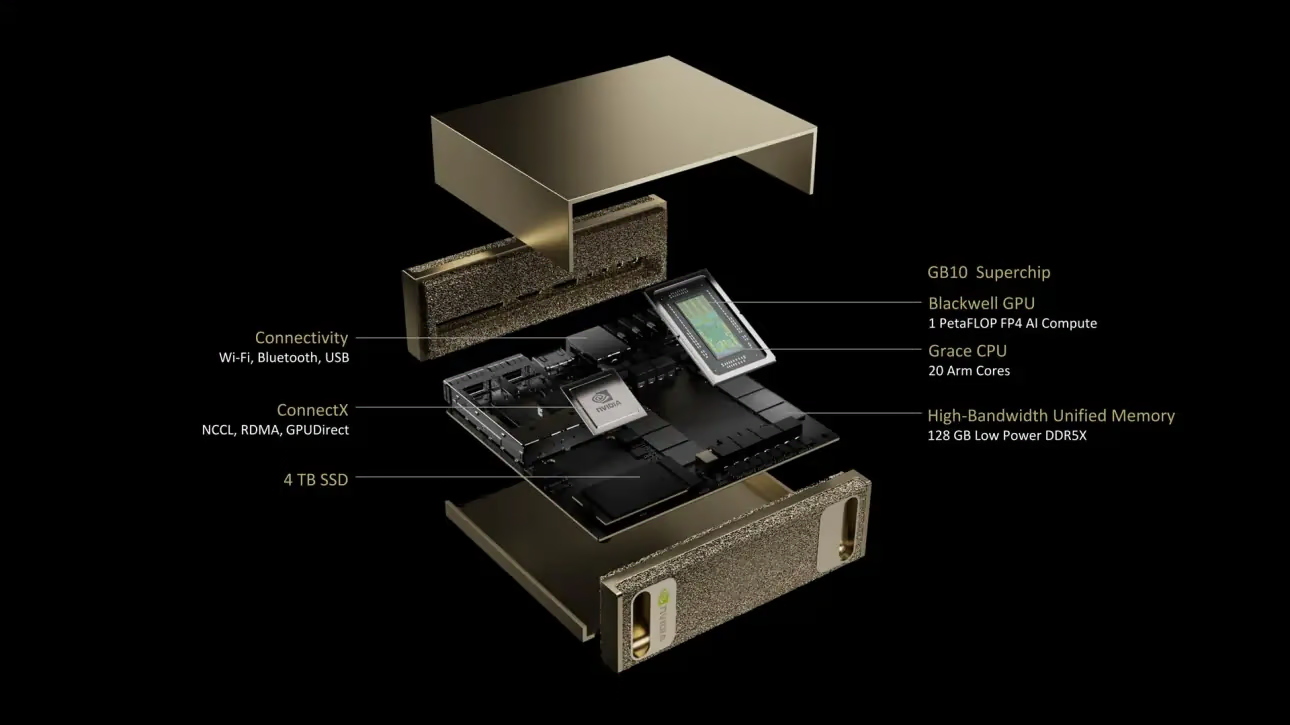

NVIDIA DGX Spark Nedir?

NVIDIA DGX Spark, NVIDIA GB10 Grace Blackwell Süperçipi tarafından desteklenen kompakt bir masaüstü yapay zeka süper bilgisayarıdır. FP4 hassasiyetinde 1 petaFLOP'a kadar yapay zeka hesaplama performansı sunarak, masaüstü form faktöründe güçlü yapay zeka yeteneklerine ihtiyaç duyan geliştiriciler, araştırmacılar ve veri bilimciler için idealdir.

Temel Özellikler

| Özellik | Detaylar |

|---|---|

| Yapay Zeka Performansı | 1 PFLOP'a kadar (FP4) |

| GPU | 5. Nesil tensor Çekirdekleri ve 4. Nesil RT Çekirdekleri ile NVIDIA Blackwell Mimarisi |

| CPU | 20 çekirdekli Arm işlemci (10 Cortex-X925 + 10 Cortex-A725) |

| Bellek | 128 GB LPDDR5x birleşik sistem belleği, 256-bit arayüz, 4266 MHz, 273 GB/s bant genişliği |

| Depolama | Kendi kendine şifrelemeli 1 TB veya 4 TB NVMe M.2 |

| Ağ | 1x RJ-45 (10 GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| Bağlantı | 4x USB Type-C, 1x HDMI 2.1a, HDMI çok kanallı ses |

| Video İşleme | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS, yapay zeka, makine öğrenimi ve analitik uygulamalarını DGX sistemlerinde çalıştırmak için kararlı, test edilmiş ve desteklenen bir işletim sistemi temeli sağlayan özelleştirilmiş bir Linux dağıtımıdır. Şunları içerir:

- Yapay zeka iş yükleri için optimize edilmiş sağlam bir Linux temeli

- NVIDIA donanımı için önceden yapılandırılmış sürücüler ve sistem ayarları

- Güvenlik güncellemeleri ve sistem bakım yetenekleri

- Daha geniş NVIDIA yazılım ekosistemi ile uyumluluk

DGX OS, genellikle yılda iki kez (Şubat ve Ağustos civarında) güncellemelerle düzenli bir yayın programı izler ve ana sürümler arasında ek güvenlik yamaları sağlanır.

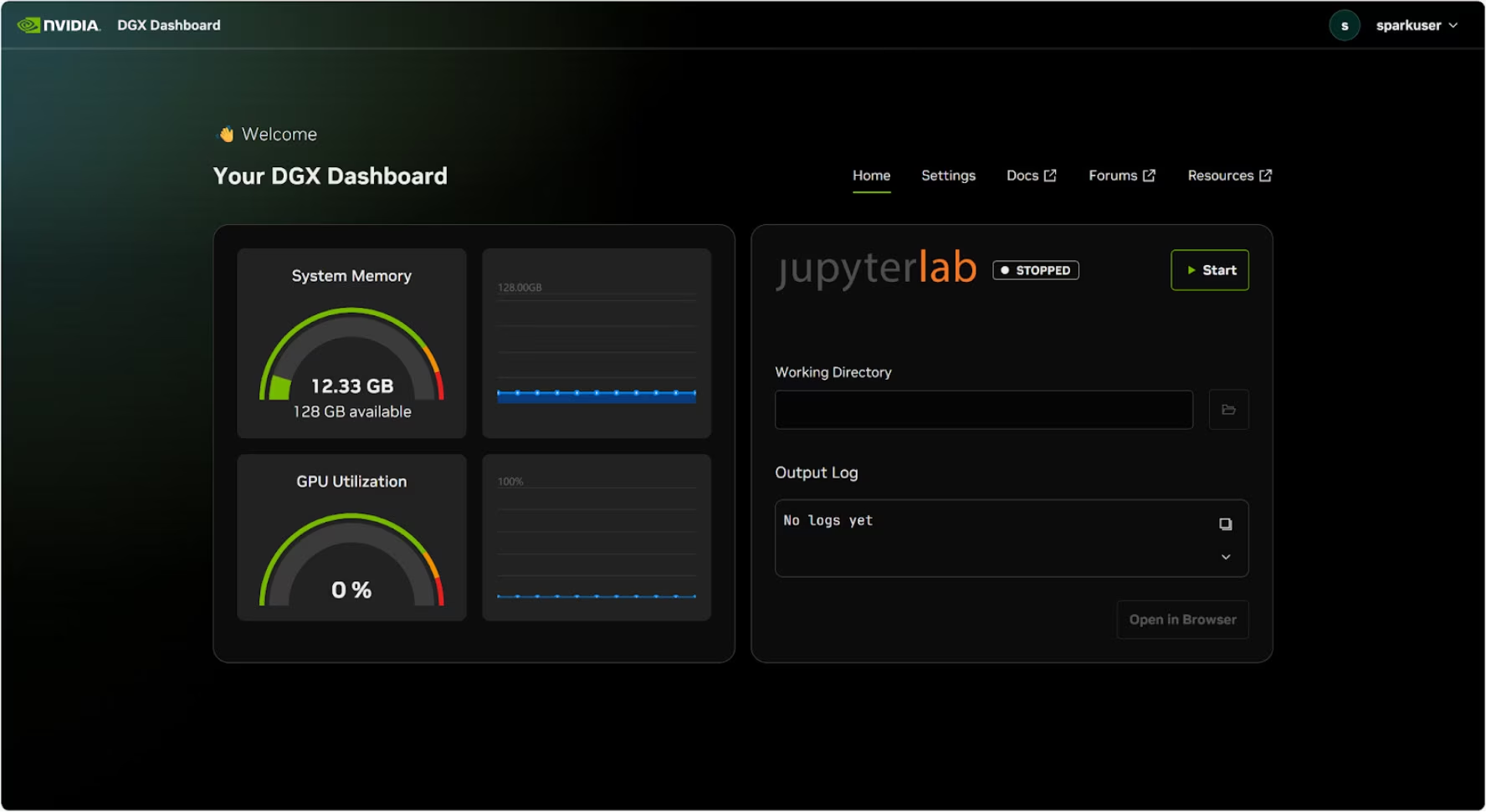

DGX Kontrol Paneli

DGX Spark, yerleşik bir DGX Dashboard ile birlikte gelir ve şunları sağlar:

- Gerçek Zamanlı Sistem İzleme: Sistemin mevcut operasyonel metriklerine genel bakış

- Sistem Güncellemeleri: Güncellemeleri doğrudan kontrol panelinden uygulama yeteneği

- Sistem Ayarları: Cihaz adını ve diğer yapılandırmaları değiştirme

- Entegre JupyterLab: Geliştirme için yerel Jupyter Notebook'lara erişim

Kontrol Paneline Erişim

Ubuntu masaüstünün sol alt köşesindeki "Uygulamaları Göster" düğmesine tıklayın, ardından tarayıcınızda açmak için "DGX Dashboard" öğesini seçin.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

NVIDIA Sync ile bağlandıktan sonra, panoyu açmak için "DGX Dashboard" düğmesine tıklayın http://localhost:11000.

Entegre JupyterLab

Pano, başlatıldığında otomatik olarak bir sanal ortam oluşturan ve önerilen paketleri yükleyen entegre bir JupyterLab örneği içerir. Her kullanıcı hesabına JupyterLab erişimi için özel bir bağlantı noktası atanır.

Docker ile Hızlı Başlangıç

Ultralytics YOLO26'yı NVIDIA DGX Spark üzerinde kullanmaya başlamanın en hızlı yolu, önceden oluşturulmuş Docker görüntüleriyle çalıştırmaktır. Jetson AGX Thor'u (JetPack 7.0) destekleyen aynı Docker görüntüsü, DGX OS ile DGX Spark üzerinde çalışır.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

Bu işlem tamamlandıktan sonra, NVIDIA DGX Spark'ta TensorRT Kullanımı bölümüne atlayın.

Yerel Kurulum ile başlayın

Docker olmadan yerel bir kurulum için şu adımları izleyin.

Ultralytics Paketini Kurulumu

Burada, PyTorch modellerini diğer farklı formatlara aktarabilmek için Ultralytics paketini DGX Spark üzerine isteğe bağlı bağımlılıklarla kuracağız. Ağırlıklı olarak NVIDIA TensorRT dışa aktarımlarına odaklanacağız, çünkü TensorRT, DGX Spark'tan maksimum performansı almamızı sağlayacaktır.

Paketler listesini güncelleyin, pip'i kurun ve en son sürüme yükseltin

sudo apt update sudo apt install python3-pip -y pip install -U pipKurulum

ultralyticsisteğe bağlı bağımlılıkları olan pip paketipip install ultralytics[export]Cihazı yeniden başlatın

sudo reboot

PyTorch ve Torchvision'ı yükle

Yukarıdaki Ultralytics kurulumu Torch ve Torchvision'ı yükleyecektir. Ancak, pip aracılığıyla yüklenen bu paketler, DGX Spark'ın CUDA 13'lü ARM64 mimarisi için tam olarak optimize edilmemiş olabilir. Bu nedenle, CUDA 13 uyumlu sürümleri yüklemenizi öneririz:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Bilgi

NVIDIA DGX Spark üzerinde PyTorch 2.9.1 çalıştırırken aşağıdaki durumla karşılaşabilirsiniz: UserWarning CUDA başlatılırken (örneğin çalıştırırken yolo checks, yolo predict, vb.):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

Bu uyarı güvenle göz ardı edilebilir. Bu sorunu kalıcı olarak çözmek için, PyTorch 2.10 sürümüne dahil edilecek olan PyTorch PR #164590 numaralı bir düzeltme gönderilmiştir.

Kurulum onnxruntime-gpu

onnxruntime-gpu PyPI'de barındırılan paketinde aarch64 ARM64 sistemleri için ikili dosyalar. Bu nedenle bu paketi manuel olarak kurmamız gerekiyor. Bu paket, bazı dışa aktarımlar için gereklidir.

Burada indirecek ve kuracağız onnxruntime-gpu 1.24.0 ile Python3.12 destek.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

NVIDIA DGX Spark'ta TensorRT Kullanımı

Ultralytics tarafından desteklenen tüm model dışa aktarım formatları arasında TensorRT, NVIDIA DGX Spark üzerinde en yüksek çıkarım performansını sunarak dağıtımlar için en önemli tavsiyemiz olmaktadır. Kurulum talimatları ve gelişmiş kullanım için özel TensorRT entegrasyon kılavuzumuza bakın.

Modeli TensorRT'ye Dönüştürün ve Çıkarım Çalıştırın

PyTorch formatındaki YOLO26n modeli, dışa aktarılan modelle çıkarım yapmak için TensorRT'ye dönüştürülür.

Örnek

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Not

Modelleri farklı model formatlarına aktarırken ek argümanlara erişmek için Dışa Aktarma sayfasına gidin

NVIDIA DGX Spark YOLO11 Kıyaslamaları

YOLO11 kıyaslamaları, Ultralytics ekibi tarafından hız ve doğruluk ölçülerek birden fazla model formatında çalıştırıldı: PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. Kıyaslamalar, NVIDIA DGX Spark üzerinde FP32 hassasiyetinde ve varsayılan 640 giriş görüntü boyutuyla çalıştırıldı.

Detaylı Karşılaştırma Tablosu

Aşağıdaki tablo, beş farklı model (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) için birden fazla formattaki kıyaslama sonuçlarını göstermekte, her bir kombinasyon için durum, boyut, mAP50-95(B) metriği ve çıkarım süresini sunmaktadır.

Performans

| Format | Durum | Disk üzerindeki boyut (MB) | mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| Format | Durum | Disk üzerindeki boyut (MB) | mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| Format | Durum | Disk üzerindeki boyut (MB) | mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| Format | Durum | Disk üzerindeki boyut (MB) | mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| Format | Durum | Disk üzerindeki boyut (MB) | mAP50-95(B) | Çıkarım süresi (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Ultralytics 8.3.249 ile kıyaslandı

Sonuçlarımızı Tekrar Üretin

Yukarıdaki Ultralytics kıyaslamalarını tüm dışa aktarma biçimlerinde yeniden oluşturmak için bu kodu çalıştırın:

Örnek

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Kıyaslama sonuçlarının, bir sistemin donanım ve yazılım yapılandırmasına ve kıyaslamaların çalıştırıldığı zamanki sistemin mevcut iş yüküne göre değişebileceğini unutmayın. En güvenilir sonuçlar için, çok sayıda görüntü içeren bir veri kümesi kullanın, örneğin: data='coco.yaml' (5000 doğrulama görüntüsü).

NVIDIA DGX Spark için En İyi Uygulamalar

NVIDIA DGX Spark kullanırken, YOLO26'yı çalıştırırken maksimum performansı sağlamak için izlenmesi gereken birkaç en iyi uygulama vardır.

Sistem Performansını İzleme

GPU ve CPU kullanımını track etmek için NVIDIA'nın izleme araçlarını kullanın:

nvidia-smiBellek Kullanımını Optimize Etme

128 GB birleşik belleği ile DGX Spark, büyük batch boyutlarını ve modelleri işleyebilir. Gelişmiş verim için batch boyutunu artırmayı düşünün:

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)TensorRT'yi FP16 veya INT8 ile Kullanın

En iyi performans için, modelleri FP16 veya INT8 hassasiyetinde dışa aktarın:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

Sistem Güncellemeleri (Founders Edition)

DGX Spark Founders Edition'ınızı güncel tutmak, performans ve güvenlik açısından çok önemlidir. NVIDIA, sistem işletim sistemini, sürücüleri ve bellenimi güncellemek için iki ana yöntem sunar.

DGX Kontrol Panelini Kullanma (Önerilen)

DGX Dashboard, uyumluluğu sağlayarak sistem güncellemelerini gerçekleştirmek için önerilen yöntemdir. Şunları yapmanızı sağlar:

- Mevcut sistem güncellemelerini görüntüle

- Güvenlik yamalarını ve sistem güncellemelerini yükle

- NVIDIA sürücü ve bellenim güncellemelerini yönet

Manuel Sistem Güncellemeleri

Gelişmiş kullanıcılar için güncellemeler terminal üzerinden manuel olarak yapılabilir:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

Uyarı

Güncellemeleri yapmadan önce sisteminizin sabit bir güç kaynağına bağlı olduğundan ve kritik verilerinizi yedeklediğinizden emin olun.

Sonraki Adımlar

Daha fazla öğrenme ve destek için Ultralytics YOLO26 Belgeleri'ne bakın.

SSS

Ultralytics YOLO26'yı NVIDIA DGX Spark üzerinde nasıl dağıtırım?

Ultralytics YOLO26'yı NVIDIA DGX Spark üzerinde dağıtmak basittir. Hızlı kurulum için önceden oluşturulmuş Docker görüntüsünü kullanabilir veya gerekli paketleri manuel olarak kurabilirsiniz. Her bir yaklaşım için ayrıntılı adımlar Docker ile Hızlı Başlangıç ve Yerel Kurulum ile Başlangıç bölümlerinde bulunabilir.

NVIDIA DGX Spark üzerinde YOLO26'dan ne kadar performans bekleyebilirim?

YOLO26 modelleri, GB10 Grace Blackwell Superchip sayesinde DGX Spark üzerinde mükemmel performans sunar. TensorRT formatı en iyi çıkarım performansını sağlar. Farklı model boyutları ve formatları arasındaki belirli kıyaslama sonuçları için Ayrıntılı Karşılaştırma Tablosu bölümünü kontrol edin.

DGX Spark üzerinde YOLO26 için neden TensorRT kullanmalıyım?

TensorRT, optimal performansı nedeniyle YOLO26 modellerini DGX Spark üzerinde dağıtmak için şiddetle tavsiye edilir. Blackwell GPU yeteneklerinden yararlanarak çıkarımı hızlandırır, maksimum verimlilik ve hız sağlar. Daha fazla bilgiyi NVIDIA DGX Spark üzerinde TensorRT Kullanımı bölümünde bulabilirsiniz.

DGX Spark, YOLO26 için Jetson cihazlarıyla nasıl karşılaştırılır?

DGX Spark, Jetson AGX Thor'un 2070 TFLOPS ve 128GB belleğine kıyasla, 1 PFLOP'a kadar yapay zeka performansı ve 128GB birleşik bellekle Jetson cihazlarından önemli ölçüde daha fazla işlem gücü sunar. DGX Spark bir masaüstü yapay zeka süper bilgisayarı olarak tasarlanmışken, Jetson cihazları uç dağıtım için optimize edilmiş gömülü sistemlerdir.

DGX Spark ve Jetson AGX Thor için aynı Docker imajını kullanabilir miyim?

Evet! ultralytics/ultralytics:latest-nvidia-arm64 Docker görüntüsü, hem NVIDIA DGX Spark'ı (DGX OS ile) hem de Jetson AGX Thor'u (JetPack 7.0 ile) destekler, çünkü her ikisi de CUDA 13 ve benzer yazılım yığınları ile ARM64 mimarisini kullanır.