Hướng dẫn Bắt đầu Nhanh: NVIDIA DGX Spark với Ultralytics YOLO26

Hướng dẫn toàn diện này cung cấp hướng dẫn chi tiết để triển khai Ultralytics YOLO26 trên NVIDIA DGX Spark, siêu máy tính AI để bàn nhỏ gọn của NVIDIA. Ngoài ra, nó còn trình bày các điểm chuẩn hiệu suất để chứng minh khả năng của YOLO26 trên hệ thống mạnh mẽ này.

Lưu ý

Hướng dẫn này đã được thử nghiệm với NVIDIA DGX Spark Founders Edition chạy DGX OS dựa trên Ubuntu. Nó được kỳ vọng sẽ hoạt động với các bản phát hành DGX OS mới nhất.

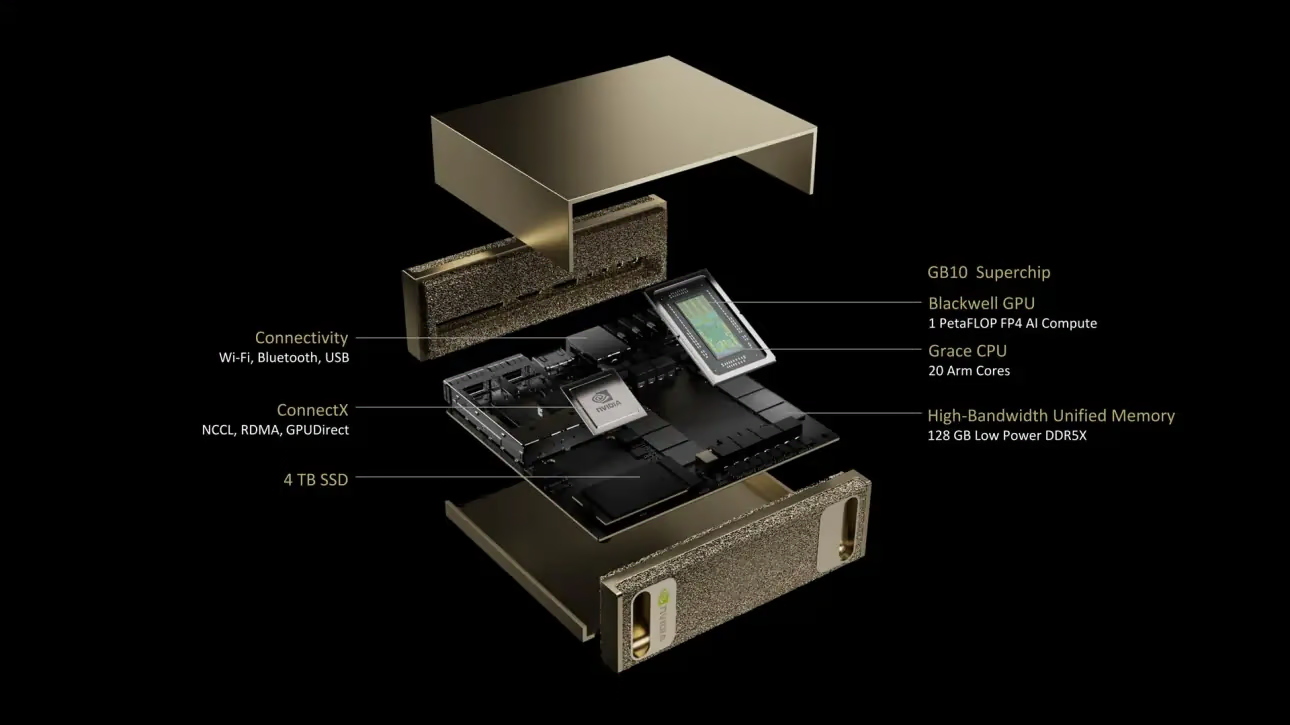

NVIDIA DGX Spark là gì?

NVIDIA DGX Spark là một siêu máy tính AI để bàn nhỏ gọn được trang bị NVIDIA GB10 Grace Blackwell Superchip. Nó cung cấp hiệu suất tính toán AI lên tới 1 petaFLOP với độ chính xác FP4, lý tưởng cho các nhà phát triển, nhà nghiên cứu và nhà khoa học dữ liệu cần khả năng AI mạnh mẽ trong một thiết bị để bàn.

Thông số kỹ thuật chính

| Thông số kỹ thuật | Chi tiết |

|---|---|

| Hiệu suất AI | Lên đến 1 PFLOP (FP4) |

| GPU | Kiến trúc NVIDIA Blackwell với Lõi Tensor thế hệ thứ 5, Lõi RT thế hệ thứ 4 |

| CPU | Bộ xử lý Arm 20 lõi (10 Cortex-X925 + 10 Cortex-A725) |

| Bộ nhớ | Bộ nhớ hệ thống hợp nhất LPDDR5x 128 GB, giao diện 256-bit, 4266 MHz, băng thông 273 GB/s |

| Lưu trữ | NVMe M.2 1 TB hoặc 4 TB với tính năng tự mã hóa |

| Mạng | 1x RJ-45 (10 GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| Kết nối | 4x USB Type-C, 1x HDMI 2.1a, âm thanh đa kênh HDMI |

| Xử lý video | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS là một bản phân phối Linux tùy chỉnh cung cấp nền tảng hệ điều hành ổn định, đã được kiểm thử và hỗ trợ để chạy các ứng dụng AI, học máy và phân tích trên các hệ thống DGX. Nó bao gồm:

- Một nền tảng Linux mạnh mẽ được tối ưu hóa cho các tác vụ AI

- Trình điều khiển và cài đặt hệ thống được cấu hình sẵn cho phần cứng NVIDIA

- Cập nhật bảo mật và khả năng bảo trì hệ thống

- Khả năng tương thích với hệ sinh thái phần mềm NVIDIA rộng lớn hơn

DGX OS tuân theo lịch trình phát hành định kỳ với các bản cập nhật thường được cung cấp hai lần mỗi năm (khoảng tháng 2 và tháng 8), cùng với các bản vá bảo mật bổ sung được cung cấp giữa các bản phát hành chính.

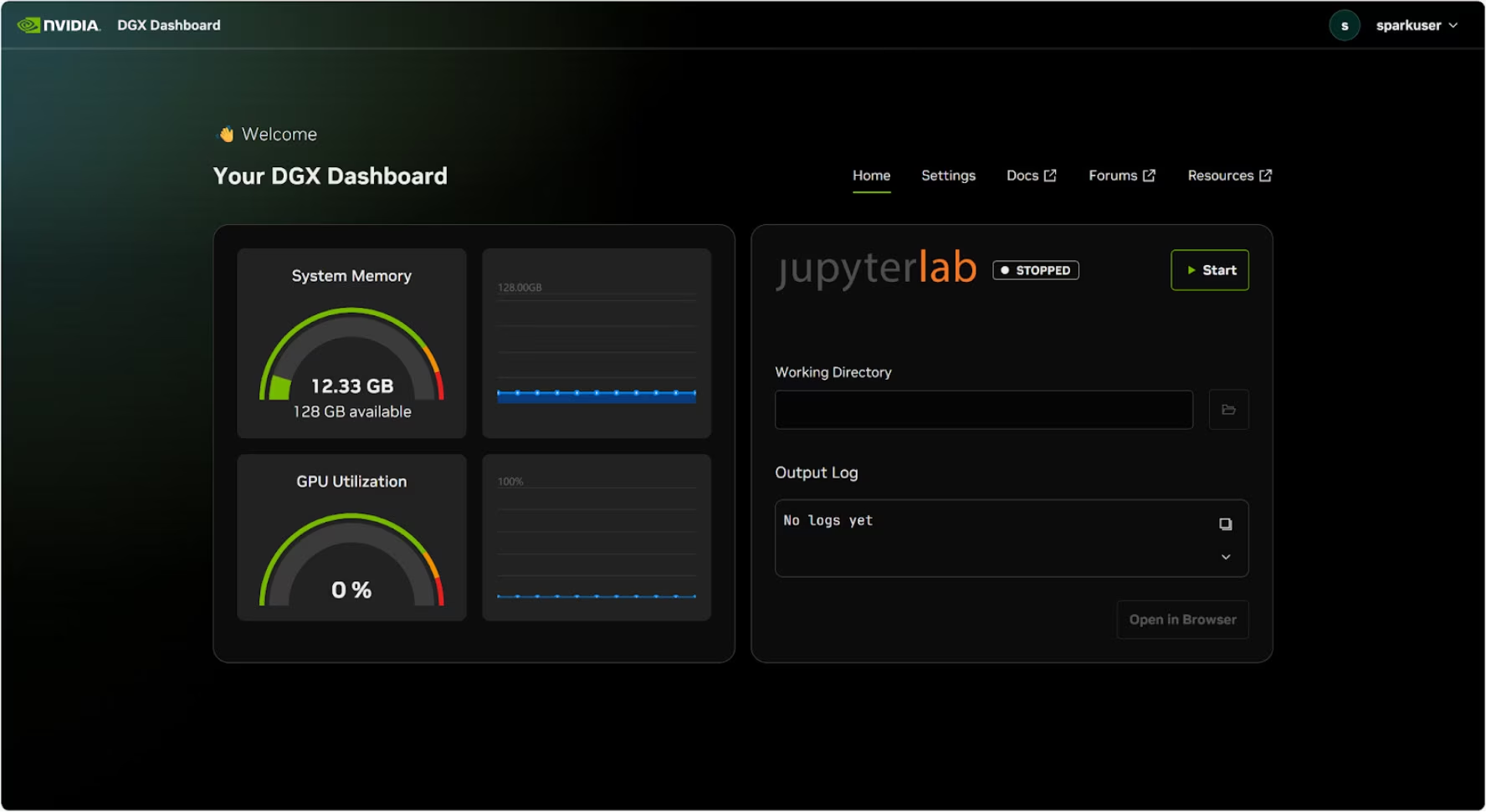

Bảng điều khiển DGX

DGX Spark đi kèm với một DGX Dashboard tích hợp sẵn, cung cấp:

- Giám sát hệ thống thời gian thực: Tổng quan về các chỉ số hoạt động hiện tại của hệ thống

- Cập nhật hệ thống: Khả năng áp dụng các bản cập nhật trực tiếp từ bảng điều khiển

- Cài đặt hệ thống: Thay đổi tên thiết bị và các cấu hình khác

- JupyterLab tích hợp: Truy cập các Jupyter Notebook cục bộ để phát triển

Truy cập Bảng điều khiển

Nhấp vào nút "Show Apps" ở góc dưới bên trái của màn hình Ubuntu, sau đó chọn "DGX Dashboard" để mở nó trong trình duyệt của bạn.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

Sau khi kết nối với NVIDIA Sync, nhấp vào nút "DGX Dashboard" để mở bảng điều khiển tại http://localhost:11000.

JupyterLab tích hợp

Bảng điều khiển bao gồm một phiên bản JupyterLab tích hợp tự động tạo môi trường ảo và cài đặt các gói được khuyến nghị khi khởi động. Mỗi tài khoản người dùng được gán một cổng riêng để truy cập JupyterLab.

Quick Start with Docker

Cách nhanh nhất để bắt đầu với Ultralytics YOLO26 trên NVIDIA DGX Spark là chạy bằng các ảnh Docker được xây dựng sẵn. Cùng một ảnh Docker hỗ trợ Jetson AGX Thor (JetPack 7.0) cũng hoạt động trên DGX Spark với DGX OS.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

Sau khi hoàn tất việc này, hãy chuyển đến mục Sử dụng TensorRT trên NVIDIA DGX Spark.

Start with Native Installation

Để cài đặt gốc mà không dùng Docker, hãy làm theo các bước sau.

Cài đặt Gói Ultralytics

Tại đây, chúng ta sẽ cài đặt gói Ultralytics trên DGX Spark với các phụ thuộc tùy chọn để chúng ta có thể xuất các mô hình PyTorch sang các định dạng khác nhau. Chúng ta sẽ chủ yếu tập trung vào xuất NVIDIA TensorRT vì TensorRT sẽ đảm bảo chúng ta có thể đạt được hiệu suất tối đa từ DGX Spark.

Cập nhật danh sách các gói, cài đặt pip và nâng cấp lên phiên bản mới nhất

sudo apt update sudo apt install python3-pip -y pip install -U pipCài đặt

ultralyticsgói pip với các dependency tùy chọnpip install ultralytics[export]Khởi động lại thiết bị

sudo reboot

Install PyTorch and Torchvision

Việc cài đặt Ultralytics ở trên sẽ cài đặt Torch và Torchvision. Tuy nhiên, các gói này được cài đặt qua pip có thể không được tối ưu hóa hoàn toàn cho kiến trúc ARM64 của DGX Spark với CUDA 13. Do đó, chúng tôi khuyến nghị cài đặt các phiên bản tương thích với CUDA 13:

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

Thông tin

Khi chạy PyTorch 2.9.1 trên NVIDIA DGX Spark, bạn có thể gặp phải những điều sau đây UserWarning khi khởi tạo CUDA (ví dụ: khi chạy yolo checks, yolo predict, v.v.):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

Cảnh báo này có thể bỏ qua một cách an toàn. Để khắc phục vĩnh viễn, một bản sửa lỗi đã được gửi trong PyTorch PR #164590 và sẽ được đưa vào bản phát hành PyTorch 2.10.

Cài đặt onnxruntime-gpu

Hàm onnxruntime-gpu gói được lưu trữ trong PyPI không có aarch64 các tệp nhị phân cho hệ thống ARM64. Vì vậy, chúng ta cần cài đặt gói này theo cách thủ công. Gói này cần thiết cho một số tác vụ xuất.

Tại đây chúng ta sẽ tải xuống và cài đặt onnxruntime-gpu 1.24.0 với Python3.12 hỗ trợ.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

Sử dụng TensorRT trên NVIDIA DGX Spark

Trong số tất cả các định dạng xuất mô hình được Ultralytics hỗ trợ, TensorRT mang lại hiệu suất suy luận cao nhất trên NVIDIA DGX Spark, khiến nó trở thành khuyến nghị hàng đầu của chúng tôi cho các triển khai. Để biết hướng dẫn cài đặt và cách sử dụng nâng cao, hãy xem hướng dẫn tích hợp TensorRT chuyên dụng của chúng tôi.

Chuyển đổi mô hình sang TensorRT và chạy suy luận

Mô hình YOLO26n ở định dạng PyTorch được chuyển đổi sang TensorRT để chạy suy luận với mô hình đã xuất.

Ví dụ

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

Lưu ý

Truy cập trang Xuất để truy cập các đối số bổ sung khi xuất mô hình sang các định dạng mô hình khác nhau

Điểm chuẩn YOLO11 của NVIDIA DGX Spark

Các thử nghiệm hiệu năng YOLO11 đã được nhóm Ultralytics thực hiện trên nhiều định dạng mô hình, đo lường tốc độ và độ chính xác: PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch. Các thử nghiệm hiệu năng được chạy trên NVIDIA DGX Spark ở độ chính xác FP32 với kích thước ảnh đầu vào mặc định là 640.

Bảng so sánh chi tiết

Bảng dưới đây trình bày kết quả thử nghiệm hiệu năng cho năm mô hình khác nhau (YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x) trên nhiều định dạng, cung cấp cho chúng ta trạng thái, kích thước, chỉ số mAP50-95(B) và thời gian suy luận cho mỗi sự kết hợp.

Hiệu suất

| Định dạng | Trạng thái | Dung lượng trên ổ cứng (MB) | mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| Định dạng | Trạng thái | Dung lượng trên ổ cứng (MB) | mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| Định dạng | Trạng thái | Dung lượng trên ổ cứng (MB) | mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| Định dạng | Trạng thái | Dung lượng trên ổ cứng (MB) | mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| Định dạng | Trạng thái | Dung lượng trên ổ cứng (MB) | mAP50-95(B) | Thời gian suy luận (ms/ảnh) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Được thử nghiệm hiệu năng với Ultralytics 8.3.249

Tái tạo Kết quả của Chúng tôi

Để tái tạo các điểm chuẩn Ultralytics ở trên trên tất cả các định dạng xuất, hãy chạy đoạn mã này:

Ví dụ

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

Lưu ý rằng kết quả đánh giá hiệu năng có thể khác nhau dựa trên cấu hình phần cứng và phần mềm chính xác của một hệ thống, cũng như khối lượng công việc hiện tại của hệ thống tại thời điểm chạy đánh giá hiệu năng. Để có kết quả đáng tin cậy nhất, hãy sử dụng tập dữ liệu có số lượng ảnh lớn, ví dụ: data='coco.yaml' (5000 ảnh val).

Các phương pháp hay nhất cho NVIDIA DGX Spark

Khi sử dụng NVIDIA DGX Spark, có một số phương pháp hay nhất cần tuân thủ để đạt được hiệu suất tối đa khi chạy YOLO26.

Giám sát hiệu suất hệ thống

Sử dụng các công cụ giám sát của NVIDIA để theo dõi mức sử dụng GPU và CPU:

nvidia-smiTối ưu hóa việc sử dụng bộ nhớ

Với 128GB bộ nhớ hợp nhất, DGX Spark có thể xử lý các kích thước lô lớn và các mô hình lớn. Cân nhắc tăng kích thước lô để cải thiện thông lượng:

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)Sử dụng TensorRT với FP16 hoặc INT8

Để đạt hiệu suất tốt nhất, hãy xuất mô hình với độ chính xác FP16 hoặc INT8:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

Cập nhật hệ thống (Phiên bản Founders Edition)

Việc giữ cho DGX Spark Founders Edition của bạn luôn được cập nhật là rất quan trọng đối với hiệu suất và bảo mật. NVIDIA cung cấp hai phương pháp chính để cập nhật hệ điều hành, trình điều khiển và firmware của hệ thống.

Sử dụng Bảng điều khiển DGX (Khuyên dùng)

DGX Dashboard là cách được khuyến nghị để thực hiện cập nhật hệ thống, đảm bảo khả năng tương thích. Nó cho phép bạn:

- Xem các bản cập nhật hệ thống có sẵn

- Cài đặt các bản vá bảo mật và cập nhật hệ thống

- Quản lý các bản cập nhật trình điều khiển và firmware của NVIDIA

Cập nhật hệ thống thủ công

Đối với người dùng nâng cao, các bản cập nhật có thể được thực hiện thủ công qua terminal:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

Cảnh báo

Đảm bảo hệ thống của bạn được kết nối với nguồn điện ổn định và bạn đã sao lưu dữ liệu quan trọng trước khi thực hiện cập nhật.

Các bước tiếp theo

Để tìm hiểu thêm và được hỗ trợ, hãy xem Tài liệu Ultralytics YOLO26.

Câu hỏi thường gặp

Làm cách nào để triển khai Ultralytics YOLO26 trên NVIDIA DGX Spark?

Việc triển khai Ultralytics YOLO26 trên NVIDIA DGX Spark rất đơn giản. Bạn có thể sử dụng ảnh Docker được xây dựng sẵn để thiết lập nhanh hoặc cài đặt thủ công các gói cần thiết. Các bước chi tiết cho từng phương pháp có thể được tìm thấy trong các phần Bắt đầu nhanh với Docker và Bắt đầu với Cài đặt gốc.

Tôi có thể mong đợi hiệu suất như thế nào từ YOLO26 trên NVIDIA DGX Spark?

Các mô hình YOLO26 mang lại hiệu suất vượt trội trên DGX Spark nhờ vào Superchip GB10 Grace Blackwell. Định dạng TensorRT cung cấp hiệu suất suy luận tốt nhất. Kiểm tra phần Bảng so sánh chi tiết để biết kết quả điểm chuẩn cụ thể trên các kích thước và định dạng mô hình khác nhau.

Tại sao tôi nên sử dụng TensorRT cho YOLO26 trên DGX Spark?

TensorRT rất được khuyến nghị để triển khai các mô hình YOLO26 trên DGX Spark do hiệu suất tối ưu của nó. Nó tăng tốc suy luận bằng cách tận dụng khả năng của GPU Blackwell, đảm bảo hiệu quả và tốc độ tối đa. Tìm hiểu thêm trong phần Sử dụng TensorRT trên NVIDIA DGX Spark.

DGX Spark so sánh với các thiết bị Jetson như thế nào đối với YOLO26?

DGX Spark cung cấp sức mạnh tính toán vượt trội đáng kể so với các thiết bị Jetson với hiệu suất AI lên tới 1 PFLOP và bộ nhớ hợp nhất 128GB, so với 2070 TFLOPS và 128GB bộ nhớ của Jetson AGX Thor. DGX Spark được thiết kế như một siêu máy tính AI để bàn, trong khi các thiết bị Jetson là hệ thống nhúng được tối ưu hóa cho triển khai biên.

Tôi có thể sử dụng cùng một Docker image cho DGX Spark và Jetson AGX Thor không?

Có! Ảnh ultralytics/ultralytics:latest-nvidia-arm64 Docker hỗ trợ cả NVIDIA DGX Spark (với DGX OS) và Jetson AGX Thor (với JetPack 7.0), vì cả hai đều sử dụng kiến trúc ARM64 với CUDA 13 và các ngăn xếp phần mềm tương tự.