SAM 3: Phân đoạn mọi thứ bằng các khái niệm

Hiện Đã Có Sẵn Trong Ultralytics

SAM 3 đã được tích hợp hoàn toàn vào gói Ultralytics kể từ phiên bản 8.3.237 (PR #22897). Cài đặt hoặc nâng cấp với pip install -U ultralytics để truy cập tất cả các tính năng của SAM 3 bao gồm segment khái niệm dựa trên văn bản, gợi ý ví dụ hình ảnh và theo dõi video (video track).

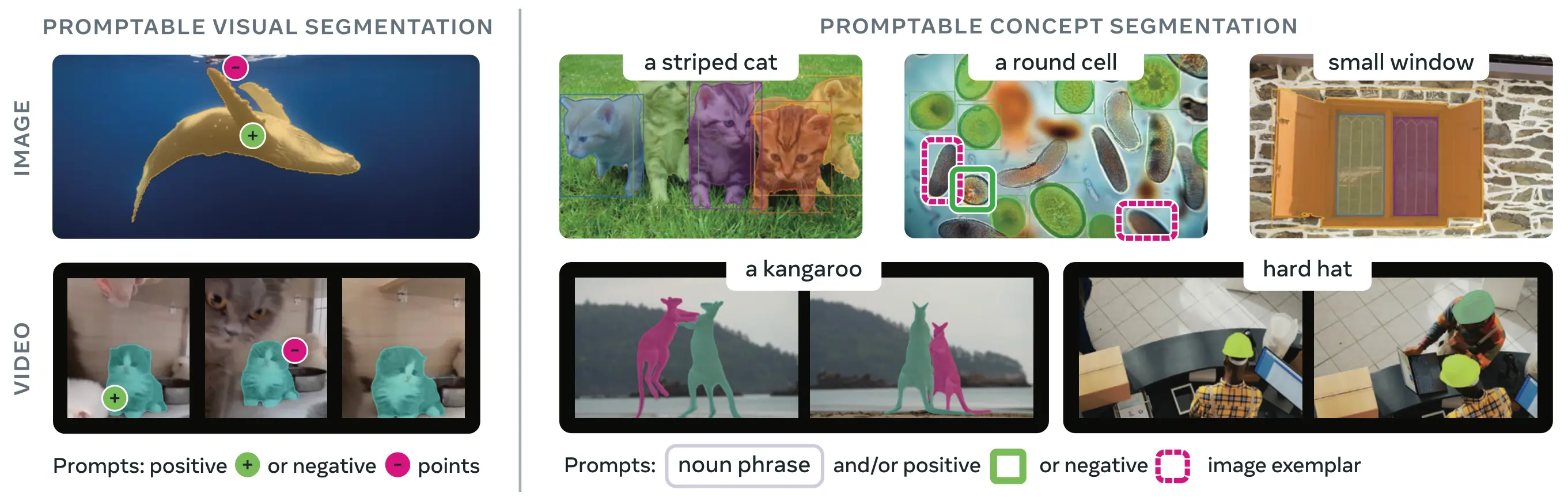

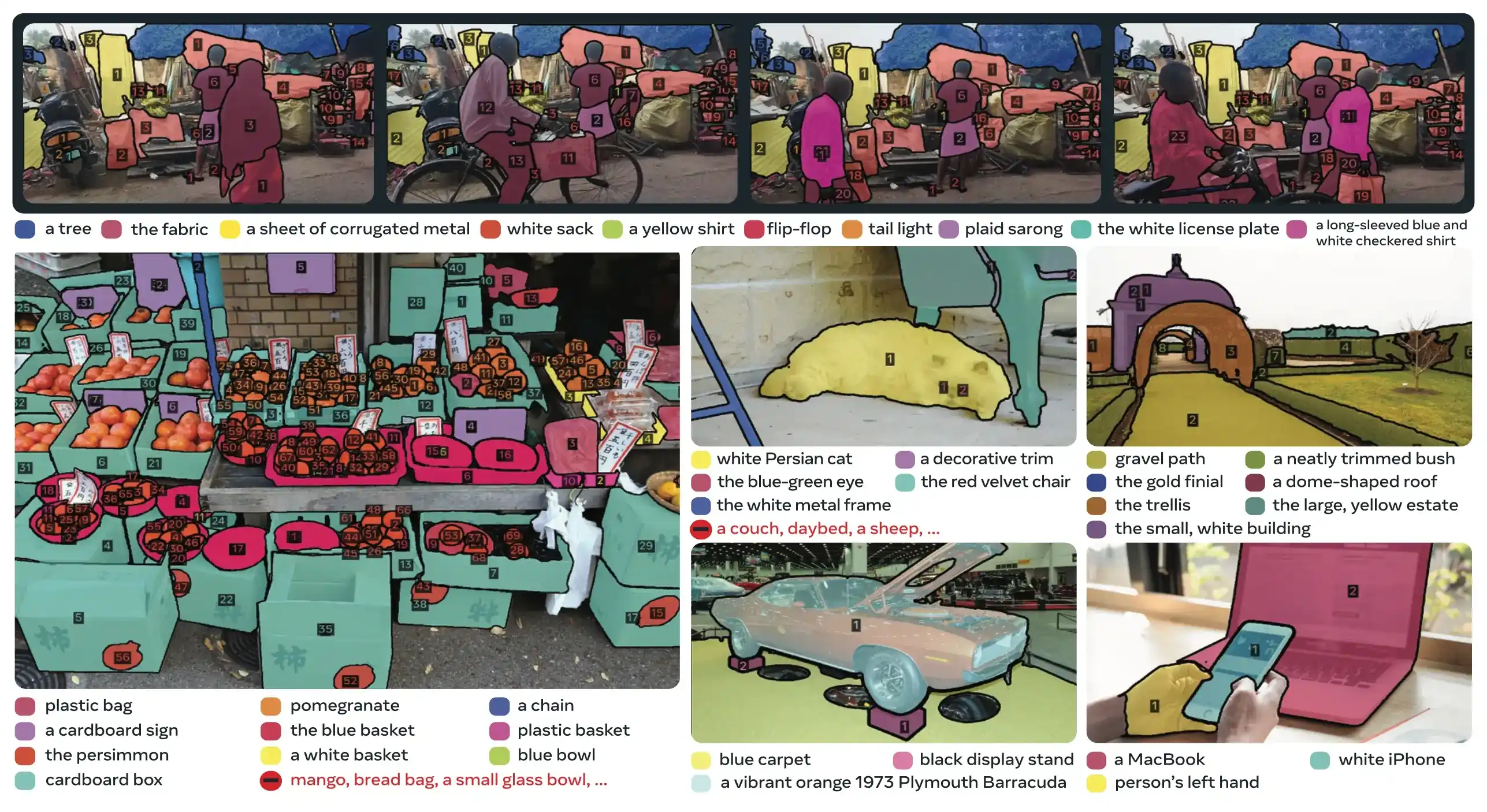

SAM 3 (Segment Anything Model 3) là mô hình nền tảng được Meta phát hành cho Phân đoạn Khái niệm có thể nhắc nhở (PCS). Dựa trên SAM 2, SAM 3 giới thiệu một khả năng hoàn toàn mới: detect, segment và track tất cả các thực thể của một khái niệm hình ảnh được chỉ định bằng lời nhắc văn bản, ví dụ hình ảnh hoặc cả hai. Không giống như các phiên bản SAM trước đây chỉ segment một đối tượng cho mỗi lời nhắc, SAM 3 có thể tìm và segment mọi sự xuất hiện của một khái niệm ở bất kỳ đâu trong hình ảnh hoặc video, phù hợp với các mục tiêu từ vựng mở trong phân đoạn thực thể hiện đại.

Xem: Cách sử dụng Meta Segment Anything 3 với Ultralytics | Phân đoạn dựa trên lời nhắc văn bản trên hình ảnh & video

SAM 3 hiện đã được tích hợp hoàn toàn vào ultralytics gói, cung cấp hỗ trợ gốc cho segment khái niệm với gợi ý văn bản, gợi ý ví dụ hình ảnh và khả năng theo dõi video (video track).

Tổng quan

SAM 3 đạt được hiệu suất tăng gấp 2 lần so với các hệ thống hiện có trong Phân đoạn Khái niệm có thể nhắc nhở (Promptable Concept Segmentation) đồng thời duy trì và cải thiện khả năng của SAM 2 đối với phân đoạn hình ảnh tương tác. Mô hình này vượt trội trong phân đoạn từ vựng mở, cho phép người dùng chỉ định các khái niệm bằng cách sử dụng các cụm danh từ đơn giản (ví dụ: "xe buýt trường học màu vàng", "mèo vằn") hoặc bằng cách cung cấp hình ảnh ví dụ về đối tượng mục tiêu. Những khả năng này bổ sung cho các quy trình sẵn sàng sản xuất dựa trên các quy trình predict và track được tối ưu hóa.

Phân khúc khái niệm có thể nhắc nhở (PCS) là gì?

Nhiệm vụ PCS lấy một gợi ý khái niệm làm đầu vào và trả về các mặt nạ phân đoạn với danh tính duy nhất cho tất cả các phiên bản đối tượng khớp . Gợi ý khái niệm có thể là:

- Văn bản : Cụm danh từ đơn giản như "táo đỏ" hoặc "người đội mũ", tương tự như học không bắn

- Ví dụ hình ảnh : Hộp giới hạn xung quanh các đối tượng ví dụ (tích cực hoặc tiêu cực) để khái quát hóa nhanh

- Kết hợp : Cả văn bản và hình ảnh mẫu cùng nhau để kiểm soát chính xác

Điều này khác với các nhắc nhở hình ảnh truyền thống (điểm, hộp, mặt nạ) chỉ phân đoạn một thể hiện đối tượng cụ thể duy nhất, như đã được phổ biến bởi dòng SAM gốc.

Các chỉ số hiệu suất chính

| Chỉ số | SAM 3 Thành tựu |

|---|---|

| LVIS Zero-shot Mask AP | 47,0 (so với mức tốt nhất trước đó là 38,5, cải thiện +22%) |

| Điểm chuẩn SA-Co | Tốt hơn 2 lần so với các hệ thống hiện có |

| Tốc độ suy luận (H200 GPU ) | 30 ms cho mỗi hình ảnh với hơn 100 đối tượng được phát hiện |

| Hiệu suất video | Gần như thời gian thực cho ~5 đối tượng đồng thời |

| Điểm chuẩn MOSEv2 VOS | 60,1 J&F (+25,5% so với SAM 2.1, +17% so với SOTA trước đó) |

| Tinh chỉnh Tương tác | Cải thiện CGF1 +18,6 sau 3 lần nhắc nhở mẫu |

| Khoảng cách hiệu suất của con người | Đạt 88% giới hạn dưới ước tính trên SA-Co/Vàng |

Để biết bối cảnh về số liệu mô hình và sự đánh đổi trong sản xuất, hãy xem thông tin chi tiết về đánh giá mô hình và số liệu hiệu suất YOLO .

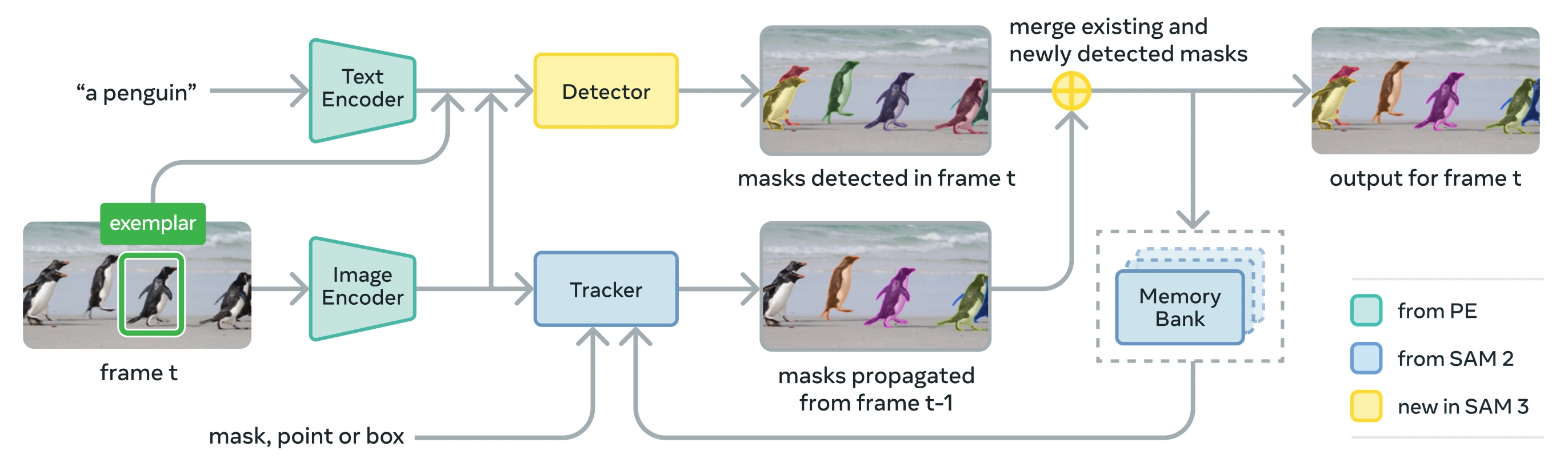

Kiến trúc

SAM 3 bao gồm một bộ phát hiện và bộ theo dõi chia sẻ xương sống thị giác của Bộ mã hóa Nhận thức (PE). Thiết kế tách biệt này tránh xung đột tác vụ, đồng thời cho phép phát hiện ở cấp độ hình ảnh và theo dõi ở cấp độ video, với giao diện tương thích với Ultralytics Sử dụng Python và sử dụng CLI .

Các Thành phần Cốt lõi

Máy dò : Kiến trúc dựa trên DETR để phát hiện khái niệm ở cấp độ hình ảnh

- Bộ mã hóa văn bản cho lời nhắc cụm danh từ

- Bộ mã hóa mẫu cho lời nhắc dựa trên hình ảnh

- Bộ mã hóa hợp nhất để điều kiện hóa các đặc điểm hình ảnh theo lời nhắc

- Sự hiện diện mới lạ tách biệt sự nhận dạng ("cái gì") khỏi sự định vị ("ở đâu")

- Đầu mặt nạ để tạo mặt nạ phân đoạn phiên bản

Tracker : Phân đoạn video dựa trên bộ nhớ được kế thừa từ SAM 2

- Bộ mã hóa nhắc nhở, bộ giải mã mặt nạ, bộ mã hóa bộ nhớ

- Ngân hàng bộ nhớ để lưu trữ hình dạng của vật thể trên các khung hình

- Sự phân biệt thời gian được hỗ trợ bởi các kỹ thuật như bộ lọc Kalman trong các thiết lập nhiều đối tượng

Mã thông báo hiện diện : Mã thông báo toàn cục đã học được dùng để dự đoán xem khái niệm mục tiêu có xuất hiện trong hình ảnh/khung hình hay không, cải thiện khả năng phát hiện bằng cách tách biệt nhận dạng khỏi định vị.

Những đổi mới quan trọng

- Nhận dạng và bản địa hóa tách biệt : Tiêu đề hiện diện dự đoán sự hiện diện của khái niệm trên toàn cầu, trong khi các truy vấn đề xuất chỉ tập trung vào bản địa hóa, tránh các mục tiêu xung đột.

- Khái niệm thống nhất và lời nhắc trực quan : Hỗ trợ cả PCS (lời nhắc khái niệm) và PVS (lời nhắc trực quan như SAM 2 nút bấm/hộp) trong một mô hình duy nhất.

- Tinh chỉnh mẫu tương tác : Người dùng có thể thêm mẫu hình ảnh dương hoặc âm để tinh chỉnh kết quả theo từng lần, với mô hình tổng quát hóa thành các đối tượng tương tự thay vì chỉ sửa từng trường hợp riêng lẻ.

- Phân biệt sự mơ hồ về thời gian : Sử dụng điểm phát hiện masklet và nhắc lại định kỳ để xử lý hiện tượng che khuất, cảnh đông đúc và lỗi theo dõi trong video, phù hợp với phân đoạn trường hợp và các phương pháp theo dõi tốt nhất.

Bộ dữ liệu SA-Co

SAM 3 được huấn luyện trên Segment Anything with Concepts (SA-Co), tập dữ liệu phân đoạn lớn nhất và đa dạng nhất của Meta cho đến nay, mở rộng vượt ra ngoài các điểm chuẩn phổ biến như COCO và LVIS.

Dữ liệu đào tạo

| Thành phần tập dữ liệu | Mô tả | Tỉ lệ |

|---|---|---|

| SA-Co/HQ | Dữ liệu hình ảnh chất lượng cao được chú thích bởi con người từ công cụ dữ liệu 4 pha | 5.2M ảnh, 4M cụm danh từ duy nhất |

| SA-Co/SYN | Bộ dữ liệu tổng hợp được gắn nhãn bởi AI mà không có sự tham gia của con người | 38M cụm danh từ, 1.4B mặt nạ |

| SA-Co/EXT | 15 bộ dữ liệu bên ngoài được làm phong phú với negative samples khó | Thay đổi tùy theo nguồn |

| SA-Co/VIDEO | Chú thích video với tính năng theo dõi thời gian | 52.5K video, 24.8K cụm danh từ duy nhất |

Dữ liệu chuẩn

Tiêu chuẩn đánh giá SA-Co bao gồm 214.000 cụm từ độc đáo trên 126.000 hình ảnh và video , cung cấp nhiều khái niệm hơn gấp 50 lần so với các tiêu chuẩn hiện có. Tiêu chuẩn này bao gồm:

- SA-Co/Gold : 7 miền, được chú thích ba lần để đo lường giới hạn hiệu suất của con người

- SA-Co/Silver : 10 miền, chú thích của một người

- SA-Co/Bronze và SA-Co/Bio : 9 tập dữ liệu hiện có được điều chỉnh để phân đoạn khái niệm

- SA-Co/VEval : Điểm chuẩn video với 3 miền (SA-V, YT-Temporal-1B, SmartGlasses)

Đổi mới công cụ dữ liệu

SAM Công cụ dữ liệu vòng lặp có thể mở rộng của con người và mô hình 3 đạt được thông lượng chú thích gấp 2 lần thông qua:

- Công cụ chú thích AI: Các mô hình dựa trên Llama đề xuất các cụm danh từ đa dạng bao gồm cả negative samples.

- Công cụ xác minh AI: LLM đa phương thức đã tinh chỉnh xác minh chất lượng mặt nạ và tính đầy đủ gần bằng hiệu suất của con người.

- Khai thác chủ động: Tập trung nỗ lực của con người vào các trường hợp lỗi đầy thách thức, nơi AI gặp khó khăn

- Dựa trên Ontology : Tận dụng một ontology lớn dựa trên Wikidata để bao quát khái niệm

Cài đặt

SAM 3 có sẵn trong Ultralytics phiên bản 8.3.237 và các phiên bản sau. Cài đặt hoặc nâng cấp với:

pip install -U ultralytics

Yêu cầu trọng số mô hình SAM 3

Không giống như các mô hình Ultralytics khác, trọng số của SAM 3 (sam3.pt) thì không được tự động tải xuống. Bạn phải yêu cầu quyền truy cập vào trọng số mô hình trên trang mô hình SAM 3 trên Hugging Face và sau đó, sau khi được phê duyệt, hãy tải xuống sam3.pt tệp. Đặt tệp đã tải xuống sam3.pt tệp trong thư mục làm việc của bạn hoặc chỉ định đường dẫn đầy đủ khi tải mô hình.

TypeError: 'SimpleTokenizer' object is not callable

Nếu bạn gặp lỗi trên trong quá trình dự đoán, điều đó có nghĩa là bạn đã nhập sai thông tin. clip Gói đã được cài đặt. Hãy cài đặt đúng gói cần thiết. clip đóng gói bằng cách chạy lệnh sau:

pip uninstall clip -y

pip install git+https://github.com/ultralytics/CLIP.git

Cách sử dụng SAM 3: Tính linh hoạt trong phân khúc khái niệm

SAM 3 hỗ trợ cả tác vụ Segment Khái niệm Có Thể Gợi ý (Promptable Concept Segmentation - PCS) và Segment Trực quan Có Thể Gợi ý (Promptable Visual Segmentation - PVS) thông qua các giao diện dự đoán khác nhau:

Nhiệm vụ và mô hình được hỗ trợ

| Loại nhiệm vụ | Các loại nhắc nhở | Đầu ra |

|---|---|---|

| Phân khúc khái niệm (PCS) | Văn bản (cụm danh từ), hình ảnh mẫu | Tất cả các trường hợp phù hợp với khái niệm |

| Phân đoạn thị giác (PVS) | Điểm, hộp, mặt nạ | Một thể hiện đối tượng đơn lẻ ( SAM 2 phong cách) |

| Tinh chỉnh Tương tác | Thêm/xóa các mẫu hoặc nhấp chuột theo từng bước | Phân đoạn tinh chỉnh với độ chính xác được cải thiện |

Ví dụ về phân đoạn khái niệm

Phân đoạn với lời nhắc văn bản

Phân đoạn khái niệm dựa trên văn bản

Tìm và segment tất cả các thực thể của một khái niệm bằng cách sử dụng mô tả văn bản. Lời nhắc văn bản yêu cầu SAM3SemanticPredictor giao diện.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor with configuration

overrides = dict(

conf=0.25,

task="segment",

mode="predict",

model="sam3.pt",

half=True, # Use FP16 for faster inference

save=True,

)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image once for multiple queries

predictor.set_image("path/to/image.jpg")

# Query with multiple text prompts

results = predictor(text=["person", "bus", "glasses"])

# Works with descriptive phrases

results = predictor(text=["person with red cloth", "person with blue cloth"])

# Query with a single concept

results = predictor(text=["a person"])

Phân đoạn với các ví dụ hình ảnh

Phân đoạn dựa trên mẫu hình ảnh

Sử dụng hộp giới hạn làm lời nhắc trực quan để tìm tất cả các thực thể tương tự. Điều này cũng yêu cầu SAM3SemanticPredictor để khớp dựa trên khái niệm.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True, save=True)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image

predictor.set_image("path/to/image.jpg")

# Provide bounding box examples to segment similar objects

results = predictor(bboxes=[[480.0, 290.0, 590.0, 650.0]])

# Multiple bounding boxes for different concepts

results = predictor(bboxes=[[539, 599, 589, 639], [343, 267, 499, 662]])

Suy luận dựa trên đặc trưng để tăng hiệu quả

Tái sử dụng các đặc trưng hình ảnh cho nhiều truy vấn

Trích xuất các đặc trưng hình ảnh một lần và tái sử dụng chúng cho nhiều truy vấn segment để cải thiện hiệu quả.

import cv2

from ultralytics.models.sam import SAM3SemanticPredictor

from ultralytics.utils.plotting import Annotator, colors

# Initialize predictors

overrides = dict(conf=0.50, task="segment", mode="predict", model="sam3.pt", verbose=False)

predictor = SAM3SemanticPredictor(overrides=overrides)

predictor2 = SAM3SemanticPredictor(overrides=overrides)

# Extract features from the first predictor

source = "path/to/image.jpg"

predictor.set_image(source)

src_shape = cv2.imread(source).shape[:2]

# Setup second predictor and reuse features

predictor2.setup_model()

# Perform inference using shared features with text prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, text=["person"])

# Perform inference using shared features with bounding box prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, bboxes=[[439, 437, 524, 709]])

# Visualize results

if masks is not None:

masks, boxes = masks.cpu().numpy(), boxes.cpu().numpy()

im = cv2.imread(source)

annotator = Annotator(im, pil=False)

annotator.masks(masks, [colors(x, True) for x in range(len(masks))])

cv2.imshow("result", annotator.result())

cv2.waitKey(0)

Phân khúc khái niệm video

Track các khái niệm trên video bằng hộp giới hạn

Track video bằng lời nhắc trực quan

Detect và track các thực thể đối tượng trên các khung video bằng cách sử dụng lời nhắc hộp giới hạn.

from ultralytics.models.sam import SAM3VideoPredictor

# Create video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True)

predictor = SAM3VideoPredictor(overrides=overrides)

# Track objects using bounding box prompts

results = predictor(source="path/to/video.mp4", bboxes=[[706.5, 442.5, 905.25, 555], [598, 635, 725, 750]], stream=True)

# Process and display results

for r in results:

r.show() # Display frame with segmentation masks

Track các khái niệm bằng lời nhắc văn bản

Track video bằng truy vấn ngữ nghĩa

Track tất cả các thực thể của các khái niệm được chỉ định bằng văn bản trên các khung video.

from ultralytics.models.sam import SAM3VideoSemanticPredictor

# Initialize semantic video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", imgsz=640, model="sam3.pt", half=True, save=True)

predictor = SAM3VideoSemanticPredictor(overrides=overrides)

# Track concepts using text prompts

results = predictor(source="path/to/video.mp4", text=["person", "bicycle"], stream=True)

# Process results

for r in results:

r.show() # Display frame with tracked objects

# Alternative: Track with bounding box prompts

results = predictor(

source="path/to/video.mp4",

bboxes=[[864, 383, 975, 620], [705, 229, 782, 402]],

labels=[1, 1], # Positive labels

stream=True,

)

Lời nhắc trực quan ( SAM 2 Khả năng tương thích)

SAM 3 duy trì khả năng tương thích ngược hoàn toàn với tính năng nhắc trực quan của SAM 2 cho segment đối tượng đơn lẻ:

SAM 2 Lời nhắc trực quan về phong cách

Cơ bản SAM giao diện hoạt động chính xác như SAM 2, chỉ segment khu vực cụ thể được chỉ định bởi các gợi ý trực quan (điểm, hộp hoặc mặt nạ).

from ultralytics import SAM

model = SAM("sam3.pt")

# Single point prompt - segments object at specific location

results = model.predict(source="path/to/image.jpg", points=[900, 370], labels=[1])

results[0].show()

# Multiple points - segments single object with multiple point hints

results = model.predict(source="path/to/image.jpg", points=[[400, 370], [900, 370]], labels=[1, 1])

# Box prompt - segments object within bounding box

results = model.predict(source="path/to/image.jpg", bboxes=[100, 150, 300, 400])

results[0].show()

Gợi ý Trực quan so với Segment Khái niệm

Sử dụng SAM("sam3.pt") với các gợi ý trực quan (điểm/hộp/mặt nạ) sẽ segment chỉ đối tượng cụ thể tại vị trí đó, giống như SAM 2. Để segment tất cả các thể hiện của một khái niệm, hãy sử dụng SAM3SemanticPredictor với gợi ý văn bản hoặc ví dụ như đã hiển thị ở trên.

Điểm chuẩn hiệu suất

Phân đoạn hình ảnh

SAM 3 đạt được kết quả tiên tiến nhất trên nhiều điểm chuẩn, bao gồm các tập dữ liệu thực tế như LVIS và COCO cho phân đoạn:

| Điểm chuẩn | Chỉ số | SAM 3 | Tốt nhất trước đó | Sự cải tiến |

|---|---|---|---|---|

| LVIS (không bắn) | Mask AP | 47.0 | 38.5 | +22.1% |

| SA-Co/Vàng | CGF1 | 65.0 | 34.3 (OWLv2) | +89.5% |

| COCO (zero-shot) | AP hộp | 53.5 | 52.2 (T-Rex2) | +2.5% |

| ADE-847 (phân đoạn ngữ nghĩa) | mIoU | 14.7 | 9.2 (APE-D) | +59.8% |

| PascalConcept-59 | mIoU | 59.4 | 58.5 (APE-D) | +1.5% |

| Cảnh quan thành phố (phân đoạn ngữ nghĩa) | mIoU | 65.1 | 44.2 (APE-D) | +47.3% |

Khám phá các tùy chọn tập dữ liệu để thử nghiệm nhanh trong tập dữ liệu Ultralytics .

Hiệu suất phân đoạn video

SAM 3 cho thấy sự cải thiện đáng kể so với SAM 2 và các tiêu chuẩn tiên tiến trước đó trên các video như DAVIS 2017 và YouTube-VOS :

| Điểm chuẩn | Chỉ số | SAM 3 | SAM 2.1 L | Sự cải tiến |

|---|---|---|---|---|

| MOSEv2 | J&F | 60.1 | 47.9 | +25.5% |

| DAVIS 2017 | J&F | 92.0 | 90.7 | +1.4% |

| LVOSv2 | J&F | 88.2 | 79.6 | +10.8% |

| SA-V | J&F | 84.6 | 78.4 | +7.9% |

| YTVOS19 | J&F | 89.6 | 89.3 | +0.3% |

Chuyển thể ít cảnh quay

SAM 3 vượt trội trong việc thích ứng với các lĩnh vực mới với số lượng ví dụ tối thiểu, phù hợp với quy trình làm việc AI lấy dữ liệu làm trung tâm :

| Điểm chuẩn | 0-shot AP | 10-shot AP | Thành tích tốt nhất trước đó (10 lần bắn) |

|---|---|---|---|

| ODinW13 | 59.9 | 71.6 | 67.9 (gDino1.5-Pro) |

| RF100-VL | 14.3 | 35.7 | 33.7 (gDino-T) |

Hiệu quả tinh chỉnh tương tác

SAM Việc gợi ý dựa trên khái niệm của 3 với các ví dụ hội tụ nhanh hơn nhiều so với gợi ý trực quan:

| Đã thêm lời nhắc | Điểm CGF1 | Tăng so với Chỉ văn bản | Lợi nhuận so với PVS cơ sở |

|---|---|---|---|

| Chỉ văn bản | 46.4 | đường cơ sở | đường cơ sở |

| +1 ví dụ | 57.6 | +11.2 | +6.7 |

| +2 ví dụ | 62.2 | +15.8 | +9.7 |

| +3 ví dụ | 65.0 | +18.6 | +11.2 |

| +4 ví dụ | 65.7 | +19.3 | +11.5 (cao nhất) |

Độ chính xác đếm đối tượng

SAM 3 cung cấp khả năng đếm chính xác bằng cách phân đoạn tất cả các trường hợp, một yêu cầu chung trong việc đếm đối tượng :

| Điểm chuẩn | Sự chính xác | MAE | so với MLLM tốt nhất |

|---|---|---|---|

| Đếm Bench | 95.6% | 0.11 | 92.4% (Gemini 2.5) |

| PixMo-Count | 87.3% | 0.22 | 88.8% (Molmo-72B) |

SAM 3 đấu với SAM 2 đấu với YOLO So sánh

Ở đây chúng ta so sánh SAM Khả năng của 3 với SAM 2 và các mẫu YOLO11 :

| Khả năng | SAM 3 | SAM 2 | YOLO11n-seg |

|---|---|---|---|

| Phân khúc khái niệm | ✅ Tất cả các trường hợp từ văn bản/ví dụ | ❌ Không được hỗ trợ | ❌ Không được hỗ trợ |

| Phân đoạn thị giác | ✅ Một trường hợp duy nhất ( SAM 2 tương thích) | ✅ Một trường hợp duy nhất | ✅ Tất cả các trường hợp |

| Khả năng bắn không phát nào | ✅ Mở rộng vốn từ vựng | ✅ Gợi ý hình học | ❌ Bộ đóng |

| Tinh chỉnh Tương tác | ✅ Mẫu + nhấp chuột | ✅ Chỉ nhấp chuột | ❌ Không được hỗ trợ |

| Theo dõi video | ✅ Nhiều đối tượng có danh tính | ✅ Nhiều đối tượng | ✅ Nhiều đối tượng |

| AP mặt nạ LVIS (zero-shot) | 47.0 | Không áp dụng | Không áp dụng |

| MOSEv2 J&F | 60.1 | 47.9 | Không áp dụng |

| Tốc độ suy luận (H200) | 30 ms (hơn 100 đối tượng) | ~23 ms (mỗi đối tượng) | 2-3 ms (hình ảnh) |

| Kích thước mô hình | 3.4GB | 162 MB (cơ bản) | 5.9 MB |

Những điểm chính cần ghi nhớ :

- SAM 3 : Tốt nhất cho việc phân đoạn khái niệm từ vựng mở, tìm tất cả các trường hợp của một khái niệm có văn bản hoặc lời nhắc mẫu

- SAM 2 : Tốt nhất cho phân đoạn đối tượng đơn lẻ tương tác trong hình ảnh và video với lời nhắc hình học

- YOLO11 : Tốt nhất cho phân đoạn thời gian thực, tốc độ cao trong các triển khai hạn chế tài nguyên bằng cách sử dụng các đường ống xuất hiệu quả như ONNX và TensorRT

Chỉ số đánh giá

SAM Phiên bản 3 giới thiệu các số liệu mới được thiết kế cho nhiệm vụ PCS, bổ sung cho các số liệu quen thuộc như điểm F1 , độ chính xác và khả năng thu hồi .

F1 có cổng phân loại (CGF1)

Chỉ số chính kết hợp giữa bản địa hóa và phân loại:

CGF1 = 100 × pmF1 × IL_MCC

Trong đó:

- pmF1 (F1 vĩ mô tích cực): Đo chất lượng bản địa hóa trên các ví dụ tích cực

- IL_MCC (Hệ số tương quan Matthews cấp độ hình ảnh): Đo độ chính xác của phân loại nhị phân ("khái niệm có tồn tại không?")

Tại sao lại có những số liệu này?

Các chỉ số AP truyền thống không tính đến hiệu chuẩn, khiến các mô hình khó sử dụng trong thực tế. Bằng cách chỉ đánh giá các dự đoán có độ tin cậy trên 0.5, các chỉ số của SAM 3 đảm bảo hiệu chuẩn tốt và mô phỏng các mẫu sử dụng trong thế giới thực trong các vòng lặp predict và track tương tác.

Những sự cắt bỏ quan trọng và hiểu biết sâu sắc

Tác động của sự hiện diện

Đầu hiện diện tách biệt khả năng nhận dạng khỏi khả năng định vị, mang lại những cải tiến đáng kể:

| Cấu hình | CGF1 | IL_MCC | chiềuF1 |

|---|---|---|---|

| Không có sự hiện diện | 57.6 | 0.77 | 74.7 |

| Với sự hiện diện | 63.3 | 0.82 | 77.1 |

Đầu hiện diện cung cấp sự tăng cường CGF1 +5,7 (+9,9%), chủ yếu cải thiện khả năng nhận dạng (IL_MCC +6,5%).

Tác động của những điều tiêu cực cứng

| Âm bản cứng/Hình ảnh | CGF1 | IL_MCC | chiềuF1 |

|---|---|---|---|

| 0 | 31.8 | 0.44 | 70.2 |

| 5 | 44.8 | 0.62 | 71.9 |

| 30 | 49.2 | 0.68 | 72.3 |

Những phủ định cứng rất quan trọng đối với việc nhận dạng từ vựng mở, cải thiện IL_MCC lên 54,5% (0,44 → 0,68).

Đào tạo dữ liệu mở rộng

| Nguồn dữ liệu | CGF1 | IL_MCC | chiềuF1 |

|---|---|---|---|

| Chỉ bên ngoài | 30.9 | 0.46 | 66.3 |

| Bên ngoài + Tổng hợp | 39.7 | 0.57 | 70.6 |

| Bên ngoài + HQ | 51.8 | 0.71 | 73.2 |

| Cả ba | 54.3 | 0.74 | 73.5 |

Chú thích chất lượng cao của con người mang lại lợi ích đáng kể so với dữ liệu tổng hợp hoặc dữ liệu bên ngoài. Để biết thêm thông tin về các phương pháp thực hành chất lượng dữ liệu, hãy xem phần thu thập và chú thích dữ liệu .

Các ứng dụng

SAM Khả năng phân đoạn khái niệm của 3 cho phép các trường hợp sử dụng mới:

- Kiểm duyệt nội dung : Tìm tất cả các trường hợp của các loại nội dung cụ thể trên các thư viện phương tiện

- Thương mại điện tử : Phân khúc tất cả các sản phẩm cùng loại trong hình ảnh danh mục, hỗ trợ chú thích tự động

- Chụp ảnh y tế : Xác định tất cả các trường hợp xuất hiện các loại mô hoặc bất thường cụ thể

- Hệ thống tự động : Theo dõi tất cả các trường hợp biển báo giao thông, người đi bộ hoặc phương tiện theo danh mục

- Phân tích Video: Đếm và track tất cả những người mặc trang phục cụ thể hoặc thực hiện các hành động

- Chú thích tập dữ liệu : Chú thích nhanh chóng tất cả các trường hợp của danh mục đối tượng hiếm

- Nghiên cứu khoa học : Định lượng và phân tích tất cả các mẫu vật phù hợp với tiêu chí cụ thể

SAM 3. Agent: Lý luận ngôn ngữ mở rộng

SAM 3 có thể được kết hợp với Mô hình ngôn ngữ lớn đa phương thức (MLLM) để xử lý các truy vấn phức tạp đòi hỏi phải suy luận, có tinh thần tương tự như các hệ thống từ vựng mở như OWLv2 và T-Rex .

Hiệu suất trên các nhiệm vụ lý luận

| Điểm chuẩn | Chỉ số | SAM 3 Đại lý (Gemini 2.5 Pro) | Tốt nhất trước đó |

|---|---|---|---|

| ReasonSeg (xác thực) | thế giới | 76.0 | 65.0 (SoTA) |

| ReasonSeg (kiểm tra) | thế giới | 73.8 | 61.3 (SoTA) |

| OmniLabel (xác thực) | AP | 46.7 | 36.5 (REAL) |

| Tham khảoCOCO+ | Acc | 91.2 | 89.3 (LISA) |

Ví dụ về truy vấn phức tạp

SAM 3. Agent có thể xử lý các truy vấn yêu cầu lý luận:

- "Người đang ngồi nhưng không cầm hộp quà trên tay"

- "Con chó gần máy ảnh nhất không đeo vòng cổ"

- "Vật thể màu đỏ lớn hơn bàn tay người"

MLLM đề xuất các truy vấn cụm danh từ đơn giản để SAM 3, phân tích các mặt nạ trả về và lặp lại cho đến khi hài lòng.

Hạn chế

Trong khi SAM 3 là một bước tiến lớn, nhưng nó có một số hạn chế nhất định:

- Độ phức tạp của cụm từ : Phù hợp nhất với các cụm danh từ đơn giản; các biểu thức tham chiếu dài hoặc lập luận phức tạp có thể yêu cầu tích hợp MLLM

- Xử lý sự mơ hồ: Một số khái niệm vốn dĩ vẫn mơ hồ (ví dụ: "cửa sổ nhỏ", "phòng ấm cúng")

- Yêu cầu tính toán : Lớn hơn và chậm hơn so với các mô hình phát hiện chuyên biệt như YOLO

- Phạm vi từ vựng : Tập trung vào các khái niệm trực quan nguyên tử; lý luận về thành phần bị hạn chế nếu không có sự hỗ trợ của MLLM

- Các khái niệm hiếm : Hiệu suất có thể giảm sút trên các khái niệm cực kỳ hiếm hoặc chi tiết không được thể hiện tốt trong dữ liệu đào tạo

Trích dẫn

@inproceedings{sam3_2025,

title = {SAM 3: Segment Anything with Concepts},

author = {Anonymous authors},

booktitle = {Submitted to ICLR 2026},

year = {2025},

url = {https://openreview.net/forum?id=r35clVtGzw},

note = {Paper ID: 4183, under double-blind review}

}

Câu hỏi thường gặp

SAM 3 Được Phát Hành Khi Nào?

SAM 3 được Meta phát hành vào ngày 20 tháng 11 năm 2025 và đã được tích hợp hoàn toàn vào Ultralytics kể từ phiên bản 8.3.237 (PR #22897). Hỗ trợ đầy đủ có sẵn cho chế độ dự đoán (predict mode) và chế độ theo dõi (track mode).

SAM 3 Đã Được Tích Hợp Vào Ultralytics Chưa?

Vâng! SAM 3 được tích hợp hoàn toàn vào gói Ultralytics Python, bao gồm phân đoạn khái niệm, các lời nhắc trực quan kiểu SAM 2 và theo dõi video đa đối tượng.

Phân khúc khái niệm có thể nhắc nhở (PCS) là gì?

PCS là một nhiệm vụ mới được giới thiệu trong SAM 3 phân đoạn tất cả các trường hợp của một khái niệm trực quan trong hình ảnh hoặc video. Không giống như phân đoạn truyền thống nhắm vào một trường hợp đối tượng cụ thể, PCS tìm thấy mọi trường hợp xuất hiện của một danh mục. Ví dụ:

- Lời nhắc văn bản : "xe buýt trường học màu vàng" → phân đoạn tất cả xe buýt trường học màu vàng trong cảnh

- Ví dụ hình ảnh : Hộp xung quanh một con chó → phân đoạn tất cả các con chó trong hình ảnh

- Kết hợp : "mèo sọc" + hộp mẫu → phân đoạn tất cả các con mèo sọc phù hợp với ví dụ

Xem thông tin liên quan về phát hiện đối tượng và phân đoạn phiên bản .

Làm thế nào SAM 3 Khác biệt với SAM 2?

| Tính năng | SAM 2 | SAM 3 |

|---|---|---|

| Tác vụ | Một đối tượng duy nhất cho mỗi lời nhắc | Tất cả các trường hợp của một khái niệm |

| Các loại nhắc nhở | Điểm, hộp, mặt nạ | + Các cụm từ văn bản, các ví dụ về hình ảnh |

| Khả năng phát hiện | Yêu cầu máy dò bên ngoài | Bộ dò từ vựng mở tích hợp |

| Sự công nhận | Chỉ dựa trên hình học | Nhận dạng văn bản và hình ảnh |

| Kiến trúc | Chỉ theo dõi | Máy dò + Theo dõi có đầu hiện diện |

| Hiệu suất Zero-Shot | Không áp dụng (yêu cầu có lời nhắc trực quan) | 47.0 AP trên LVIS, tốt hơn 2 lần trên SA-Co |

| Tinh chỉnh Tương tác | Chỉ nhấp chuột | Nhấp chuột + khái quát mẫu |

SAM Phiên bản 3 vẫn duy trì khả năng tương thích ngược với chức năng nhắc nhở trực quan SAM 2 đồng thời bổ sung thêm các khả năng dựa trên khái niệm.

Những tập dữ liệu nào được sử dụng để đào tạo SAM 3?

SAM 3 được đào tạo trên tập dữ liệu Segment Anything with Concepts (SA-Co) :

Dữ liệu đào tạo :

- 5,2 triệu hình ảnh với 4 triệu cụm danh từ riêng biệt (SA-Co/HQ) - chú thích chất lượng cao của con người

- 52,5 nghìn video với 24,8 nghìn cụm danh từ duy nhất (SA-Co/VIDEO)

- 1,4B mặt nạ tổng hợp trên 38 triệu cụm danh từ (SA-Co/SYN)

- 15 tập dữ liệu bên ngoài được làm giàu với các kết quả âm tính cứng (SA-Co/EXT)

Dữ liệu chuẩn :

- 214 nghìn khái niệm độc đáo trên 126 nghìn hình ảnh/video

- Nhiều khái niệm hơn 50 lần so với các chuẩn mực hiện có (ví dụ: LVIS có ~4K khái niệm)

- Chú thích ba lần trên SA-Co/Gold để đo lường giới hạn hiệu suất của con người

Quy mô lớn và sự đa dạng này cho phép SAM Khả năng khái quát hóa vượt trội của 3 trên các khái niệm từ vựng mở.

Làm thế nào SAM 3 so sánh với YOLO11 để phân khúc?

SAM 3 và YOLO11 phục vụ các trường hợp sử dụng khác nhau:

Ưu điểm của SAM 3 :

- Từ vựng mở : Phân đoạn bất kỳ khái niệm nào thông qua lời nhắc văn bản mà không cần đào tạo

- Zero-shot : Hoạt động trên các danh mục mới ngay lập tức

- Tương tác : Tinh chỉnh dựa trên ví dụ được khái quát hóa thành các đối tượng tương tự

- Dựa trên khái niệm : Tự động tìm tất cả các trường hợp của một danh mục

- Độ chính xác: 47.0 AP trên phân đoạn instance zero-shot LVIS

Ưu điểm của YOLO11 :

- Tốc độ : Suy luận nhanh hơn 10-15 lần (2-3ms so với 30ms cho mỗi hình ảnh)

- Hiệu quả: Mô hình nhỏ hơn 576 lần (5.9MB so với 3.4GB)

- Thân thiện với tài nguyên : Chạy trên các thiết bị biên và thiết bị di động

- Thời gian thực : Được tối ưu hóa cho việc triển khai sản xuất

Sự giới thiệu :

- Sử dụng SAM 3 để phân đoạn từ vựng linh hoạt, mở khi bạn cần tìm tất cả các trường hợp khái niệm được mô tả bằng văn bản hoặc ví dụ

- Sử dụng YOLO11 cho các triển khai sản xuất tốc độ cao, nơi các danh mục được biết trước

- Sử dụng SAM 2 để phân đoạn đối tượng đơn lẻ tương tác với các gợi ý hình học

Có thể SAM 3 xử lý các truy vấn ngôn ngữ phức tạp?

SAM 3 được thiết kế cho các cụm danh từ đơn giản (ví dụ: "táo đỏ", "người đội mũ"). Đối với các truy vấn phức tạp đòi hỏi lý luận, hãy kết hợp SAM 3 với MLLM là Đại lý SAM 3 :

Các truy vấn đơn giản ( SAM 3 gốc) :

- "Xe buýt trường học màu vàng"

- "Mèo vằn"

- "Người đội mũ đỏ"

Các truy vấn phức tạp ( SAM 3 Agent với MLLM) :

- "Người đang ngồi nhưng không cầm hộp quà"

- "Con chó gần máy ảnh nhất không có vòng cổ"

- "Vật thể màu đỏ lớn hơn bàn tay người"

SAM 3 Đại lý đạt được 76,0 gIoU trên xác thực ReasonSeg (so với 65,0 gIoU tốt nhất trước đó, cải thiện +16,9%) bằng cách kết hợp SAM Phân đoạn 3 với khả năng suy luận MLLM.

Độ chính xác là bao nhiêu? SAM 3 so với hiệu suất của con người?

Trên chuẩn SA-Co/Gold với chú thích của ba con người:

- Giới hạn dưới của con người : 74,2 CGF1 (người chú thích bảo thủ nhất)

- Hiệu suất SAM 3 : 65.0 CGF1

- Thành tựu: 88% so với ước tính cận dưới của con người

- Giới hạn trên của con người : 81,4 CGF1 (người chú thích tự do nhất)

SAM 3 đạt hiệu suất cao, gần đạt độ chính xác ngang bằng con người trong phân đoạn khái niệm từ vựng mở, với khoảng cách chủ yếu ở các khái niệm mơ hồ hoặc chủ quan (ví dụ: "cửa sổ nhỏ", "phòng ấm cúng").