使用 Ultralytics 进行 K 折交叉验证

简介

本综合指南阐述了如何在 Ultralytics 生态系统中为目标检测数据集实现 K 折交叉验证。我们将利用 YOLO detect 格式和关键的 Python 库,如 sklearn、Pandas 和 PyYAML,引导您完成必要的设置、特征向量生成过程以及 K 折数据集划分的执行。

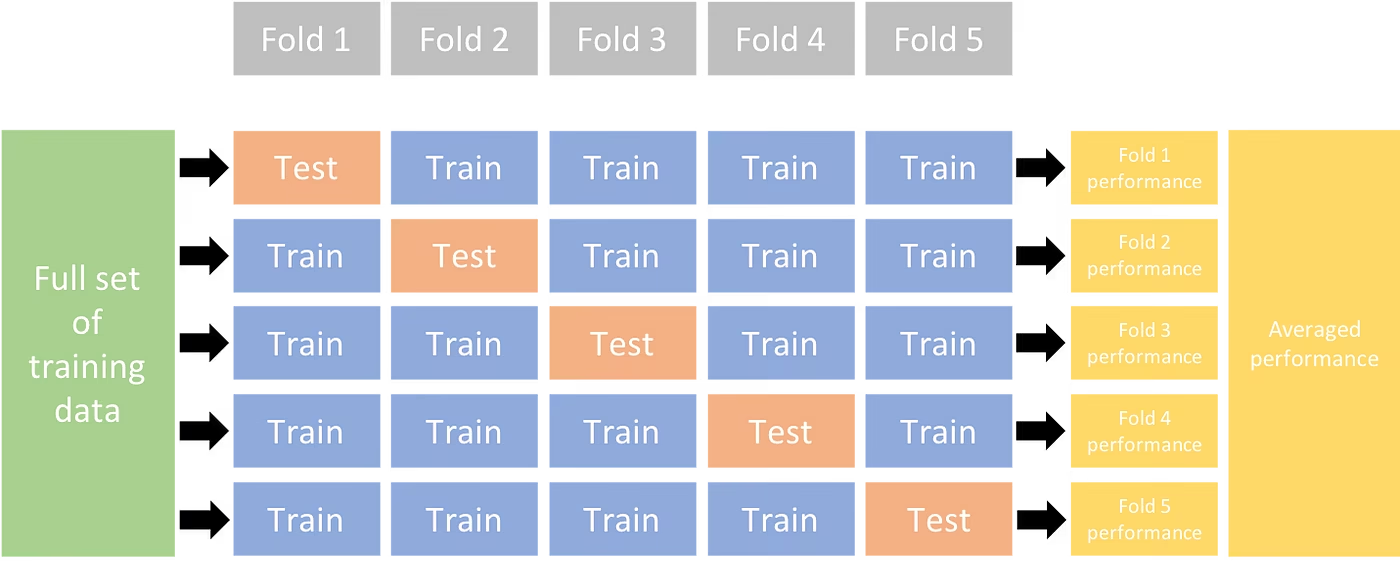

无论您的项目涉及 Fruit Detection 数据集还是自定义数据源,本教程旨在帮助您理解和应用 K-Fold 交叉验证,以增强您的 机器学习 模型。当我们应用 k=5 此教程的 folds,请记住,最佳 folds 数量可能因您的数据集和项目的具体情况而异。

让我们开始吧。

设置

您的标注应采用 YOLO 检测格式。

本指南假定注释文件在本地可用。

在我们的演示中,我们使用 水果检测 数据集。

- 此数据集总共包含 8479 张图像。

- 它包括 6 个类别标签,每个标签的总实例计数如下所示。

| 类标签 | 实例计数 |

|---|---|

| Apple | 7049 |

| 葡萄 | 7202 |

| 菠萝 | 1613 |

| 橙色 | 15549 |

| 香蕉 | 3536 |

| 西瓜 | 1976 |

必要的 python 包包括:

ultralyticssklearnpandaspyyaml

本教程适用于

k=5folds。但是,您应该确定最适合您特定数据集的 folds 数量。启动一个新的 python 虚拟环境(

venv),并激活它。使用pip(或您喜欢的包管理器)来安装:- Ultralytics 库:

pip install -U ultralytics。或者,您可以克隆官方的 仓库. - Scikit-learn、pandas 和 PyYAML:

pip install -U scikit-learn pandas pyyaml.

- Ultralytics 库:

验证您的标注是否为 YOLO 检测格式。

- 在本教程中,所有标注文件都位于

Fruit-Detection/labels目录。

- 在本教程中,所有标注文件都位于

为对象检测数据集生成特征向量

首先创建一个新的

example.py以下步骤的 Python 文件。继续检索数据集的所有标签文件。

from pathlib import Path dataset_path = Path("./Fruit-detection") # replace with 'path/to/dataset' for your custom data labels = sorted(dataset_path.rglob("*labels/*.txt")) # all data in 'labels'现在,读取数据集 YAML 文件的内容并提取类标签的索引。

import yaml yaml_file = "path/to/data.yaml" # your data YAML with data directories and names dictionary with open(yaml_file, encoding="utf8") as y: classes = yaml.safe_load(y)["names"] cls_idx = sorted(classes.keys())初始化一个空的

pandasDataFrame。import pandas as pd index = [label.stem for label in labels] # uses base filename as ID (no extension) labels_df = pd.DataFrame([], columns=cls_idx, index=index)统计标注文件中存在的每个类标签的实例数。

from collections import Counter for label in labels: lbl_counter = Counter() with open(label) as lf: lines = lf.readlines() for line in lines: # classes for YOLO label uses integer at first position of each line lbl_counter[int(line.split(" ", 1)[0])] += 1 labels_df.loc[label.stem] = lbl_counter labels_df = labels_df.fillna(0.0) # replace `nan` values with `0.0`以下是已填充 DataFrame 的示例视图:

0 1 2 3 4 5 '0000a16e4b057580_jpg.rf.00ab48988370f64f5ca8ea4...' 0.0 0.0 0.0 0.0 0.0 7.0 '0000a16e4b057580_jpg.rf.7e6dce029fb67f01eb19aa7...' 0.0 0.0 0.0 0.0 0.0 7.0 '0000a16e4b057580_jpg.rf.bc4d31cdcbe229dd022957a...' 0.0 0.0 0.0 0.0 0.0 7.0 '00020ebf74c4881c_jpg.rf.508192a0a97aa6c4a3b6882...' 0.0 0.0 0.0 1.0 0.0 0.0 '00020ebf74c4881c_jpg.rf.5af192a2254c8ecc4188a25...' 0.0 0.0 0.0 1.0 0.0 0.0 ... ... ... ... ... ... ... 'ff4cd45896de38be_jpg.rf.c4b5e967ca10c7ced3b9e97...' 0.0 0.0 0.0 0.0 0.0 2.0 'ff4cd45896de38be_jpg.rf.ea4c1d37d2884b3e3cbce08...' 0.0 0.0 0.0 0.0 0.0 2.0 'ff5fd9c3c624b7dc_jpg.rf.bb519feaa36fc4bf630a033...' 1.0 0.0 0.0 0.0 0.0 0.0 'ff5fd9c3c624b7dc_jpg.rf.f0751c9c3aa4519ea3c9d6a...' 1.0 0.0 0.0 0.0 0.0 0.0 'fffe28b31f2a70d4_jpg.rf.7ea16bd637ba0711c53b540...' 0.0 6.0 0.0 0.0 0.0 0.0

行索引标签文件,每个文件对应于数据集中的一个图像,列对应于您的类标签索引。每一行代表一个伪特征向量,其中包含数据集中存在的每个类标签的计数。这种数据结构使得可以将K-Fold 交叉验证应用于目标检测数据集。

K 折数据集分割

现在我们将使用

KFold类,来自sklearn.model_selection生成k数据集的分割。- 重要提示:

- 设置

shuffle=True确保在您的分割中随机分配类。 - 通过设置

random_state=M其中M是一个选定的整数,您可以获得可重复的结果。

- 设置

import random from sklearn.model_selection import KFold random.seed(0) # for reproducibility ksplit = 5 kf = KFold(n_splits=ksplit, shuffle=True, random_state=20) # setting random_state for repeatable results kfolds = list(kf.split(labels_df))- 重要提示:

数据集现已拆分为

kfolds,每个 fold 都有一个列表,其中包含train和val索引。我们将构建一个DataFrame来更清晰地展示这些结果。folds = [f"split_{n}" for n in range(1, ksplit + 1)] folds_df = pd.DataFrame(index=index, columns=folds) for i, (train, val) in enumerate(kfolds, start=1): folds_df[f"split_{i}"].loc[labels_df.iloc[train].index] = "train" folds_df[f"split_{i}"].loc[labels_df.iloc[val].index] = "val"现在,我们将计算每个fold的类标签分布,作为类中存在的类的比率

val到那些存在于train.fold_lbl_distrb = pd.DataFrame(index=folds, columns=cls_idx) for n, (train_indices, val_indices) in enumerate(kfolds, start=1): train_totals = labels_df.iloc[train_indices].sum() val_totals = labels_df.iloc[val_indices].sum() # To avoid division by zero, we add a small value (1E-7) to the denominator ratio = val_totals / (train_totals + 1e-7) fold_lbl_distrb.loc[f"split_{n}"] = ratio理想情况下,所有类别的比例在每个分割中以及不同类别之间都应合理地相似。然而,这会受到数据集具体情况的影响。

接下来,我们为每个拆分创建目录和数据集 YAML 文件。

import datetime supported_extensions = [".jpg", ".jpeg", ".png"] # Initialize an empty list to store image file paths images = [] # Loop through supported extensions and gather image files for ext in supported_extensions: images.extend(sorted((dataset_path / "images").rglob(f"*{ext}"))) # Create the necessary directories and dataset YAML files save_path = Path(dataset_path / f"{datetime.date.today().isoformat()}_{ksplit}-Fold_Cross-val") save_path.mkdir(parents=True, exist_ok=True) ds_yamls = [] for split in folds_df.columns: # Create directories split_dir = save_path / split split_dir.mkdir(parents=True, exist_ok=True) (split_dir / "train" / "images").mkdir(parents=True, exist_ok=True) (split_dir / "train" / "labels").mkdir(parents=True, exist_ok=True) (split_dir / "val" / "images").mkdir(parents=True, exist_ok=True) (split_dir / "val" / "labels").mkdir(parents=True, exist_ok=True) # Create dataset YAML files dataset_yaml = split_dir / f"{split}_dataset.yaml" ds_yamls.append(dataset_yaml) with open(dataset_yaml, "w") as ds_y: yaml.safe_dump( { "path": split_dir.as_posix(), "train": "train", "val": "val", "names": classes, }, ds_y, )最后,将图像和标签复制到每个分割的相应目录('train' 或 'val')中。

- 注意: 代码的这一部分所需的时间将根据数据集的大小和系统硬件而有所不同。

import shutil from tqdm import tqdm for image, label in tqdm(zip(images, labels), total=len(images), desc="Copying files"): for split, k_split in folds_df.loc[image.stem].items(): # Destination directory img_to_path = save_path / split / k_split / "images" lbl_to_path = save_path / split / k_split / "labels" # Copy image and label files to new directory (SamefileError if file already exists) shutil.copy(image, img_to_path / image.name) shutil.copy(label, lbl_to_path / label.name)

保存记录(可选)

作为可选项,您可以将 K-Fold 拆分和标签分布 DataFrame 的记录保存为 CSV 文件,以供将来参考。

folds_df.to_csv(save_path / "kfold_datasplit.csv")

fold_lbl_distrb.to_csv(save_path / "kfold_label_distribution.csv")

使用 K 折数据分割训练 YOLO

首先,加载 YOLO 模型。

from ultralytics import YOLO weights_path = "path/to/weights.pt" # use yolo26n.pt for a small model model = YOLO(weights_path, task="detect")接下来,遍历数据集 YAML 文件以运行训练。结果将保存到由以下内容指定的目录中

project和name参数。默认情况下,此目录是'runs/detect/train#',其中#是一个整数索引。results = {} # Define your additional arguments here batch = 16 project = "kfold_demo" epochs = 100 for k, dataset_yaml in enumerate(ds_yamls): model = YOLO(weights_path, task="detect") results[k] = model.train( data=dataset_yaml, epochs=epochs, batch=batch, project=project, name=f"fold_{k + 1}" ) # include any additional train arguments您还可以使用 Ultralytics data.utils.autosplit 函数来自动分割数据集:

from ultralytics.data.split import autosplit # Automatically split dataset into train/val/test autosplit(path="path/to/images", weights=(0.8, 0.2, 0.0), annotated_only=True)

结论

在本指南中,我们探讨了使用 K-Fold 交叉验证来训练 YOLO 对象检测模型的过程。我们学习了如何将我们的数据集分成 K 个分区,确保不同折叠之间的平衡类分布。

我们还探讨了创建报告 DataFrame 的过程,以可视化数据分割以及这些分割中的标签分布,从而使我们能够清楚地了解训练集和验证集的结构。

作为可选项,我们保存了记录以供将来参考,这在大型项目中或在排除模型性能故障时特别有用。

最后,我们使用循环中的每个分割实现了实际的模型训练,保存我们的训练结果以供进一步分析和比较。

K折交叉验证是一种充分利用现有数据的可靠方法,它有助于确保您的模型性能在不同的数据子集上保持可靠和一致。 这样可以得到一个更具泛化能力和更可靠的模型,从而降低模型过拟合特定数据模式的可能性。

请记住,尽管本指南中使用了YOLO,但这些步骤大多可迁移到其他机器学习模型。理解这些步骤将使您能够在自己的机器学习项目中有效地应用交叉验证。

常见问题

什么是 K 折交叉验证?为什么它在目标检测中很有用?

K-折交叉验证是一种将数据集分成“k”个子集(折叠)以更可靠地评估模型性能的技术。每个折叠都用作训练和 验证数据。在对象检测的上下文中,使用 K-折交叉验证有助于确保您的 Ultralytics YOLO 模型的性能在不同的数据分割中是稳健且可推广的,从而提高其可靠性。有关使用 Ultralytics YOLO 设置 K-折交叉验证的详细说明,请参阅 使用 Ultralytics 的 K-折交叉验证。

如何使用 Ultralytics YOLO 实现 K 折交叉验证?

要使用 Ultralytics YOLO 实施 K 折交叉验证,您需要按照以下步骤操作:

- 验证标注是否为 YOLO 检测格式。

- 使用诸如以下的 python 库

sklearn,pandas和pyyaml. - 从您的数据集创建特征向量。

- 使用以下方式拆分数据集

KFold从sklearn.model_selection. - 在每个分割上训练 YOLO 模型。

有关全面的指南,请参阅我们文档中的K-Fold 数据集分割部分。

为什么我应该使用 Ultralytics YOLO 进行目标检测?

Ultralytics YOLO提供最先进、高精度和高效率的实时目标检测。它功能多样,支持detect、segmentation和分类等多种计算机视觉任务。此外,它与Ultralytics Platform等工具无缝集成,可实现无代码模型训练和部署。欲了解更多详情,请访问我们的Ultralytics YOLO页面,探索其优势和功能。

如何确保我的标注格式对于 Ultralytics YOLO 是正确的?

您的标注应遵循 YOLO 检测格式。每个标注文件必须列出对象类别,以及其在图像中的边界框坐标。YOLO 格式确保了用于训练对象检测模型的精简和标准化数据处理。有关正确标注格式的更多信息,请访问YOLO 检测格式指南。

除了水果检测之外,我是否可以将K折交叉验证用于自定义数据集?

是的,只要标注采用 YOLO 检测格式,您就可以将 K-Fold 交叉验证用于任何自定义数据集。将数据集路径和类别标签替换为您自定义数据集的特定路径和标签。这种灵活性确保了任何对象检测项目都可以从使用 K-Fold 交叉验证的强大模型评估中受益。有关实际示例,请查看我们的Generating Feature Vectors部分。