أفضل ممارسات تعلم الآلة ونصائح لتدريب النماذج

مقدمة

تعد إحدى أهم الخطوات عند العمل على مشروع رؤية الكمبيوتر هي تدريب النموذج. قبل الوصول إلى هذه الخطوة، تحتاج إلى تحديد أهدافك و جمع بياناتك وتصنيفها. بعد معالجة البيانات مسبقًا للتأكد من أنها نظيفة ومتسقة، يمكنك الانتقال إلى تدريب النموذج الخاص بك.

شاهد: نصائح حول تدريب النموذج | كيفية التعامل مع مجموعات البيانات الكبيرة | حجم الدفعة، واستخدام وحدة معالجة الرسومات (GPU) و الدقة المختلطة

إذًا، ما هو تدريب النموذج؟ تدريب النموذج هو عملية تعليم النموذج الخاص بك للتعرف على الأنماط المرئية وإجراء تنبؤات بناءً على بياناتك. إنه يؤثر بشكل مباشر على أداء ودقة تطبيقك. في هذا الدليل، سنغطي أفضل الممارسات وتقنيات التحسين ونصائح استكشاف الأخطاء وإصلاحها لمساعدتك في تدريب نماذج رؤية الكمبيوتر الخاصة بك بشكل فعال.

كيفية تدريب نموذج تعلم الآلة

يتم تدريب نموذج رؤية الكمبيوتر عن طريق تعديل معلماته الداخلية لتقليل الأخطاء. في البداية، يتم تزويد النموذج بمجموعة كبيرة من الصور المصنفة. ويقوم بعمل تنبؤات حول محتوى هذه الصور، وتتم مقارنة التنبؤات بالتصنيفات أو المحتويات الفعلية لحساب الأخطاء. تُظهر هذه الأخطاء مدى بعد تنبؤات النموذج عن القيم الحقيقية.

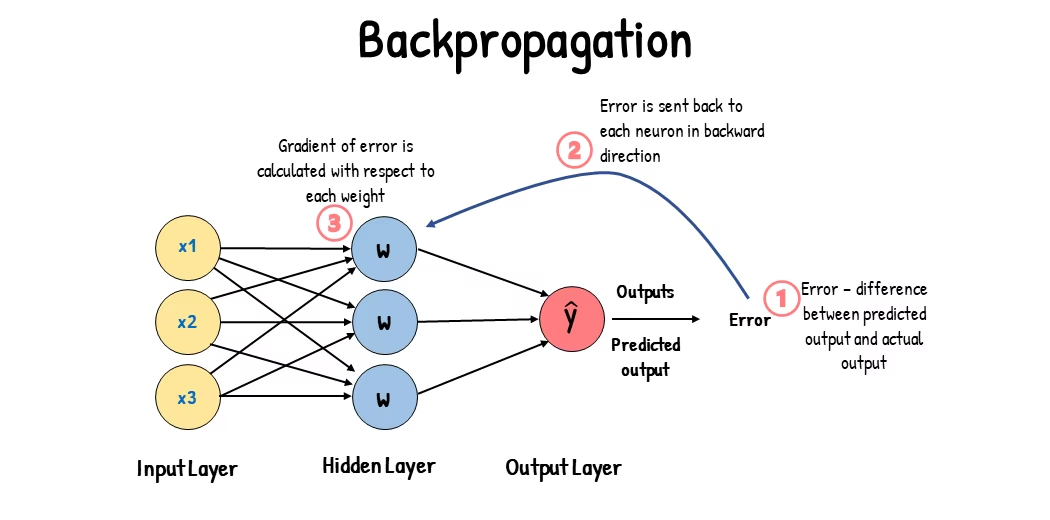

أثناء التدريب، يقوم النموذج بشكل متكرر بعمل تنبؤات، وحساب الأخطاء، وتحديث معلماته من خلال عملية تسمى الانتشار الخلفي. في هذه العملية، يقوم النموذج بضبط معلماته الداخلية (الأوزان والانحيازات) لتقليل الأخطاء. من خلال تكرار هذه الدورة عدة مرات، يحسن النموذج دقته تدريجيًا. بمرور الوقت، يتعلم التعرف على الأنماط المعقدة مثل الأشكال والألوان والقوام.

تتيح عملية التعلم هذه لنموذج رؤية الكمبيوتر أداء مهام مختلفة، بما في ذلك الكشف عن الأجسام و تجزئة المثيلات و تصنيف الصور. الهدف النهائي هو إنشاء نموذج يمكنه تعميم تعلمه على صور جديدة غير مرئية حتى يتمكن من فهم البيانات المرئية بدقة في تطبيقات العالم الحقيقي.

الآن بعد أن عرفنا ما يحدث خلف الكواليس عندما نقوم بتدريب نموذج، دعنا نلقي نظرة على النقاط التي يجب مراعاتها عند تدريب نموذج.

التدريب على مجموعات البيانات الكبيرة

هناك بعض الجوانب المختلفة التي يجب التفكير فيها عندما تخطط لاستخدام مجموعة بيانات كبيرة لتدريب نموذج. على سبيل المثال، يمكنك ضبط حجم الدفعة، والتحكم في استخدام وحدة معالجة الرسومات (GPU)، واختيار استخدام التدريب متعدد المقاييس، وما إلى ذلك. دعنا نتناول كل خيار من هذه الخيارات بالتفصيل.

حجم الدفعة واستخدام وحدة معالجة الرسومات (GPU)

عند تدريب النماذج على مجموعات بيانات كبيرة، يعد الاستخدام الفعال لوحدة معالجة الرسومات (GPU) أمرًا أساسيًا. حجم الدفعة (Batch size) هو عامل مهم. وهو عدد عينات البيانات التي يعالجها نموذج تعلم الآلة في تكرار تدريب واحد. باستخدام الحد الأقصى لحجم الدفعة الذي تدعمه وحدة معالجة الرسومات (GPU) الخاصة بك، يمكنك الاستفادة الكاملة من قدراتها وتقليل الوقت الذي يستغرقه تدريب النموذج. ومع ذلك، يجب تجنب نفاد ذاكرة وحدة معالجة الرسومات (GPU). إذا واجهت أخطاء في الذاكرة، فقلل حجم الدفعة تدريجيًا حتى يتدرب النموذج بسلاسة.

شاهد: كيفية استخدام الاستدلال الدفعي مع Ultralytics YOLO26 | تسريع اكتشاف الكائنات في python 🎉

فيما يتعلق بـ YOLO26، يمكنك تعيين الـ batch_size المعلمة في تهيئة التدريب لتتناسب مع سعة وحدة معالجة الرسومات GPU الخاصة بك. أيضًا، تعيين batch=-1 في سكريبت التدريب الخاص بك سيحدد تلقائيًا حجم الدفعة التي يمكن معالجتها بكفاءة بناءً على قدرات جهازك. من خلال الضبط الدقيق لحجم الدفعة، يمكنك تحقيق أقصى استفادة من موارد GPU الخاصة بك وتحسين عملية التدريب بشكل عام.

التدريب على مجموعة فرعية

التدريب على مجموعة فرعية هو استراتيجية ذكية تتضمن تدريب النموذج الخاص بك على مجموعة بيانات أصغر تمثل مجموعة البيانات الأكبر. يمكن أن يوفر الوقت والموارد، خاصة أثناء التطوير الأولي للنموذج واختباره. إذا كنت تعاني من ضيق الوقت أو تجرب تكوينات نماذج مختلفة، فإن التدريب على مجموعة فرعية يعد خيارًا جيدًا.

عندما يتعلق الأمر بـ YOLO26، يمكنك بسهولة تطبيق تدريب المجموعات الفرعية باستخدام الـ fraction المعلمة. تتيح لك هذه المعلمة تحديد الجزء الذي تريد استخدامه من مجموعة البيانات الخاصة بك للتدريب. على سبيل المثال، ضبط fraction=0.1 سوف يقوم بتدريب النموذج الخاص بك على 10٪ من البيانات. يمكنك استخدام هذه التقنية للتكرارات السريعة وضبط النموذج الخاص بك قبل الالتزام بتدريب نموذج باستخدام مجموعة بيانات كاملة. يساعدك التدريب على مجموعة فرعية في إحراز تقدم سريع وتحديد المشكلات المحتملة في وقت مبكر.

التدريب متعدد المقاييس

التدريب متعدد المقاييس هو تقنية تعمل على تحسين قدرة النموذج الخاص بك على التعميم من خلال تدريبه على صور بأحجام مختلفة. يمكن لنموذجك أن يتعلم اكتشاف الكائنات بمقاييس ومسافات مختلفة ويصبح أكثر قوة.

على سبيل المثال، عند تدريب YOLO26، يمكنك تمكين التدريب متعدد المقاييس عن طريق تعيين الـ scale المعلمة. تقوم هذه المعلمة بضبط حجم صور التدريب بمعامل محدد، مما يحاكي الكائنات على مسافات مختلفة. على سبيل المثال، ضبط scale=0.5 يقوم بتكبير صور التدريب عشوائيًا بمعامل يتراوح بين 0.5 و 1.5 أثناء التدريب. يتيح تكوين هذه المعلمة لنموذجك تجربة مجموعة متنوعة من مقاييس الصور وتحسين قدرات الكشف الخاصة به عبر أحجام وسيناريوهات مختلفة للكائنات.

تدعم Ultralytics التدريب متعدد المقاييس لحجم الصور عبر multi_scale المعلمة. على عكس scale، الذي يقوم بتكبير الصور ثم يعيد تعديلها/قصها إلى imgsz, multi_scale التغييرات imgsz كل دفعة (مقربة إلى خطوة النموذج). على سبيل المثال، مع imgsz=640 و multi_scale=0.25، يتم أخذ عينات من حجم التدريب من 480 إلى 800 بخطوات متتالية (على سبيل المثال، 480، 512، 544، ...، 800)، بينما multi_scale=0.0 يحافظ على حجم ثابت.

التخزين المؤقت

التخزين المؤقت هو أسلوب مهم لتحسين كفاءة تدريب نماذج تعلم الآلة. من خلال تخزين الصور التي تمت معالجتها مسبقًا في الذاكرة، يقلل التخزين المؤقت من الوقت الذي تقضيه وحدة معالجة الرسومات (GPU) في انتظار تحميل البيانات من القرص. يمكن للنموذج استقبال البيانات باستمرار دون تأخيرات ناتجة عن عمليات الإدخال/الإخراج للقرص.

يمكن التحكم في التخزين المؤقت عند تدريب YOLO26 باستخدام الـ cache المعلمة:

cache=True: يخزن صور مجموعة البيانات في ذاكرة الوصول العشوائي RAM، مما يوفر أسرع سرعة وصول ولكن على حساب زيادة استخدام الذاكرة.cache='disk': يخزن الصور على القرص، وهو أبطأ من ذاكرة الوصول العشوائي RAM ولكنه أسرع من تحميل بيانات جديدة في كل مرة.cache=False: تعطيل التخزين المؤقت، والاعتماد كليًا على الإدخال/الإخراج للقرص، وهو الخيار الأبطأ.

التدريب بالدقة المختلطة

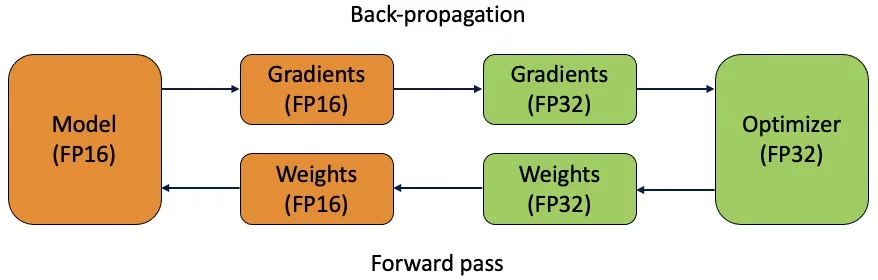

يستخدم التدريب بالدقة المختلطة كلاً من أنواع الفاصلة العائمة 16 بت (FP16) و 32 بت (FP32). يتم الاستفادة من نقاط القوة في كل من FP16 و FP32 باستخدام FP16 للحساب الأسرع و FP32 للحفاظ على الدقة عند الحاجة. يتم إجراء معظم عمليات الشبكة العصبية في FP16 للاستفادة من الحساب الأسرع وتقليل استخدام الذاكرة. ومع ذلك، يتم الاحتفاظ بنسخة رئيسية من أوزان النموذج في FP32 لضمان الدقة خلال خطوات تحديث الوزن. يمكنك التعامل مع نماذج أكبر أو أحجام دفعات أكبر ضمن نفس قيود الأجهزة.

لتنفيذ تدريب الدقة المختلطة، ستحتاج إلى تعديل نصوص التدريب الخاصة بك والتأكد من أن أجهزتك (مثل وحدات معالجة الرسومات) تدعمها. تقدم العديد من أطر التعلم العميق الحديثة، مثل PyTorch و TensorFlow، دعمًا مدمجًا للدقة المختلطة.

التدريب بدقة مختلطة مباشر عند العمل مع YOLO26. يمكنك استخدام الـ amp flag في إعدادات التدريب الخاصة بك. تعيين amp=True تمكين التدريب التلقائي بالدقة المختلطة (AMP). التدريب بالدقة المختلطة هو وسيلة بسيطة وفعالة لتحسين عملية تدريب النموذج الخاص بك.

الأوزان المدربة مسبقًا

يعد استخدام الأوزان المدربة مسبقًا طريقة ذكية لتسريع عملية تدريب نموذجك. تأتي الأوزان المدربة مسبقًا من نماذج مدربة بالفعل على مجموعات بيانات كبيرة، مما يمنح نموذجك بداية قوية. التعلم الانتقالي يكيف النماذج المدربة مسبقًا للمهام الجديدة ذات الصلة. يتضمن الضبط الدقيق لنموذج مدرب مسبقًا البدء بهذه الأوزان ثم مواصلة التدريب على مجموعة بياناتك المحددة. تؤدي طريقة التدريب هذه إلى أوقات تدريب أسرع وأداء أفضل غالبًا لأن النموذج يبدأ بفهم قوي للميزات الأساسية.

في pretrained المعامل يجعل التعلم الانتقالي سهلاً مع YOLO26. تعيين pretrained=True سيستخدم الأوزان الافتراضية المدربة مسبقًا، أو يمكنك تحديد مسار لنموذج مخصص مدرب مسبقًا. يؤدي استخدام الأوزان المدربة مسبقًا والتعلم الانتقالي إلى تعزيز قدرات نموذجك بفعالية وتقليل تكاليف التدريب.

تقنيات أخرى يجب مراعاتها عند التعامل مع مجموعة بيانات كبيرة

هناك بعض التقنيات الأخرى التي يجب مراعاتها عند التعامل مع مجموعة بيانات كبيرة:

- جداول معدل التعلم: يؤدي تطبيق مجدولي معدل التعلم إلى ضبط معدل التعلم ديناميكيًا أثناء التدريب. يمكن لمعدل التعلم المضبوط جيدًا أن يمنع النموذج من تجاوز القيم الدنيا ويحسن الاستقرار. عند تدريب YOLO26، الـ

lrfتساعد معلمة في إدارة جدولة معدل التعلم عن طريق تحديد معدل التعلم النهائي كجزء من المعدل الأولي. - التدريب الموزع: للتعامل مع مجموعات البيانات الكبيرة، يمكن أن يكون التدريب الموزع بمثابة تغيير جذري. يمكنك تقليل وقت التدريب عن طريق توزيع حجم عمل التدريب عبر وحدات معالجة الرسوميات (GPUs) أو الأجهزة المتعددة. هذا النهج ذو قيمة خاصة للمشاريع واسعة النطاق للمؤسسات ذات الموارد الحسابية الكبيرة.

عدد الحقب المراد التدريب عليها

عند تدريب نموذج، يشير العصر (epoch) إلى اجتياز كامل واحد عبر مجموعة بيانات التدريب بأكملها. خلال العصر، يعالج النموذج كل مثال في مجموعة التدريب مرة واحدة ويحدث معلماته بناءً على خوارزمية التعلم. عادة ما تكون هناك حاجة إلى عصور متعددة للسماح للنموذج بالتعلم وتحسين معلماته بمرور الوقت.

أحد الأسئلة الشائعة التي تطرح هو كيفية تحديد عدد الدورات التدريبية لتدريب النموذج. نقطة البداية الجيدة هي 300 دورة تدريبية. إذا كان النموذج يعاني من تجاوز التوفيق في وقت مبكر، يمكنك تقليل عدد الدورات التدريبية. إذا لم يحدث تجاوز التوفيق بعد 300 دورة تدريبية، يمكنك تمديد التدريب إلى 600 أو 1200 دورة تدريبية أو أكثر.

ومع ذلك، يمكن أن يختلف العدد المثالي للعصور (epochs) بناءً على حجم مجموعة البيانات وأهداف المشروع. قد تتطلب مجموعات البيانات الأكبر عددًا أكبر من العصور ليتعلم النموذج بفعالية، بينما قد تحتاج مجموعات البيانات الأصغر إلى عدد أقل من العصور لتجنب التجاوز (overfitting). فيما يتعلق بـ YOLO26، يمكنك تعيين الـ epochs المعلمة في برنامج التدريب النصي الخاص بك.

الإيقاف المبكر

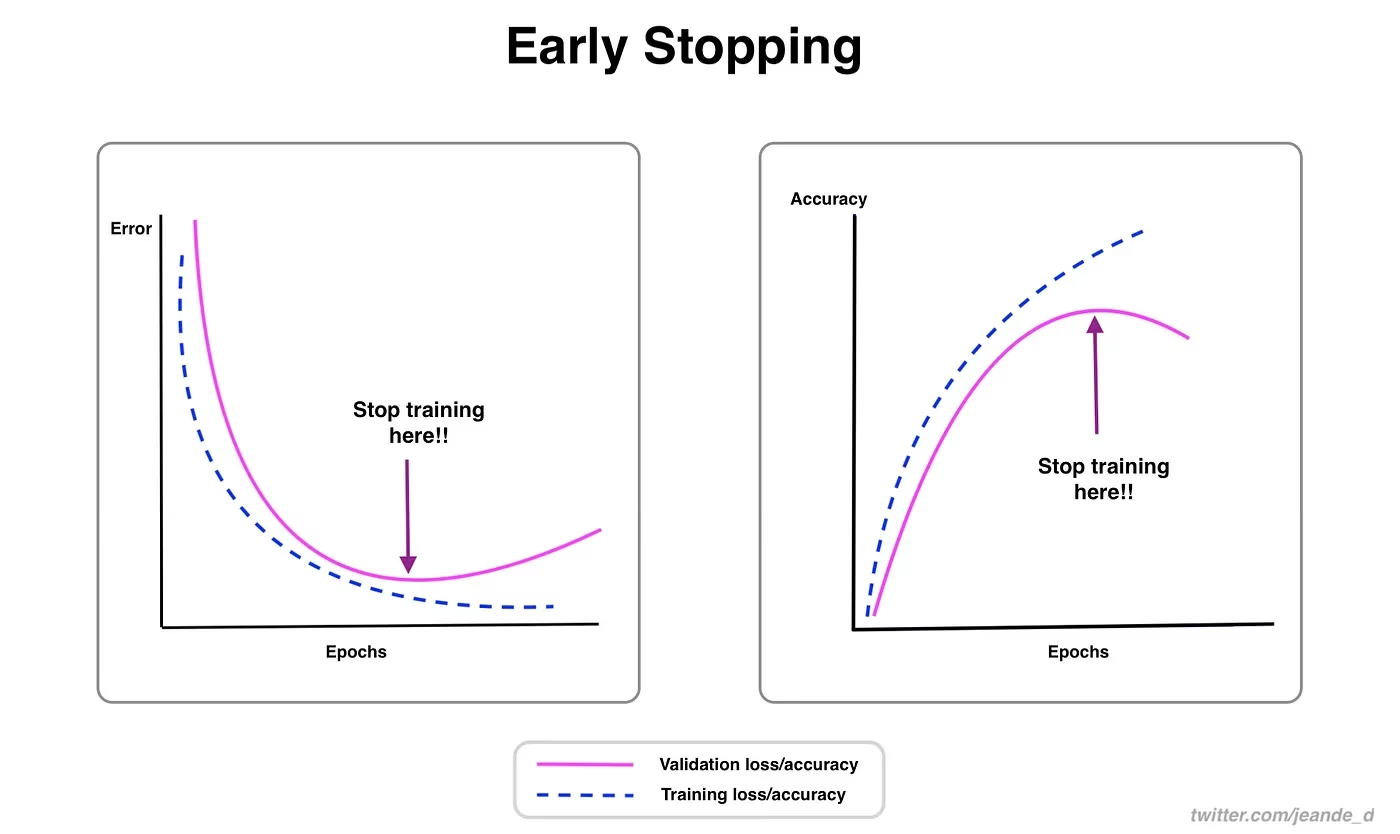

الإيقاف المبكر هو أسلوب قيّم لتحسين تدريب النموذج. من خلال مراقبة أداء التحقق، يمكنك إيقاف التدريب بمجرد توقف النموذج عن التحسن. يمكنك توفير موارد الحوسبة ومنع التجاوز.

تتضمن العملية تعيين معلمة تحمل تحدد عدد الحقب الزمنية التي يجب الانتظار فيها لتحسين مقاييس التحقق قبل إيقاف التدريب. إذا لم يتحسن أداء النموذج خلال هذه الحقب، يتم إيقاف التدريب لتجنب إضاعة الوقت والموارد.

بالنسبة لـ YOLO26، يمكنك تمكين الإيقاف المبكر عن طريق تعيين معامل الصبر (patience) في إعدادات التدريب الخاصة بك. على سبيل المثال، patience=5 يعني أن التدريب سيتوقف إذا لم يكن هناك تحسن في مقاييس التحقق لمدة 5 فترات متتالية. يضمن استخدام هذه الطريقة بقاء عملية التدريب فعالة وتحقيق الأداء الأمثل دون حساب مفرط.

الاختيار بين التدريب من البداية أو استخدام التعلم بالنقل يؤثر على كيفية إعداد بياناتك. يتطلب التدريب من البداية مجموعة بيانات متنوعة لبناء فهم النموذج من الألف إلى الياء. من ناحية أخرى، يتيح لك التعلم بالنقل استخدام نموذج مُدرَّب مسبقًا وتكييفه مع مجموعة بيانات أصغر وأكثر تحديدًا. أيضًا، سيحدد اختيار نموذج معين للتدريب كيف تحتاج إلى إعداد بياناتك، مثل تغيير حجم الصور أو إضافة تعليقات توضيحية، وفقًا للمتطلبات المحددة للنموذج.

هناك خياران لتدريب النموذج الخاص بك: التدريب السحابي والتدريب المحلي.

يوفر التدريب السحابي قابلية التوسع والأجهزة القوية وهو مثالي للتعامل مع مجموعات البيانات الكبيرة والنماذج المعقدة. توفر منصات مثل Google Cloud و AWS و Azure وصولاً عند الطلب إلى وحدات معالجة الرسوميات (GPUs) ووحدات معالجة TPU عالية الأداء، مما يؤدي إلى تسريع أوقات التدريب وتمكين التجارب بنماذج أكبر. ومع ذلك، يمكن أن يكون التدريب السحابي مكلفًا، خاصةً لفترات طويلة، ويمكن أن تزيد تكلفة نقل البيانات ووقت الاستجابة.

يوفر التدريب المحلي تحكمًا وتخصيصًا أكبر، مما يتيح لك تصميم بيئتك وفقًا لاحتياجات محددة وتجنب التكاليف السحابية المستمرة. يمكن أن يكون أكثر اقتصادا للمشاريع طويلة الأجل، وبما أن بياناتك تبقى في مقر العمل، فهي أكثر أمانًا. ومع ذلك، قد يكون للأجهزة المحلية قيود على الموارد وتتطلب صيانة، مما قد يؤدي إلى أوقات تدريب أطول للنماذج الكبيرة.

تحديد مُحسِّن

المُحسِّن (Optimizer) هو خوارزمية تقوم بضبط أوزان الشبكة العصبية لتقليل دالة الخسارة (Loss Function)، والتي تقيس مدى جودة أداء النموذج. بعبارات أبسط، يساعد المُحسِّن النموذج على التعلم عن طريق تعديل معلماته لتقليل الأخطاء. يؤثر اختيار المُحسِّن المناسب بشكل مباشر على مدى سرعة ودقة تعلم النموذج.

يمكنك أيضًا ضبط معلمات المحسن لتحسين أداء النموذج. يؤدي تعديل معدل التعلم إلى تحديد حجم الخطوات عند تحديث المعلمات. لتحقيق الاستقرار، يمكنك البدء بمعدل تعلم معتدل وتقليله تدريجيًا بمرور الوقت لتحسين التعلم على المدى الطويل. بالإضافة إلى ذلك، يحدد تحديد الزخم مقدار تأثير التحديثات السابقة على التحديثات الحالية. القيمة الشائعة للزخم هي حوالي 0.9. يوفر بشكل عام توازنًا جيدًا.

محسنات شائعة

المحسنات المختلفة لها نقاط قوة وضعف مختلفة. دعنا نلقي نظرة خاطفة على عدد قليل من المحسنات الشائعة.

SGD (هبوط التدرج العشوائي):

- يقوم بتحديث معلمات النموذج باستخدام تدرج دالة الخسارة بالنسبة للمعلمات.

- بسيط وفعال ولكنه قد يكون بطيئًا في التقارب وقد يعلق في الحد الأدنى المحلي.

Adam (تقدير العزم التكيفي):

- يجمع بين فوائد كل من SGD مع الزخم و RMSProp.

- يضبط معدل التعلم لكل معلمة بناءً على تقديرات اللحظات الأولى والثانية للتدرجات.

- مناسبة تمامًا للبيانات الصاخبة والتدرجات المتفرقة.

- فعال ويتطلب عمومًا ضبطًا أقل، مما يجعله مُحسِّنًا موصى به لـ YOLO26.

RMSProp (توزيع الجذر التربيعي المتوسط):

- يضبط معدل التعلم لكل معلمة عن طريق قسمة التدرج اللوني على متوسط متحرك لأحجام التدرجات الحديثة.

- يساعد في معالجة مشكلة تلاشي التدرج وهو فعال لـ الشبكات العصبية المتكررة.

بالنسبة لـ YOLO26، الـ optimizer يتيح لك المعامل الاختيار من بين العديد من المحسنات، بما في ذلك SGD و Adam و AdamW و NAdam و RAdam و RMSProp، أو يمكنك تعيينه على auto للتحديد التلقائي بناءً على تكوين النموذج.

التواصل مع المجتمع

يمكن أن تساعدك المشاركة في مجتمع من المتحمسين لرؤية الكمبيوتر في حل المشكلات والتعلم بشكل أسرع. فيما يلي بعض الطرق للتواصل والحصول على المساعدة وتبادل الأفكار.

مصادر المجتمع

- مشاكل GitHub: قم بزيارة مستودع YOLO26 على GitHub واستخدم علامة تبويب "المشاكل" (Issues) لطرح الأسئلة، والإبلاغ عن الأخطاء، واقتراح ميزات جديدة. المجتمع والقائمون على الصيانة نشطون للغاية ومستعدون للمساعدة.

- خادم Ultralytics Discord: انضم إلى خادم Ultralytics Discord للدردشة مع المستخدمين والمطورين الآخرين، والحصول على الدعم، ومشاركة خبراتك.

الوثائق الرسمية

- وثائق Ultralytics YOLO26: اطلع على وثائق YOLO26 الرسمية للحصول على أدلة مفصلة ونصائح مفيدة حول مشاريع رؤية الكمبيوتر المختلفة.

سيساعدك استخدام هذه الموارد على حل التحديات والبقاء على اطلاع دائم بأحدث الاتجاهات والممارسات في مجتمع رؤية الحاسوب.

النقاط الرئيسية

يتضمن تدريب نماذج الرؤية الحاسوبية اتباع الممارسات الجيدة، وتحسين استراتيجياتك، وحل المشكلات فور ظهورها. يمكن لتقنيات مثل تعديل أحجام الدفعات، والتدريب بدقة مختلطة، والبدء بالأوزان المدربة مسبقًا أن تجعل نماذجك تعمل بشكل أفضل وتتدرب بشكل أسرع. تساعد طرق مثل التدريب على مجموعات فرعية والإيقاف المبكر في توفير الوقت والموارد. سيبقى البقاء على اتصال مع المجتمع ومواكبة الاتجاهات الجديدة يساعدك على الاستمرار في تحسين مهاراتك في تدريب النماذج.

الأسئلة الشائعة

كيف يمكنني تحسين استخدام وحدة معالجة الرسوميات (GPU) عند تدريب مجموعة بيانات كبيرة باستخدام Ultralytics YOLO؟

لتحسين استخدام GPU، قم بتعيين batch_size المعامل في إعدادات التدريب الخاصة بك إلى أقصى حجم تدعمه وحدة معالجة الرسوميات (GPU) الخاصة بك. يضمن ذلك الاستفادة الكاملة من قدرات وحدة معالجة الرسوميات (GPU)، مما يقلل من وقت التدريب. إذا واجهت أخطاء في الذاكرة، قلل حجم الدفعة تدريجيًا حتى يسير التدريب بسلاسة. بالنسبة لـ YOLO26، تعيين batch=-1 في سكريبت التدريب الخاص بك سيحدد تلقائيًا حجم الدفعة الأمثل للمعالجة الفعالة. لمزيد من المعلومات، راجع تهيئة التدريب.

ما هو التدريب بالدقة المختلطة، وكيف يمكنني تمكينه في YOLO26؟

يستخدم التدريب بالدقة المختلطة كلاً من أنواع الفاصلة العائمة 16 بت (FP16) و 32 بت (FP32) لتحقيق التوازن بين سرعة الحساب والدقة. يسرع هذا النهج التدريب ويقلل من استخدام الذاكرة دون التضحية بالنموذج الدقة. لتمكين التدريب بدقة مختلطة في YOLO26، قم بتعيين الـ amp المعلمة إلى True في إعدادات التدريب الخاصة بك. هذا ينشط التدريب بالدقة المختلطة التلقائية (AMP). لمزيد من التفاصيل حول تقنية التحسين هذه، راجع تهيئة التدريب.

كيف يعزز التدريب متعدد المقاييس أداء نموذج YOLO26؟

التدريب متعدد المقاييس يعزز أداء النموذج عن طريق التدريب على صور بأحجام مختلفة، مما يسمح للنموذج بالتعميم بشكل أفضل عبر مقاييس ومسافات مختلفة. في YOLO26، يمكنك تمكين التدريب متعدد المقاييس عن طريق تعيين الـ scale المعلمة في تكوين التدريب. على سبيل المثال، scale=0.5 يأخذ عينات من عامل تكبير يتراوح بين 0.5 و 1.5، ثم يعيد التعبئة/القص إلى imgsz. هذه التقنية تحاكي الأجسام على مسافات مختلفة، مما يجعل النموذج أكثر قوة في مختلف السيناريوهات. للاطلاع على الإعدادات والمزيد من التفاصيل، راجع تهيئة التدريب.

كيف يمكنني استخدام الأوزان المدربة مسبقاً لتسريع التدريب في YOLO26؟

يمكن أن يؤدي استخدام الأوزان المدربة مسبقًا إلى تسريع التدريب بشكل كبير وتعزيز دقة النموذج من خلال الاستفادة من نموذج مألوف بالفعل مع الميزات البصرية الأساسية. في YOLO26، ما عليك سوى تعيين الـ pretrained المعلمة إلى True أو توفير مسار لأوزانك المخصصة المدربة مسبقًا في إعدادات التدريب. تتيح هذه الطريقة، التي تسمى التعلم الانتقالي، تكييف النماذج المدربة على مجموعات بيانات كبيرة بفعالية مع تطبيقك المحدد. تعرف على المزيد حول كيفية استخدام الأوزان المدربة مسبقًا وفوائدها في دليل تكوين التدريب.

ما هو العدد الموصى به للحقب لتدريب نموذج، وكيف يمكنني تعيين ذلك في YOLO26؟

يشير عدد العصور (epochs) إلى التمريرات الكاملة عبر مجموعة بيانات التدريب أثناء تدريب النموذج. نقطة البداية النموذجية هي 300 عصر. إذا تجاوز نموذجك (overfits) مبكرًا، يمكنك تقليل العدد. بدلاً من ذلك، إذا لم يتم ملاحظة التجاوز، فقد تمدد التدريب إلى 600، 1200، أو أكثر من العصور. لتعيين هذا في YOLO26، استخدم الـ epochs المعلمة في برنامج التدريب النصي الخاص بك. للحصول على نصائح إضافية حول تحديد العدد المثالي للحقبات، راجع هذا القسم حول عدد الحقب.