دليل البدء السريع: NVIDIA Jetson مع Ultralytics YOLO26

يقدم هذا الدليل الشامل شرحًا مفصلاً لنشر Ultralytics YOLO26 على أجهزة NVIDIA Jetson. بالإضافة إلى ذلك، يعرض معايير الأداء لإظهار قدرات YOLO26 على هذه الأجهزة الصغيرة والقوية.

دعم منتج جديد

لقد قمنا بتحديث هذا الدليل بأحدث NVIDIA Jetson AGX Thor Developer Kit الذي يوفر ما يصل إلى 2070 FP4 TFLOPS من حساب الذكاء الاصطناعي و 128 جيجابايت من الذاكرة مع طاقة قابلة للتكوين بين 40 واط و 130 واط. إنه يوفر أكثر من 7.5 أضعاف حساب الذكاء الاصطناعي أعلى من NVIDIA Jetson AGX Orin، مع كفاءة طاقة أفضل بمقدار 3.5 مرة لتشغيل نماذج الذكاء الاصطناعي الأكثر شيوعًا بسلاسة.

شاهد: كيفية استخدام Ultralytics YOLO26 على أجهزة NVIDIA Jetson

ملاحظة

تم اختبار هذا الدليل باستخدام مجموعة مطوري NVIDIA Jetson AGX Thor (Jetson T5000) التي تعمل بأحدث إصدار مستقر من JetPack وهو JP7.0، ومجموعة مطوري NVIDIA Jetson AGX Orin (64GB) التي تعمل بإصدار JetPack JP6.2، ومجموعة مطوري NVIDIA Jetson Orin Nano Super التي تعمل بإصدار JetPack JP6.1، وSeeed Studio reComputer J4012 الذي يعتمد على NVIDIA Jetson Orin NX 16GB ويعمل بإصدار JetPack JP6.0/ إصدار JetPack JP5.1.3 وSeeed Studio reComputer J1020 v2 الذي يعتمد على NVIDIA Jetson Nano 4GB ويعمل بإصدار JetPack JP4.6.1. من المتوقع أن يعمل عبر جميع تشكيلة أجهزة NVIDIA Jetson، بما في ذلك الأجهزة الأحدث والقديمة.

ما هو NVIDIA Jetson؟

NVIDIA Jetson هي سلسلة من لوحات الحوسبة المدمجة المصممة لجلب حوسبة الذكاء الاصطناعي (AI) المعجلة إلى الأجهزة الطرفية. تم بناء هذه الأجهزة المدمجة والقوية حول معمارية NVIDIA للـ GPU ويمكنها تشغيل خوارزميات الذكاء الاصطناعي المعقدة ونماذج التعلم العميق مباشرة على الجهاز، دون الاعتماد على موارد الحوسبة السحابية. تُستخدم لوحات Jetson غالبًا في الروبوتات، والمركبات ذاتية القيادة، والأتمتة الصناعية، والتطبيقات الأخرى التي تتطلب إجراء استدلال الذكاء الاصطناعي محليًا بزمن استجابة منخفض وكفاءة عالية. بالإضافة إلى ذلك، تعتمد هذه اللوحات على معمارية ARM64 وتعمل باستهلاك طاقة أقل مقارنة بأجهزة حوسبة GPU التقليدية.

مقارنة سلسلة NVIDIA Jetson

NVIDIA Jetson AGX Thor هو أحدث تكرار لعائلة NVIDIA Jetson استنادًا إلى بنية NVIDIA Blackwell التي تجلب أداءً مُحسَّنًا بشكل كبير للذكاء الاصطناعي مقارنةً بالأجيال السابقة. يقارن الجدول أدناه عددًا قليلاً من أجهزة Jetson في النظام البيئي.

| Jetson AGX Thor(T5000) | Jetson AGX Orin 64GB | Jetson Orin NX 16GB | Jetson Orin Nano Super | Jetson AGX Xavier | Jetson Xavier NX | Jetson Nano | |

|---|---|---|---|---|---|---|---|

| أداء الذكاء الاصطناعي | 2070 TFLOPS | 275 TOPS | 100 TOPS | 67 TOPS | 32 TOPS | 21 TOPS | 472 جيجا فلوبس |

| GPU | معالج رسوميات معمارية NVIDIA Blackwell ذو 2560 نواة مع 96 نواة tensor | وحدة معالجة الرسوميات (GPU) بمعمارية NVIDIA Ampere بـ 2048 نواة مع 64 نواة tensor | وحدة معالجة الرسوميات NVIDIA Ampere ببنية 1024 نواة مع 32 نواة tensor | وحدة معالجة الرسوميات NVIDIA Ampere ببنية 1024 نواة مع 32 نواة tensor | وحدة معالجة الرسوميات NVIDIA Volta architecture بـ 512 نواة مع 64 نواة tensor | وحدة معالجة الرسوميات (GPU) بمعمارية NVIDIA Volta™ بـ 384 نواة مع 48 نواة tensor | وحدة معالجة الرسوميات NVIDIA Maxwell™ ببنية 128 نواة |

| التردد الأقصى لوحدة معالجة الرسوميات GPU | 1.57 جيجاهرتز | 1.3 جيجاهرتز | 918 MHz | 1020 MHz | 1377 MHz | 1100 MHz | 921 ميجاهرتز |

| وحدة المعالجة المركزية (CPU) | وحدة معالجة مركزية 14-core Arm® Neoverse®-V3AE 64-bit CPU 1 ميجابايت L2 + 16 ميجابايت L3 | وحدة معالجة مركزية NVIDIA Arm® Cortex A78AE v8.2 64-bit CPU بـ 12 نواة وذاكرة تخزين مؤقت L2 سعة 3 ميجابايت + ذاكرة تخزين مؤقت L3 سعة 6 ميجابايت | وحدة معالجة مركزية NVIDIA Arm® Cortex A78AE v8.2 64-bit CPU ثمانية النواة بسعة 2 ميجابايت L2 + 4 ميجابايت L3 | وحدة معالجة مركزية 6-core Arm® Cortex®-A78AE v8.2 64-bit CPU بسعة 1.5 ميجابايت L2 + 4 ميجابايت L3 | وحدة معالجة مركزية NVIDIA Carmel Arm®v8.2 64-bit CPU ثمانية النواة بسعة 8 ميجابايت L2 + 4 ميجابايت L3 | وحدة معالجة مركزية NVIDIA Carmel Arm®v8.2 64-bit CPU سداسية النواة بسعة 6 ميجابايت L2 + 4 ميجابايت L3 | معالج Quad-Core Arm® Cortex®-A57 MPCore |

| الحد الأقصى لتردد وحدة المعالجة المركزية (CPU) | 2.6 جيجاهرتز | 2.2 جيجاهرتز | 2.0 جيجاهرتز | 1.7 جيجاهرتز | 2.2 جيجاهرتز | 1.9 جيجاهرتز | 1.43 جيجاهرتز |

| الذاكرة | 128 جيجابايت 256-bit LPDDR5X 273 جيجابايت/ثانية | ذاكرة وصول عشوائي LPDDR5 بسعة 64 جيجابايت و 256 بت بسرعة 204.8 جيجابايت/ثانية | ذاكرة وصول عشوائي LPDDR5 سعة 16 جيجابايت و 128 بت بسرعة 102.4 جيجابايت/ثانية | ذاكرة وصول عشوائي LPDDR5 بسعة 8 جيجابايت و 128 بت بسرعة 102 جيجابايت/ثانية | 32 جيجابايت 256-bit LPDDR4x 136.5 جيجابايت/ثانية | ذاكرة وصول عشوائي LPDDR4x بسعة 8 جيجابايت و 128 بت بسرعة 59.7 جيجابايت/ثانية | 4GB 64-bit LPDDR4 25.6GB/s |

للحصول على جدول مقارنة أكثر تفصيلاً، يرجى زيارة قسم مقارنة المواصفات في صفحة NVIDIA Jetson الرسمية.

ما هو NVIDIA JetPack؟

توفر NVIDIA JetPack SDK التي تدعم وحدات Jetson الحل الأكثر شمولاً وتوفر بيئة تطوير كاملة لإنشاء تطبيقات الذكاء الاصطناعي المتسارعة الشاملة وتقصير الوقت اللازم لطرحها في السوق. يشتمل JetPack على Jetson Linux مع أداة تحميل التشغيل ونواة Linux وبيئة سطح مكتب Ubuntu ومجموعة كاملة من المكتبات لتسريع حوسبة وحدة معالجة الرسومات (GPU) والوسائط المتعددة والرسومات ورؤية الكمبيوتر. كما يتضمن أيضًا أمثلة ووثائق وأدوات تطوير لكل من الكمبيوتر المضيف ومجموعة المطورين، ويدعم SDKs ذات المستوى الأعلى مثل DeepStream لتحليلات الفيديو المتدفقة و Isaac للروبوتات و Riva للذكاء الاصطناعي للمحادثة.

تثبيت Flash JetPack على NVIDIA Jetson

الخطوة الأولى بعد الحصول على جهاز NVIDIA Jetson هي تثبيت NVIDIA JetPack على الجهاز. هناك عدة طرق مختلفة لتثبيت أجهزة NVIDIA Jetson.

- إذا كنت تمتلك مجموعة تطوير NVIDIA رسمية مثل Jetson AGX Thor Developer Kit، فيمكنك تنزيل صورة وإعداد ذاكرة USB قابلة للتمهيد لتثبيت JetPack على SSD المرفق.

- إذا كنت تمتلك مجموعة تطوير NVIDIA الرسمية مثل Jetson Orin Nano Developer Kit، فيمكنك تنزيل صورة وإعداد بطاقة SD باستخدام JetPack لتمهيد الجهاز.

- إذا كنت تمتلك أي مجموعة تطوير NVIDIA أخرى، فيمكنك تثبيت JetPack على الجهاز باستخدام SDK Manager.

- إذا كنت تمتلك جهاز Seeed Studio reComputer J4012، فيمكنك تثبيت JetPack على SSD المضمن وإذا كنت تمتلك جهاز Seeed Studio reComputer J1020 v2، فيمكنك تثبيت JetPack على eMMC/ SSD.

- إذا كنت تمتلك أي جهاز آخر من طرف ثالث يعمل بوحدة NVIDIA Jetson، فمن المستحسن اتباع التثبيت عبر سطر الأوامر.

ملاحظة

بالنسبة للطرق 1 و 4 و 5 المذكورة أعلاه، بعد تثبيت النظام وإقلاع الجهاز، يرجى إدخال "sudo apt update && sudo apt install nvidia-jetpack -y" في طرفية الجهاز لتثبيت جميع مكونات JetPack المتبقية اللازمة.

دعم JetPack بناءً على جهاز Jetson

يسلط الجدول أدناه الضوء على إصدارات NVIDIA JetPack التي تدعمها أجهزة NVIDIA Jetson المختلفة.

| JetPack 4 | JetPack 5 | JetPack 6 | JetPack 7 | |

|---|---|---|---|---|

| Jetson Nano | ✅ | ❌ | ❌ | ❌ |

| Jetson TX2 | ✅ | ❌ | ❌ | ❌ |

| Jetson Xavier NX | ✅ | ✅ | ❌ | ❌ |

| Jetson AGX Xavier | ✅ | ✅ | ❌ | ❌ |

| Jetson AGX Orin | ❌ | ✅ | ✅ | ❌ |

| Jetson Orin NX | ❌ | ✅ | ✅ | ❌ |

| Jetson Orin Nano | ❌ | ✅ | ✅ | ❌ |

| Jetson AGX Thor | ❌ | ❌ | ❌ | ✅ |

بداية سريعة مع Docker

أسرع طريقة للبدء باستخدام Ultralytics YOLO26 على NVIDIA Jetson هي التشغيل باستخدام صور Docker المُعدة مسبقًا لـ Jetson. ارجع إلى الجدول أعلاه واختر إصدار JetPack وفقًا لجهاز Jetson الذي تملكه.

t=ultralytics/ultralytics:latest-jetson-jetpack4

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-jetson-jetpack5

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-jetson-jetpack6

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

بعد الانتهاء من ذلك، انتقل إلى استخدام TensorRT على قسم NVIDIA Jetson.

ابدأ بالتثبيت الأصلي

للتثبيت الأصلي بدون Docker، يرجى الرجوع إلى الخطوات أدناه.

التشغيل على JetPack 7.0

تثبيت حزمة Ultralytics

هنا سنقوم بتثبيت حزمة Ultralytics على Jetson مع التبعيات الاختيارية حتى نتمكن من تصدير نماذج PyTorch إلى تنسيقات مختلفة أخرى. سنركز بشكل أساسي على صادرات NVIDIA TensorRT لأن TensorRT ستضمن حصولنا على أقصى أداء من أجهزة Jetson.

تحديث قائمة الحزم وتثبيت pip والترقية إلى الأحدث

sudo apt update sudo apt install python3-pip -y pip install -U pipتثبيت

ultralyticsحزمة pip مع تبعيات اختياريةpip install ultralytics[export]أعد تشغيل الجهاز

sudo reboot

تثبيت PyTorch و Torchvision

سيؤدي تثبيت Ultralytics أعلاه إلى تثبيت Torch و Torchvision. ومع ذلك، فإن هاتين الحزمتين المثبتتين عبر pip غير متوافقتين للتشغيل على Jetson AGX Thor الذي يأتي مع JetPack 7.0 و CUDA 13. لذلك، نحتاج إلى تثبيتهما يدويًا.

تثبيت torch و torchvision وفقًا لـ JP7.0

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

تثبيت onnxruntime-gpu

في onnxruntime-gpu الحزمة المستضافة في PyPI غير متوفرة aarch64 الثنائيات الخاصة بـ Jetson. لذلك نحن بحاجة إلى تثبيت هذه الحزمة يدويًا. هذه الحزمة مطلوبة لبعض عمليات التصدير.

هنا سنقوم بتنزيل وتثبيت onnxruntime-gpu 1.24.0 مع Python3.12 الدعم.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

التشغيل على JetPack 6.1

تثبيت حزمة Ultralytics

هنا سنقوم بتثبيت حزمة Ultralytics على Jetson مع التبعيات الاختيارية حتى نتمكن من تصدير نماذج PyTorch إلى تنسيقات مختلفة أخرى. سنركز بشكل أساسي على صادرات NVIDIA TensorRT لأن TensorRT ستضمن حصولنا على أقصى أداء من أجهزة Jetson.

تحديث قائمة الحزم وتثبيت pip والترقية إلى الأحدث

sudo apt update sudo apt install python3-pip -y pip install -U pipتثبيت

ultralyticsحزمة pip مع تبعيات اختياريةpip install ultralytics[export]أعد تشغيل الجهاز

sudo reboot

تثبيت PyTorch و Torchvision

سيؤدي تثبيت Ultralytics أعلاه إلى تثبيت Torch و Torchvision. ومع ذلك، فإن هاتين الحزمتين المثبتتين عبر pip غير متوافقتين مع منصة Jetson، التي تعتمد على بنية ARM64. لذلك، نحتاج إلى تثبيت PyTorch pip wheel مُجمَّع مسبقًا يدويًا وتجميع Torchvision أو تثبيته من المصدر.

تثبيت torch 2.5.0 و torchvision 0.20 وفقًا لـ JP6.1

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torch-2.5.0a0+872d972e41.nv24.08-cp310-cp310-linux_aarch64.whl

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torchvision-0.20.0a0+afc54f7-cp310-cp310-linux_aarch64.whl

ملاحظة

تفضل بزيارة صفحة PyTorch لـ Jetson للوصول إلى جميع الإصدارات المختلفة من PyTorch لإصدارات JetPack المختلفة. للحصول على قائمة أكثر تفصيلاً حول توافق PyTorch و Torchvision، تفضل بزيارة صفحة توافق PyTorch و Torchvision.

تثبيت cuSPARSELt لإصلاح مشكلة في التبعيات مع torch 2.5.0

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/arm64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt-get update

sudo apt-get -y install libcusparselt0 libcusparselt-dev

تثبيت onnxruntime-gpu

في onnxruntime-gpu الحزمة المستضافة في PyPI غير متوفرة aarch64 الثنائيات الخاصة بـ Jetson. لذلك نحن بحاجة إلى تثبيت هذه الحزمة يدويًا. هذه الحزمة مطلوبة لبعض عمليات التصدير.

يمكنك العثور على جميع onnxruntime-gpu — منظمة حسب إصدار JetPack وإصدار Python وتفاصيل التوافق الأخرى — في مصفوفة توافق Jetson Zoo ONNX Runtime.

ل JetPack 6 مع Python 3.10 يمكنك تثبيت الدعم onnxruntime-gpu 1.23.0:

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.23.0-cp310-cp310-linux_aarch64.whl

بدلاً من ذلك، لـ onnxruntime-gpu 1.20.0:

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.20.0-cp310-cp310-linux_aarch64.whl

التشغيل على JetPack 5.1.2

تثبيت حزمة Ultralytics

هنا سنقوم بتثبيت حزمة Ultralytics على Jetson مع التبعيات الاختيارية حتى نتمكن من تصدير نماذج PyTorch إلى تنسيقات مختلفة أخرى. سنركز بشكل أساسي على صادرات NVIDIA TensorRT لأن TensorRT ستضمن حصولنا على أقصى أداء من أجهزة Jetson.

تحديث قائمة الحزم وتثبيت pip والترقية إلى الأحدث

sudo apt update sudo apt install python3-pip -y pip install -U pipتثبيت

ultralyticsحزمة pip مع تبعيات اختياريةpip install ultralytics[export]أعد تشغيل الجهاز

sudo reboot

تثبيت PyTorch و Torchvision

سيؤدي تثبيت Ultralytics أعلاه إلى تثبيت Torch و Torchvision. ومع ذلك، فإن هاتين الحزمتين المثبتتين عبر pip غير متوافقتين مع منصة Jetson، التي تعتمد على بنية ARM64. لذلك، نحتاج إلى تثبيت PyTorch pip wheel مُجمَّع مسبقًا يدويًا وتجميع Torchvision أو تثبيته من المصدر.

إلغاء تثبيت PyTorch و Torchvision المثبتين حاليًا

pip uninstall torch torchvisionتثبيت

torch 2.2.0وtorchvision 0.17.2وفقًا لـ JP5.1.2pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torch-2.2.0-cp38-cp38-linux_aarch64.whl pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torchvision-0.17.2+c1d70fe-cp38-cp38-linux_aarch64.whl

ملاحظة

تفضل بزيارة صفحة PyTorch لـ Jetson للوصول إلى جميع الإصدارات المختلفة من PyTorch لإصدارات JetPack المختلفة. للحصول على قائمة أكثر تفصيلاً حول توافق PyTorch و Torchvision، تفضل بزيارة صفحة توافق PyTorch و Torchvision.

تثبيت onnxruntime-gpu

في onnxruntime-gpu الحزمة المستضافة في PyPI غير متوفرة aarch64 الثنائيات الخاصة بـ Jetson. لذلك نحن بحاجة إلى تثبيت هذه الحزمة يدويًا. هذه الحزمة مطلوبة لبعض عمليات التصدير.

يمكنك العثور على جميع onnxruntime-gpu — منظمة حسب إصدار JetPack وإصدار Python وتفاصيل التوافق الأخرى — في مصفوفة توافق Jetson Zoo ONNX Runtime. هنا سنقوم بتنزيل وتثبيت onnxruntime-gpu 1.17.0 مع Python3.8 الدعم.

wget https://nvidia.box.com/shared/static/zostg6agm00fb6t5uisw51qi6kpcuwzd.whl -O onnxruntime_gpu-1.17.0-cp38-cp38-linux_aarch64.whl

pip install onnxruntime_gpu-1.17.0-cp38-cp38-linux_aarch64.whl

ملاحظة

onnxruntime-gpu سيؤدي تلقائيًا إلى إرجاع إصدار numpy إلى الأحدث. لذا، نحتاج إلى إعادة تثبيت numpy إلى 1.23.5 لإصلاح مشكلة عن طريق تنفيذ:

pip install numpy==1.23.5

استخدم TensorRT على NVIDIA Jetson

من بين جميع تنسيقات تصدير النماذج التي تدعمها Ultralytics، يوفر TensorRT أعلى أداء استدلال على أجهزة NVIDIA Jetson، مما يجعله توصيتنا الأولى لعمليات نشر Jetson. للحصول على إرشادات الإعداد والاستخدام المتقدم، راجع دليل تكامل TensorRT المخصص الخاص بنا.

تحويل النموذج إلى TensorRT وتشغيل الاستدلال

يتم تحويل نموذج YOLO26n بتنسيق PyTorch إلى TensorRT لتشغيل الاستدلال باستخدام النموذج المصدر.

مثال

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

ملاحظة

تفضل بزيارة صفحة التصدير للوصول إلى المزيد من الوسائط عند تصدير النماذج إلى تنسيقات نماذج مختلفة

استخدم NVIDIA Deep Learning Accelerator (DLA)

NVIDIA Deep Learning Accelerator (DLA) هو مكون أجهزة متخصص مدمج في أجهزة NVIDIA Jetson يعمل على تحسين استدلال التعلم العميق لكفاءة الطاقة والأداء. من خلال تفريغ المهام من وحدة معالجة الرسومات (مما يحررها لعمليات أكثر كثافة)، يتيح DLA تشغيل النماذج باستهلاك أقل للطاقة مع الحفاظ على إنتاجية عالية، وهو مثالي للأنظمة المدمجة وتطبيقات الذكاء الاصطناعي في الوقت الفعلي.

أجهزة Jetson التالية مزودة بأجهزة DLA:

| جهاز Jetson | نوى DLA | الحد الأقصى لتردد DLA |

|---|---|---|

| سلسلة Jetson AGX Orin | 2 | 1.6 جيجاهرتز |

| Jetson Orin NX 16GB | 2 | 614 MHz |

| Jetson Orin NX 8GB | 1 | 614 MHz |

| سلسلة Jetson AGX Xavier | 2 | 1.4 جيجاهرتز |

| سلسلة Jetson Xavier NX | 2 | 1.1 جيجاهرتز |

مثال

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT with DLA enabled (only works with FP16 or INT8)

model.export(format="engine", device="dla:0", half=True) # dla:0 or dla:1 corresponds to the DLA cores

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format with DLA enabled (only works with FP16 or INT8)

# Once DLA core number is specified at export, it will use the same core at inference

yolo export model=yolo26n.pt format=engine device="dla:0" half=True # dla:0 or dla:1 corresponds to the DLA cores

# Run inference with the exported model on the DLA

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

ملاحظة

عند استخدام تصديرات DLA، قد لا يتم دعم بعض الطبقات للتشغيل على DLA وستعود إلى وحدة معالجة الرسومات (GPU) للتنفيذ. يمكن أن يؤدي هذا الرجوع إلى إضافة زمن انتقال إضافي والتأثير على أداء الاستدلال العام. لذلك، لم يتم تصميم DLA بشكل أساسي لتقليل زمن انتقال الاستدلال مقارنة بـ TensorRT الذي يعمل بالكامل على وحدة معالجة الرسومات (GPU). بدلاً من ذلك، فإن غرضه الأساسي هو زيادة الإنتاجية وتحسين كفاءة استخدام الطاقة.

معايير أداء NVIDIA YOLO11 YOLO26

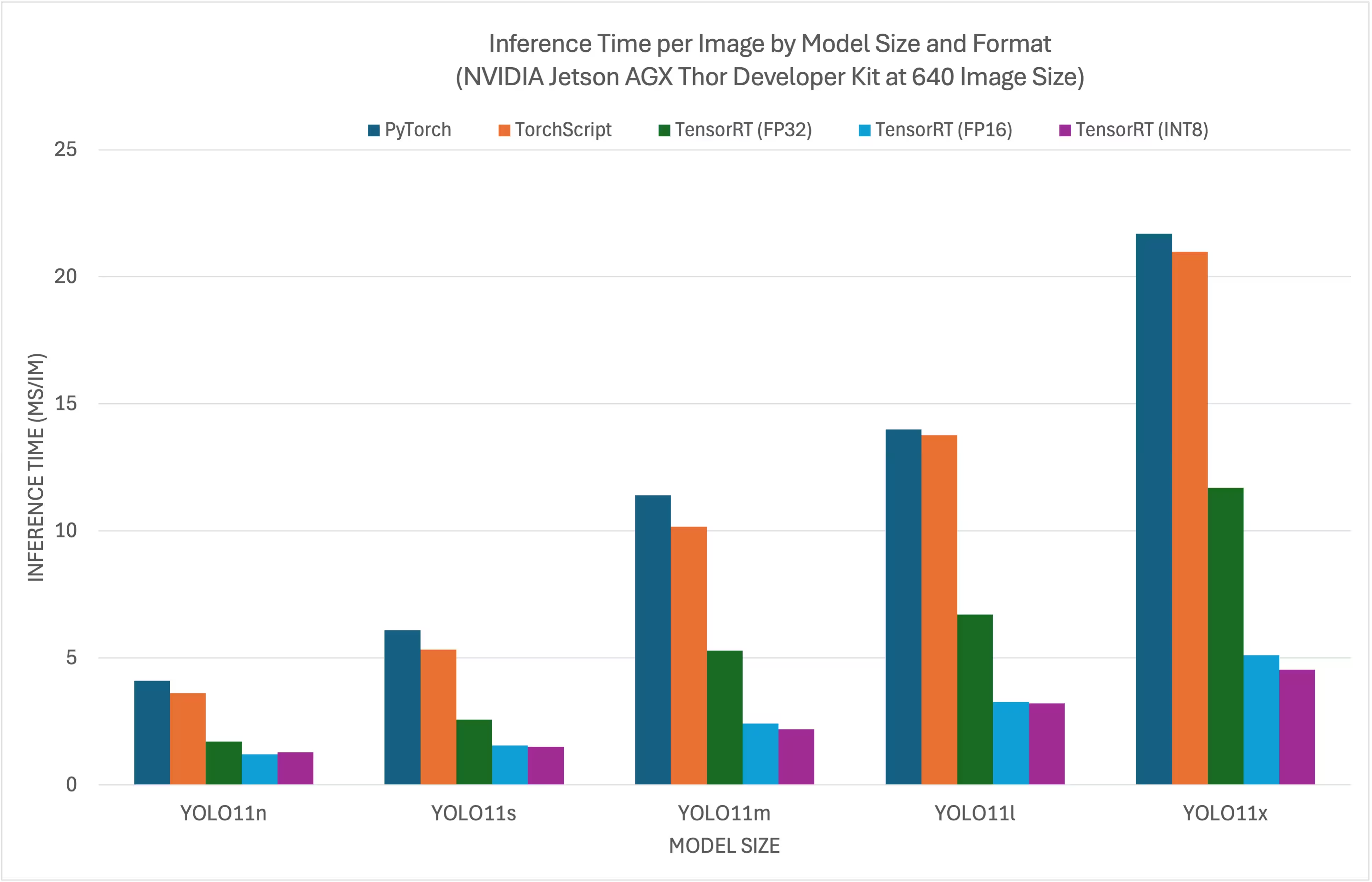

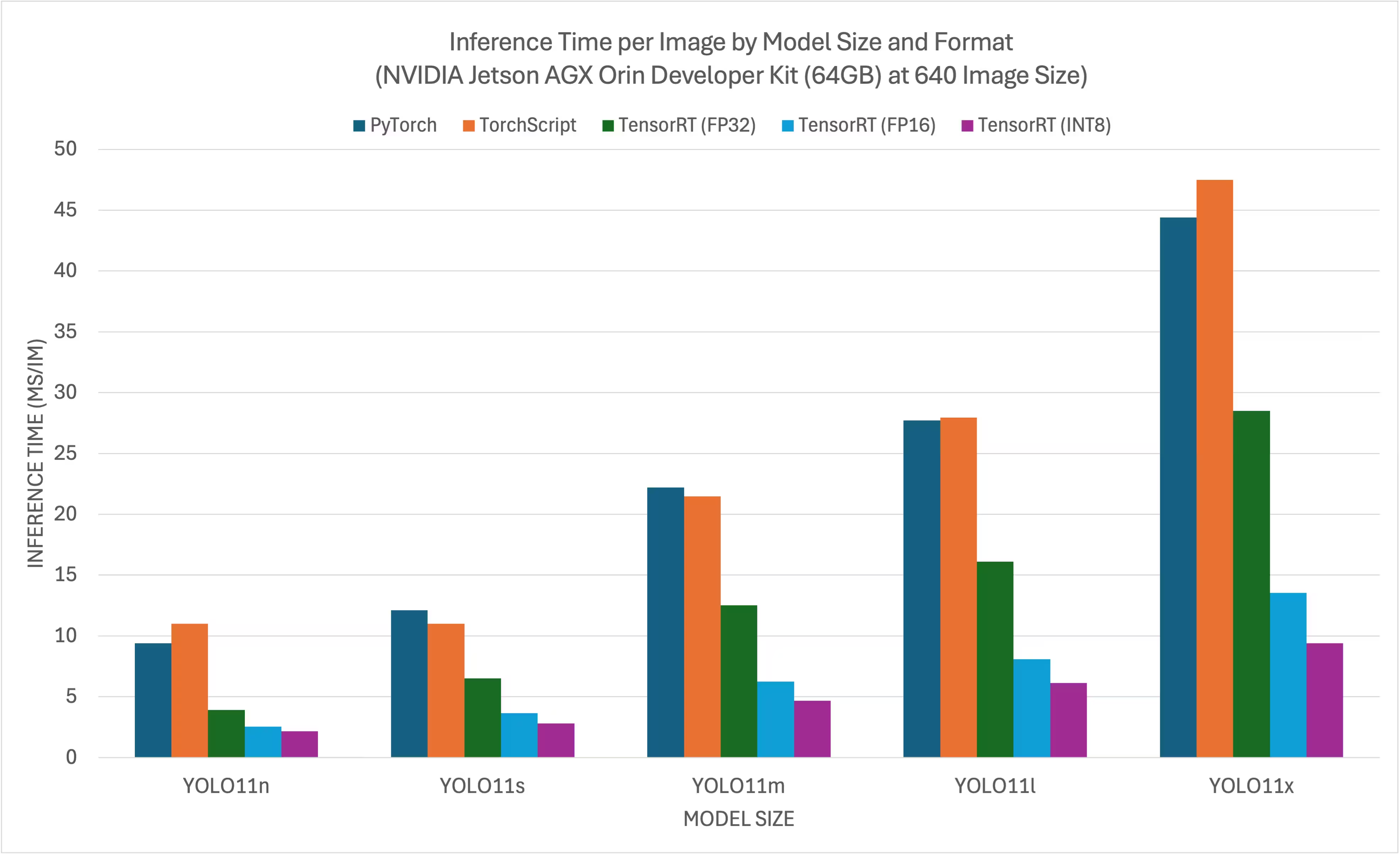

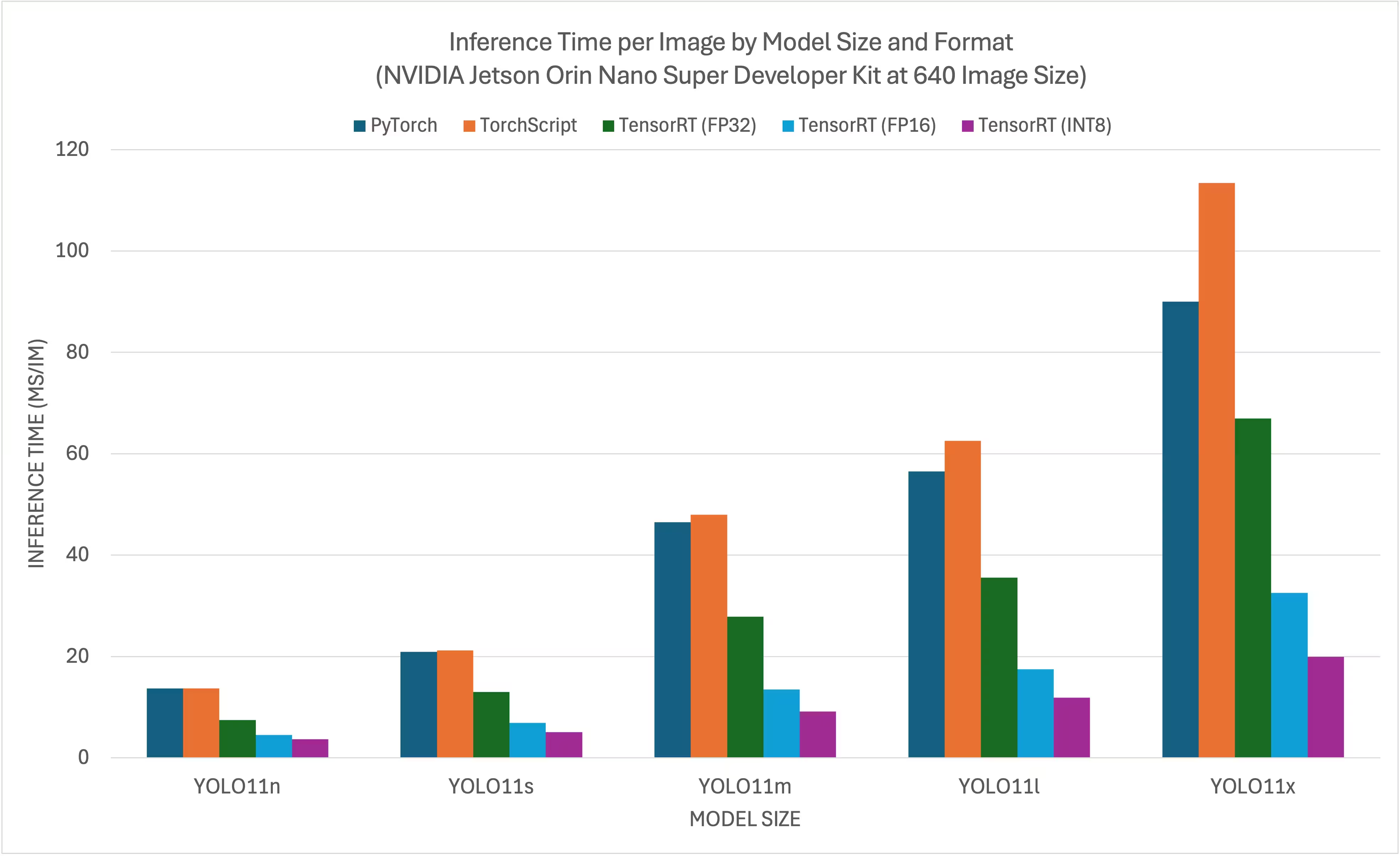

تم تشغيل معايير YOLO11 YOLO26 بواسطة Ultralytics على 11 تنسيقًا مختلفًا للنماذج لقياس السرعة والدقة: PyTorch و TorchScript و ONNX و OpenVINO و TensorRT و TF SavedModel و TF GraphDef و TF و MNN و NCNN و ExecuTorch. تم تشغيل المعايير على NVIDIA AGX Thor Developer Kit و NVIDIA AGX Orin Developer Kit (64 جيجابايت) و NVIDIA Orin Nano Super Developer Kit و Seeed Studio reComputer J4012 المدعوم بجهاز Jetson Orin NX 16 جيجابايت بدقة FP32 مع حجم صورة إدخال افتراضي يبلغ 640.

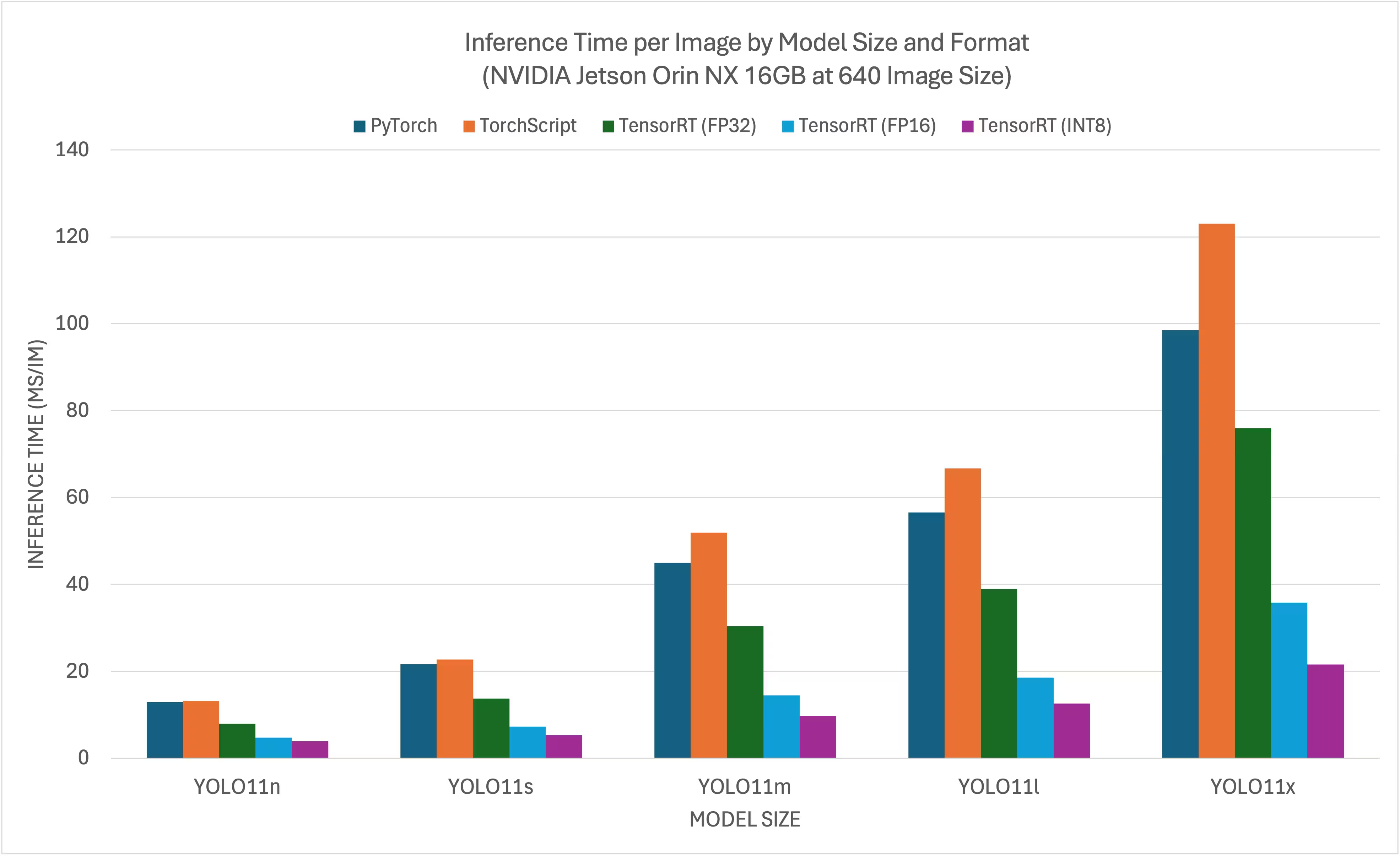

مخططات المقارنة

على الرغم من أن جميع صادرات النماذج تعمل على NVIDIA Jetson، فقد قمنا بتضمين PyTorch وTorchScript وTensorRT فقط في مخطط المقارنة أدناه لأنها تستفيد من GPU على Jetson ومضمونة لتقديم أفضل النتائج. جميع الصادرات الأخرى تستخدم CPU فقط والأداء ليس جيدًا مثل الثلاثة المذكورة أعلاه. يمكنك العثور على معايير الأداء لجميع الصادرات في القسم الذي يلي هذا المخطط.

مجموعة تطوير NVIDIA Jetson AGX Thor

مجموعة تطوير NVIDIA Jetson AGX Orin (بسعة 64 جيجابايت)

مجموعة أدوات NVIDIA Jetson Orin Nano Super Developer

NVIDIA Jetson Orin NX 16GB

جداول مقارنة تفصيلية

يمثل الجدول أدناه نتائج المقارنة المعيارية لخمسة نماذج مختلفة (YOLO11n و YOLO11s و YOLO11m و YOLO11l و YOLO11x) عبر 11 تنسيقًا مختلفًا (PyTorch و TorchScript و ONNX و OpenVINO و TensorRT و TF SavedModel و TF GraphDef و TF Lite و MNN و NCNN و ExecuTorch)، مما يمنحنا الحالة والحجم ومقياس mAP50-95(B) ووقت الاستدلال لكل مجموعة.

مجموعة تطوير NVIDIA Jetson AGX Thor

الأداء

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.3 | 0.4798 | 7.39 |

| TorchScript | ✅ | 9.8 | 0.4789 | 4.21 |

| ONNX | ✅ | 9.5 | 0.4767 | 6.58 |

| OpenVINO | ✅ | 10.1 | 0.4794 | 17.50 |

| TensorRT (FP32) | ✅ | 13.9 | 0.4791 | 1.90 |

| TensorRT (FP16) | ✅ | 7.6 | 0.4797 | 1.39 |

| TensorRT (INT8) | ✅ | 6.5 | 0.4273 | 1.52 |

| TF SavedModel | ✅ | 25.7 | 0.4764 | 47.24 |

| TF GraphDef | ✅ | 9.5 | 0.4764 | 45.98 |

| TF Lite | ✅ | 9.9 | 0.4764 | 182.04 |

| MNN | ✅ | 9.4 | 0.4784 | 21.83 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 19.5 | 0.5738 | 7.99 |

| TorchScript | ✅ | 36.8 | 0.5664 | 6.01 |

| ONNX | ✅ | 36.5 | 0.5666 | 9.31 |

| OpenVINO | ✅ | 38.5 | 0.5656 | 35.56 |

| TensorRT (FP32) | ✅ | 38.9 | 0.5664 | 2.95 |

| TensorRT (FP16) | ✅ | 21.0 | 0.5650 | 1.77 |

| TensorRT (INT8) | ✅ | 13.5 | 0.5010 | 1.75 |

| TF SavedModel | ✅ | 96.6 | 0.5665 | 88.87 |

| TF GraphDef | ✅ | 36.5 | 0.5665 | 89.20 |

| TF Lite | ✅ | 36.9 | 0.5665 | 604.25 |

| MNN | ✅ | 36.4 | 0.5651 | 53.75 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 42.2 | 0.6237 | 10.76 |

| TorchScript | ✅ | 78.5 | 0.6217 | 10.57 |

| ONNX | ✅ | 78.2 | 0.6211 | 14.91 |

| OpenVINO | ✅ | 82.2 | 0.6204 | 86.27 |

| TensorRT (FP32) | ✅ | 82.2 | 0.6230 | 5.56 |

| TensorRT (FP16) | ✅ | 41.6 | 0.6209 | 2.58 |

| TensorRT (INT8) | ✅ | 24.3 | 0.5595 | 2.49 |

| TF SavedModel | ✅ | 205.8 | 0.6229 | 200.96 |

| TF GraphDef | ✅ | 78.2 | 0.6229 | 203.00 |

| TF Lite | ✅ | 78.6 | 0.6229 | 1867.12 |

| MNN | ✅ | 78.0 | 0.6176 | 142.00 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 50.7 | 0.6258 | 13.34 |

| TorchScript | ✅ | 95.5 | 0.6248 | 13.86 |

| ONNX | ✅ | 95.0 | 0.6247 | 18.44 |

| OpenVINO | ✅ | 99.9 | 0.6238 | 106.67 |

| TensorRT (FP32) | ✅ | 99.0 | 0.6249 | 6.74 |

| TensorRT (FP16) | ✅ | 50.3 | 0.6243 | 3.34 |

| TensorRT (INT8) | ✅ | 29.0 | 0.5708 | 3.24 |

| TF SavedModel | ✅ | 250.0 | 0.6245 | 259.74 |

| TF GraphDef | ✅ | 95.0 | 0.6245 | 263.42 |

| TF Lite | ✅ | 95.4 | 0.6245 | 2367.83 |

| MNN | ✅ | 94.8 | 0.6272 | 174.39 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 113.2 | 0.6565 | 20.92 |

| TorchScript | ✅ | 213.5 | 0.6595 | 21.76 |

| ONNX | ✅ | 212.9 | 0.6590 | 26.72 |

| OpenVINO | ✅ | 223.6 | 0.6620 | 205.27 |

| TensorRT (FP32) | ✅ | 217.2 | 0.6593 | 12.29 |

| TensorRT (FP16) | ✅ | 112.1 | 0.6611 | 5.16 |

| TensorRT (INT8) | ✅ | 58.9 | 0.5222 | 4.72 |

| TF SavedModel | ✅ | 559.2 | 0.6593 | 498.85 |

| TF GraphDef | ✅ | 213.0 | 0.6593 | 507.43 |

| TF Lite | ✅ | 213.3 | 0.6593 | 5134.22 |

| MNN | ✅ | 212.8 | 0.6625 | 347.84 |

تمت المقارنة مع Ultralytics .4.7

ملاحظة

لا يشمل وقت الاستدلال المعالجة المسبقة/اللاحقة.

مجموعة تطوير NVIDIA Jetson AGX Orin (بسعة 64 جيجابايت)

الأداء

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 9.40 |

| TorchScript | ✅ | 10.5 | 0.5083 | 11.00 |

| ONNX | ✅ | 10.2 | 0.5077 | 48.32 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 27.24 |

| TensorRT (FP32) | ✅ | 12.1 | 0.5085 | 3.93 |

| TensorRT (FP16) | ✅ | 8.3 | 0.5063 | 2.55 |

| TensorRT (INT8) | ✅ | 5.4 | 0.4719 | 2.18 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 66.87 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 65.68 |

| TF Lite | ✅ | 10.3 | 0.5077 | 272.92 |

| MNN | ✅ | 10.1 | 0.5059 | 36.33 |

| NCNN | ✅ | 10.2 | 0.5031 | 28.51 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5783 | 12.10 |

| TorchScript | ✅ | 36.5 | 0.5782 | 11.01 |

| ONNX | ✅ | 36.3 | 0.5782 | 107.54 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 55.03 |

| TensorRT (FP32) | ✅ | 38.1 | 0.5781 | 6.52 |

| TensorRT (FP16) | ✅ | 21.4 | 0.5803 | 3.65 |

| TensorRT (INT8) | ✅ | 12.1 | 0.5735 | 2.81 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 132.73 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 134.96 |

| TF Lite | ✅ | 36.3 | 0.5782 | 798.21 |

| MNN | ✅ | 36.2 | 0.5777 | 82.35 |

| NCNN | ✅ | 36.2 | 0.5784 | 56.07 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6265 | 22.20 |

| TorchScript | ✅ | 77.3 | 0.6307 | 21.47 |

| ONNX | ✅ | 76.9 | 0.6307 | 270.89 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 129.10 |

| TensorRT (FP32) | ✅ | 78.8 | 0.6306 | 12.53 |

| TensorRT (FP16) | ✅ | 41.9 | 0.6305 | 6.25 |

| TensorRT (INT8) | ✅ | 23.2 | 0.6291 | 4.69 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 299.95 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 310.58 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2400.54 |

| MNN | ✅ | 76.8 | 0.6308 | 213.56 |

| NCNN | ✅ | 76.8 | 0.6284 | 141.18 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 27.70 |

| TorchScript | ✅ | 97.6 | 0.6399 | 27.94 |

| ONNX | ✅ | 97.0 | 0.6409 | 345.47 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 161.93 |

| TensorRT (FP32) | ✅ | 99.1 | 0.6406 | 16.11 |

| TensorRT (FP16) | ✅ | 52.6 | 0.6376 | 8.08 |

| TensorRT (INT8) | ✅ | 30.8 | 0.6208 | 6.12 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 390.78 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 398.76 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3037.05 |

| MNN | ✅ | 96.9 | 0.6372 | 265.46 |

| NCNN | ✅ | 96.9 | 0.6364 | 179.68 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 44.40 |

| TorchScript | ✅ | 218.1 | 0.6898 | 47.49 |

| ONNX | ✅ | 217.5 | 0.6900 | 682.98 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 298.15 |

| TensorRT (FP32) | ✅ | 219.6 | 0.6904 | 28.50 |

| TensorRT (FP16) | ✅ | 112.2 | 0.6887 | 13.55 |

| TensorRT (INT8) | ✅ | 60.0 | 0.6574 | 9.40 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 749.85 |

| TF GraphDef | ✅ | 217.7 | 0.6900 | 753.86 |

| TF Lite | ✅ | 217.6 | 0.6900 | 6603.27 |

| MNN | ✅ | 217.3 | 0.6868 | 519.77 |

| NCNN | ✅ | 217.3 | 0.6849 | 298.58 |

تم القياس باستخدام Ultralytics 8.3.157

ملاحظة

لا يشمل وقت الاستدلال المعالجة المسبقة/اللاحقة.

مجموعة أدوات NVIDIA Jetson Orin Nano Super Developer

الأداء

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 13.70 |

| TorchScript | ✅ | 10.5 | 0.5082 | 13.69 |

| ONNX | ✅ | 10.2 | 0.5081 | 14.47 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 56.66 |

| TensorRT (FP32) | ✅ | 12.0 | 0.5081 | 7.44 |

| TensorRT (FP16) | ✅ | 8.2 | 0.5061 | 4.53 |

| TensorRT (INT8) | ✅ | 5.4 | 0.4825 | 3.70 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 116.23 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 114.92 |

| TF Lite | ✅ | 10.3 | 0.5077 | 340.75 |

| MNN | ✅ | 10.1 | 0.5059 | 76.26 |

| NCNN | ✅ | 10.2 | 0.5031 | 45.03 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5790 | 20.90 |

| TorchScript | ✅ | 36.5 | 0.5781 | 21.22 |

| ONNX | ✅ | 36.3 | 0.5781 | 25.07 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 122.98 |

| TensorRT (FP32) | ✅ | 37.9 | 0.5783 | 13.02 |

| TensorRT (FP16) | ✅ | 21.8 | 0.5779 | 6.93 |

| TensorRT (INT8) | ✅ | 12.2 | 0.5735 | 5.08 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 250.65 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 252.69 |

| TF Lite | ✅ | 36.3 | 0.5782 | 998.68 |

| MNN | ✅ | 36.2 | 0.5781 | 188.01 |

| NCNN | ✅ | 36.2 | 0.5784 | 101.37 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6266 | 46.50 |

| TorchScript | ✅ | 77.3 | 0.6307 | 47.95 |

| ONNX | ✅ | 76.9 | 0.6307 | 53.06 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 301.63 |

| TensorRT (FP32) | ✅ | 78.8 | 0.6305 | 27.86 |

| TensorRT (FP16) | ✅ | 41.7 | 0.6309 | 13.50 |

| TensorRT (INT8) | ✅ | 23.2 | 0.6291 | 9.12 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 622.24 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 628.74 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2997.93 |

| MNN | ✅ | 76.8 | 0.6299 | 509.96 |

| NCNN | ✅ | 76.8 | 0.6284 | 292.99 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 56.50 |

| TorchScript | ✅ | 97.6 | 0.6409 | 62.51 |

| ONNX | ✅ | 97.0 | 0.6399 | 68.35 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 376.03 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6396 | 35.59 |

| TensorRT (FP16) | ✅ | 52.1 | 0.6361 | 17.48 |

| TensorRT (INT8) | ✅ | 30.9 | 0.6207 | 11.87 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 807.47 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 822.88 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3792.23 |

| MNN | ✅ | 96.9 | 0.6372 | 631.16 |

| NCNN | ✅ | 96.9 | 0.6364 | 350.46 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 90.00 |

| TorchScript | ✅ | 218.1 | 0.6901 | 113.40 |

| ONNX | ✅ | 217.5 | 0.6901 | 122.94 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 713.1 |

| TensorRT (FP32) | ✅ | 219.5 | 0.6904 | 66.93 |

| TensorRT (FP16) | ✅ | 112.2 | 0.6892 | 32.58 |

| TensorRT (INT8) | ✅ | 61.5 | 0.6612 | 19.90 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 1605.4 |

| TF GraphDef | ✅ | 217.8 | 0.6900 | 2961.8 |

| TF Lite | ✅ | 217.6 | 0.6900 | 8234.86 |

| MNN | ✅ | 217.3 | 0.6893 | 1254.18 |

| NCNN | ✅ | 217.3 | 0.6849 | 725.50 |

تم القياس باستخدام Ultralytics 8.3.157

ملاحظة

لا يشمل وقت الاستدلال المعالجة المسبقة/اللاحقة.

NVIDIA Jetson Orin NX 16GB

الأداء

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 12.90 |

| TorchScript | ✅ | 10.5 | 0.5082 | 13.17 |

| ONNX | ✅ | 10.2 | 0.5081 | 15.43 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 39.80 |

| TensorRT (FP32) | ✅ | 11.8 | 0.5081 | 7.94 |

| TensorRT (FP16) | ✅ | 8.1 | 0.5085 | 4.73 |

| TensorRT (INT8) | ✅ | 5.4 | 0.4786 | 3.90 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 88.48 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 86.67 |

| TF Lite | ✅ | 10.3 | 0.5077 | 302.55 |

| MNN | ✅ | 10.1 | 0.5059 | 52.73 |

| NCNN | ✅ | 10.2 | 0.5031 | 32.04 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5790 | 21.70 |

| TorchScript | ✅ | 36.5 | 0.5781 | 22.71 |

| ONNX | ✅ | 36.3 | 0.5781 | 26.49 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 84.73 |

| TensorRT (FP32) | ✅ | 37.8 | 0.5783 | 13.77 |

| TensorRT (FP16) | ✅ | 21.2 | 0.5796 | 7.31 |

| TensorRT (INT8) | ✅ | 12.0 | 0.5735 | 5.33 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 185.06 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 186.45 |

| TF Lite | ✅ | 36.3 | 0.5782 | 882.58 |

| MNN | ✅ | 36.2 | 0.5775 | 126.36 |

| NCNN | ✅ | 36.2 | 0.5784 | 66.73 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6266 | 45.00 |

| TorchScript | ✅ | 77.3 | 0.6307 | 51.87 |

| ONNX | ✅ | 76.9 | 0.6307 | 56.00 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 202.69 |

| TensorRT (FP32) | ✅ | 78.7 | 0.6305 | 30.38 |

| TensorRT (FP16) | ✅ | 41.8 | 0.6302 | 14.48 |

| TensorRT (INT8) | ✅ | 23.2 | 0.6291 | 9.74 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 445.58 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 460.94 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2653.65 |

| MNN | ✅ | 76.8 | 0.6308 | 339.38 |

| NCNN | ✅ | 76.8 | 0.6284 | 187.64 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 56.60 |

| TorchScript | ✅ | 97.6 | 0.6409 | 66.72 |

| ONNX | ✅ | 97.0 | 0.6399 | 71.92 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 254.17 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6406 | 38.89 |

| TensorRT (FP16) | ✅ | 51.9 | 0.6363 | 18.59 |

| TensorRT (INT8) | ✅ | 30.9 | 0.6207 | 12.60 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 575.98 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 583.79 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3353.41 |

| MNN | ✅ | 96.9 | 0.6367 | 421.33 |

| NCNN | ✅ | 96.9 | 0.6364 | 228.26 |

| التنسيق | الحالة | الحجم على القرص (ميجابايت) | mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 98.50 |

| TorchScript | ✅ | 218.1 | 0.6901 | 123.03 |

| ONNX | ✅ | 217.5 | 0.6901 | 129.55 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 483.44 |

| TensorRT (FP32) | ✅ | 219.6 | 0.6904 | 75.92 |

| TensorRT (FP16) | ✅ | 112.1 | 0.6885 | 35.78 |

| TensorRT (INT8) | ✅ | 61.6 | 0.6592 | 21.60 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 1120.43 |

| TF GraphDef | ✅ | 217.7 | 0.6900 | 1172.35 |

| TF Lite | ✅ | 217.6 | 0.6900 | 7283.63 |

| MNN | ✅ | 217.3 | 0.6877 | 840.16 |

| NCNN | ✅ | 217.3 | 0.6849 | 474.41 |

تم القياس باستخدام Ultralytics 8.3.157

ملاحظة

لا يشمل وقت الاستدلال المعالجة المسبقة/اللاحقة.

استكشف المزيد من جهود القياس بواسطة Seeed Studio التي تعمل على إصدارات مختلفة من أجهزة NVIDIA Jetson.

إعادة إنتاج نتائجنا

لإعادة إنتاج معايير Ultralytics المذكورة أعلاه على جميع صيغ التصدير، قم بتشغيل هذا الكود:

مثال

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml imgsz=640

لاحظ أن نتائج الاختبارات المعيارية قد تختلف بناءً على التكوين الدقيق للأجهزة والبرامج للنظام، بالإضافة إلى عبء العمل الحالي للنظام وقت تشغيل الاختبارات المعيارية. للحصول على النتائج الأكثر موثوقية، استخدم مجموعة بيانات تحتوي على عدد كبير من الصور، على سبيل المثال، data='coco.yaml' (5000 صورة تحقق).

أفضل الممارسات عند استخدام NVIDIA Jetson

عند استخدام NVIDIA Jetson، هناك بعض أفضل الممارسات التي يجب اتباعها لتمكين أقصى أداء على NVIDIA Jetson الذي يشغل YOLO26.

تمكين وضع الطاقة القصوى

سيضمن تمكين وضع الطاقة القصوى على Jetson تشغيل جميع نوى CPU و GPU.

sudo nvpmodel -m 0تمكين ساعات Jetson

سيضمن تمكين ساعات Jetson أن يتم ضبط جميع نوى CPU و GPU على أقصى تردد لها.

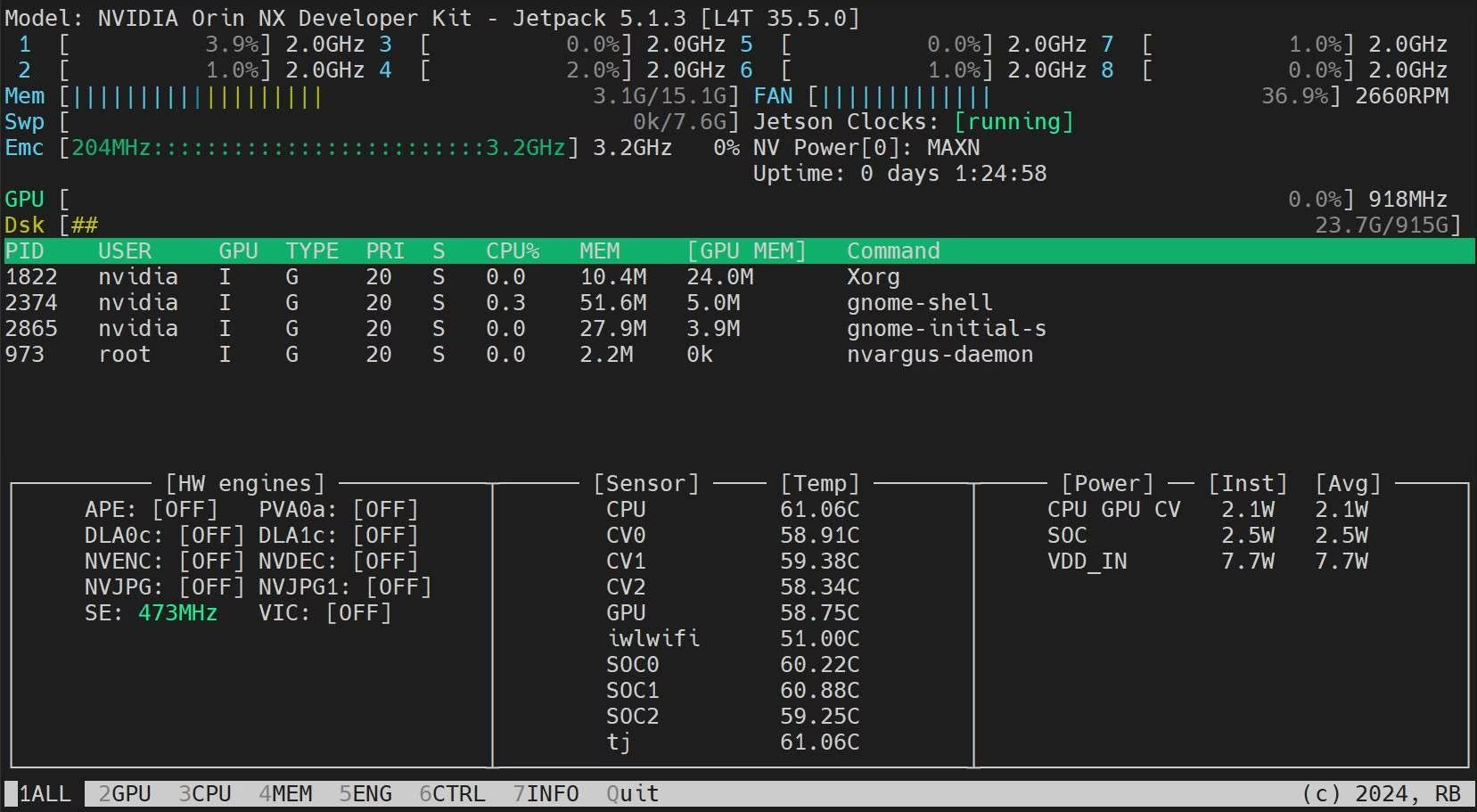

sudo jetson_clocksتثبيت تطبيق Jetson Stats

يمكننا استخدام تطبيق إحصائيات jetson لمراقبة درجات حرارة مكونات النظام والتحقق من تفاصيل النظام الأخرى مثل عرض وحدة المعالجة المركزية (CPU) ووحدة معالجة الرسومات (GPU) واستخدام ذاكرة الوصول العشوائي (RAM) وتغيير أوضاع الطاقة والتعيين إلى الحد الأقصى للساعات والتحقق من معلومات JetPack.

sudo apt update sudo pip install jetson-stats sudo reboot jtop

كيف يمكنني تدريب YOLOv5 على مجموعة البيانات المخصصة الخاصة بي؟

للمزيد من التعلم والدعم، راجع وثائق Ultralytics YOLO26.

الأسئلة الشائعة

كيف أقوم بنشر Ultralytics YOLO26 على أجهزة NVIDIA Jetson؟

يعد نشر Ultralytics YOLO26 على أجهزة NVIDIA Jetson عملية مباشرة. أولاً، قم بتثبيت NVIDIA JetPack SDK على جهاز Jetson الخاص بك. ثم، استخدم إما صورة Docker جاهزة للإعداد السريع أو قم بتثبيت الحزم المطلوبة يدويًا. يمكن العثور على خطوات مفصلة لكل نهج في قسمي البدء السريع باستخدام Docker و البدء بالتثبيت الأصلي.

ما هي معايير الأداء التي يمكن أن أتوقعها من نماذج YOLO11 على أجهزة NVIDIA Jetson؟

تمت مقارنة أداء نماذج YOLO11 على أجهزة NVIDIA Jetson المختلفة، مما أظهر تحسينات كبيرة في الأداء. على سبيل المثال، يوفر تنسيق TensorRT أفضل أداء للاستدلال. يقدم الجدول في قسم جداول المقارنة التفصيلية عرضًا شاملاً لمقاييس الأداء مثل mAP50-95 ووقت الاستدلال عبر تنسيقات النماذج المختلفة.

لماذا يجب أن أستخدم TensorRT لنشر YOLO26 على NVIDIA Jetson؟

يوصى بشدة باستخدام TensorRT لنشر نماذج YOLO26 على NVIDIA Jetson نظرًا لأدائه الأمثل. فهو يسرّع الاستدلال من خلال الاستفادة من قدرات GPU لجهاز Jetson، مما يضمن أقصى قدر من الكفاءة والسرعة. تعرّف على المزيد حول كيفية التحويل إلى TensorRT وتشغيل الاستدلال في قسم استخدام TensorRT على NVIDIA Jetson.

كيف يمكنني تثبيت PyTorch و Torchvision على NVIDIA Jetson؟

لتثبيت PyTorch و Torchvision على NVIDIA Jetson، قم أولاً بإلغاء تثبيت أي إصدارات موجودة ربما تم تثبيتها عبر pip. بعد ذلك، قم بتثبيت إصدارات PyTorch و Torchvision المتوافقة يدويًا لبنية ARM64 الخاصة بـ Jetson. يتم توفير إرشادات مفصلة لهذه العملية في قسم تثبيت PyTorch و Torchvision.

ما هي أفضل الممارسات لزيادة الأداء إلى أقصى حد على NVIDIA Jetson عند استخدام YOLO26؟

لزيادة الأداء إلى أقصى حد على NVIDIA Jetson باستخدام YOLO26، اتبع أفضل الممارسات التالية:

- تمكين وضع الطاقة القصوى لاستخدام جميع نوى CPU و GPU.

- تمكين ساعات Jetson لتشغيل جميع النوى بأقصى تردد لها.

- قم بتثبيت تطبيق Jetson Stats لمراقبة مقاييس النظام.

للحصول على الأوامر والتفاصيل الإضافية، راجع قسم أفضل الممارسات عند استخدام NVIDIA Jetson.