تصدير Intel OpenVINO

في هذا الدليل، نغطي تصدير نماذج YOLO26 إلى تنسيق OpenVINO، والذي يمكن أن يوفر تسريعًا يصل إلى 3 أضعاف في أداء CPU، بالإضافة إلى تسريع استدلال YOLO على أجهزة Intel GPU و NPU.

OpenVINO، اختصار لـ Open Visual Inference & Neural Network Optimization toolkit، هي مجموعة أدوات شاملة لتحسين ونشر نماذج الاستدلال بالذكاء الاصطناعي. على الرغم من أن الاسم يحتوي على Visual، إلا أن OpenVINO يدعم أيضًا العديد من المهام الإضافية بما في ذلك اللغة والصوت والسلاسل الزمنية وما إلى ذلك.

شاهد: كيفية تصدير Ultralytics YOLO26 إلى تنسيق Intel OpenVINO لاستدلال أسرع 🚀

أمثلة الاستخدام

قم بتصدير نموذج YOLO26n إلى تنسيق OpenVINO وتشغيل الاستدلال بالنموذج المصدر.

مثال

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

وسائط التصدير

| الوسيطة | النوع | افتراضي | الوصف |

|---|---|---|---|

format | str | 'openvino' | تنسيق الهدف للنموذج الذي تم تصديره، والذي يحدد التوافق مع بيئات النشر المختلفة. |

imgsz | int أو tuple | 640 | حجم الصورة المطلوب لإدخال النموذج. يمكن أن يكون عددًا صحيحًا للصور المربعة أو صفًا. (height, width) لأبعاد محددة. |

half | bool | False | يتيح تكميم FP16 (نصف الدقة)، مما يقلل من حجم النموذج وربما يسرع الاستدلال على الأجهزة المدعومة. |

int8 | bool | False | يقوم بتنشيط تكميم INT8، مما يزيد من ضغط النموذج وتسريع الاستدلال مع الحد الأدنى من فقدان الدقة، خاصةً للأجهزة الطرفية. |

dynamic | bool | False | يسمح بأحجام إدخال ديناميكية، مما يعزز المرونة في التعامل مع أبعاد الصور المتغيرة. |

nms | bool | False | يضيف خاصية منع التداخل (NMS)، الضرورية للمعالجة اللاحقة للكشف الدقيقة والفعالة. |

batch | int | 1 | يحدد حجم الاستدلال الدفعي لنموذج التصدير أو الحد الأقصى لعدد الصور التي سيعالجها النموذج المصدر في وقت واحد في predict الوضع. |

data | str | 'coco8.yaml' | مسار إلى مجموعة البيانات ملف التكوين (افتراضي: coco8.yaml)، وهو ضروري لتحديد الكميات. |

fraction | float | 1.0 | يحدد جزء مجموعة البيانات المراد استخدامها لمعايرة القياس الكمي INT8. يسمح بالمعايرة على مجموعة فرعية من مجموعة البيانات الكاملة، وهو أمر مفيد للتجارب أو عندما تكون الموارد محدودة. إذا لم يتم تحديده مع تمكين INT8، فسيتم استخدام مجموعة البيانات الكاملة. |

لمزيد من التفاصيل حول عملية التصدير، قم بزيارة صفحة وثائق Ultralytics حول التصدير.

تحذير

يتوافق OpenVINO™ مع معظم معالجات Intel® ولكن لضمان الأداء الأمثل:

تحقق من دعم OpenVINO™ تحقق مما إذا كانت شريحة Intel® الخاصة بك مدعومة رسميًا من قبل OpenVINO™ باستخدام قائمة توافق Intel.

حدد المسرّع الخاص بك. تحقق مما إذا كان المعالج الخاص بك يتضمن وحدة معالجة عصبية (NPU) مدمجة أو وحدة معالجة رسوميات (GPU) (وحدة معالجة رسوميات مدمجة) عن طريق الرجوع إلى دليل أجهزة Intel.

قم بتثبيت أحدث برامج التشغيل إذا كانت الشريحة الخاصة بك تدعم وحدة المعالجة العصبية (NPU) أو وحدة معالجة الرسومات (GPU) ولكن OpenVINO™ لا تكتشفها، فقد تحتاج إلى تثبيت برامج التشغيل المرتبطة أو تحديثها. اتبع تعليمات تثبيت برنامج التشغيل لتمكين التسريع الكامل.

باتباع هذه الخطوات الثلاث، يمكنك التأكد من أن OpenVINO™ يعمل على النحو الأمثل على أجهزة Intel® الخاصة بك.

فوائد OpenVINO

- الأداء: يوفر OpenVINO استدلالًا عالي الأداء من خلال الاستفادة من قوة وحدات المعالجة المركزية (CPU) ووحدات معالجة الرسومات (GPU) المتكاملة والمنفصلة، و FPGAs من Intel.

- دعم التنفيذ غير المتجانس: يوفر OpenVINO واجهة برمجة تطبيقات (API) للكتابة مرة واحدة والنشر على أي جهاز Intel مدعوم (وحدة المعالجة المركزية CPU، ووحدة معالجة الرسومات GPU، و FPGA، و VPU، وما إلى ذلك).

- محسِّن النموذج (Model Optimizer): يوفر OpenVINO مُحسِّن نموذج يستورد النماذج ويحولها ويحسنها من أطر التعلم العميق الشائعة مثل PyTorch و TensorFlow و TensorFlow Lite و Keras و ONNX و PaddlePaddle و Caffe.

- سهولة الاستخدام: تأتي مجموعة الأدوات مع أكثر من 80 دفترًا تعليميًا (بما في ذلك تحسين YOLOv8) لتعليم جوانب مختلفة من مجموعة الأدوات.

هيكل تصدير OpenVINO

عندما تقوم بتصدير نموذج إلى تنسيق OpenVINO، فإنه يؤدي إلى دليل يحتوي على ما يلي:

- ملف XML: يصف هيكل الشبكة.

- ملف BIN: يحتوي على بيانات ثنائية للأوزان والانحيازات.

- ملف الربط: يحتفظ بربط موترات إخراج النموذج الأصلي بأسماء موترات OpenVINO.

يمكنك استخدام هذه الملفات لتشغيل الاستدلال باستخدام محرك الاستدلال OpenVINO.

استخدام تصدير OpenVINO في النشر

بمجرد تصدير النموذج الخاص بك بنجاح إلى تنسيق OpenVINO، لديك خياران أساسيان لتشغيل الاستدلال:

استخدم

ultralytics، الذي يوفر واجهة برمجة تطبيقات عالية المستوى ويغلف وقت تشغيل OpenVINO.استخدم الأصلي

openvinoلتوفير تحكم أكثر تقدمًا أو مخصصًا في سلوك الاستدلال.

الاستدلال باستخدام Ultralytics

تتيح لك حزمة ultralytics تشغيل الاستدلال بسهولة باستخدام نموذج OpenVINO المصدر عبر طريقة التنبؤ. يمكنك أيضًا تحديد الجهاز المستهدف (على سبيل المثال، intel:gpu, intel:npu, intel:cpu) باستخدام وسيطة الجهاز.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

هذا الأسلوب مثالي للنماذج الأولية السريعة أو النشر عندما لا تحتاج إلى تحكم كامل في مسار الاستدلال.

الاستدلال باستخدام OpenVINO Runtime

يوفر OpenVINO Runtime واجهة برمجة تطبيقات موحدة للاستدلال عبر جميع أجهزة Intel المدعومة. كما يوفر إمكانيات متقدمة مثل موازنة التحميل عبر أجهزة Intel والتنفيذ غير المتزامن. لمزيد من المعلومات حول تشغيل الاستدلال، ارجع إلى دفاتر ملاحظات YOLO26.

تذكر، ستحتاج إلى ملفات XML و BIN بالإضافة إلى أي إعدادات خاصة بالتطبيق مثل حجم الإدخال، عامل القياس للتطبيع، وما إلى ذلك، لتهيئة النموذج واستخدامه بشكل صحيح مع وقت التشغيل.

في تطبيق النشر الخاص بك، ستقوم عادةً بالخطوات التالية:

- تهيئة OpenVINO عن طريق إنشاء

core = Core(). - قم بتحميل النموذج باستخدام

core.read_model()دالة (method). - تجميع النموذج باستخدام

core.compile_model()الدالة. - إعداد المدخلات (صورة، نص، صوت، إلخ).

- تشغيل الاستدلال باستخدام

compiled_model(input_data).

للحصول على خطوات ومقتطفات التعليمات البرمجية أكثر تفصيلاً، راجع وثائق OpenVINO أو البرنامج التعليمي لواجهة برمجة التطبيقات (API).

معايير OpenVINO YOLO11

قام فريق Ultralytics بتقييم YOLO11 عبر تنسيقات نماذج مختلفة و دقة، وتقييم السرعة والدقة على أجهزة Intel المختلفة المتوافقة مع OpenVINO.

ملاحظة

نتائج القياس المعياري أدناه هي للإشارة وقد تختلف بناءً على التكوين الدقيق للأجهزة والبرامج للنظام، بالإضافة إلى عبء العمل الحالي للنظام في وقت تشغيل القياسات.

يتم تشغيل جميع المقاييس المعيارية باستخدام openvino إصدار حزمة Python 2025.1.0.

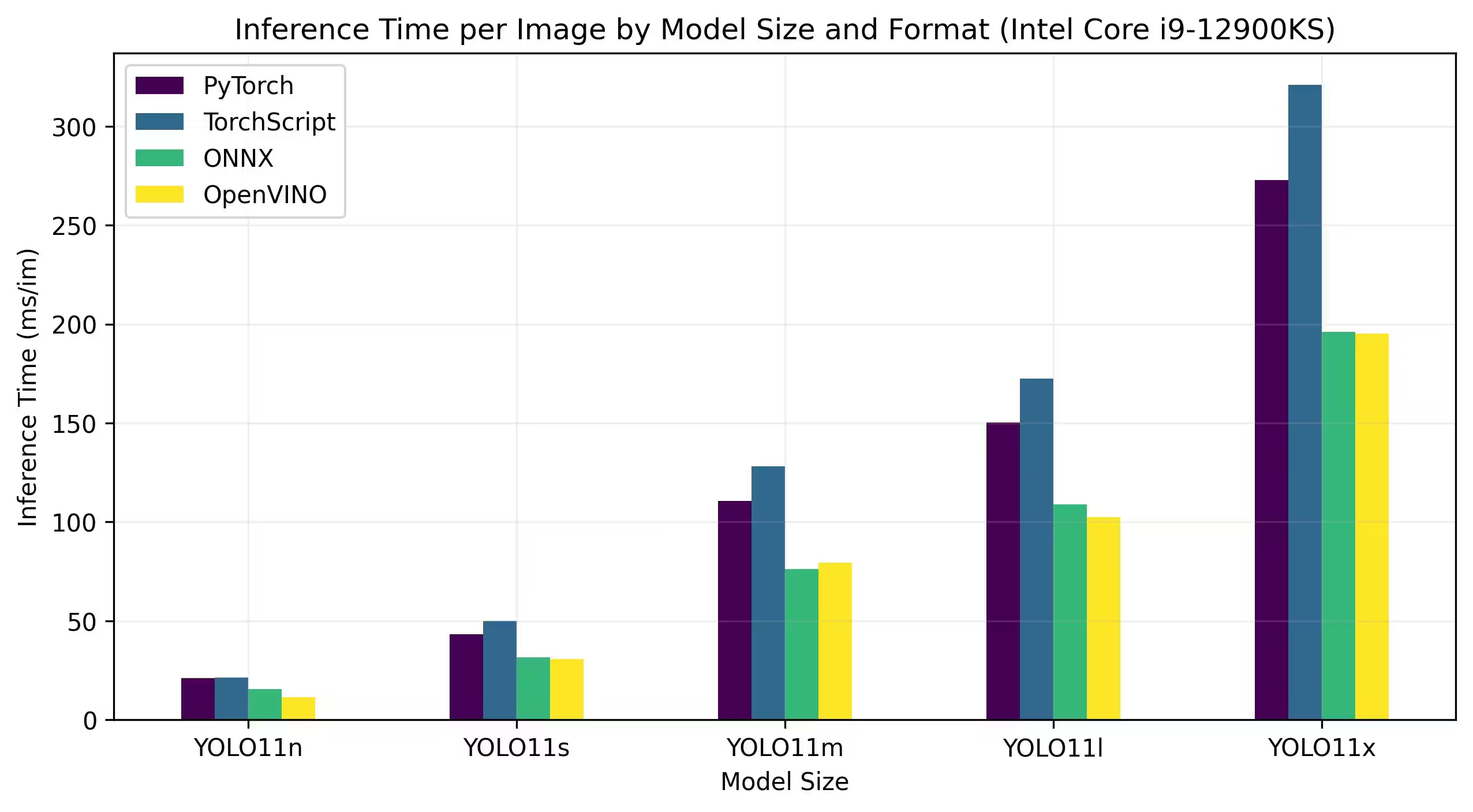

وحدة المعالجة المركزية Intel Core

تُعد سلسلة Intel® Core® مجموعة من المعالجات عالية الأداء من Intel. تشتمل التشكيلة على Core i3 (المستوى المبتدئ) و Core i5 (النطاق المتوسط) و Core i7 (المستوى العالي) و Core i9 (الأداء الفائق). تلبي كل سلسلة احتياجات وميزانيات حوسبة مختلفة، من المهام اليومية إلى أعباء العمل الاحترافية الصعبة. مع كل جيل جديد، يتم إجراء تحسينات على الأداء وكفاءة الطاقة والميزات.

تعمل المقاييس المرجعية أدناه على الجيل الثاني عشر من معالج Intel® Core® i9-12900KS CPU بدقة FP32.

نتائج معيارية تفصيلية

| النموذج | التنسيق | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

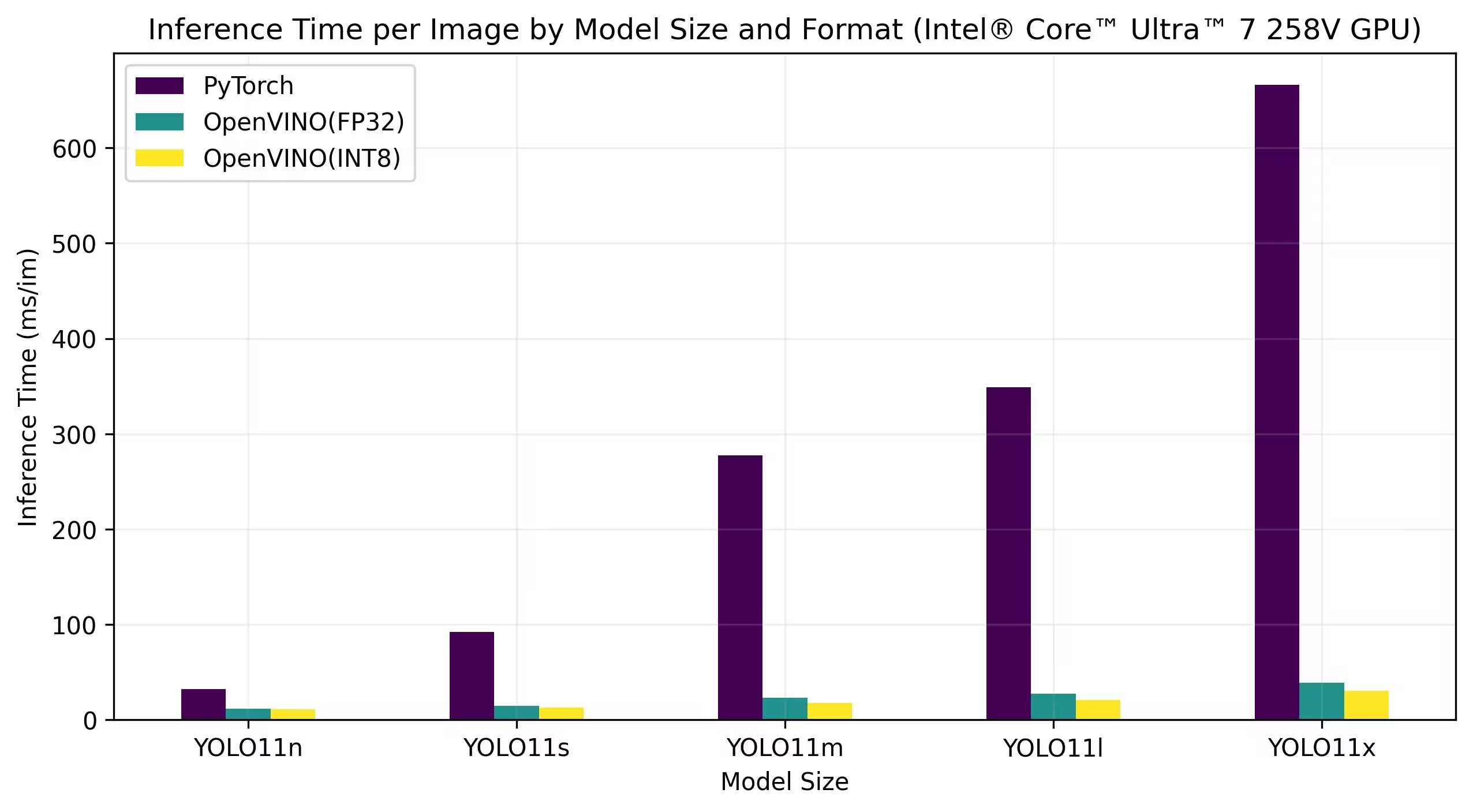

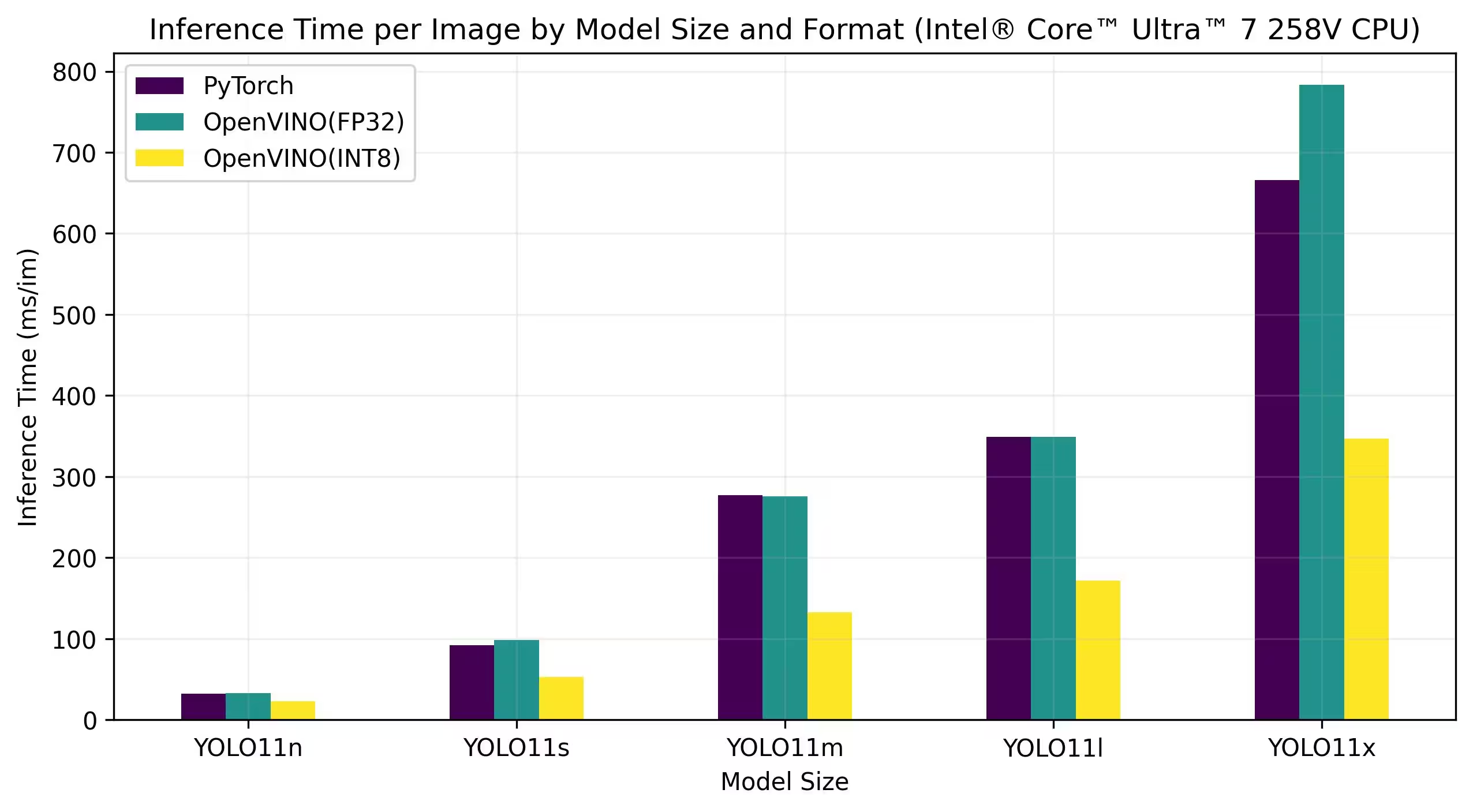

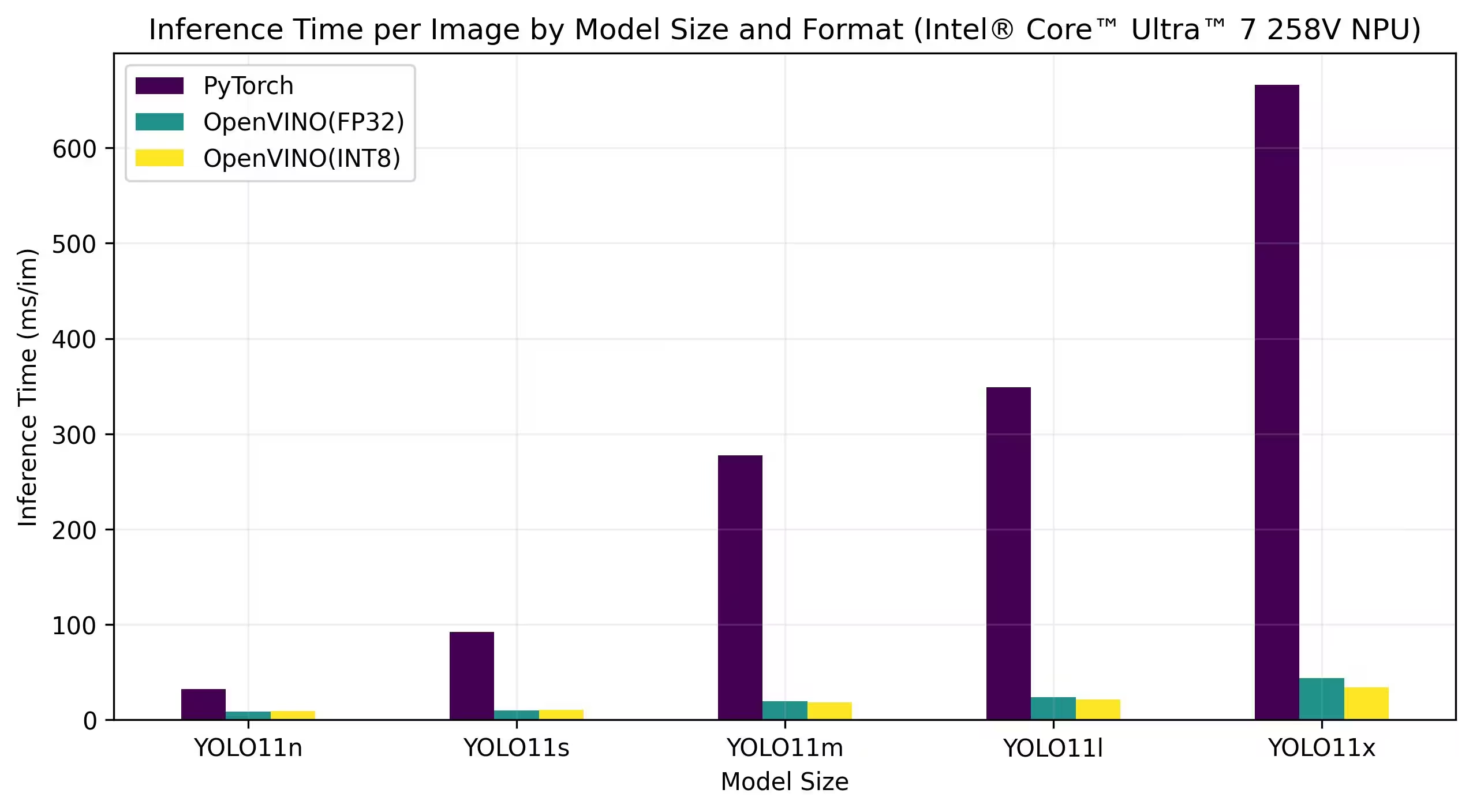

Intel® Core™ Ultra

تمثل سلسلة Intel® Core™ Ultra™ معيارًا جديدًا في الحوسبة عالية الأداء، وهي مصممة لتلبية المتطلبات المتطورة للمستخدمين العصريين - من اللاعبين والمبدعين إلى المحترفين الذين يستفيدون من الذكاء الاصطناعي. هذه التشكيلة من الجيل التالي هي أكثر من مجرد سلسلة وحدات معالجة مركزية تقليدية؛ فهي تجمع بين نوى وحدة المعالجة المركزية القوية وقدرات وحدة معالجة الرسوميات GPU عالية الأداء المدمجة ووحدة المعالجة العصبية المخصصة (NPU) داخل شريحة واحدة، مما يوفر حلاً موحدًا لأعباء العمل الحسابية المتنوعة والمكثفة.

يكمن في قلب بنية Intel® Core Ultra™ تصميم هجين يتيح أداءً استثنائيًا عبر مهام المعالجة التقليدية وأعباء العمل المتسارعة بواسطة GPU والعمليات المدفوعة بالذكاء الاصطناعي. يعزز تضمين NPU الاستنتاج بالذكاء الاصطناعي على الجهاز، مما يتيح تعلمًا آليًا أسرع وأكثر كفاءة ومعالجة بيانات عبر مجموعة واسعة من التطبيقات.

تتضمن عائلة Core Ultra™ نماذج مختلفة مصممة خصيصًا لتلبية احتياجات الأداء المختلفة، مع خيارات تتراوح من التصميمات الموفرة للطاقة إلى المتغيرات عالية الطاقة التي تحمل علامة "H" — وهي مثالية لأجهزة الكمبيوتر المحمولة وعوامل الشكل المدمجة التي تتطلب قوة حوسبة جادة. عبر المجموعة، يستفيد المستخدمون من التآزر بين تكامل CPU و GPU و NPU، مما يوفر كفاءة واستجابة وقدرات تعدد المهام رائعة.

كجزء من ابتكارات Intel المستمرة، تضع سلسلة Core Ultra™ معيارًا جديدًا للحوسبة الجاهزة للمستقبل. مع توفر نماذج متعددة والمزيد في الأفق، تؤكد هذه السلسلة التزام Intel بتقديم حلول متطورة للجيل القادم من الأجهزة الذكية والمعززة بالذكاء الاصطناعي.

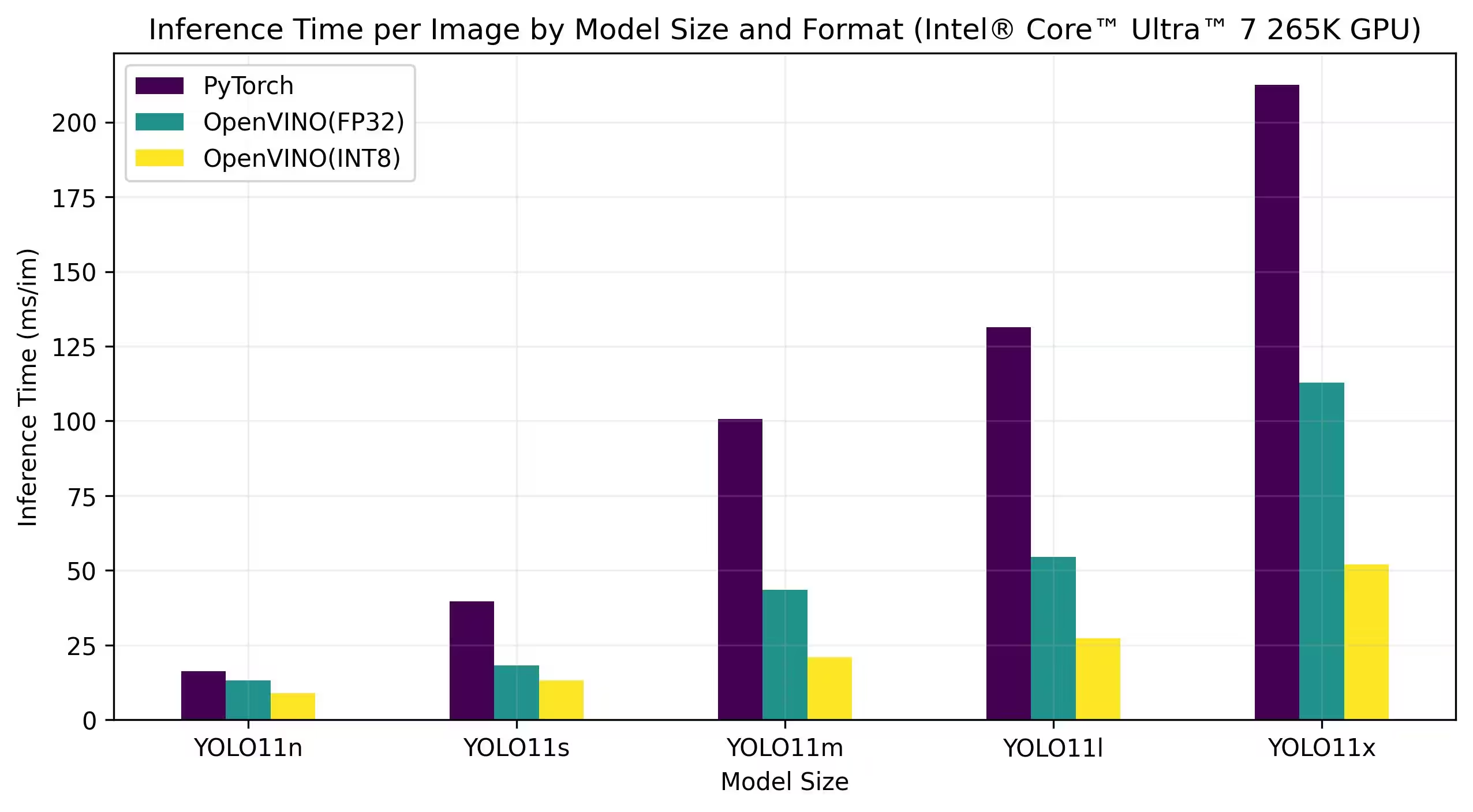

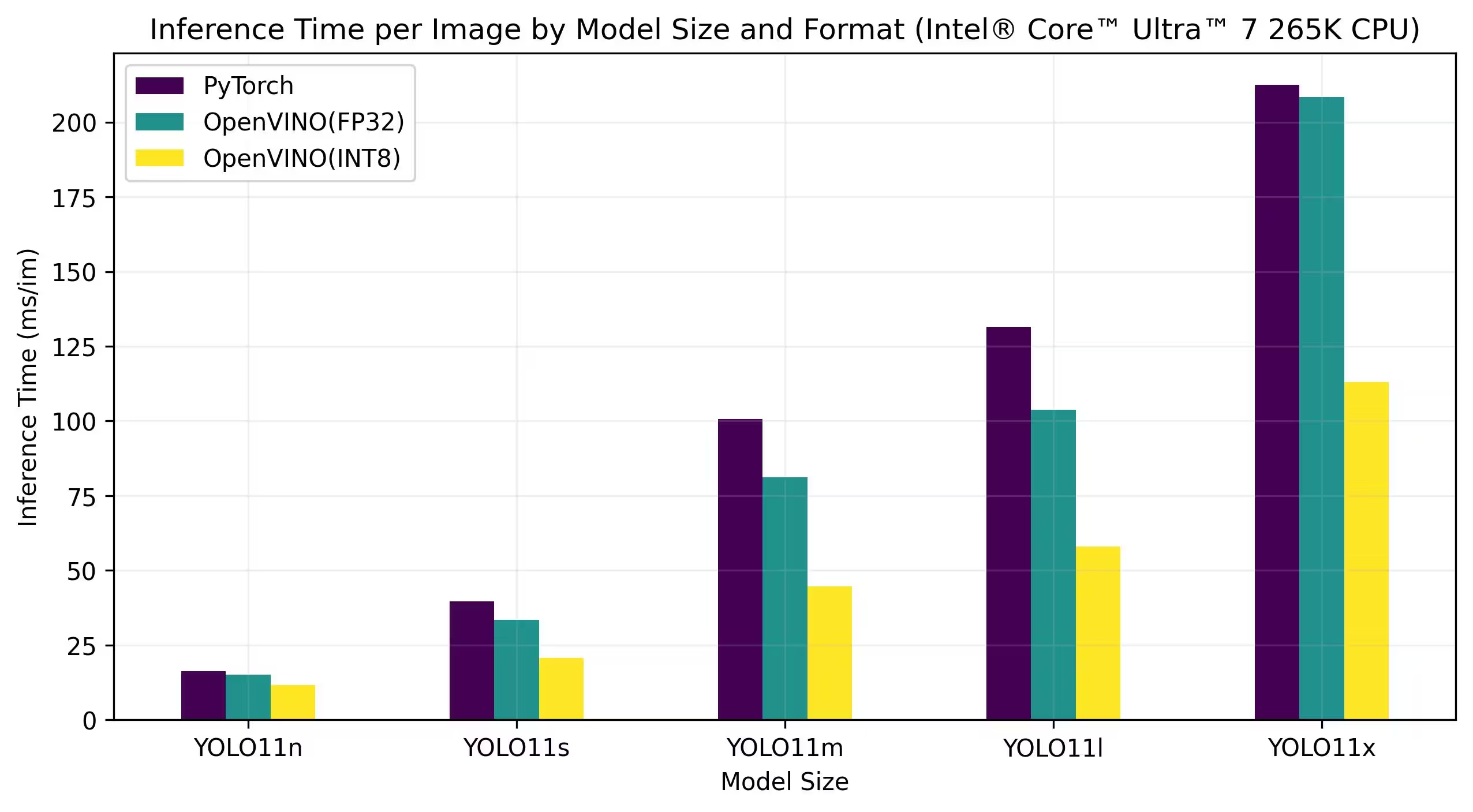

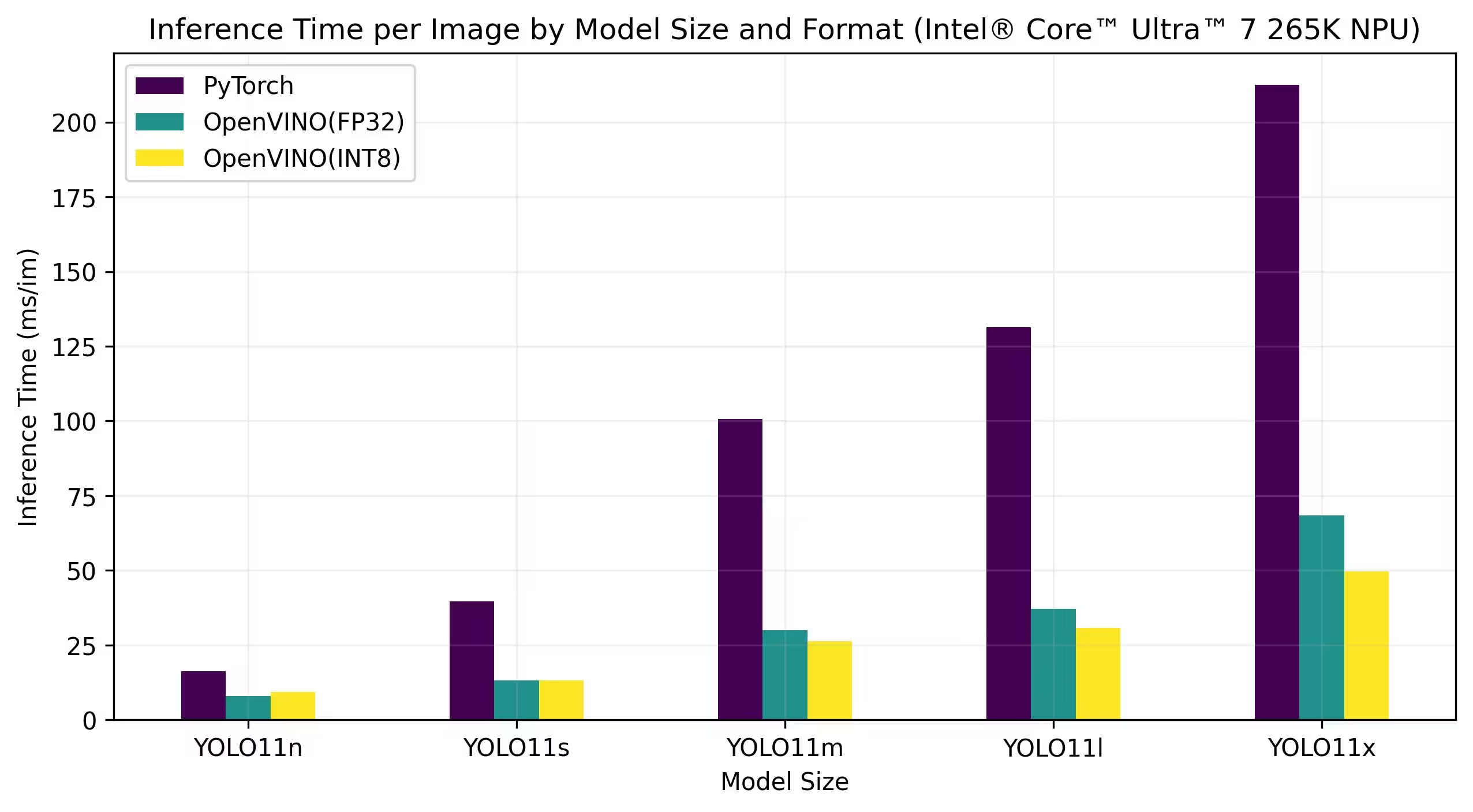

تعمل المقاييس المرجعية أدناه على معالجات Intel® Core™ Ultra™ 7 258V و Intel® Core™ Ultra™ 7 265K بدقة FP32 و INT8.

Intel® Core™ Ultra™ 7 258V

المعايير

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

Intel® Core™ Ultra™ 7 265K

المعايير

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

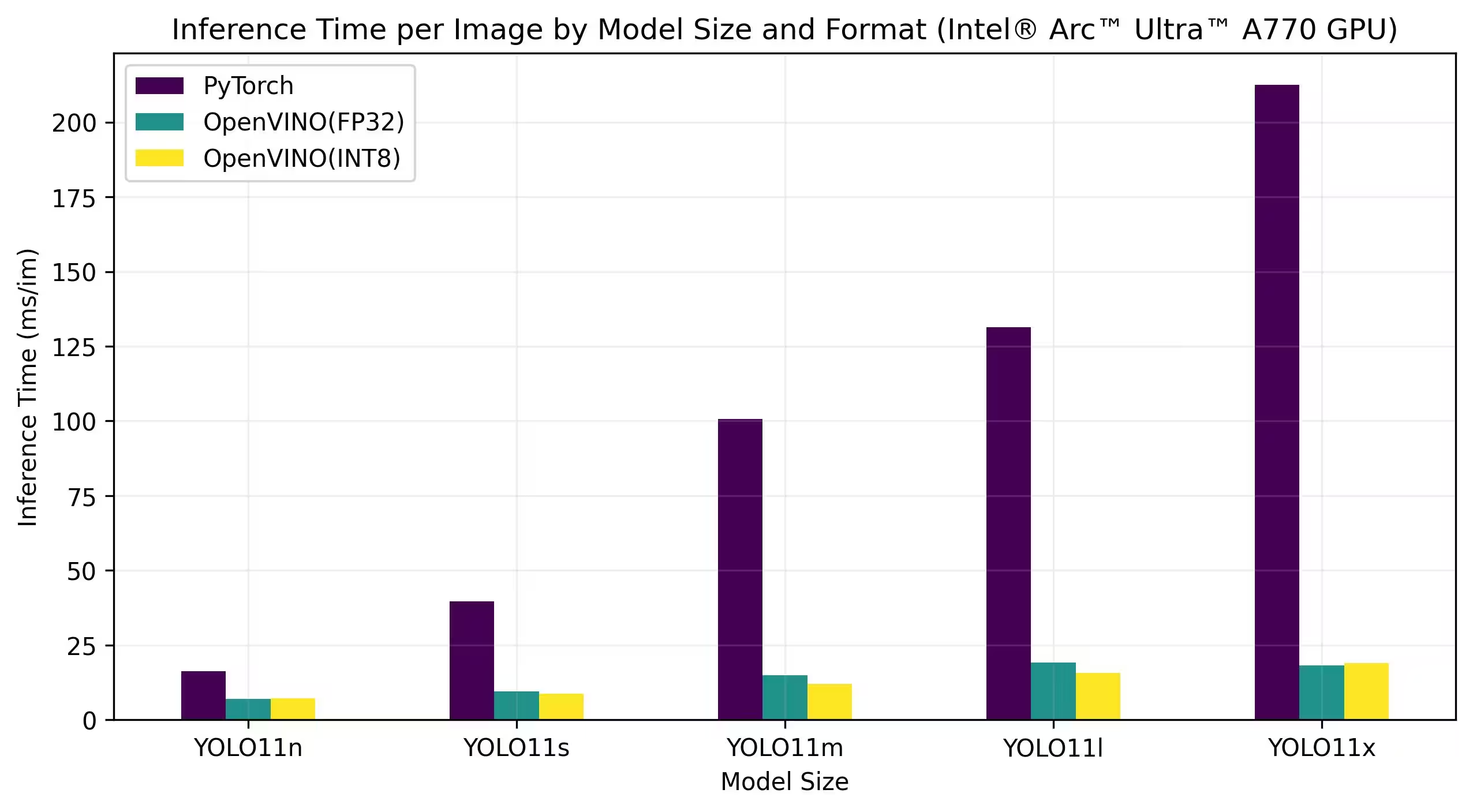

Intel® Arc GPU

تُعد Intel® Arc™ خطًا من بطاقات الرسومات المنفصلة من Intel مصممة للألعاب عالية الأداء وإنشاء المحتوى وأحمال عمل الذكاء الاصطناعي. تتميز سلسلة Arc ببنى GPU متقدمة تدعم تتبع الأشعة في الوقت الفعلي والرسومات المحسّنة بالذكاء الاصطناعي والألعاب عالية الدقة. مع التركيز على الأداء والكفاءة، تهدف Intel® Arc™ إلى منافسة العلامات التجارية الرائدة الأخرى في مجال GPU مع توفير ميزات فريدة مثل ترميز AV1 المسرّع بالأجهزة ودعم أحدث واجهات برمجة تطبيقات الرسومات.

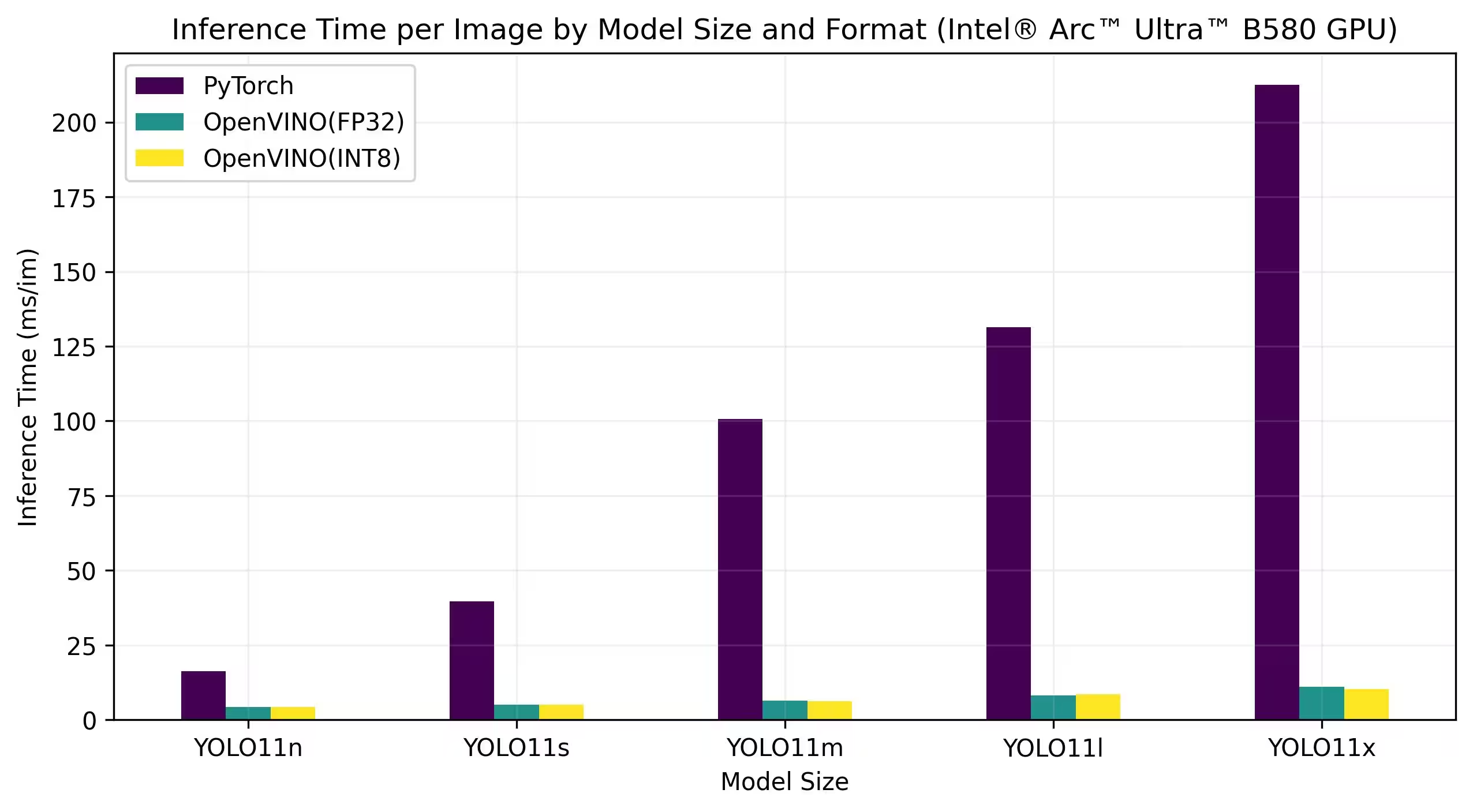

تعمل المقاييس المرجعية أدناه على Intel Arc A770 و Intel Arc B580 بدقة FP32 و INT8.

Intel Arc A770

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

نتائج معيارية تفصيلية

| النموذج | التنسيق | الدقة | الحالة | الحجم (ميجابايت) | metrics/mAP50-95(B) | وقت الاستدلال (مللي ثانية / صورة) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

إعادة إنتاج نتائجنا

لإعادة إنتاج معايير Ultralytics المذكورة أعلاه على جميع صيغ التصدير، قم بتشغيل هذا الكود:

مثال

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

لاحظ أن نتائج القياس قد تختلف بناءً على التكوين الدقيق للأجهزة والبرامج الخاصة بالنظام، بالإضافة إلى عبء العمل الحالي للنظام في وقت تشغيل القياسات. للحصول على نتائج أكثر موثوقية، استخدم مجموعة بيانات تحتوي على عدد كبير من الصور، أي data='coco.yaml' (5000 صورة تحقق).

الخلاصة

توضح نتائج المقارنة المعيارية بوضوح فوائد تصدير نموذج YOLO11 إلى تنسيق OpenVINO. عبر النماذج المختلفة والمنصات الصلبة، يتفوق تنسيق OpenVINO باستمرار على التنسيقات الأخرى من حيث سرعة الاستدلال مع الحفاظ على دقة مماثلة.

تؤكد المعايير فعالية OpenVINO كأداة لنشر نماذج التعلم العميق. من خلال تحويل النماذج إلى تنسيق OpenVINO، يمكن للمطورين تحقيق تحسينات كبيرة في الأداء، مما يسهل نشر هذه النماذج في تطبيقات العالم الحقيقي.

لمزيد من المعلومات التفصيلية والإرشادات حول استخدام OpenVINO، راجع وثائق OpenVINO الرسمية.

الأسئلة الشائعة

كيف أقوم بتصدير نماذج YOLO26 إلى تنسيق OpenVINO؟

يمكن لتصدير نماذج YOLO26 إلى تنسيق OpenVINO أن يعزز سرعة CPU بشكل كبير ويمكّن تسريع GPU و NPU على أجهزة Intel. للتصدير، يمكنك استخدام Python أو CLI كما هو موضح أدناه:

مثال

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

لمزيد من المعلومات، راجع وثائق تنسيقات التصدير.

ما هي فوائد استخدام OpenVINO مع نماذج YOLO26؟

يوفر استخدام مجموعة أدوات OpenVINO من Intel مع نماذج YOLO26 العديد من الفوائد:

- الأداء: حقق تسريعًا يصل إلى 3x في استنتاج وحدة المعالجة المركزية (CPU) واستفد من وحدات معالجة الرسومات (GPU) ووحدات المعالجة العصبية (NPU) من Intel للتسريع.

- محسِّن النموذج (Model Optimizer): قم بتحويل النماذج وتحسينها وتنفيذها من الأطر الشائعة مثل PyTorch و TensorFlow و ONNX.

- سهولة الاستخدام: يتوفر أكثر من 80 دفتر ملاحظات تعليمي لمساعدة المستخدمين على البدء، بما في ذلك دفاتر خاصة بـ YOLO26.

- تنفيذ غير متجانس: نشر النماذج على أجهزة Intel المختلفة بواجهة برمجة تطبيقات موحدة.

للحصول على مقارنات تفصيلية للأداء، تفضل بزيارة قسم المعايير الخاص بنا.

كيف يمكنني تشغيل الاستدلال باستخدام نموذج YOLO26 تم تصديره إلى OpenVINO؟

بعد تصدير نموذج YOLO26n إلى تنسيق OpenVINO، يمكنك تشغيل الاستدلال باستخدام Python أو CLI:

مثال

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

راجع وثائق وضع التنبؤ لمزيد من التفاصيل.

لماذا يجب أن أختار Ultralytics YOLO26 بدلاً من النماذج الأخرى لتصدير OpenVINO؟

تم تحسين Ultralytics YOLO26 للكشف عن الكائنات في الوقت الفعلي بدقة وسرعة عالية. على وجه التحديد، عند دمجه مع OpenVINO، يوفر YOLO26 ما يلي:

- تسريع يصل إلى 3 أضعاف على وحدات المعالجة المركزية Intel

- نشر سلس على وحدات معالجة الرسوميات (GPU) ووحدات المعالجة العصبية (NPU) من Intel

- دقة متسقة وقابلة للمقارنة عبر تنسيقات التصدير المختلفة

لتحليل متعمق للأداء، تحقق من معايير YOLO11 التفصيلية الخاصة بنا على أجهزة مختلفة.

هل يمكنني قياس أداء نماذج YOLO26 على تنسيقات مختلفة مثل PyTorch و ONNX و OpenVINO؟

نعم، يمكنك قياس أداء نماذج YOLO26 في تنسيقات مختلفة بما في ذلك PyTorch و TorchScript و ONNX و OpenVINO. استخدم مقتطف الشفرة التالي لتشغيل قياسات الأداء على مجموعة البيانات التي اخترتها:

مثال

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

للحصول على نتائج معيارية مفصلة، راجع قسم المعايير ووثائق تنسيقات التصدير الخاصة بنا.