Inferencia segura para subprocesos con modelos YOLO

La ejecución de modelos YOLO en un entorno multi-hilo requiere una consideración cuidadosa para garantizar la seguridad de los hilos. Python threading El módulo te permite ejecutar varios hilos concurrentemente, pero cuando se trata de usar modelos YOLO a través de estos hilos, hay importantes problemas de seguridad que debes tener en cuenta. Esta página te guiará a través de la creación de inferencias de modelos YOLO seguros para hilos.

Ver: Cómo realizar una inferencia segura para subprocesos con modelos Ultralytics YOLO en python | Multihilo 🚀

Comprensión de hilos de ejecución en Python

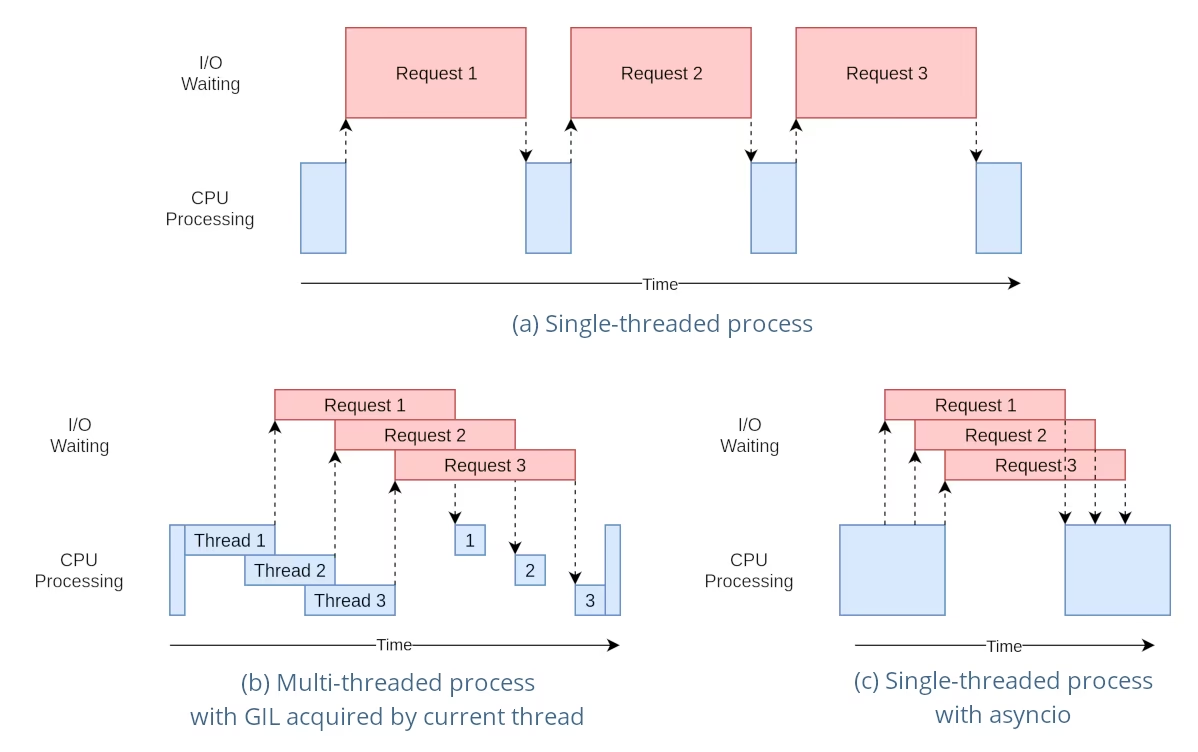

Los hilos de Python son una forma de paralelismo que permite que tu programa ejecute múltiples operaciones a la vez. Sin embargo, el bloqueo global del intérprete (GIL) de Python significa que solo un hilo puede ejecutar bytecode de Python a la vez.

Si bien esto suena como una limitación, los hilos aún pueden proporcionar concurrencia, especialmente para las operaciones vinculadas a E/S o cuando se utilizan operaciones que liberan el GIL, como las realizadas por las bibliotecas C subyacentes de YOLO.

El peligro de las instancias de modelos compartidos

La creación de instancias de un modelo YOLO fuera de tus hilos y el hecho de compartir esta instancia a través de múltiples hilos puede conducir a condiciones de carrera, donde el estado interno del modelo se modifica de forma inconsistente debido a accesos concurrentes. Esto es particularmente problemático cuando el modelo o sus componentes mantienen un estado que no está diseñado para ser seguro para los hilos.

Ejemplo no seguro para hilos: Instancia única del modelo

Cuando se utilizan hilos en python, es importante reconocer los patrones que pueden conducir a problemas de concurrencia. Esto es lo que debe evitar: compartir una única instancia del modelo YOLO entre varios hilos.

# Unsafe: Sharing a single model instance across threads

from threading import Thread

from ultralytics import YOLO

# Instantiate the model outside the thread

shared_model = YOLO("yolo26n.pt")

def predict(image_path):

"""Predicts objects in an image using a preloaded YOLO model, take path string to image as argument."""

results = shared_model.predict(image_path)

# Process results

# Starting threads that share the same model instance

Thread(target=predict, args=("image1.jpg",)).start()

Thread(target=predict, args=("image2.jpg",)).start()

En el ejemplo anterior, el shared_model es utilizado por múltiples hilos, lo que puede conducir a resultados impredecibles porque predict podría ser ejecutado simultáneamente por múltiples hilos.

Ejemplo no seguro para hilos: Múltiples instancias del modelo

De manera similar, aquí hay un patrón inseguro con múltiples instancias del modelo YOLO:

# Unsafe: Sharing multiple model instances across threads can still lead to issues

from threading import Thread

from ultralytics import YOLO

# Instantiate multiple models outside the thread

shared_model_1 = YOLO("yolo26n_1.pt")

shared_model_2 = YOLO("yolo26n_2.pt")

def predict(model, image_path):

"""Runs prediction on an image using a specified YOLO model, returning the results."""

results = model.predict(image_path)

# Process results

# Starting threads with individual model instances

Thread(target=predict, args=(shared_model_1, "image1.jpg")).start()

Thread(target=predict, args=(shared_model_2, "image2.jpg")).start()

Aunque existen dos instancias de modelo separadas, el riesgo de problemas de concurrencia aún existe. Si la implementación interna de YOLO no es thread-safe, el uso de instancias separadas podría no evitar las condiciones de carrera, especialmente si estas instancias comparten recursos o estados subyacentes que no son thread-local.

Inferencia segura para subprocesos

Para realizar inferencias de forma segura para subprocesos, debes instanciar un modelo YOLO separado dentro de cada subproceso. Esto asegura que cada subproceso tenga su propia instancia de modelo aislada, eliminando el riesgo de condiciones de carrera.

Ejemplo de seguridad para subprocesos

Aquí se explica cómo instanciar un modelo YOLO dentro de cada hilo para una inferencia paralela segura:

# Safe: Instantiating a single model inside each thread

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image using a new YOLO model instance in a thread-safe manner; takes image path as input."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

# Starting threads that each have their own model instance

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

En este ejemplo, cada hilo crea su propio YOLO instancia. Esto evita que cualquier hilo interfiera con el estado del modelo de otro, asegurando así que cada hilo realice la inferencia de forma segura y sin interacciones inesperadas con los otros hilos.

Usando el Decorador ThreadingLocked

Ultralytics proporciona una ThreadingLocked decorador que se puede utilizar para garantizar la ejecución segura para subprocesos de funciones. Este decorador utiliza un bloqueo para garantizar que solo un subproceso a la vez pueda ejecutar la función decorada.

from ultralytics import YOLO

from ultralytics.utils import ThreadingLocked

# Create a model instance

model = YOLO("yolo26n.pt")

# Decorate the predict method to make it thread-safe

@ThreadingLocked()

def thread_safe_predict(image_path):

"""Thread-safe prediction using a shared model instance."""

results = model.predict(image_path)

return results

# Now you can safely call this function from multiple threads

El ThreadingLocked El decorador es particularmente útil cuando necesita compartir una instancia de modelo entre subprocesos, pero desea asegurarse de que solo un subproceso pueda acceder a ella a la vez. Este enfoque puede ahorrar memoria en comparación con la creación de una nueva instancia de modelo para cada subproceso, pero puede reducir la concurrencia, ya que los subprocesos deberán esperar a que se libere el bloqueo.

Conclusión

Cuando se utilizan modelos YOLO con python, threading, siempre instancia tus modelos dentro del hilo que los utilizará para garantizar la seguridad del hilo. Esta práctica evita las condiciones de carrera y asegura que tus tareas de inferencia se ejecuten de manera fiable.

Para escenarios más avanzados y para optimizar aún más el rendimiento de la inferencia multi-hilo, considera la posibilidad de utilizar el paralelismo basado en procesos con multiprocessing o de aprovechar una cola de tareas con procesos de trabajo dedicados.

Preguntas frecuentes

¿Cómo puedo evitar las condiciones de carrera cuando utilizo modelos YOLO en un entorno python multi-hilo?

Para prevenir condiciones de carrera al usar modelos Ultralytics YOLO en un entorno Python multi-hilo, instancia un modelo YOLO separado dentro de cada hilo. Esto asegura que cada hilo tenga su propia instancia de modelo aislada, evitando la modificación concurrente del estado del modelo.

Ejemplo:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image in a thread-safe manner."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Para obtener más información sobre cómo garantizar la seguridad de los hilos, visita la Inferencia Segura para Hilos con Modelos YOLO.

¿Cuáles son las mejores prácticas para ejecutar la inferencia de modelos YOLO multi-hilo en Python?

Para ejecutar la inferencia del modelo YOLO multi-hilo de forma segura en Python, sigue estas prácticas recomendadas:

- Instancie los modelos YOLO dentro de cada hilo en lugar de compartir una única instancia del modelo entre los hilos.

- Utiliza python

multiprocessingpara el procesamiento paralelo para evitar problemas relacionados con el Bloqueo Global del Intérprete (GIL). - Libere el GIL utilizando operaciones realizadas por las bibliotecas C subyacentes de YOLO.

- Considere la posibilidad de utilizar el

ThreadingLockeddecorador para instancias de modelo compartidas cuando la memoria es una preocupación.

Ejemplo para la instanciación de modelos thread-safe:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Runs inference in a thread-safe manner with a new YOLO model instance."""

model = YOLO("yolo26n.pt")

results = model.predict(image_path)

# Process results

# Initiate multiple threads

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Para obtener contexto adicional, consulte la sección sobre Inferencia segura para subprocesos.

¿Por qué cada hilo debería tener su propia instancia del modelo YOLO?

Cada hilo debe tener su propia instancia del modelo YOLO para evitar condiciones de carrera. Cuando se comparte una sola instancia del modelo entre varios hilos, los accesos concurrentes pueden provocar un comportamiento impredecible y modificaciones del estado interno del modelo. Al usar instancias separadas, se asegura el aislamiento de los hilos, lo que hace que sus tareas de subprocesos múltiples sean confiables y seguras.

Para obtener una guía detallada, consulta las secciones Ejemplo no seguro para subprocesos: instancia de modelo único y Ejemplo seguro para subprocesos.

¿Cómo afecta el Bloqueo Global del Intérprete (GIL) de Python a la inferencia del modelo YOLO?

El Bloqueo Global del Intérprete (GIL) de python permite que solo un hilo ejecute el bytecode de Python a la vez, lo que puede limitar el rendimiento de las tareas de subprocesamiento múltiple ligadas a la CPU. Sin embargo, para las operaciones ligadas a E/S o los procesos que utilizan bibliotecas que liberan el GIL, como las bibliotecas C subyacentes de YOLO, aún puede lograr la concurrencia. Para un rendimiento mejorado, considere usar el paralelismo basado en procesos con el módulo de multiprocessing módulo.

Para obtener más información sobre el threading en Python, consulta la sección Comprensión del Threading en Python.

¿Es más seguro usar paralelismo basado en procesos en lugar de hilos para la inferencia del modelo YOLO?

Sí, usando el multiprocessing es más seguro y a menudo más eficiente para ejecutar la inferencia del modelo YOLO en paralelo. El paralelismo basado en procesos crea espacios de memoria separados, evitando el Bloqueo Global del Intérprete (GIL) y reduciendo el riesgo de problemas de concurrencia. Cada proceso operará de forma independiente con su propia instancia del modelo YOLO.

Para obtener más detalles sobre el paralelismo basado en procesos con los modelos YOLO, consulta la página sobre Inferencia Segura para Hilos.