Threadsichere Inferenz mit YOLO-Modellen

Das Ausführen von YOLO-Modellen in einer Multi-Thread-Umgebung erfordert eine sorgfältige Abwägung, um die Thread-Sicherheit zu gewährleisten. Python threading Modul ermöglicht es Ihnen, mehrere Threads gleichzeitig auszuführen. Bei der Verwendung von YOLO-Modellen in diesen Threads sind jedoch wichtige Sicherheitsaspekte zu beachten. Diese Seite führt Sie durch die Erstellung einer Thread-sicheren YOLO-Modellinferenz.

Ansehen: Wie man Thread-sichere Inferenz mit Ultralytics YOLO-Modellen in Python durchführt | Multi-Threading 🚀

Grundlagen des Python-Threading

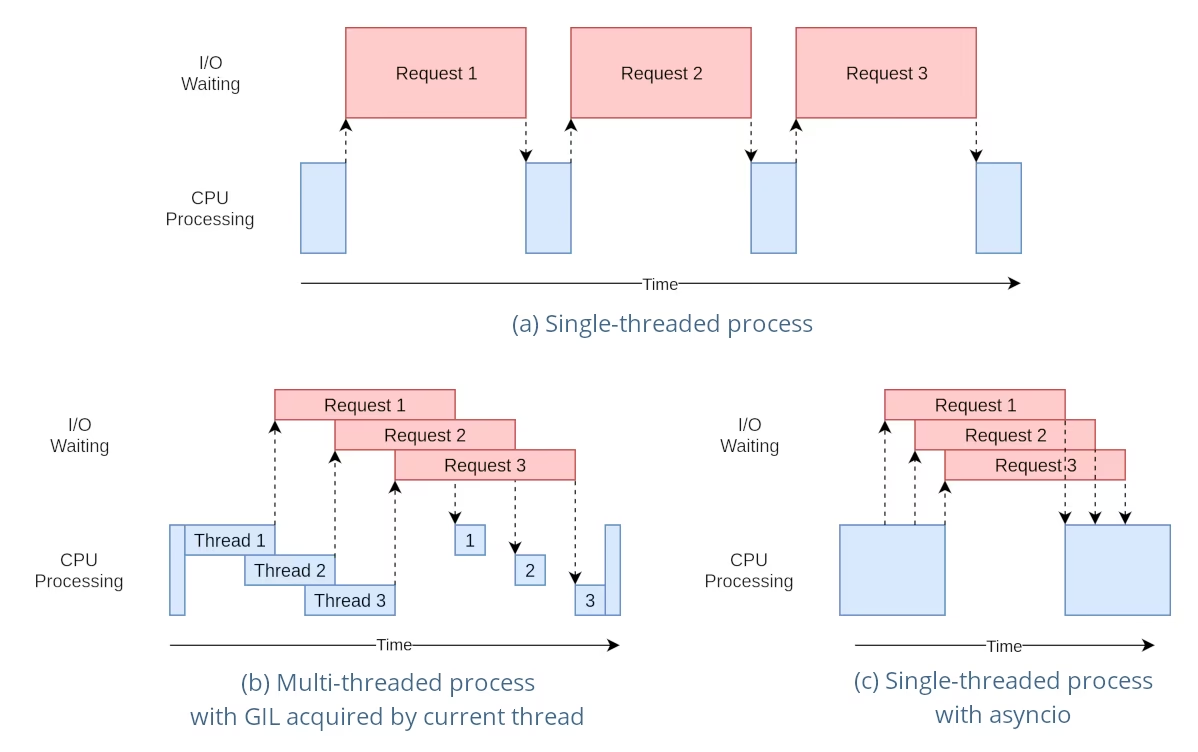

Python-Threads sind eine Form des Parallelismus, die es Ihrem Programm ermöglichen, mehrere Operationen gleichzeitig auszuführen. Der Global Interpreter Lock (GIL) von Python bedeutet jedoch, dass immer nur ein Thread Python-Bytecode ausführen kann.

Auch wenn dies wie eine Einschränkung klingt, können Threads dennoch Parallelität bieten, insbesondere bei E/A-gebundenen Operationen oder bei Verwendung von Operationen, die das GIL freigeben, wie z. B. solche, die von den zugrunde liegenden C-Bibliotheken von YOLO ausgeführt werden.

Die Gefahr gemeinsam genutzter Modellinstanzen

Das Instanziieren eines YOLO-Modells außerhalb Ihrer Threads und die gemeinsame Nutzung dieser Instanz über mehrere Threads hinweg kann zu Race Conditions führen, bei denen der interne Zustand des Modells aufgrund gleichzeitiger Zugriffe inkonsistent verändert wird. Dies ist besonders problematisch, wenn das Modell oder seine Komponenten einen Zustand haben, der nicht threadsicher ausgelegt ist.

Nicht threadsicheres Beispiel: Einzelne Modellinstanz

Bei der Verwendung von Threads in python ist es wichtig, Muster zu erkennen, die zu Nebenläufigkeitsproblemen führen können. Folgendes sollten Sie vermeiden: die gemeinsame Nutzung einer einzelnen YOLO-Modellinstanz über mehrere Threads hinweg.

# Unsafe: Sharing a single model instance across threads

from threading import Thread

from ultralytics import YOLO

# Instantiate the model outside the thread

shared_model = YOLO("yolo26n.pt")

def predict(image_path):

"""Predicts objects in an image using a preloaded YOLO model, take path string to image as argument."""

results = shared_model.predict(image_path)

# Process results

# Starting threads that share the same model instance

Thread(target=predict, args=("image1.jpg",)).start()

Thread(target=predict, args=("image2.jpg",)).start()

In dem obigen Beispiel ist die shared_model wird von mehreren Threads verwendet, was zu unvorhersehbaren Ergebnissen führen kann, da predict könnte gleichzeitig von mehreren Threads ausgeführt werden.

Nicht threadsicheres Beispiel: Mehrere Modellinstanzen

In ähnlicher Weise ist hier ein unsicheres Muster mit mehreren YOLO-Modellinstanzen:

# Unsafe: Sharing multiple model instances across threads can still lead to issues

from threading import Thread

from ultralytics import YOLO

# Instantiate multiple models outside the thread

shared_model_1 = YOLO("yolo26n_1.pt")

shared_model_2 = YOLO("yolo26n_2.pt")

def predict(model, image_path):

"""Runs prediction on an image using a specified YOLO model, returning the results."""

results = model.predict(image_path)

# Process results

# Starting threads with individual model instances

Thread(target=predict, args=(shared_model_1, "image1.jpg")).start()

Thread(target=predict, args=(shared_model_2, "image2.jpg")).start()

Auch wenn es sich um zwei separate Modellinstanzen handelt, besteht weiterhin das Risiko von Nebenläufigkeitsproblemen. Wenn die interne Implementierung von YOLO ist nicht Thread-sicher. Die Verwendung separater Instanzen verhindert möglicherweise keine Race Conditions, insbesondere wenn diese Instanzen zugrunde liegende Ressourcen oder Zustände gemeinsam nutzen, die nicht Thread-lokal sind.

Threadsichere Inferenz

Um Thread-sichere Inferenz durchzuführen, sollten Sie ein separates YOLO-Modell innerhalb jedes Threads instanziieren. Dies stellt sicher, dass jeder Thread seine eigene isolierte Modellinstanz hat, wodurch das Risiko von Race Conditions ausgeschlossen wird.

Threadsicheres Beispiel

Hier erfahren Sie, wie Sie ein YOLO-Modell in jedem Thread für eine sichere parallele Inferenz instanziieren:

# Safe: Instantiating a single model inside each thread

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image using a new YOLO model instance in a thread-safe manner; takes image path as input."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

# Starting threads that each have their own model instance

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

In diesem Beispiel erstellt jeder Thread seinen eigenen YOLO Instanz. Dies verhindert, dass ein Thread den Modellzustand eines anderen beeinträchtigt, und stellt so sicher, dass jeder Thread Inferenz sicher und ohne unerwartete Interaktionen mit den anderen Threads durchführt.

Verwendung des ThreadingLocked Decorator

Ultralytics bietet ein ThreadingLocked Decorator, der verwendet werden kann, um die threadsichere Ausführung von Funktionen zu gewährleisten. Dieser Decorator verwendet eine Sperre, um sicherzustellen, dass jeweils nur ein Thread die dekorierte Funktion ausführen kann.

from ultralytics import YOLO

from ultralytics.utils import ThreadingLocked

# Create a model instance

model = YOLO("yolo26n.pt")

# Decorate the predict method to make it thread-safe

@ThreadingLocked()

def thread_safe_predict(image_path):

"""Thread-safe prediction using a shared model instance."""

results = model.predict(image_path)

return results

# Now you can safely call this function from multiple threads

Die ThreadingLocked Decorator ist besonders nützlich, wenn Sie eine Modellinstanz über Threads hinweg gemeinsam nutzen müssen, aber sicherstellen möchten, dass nur ein Thread gleichzeitig darauf zugreifen kann. Dieser Ansatz kann Speicherplatz sparen, verglichen mit der Erstellung einer neuen Modellinstanz für jeden Thread, aber er kann die Parallelität reduzieren, da Threads möglicherweise warten müssen, bis die Sperre freigegeben wird.

Fazit

Bei Verwendung von YOLO-Modellen mit python's threading, instanziieren Sie Ihre Modelle immer innerhalb des Threads, der sie verwenden wird, um Thread-Sicherheit zu gewährleisten. Diese Vorgehensweise vermeidet Race Conditions und stellt sicher, dass Ihre Inferenzaufgaben zuverlässig ausgeführt werden.

Für komplexere Szenarien und zur weiteren Optimierung Ihrer Multi-Threaded-Inferenzleistung sollten Sie die Verwendung von prozessbasierter Parallelität mit Multiprocessing oder die Nutzung einer Aufgabenwarteschlange mit dedizierten Worker-Prozessen in Betracht ziehen.

FAQ

Wie kann ich Race Conditions vermeiden, wenn ich YOLO-Modelle in einer Multithread- Python-Umgebung verwende?

Um Race Conditions bei der Verwendung von Ultralytics YOLO-Modellen in einer Multi-Thread-fähigen Python-Umgebung zu vermeiden, instanziieren Sie ein separates YOLO-Modell innerhalb jedes Threads. Dies stellt sicher, dass jeder Thread seine eigene isolierte Modellinstanz hat, wodurch eine gleichzeitige Änderung des Modellzustands vermieden wird.

Beispiel:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image in a thread-safe manner."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Weitere Informationen zur Gewährleistung der Thread-Sicherheit finden Sie unter Thread-Safe Inference with YOLO Models.

Welche Best Practices gibt es für die Ausführung von Multi-Threaded YOLO-Modellinferenzen in Python?

Um die YOLO-Modellinferenz sicher in Python mit mehreren Threads auszuführen, befolgen Sie diese Best Practices:

- Instanziieren Sie YOLO-Modelle innerhalb jedes Threads, anstatt eine einzelne Modellinstanz über Threads hinweg zu teilen.

- Verwenden Sie Python's

multiprocessingModul zur parallelen Verarbeitung beziehen, um Probleme im Zusammenhang mit dem Global Interpreter Lock (GIL) zu vermeiden. - Geben Sie das GIL frei, indem Sie Operationen verwenden, die von den zugrunde liegenden C-Bibliotheken von YOLO ausgeführt werden.

- Erwägen Sie die Verwendung des

ThreadingLockedDecorator für gemeinsam genutzte Modellinstanzen, wenn Speicherplatz ein Problem darstellt.

Beispiel für Thread-sichere Modellinstanziierung:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Runs inference in a thread-safe manner with a new YOLO model instance."""

model = YOLO("yolo26n.pt")

results = model.predict(image_path)

# Process results

# Initiate multiple threads

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Zusätzliche Informationen finden Sie im Abschnitt über Thread-sichere Inferenz.

Warum sollte jeder Thread eine eigene YOLO-Modellinstanz haben?

Jeder Thread sollte seine eigene YOLO-Modellinstanz haben, um Race Conditions zu vermeiden. Wenn eine einzelne Modellinstanz von mehreren Threads gemeinsam genutzt wird, können gleichzeitige Zugriffe zu unvorhersehbarem Verhalten und Änderungen des internen Zustands des Modells führen. Durch die Verwendung separater Instanzen stellen Sie die Thread-Isolation sicher, wodurch Ihre Multi-Threading-Aufgaben zuverlässig und sicher werden.

Detaillierte Anleitungen finden Sie in den Abschnitten Nicht threadsicheres Beispiel: Einzelne Modellinstanz und Threadsicheres Beispiel.

Wie beeinflusst der Global Interpreter Lock (GIL) von Python die YOLO-Modellinferenz?

Der Global Interpreter Lock (GIL) von Python erlaubt jeweils nur einem Thread die Ausführung von Python-Bytecode, was die Leistung von CPU-lastigen Multi-Threading-Aufgaben einschränken kann. Für E/A-gebundene Operationen oder Prozesse, die Bibliotheken verwenden, die den GIL freigeben, wie z. B. die zugrunde liegenden C-Bibliotheken von YOLO, können Sie jedoch weiterhin Nebenläufigkeit erreichen. Für eine verbesserte Leistung sollten Sie die prozessbasierte Parallelverarbeitung mit dem Multiprocessing-Modul von Python in Betracht ziehen. multiprocessing Modul.

Weitere Informationen zum Thema Threading in Python finden Sie im Abschnitt Grundlagen des Python-Threadings.

Ist es sicherer, prozessbasierte Parallelverarbeitung anstelle von Threading für die YOLO-Modellinferenz zu verwenden?

Ja, mit Python's multiprocessing Modul ist sicherer und oft effizienter für die parallele Ausführung der YOLO-Modellinferenz. Prozessbasierte Parallelverarbeitung erzeugt separate Speicherbereiche, wodurch der Global Interpreter Lock (GIL) vermieden und das Risiko von Nebenläufigkeitsproblemen reduziert wird. Jeder Prozess arbeitet unabhängig mit seiner eigenen YOLO-Modellinstanz.

Weitere Informationen zur prozessbasierten Parallelverarbeitung mit YOLO-Modellen finden Sie auf der Seite zur Thread-Safe Inferenz.