Ein Leitfaden zum Testen von Modellen

Einführung

Nach dem Trainieren und Bewerten Ihres Modells ist es an der Zeit, es zu testen. Beim Testen des Modells wird beurteilt, wie gut es in realen Szenarien funktioniert. Beim Testen werden Faktoren wie Genauigkeit, Zuverlässigkeit, Fairness und die Verständlichkeit der Entscheidungen des Modells berücksichtigt. Ziel ist es, sicherzustellen, dass das Modell wie vorgesehen funktioniert, die erwarteten Ergebnisse liefert und zum Gesamtziel Ihrer Anwendung oder Ihres Projekts passt.

Ansehen: So testen Sie Modelle für maschinelles Lernen | Vermeiden Sie Datenlecks in der Computer Vision 🚀

Modelltests ähneln der Modellevaluierung, sind aber zwei unterschiedliche Schritte in einem Computer Vision Projekt. Die Modellevaluierung umfasst Metriken und Diagramme zur Bewertung der Genauigkeit des Modells. Andererseits prüft der Modelltest, ob das erlernte Verhalten des Modells den Erwartungen entspricht. In diesem Leitfaden werden wir Strategien zum Testen Ihrer Computer Vision-Modelle untersuchen.

Modelltest vs. Modellevaluierung

Lassen Sie uns zunächst den Unterschied zwischen Modellevaluierung und -test anhand eines Beispiels verstehen.

Angenommen, Sie haben ein Computer Vision-Modell trainiert, um Katzen und Hunde zu erkennen, und Sie möchten dieses Modell in einer Tierhandlung einsetzen, um die Tiere zu überwachen. Während der Modellevaluierungsphase verwenden Sie einen beschrifteten Datensatz, um Metriken wie Genauigkeit, Präzision, Erinnerung (Recall) und F1-Score zu berechnen. Beispielsweise könnte das Modell eine Genauigkeit von 98 % bei der Unterscheidung zwischen Katzen und Hunden in einem bestimmten Datensatz aufweisen.

Nach der Evaluierung testen Sie das Modell anhand von Bildern aus einer Tierhandlung, um zu sehen, wie gut es Katzen und Hunde unter verschiedenen und realistischeren Bedingungen identifiziert. Sie prüfen, ob es Katzen und Hunde korrekt beschriften kann, wenn sie sich bewegen, bei unterschiedlichen Lichtverhältnissen oder teilweise durch Gegenstände wie Spielzeug oder Möbel verdeckt sind. Die Modellprüfung stellt sicher, dass sich das Modell außerhalb der kontrollierten Evaluierungsumgebung wie erwartet verhält.

Vorbereitung auf Modelltests

Computer-Vision-Modelle lernen aus Datensätzen, indem sie Muster erkennen, Vorhersagen treffen und ihre Leistung bewerten. Diese Datensätze werden in der Regel in Trainings- und Testdatensätze unterteilt, um reale Bedingungen zu simulieren. Trainingsdaten lehren das Modell, während Testdaten seine Genauigkeit überprüfen.

Hier sind zwei Punkte, die Sie vor dem Testen Ihres Modells beachten sollten:

- Realistische Darstellung: Die bisher ungesehenen Testdaten sollten den Daten ähneln, die das Modell bei der Bereitstellung verarbeiten muss. Dies trägt zu einem realistischen Verständnis der Fähigkeiten des Modells bei.

- Ausreichende Größe: Die Größe des Testdatensatzes muss ausreichend groß sein, um zuverlässige Erkenntnisse darüber zu liefern, wie gut das Modell funktioniert.

Testen Ihres Computer Vision Modells

Hier sind die wichtigsten Schritte, die Sie unternehmen müssen, um Ihr Computer Vision Modell zu testen und seine Leistung zu verstehen.

- Vorhersagen ausführen: Verwenden Sie das Modell, um Vorhersagen auf dem Testdatensatz zu treffen.

- Vorhersagen vergleichen: Überprüfen Sie, wie gut die Vorhersagen des Modells mit den tatsächlichen Labels (Ground Truth) übereinstimmen.

- Leistungsmetriken berechnen:Berechnen Sie Metriken wie Genauigkeit, Präzision, Recall und F1-Score, um die Stärken und Schwächen des Modells zu verstehen. Tests konzentrieren sich darauf, wie diese Metriken die reale Leistung widerspiegeln.

- Ergebnisse visualisieren: Erstellen Sie visuelle Hilfsmittel wie Konfusionsmatrizen und ROC-Kurven. Diese helfen Ihnen, bestimmte Bereiche zu erkennen, in denen das Modell in praktischen Anwendungen möglicherweise nicht gut funktioniert.

Als Nächstes können die Testergebnisse analysiert werden:

- Falsch klassifizierte Bilder: Identifizieren und überprüfen Sie Bilder, die das Modell falsch klassifiziert hat, um zu verstehen, wo es Fehler macht.

- Fehleranalyse: Führen Sie eine gründliche Fehleranalyse durch, um die Arten von Fehlern (z. B. falsch positive vs. falsch negative) und ihre potenziellen Ursachen zu verstehen.

- Bias und Fairness: Überprüfen Sie die Vorhersagen des Modells auf Verzerrungen. Stellen Sie sicher, dass das Modell in verschiedenen Teilmengen der Daten gleich gut funktioniert, insbesondere wenn es sensible Attribute wie Rasse, Geschlecht oder Alter enthält.

Testen Ihres YOLO26-Modells

Um Ihr YOLO26-Modell zu testen, können Sie den Validierungsmodus verwenden. Dies ist eine unkomplizierte Methode, um die Stärken und verbesserungswürdigen Bereiche des Modells zu verstehen. Außerdem müssen Sie Ihren Testdatensatz korrekt für YOLO26 formatieren. Weitere Details zur Verwendung des Validierungsmodus finden Sie auf der Dokumentationsseite Modellvalidierung.

YOLO26 für Vorhersagen auf mehreren Testbildern verwenden

Wenn Sie Ihr trainiertes YOLO26-Modell auf mehreren Bildern testen möchten, die in einem Ordner gespeichert sind, können Sie dies problemlos in einem Durchgang tun. Anstatt den Validierungsmodus zu verwenden, der typischerweise zur Bewertung der Modellleistung auf einem Validierungssatz und zur Bereitstellung detaillierter Metriken dient, möchten Sie vielleicht einfach nur die Vorhersagen auf allen Bildern in Ihrem Testsatz sehen. Dafür können Sie den Vorhersagemodus verwenden.

Unterschied zwischen Validierungs- und Vorhersagemodus

- Validierungsmodus: Wird verwendet, um die Leistung des Modells zu bewerten, indem Vorhersagen mit bekannten Labels (Ground Truth) verglichen werden. Er liefert detaillierte Metriken wie Genauigkeit, Präzision, Rückruf und F1-Score.

- Vorhersagemodus: Wird verwendet, um das Modell auf neuen, unbekannten Daten auszuführen, um Vorhersagen zu generieren. Es liefert keine detaillierten Leistungsmetriken, ermöglicht es Ihnen aber zu sehen, wie das Modell auf realen Bildern funktioniert.

YOLO26-Vorhersagen ohne benutzerdefiniertes Training ausführen

Wenn Sie daran interessiert sind, das grundlegende YOLO26-Modell zu testen, um zu verstehen, ob es ohne benutzerdefiniertes Training für Ihre Anwendung verwendet werden kann, können Sie den Vorhersagemodus verwenden. Obwohl das Modell auf Datensätzen wie COCO vortrainiert ist, können Vorhersagen auf Ihrem eigenen Datensatz Ihnen schnell einen Eindruck davon vermitteln, wie gut es in Ihrem spezifischen Kontext funktionieren könnte.

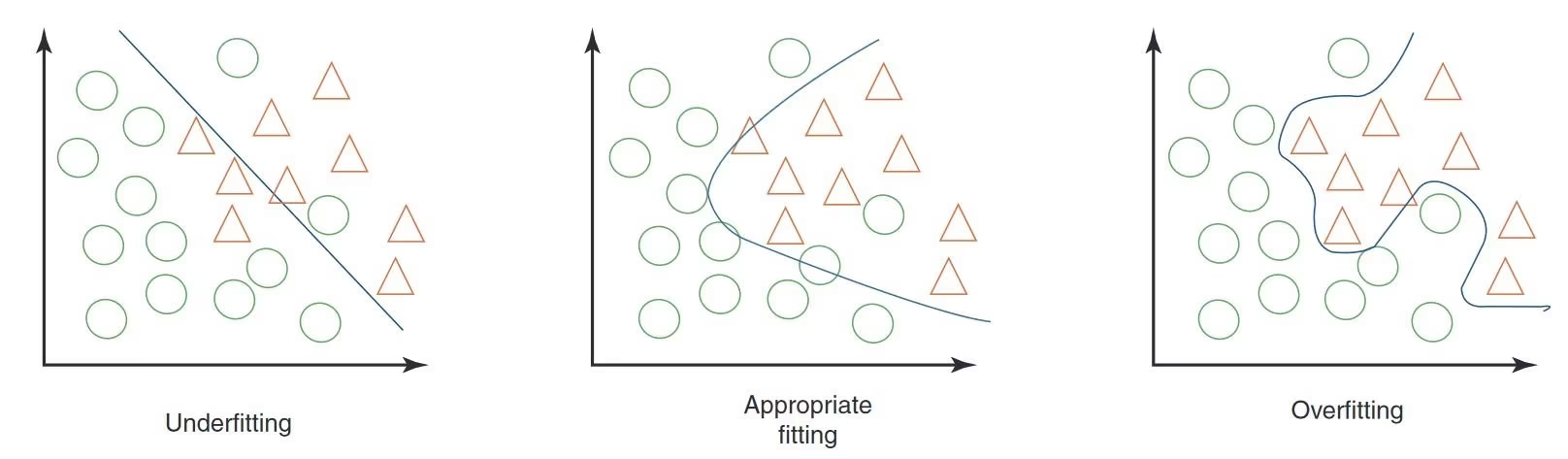

Overfitting und Underfitting im Machine Learning

Beim Testen eines Modells für maschinelles Lernen, insbesondere im Bereich Computer Vision, ist es wichtig, auf Overfitting und Underfitting zu achten. Diese Probleme können die Funktionsweise Ihres Modells mit neuen Daten erheblich beeinträchtigen.

Overfitting

Überanpassung tritt auf, wenn Ihr Modell die Trainingsdaten zu gut lernt, einschließlich des Rauschens und der Details, die sich nicht auf neue Daten verallgemeinern lassen. In der Computer Vision bedeutet dies, dass Ihr Modell mit Trainingsbildern hervorragend zurechtkommt, aber mit neuen Bildern Schwierigkeiten hat.

Anzeichen von Overfitting

- Hohe Trainingsgenauigkeit, niedrige Validierungsgenauigkeit: Wenn Ihr Modell bei Trainingsdaten sehr gut, aber bei Validierungs- oder Testdaten schlecht abschneidet, liegt wahrscheinlich eine Überanpassung vor.

- Visuelle Inspektion: Manchmal kann man Overfitting erkennen, wenn Ihr Modell zu empfindlich auf geringfügige Änderungen oder irrelevante Details in Bildern reagiert.

Underfitting

Underfitting tritt auf, wenn Ihr Modell die zugrunde liegenden Muster in den Daten nicht erfassen kann. In der Computer Vision kann es vorkommen, dass ein Modell mit Underfitting Objekte in den Trainingsbildern nicht einmal richtig erkennt.

Anzeichen von Underfitting

- Geringe Trainingsgenauigkeit: Wenn Ihr Modell keine hohe Genauigkeit im Trainingsdatensatz erreicht, könnte es Underfitting aufweisen.

- Visuelle Fehlklassifizierung: Wenn offensichtliche Merkmale oder Objekte wiederholt nicht erkannt werden, deutet dies auf Underfitting hin.

Ausgleich zwischen Overfitting und Underfitting

Der Schlüssel liegt darin, ein Gleichgewicht zwischen Overfitting und Underfitting zu finden. Idealerweise sollte ein Modell sowohl auf Trainings- als auch auf Validierungsdatensätzen gute Ergebnisse erzielen. Die regelmäßige Überwachung der Leistung Ihres Modells anhand von Metriken und visuellen Inspektionen sowie die Anwendung der richtigen Strategien können Ihnen helfen, die besten Ergebnisse zu erzielen.

Datenleckage in der Computer Vision und wie man sie vermeidet

Beim Testen Ihres Modells ist es wichtig, die Datenleckage zu berücksichtigen. Datenleckage tritt auf, wenn Informationen von außerhalb des Trainingsdatensatzes versehentlich zum Trainieren des Modells verwendet werden. Das Modell mag während des Trainings sehr genau erscheinen, aber es wird bei neuen, ungesehenen Daten nicht gut funktionieren, wenn Datenleckage auftritt.

Warum Datenlecks auftreten

Datenlecks können schwer zu erkennen sein und entstehen oft durch versteckte Verzerrungen in den Trainingsdaten. Hier sind einige gängige Möglichkeiten, wie dies in der Computer Vision geschehen kann:

- Kamera-Bias: Unterschiedliche Winkel, Beleuchtung, Schatten und Kamerabewegungen können unerwünschte Muster verursachen.

- Overlay-Bias: Logos, Zeitstempel oder andere Overlays in Bildern können das Modell in die Irre führen.

- Schriftart- und Objekt-Bias: Bestimmte Schriftarten oder Objekte, die häufig in bestimmten Klassen vorkommen, können das Lernen des Modells verzerren.

- Räumliche Verzerrung: Ungleichgewichte in Vordergrund-Hintergrund-, Bounding-Box-Verteilungen und Objektpositionen können das Training beeinträchtigen.

- Label- und Domain-Bias: Falsche Labels oder Verschiebungen in Datentypen können zu einem Informationsleck führen.

Erkennung von Datenlecks

Um Data Leakage zu finden, können Sie:

- Leistung prüfen: Wenn die Ergebnisse des Modells überraschend gut sind, könnte es sein, dass es undicht ist.

- Betrachten der Feature-Wichtigkeit: Wenn ein Feature viel wichtiger ist als andere, könnte dies auf ein Leck hindeuten.

- Visuelle Inspektion: Überprüfen Sie nochmals, ob die Entscheidungen des Modells intuitiv sinnvoll sind.

- Datenaufteilung überprüfen: Stellen Sie sicher, dass die Daten vor der Verarbeitung korrekt aufgeteilt wurden.

Vermeidung von Datenlecks

Um Data Leakage zu vermeiden, verwenden Sie einen vielfältigen Datensatz mit Bildern oder Videos von verschiedenen Kameras und Umgebungen. Überprüfen Sie Ihre Daten sorgfältig und stellen Sie sicher, dass keine versteckten Verzerrungen vorliegen, z. B. dass alle positiven Stichproben zu einer bestimmten Tageszeit entnommen wurden. Das Vermeiden von Data Leakage trägt dazu bei, dass Ihre Computer-Vision-Modelle in realen Situationen zuverlässiger und effektiver sind.

Was kommt nach dem Modelltest?

Nach dem Testen Ihres Modells hängen die nächsten Schritte von den Ergebnissen ab. Wenn Ihr Modell gut funktioniert, können Sie es in einer realen Umgebung einsetzen. Wenn die Ergebnisse nicht zufriedenstellend sind, müssen Sie Verbesserungen vornehmen. Dies kann die Analyse von Fehlern, das Sammeln weiterer Daten, die Verbesserung der Datenqualität, die Anpassung von Hyperparametern und das erneute Trainieren des Modells umfassen.

An der KI-Konversation teilnehmen

Ein Teil einer Community von Computer-Vision-Enthusiasten zu werden, kann helfen, Probleme zu lösen und effizienter zu lernen. Hier sind einige Möglichkeiten, sich zu vernetzen, Hilfe zu suchen und Ihre Gedanken auszutauschen.

Community-Ressourcen

- GitHub Issues: Erkunden Sie das YOLO26 GitHub-Repository und nutzen Sie den Tab „Issues“, um Fragen zu stellen, Fehler zu melden und neue Funktionen vorzuschlagen. Die Community und die Betreuer sind sehr aktiv und hilfsbereit.

- Ultralytics Discord Server: Treten Sie dem Ultralytics Discord Server bei, um sich mit anderen Benutzern und Entwicklern auszutauschen, Unterstützung zu erhalten und Ihre Erfahrungen zu teilen.

Offizielle Dokumentation

- Ultralytics YOLO26-Dokumentation: Lesen Sie die offizielle YOLO26-Dokumentation für detaillierte Anleitungen und hilfreiche Tipps zu verschiedenen Computer-Vision-Projekten.

Diese Ressourcen helfen Ihnen, Herausforderungen zu meistern und über die neuesten Trends und Praktiken innerhalb der Computer-Vision-Community auf dem Laufenden zu bleiben.

Zusammenfassend

Der Aufbau vertrauenswürdiger Computer-Vision-Modelle basiert auf rigorosen Modelltests. Durch das Testen des Modells mit zuvor ungesehenen Daten können wir es analysieren und Schwächen wie Overfitting und Datenlecks erkennen. Die Behebung dieser Probleme vor der Bereitstellung hilft dem Modell, in realen Anwendungen gut zu funktionieren. Es ist wichtig zu bedenken, dass Modelltests genauso wichtig sind wie die Modellevaluierung, um den langfristigen Erfolg und die Effektivität des Modells zu gewährleisten.

FAQ

Was sind die Hauptunterschiede zwischen Modellevaluierung und Modelltests in der Computer Vision?

Modellbewertung und Modelltests sind unterschiedliche Schritte in einem Computer-Vision-Projekt. Die Modellbewertung umfasst die Verwendung eines beschrifteten Datensatzes zur Berechnung von Metriken wie Genauigkeit, Präzision, Trefferquote und F1-Score, wodurch Einblicke in die Leistung des Modells mit einem kontrollierten Datensatz gewonnen werden. Modelltests hingegen bewerten die Leistung des Modells in realen Szenarien, indem sie es auf neue, ungesehene Daten anwenden und sicherstellen, dass das erlernte Verhalten des Modells mit den Erwartungen außerhalb der Bewertungsumgebung übereinstimmt. Eine detaillierte Anleitung finden Sie in den Schritten eines Computer-Vision-Projekts.

Wie kann ich mein Ultralytics YOLO26-Modell auf mehreren Bildern testen?

Um Ihr Ultralytics YOLO26-Modell auf mehreren Bildern zu testen, können Sie den Vorhersagemodus verwenden. Dieser Modus ermöglicht es Ihnen, das Modell auf neuen, ungesehenen Daten auszuführen, um Vorhersagen zu generieren, ohne detaillierte Metriken bereitzustellen. Dies ist ideal für Leistungstests unter realen Bedingungen bei größeren Bildersätzen, die in einem Ordner gespeichert sind. Zur Bewertung von Leistungsmetriken verwenden Sie stattdessen den Validierungsmodus.

Was soll ich tun, wenn mein Computer-Vision-Modell Anzeichen von Overfitting oder Underfitting zeigt?

Um Overfitting zu beheben:

- Regularisierungs-Techniken wie Dropout.

- Erhöhen Sie die Größe des Trainingsdatensatzes.

- Vereinfachen Sie die Modellarchitektur.

Um Underfitting zu beheben:

- Verwenden Sie ein komplexeres Modell.

- Bieten Sie relevantere Funktionen.

- Erhöhen Sie die Anzahl der Trainingsiterationen oder Epochen.

Überprüfen Sie falsch klassifizierte Bilder, führen Sie eine gründliche Fehleranalyse durch und verfolgen Sie regelmäßig Leistungsmetriken, um ein Gleichgewicht zu wahren. Für weitere Informationen zu diesen Konzepten erkunden Sie unseren Abschnitt über Overfitting und Underfitting.

Wie kann ich Datenlecks in der Computer Vision erkennen und vermeiden?

Um Datenlecks zu detecten:

- Vergewissern Sie sich, dass die Testleistung nicht ungewöhnlich hoch ist.

- Überprüfen Sie die Feature-Wichtigkeit auf unerwartete Erkenntnisse.

- Intuitive Überprüfung von Modellentscheidungen.

- Stellen Sie vor der Verarbeitung eine korrekte Datenaufteilung sicher.

Um Data Leakage zu vermeiden:

- Verwenden Sie verschiedene Datensätze mit unterschiedlichen Umgebungen.

- Überprüfen Sie die Daten sorgfältig auf versteckte Verzerrungen.

- Stellen Sie sicher, dass es keine überlappenden Informationen zwischen Trainings- und Testdatensätzen gibt.

Detaillierte Strategien zur Verhinderung von Datenlecks finden Sie in unserem Abschnitt über Datenlecks in der Computer Vision.

Welche Schritte sollte ich nach dem Testen meines Computer Vision Modells unternehmen?

Wenn die Modellleistung nach dem Testen die Projektziele erfüllt, fahren Sie mit der Bereitstellung fort. Wenn die Ergebnisse unbefriedigend sind, sollten Sie Folgendes in Betracht ziehen:

- Fehleranalyse.

- Sammeln vielfältigerer und qualitativ hochwertigerer Daten.

- Hyperparameter-Optimierung.

- Das Modell erneut trainieren.

Gewinnen Sie Erkenntnisse aus dem Abschnitt Modelltest vs. Modellevaluierung, um die Modelleffektivität in realen Anwendungen zu verfeinern und zu verbessern.

Wie führe ich YOLO26-Vorhersagen ohne benutzerdefiniertes Training aus?

Sie können Vorhersagen mit dem vortrainierten YOLO26-Modell auf Ihrem Datensatz ausführen, um zu prüfen, ob es Ihren Anwendungsanforderungen entspricht. Nutzen Sie den Vorhersagemodus, um sich schnell ein Bild von den Leistungsergebnissen zu machen, ohne ein benutzerdefiniertes Training durchführen zu müssen.