YOLOv5 Schnellstart 🚀

Begeben Sie sich mit Ultralytics YOLOv5 auf eine Reise in die dynamische Welt der Objekterkennung in Echtzeit! Dieser Leitfaden dient als umfassender Ausgangspunkt für KI-Enthusiasten und Fachleute, die YOLOv5 beherrschen möchten. Von der Ersteinrichtung bis hin zu fortgeschrittenen Trainingstechniken sind Sie bei uns an der richtigen Adresse. Am Ende dieses Leitfadens verfügen Sie über das Wissen, um YOLOv5 mithilfe modernster Deep-Learning-Methoden selbstbewusst in Ihren Projekten zu implementieren. Zünden wir die Triebwerke und starten wir durch mit YOLOv5!

Installieren

Bereiten Sie den Start vor, indem Sie das YOLOv5-Repository klonen und die Umgebung einrichten. Dadurch wird sichergestellt, dass alle notwendigen Anforderungen installiert sind. Stellen Sie sicher, dass Sie Python>=3.8.0 und PyTorch>=1.8 für den Start bereit haben. Diese grundlegenden Tools sind entscheidend für den effektiven Betrieb von YOLOv5.

git clone https://github.com/ultralytics/yolov5 # clone repository

cd yolov5

pip install -r requirements.txt # install dependencies

Inferenz mit PyTorch Hub

Erleben Sie die Einfachheit der YOLOv5 PyTorch Hub Inferenz, bei der Modelle nahtlos aus dem neuesten YOLOv5 Release heruntergeladen werden. Diese Methode nutzt die Leistungsfähigkeit von PyTorch für einfaches Laden und Ausführen von Modellen, wodurch es unkompliziert ist, Vorhersagen zu erhalten.

import torch

# Model loading

model = torch.hub.load("ultralytics/yolov5", "yolov5s") # Can be 'yolov5n' - 'yolov5x6', or 'custom'

# Inference on images

img = "https://ultralytics.com/images/zidane.jpg" # Can be a file, Path, PIL, OpenCV, numpy, or list of images

# Run inference

results = model(img)

# Display results

results.print() # Other options: .show(), .save(), .crop(), .pandas(), etc. Explore these in the Predict mode documentation.

Inferenz mit detect.py

Nutzen detect.py für vielseitig Inferenz aus verschiedenen Quellen. Es ruft automatisch ab Modelle von der neuesten YOLOv5 Veröffentlichung und speichert Ergebnisse mit Leichtigkeit. Dieses Skript ist ideal für die Verwendung in der Befehlszeile und die Integration von YOLOv5 in größere Systeme und unterstützt Eingaben wie Bilder, Videos, Verzeichnisse, Webcams und sogar Live-Streams.

python detect.py --weights yolov5s.pt --source 0 # webcam

python detect.py --weights yolov5s.pt --source image.jpg # image

python detect.py --weights yolov5s.pt --source video.mp4 # video

python detect.py --weights yolov5s.pt --source screen # screenshot

python detect.py --weights yolov5s.pt --source path/ # directory

python detect.py --weights yolov5s.pt --source list.txt # list of images

python detect.py --weights yolov5s.pt --source list.streams # list of streams

python detect.py --weights yolov5s.pt --source 'path/*.jpg' # glob pattern

python detect.py --weights yolov5s.pt --source 'https://youtu.be/LNwODJXcvt4' # YouTube video

python detect.py --weights yolov5s.pt --source 'rtsp://example.com/media.mp4' # RTSP, RTMP, HTTP stream

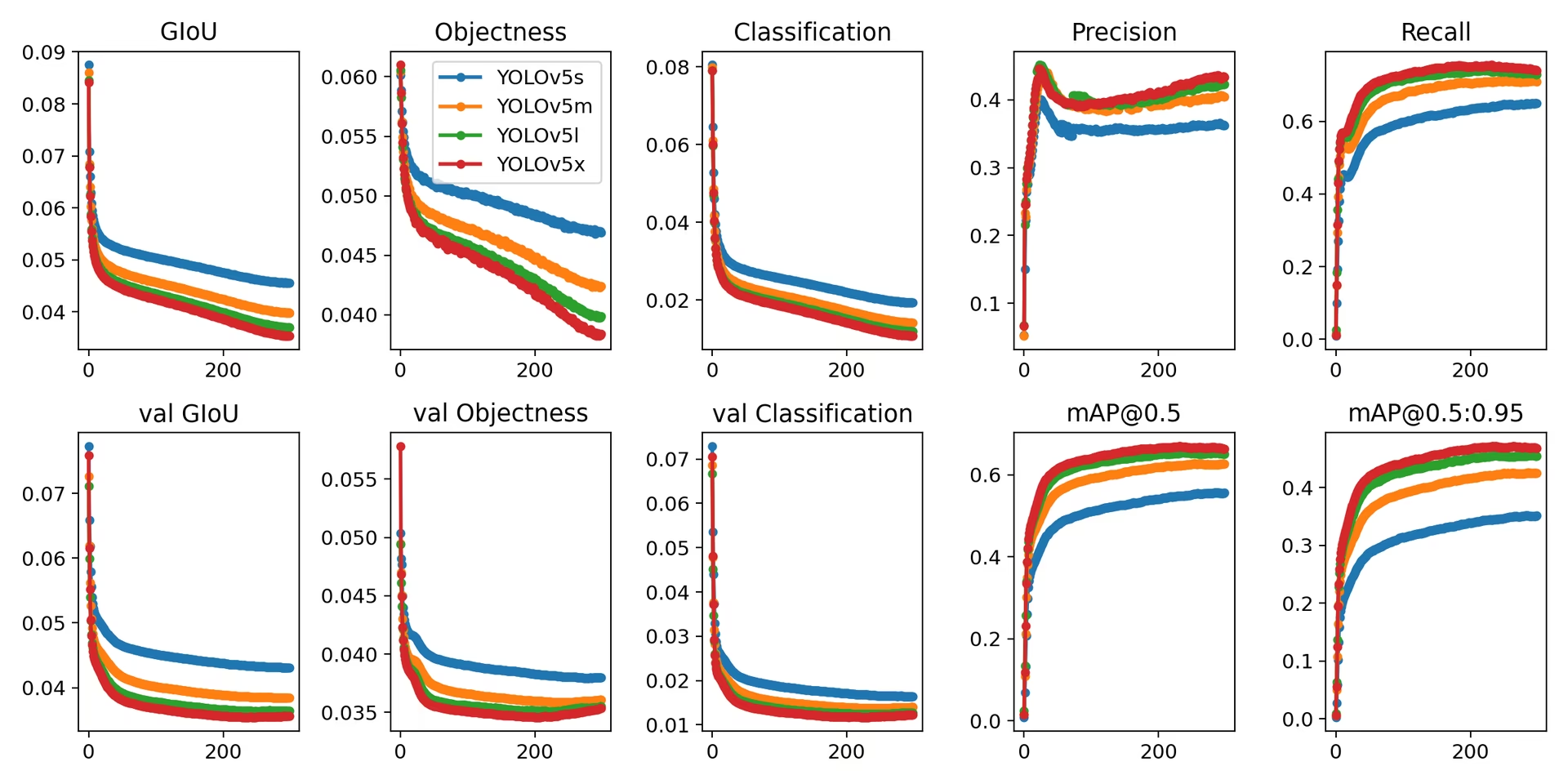

Training

YOLOv5 replizieren COCO-Datensatz Benchmarks durch Befolgen der Trainingsanweisungen unten. Das Notwendige Modelle und Datensätze (wie coco128.yaml oder die vollständige coco.yaml) werden direkt von der neuesten YOLOv5 Version übernommen. VeröffentlichungTraining von YOLOv5n/s/m/l/x auf einer V100 GPU sollte typischerweise 1/2/4/6/8 Tage dauern (beachten Sie, dass Multi-GPU-Training Setups funktionieren schneller). Maximieren Sie die Leistung, indem Sie die höchstmögliche verwenden --batch-size oder verwenden Sie --batch-size -1 für das YOLOv5 AutoBatch Funktion, die automatisch die optimale findet Batch-GrößeDie folgenden Batch-Größen sind ideal für V100-16GB GPUs. Beachten Sie unsere Konfigurationsanleitung für Details zu Modellkonfigurationsdateien (*.yaml), oder Auto-Modus mit angegebener Auslastungsfraktion (

# Train YOLOv5n on COCO128 for 3 epochs

python train.py --data coco128.yaml --epochs 3 --weights yolov5n.pt --batch-size 128

# Train YOLOv5s on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5s.yaml --batch-size 64

# Train YOLOv5m on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5m.yaml --batch-size 40

# Train YOLOv5l on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5l.yaml --batch-size 24

# Train YOLOv5x on COCO for 300 epochs

python train.py --data coco.yaml --epochs 300 --weights '' --cfg yolov5x.yaml --batch-size 16

Zusammenfassend ist YOLOv5 nicht nur ein hochmodernes Werkzeug zur Objekterkennung, sondern auch ein Beweis für die Leistungsfähigkeit von maschinellem Lernen bei der Transformation unserer Interaktion mit der Welt durch visuelles Verständnis. Während Sie diesen Leitfaden durcharbeiten und YOLOv5 auf Ihre Projekte anwenden, denken Sie daran, dass Sie an der Spitze einer technologischen Revolution stehen, die in der Lage ist, bemerkenswerte Leistungen in der Computer Vision zu erzielen. Sollten Sie weitere Einblicke oder Unterstützung von anderen Visionären benötigen, laden wir Sie herzlich in unser GitHub repository ein, die Heimat einer florierenden Gemeinschaft von Entwicklern und Forschern. Entdecken Sie weitere Ressourcen wie die Ultralytics Platform für Dataset-Management und Modelltraining ohne Code, oder besuchen Sie unsere Solutions-Seite für reale Anwendungen und Inspiration. Bleiben Sie neugierig, bleiben Sie innovativ und genießen Sie die Wunder von YOLOv5. Viel Spaß beim detecting! 🌠🔍