Ultralytics Platform

Ultralytics Platform es una plataforma integral de visión artificial de extremo a extremo que optimiza todo el flujo de trabajo de ML, desde la preparación de datos hasta el despliegue del modelo. Diseñada para equipos e individuos que necesitan soluciones de visión artificial listas para producción sin la complejidad de la infraestructura.

¿Qué es Ultralytics Platform?

Ultralytics Platform está diseñada para reemplazar las herramientas de ML fragmentadas con una solución unificada. Combina las capacidades de:

- Roboflow - Gestión y anotación de datos

- Weights & Biases - Seguimiento de experimentos

- SageMaker - Entrenamiento en la nube

- HuggingFace - Despliegue de modelos

- Arize - Monitorización

Plataforma todo en uno con soporte nativo para YOLO11 YOLO26 y YOLO11 .

Flujo de trabajo: Cargar → Anotar → Entrenar → Exportar → Implementar

La plataforma ofrece un flujo de trabajo integral:

graph LR

subgraph Data["📁 Data"]

A[Upload] --> B[Annotate]

B --> C[Analyze]

end

subgraph Train["🚀 Train"]

D[Configure] --> E[Train on GPU]

E --> F[View Metrics]

end

subgraph Deploy["🌐 Deploy"]

G[Export] --> H[Deploy Endpoint]

H --> I[Monitor]

end

Data --> Train --> Deploy| Etapa | Características |

|---|---|

| Cargar | Imágenes (50 MB), vídeos (1 GB), archivos ZIP (50 GB) con procesamiento automático. |

| Anotar | Herramientas manuales, anotación SAM , YOLO para los 5 tipos de tareas. |

| Entrenar | GPU en la nube (RTX 4090 a H200), métricas en tiempo real, organización de proyectos. |

| Exportar | 17 formatos de implementación (ONNX, TensorRT, CoreML, TFLite, etc.) |

| Despliegue | 43 regiones globales con terminales dedicados, escalado automático y supervisión. |

Lo que puedes hacer:

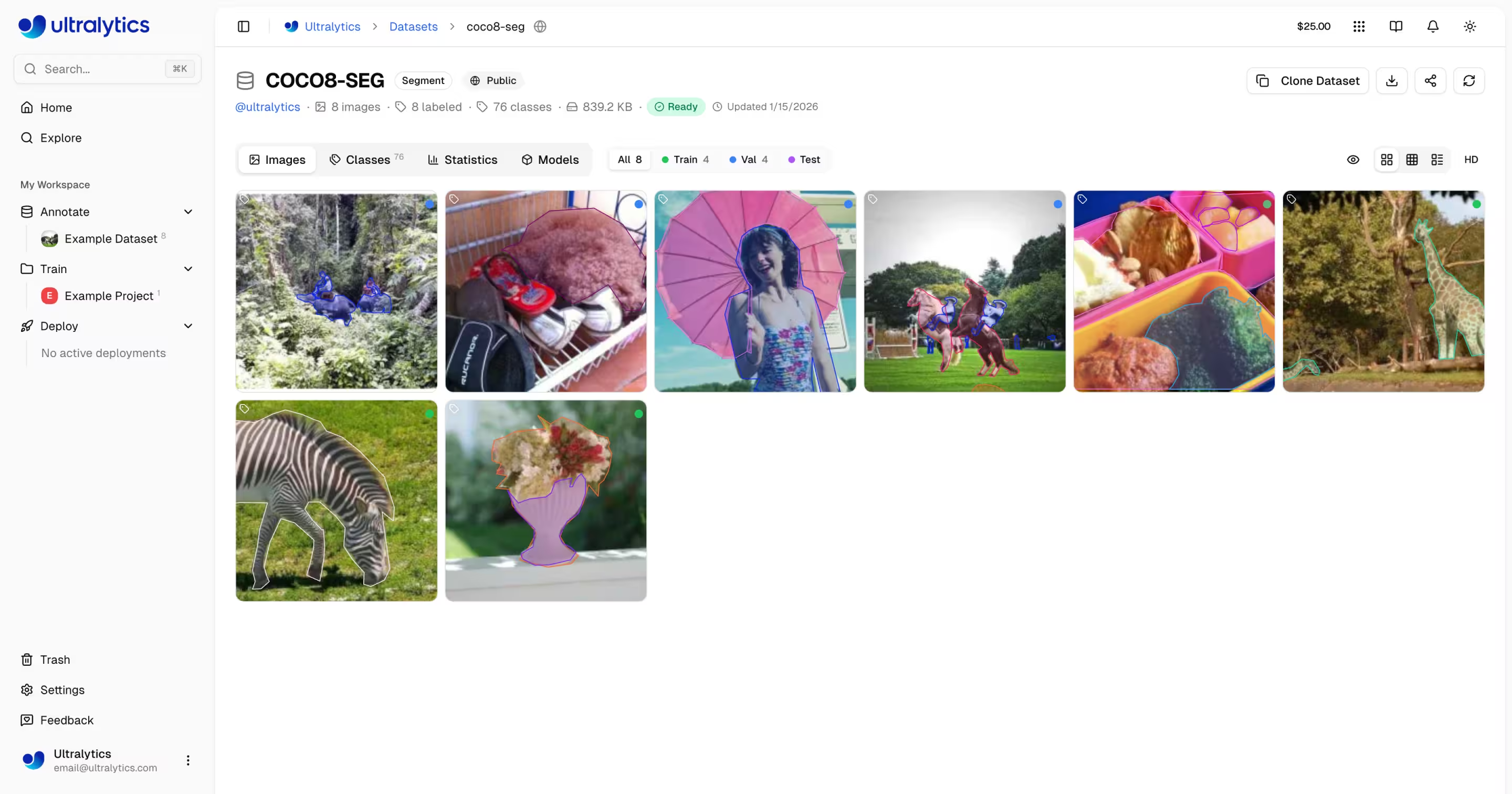

- Sube imágenes, vídeos y archivos ZIP para crear conjuntos de datos de entrenamiento.

- Visualiza anotaciones con superposiciones interactivas para los 5 tipos YOLO .

- Entrena modelos en GPU en la nube (RTX 4090 a H200) con métricas en tiempo real.

- Exportación a 17 formatos de implementación (ONNX, TensorRT, CoreML, TFLite, etc.)

- Implemente en 43 regiones globales con terminales dedicados con un solo clic.

- Supervisar el progreso de la formación, el estado de la implementación y las métricas de uso.

- Colabora haciendo públicos los proyectos y conjuntos de datos para la comunidad.

Infraestructura multirregional

Sus datos permanecen en su región. La plataforma Ultralytics opera infraestructura en tres regiones globales:

| Región | Ubicación | Ideal para |

|---|---|---|

| EE. UU. | Iowa, EE. UU. | Usuarios de América, el más rápido para América |

| UE | Bélgica, Europa | Usuarios europeos, cumplimiento del RGPD |

| AP | Taiwán, Asia-Pacífico | Usuarios de Asia-Pacífico, latencia más baja de APAC |

Usted selecciona su región durante la incorporación, y todos sus datos, modelos y despliegues permanecen en esa región.

Características clave

Preparación de datos

- Gestión de Conjuntos de Datos: Suba imágenes, videos o archivos ZIP con procesamiento automático

- Editor de Anotaciones: Anotación manual para los 5 tipos de tareas de YOLO (detect, segment, pose, obb, classify)

- Anotación Inteligente SAM: Anotación inteligente basada en clics utilizando Segment Anything Model

- Auto-Anotación: Utilice modelos entrenados para pre-etiquetar nuevos datos

- Estadísticas: Distribución de clases, mapas de calor de ubicación y análisis de dimensiones

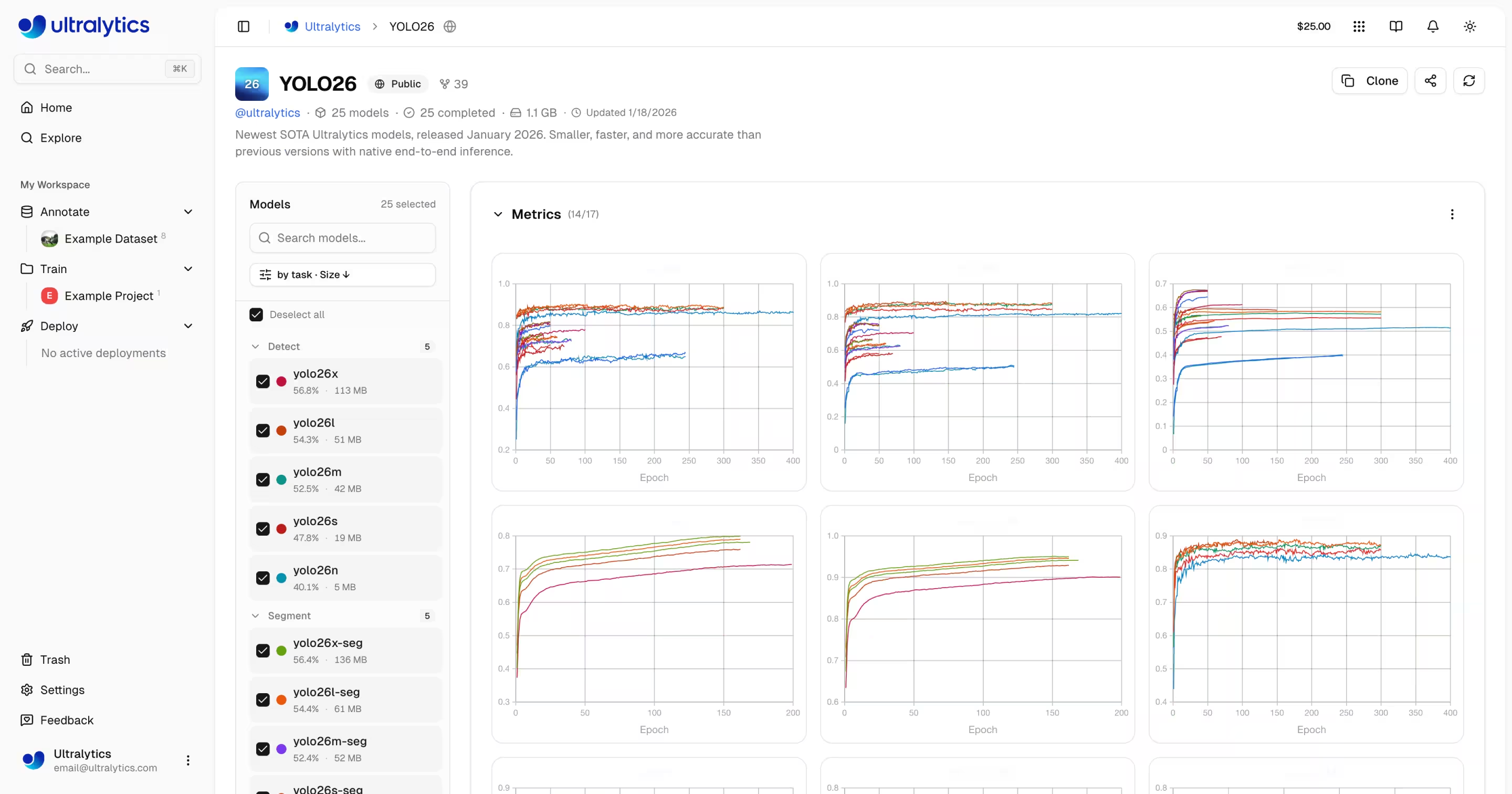

Entrenamiento de modelos

- Entrenamiento en la Nube: Entrene en GPUs en la nube (RTX 4090, A100, H100) con métricas en tiempo real

- Entrenamiento Remoto: Entrene en cualquier lugar y transmita métricas a la Plataforma (estilo W&B)

- Organización de Proyectos: Agrupe modelos relacionados, compare experimentos, realice seguimiento de la actividad

- 17 Formatos de Exportación: ONNX, TensorRT, CoreML, TFLite y más

Despliegue

- Pruebas de Inferencia: Pruebe modelos directamente en el navegador con imágenes personalizadas

- Endpoints Dedicados: Despliegue en 43 regiones globales con autoescalado

- Monitoreo: Métricas en tiempo real, registros de solicitudes y paneles de rendimiento

Gestión de cuentas

- API Keys: Gestión segura de claves para entrenamiento remoto y acceso a la API

- Créditos y Facturación: Entrenamiento de pago por uso con precios transparentes

- Feed de actividad: Realiza un seguimiento de todos los eventos y acciones de la cuenta.

- Papelera y restauración: eliminación temporal durante 30 días con recuperación de elementos.

- Cumplimiento GDPR: Exportación de datos y eliminación de cuentas

Enlaces rápidos

Empiece con estos recursos:

- Inicio Rápido: Cree su primer proyecto y entrene un modelo en minutos

- Conjuntos de Datos: Suba y gestione sus datos de entrenamiento

- Anotación: Etiquete sus datos con herramientas manuales y asistidas por IA

- Proyectos: Organice sus modelos y experimentos

- Entrenamiento en la Nube: Entrene en GPUs en la nube

- Inferencia: Pruebe sus modelos

- Endpoints: Despliegue modelos a producción

- Monitorización: track el rendimiento del despliegue

- API Keys: Gestione el acceso a la API

- Facturación: Créditos y pago

- Actividad: Realizar un seguimiento de los eventos de la cuenta.

- Papelera: Recuperar elementos eliminados

- REST API: Referencia de la API

Preguntas frecuentes

¿Cómo empiezo con Ultralytics Platform?

Para empezar con Ultralytics Platform:

- Registrarse: Cree una cuenta en platform.ultralytics.com

- Seleccionar Región: Elija su región de datos (EE. UU., UE o AP) durante la incorporación

- Subir Conjunto de Datos: Vaya a la sección de Conjuntos de Datos para subir sus datos

- Entrenar Modelo: Cree un proyecto y empiece a entrenar en GPUs en la nube

- Desplegar: Pruebe su modelo y despliegue a un endpoint dedicado

Para una guía detallada, consulte la página de Inicio Rápido.

¿Cuáles son los beneficios de Ultralytics Platform?

Ultralytics Platform ofrece:

- Flujo de Trabajo Unificado: Datos, entrenamiento y despliegue en un solo lugar

- Multirregión: Residencia de datos en regiones de EE. UU., UE o AP

- Entrenamiento sin código: Entrene modelos avanzados de YOLO sin escribir código

- Métricas en tiempo real: Transmita el progreso del entrenamiento y supervise las implementaciones

- 43 Regiones de despliegue: Despliegue modelos cerca de sus usuarios en todo el mundo

- 5 Tipos de tareas: Soporte para detect, segment, pose, obb y clasificación

- Anotación asistida por IA: SAM y autoetiquetado para acelerar la preparación de datos

¿Qué opciones de GPU están disponibles para el entrenamiento en la nube?

La Plataforma Ultralytics es compatible con múltiples tipos de GPU para el entrenamiento en la nube:

| Nivel | GPU | VRAM | Costo por hora | Ideal para |

|---|---|---|---|---|

| Presupuesto | RTX A2000 | 6 GB | $0.12 | Conjuntos de datos pequeños, pruebas |

| Presupuesto | RTX 3080 | 10 GB | $0.25 | Conjuntos de datos medianos |

| Presupuesto | RTX 3080 Ti | 12 GB | $0.30 | Conjuntos de datos medianos |

| Presupuesto | A30 | 24 GB | $0.44 | Tamaños de lotes más grandes |

| Medio | RTX 4090 | 24 GB | $0.60 | Excelente relación calidad-precio |

| Medio | A6000 | 48 GB | $0.90 | Modelos grandes |

| Medio | L4 | 24 GB | $0.54 | Inferencia optimizada |

| Medio | L40S | 48 GB | $1.72 | Entrenamiento por lotes grandes |

| Pro | A100 40GB | 40 GB | $2.78 | Formación en producción |

| Pro | A100 80GB | 80 GB | $3.44 | Modelos muy grandes |

| Pro | H100 | 80 GB | $5.38 | Entrenamiento más rápido |

| Empresarial | H200 | 141 GB | $5.38 | Máximo rendimiento |

| Empresarial | B200 | 192 GB | $10.38 | Modelos más grandes |

| Ultralytics | RTX PRO 6000 | 48 GB | $3.68 | Ultralytics |

Consulte Formación en la nube para obtener información completa sobre precios y GPU .

¿Cómo funciona el entrenamiento remoto?

Puede entrenar modelos en cualquier lugar y transmitir métricas a la Plataforma.

Requisito de Versión del Paquete

La integración con la Plataforma requiere ultralytics>=8.4.0. Las versiones anteriores NO funcionarán con la Plataforma.

pip install "ultralytics>=8.4.0"

# Set your API key

export ULTRALYTICS_API_KEY="your_api_key"

# Train with project/name to stream metrics

yolo train model=yolo26n.pt data=coco.yaml epochs=100 project=username/my-project name=exp1

Consulte Entrenamiento en la Nube para obtener más detalles sobre el entrenamiento remoto.

¿Qué herramientas de anotación están disponibles?

La Plataforma incluye un editor de anotaciones con todas las funciones, compatible con:

- Herramientas manuales: Cajas delimitadoras, polígonos, puntos clave, cajas orientadas, clasificación

- Anotación inteligente SAM: Haga clic para generar máscaras precisas utilizando el Modelo Segment Anything

- YOLO Auto-Annotation: Utilice modelos entrenados para pre-etiquetar imágenes

- Atajos de teclado: Flujos de trabajo eficientes con teclas de acceso rápido

Consulte Anotación para la guía completa.

Solución de problemas

Problemas con los conjuntos de datos

| Problema | Solución |

|---|---|

| El conjunto de datos no se procesará. | Comprueba que el formato del archivo sea compatible (JPEG, PNG, WebP, etc.). Tamaño máximo del archivo: imágenes 50 MB, vídeos 1 GB, ZIP 50 GB. |

| Anotaciones faltantes | Verifique que las etiquetas estén en YOLO con .txt archivos que coinciden con los nombres de los archivos de imagen |

| «Se requiere división del tren» | Añadir train/ Añade una carpeta a la estructura de tu conjunto de datos o crea divisiones en la configuración del conjunto de datos. |

| Nombres de clase indefinidos | Añadir un data.yaml archivo con names: lista, o definir clases en la configuración del conjunto de datos |

Cuestiones relacionadas con la formación

| Problema | Solución |

|---|---|

| El entrenamiento no comenzará. | Comprueba el saldo de crédito en Ajustes > Facturación. Se requiere un mínimo de 5,00 $. |

| Error de memoria insuficiente | Reduzca el tamaño del lote, utilice un modelo más pequeño (n/s) o seleccione GPU más VRAM. |

| Métricas deficientes | Comprueba la calidad del conjunto de datos, aumenta los períodos, prueba el aumento de datos, verifica el equilibrio de clases. |

| Entrenamiento lento | Selecciona GPU más rápida, reduce el tamaño de la imagen y comprueba que el conjunto de datos no esté saturado. |

Problemas de implementación

| Problema | Solución |

|---|---|

| El punto final no responde. | Comprueba el estado del punto final (en ejecución o detenido). El arranque en frío puede tardar entre 2 y 5 segundos. |

| 401 No autorizado | Verifica que la clave API sea correcta y tenga los ámbitos necesarios. |

| Inferencia lenta | Comprueba el tamaño del modelo, considera TensorRT , selecciona una región más cercana. |

| Error en la exportación | Algunos formatos requieren arquitecturas de modelo específicas. Prueba ONNX obtener la mayor compatibilidad posible. |

Preguntas frecuentes

¿Puedo cambiar mi nombre de usuario después de registrarme?

No, los nombres de usuario son permanentes y no se pueden cambiar. Elígelo con cuidado durante el registro.

¿Puedo cambiar mi región de datos?

No, la región de datos se selecciona durante el registro y no se puede cambiar. Para cambiar de región, cree una nueva cuenta y vuelva a cargar sus datos.

¿Cómo puedo conseguir más créditos?

Ve a Configuración > Facturación > Añadir créditos. Compra créditos por valor de entre 5 y 1000 dólares. Los créditos comprados nunca caducan.

¿Qué sucede si el entrenamiento falla?

Solo se le cobrará por el tiempo de computación completado. Los puntos de control se guardan y puede reanudar el entrenamiento.

¿Puedo descargar mi modelo entrenado?

Sí, haz clic en el icono de descarga en cualquier página de modelo para descargar el .pt archivo o formatos exportados.

¿Cómo puedo compartir mi trabajo públicamente?

Edita la configuración de tu proyecto o conjunto de datos y cambia la visibilidad a «Público». El contenido público aparece en la página Explorar.

¿Cuáles son los límites de tamaño de los archivos?

Imágenes: 50 MB, vídeos: 1 GB, archivos ZIP: 50 GB. Para archivos más grandes, divídalos en varias subidas.

¿Cuánto tiempo se conservan los elementos eliminados en la Papelera?

30 días. Después de ese plazo, los elementos se eliminan de forma permanente y no se pueden recuperar.

¿Puedo utilizar los modelos de la plataforma con fines comerciales?

Los planes Free y Pro utilizan la licencia AGPL. Para uso comercial sin los requisitos de la AGPL, póngase en contacto conultralytics para obtener una licencia Enterprise.