SAM 3: Segment Anything con Conceptos

Ahora disponible en Ultralytics

SAM 3 está completamente integrado en el paquete Ultralytics a partir de versión 8.3.237 (PR #22897). Instale o actualice con pip install -U ultralytics para acceder a todas las características de SAM 3, incluyendo la segmentación de conceptos basada en texto, prompts de imágenes de ejemplo y el track de video.

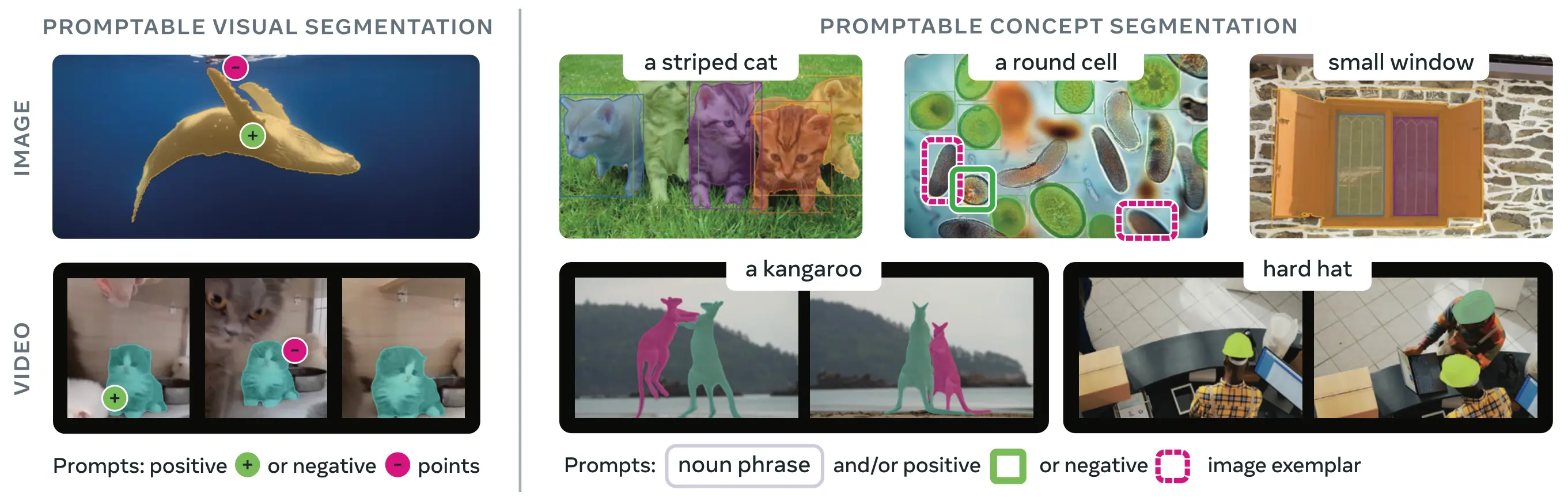

SAM 3 (Segment Anything Model 3) es el modelo fundacional lanzado por Meta para la Segmentación de Conceptos Solicitables (PCS). Basándose en SAM 2, SAM 3 introduce una capacidad fundamentalmente nueva: detectar, segmentar y trackear todas las instancias de un concepto visual especificado por indicaciones de texto, ejemplos de imágenes o ambos. A diferencia de las versiones anteriores de SAM que segmentan objetos individuales por indicación, SAM 3 puede encontrar y segmentar cada aparición de un concepto que aparezca en cualquier lugar de las imágenes o los vídeos, lo que se alinea con los objetivos de vocabulario abierto en la segmentación de instancias moderna.

Ver: Cómo usar Meta Segment Anything 3 con Ultralytics | Segmentación por prompt de texto en imágenes y vídeos

SAM 3 ahora está completamente integrado en el ultralytics paquete, proporcionando soporte nativo para la segmentación de conceptos con prompts de texto, prompts de imágenes de ejemplo y capacidades de track de video.

Visión general

SAM 3 logra una ganancia de rendimiento de 2× con respecto a los sistemas existentes en Segmentación de Conceptos Solicitables, al tiempo que mantiene y mejora las capacidades de SAM 2 para la segmentación visual interactiva. El modelo destaca en la segmentación de vocabulario abierto, lo que permite a los usuarios especificar conceptos utilizando frases nominales simples (por ejemplo, "autobús escolar amarillo", "gato a rayas") o proporcionando imágenes de ejemplo del objeto objetivo. Estas capacidades complementan los flujos de trabajo listos para producción que se basan en flujos de trabajo optimizados de predict y track.

¿Qué es la segmentación de conceptos con avisos (PCS)?

La tarea PCS toma un prompt de concepto como entrada y devuelve máscaras de segmentación con identidades únicas para todas las instancias de objetos coincidentes. Los prompts de concepto pueden ser:

- Texto: Frases nominales simples como "manzana roja" o "persona con sombrero", similar al aprendizaje zero-shot

- Imágenes ejemplares: Bounding boxes alrededor de objetos de ejemplo (positivos o negativos) para una generalización rápida

- Combinado: Ejemplares de texto e imagen juntos para un control preciso

Esto difiere de los prompts visuales tradicionales (puntos, bbox, máscaras) que segment solo una instancia de objeto específica, como popularizó la familia SAM original.

Métricas clave de rendimiento

| Métrica | Logro SAM 3 |

|---|---|

| AP de máscaras LVIS Zero-Shot | 47.0 (vs el mejor anterior 38.5, +22% de mejora) |

| Benchmark SA-Co | 2 veces mejor que los sistemas existentes |

| Velocidad de Inferencia (GPU H200) | 30 ms por imagen con más de 100 objetos detectados |

| Rendimiento de vídeo | Casi en tiempo real para ~5 objetos concurrentes |

| Benchmark MOSEv2 VOS | 60.1 J&F (+25.5% sobre SAM 2.1, +17% sobre el SOTA anterior) |

| Refinamiento interactivo | Mejora de +18.6 CGF1 tras 3 indicaciones ejemplares |

| Brecha de Rendimiento Humano | Alcanza un 88% del límite inferior estimado en SA-Co/Gold |

Para obtener contexto sobre las métricas del modelo y las compensaciones en la producción, consulta información sobre la evaluación del modelo y métricas de rendimiento de YOLO.

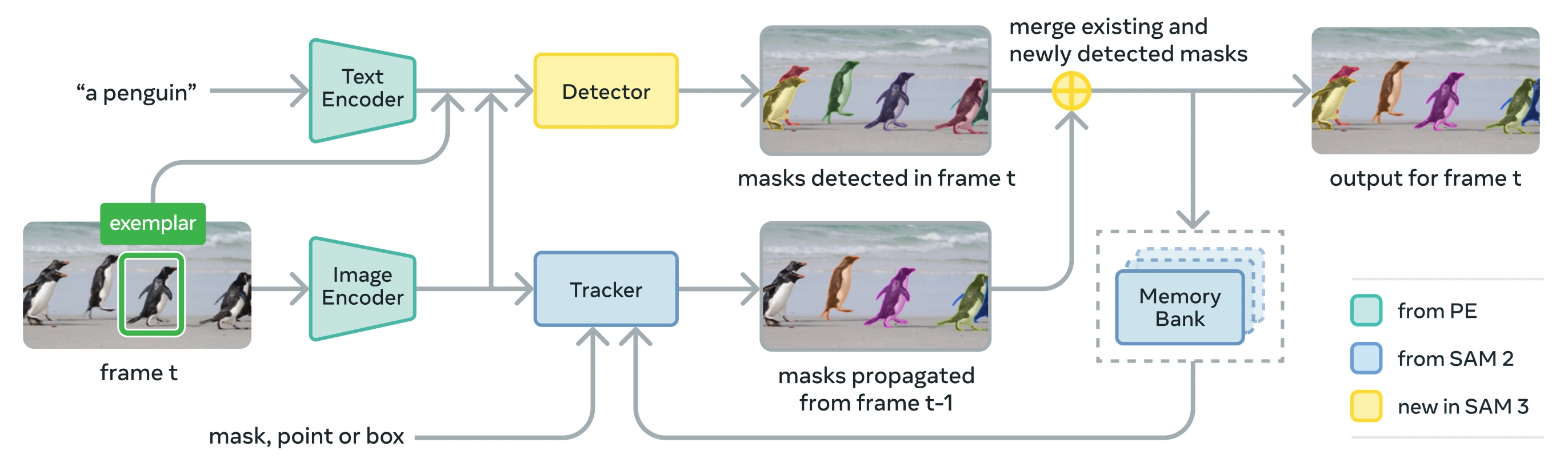

Arquitectura

SAM 3 consta de un detector y un tracker que comparten una red troncal de visión Perception Encoder (PE). Este diseño desacoplado evita conflictos de tareas al tiempo que permite la detección a nivel de imagen y el tracking a nivel de video, con una interfaz compatible con el uso de python y el uso de la CLI de Ultralytics.

Componentes centrales

Detector: Arquitectura basada en DETR para la detección de conceptos a nivel de imagen

- Codificador de texto para indicaciones de frases nominales

- Codificador ejemplar para indicaciones basadas en imágenes

- Codificador de fusión para condicionar las características de la imagen en función de las indicaciones

- Nueva cabecera de presencia que desacopla el reconocimiento ("qué") de la localización ("dónde")

- Cabezal de máscara para generar máscaras de segmentación de instancias

Tracker: Segmentación de video basada en memoria heredada de SAM 2

- Codificador de indicaciones, decodificador de máscaras, codificador de memoria

- Banco de memoria para almacenar la apariencia de los objetos a través de los fotogramas

- Desambiguación temporal asistida por técnicas como un filtro de Kalman en configuraciones multi-objeto

Token de Presencia: Un token global aprendido que predice si el concepto objetivo está presente en la imagen/fotograma, mejorando la detección al separar el reconocimiento de la localización.

Innovaciones clave

- Reconocimiento y Localización Desacoplados: El head de presencia predice la presencia del concepto globalmente, mientras que las consultas de propuesta se centran únicamente en la localización, evitando objetivos conflictivos.

- Concepto unificado y avisos visuales: Admite tanto PCS (avisos de concepto) como PVS (avisos visuales como los clics/cuadros de SAM 2) en un solo modelo.

- Refinamiento Interactivo de Ejemplares: Los usuarios pueden añadir ejemplares de imagen positivos o negativos para refinar los resultados de forma iterativa, con el modelo generalizando a objetos similares en lugar de solo corregir instancias individuales.

- Desambiguación Temporal: Utiliza puntuaciones de detección de masklet y re-prompts periódicos para manejar oclusiones, escenas concurridas y fallos de seguimiento en vídeo, en consonancia con las mejores prácticas de segmentación y seguimiento de instancias.

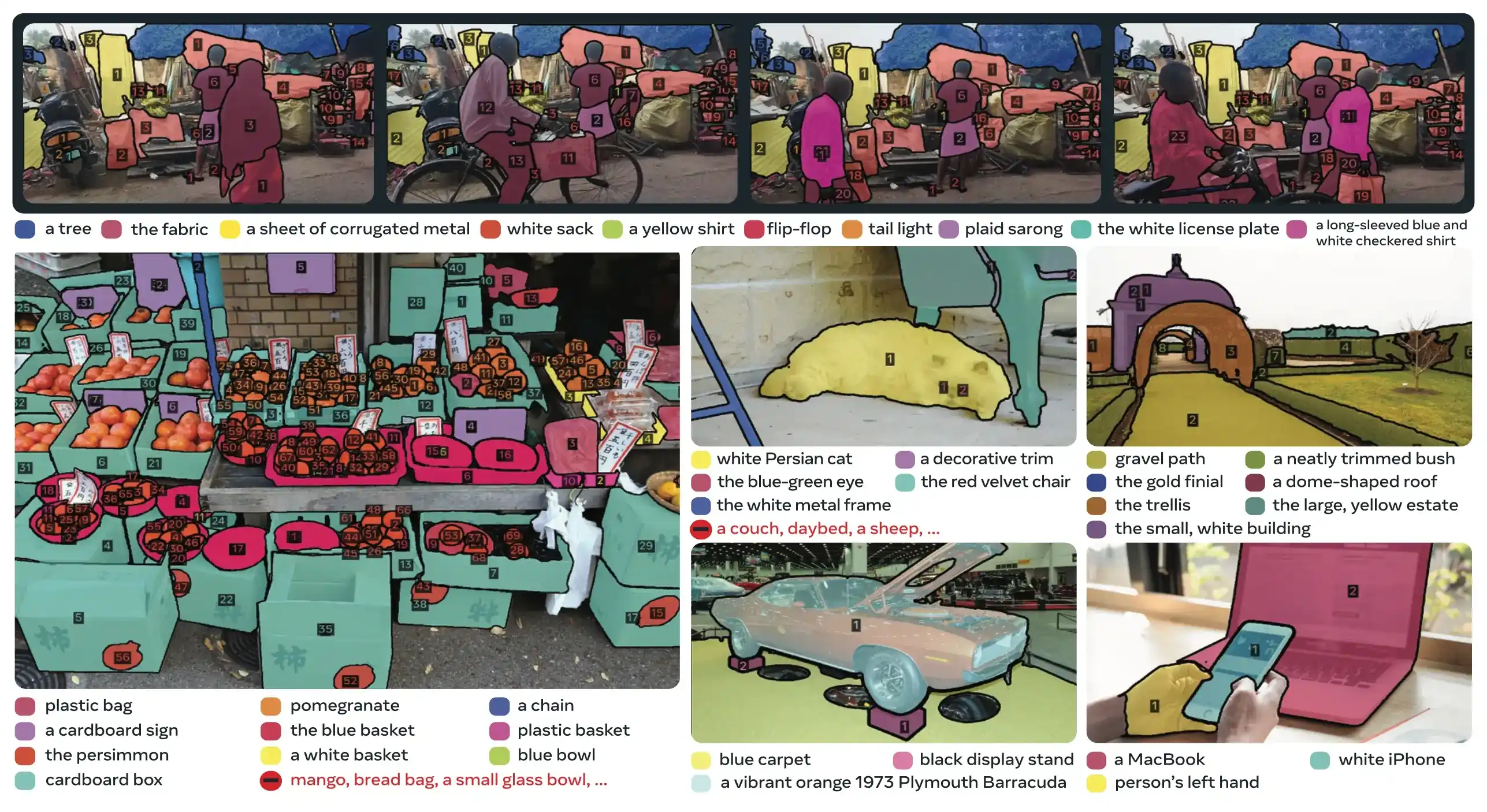

Conjunto de datos SA-Co

SAM 3 está entrenado en Segment Anything with Concepts (SA-Co), el conjunto de datos de segmentación más grande y diverso de Meta hasta la fecha, que se extiende más allá de los benchmarks comunes como COCO y LVIS.

Datos de entrenamiento

| Componente del conjunto de datos | Descripción | Escala |

|---|---|---|

| SA-Co/HQ | Datos de imagen anotados por humanos de alta calidad procedentes del motor de datos de 4 fases | 5.2 millones de imágenes, 4 millones de frases nominales únicas |

| SA-Co/SYN | Conjunto de datos sintéticos etiquetado por IA sin intervención humana | 38 millones de frases nominales, 1.400 millones de máscaras |

| SA-Co/EXT | 15 conjuntos de datos externos enriquecidos con negativos difíciles | Varía según la fuente |

| SA-Co/VIDEO | Anotaciones de vídeo con seguimiento temporal | 52.5K vídeos, 24.8K frases nominales únicas |

Datos de referencia

El punto de referencia de evaluación SA-Co contiene 214.000 frases únicas en 126.000 imágenes y vídeos, lo que proporciona más de 50 veces más conceptos que los puntos de referencia existentes. Incluye:

- SA-Co/Gold: 7 dominios, con triple anotación para medir los límites del rendimiento humano

- SA-Co/Silver: 10 dominios, anotación humana única

- SA-Co/Bronze y SA-Co/Bio: 9 conjuntos de datos existentes adaptados para la segmentación de conceptos

- SA-Co/VEval: Video benchmark con 3 dominios (SA-V, YT-Temporal-1B, SmartGlasses)

Innovaciones del motor de datos

El motor de datos escalable de SAM 3, con humanos y modelos en el bucle, logra un rendimiento de anotación 2× a través de:

- Anotadores de IA: Los modelos basados en Llama proponen diversas frases nominales, incluyendo negativos difíciles.

- Verificadores de IA: Los LLM multimodales ajustados verifican la calidad y la exhaustividad de la máscara con un rendimiento casi humano.

- Minería Activa: Centra el esfuerzo humano en casos de fallo desafiantes donde la IA tiene dificultades

- Basado en ontología: Aprovecha una gran ontología basada en Wikidata para la cobertura de conceptos

Instalación

SAM 3 está disponible en Ultralytics versión 8.3.237 y posteriores. Instale o actualice con:

pip install -U ultralytics

Se Requieren Pesos del Modelo SAM 3

A diferencia de otros modelos de Ultralytics, los pesos de SAM 3 (sam3.pt) no se descargan automáticamente. Primero debe solicitar acceso a los pesos del modelo en la página del modelo SAM 3 en Hugging Face y luego, una vez aprobado, descargar el sam3.pt archivo. Coloque el descargado sam3.pt archivo en su directorio de trabajo o especifique la ruta completa al cargar el modelo.

TypeError: 'SimpleTokenizer' object is not callable

Si aparece el error anterior durante la predicción, significa que tiene incorrecto el clip paquete instalado. Instale el correcto clip paquete ejecutando lo siguiente:

pip uninstall clip -y

pip install git+https://github.com/ultralytics/CLIP.git

Cómo utilizar SAM 3: Versatilidad en la segmentación de conceptos

SAM 3 soporta tanto la Segmentación de Conceptos Prompteable (PCS) como las tareas de Segmentación Visual Prompteable (PVS) a través de diferentes interfaces de predictor:

Tareas y Modelos Soportados

| Tipo de Tarea | Tipos de indicaciones | Salida |

|---|---|---|

| Segmentación de conceptos (PCS) | Texto (frases nominales), ejemplos de imágenes | Todas las instancias que coinciden con el concepto |

| Segmentación visual (PVS) | Puntos, cuadros, máscaras | Instancia de un solo objeto (estilo SAM 2) |

| Refinamiento interactivo | Añadir/eliminar ejemplares o clics de forma iterativa | Segmentación refinada con precisión mejorada |

Ejemplos de segmentación de conceptos

segment con Indicaciones de Texto

Segmentación de conceptos basada en texto

Encuentre y segment todas las instancias de un concepto utilizando una descripción de texto. Los prompts de texto requieren la SAM3SemanticPredictor interfaz.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor with configuration

overrides = dict(

conf=0.25,

task="segment",

mode="predict",

model="sam3.pt",

half=True, # Use FP16 for faster inference

save=True,

)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image once for multiple queries

predictor.set_image("path/to/image.jpg")

# Query with multiple text prompts

results = predictor(text=["person", "bus", "glasses"])

# Works with descriptive phrases

results = predictor(text=["person with red cloth", "person with blue cloth"])

# Query with a single concept

results = predictor(text=["a person"])

segment con Ejemplares de Imagen

Segmentación basada en ejemplares de imágenes

Utilice cajas delimitadoras como prompts visuales para encontrar todas las instancias similares. Esto también requiere SAM3SemanticPredictor para la coincidencia basada en conceptos.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True, save=True)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image

predictor.set_image("path/to/image.jpg")

# Provide bounding box examples to segment similar objects

results = predictor(bboxes=[[480.0, 290.0, 590.0, 650.0]])

# Multiple bounding boxes for different concepts

results = predictor(bboxes=[[539, 599, 589, 639], [343, 267, 499, 662]])

Inferencia Basada en Características para la Eficiencia

Reutilización de Características de Imagen para Múltiples Consultas

Extraiga las características de la imagen una vez y reutilícelas para múltiples consultas de segmentación para mejorar la eficiencia.

import cv2

from ultralytics.models.sam import SAM3SemanticPredictor

from ultralytics.utils.plotting import Annotator, colors

# Initialize predictors

overrides = dict(conf=0.50, task="segment", mode="predict", model="sam3.pt", verbose=False)

predictor = SAM3SemanticPredictor(overrides=overrides)

predictor2 = SAM3SemanticPredictor(overrides=overrides)

# Extract features from the first predictor

source = "path/to/image.jpg"

predictor.set_image(source)

src_shape = cv2.imread(source).shape[:2]

# Setup second predictor and reuse features

predictor2.setup_model()

# Perform inference using shared features with text prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, text=["person"])

# Perform inference using shared features with bounding box prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, bboxes=[[439, 437, 524, 709]])

# Visualize results

if masks is not None:

masks, boxes = masks.cpu().numpy(), boxes.cpu().numpy()

im = cv2.imread(source)

annotator = Annotator(im, pil=False)

annotator.masks(masks, [colors(x, True) for x in range(len(masks))])

cv2.imshow("result", annotator.result())

cv2.waitKey(0)

Segmentación de conceptos en vídeo

track Conceptos en Video con Cajas Delimitadoras

track de Video con Prompts Visuales

detect y track instancias de objetos a través de fotogramas de video utilizando prompts de cajas delimitadoras.

from ultralytics.models.sam import SAM3VideoPredictor

# Create video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True)

predictor = SAM3VideoPredictor(overrides=overrides)

# Track objects using bounding box prompts

results = predictor(source="path/to/video.mp4", bboxes=[[706.5, 442.5, 905.25, 555], [598, 635, 725, 750]], stream=True)

# Process and display results

for r in results:

r.show() # Display frame with segmentation masks

track Conceptos con Prompts de Texto

track de Video con Consultas Semánticas

track todas las instancias de conceptos especificados por texto a través de fotogramas de video.

from ultralytics.models.sam import SAM3VideoSemanticPredictor

# Initialize semantic video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", imgsz=640, model="sam3.pt", half=True, save=True)

predictor = SAM3VideoSemanticPredictor(overrides=overrides)

# Track concepts using text prompts

results = predictor(source="path/to/video.mp4", text=["person", "bicycle"], stream=True)

# Process results

for r in results:

r.show() # Display frame with tracked objects

# Alternative: Track with bounding box prompts

results = predictor(

source="path/to/video.mp4",

bboxes=[[864, 383, 975, 620], [705, 229, 782, 402]],

labels=[1, 1], # Positive labels

stream=True,

)

Indicaciones visuales (compatibilidad con SAM 2)

SAM 3 mantiene total compatibilidad con versiones anteriores con el prompting visual de SAM 2 para la segmentación de objetos únicos:

SAM 2 Estilos de Prompts Visuales

La interfaz básica SAM se comporta exactamente como SAM 2, segmentando solo el área específica indicada por prompts visuales (puntos, cajas o máscaras).

from ultralytics import SAM

model = SAM("sam3.pt")

# Single point prompt - segments object at specific location

results = model.predict(source="path/to/image.jpg", points=[900, 370], labels=[1])

results[0].show()

# Multiple points - segments single object with multiple point hints

results = model.predict(source="path/to/image.jpg", points=[[400, 370], [900, 370]], labels=[1, 1])

# Box prompt - segments object within bounding box

results = model.predict(source="path/to/image.jpg", bboxes=[100, 150, 300, 400])

results[0].show()

Prompts visuales vs. segmentación de conceptos

Usando SAM("sam3.pt") con prompts visuales (puntos/cajas/máscaras) segmentará solo el objeto específico en esa ubicación, al igual que SAM 2. Para segmentar todas las instancias de un concepto, usa SAM3SemanticPredictor con prompts de texto o de ejemplo, como se muestra arriba.

Métricas de rendimiento

Segmentación de imágenes

SAM 3 logra resultados de última generación en múltiples benchmarks, incluyendo conjuntos de datos del mundo real como LVIS y COCO para segmentación:

| Benchmark | Métrica | SAM 3 | Mejor Anterior | Mejora |

|---|---|---|---|---|

| LVIS (zero-shot) | Mask AP | 47.0 | 38.5 | +22.1% |

| SA-Co/Gold | CGF1 | 65.0 | 34.3 (OWLv2) | +89.5% |

| COCO (zero-shot) | AP de caja | 53.5 | 52.2 (T-Rex2) | +2.5% |

| ADE-847 (segmentación semántica) | mIoU | 14.7 | 9.2 (APE-D) | +59.8% |

| PascalConcept-59 | mIoU | 59.4 | 58.5 (APE-D) | +1.5% |

| Cityscapes (seg. semántica) | mIoU | 65.1 | 44.2 (APE-D) | +47.3% |

Explore las opciones de conjuntos de datos para una experimentación rápida en conjuntos de datos de Ultralytics.

Rendimiento de la segmentación de vídeo

SAM 3 muestra mejoras significativas sobre SAM 2 y el estado del arte anterior en benchmarks de video como DAVIS 2017 y YouTube-VOS:

| Benchmark | Métrica | SAM 3 | SAM 2.1 L | Mejora |

|---|---|---|---|---|

| MOSEv2 | J&F | 60.1 | 47.9 | +25.5% |

| DAVIS 2017 | J&F | 92.0 | 90.7 | +1.4% |

| LVOSv2 | J&F | 88.2 | 79.6 | +10.8% |

| SA-V | J&F | 84.6 | 78.4 | +7.9% |

| YTVOS19 | J&F | 89.6 | 89.3 | +0.3% |

Adaptación Few-Shot

SAM 3 destaca en la adaptación a nuevos dominios con ejemplos mínimos, relevante para los flujos de trabajo de IA centrada en los datos:

| Benchmark | AP 0-shot | AP 10-shot | Mejor Anterior (10-shot) |

|---|---|---|---|

| ODinW13 | 59.9 | 71.6 | 67.9 (gDino1.5-Pro) |

| RF100-VL | 14.3 | 35.7 | 33.7 (gDino-T) |

Eficacia del refinamiento interactivo

El prompting basado en conceptos con ejemplares de SAM 3 converge mucho más rápido que el prompting visual:

| Indicaciones añadidas | Puntuación CGF1 | Ganancia vs Solo texto | Ganancia vs Línea base PVS |

|---|---|---|---|

| Solo texto | 46.4 | línea base | línea base |

| +1 ejemplo | 57.6 | +11.2 | +6.7 |

| +2 ejemplos | 62.2 | +15.8 | +9.7 |

| +3 ejemplos | 65.0 | +18.6 | +11.2 |

| +4 ejemplares | 65.7 | +19.3 | +11.5 (meseta) |

Precisión en el conteo de objetos

SAM 3 proporciona un conteo preciso al segmentar todas las instancias, un requisito común en el conteo de objetos:

| Benchmark | Precisión | MAE | vs el mejor MLLM |

|---|---|---|---|

| CountBench | 95.6% | 0.11 | 92.4% (Gemini 2.5) |

| PixMo-Count | 87.3% | 0.22 | 88.8% (Molmo-72B) |

Comparación de SAM 3 vs SAM 2 vs YOLO

Aquí comparamos las capacidades de SAM 3 con los modelos SAM 2 y YOLO11:

| Capacidad | SAM 3 | SAM 2 | YOLO11n-seg |

|---|---|---|---|

| Segmentación de conceptos | ✅ Todas las instancias de texto/ejemplares | ❌ No compatible | ❌ No compatible |

| Segmentación visual | ✅ Instancia única (compatible con SAM 2) | ✅ Instancia única | ✅ Todas las instancias |

| Capacidad Zero-shot | ✅ Vocabulario abierto | ✅ Indicaciones geométricas | ❌ Conjunto cerrado |

| Refinamiento interactivo | ✅ Ejemplares + clics | ✅ Solo clics | ❌ No compatible |

| Seguimiento de vídeo | ✅ Multiobjeto con identidades | ✅ Multiobjeto | ✅ Multiobjeto |

| AP de máscaras LVIS (zero-shot) | 47.0 | N/A | N/A |

| MOSEv2 J&F | 60.1 | 47.9 | N/A |

| Velocidad de Inferencia (H200) | 30 ms (más de 100 objetos) | ~23 ms (por objeto) | 2-3 ms (imagen) |

| Tamaño del modelo | 3.4GB | 162 MB (base) | 5.9 MB |

Conclusiones clave:

- SAM 3: Ideal para la segmentación de conceptos de vocabulario abierto, encontrando todas las instancias de un concepto con texto o indicaciones ejemplares

- SAM 2: Lo mejor para la segmentación interactiva de un solo objeto en imágenes y vídeos con indicaciones geométricas

- YOLO11: Ideal para segmentación en tiempo real y de alta velocidad en implementaciones con recursos limitados utilizando pipelines de exportación eficientes como ONNX y TensorRT

Métricas de evaluación

SAM 3 introduce nuevas métricas diseñadas para la tarea PCS, que complementan las medidas familiares como la puntuación F1, la precisión y la recuperación.

F1 con puerta de enlace de clasificación (CGF1)

La métrica principal que combina localización y clasificación:

CGF1 = 100 × pmF1 × IL_MCC

Dónde:

- pmF1 (F1 Macro Positivo): Mide la calidad de la localización en ejemplos positivos

- IL_MCC (Coeficiente de Correlación de Matthews a Nivel de Imagen): Mide la precisión de la clasificación binaria ("¿está presente el concepto?")

¿Por qué estas métricas?

Las métricas AP tradicionales no tienen en cuenta la calibración, lo que dificulta el uso de los modelos en la práctica. Al evaluar solo las predicciones por encima de 0.5 de confianza, las métricas de SAM 3 imponen una buena calibración e imitan los patrones de uso del mundo real en los bucles interactivos de predict y track.

Ablaciones e Insights Clave

Impacto de la presencia de la cabeza

El encabezado de presencia desacopla el reconocimiento de la localización, proporcionando mejoras significativas:

| Configuración | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| Sin presencia | 57.6 | 0.77 | 74.7 |

| Con presencia | 63.3 | 0.82 | 77.1 |

El encabezado de presencia proporciona un aumento de +5.7 CGF1 (+9.9%), mejorando principalmente la capacidad de reconocimiento (IL_MCC +6.5%).

Efecto de los negativos difíciles

| Negativos Difíciles/Imagen | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| 0 | 31.8 | 0.44 | 70.2 |

| 5 | 44.8 | 0.62 | 71.9 |

| 30 | 49.2 | 0.68 | 72.3 |

Los negativos difíciles son cruciales para el reconocimiento de vocabulario abierto, mejorando IL_MCC en un 54.5% (0.44 → 0.68).

Escalado de datos de entrenamiento

| Fuentes de datos | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| Solo externo | 30.9 | 0.46 | 66.3 |

| Externo + Sintético | 39.7 | 0.57 | 70.6 |

| Externo + AC | 51.8 | 0.71 | 73.2 |

| Los tres | 54.3 | 0.74 | 73.5 |

Las anotaciones humanas de alta calidad proporcionan grandes beneficios en comparación con los datos sintéticos o externos por sí solos. Para obtener información general sobre las prácticas de calidad de los datos, consulta recopilación y anotación de datos.

Aplicaciones

La capacidad de segmentación de conceptos de SAM 3 permite nuevos casos de uso:

- Moderación de contenido: Encuentra todas las instancias de tipos de contenido específicos en las bibliotecas de medios

- Comercio electrónico: segment todos los productos de un determinado tipo en las imágenes del catálogo, lo que permite la anotación automática

- Imágenes médicas: Identifique todas las apariciones de tipos de tejido o anomalías específicas

- Sistemas autónomos: track todas las instancias de señales de tráfico, peatones o vehículos por categoría

- Analítica de Video: Contar y rastrear a todas las personas que visten ropa específica o realizan acciones

- Anotación de conjuntos de datos: Anote rápidamente todas las instancias de categorías de objetos raras

- Investigación Científica: Cuantificar y analizar todos los especímenes que coincidan con criterios específicos

Agente SAM 3: Razonamiento Extendido del Lenguaje

SAM 3 se puede combinar con Modelos de Lenguaje Grande Multimodal (MLLM) para manejar consultas complejas que requieren razonamiento, similar en espíritu a los sistemas de vocabulario abierto como OWLv2 y T-Rex.

Rendimiento en tareas de razonamiento

| Benchmark | Métrica | Agente SAM 3 (Gemini 2.5 Pro) | Mejor Anterior |

|---|---|---|---|

| ReasonSeg (validación) | GIoU | 76.0 | 65.0 (SoTA) |

| ReasonSeg (prueba) | GIoU | 73.8 | 61.3 (SoTA) |

| OmniLabel (validación) | AP | 46.7 | 36.5 (REAL) |

| RefCOCO+ | Prec | 91.2 | 89.3 (LISA) |

Ejemplo de consultas complejas

El Agente SAM 3 puede manejar consultas que requieren razonamiento:

- "Personas sentadas que no sostienen una caja de regalo en sus manos"

- "El perro más cercano a la cámara que no lleva collar"

- "Objetos rojos más grandes que la mano de la persona"

El MLLM propone consultas simples de frases nominales a SAM 3, analiza las máscaras devueltas e itera hasta que esté satisfecho.

Limitaciones

Si bien SAM 3 representa un gran avance, tiene ciertas limitaciones:

- Complejidad de la frase: Más adecuado para frases nominales simples; las expresiones de referencia largas o el razonamiento complejo pueden requerir la integración de MLLM

- Manejo de la ambigüedad: Algunos conceptos siguen siendo intrínsecamente ambiguos (por ejemplo, "ventana pequeña", "habitación acogedora")

- Requisitos Computacionales: Más grande y lento que los modelos de detección especializados como YOLO

- Alcance del Vocabulario: Centrado en conceptos visuales atómicos; el razonamiento compositivo es limitado sin la asistencia de MLLM

- Conceptos raros: El rendimiento puede degradarse en conceptos extremadamente raros o de grano fino que no están bien representados en los datos de entrenamiento.

Citación

@inproceedings{sam3_2025,

title = {SAM 3: Segment Anything with Concepts},

author = {Anonymous authors},

booktitle = {Submitted to ICLR 2026},

year = {2025},

url = {https://openreview.net/forum?id=r35clVtGzw},

note = {Paper ID: 4183, under double-blind review}

}

Preguntas frecuentes

¿Cuándo fue lanzado SAM 3?

SAM 3 fue lanzado por Meta el 20 de noviembre de 2025 y está completamente integrado en Ultralytics a partir de la versión 8.3.237 (PR #22897). Hay soporte completo disponible para el modo de predicción y el modo de track.

¿Está SAM 3 integrado en Ultralytics?

¡Sí! SAM 3 está completamente integrado en el paquete python de Ultralytics, incluyendo la segmentación de conceptos, los prompts visuales al estilo de SAM 2 y el seguimiento de múltiples objetos en vídeo.

¿Qué es la segmentación de conceptos con avisos (PCS)?

PCS es una nueva tarea introducida en SAM 3 que segmenta todas las instancias de un concepto visual en una imagen o video. A diferencia de la segmentación tradicional que se dirige a una instancia de objeto específica, PCS encuentra cada ocurrencia de una categoría. Por ejemplo:

- Indicación de texto: "autobús escolar amarillo" → segmenta todos los autobuses escolares amarillos en la escena

- Imagen ejemplar: Recuadro alrededor de un perro → segments todos los perros en la imagen

- Combinado: "gato atigrado" + cuadro ejemplar → segmenta todos los gatos atigrados que coinciden con el ejemplo

Consulte información relacionada sobre detección de objetos y segmentación de instancias.

¿En qué se diferencia SAM 3 de SAM 2?

| Característica | SAM 2 | SAM 3 |

|---|---|---|

| Tarea | Un solo objeto por solicitud | Todas las instancias de un concepto |

| Tipos de indicaciones | Puntos, cuadros, máscaras | + Frases de texto, ejemplos de imágenes |

| Capacidad de Detección | Requiere detector externo | Detector de vocabulario abierto incorporado |

| Reconocimiento | Basado solo en la geometría | Texto y reconocimiento visual |

| Arquitectura | Solo Tracker | Detector + Tracker con cabezal de presencia |

| Rendimiento Zero-Shot | N/A (requiere indicaciones visuales) | 47.0 AP en LVIS, 2× mejor en SA-Co |

| Refinamiento interactivo | Solo clics | Clics + generalización ejemplar |

SAM 3 mantiene la compatibilidad con versiones anteriores con el prompting visual de SAM 2 al tiempo que añade capacidades basadas en conceptos.

¿Qué conjuntos de datos se utilizan para entrenar SAM 3?

SAM 3 está entrenado en el conjunto de datos Segment Anything with Concepts (SA-Co):

Datos de Entrenamiento:

- 5.2M de imágenes con 4M de frases nominales únicas (SA-Co/HQ) - anotaciones humanas de alta calidad

- 52.5K vídeos con 24.8K frases nominales únicas (SA-Co/VIDEO)

- 1.400 millones de máscaras sintéticas en 38 millones de frases nominales (SA-Co/SYN)

- 15 conjuntos de datos externos enriquecidos con negativos difíciles (SA-Co/EXT)

Datos de referencia:

- 214.000 conceptos únicos en 126.000 imágenes/vídeos

- 50× más conceptos que los benchmarks existentes (p. ej., LVIS tiene ~4K conceptos)

- Anotación triple en SA-Co/Gold para medir los límites del rendimiento humano

Esta escala y diversidad masivas permiten la generalización superior de cero disparos de SAM 3 a través de conceptos de vocabulario abierto.

¿Cómo se compara SAM 3 con YOLO11 para la segmentación?

SAM 3 y YOLO11 sirven para diferentes casos de uso:

SAM 3 Ventajas:

- Vocabulario abierto: segmenta cualquier concepto a través de indicaciones de texto sin entrenamiento

- Zero-shot: Funciona en nuevas categorías inmediatamente

- Interactivo: El refinamiento basado en ejemplares se generaliza a objetos similares

- Basado en conceptos: Encuentra automáticamente todas las instancias de una categoría

- Precisión: 47.0 AP en segmentación de instancias zero-shot en LVIS

Ventajas de YOLO11:

- Velocidad: Inferencia 10-15 veces más rápida (2-3 ms frente a 30 ms por imagen)

- Eficiencia: modelos 576 veces más pequeños (5.9MB vs 3.4GB)

- Amigable con los recursos: Se ejecuta en dispositivos edge y móviles

- Tiempo real: Optimizado para implementaciones de producción

Recomendación:

- Utilice SAM 3 para una segmentación flexible y de vocabulario abierto donde necesite encontrar todas las instancias de conceptos descritos por texto o ejemplos

- Utilice YOLO11 para implementaciones de producción de alta velocidad donde las categorías se conocen de antemano

- Utilice SAM 2 para la segmentación interactiva de un solo objeto con indicaciones geométricas

¿Puede SAM 3 manejar consultas de lenguaje complejas?

SAM 3 está diseñado para frases nominales simples (por ejemplo, "manzana roja", "persona con sombrero"). Para consultas complejas que requieren razonamiento, combine SAM 3 con un MLLM como Agente SAM 3:

Consultas sencillas (SAM 3 nativo):

- "Autobús escolar amarillo"

- "Gato atigrado"

- "Persona con sombrero rojo"

Consultas complejas (SAM 3 Agent con MLLM):

- "Personas sentadas que no sostienen una caja de regalo"

- "El perro más cercano a la cámara sin collar"

- "Objetos rojos más grandes que la mano de la persona"

El Agente SAM 3 logra 76.0 gIoU en la validación de ReasonSeg (vs 65.0, la mejor anterior, +16.9% de mejora) al combinar la segmentación de SAM 3 con las capacidades de razonamiento de MLLM.

¿Qué precisión tiene SAM 3 en comparación con el rendimiento humano?

En el benchmark SA-Co/Gold con triple anotación humana:

- Límite inferior humano: 74.2 CGF1 (anotador más conservador)

- SAM 3 rendimiento: 65.0 CGF1

- Logro: 88% del límite inferior humano estimado

- Límite superior humano: 81.4 CGF1 (anotador más liberal)

SAM 3 logra un sólido rendimiento que se acerca a la precisión del nivel humano en la segmentación de conceptos de vocabulario abierto, con la diferencia principalmente en conceptos ambiguos o subjetivos (por ejemplo, "ventana pequeña", "habitación acogedora").