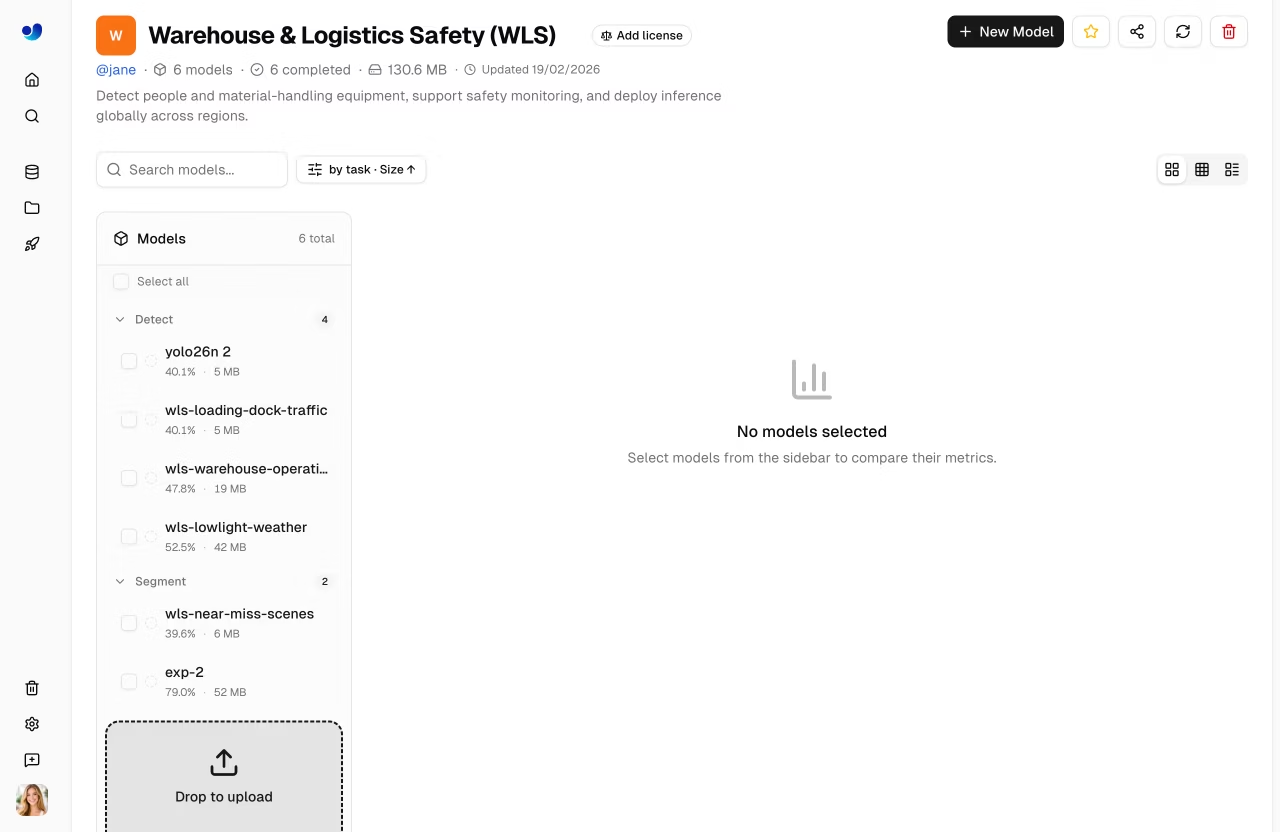

Modelos

Ultralytics ofrece una gestión integral de modelos para entrenar, analizar e implementar YOLO . Cargue modelos preentrenados o entrene otros nuevos directamente en la plataforma.

Cargar Modelo

Cargar los pesos del modelo existente en la plataforma:

- Navegue a su proyecto

- Arrastrar y soltar

.ptarchivos en la página del proyecto o en la barra lateral de modelos - Los metadatos del modelo se analizan automáticamente a partir del archivo.

Se pueden cargar varios archivos simultáneamente (hasta 3 a la vez).

Formatos de modelo compatibles:

| Formato | Extensión | Descripción |

|---|---|---|

| PyTorch | .pt | Formato nativo de Ultralytics |

Después de la carga, la plataforma analiza los metadatos del modelo:

- Tipo de tarea (detect, segment, pose, OBB, classify)

- Arquitectura (YOLO26n, YOLO26s, etc.)

- Nombres y recuento de clases

- Tamaño de entrada y parámetros

- Resultados y métricas de entrenamiento (si están presentes en el punto de control)

Entrenar Modelo

Entrena un nuevo modelo directamente en la plataforma:

- Navegue a su proyecto

- Haga clic en Nuevo modelo

- Seleccionar modelo base y conjunto de datos

- Configura los parámetros de entrenamiento

- Elija formación en la nube o local

- Inicia el entrenamiento

Consulte Entrenamiento en la Nube para obtener instrucciones detalladas.

Ciclo de vida del modelo

graph LR

A[Upload .pt] --> B[Overview]

C[Train] --> B

B --> D[Predict]

B --> E[Export]

B --> F[Deploy]

E --> G[17+ Formats]

F --> H[Endpoint]

style A fill:#4CAF50,color:#fff

style C fill:#FF9800,color:#fff

style E fill:#2196F3,color:#fff

style F fill:#9C27B0,color:#fffPestañas de la página del modelo

Cada página de modelo tiene las siguientes pestañas:

| Pestaña | Contenido |

|---|---|

| Visión general | Metadatos del modelo, métricas clave, enlace al conjunto de datos |

| Entrenar | Gráficos de entrenamiento, salida de la consola, estadísticas del sistema |

| Predecir | Inferencia interactiva del navegador |

| Exportar | Conversión de formato con GPU |

| Despliegue | Creación y gestión de endpoints |

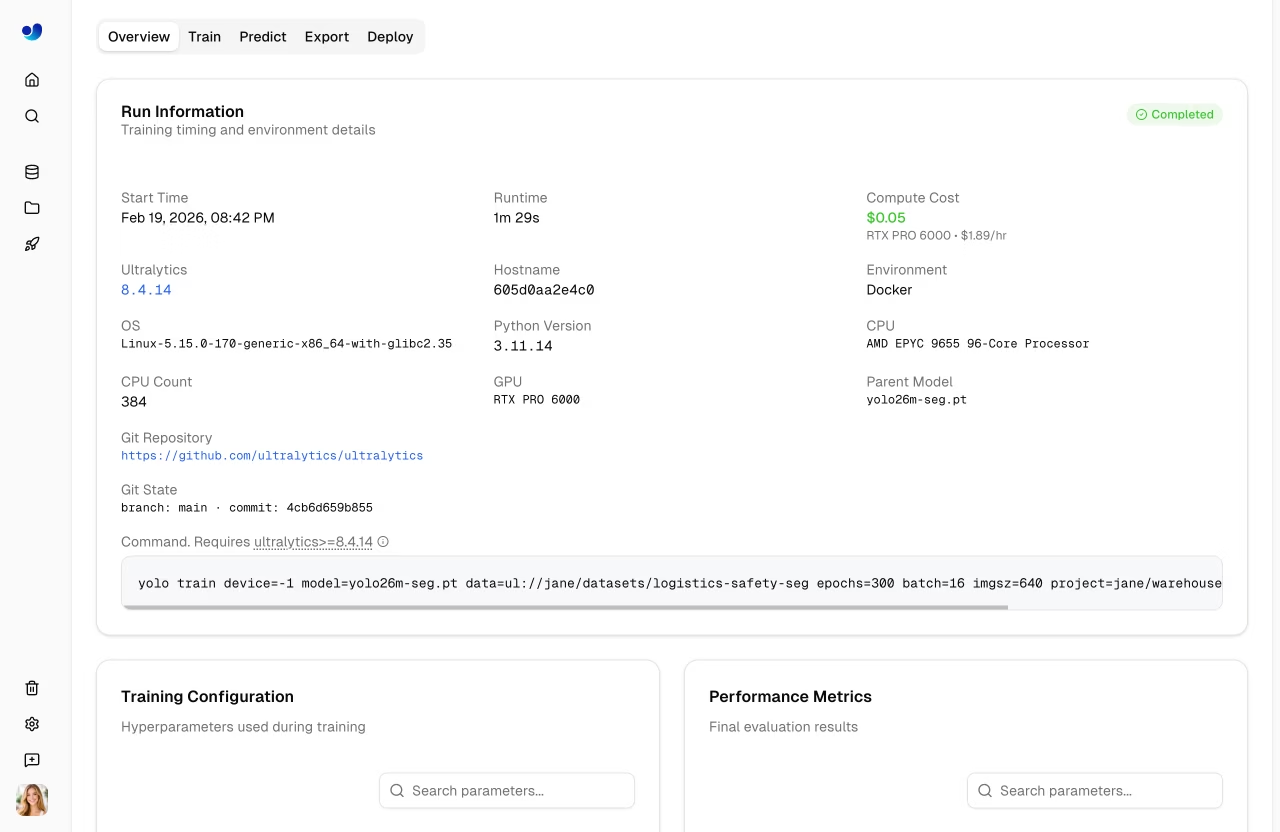

Pestaña Descripción general

Muestra los metadatos del modelo y las métricas clave:

- Nombre del modelo (editable), insignia de estado, tipo de tarea

- Métricas finales (mAP50, mAP50, precisión, recuperación)

- Gráficos métricos de sparkline que muestran la progresión del entrenamiento.

- Argumentos de entrenamiento (épocas, tamaño del lote, tamaño de la imagen, etc.)

- Enlace al conjunto de datos (cuando se entrena con un conjunto de datos de la plataforma)

- Botón de descarga para los pesos del modelo

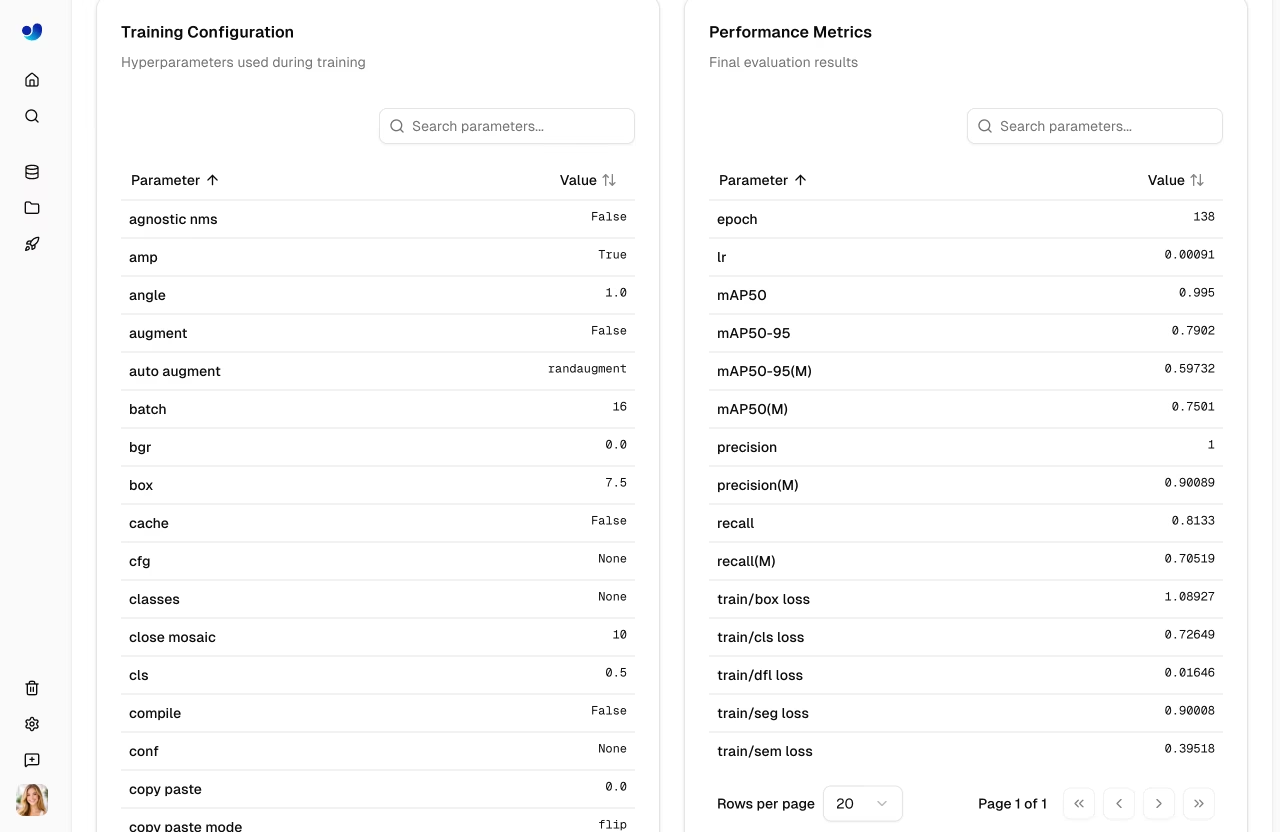

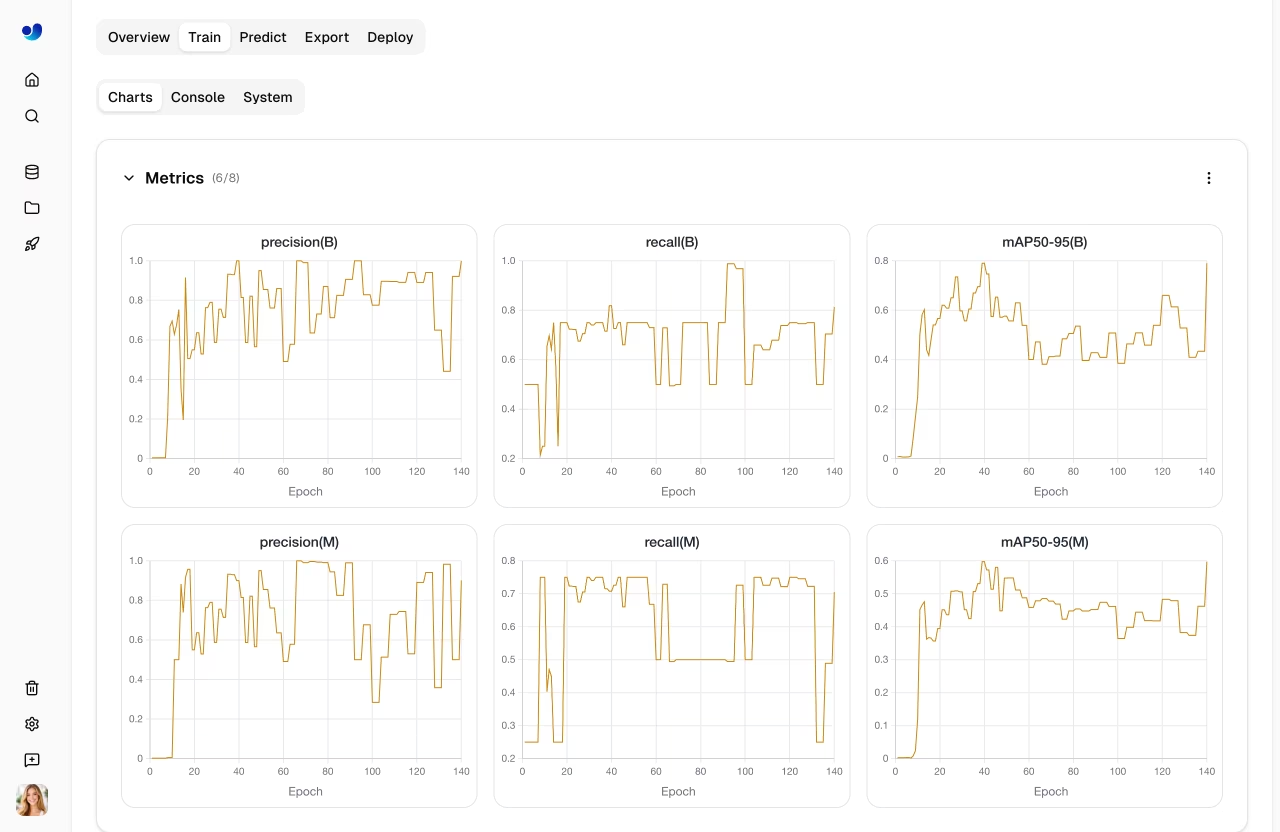

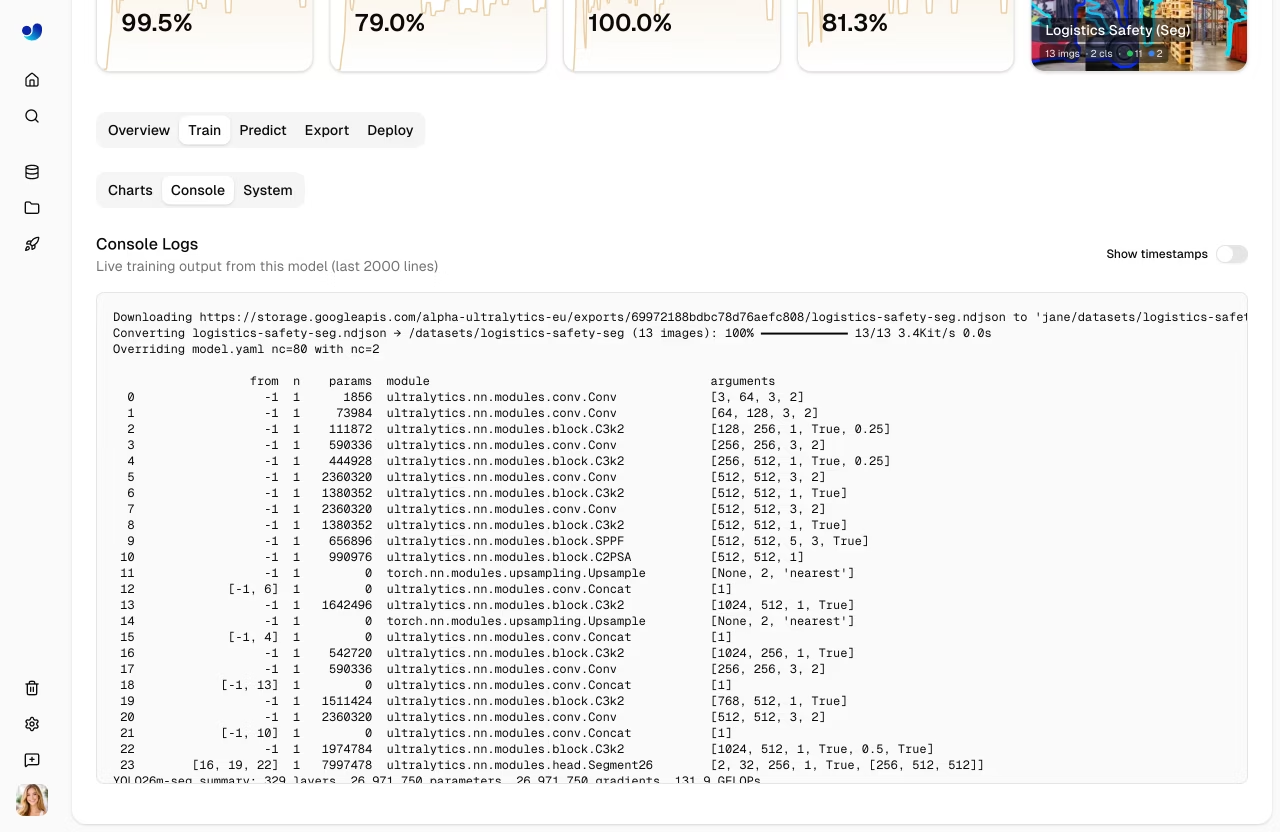

Pestaña Tren

La pestaña Tren tiene tres subpestañas:

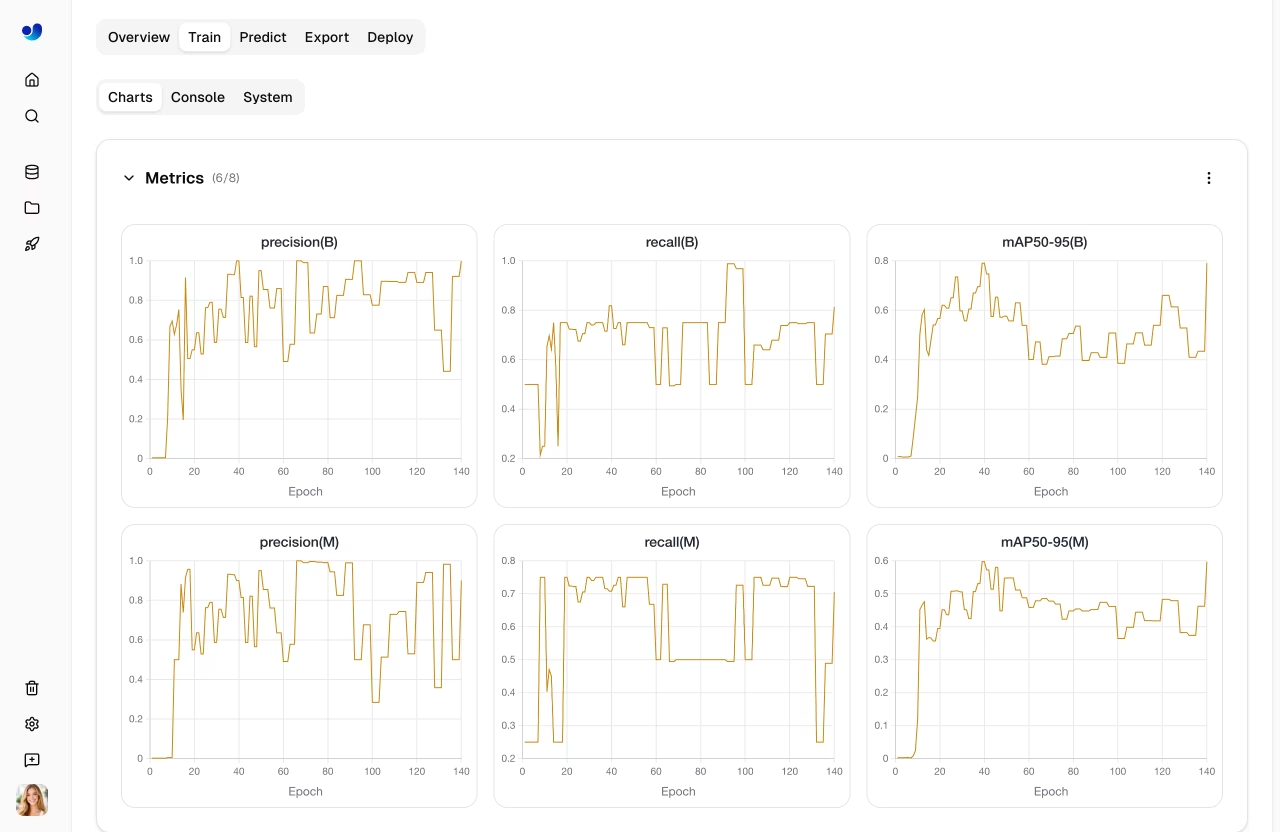

Subpestaña Gráficos

Gráficos métricos de entrenamiento interactivos que muestran curvas de pérdida y métricas de rendimiento a lo largo de épocas:

| Grupo de gráficos | Métricas |

|---|---|

| Métricas | mAP50, mAP50, precisión, recuperación |

| Pérdida del tren | entrenamiento/pérdida_box, entrenamiento/pérdida_cls, entrenamiento/pérdida_dfl |

| Pérdida de valor | val/pérdida de caja, val/pérdida de clase, val/pérdida de dfl |

| Tasa de aprendizaje | lr/pg0, lr/pg1, lr/pg2 |

Subpestaña Consola

Salida de la consola en vivo del proceso de entrenamiento:

- Transmisión de registros en tiempo real durante el entrenamiento

- Barras de progreso de Epoch y resultados de validación

- Detección de errores con banners de error resaltados

- Compatibilidad con colores ANSI para salida formateada

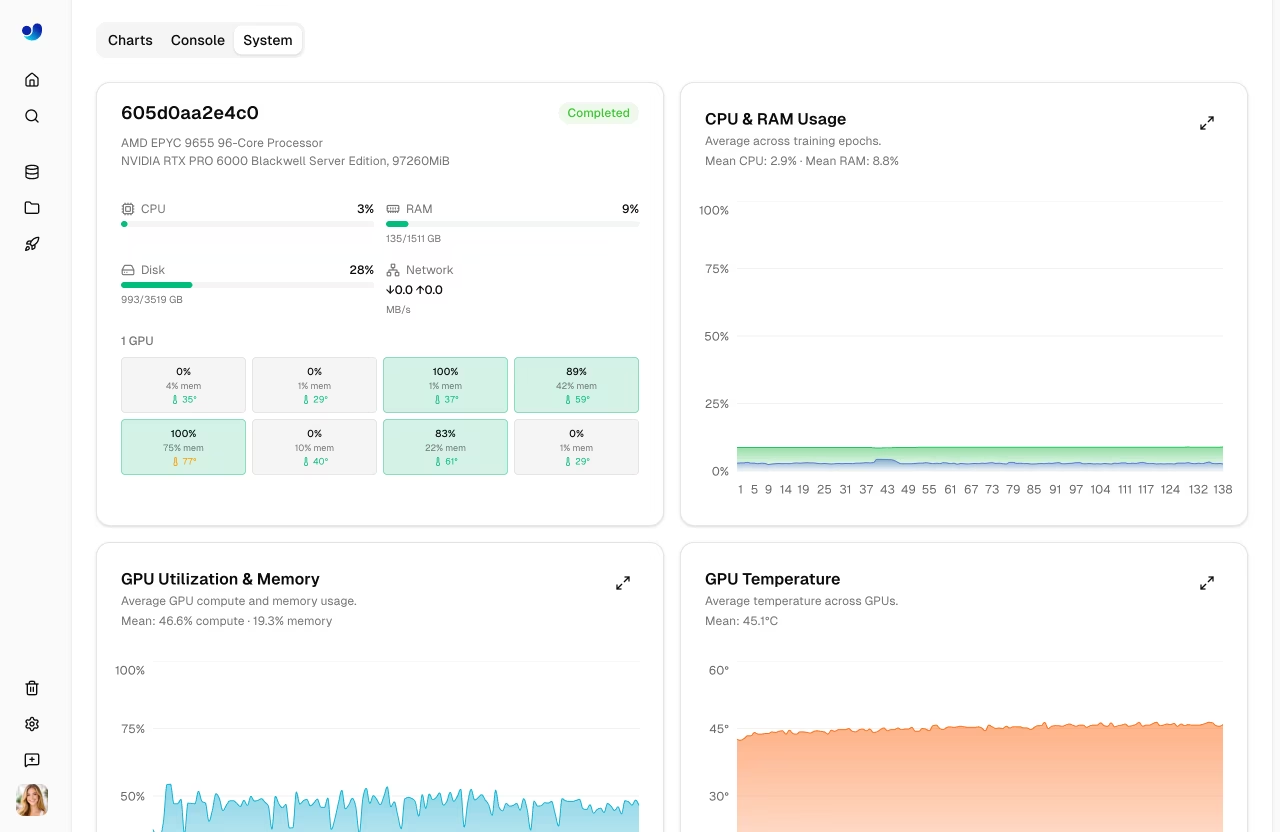

Subpestaña Sistema

Métricas GPU del sistema durante el entrenamiento:

| Métrica | Descripción |

|---|---|

| Utilización de GPU | Porcentaje de utilización de la GPU |

| GPU | Uso de memoria de la GPU |

| GPU | GPU |

| CPU | CPU |

| RAM | Uso de la memoria del sistema |

| Disco | Uso del disco |

Pestaña Predecir

Ejecute la inferencia interactiva directamente en el navegador:

- Sube una imagen, pega una URL o utiliza la cámara web.

- Los resultados se muestran con cuadros delimitadores, máscaras o puntos clave.

- Inferencia automática cuando se proporciona una imagen

- Admite todos los tipos de tareas (detect, segment, pose, OBB, classify)

Prueba rápida

La pestaña Predict ejecuta inferencias en Ultralytics , por lo que no es necesario disponer de una GPU local. Los resultados se muestran con superposiciones interactivas que coinciden con el tipo de tarea del modelo.

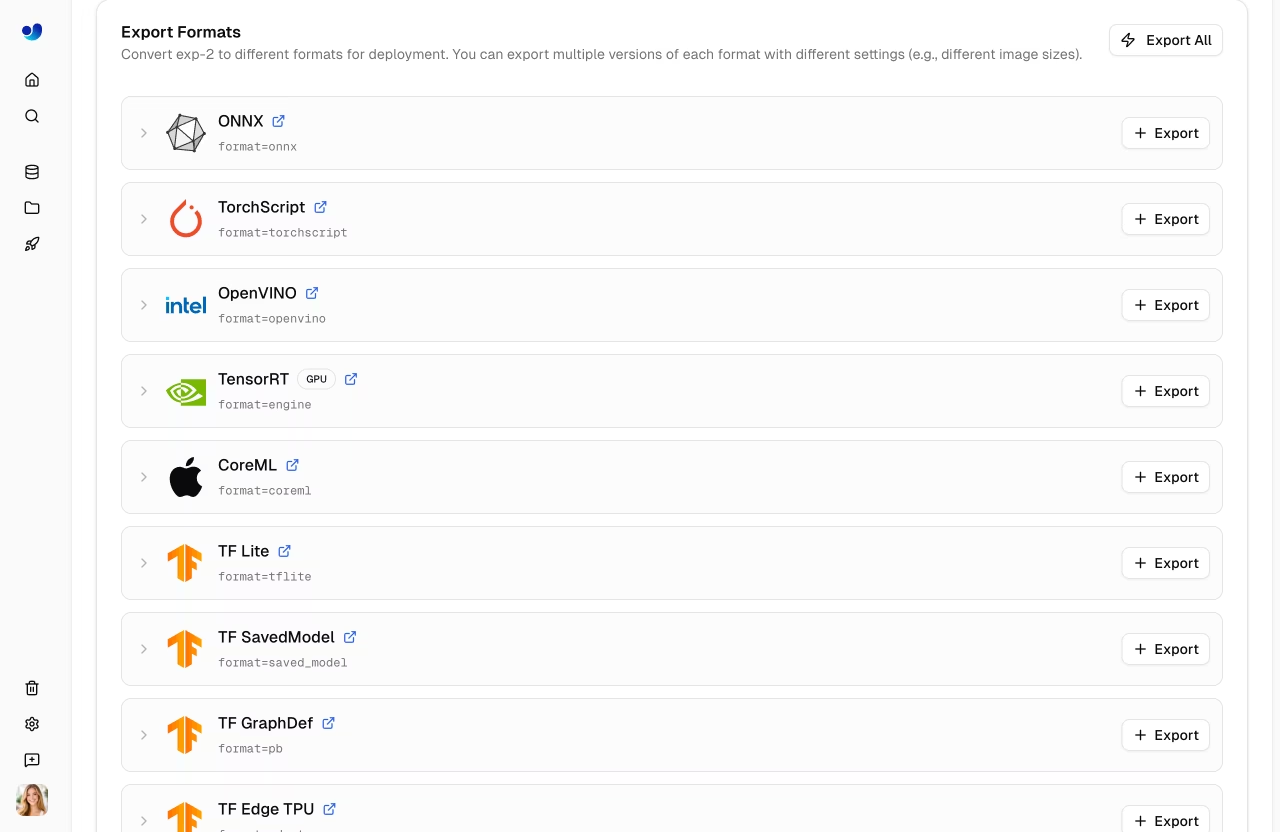

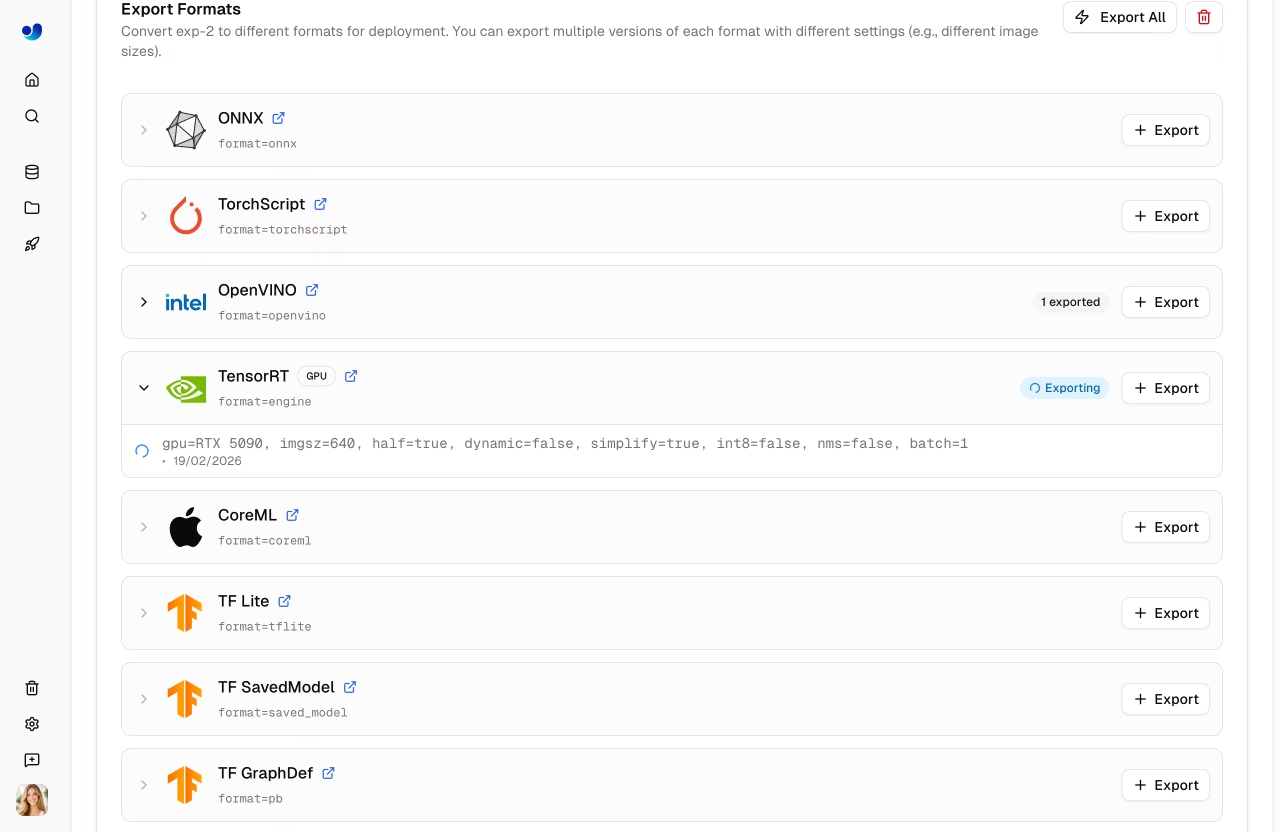

Pestaña Exportar

Exporte su modelo a más de 17 formatos de implementación. Consulte Exportar modelo a continuación y la guía básica del modo Exportar para obtener más detalles.

Pestaña Implementar

Cree y gestione puntos finales de inferencia dedicados. Consulte Implementaciones para obtener más información.

Gráficos de validación

Una vez completado el entrenamiento, vea un análisis de validación detallado:

Matriz de Confusión

Mapa de calor interactivo que muestra la precisión de la predicción por clase:

Curvas PR/F1

Curvas de rendimiento en diferentes umbrales de confianza:

| Curva | Descripción |

|---|---|

| Precisión-Exhaustividad | Compromiso entre precisión y exhaustividad |

| F1-Confianza | Puntuación F1 en diferentes niveles de confianza |

| Precisión-Confianza | Precisión en diferentes niveles de confianza |

| Exhaustividad-Confianza | Exhaustividad en diferentes niveles de confianza |

Exportar modelo

graph LR

A[Select Format] --> B[Configure Args]

B --> C[Export]

C --> D{GPU Required?}

D -->|Yes| E[Cloud GPU Export]

D -->|No| F[CPU Export]

E --> G[Download]

F --> G

style A fill:#2196F3,color:#fff

style C fill:#FF9800,color:#fff

style G fill:#4CAF50,color:#fffExporta tu modelo a más de 17 formatos de implementación:

- Navegue a la pestaña Exportar

- Seleccione el formato de destino

- Configurar argumentos de exportación (tamaño de imagen, media precisión, dinámica, etc.)

- Para formatos GPU(TensorRT), seleccione un GPU

- Haga clic en Exportar

- Descargue cuando esté completo

Formatos compatibles

La plataforma admite la exportación a más de 17 formatos de implementación: ONNX, TorchScript, OpenVINO, TensorRT, CoreML, TF SavedModel, TF GraphDef, TF , TF TPU, TF.js, PaddlePaddle, NCNN, MNN, RKNN, IMX500, Axelera y ExecuTorch.

Guía de selección de formatos

| Objetivo | Formato recomendado | Notas |

|---|---|---|

| GPUs de NVIDIA | TensorRT | Velocidad máxima de inferencia |

| Intel | OpenVINO | CPU, GPU y VPU |

| Dispositivos Apple | CoreML | iOS, macOS, Apple Silicon |

| Android | TF o NCNN | El mejor rendimiento móvil |

| Navegadores web | TF.js u ONNX | ONNX ONNX Web |

| Dispositivos periféricos | TF TPU RKNN | Coral y Rockchip (véase chips compatibles) |

| General | ONNX | Funciona con la mayoría de entornos de ejecución. |

Compatibilidad con chips RKNN

Al exportar al formato RKNN, seleccione su dispositivo Rockchip de destino:

| Chip | Descripción |

|---|---|

| RK3588 | SoC de gama alta |

| RK3576 | SoC de gama media |

| RK3568 | SoC de gama media |

| RK3566 | SoC de gama media |

| RK3562 | SoC de gama básica |

| RV1103 | Procesador de visión |

| RV1106 | Procesador de visión |

| RV1103B | Procesador de visión |

| RV1106B | Procesador de visión |

| RK2118 | Procesador de IA |

| RV1126B | Procesador de visión |

Ciclo de vida de los trabajos de exportación

Los trabajos de exportación pasan por los siguientes estados:

| Estado | Descripción |

|---|---|

| En cola | El trabajo de exportación está esperando para comenzar. |

| Inicio | Se está inicializando el trabajo de exportación. |

| Correr | La exportación está en curso. |

| Completado | Exportación finalizada — descarga disponible |

| Fallido | Error al exportar (véase el mensaje de error) |

| Cancelado | La exportación fue cancelada por el usuario. |

Tiempo de exportación

El tiempo de exportación varía según el formato. TensorRT pueden tardar varios minutos debido a la optimización del motor. Los formatos GPU(TensorRT) se ejecutan en las GPU Ultralytics ; la GPU de exportación predeterminada GPU RTX 5090.

Acciones de exportación masiva

- Exportar todo: Haga clic

Export AllIniciar trabajos de exportación para todos los formatos CPU con la configuración predeterminada. - Eliminar todas las exportaciones: Haga clic

Delete Allpara eliminar todas las exportaciones del modelo.

Restricciones de formato

Algunos formatos de exportación tienen restricciones de arquitectura o tareas:

| Formato | Restricción |

|---|---|

| IMX500 | Solo disponible para YOLO11 YOLOv8 YOLO11 . |

| Axelera | Solo disponible para modelos de detección. |

| PaddlePaddle | No disponible para modelos YOLO26 de detección/segmentación/pose/OBB. |

Modelo clonado

Clonar un modelo en un proyecto diferente:

- Abrir la página del modelo

- Haga clic en el botón Clonar.

- Selecciona el proyecto de destino.

- Haga clic en Clone

El modelo y sus pesos se copian al proyecto de destino.

Descargar Modelo

Descarga los pesos de tu modelo:

- Navega hasta la pestaña Descripción general del modelo.

- Haga clic en el botón Descargar.

- El original

.ptDescarga automática de archivos

Los formatos exportados se pueden descargar desde la pestaña Exportar una vez completada la exportación.

Vinculación de conjuntos de datos

Los modelos se pueden vincular a su conjunto de datos de origen:

- Visualizar qué conjunto de datos se utilizó para el entrenamiento

- Haga clic en la tarjeta del conjunto de datos en la pestaña Descripción general para acceder a él.

- track el linaje de los datos

Al entrenar con conjuntos de datos de la Plataforma utilizando el ul:// Formato URI, el enlace es automático.

Formato URI del conjunto de datos

# Train with a Platform dataset — linking is automatic

yolo train model=yolo26n.pt data=ul://username/datasets/my-dataset epochs=100

El ul:// El esquema se resuelve en el conjunto de datos de su plataforma. La pestaña «Descripción general» del modelo entrenado mostrará un enlace a este conjunto de datos (véase Uso de Conjuntos de Datos de la Plataforma).

Configuración de Visibilidad

Controla quién puede ver tu modelo:

| Configuración | Descripción |

|---|---|

| Privado | Solo tú puedes acceder |

| Público | Cualquiera puede visualizarlo en la página Explorar |

Para cambiar la visibilidad, haz clic en la insignia de visibilidad (por ejemplo, private o public) en la página del modelo. El cambio a privado se aplica de forma inmediata. El cambio a público muestra un cuadro de diálogo de confirmación antes de aplicarse.

Eliminar modelo

Elimina un modelo que ya no necesites:

- Abrir menú de acciones del modelo

- Haz clic en Eliminar

- Confirma la eliminación

Papelera y Restaurar

Los modelos eliminados se envían a la Papelera durante 30 días. Restáuralos desde Ajustes > Papelera.

Preguntas frecuentes

¿Qué arquitecturas de modelo son compatibles?

Ultralytics es totalmente compatible con todas YOLO con proyectos dedicados:

- YOLO26: variantes n, s, m, l, x (última versión, recomendada) — platform.ultralytics.ultralytics

- YOLO11: variantes n, s, m, l, x — platform.ultralytics.yolo11

- YOLOv8: variantes n, s, m, l, x — platform.ultralytics.yolov8

- YOLOv5: variantes n, s, m, l, x — platform.ultralytics.yolov5

Todas las arquitecturas admiten 5 tipos de tareas: detect, segment, pose, OBB y classify.

¿Puedo descargar mi modelo entrenado?

Sí, descargue los pesos de su modelo desde la página del modelo:

- Haga clic en el icono de descarga en la pestaña Descripción general.

- El original

.ptDescarga automática de archivos - Los formatos exportados se pueden descargar desde la pestaña Exportar.

¿Cómo comparo modelos entre proyectos?

Actualmente, la comparación de modelos se realiza dentro de los proyectos. Para comparar entre proyectos:

- Clonar modelos a un único proyecto, o

- Exporta métricas y compara externamente

¿Cuál es el tamaño máximo del modelo?

No hay un límite estricto, pero los modelos muy grandes (>2GB) pueden tener tiempos de carga y procesamiento más largos.

¿Puedo ajustar modelos preentrenados?

¡Sí! Puede utilizar cualquiera de los modelos oficiales de YOLO26 como base, o seleccionar uno de sus propios modelos completados en el selector de modelos del cuadro de diálogo de entrenamiento. La plataforma admite el ajuste fino desde cualquier punto de control cargado.