Plateforme Ultralytics

La plateforme Ultralytics est une plateforme de vision par ordinateur complète et de bout en bout qui rationalise l'ensemble du flux de travail ML, de la préparation des données au déploiement des modèles. Conçue pour les équipes et les individus qui ont besoin de solutions de vision par ordinateur prêtes pour la production, sans la complexité de l'infrastructure.

Qu'est-ce que la plateforme Ultralytics ?

La plateforme Ultralytics est conçue pour remplacer les outils ML fragmentés par une solution unifiée. Elle combine les capacités de :

- Roboflow - Gestion et annotation des données

- Weights & Biases - Suivi des expérimentations

- SageMaker - Entraînement dans le cloud

- HuggingFace - Déploiement de modèles

- Arize - Surveillance

Une plateforme tout-en-un avec prise en charge native des YOLO11 YOLO26 et YOLO11 .

Flux de travail : Télécharger → Annoter → Former → Exporter → Déployer

La plateforme offre un flux de travail de bout en bout :

graph LR

subgraph Data["📁 Data"]

A[Upload] --> B[Annotate]

B --> C[Analyze]

end

subgraph Train["🚀 Train"]

D[Configure] --> E[Train on GPU]

E --> F[View Metrics]

end

subgraph Deploy["🌐 Deploy"]

G[Export] --> H[Deploy Endpoint]

H --> I[Monitor]

end

Data --> Train --> Deploy| Étape | Fonctionnalités |

|---|---|

| Téléversement | Images (50 Mo), vidéos (1 Go), archives ZIP (50 Go) avec traitement automatique |

| Annotation | Outils manuels, annotation SAM , YOLO pour les 5 types de tâches |

| Entraîner | GPU cloud (RTX 4090 à H200), métriques en temps réel, organisation des projets |

| Exporter | 17 formats de déploiement (ONNX, TensorRT, CoreML, TFLite, etc.) |

| Déployer | 43 régions mondiales avec des points de terminaison dédiés, mise à l'échelle automatique, surveillance |

Ce que vous pouvez faire :

- Téléchargez des images, des vidéos et des archives ZIP pour créer des ensembles de données d'entraînement.

- Visualisez les annotations grâce à des superpositions interactives pour les 5 types YOLO .

- Entraînez des modèles sur des GPU cloud (RTX 4090 à H200) avec des métriques en temps réel.

- Exportation vers 17 formats de déploiement (ONNX, TensorRT, CoreML, TFLite, etc.)

- Déployez dans 43 régions du monde entier grâce à des points de terminaison dédiés en un seul clic.

- Suivre les progrès de la formation, l'état du déploiement et les indicateurs d'utilisation

- Collaborez en rendant publics vos projets et vos ensembles de données pour la communauté.

Infrastructure multi-régions

Vos données restent dans votre région. La Plateforme Ultralytics exploite une infrastructure dans trois régions mondiales :

| Région | Emplacement | Idéal pour |

|---|---|---|

| États-Unis | Iowa, États-Unis | Utilisateurs américains, le plus rapide pour les États-Unis |

| UE | Belgique, Europe | Utilisateurs européens, conformité RGPD |

| AP | Taïwan, Asie-Pacifique | Utilisateurs de la région Asie-Pacifique, latence APAC la plus faible |

Vous sélectionnez votre région lors de l'intégration, et toutes vos données, modèles et déploiements restent dans cette région.

Principales caractéristiques

Préparation des données

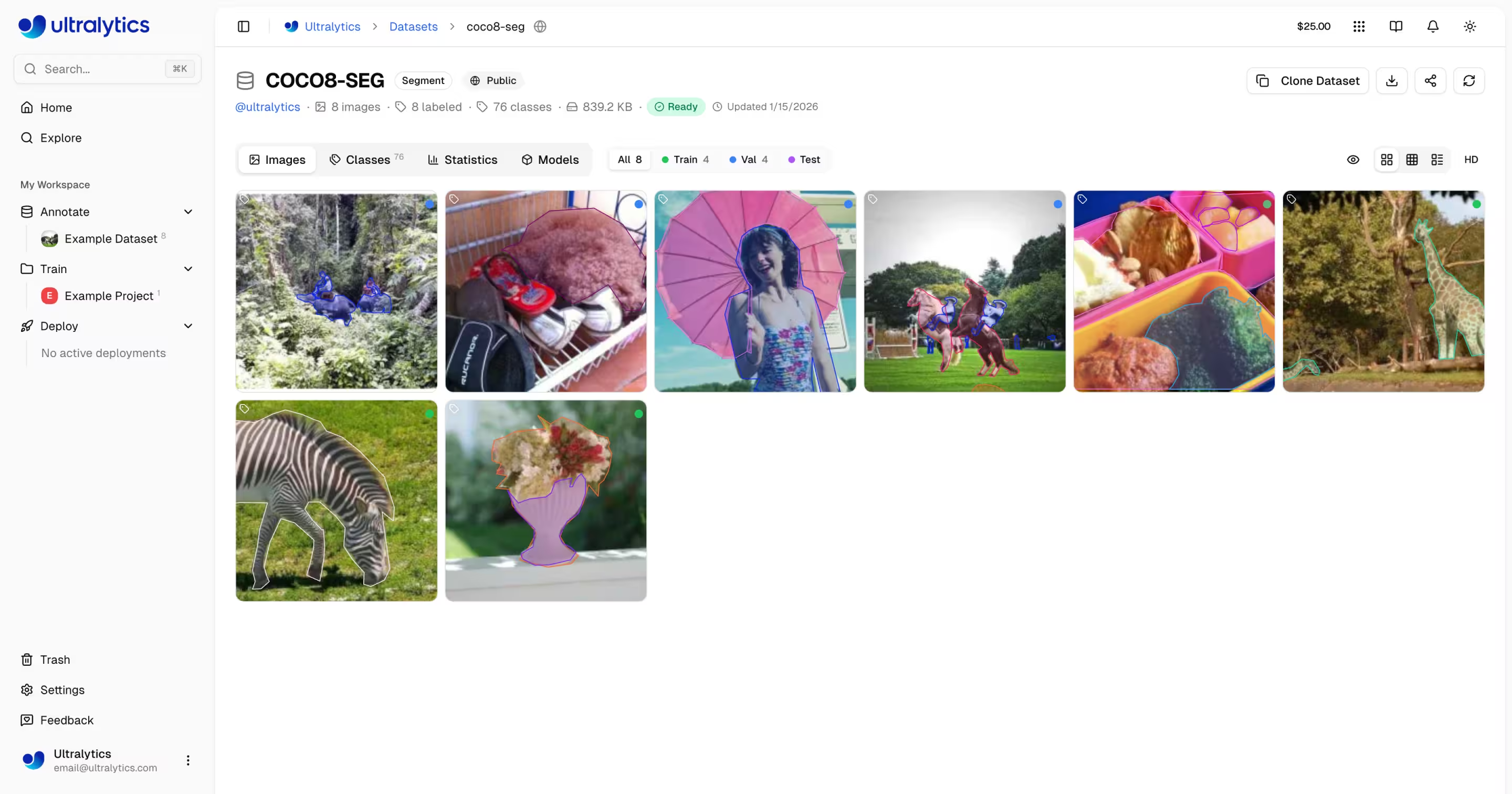

- Gestion des jeux de données : Téléchargez des images, des vidéos ou des archives ZIP avec traitement automatique

- Éditeur d'annotation : Annotation manuelle pour les 5 types de tâches YOLO (detect, segment, pose, obb, classify)

- Annotation intelligente SAM : Annotation intelligente basée sur le clic utilisant le modèle Segment Anything

- Auto-annotation : Utilisez des modèles entraînés pour pré-étiqueter de nouvelles données

- Statistiques : Distribution des classes, cartes thermiques de localisation et analyse dimensionnelle

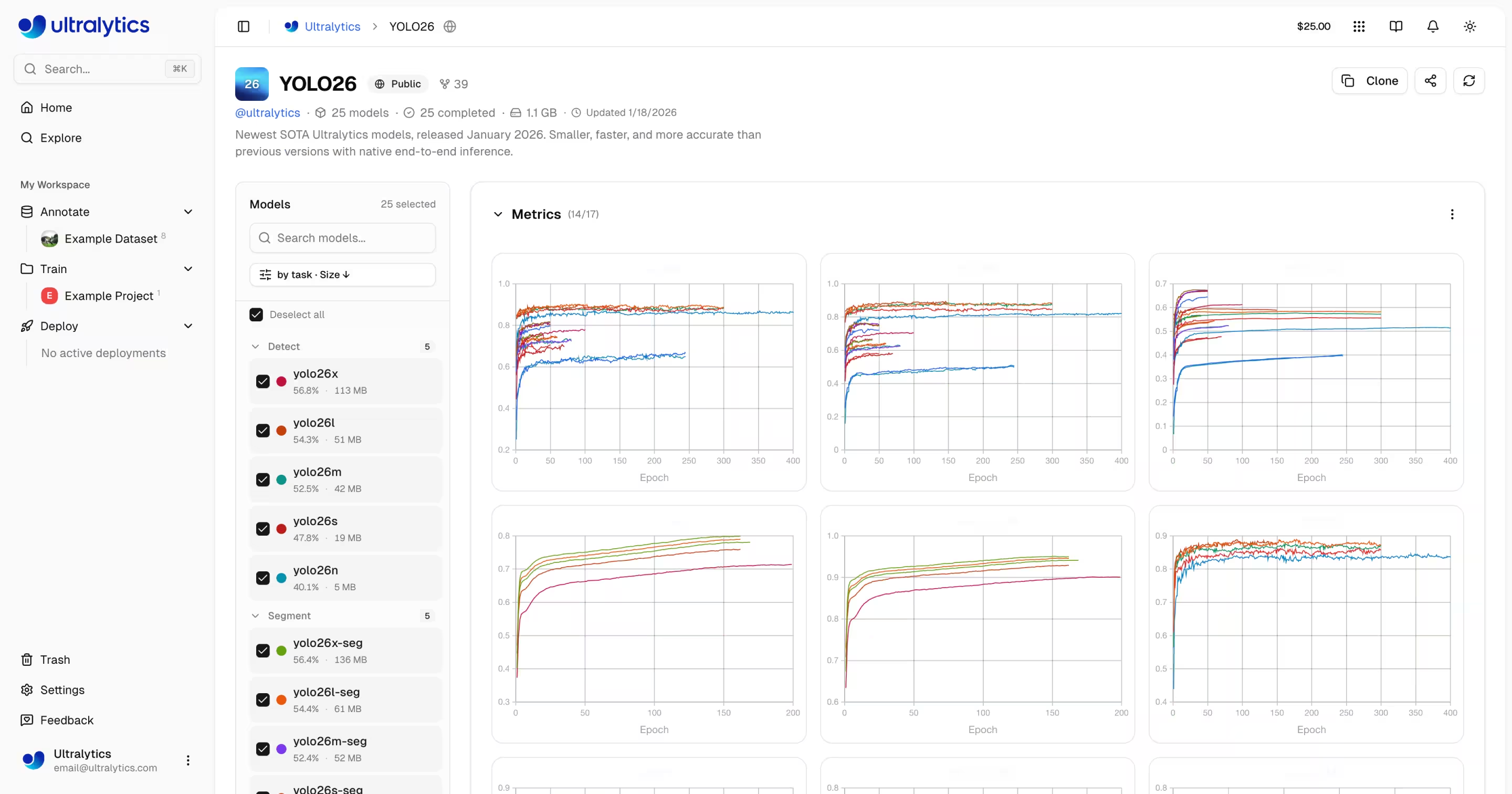

Entraînement de modèles

- Entraînement dans le cloud : Entraînez-vous sur des GPU cloud (RTX 4090, A100, H100) avec des métriques en temps réel

- Entraînement à distance : Entraînez-vous n'importe où et diffusez les métriques vers la Plateforme (style W&B)

- Organisation de projet : Regroupez les modèles associés, comparez les expériences, suivez l'activité

- 17 formats d'exportation : ONNX, TensorRT, CoreML, TFLite, et plus encore

Déploiement

- Test d'inférence : Testez les modèles directement dans le navigateur avec des images personnalisées

- Points de terminaison dédiés : Déployez dans 43 régions mondiales avec mise à l'échelle automatique

- Surveillance : Métriques en temps réel, journaux de requêtes et tableaux de bord de performance

Gestion du compte

- Clés API : Gestion sécurisée des clés pour l'entraînement à distance et l'accès à l'API

- Crédits et Facturation : Entraînement à la consommation avec une tarification transparente

- Flux d'activité: suivez tous les événements et toutes les actions liés au compte.

- Suppression et restauration: suppression temporaire pendant 30 jours avec possibilité de récupération des éléments

- Conformité RGPD : Exportation des données et suppression de compte

Liens rapides

Démarrez avec ces ressources :

- Démarrage rapide : Créez votre premier projet et entraînez un modèle en quelques minutes

- Jeux de données : Téléchargez et gérez vos données d'entraînement

- Annotation : Étiquetez vos données avec des outils manuels et assistés par l'IA

- Projets : Organisez vos modèles et expériences

- Entraînement dans le cloud : Entraînez-vous sur des GPU cloud

- Inférence : Testez vos modèles

- Endpoints : Déployez des modèles en production

- Surveillance : Suivez les performances de déploiement

- Clés API : Gérez l'accès à l'API

- Facturation : Crédits et paiement

- Activité: Suivre les événements liés au compte

- Corbeille: Récupérer les éléments supprimés

- REST API : Référence de l'API

FAQ

Comment démarrer avec la plateforme Ultralytics ?

Pour démarrer avec la Plateforme Ultralytics :

- Inscription : Créez un compte sur platform.ultralytics.com

- Sélectionnez la région : Choisissez votre région de données (US, EU ou AP) lors de l'intégration

- Téléchargez le jeu de données : Accédez à la section Jeux de données pour télécharger vos données

- Entraînez le modèle : Créez un projet et commencez l'entraînement sur des GPU cloud

- Déployez : Testez votre modèle et déployez-le sur un endpoint dédié

Pour un guide détaillé, consultez la page Démarrage rapide.

Quels sont les avantages de la plateforme Ultralytics ?

La Plateforme Ultralytics offre :

- Flux de travail unifié : Données, entraînement et déploiement en un seul endroit

- Multi-régions: Résidence des données dans les régions US, UE ou AP

- Entraînement sans code: Entraînez des modèles YOLO avancés sans écrire de code

- Métriques en temps réel: Suivez la progression de l'entraînement en continu et surveillez les déploiements

- 43 régions de déploiement: Déployez des modèles à proximité de vos utilisateurs partout dans le monde

- 5 types de tâches: Prise en charge de la detection, la segmentation, l'estimation de pose, l'OBB et la classification

- Annotation assistée par l'IA: SAM et l'auto-étiquetage pour accélérer la préparation des données

Quelles options de GPU sont disponibles pour l'entraînement dans le cloud ?

La plateforme Ultralytics prend en charge plusieurs types de GPU pour l'entraînement dans le cloud :

| Niveau | GPU | VRAM | Coût/Heure | Idéal pour |

|---|---|---|---|---|

| Budget | RTX A2000 | 6 Go | $0.12 | Petits ensembles de données, tests |

| Budget | RTX 3080 | 10 Go | $0.25 | Ensembles de données de taille moyenne |

| Budget | RTX 3080 Ti | 12 Go | $0.30 | Ensembles de données de taille moyenne |

| Budget | A30 | 24 Go | $0.44 | Taille des lots plus importante |

| Milieu | RTX 4090 | 24 Go | $0.60 | Excellent rapport qualité/prix |

| Milieu | A6000 | 48 Go | $0.90 | Grands modèles |

| Milieu | L4 | 24 Go | $0.54 | Inférence optimisée |

| Milieu | L40S | 48 Go | $1.72 | Entraînement par lots volumineux |

| Pro | A100 40 Go | 40 Go | $2.78 | Formation à la production |

| Pro | A100 80 Go | 80 Go | $3.44 | Très grands modèles |

| Pro | H100 | 80 Go | $5.38 | Formation la plus rapide |

| Entreprise | H200 | 141 Go | $5.38 | Performances maximales |

| Entreprise | B200 | 192 Go | $10.38 | Modèles les plus grands |

| Ultralytics | RTX PRO 6000 | 48 Go | $3.68 | Ultralytics |

Consultez la formation Cloud pour connaître les tarifs complets et GPU .

Comment fonctionne l'entraînement à distance ?

Vous pouvez entraîner des modèles n'importe où et diffuser les métriques vers la plateforme.

Version de package requise

L'intégration à la plateforme nécessite ultralytics>=8.4.0. Les versions antérieures NE fonctionneront PAS avec la plateforme.

pip install "ultralytics>=8.4.0"

# Set your API key

export ULTRALYTICS_API_KEY="your_api_key"

# Train with project/name to stream metrics

yolo train model=yolo26n.pt data=coco.yaml epochs=100 project=username/my-project name=exp1

Consultez Entraînement dans le cloud pour plus de détails sur l'entraînement à distance.

Quels outils d'annotation sont disponibles ?

La plateforme inclut un éditeur d'annotation complet prenant en charge :

- Outils manuels: Boîtes englobantes, polygones, points clés, boîtes orientées, classification

- Annotation intelligente SAM: Cliquez pour générer des masques précis à l'aide du modèle Segment Anything Model

- Auto-annotation YOLO: Utilisez des modèles entraînés pour pré-étiqueter les images

- Raccourcis clavier: Des flux de travail efficaces avec des raccourcis

Consultez Annotation pour le guide complet.

Dépannage

Problèmes liés aux ensembles de données

| Problème | Solution |

|---|---|

| Le jeu de données ne sera pas traité. | Vérifiez que le format de fichier est pris en charge (JPEG, PNG, WebP, etc.). Taille maximale des fichiers : images 50 Mo, vidéos 1 Go, ZIP 50 Go |

| Annotations manquantes | Vérifiez que les étiquettes sont au YOLO avec .txt fichiers correspondant aux noms de fichiers image |

| « Séparation du train requise » | Ajouter train/ dossier à la structure de votre ensemble de données, ou créez des divisions dans les paramètres de l'ensemble de données |

| Noms de classe non définis | Ajouter un data.yaml dossier avec names: liste, ou définir des classes dans les paramètres du jeu de données |

Problèmes liés à la formation

| Problème | Solution |

|---|---|

| La formation ne commencera pas | Vérifiez le solde de votre crédit dans Paramètres > Facturation. Montant minimum requis : 5,00 $. |

| Erreur de mémoire insuffisante | Réduisez la taille des lots, utilisez un modèle plus petit (n/s) ou sélectionnez GPU plus de VRAM. |

| Mauvais indicateurs | Vérifier la qualité des ensembles de données, augmenter le nombre d'époques, essayer l'augmentation des données, vérifier l'équilibre des classes. |

| Entraînement lent | Sélectionnez GPU plus rapide, réduisez la taille de l'image, vérifiez que l'ensemble de données n'est pas goulot d'étranglement. |

Problèmes de déploiement

| Problème | Solution |

|---|---|

| Terminal ne répondant pas | Vérifiez l'état du point de terminaison (en cours d'exécution ou arrêté). Le démarrage à froid peut prendre 2 à 5 secondes. |

| 401 Non autorisé | Vérifiez que la clé API est correcte et dispose des champs d'application requis. |

| Inférence lente | Vérifiez la taille du modèle, envisagez TensorRT , sélectionnez une région plus proche. |

| Échec de l'exportation | Certains formats nécessitent des architectures de modèle spécifiques. Essayez ONNX une compatibilité optimale. |

Questions fréquentes

Puis-je modifier mon nom d'utilisateur après mon inscription ?

Non, les noms d'utilisateur sont permanents et ne peuvent pas être modifiés. Choisissez-le avec soin lors de votre inscription.

Puis-je modifier ma région de données ?

Non, la région de données est sélectionnée lors de l'inscription et ne peut pas être modifiée. Pour changer de région, créez un nouveau compte et téléchargez à nouveau vos données.

Comment obtenir plus de crédits ?

Allez dans Paramètres > Facturation > Ajouter des crédits. Achetez des crédits d'une valeur comprise entre 5 $ et 1 000 $. Les crédits achetés n'expirent jamais.

Que se passe-t-il si l'entraînement échoue ?

Vous n'êtes facturé que pour le temps de calcul effectif. Les points de contrôle sont enregistrés et vous pouvez reprendre la formation.

Puis-je télécharger mon modèle entraîné ?

Oui, cliquez sur l'icône de téléchargement sur n'importe quelle page de modèle pour télécharger le .pt fichier ou formats exportés.

Comment puis-je partager mon travail publiquement ?

Modifiez les paramètres de votre projet ou de votre ensemble de données et activez la visibilité « Public ». Le contenu public apparaît sur la page Explorer.

Quelles sont les limites de taille des fichiers ?

Images : 50 Mo, vidéos : 1 Go, archives ZIP : 50 Go. Pour les fichiers plus volumineux, divisez-les en plusieurs téléchargements.

Combien de temps les éléments supprimés sont-ils conservés dans la corbeille ?

30 jours. Passé ce délai, les éléments sont définitivement supprimés et ne peuvent plus être récupérés.

Puis-je utiliser les modèles Platform à des fins commerciales ?

Les plans Free et Pro utilisent la licence AGPL. Pour une utilisation commerciale sans les exigences AGPL, contactezultralytics pour obtenir une licence Enterprise.