YOLOE : Voir n'importe quoi en temps réel

Introduction

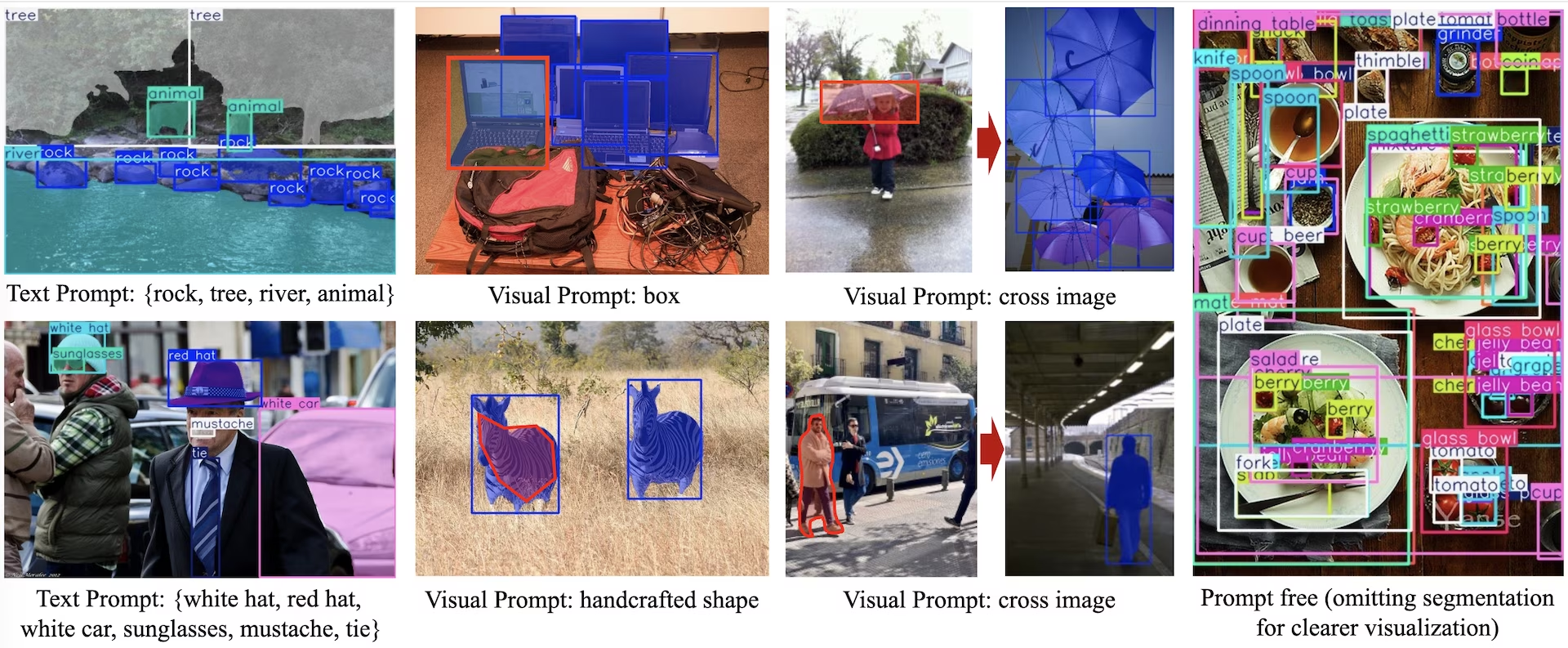

YOLOE (Real-Time Seeing Anything) est une nouvelle avancée dans les modèles YOLO à amorçage zéro et incitables, conçus pour la détection et la segmentation à vocabulaire ouvert. Contrairement aux modèles YOLO précédents limités à des catégories fixes, YOLOE utilise des invites de texte, d'image ou de vocabulaire interne, ce qui permet la détection en temps réel de n'importe quelle classe d'objets. Construit sur YOLOv10 et inspiré de YOLO-World, YOLOE atteint des performances de pointe à amorçage zéro avec un impact minimal sur la vitesse et la précision.

Regarder : Comment utiliser YOLOE avec le package python Ultralytics : vocabulaire ouvert et voir tout en temps réel 🚀

Comparé aux modèles YOLO antérieurs, YOLOE améliore considérablement l'efficacité et la précision. Il s'améliore de +3.5 AP par rapport à YOLO-Worldv2 sur LVIS tout en utilisant seulement un tiers des ressources de formation et en atteignant des vitesses d'inférence 1,4 fois plus rapides. Ajusté avec précision sur COCO, YOLOE-v8-large surpasse YOLOv8-L de 0.1 mAP, en utilisant près de 4 fois moins de temps de formation. Cela démontre l'équilibre exceptionnel de YOLOE en termes de précision, d'efficacité et de polyvalence. Les sections ci-dessous explorent l'architecture de YOLOE, les comparaisons de benchmarks et l'intégration avec le framework Ultralytics.

Aperçu de l'architecture

YOLOE conserve la structure YOLO standard—un backbone convolutionnel (par exemple, CSP-Darknet) pour l'extraction de caractéristiques, un neck (par exemple, PAN-FPN) pour la fusion multi-échelle, et une tête de détection sans ancrage et découplée (comme dans YOLOv8/YOLO11) prédisant l'objectivité, les classes et les boîtes indépendamment. YOLOE introduit trois nouveaux modules permettant la détection à vocabulaire ouvert :

Alignement région-texte reparamétrable (RepRTA): Prend en charge la détection basée sur des invites textuelles en affinant les intégrations de texte (par exemple, à partir de CLIP) via un petit réseau auxiliaire. Lors de l'inférence, ce réseau est intégré au modèle principal, ce qui garantit une surcharge nulle. YOLOE détecte ainsi les objets arbitraires étiquetés par du texte (par exemple, un « feu de circulation » invisible) sans pénalité d'exécution.

Encodeur d'invite visuelle à activation sémantique (SAVPE) : Permet la détection à invite visuelle via une branche d'intégration légère. Étant donné une image de référence, SAVPE encode les caractéristiques sémantiques et d'activation, conditionnant le modèle pour qu'il detect des objets visuellement similaires, une capacité de détection unique utile pour les logos ou des parties spécifiques.

Contraste de région-prompt paresseux (LRPC) : En mode sans prompt, YOLOE effectue une reconnaissance d’ensemble ouvert à l’aide d’intégrations internes entraînées sur de grands vocabulaires (plus de 1 200 catégories de LVIS et Objects365). Sans invites ni encodeurs externes, YOLOE identifie les objets via la recherche de similarité d’intégration, gérant efficacement de grands espaces d’étiquettes lors de l’inférence.

De plus, YOLOE intègre la segmentation d'instance en temps réel en étendant la tête de détection avec une branche de prédiction de masque (similaire à YOLACT ou YOLOv8-Seg), ce qui ajoute une surcharge minimale.

Surtout, les modules open-world de YOLOE n'introduisent aucun coût d'inférence lorsqu'ils sont utilisés comme un YOLO à ensemble fermé régulier. Après l'entraînement, les paramètres YOLOE peuvent être reparamétrés dans un head YOLO standard, préservant des FLOPs et une vitesse identiques (par exemple, correspondant exactement à YOLO11).

Modèles disponibles, tâches prises en charge et modes de fonctionnement

Cette section détaille les modèles disponibles avec leurs poids pré-entraînés spécifiques, les tâches qu'ils prennent en charge et leur compatibilité avec différents modes de fonctionnement tels que l'Inférence, la Validation, l'Entraînement et l'Exportation, indiqués par ✅ pour les modes pris en charge et ❌ pour les modes non pris en charge.

Modèles d'invite texte/visuelle

| Type de modèle | Poids pré-entraînés | Tâches prises en charge | Inférence | Validation | Entraînement | Exporter |

|---|---|---|---|---|---|---|

| YOLOE-11S | yoloe-11s-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11M | yoloe-11m-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11L | yoloe-11l-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8S | yoloe-v8s-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8M | yoloe-v8m-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8L | yoloe-v8l-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26N | yoloe-26n-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26S | yoloe-26s-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26M | yoloe-26m-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26L | yoloe-26l-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26X | yoloe-26x-seg.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

Modèles sans invite

| Type de modèle | Poids pré-entraînés | Tâches prises en charge | Inférence | Validation | Entraînement | Exporter |

|---|---|---|---|---|---|---|

| YOLOE-11S-PF | yoloe-11s-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11M-PF | yoloe-11m-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-11L-PF | yoloe-11l-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8S-PF | yoloe-v8s-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8M-PF | yoloe-v8m-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-v8L-PF | yoloe-v8l-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26N-PF | yoloe-26n-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26S-PF | yoloe-26s-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26M-PF | yoloe-26m-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26L-PF | yoloe-26l-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

| YOLOE-26X-PF | yoloe-26x-seg-pf.pt | Segmentation d'instance | ✅ | ✅ | ✅ | ✅ |

Performances de YOLOE-26

Pour des benchmarks de performance détaillés des modèles YOLOE-26, consultez la documentation YOLO26.

Exemples d'utilisation

Les modèles YOLOE sont faciles à intégrer dans vos applications python. Ultralytics fournit une API python et des commandes CLI conviviales pour rationaliser le développement.

Utilisation de l'entraînement

Finetuning sur un jeu de données personnalisé

Vous pouvez affiner n'importe quel modèle YOLOE pré-entraîné sur votre ensemble de données YOLO personnalisé pour les tâches de détection et de segmentation d'instances.

Regarder : Comment entraîner YOLOE sur un ensemble de données de segmentation de pièces automobiles | Modèle à vocabulaire ouvert, prédiction et exportation 🚀

Exemple

Segmentation d'instance

L'affinage d'un point de contrôle YOLOE pré-entraîné suit principalement la procédure d'entraînement YOLO standard. La principale différence est de passer explicitement YOLOEPESegTrainer comme trainer paramètre à model.train():

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPESegTrainer

model = YOLOE("yoloe-26s-seg.pt")

# Fine-tune on your segmentation dataset

results = model.train(

data="coco128-seg.yaml", # Segmentation dataset

epochs=80,

patience=10,

trainer=YOLOEPESegTrainer, # <- Important: use segmentation trainer

)

Détection d'objets

Tous les modèles YOLOE pré-entraînés effectuent la segmentation d'instance par défaut. Pour utiliser ces points de contrôle pré-entraînés pour entraîner un modèle de détection, initialisez un modèle de détection à partir de zéro en utilisant la configuration YAML, puis chargez le point de contrôle de segmentation pré-entraîné de la même échelle. Notez que nous utilisons YOLOEPETrainer au lieu de YOLOEPESegTrainer puisque nous entraînons un modèle de détection :

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPETrainer

# Initialize a detection model from a config

model = YOLOE("yoloe-26s.yaml")

# Load weights from a pretrained segmentation checkpoint (same scale)

model.load("yoloe-26s-seg.pt")

# Fine-tune on your detection dataset

results = model.train(

data="coco128.yaml", # Detection dataset

epochs=80,

patience=10,

trainer=YOLOEPETrainer, # <- Important: use detection trainer

)

Le probing linéaire affine uniquement la branche de classification tout en gelant le reste du modèle. Cette approche est utile lorsque vous travaillez avec des données limitées, car elle empêche le surapprentissage en exploitant les caractéristiques apprises précédemment tout en adaptant uniquement l'en-tête de classification.

Segmentation d'instance

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPESegTrainer

# Load a pretrained segmentation model

model = YOLOE("yoloe-26s-seg.pt")

# Identify the head layer index

head_index = len(model.model.model) - 1

# Freeze all backbone and neck layers (i.e., everything before the head)

freeze = [str(i) for i in range(0, head_index)]

# Freeze parts of the segmentation head, keeping only the classification branch trainable

for name, child in model.model.model[-1].named_children():

if "cv3" not in name:

freeze.append(f"{head_index}.{name}")

# Freeze detection branch components

freeze.extend(

[

f"{head_index}.cv3.0.0",

f"{head_index}.cv3.0.1",

f"{head_index}.cv3.1.0",

f"{head_index}.cv3.1.1",

f"{head_index}.cv3.2.0",

f"{head_index}.cv3.2.1",

]

)

# Train only the classification branch

results = model.train(

data="coco128-seg.yaml", # Segmentation dataset

epochs=80,

patience=10,

trainer=YOLOEPESegTrainer, # <- Important: use segmentation trainer

freeze=freeze,

)

Détection d'objets

Pour la tâche de détection d'objets, le processus d'entraînement est presque le même que l'exemple de segmentation d'instance ci-dessus, mais nous utilisons YOLOEPETrainer au lieu de YOLOEPESegTrainer, et initialisons le modèle de détection d'objets en utilisant le YAML, puis chargeons les poids à partir du point de contrôle de segmentation d'instance pré-entraîné.

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEPETrainer

# Initialize a detection model from a config

model = YOLOE("yoloe-26s.yaml")

# Load weights from a pretrained segmentation checkpoint (same scale)

model.load("yoloe-26s-seg.pt")

# Identify the head layer index

head_index = len(model.model.model) - 1

# Freeze all backbone and neck layers (i.e., everything before the head)

freeze = [str(i) for i in range(0, head_index)]

# Freeze parts of the segmentation head, keeping only the classification branch trainable

for name, child in model.model.model[-1].named_children():

if "cv3" not in name:

freeze.append(f"{head_index}.{name}")

# Freeze detection branch components

freeze.extend(

[

f"{head_index}.cv3.0.0",

f"{head_index}.cv3.0.1",

f"{head_index}.cv3.1.0",

f"{head_index}.cv3.1.1",

f"{head_index}.cv3.2.0",

f"{head_index}.cv3.2.1",

]

)

# Train only the classification branch

results = model.train(

data="coco128.yaml", # Detection dataset

epochs=80,

patience=10,

trainer=YOLOEPETrainer, # <- Important: use detection trainer

freeze=freeze,

)

Utilisation de la prédiction

YOLOE prend en charge les invites textuelles et visuelles. L'utilisation des invites est simple : il suffit de les transmettre via le predict méthode comme indiqué ci-dessous :

Exemple

Les invites textuelles vous permettent de spécifier les classes que vous souhaitez detecter grâce à des descriptions textuelles. Le code suivant montre comment vous pouvez utiliser YOLOE pour detecter des personnes et des bus dans une image :

from ultralytics import YOLOE

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Les invites visuelles vous permettent de guider le modèle en lui montrant des exemples visuels des classes cibles, plutôt qu'en les décrivant par du texte.

L'argument visual_prompts argument prend un dictionnaire avec deux clés: bboxes et cls. Chaque boîte englobante dans bboxes doit enfermer étroitement un exemple de l'objet que vous voulez que le modèle detect, et l'entrée correspondante dans cls spécifie l'étiquette de classe pour cette boîte. Ce jumelage indique au modèle : « Voici à quoi ressemble la classe X : trouvez-en d'autres comme elle. »

ID de classe (cls) dans visual_prompts sont utilisés pour associer chaque bounding box à une catégorie spécifique dans votre prompt. Ce ne sont pas des étiquettes fixes, mais des identifiants temporaires que vous attribuez à chaque exemple. La seule exigence est que les ID de classe doivent être séquentiels, en commençant par 0. Cela aide le modèle à associer correctement chaque boîte à sa classe respective.

Vous pouvez fournir des invites visuelles directement dans la même image sur laquelle vous souhaitez exécuter l’inférence. Par exemple :

import numpy as np

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

Vous pouvez également fournir des exemples à partir d'une image de référence distincte en utilisant le refer_image argument. Dans ce cas, le bboxes et cls dans visual_prompts doit décrire les objets dans l'image de référence, et non l'image cible sur laquelle vous effectuez des prédictions :

Remarque

Si source est une vidéo ou un flux, le modèle utilise automatiquement la première image comme refer_image. Cela signifie que votre visual_prompts sont appliqués à cette image initiale pour aider le modèle à comprendre ce qu'il doit rechercher dans le reste de la vidéo. Alternativement, vous pouvez explicitement passer n'importe quelle image spécifique comme le refer_image pour contrôler quels exemples visuels le modèle utilise comme référence.

import numpy as np

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt")

# Define visual prompts based on a separate reference image

visual_prompts = dict(

bboxes=np.array([[221.52, 405.8, 344.98, 857.54]]), # Box enclosing person

cls=np.array([0]), # ID to be assigned for person

)

# Run prediction on a different image, using reference image to guide what to look for

results = model.predict(

"ultralytics/assets/zidane.jpg", # Target image for detection

refer_image="ultralytics/assets/bus.jpg", # Reference image used to get visual prompts

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

L'utilisation de refer_image définit également les classes de manière permanente, de sorte que vous pouvez exécuter des prédictions sans avoir à fournir à nouveau les mêmes invites visuelles, et exporter le modèle tout en conservant la possibilité de détecter les mêmes classes après l'exportation :

# After making prediction with `refer_image`, you can run predictions without passing visual_prompts again and still get the same classes back

results = model("ultralytics/assets/bus.jpg")

# Or export it to a different format while retaining the classes

model.export(format="onnx")

Vous pouvez également transmettre plusieurs images cibles pour exécuter la prédiction :

import numpy as np

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=[

np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

np.array([[150, 200, 1150, 700]]),

],

cls=[

np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

np.array([0]),

],

)

# Run inference on multiple images, using the provided visual prompts as guidance

results = model.predict(

["ultralytics/assets/bus.jpg", "ultralytics/assets/zidane.jpg"],

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

YOLOE inclut également des variantes sans invite, dotées d'un vocabulaire intégré. Ces modèles ne nécessitent aucune invite et fonctionnent comme les modèles YOLO traditionnels. Au lieu de s'appuyer sur des étiquettes fournies par l'utilisateur ou des exemples visuels, ils detect des objets à partir d'une liste prédéfinie de 4 585 classes basée sur l'ensemble de balises utilisé par le Recognize Anything Model Plus (RAM++).

from ultralytics import YOLOE

# Initialize a YOLOE model

model = YOLOE("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Utilisation de Val

La validation du modèle sur un ensemble de données est simplifiée comme suit :

Exemple

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or yoloe-26s/m-seg.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml")

Par défaut, il utilise l'ensemble de données fourni pour extraire les intégrations visuelles pour chaque catégorie.

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or yoloe-26s/m-seg.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml", load_vp=True)

Alternativement, nous pourrions utiliser un autre jeu de données comme jeu de données de référence pour extraire les embeddings visuels pour chaque catégorie. Notez que ce jeu de données de référence doit avoir exactement les mêmes catégories que le jeu de données fourni.

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml", load_vp=True, refer_data="coco.yaml")

from ultralytics import YOLOE

# Create a YOLOE model

model = YOLOE("yoloe-26l-seg-pf.pt") # or yoloe-26s/m-seg-pf.pt for different sizes

# Conduct model validation on the COCO128-seg example dataset

metrics = model.val(data="coco128-seg.yaml", single_cls=True)

Utilisation de l'exportation

Le processus d'exportation est similaire à celui des autres modèles YOLO, avec la flexibilité supplémentaire de gérer les invites textuelles et visuelles :

Exemple

from ultralytics import YOLOE

# Select yoloe-26s/m-seg.pt for different sizes

model = YOLOE("yoloe-26l-seg.pt")

# Configure the set_classes() before exporting the model

model.set_classes(["person", "bus"])

export_model = model.export(format="onnx")

model = YOLOE(export_model)

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

Entraîner des modèles officiels

Préparer les jeux de données

Remarque

L'entraînement des modèles YOLOE officiels nécessite des annotations de segment pour les données d'entraînement, voici le script fourni par l'équipe officielle qui convertit les ensembles de données en annotations de segment, alimenté par Modèles SAM2.1. Ou vous pouvez télécharger directement le Processed Segment Annotations dans le tableau suivant fourni par l'équipe officielle.

- Données d'entraînement

| Ensemble de données | Type | Échantillons | Boîtes | Annotations de détection brutes | Annotations de segments traitées |

|---|---|---|---|---|---|

| Objects365v1 | Détection | 609k | 9621k | objects365_train.json | objects365_train_segm.json |

| GQA | Ancrage sémantique | 621k | 3681k | final_mixed_train_no_coco.json | final_mixed_train_no_coco_segm.json |

| Flickr30k | Ancrage sémantique | 149k | 641k | final_flickr_separateGT_train.json | final_flickr_separateGT_train_segm.json |

- Données Val

| Ensemble de données | Type | Fichiers d'annotations |

|---|---|---|

| LVIS minival | Détection | minival.txt |

Lancement de l'entraînement à partir de zéro

Remarque

Visual Prompt les modèles sont affinés sur la base de modèles bien entraînés Text Prompt modèles.

Exemple

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOESegTrainerFromScratch

# Option 1: Use Python dictionary

data = dict(

train=dict(

yolo_data=["Objects365.yaml"],

grounding_data=[

dict(

img_path="flickr/full_images/",

json_file="flickr/annotations/final_flickr_separateGT_train_segm.json",

),

dict(

img_path="mixed_grounding/gqa/images",

json_file="mixed_grounding/annotations/final_mixed_train_no_coco_segm.json",

),

],

),

val=dict(yolo_data=["lvis.yaml"]),

)

# Option 2: Use YAML file (yoloe_data.yaml)

# train:

# yolo_data:

# - Objects365.yaml

# grounding_data:

# - img_path: flickr/full_images/

# json_file: flickr/annotations/final_flickr_separateGT_train_segm.json

# - img_path: mixed_grounding/gqa/images

# json_file: mixed_grounding/annotations/final_mixed_train_no_coco_segm.json

# val:

# yolo_data:

# - lvis.yaml

model = YOLOE("yoloe-26l-seg.yaml")

model.train(

data=data, # or data="yoloe_data.yaml" if using YAML file

batch=128,

epochs=30,

close_mosaic=2,

optimizer="AdamW",

lr0=2e-3,

warmup_bias_lr=0.0,

weight_decay=0.025,

momentum=0.9,

workers=4,

trainer=YOLOESegTrainerFromScratch,

device="0,1,2,3,4,5,6,7",

)

Puisque seulement le SAVPE Le module doit être mis à jour pendant la formation.

Convertir le modèle Text-prompt bien formé en modèle de détection et adopter un pipeline de détection avec un coût de formation moindre.

Notez que cette étape est facultative, vous pouvez également commencer directement par la segmentation.

from ultralytics import YOLOE

from ultralytics.utils.patches import torch_load

det_model = YOLOE("yoloe-26l.yaml")

state = torch_load("yoloe-26l-seg.pt")

det_model.load(state["model"])

det_model.save("yoloe-26l-seg-det.pt")

Démarrer l'entraînement :

from ultralytics import YOLOE

from ultralytics.models.yolo.yoloe import YOLOESegVPTrainer

data = dict(

train=dict(

yolo_data=["Objects365.yaml"],

grounding_data=[

dict(

img_path="flickr/full_images/",

json_file="flickr/annotations/final_flickr_separateGT_train_segm.json",

),

dict(

img_path="mixed_grounding/gqa/images",

json_file="mixed_grounding/annotations/final_mixed_train_no_coco_segm.json",

),

],

),

val=dict(yolo_data=["lvis.yaml"]),

)

model = YOLOE("yoloe-26l-seg.pt")

# replace to yoloe-26l-seg-det.pt if converted to detection model

# model = YOLOE("yoloe-26l-seg-det.pt")

# freeze every layer except of the savpe module.

head_index = len(model.model.model) - 1

freeze = list(range(0, head_index))

for name, child in model.model.model[-1].named_children():

if "savpe" not in name:

freeze.append(f"{head_index}.{name}")

model.train(

data=data,

batch=128,

epochs=2,

close_mosaic=2,

optimizer="AdamW",

lr0=16e-3,

warmup_bias_lr=0.0,

weight_decay=0.025,

momentum=0.9,

workers=4,

trainer=YOLOESegVPTrainer, # use YOLOEVPTrainer if converted to detection model

device="0,1,2,3,4,5,6,7",

freeze=freeze,

)

Revenir au modèle de segmentation après l'entraînement. Nécessaire uniquement si vous avez converti le modèle de segmentation en modèle de détection avant l'entraînement.

from copy import deepcopy

from ultralytics import YOLOE

model = YOLOE("yoloe-26l-seg.yaml")

model.load("yoloe-26l-seg.pt")

vp_model = YOLOE("yoloe-11l-vp.pt")

model.model.model[-1].savpe = deepcopy(vp_model.model.model[-1].savpe)

model.eval()

model.save("yoloe-26l-seg.pt")

Tout comme pour l'entraînement avec invites visuelles, pour le modèle sans invite, seule l'intégration d'invites spécialisées doit être mise à jour pendant l'entraînement. Convertissez le modèle d'invites textuelles bien entraîné en modèle de détection et adoptez un pipeline de détection avec un coût d'entraînement moindre. Notez que cette étape est facultative, vous pouvez également commencer directement par la segmentation.

from ultralytics import YOLOE

from ultralytics.utils.patches import torch_load

det_model = YOLOE("yoloe-26l.yaml")

state = torch_load("yoloe-26l-seg.pt")

det_model.load(state["model"])

det_model.save("yoloe-26l-seg-det.pt")

from ultralytics import YOLOE

data = dict(

train=dict(

yolo_data=["Objects365.yaml"],

grounding_data=[

dict(

img_path="flickr/full_images/",

json_file="flickr/annotations/final_flickr_separateGT_train_segm.json",

),

dict(

img_path="mixed_grounding/gqa/images",

json_file="mixed_grounding/annotations/final_mixed_train_no_coco_segm.json",

),

],

),

val=dict(yolo_data=["lvis.yaml"]),

)

model = YOLOE("yoloe-26l-seg.pt")

# replace to yoloe-26l-seg-det.pt if converted to detection model

# model = YOLOE("yoloe-26l-seg-det.pt")

# freeze layers.

head_index = len(model.model.model) - 1

freeze = [str(f) for f in range(0, head_index)]

for name, child in model.model.model[-1].named_children():

if "cv3" not in name:

freeze.append(f"{head_index}.{name}")

freeze.extend(

[

f"{head_index}.cv3.0.0",

f"{head_index}.cv3.0.1",

f"{head_index}.cv3.1.0",

f"{head_index}.cv3.1.1",

f"{head_index}.cv3.2.0",

f"{head_index}.cv3.2.1",

]

)

model.train(

data=data,

batch=128,

epochs=1,

close_mosaic=1,

optimizer="AdamW",

lr0=2e-3,

warmup_bias_lr=0.0,

weight_decay=0.025,

momentum=0.9,

workers=4,

trainer=YOLOEPEFreeTrainer,

device="0,1,2,3,4,5,6,7",

freeze=freeze,

single_cls=True, # this is needed

)

Revenir au modèle de segmentation après l'entraînement. Nécessaire uniquement si vous avez converti le modèle de segmentation en modèle de détection avant l'entraînement.

from copy import deepcopy

from ultralytics import YOLOE

model = YOLOE("yoloe-26l-seg.pt")

model.eval()

pf_model = YOLOE("yoloe-26l-seg-pf.pt")

names = ["object"]

tpe = model.get_text_pe(names)

model.set_classes(names, tpe)

model.model.model[-1].fuse(model.model.pe)

model.model.model[-1].cv3[0][2] = deepcopy(pf_model.model.model[-1].cv3[0][2]).requires_grad_(True)

model.model.model[-1].cv3[1][2] = deepcopy(pf_model.model.model[-1].cv3[1][2]).requires_grad_(True)

model.model.model[-1].cv3[2][2] = deepcopy(pf_model.model.model[-1].cv3[2][2]).requires_grad_(True)

del model.model.pe

model.save("yoloe-26l-seg-pf.pt")

Comparaison des performances de YOLOE

YOLOE égale ou dépasse la précision des modèles YOLO à ensemble fermé sur des benchmarks standards comme COCO et LVIS, sans compromettre la vitesse ou la taille du modèle. Le tableau ci-dessous compare YOLOE-L (basé sur YOLO11) et YOLOE26-L (basé sur YOLO26) aux modèles à ensemble fermé correspondants :

| Modèle | COCO mAP50-95 | mAP LVIS50-95 | Vitesse d'inférence (T4) | Paramètres | GFLOPs (640px) |

|---|---|---|---|---|---|

| YOLOv8-L (ensemble fermé) | 52.9% | - | 9,06 ms (110 FPS) | 43.7 M | 165.2 B |

| YOLO11-L (ensemble fermé) | 53.5% | - | 6,2 ms (161 FPS) | 26.2 M | 86.9 B |

| YOLOE-L (vocabulaire ouvert) | 52.6% | 35.2% | 6,2 ms (161 FPS) | 26.2 M | 86.9 B† |

| YOLOE26-L (vocabulaire ouvert) | - | 36.8% | 6,2 ms (161 FPS) | 32.3 M | 88,3 B† |

†YOLOE-L partage l'architecture de YOLO11-L et YOLOE26-L partage l'architecture de YOLO26-L, ce qui se traduit par une vitesse d'inférence et des GFLOPs similaires.

YOLOE26-L atteint un mAP LVIS de 36,8 % avec 32,3 millions de paramètres et 88,3 milliards de FLOPs, traitant des images de 640×640 à 6,2 ms (161 FPS) sur un GPU T4. Cela représente une amélioration par rapport au mAP LVIS de 35,2 % de YOLOE-L, tout en maintenant la même vitesse d'inférence. Il est crucial de noter que les modules à vocabulaire ouvert de YOLOE n'entraînent aucun coût d'inférence, démontrant une conception sans « compromis de gratuité ».

Pour les tâches zero-shot, YOLOE26 surpasse significativement les détecteurs à vocabulaire ouvert précédents : sur LVIS, YOLOE26-S atteint un mAP de 29,9 %, dépassant YOLO-World-S de +11,4 AP, tandis que YOLOE26-L atteint un mAP de 36,8 %, surpassant YOLO-World-L de +10,0 AP. YOLOE26 maintient une inférence efficace à 161 FPS sur un GPU T4, idéal pour les applications à vocabulaire ouvert en temps réel.

Remarque

Conditions de référence : Les résultats de YOLOE proviennent de modèles pré-entraînés sur Objects365, GoldG et LVIS, puis affinés ou évalués sur COCO. Le léger avantage de YOLOE en termes de mAP par rapport à YOLOv8 provient d'un pré-entraînement extensif. Sans cet entraînement à vocabulaire ouvert, YOLOE égale les modèles YOLO de taille similaire, confirmant sa précision SOTA et sa flexibilité en monde ouvert sans pénalités de performance.

Comparaison avec les modèles précédents

YOLOE introduit des avancées notables par rapport aux modèles YOLO précédents et aux détecteurs à vocabulaire ouvert :

YOLOE vs YOLOv5 :YOLOv5 offrait un bon équilibre vitesse-précision, mais nécessitait un réentraînement pour les nouvelles classes et utilisait des heads basés sur des anchors. En revanche, YOLOE est anchor-free et detect dynamiquement de nouvelles classes. YOLOE, s’appuyant sur les améliorations de YOLOv8, atteint une précision plus élevée (52,6 % vs. environ 50 % de mAP de YOLOv5 sur COCO) et intègre la segmentation d’instance, contrairement à YOLOv5.

YOLOE vs YOLOv8 : YOLOE étend l’architecture repensée de YOLOv8, atteignant une précision similaire ou supérieure (52,6 % de mAP avec environ 26 millions de paramètres vs. 52,9 % avec environ 44 millions de paramètres pour YOLOv8-L). Il réduit considérablement le temps d’entraînement grâce à un pré-entraînement plus robuste. L’avancée clé est la capacité open-world de YOLOE, qui detect des objets invisibles (par exemple, « bird scooter » ou « peace symbol ») via des prompts, contrairement à la conception closed-set de YOLOv8.

YOLOE vs YOLO11 :YOLO11 améliore YOLOv8 avec une efficacité accrue et moins de paramètres (réduction d’environ 22 %). YOLOE hérite directement de ces gains, égalant la vitesse d’inférence et le nombre de paramètres de YOLO11 (environ 26 millions de paramètres), tout en ajoutant la détection et la segmentation open-vocabulary. Dans les scénarios closed-set, YOLOE est équivalent à YOLO11, mais ajoute surtout une adaptabilité pour detect des classes invisibles, atteignant YOLO11 + capacité open-world sans compromettre la vitesse.

YOLOE26 vs YOLOE (basé sur YOLO11) : YOLOE26 s'appuie sur l'architecture de YOLO26, héritant de sa conception de bout en bout sans NMS pour une inférence plus rapide. Sur LVIS, YOLOE26-L atteint un mAP de 36,8 %, améliorant le mAP de 35,2 % de YOLOE-L. YOLOE26 propose les cinq échelles de modèle (N/S/M/L/X) par rapport aux trois de YOLOE (S/M/L), offrant ainsi plus de flexibilité pour différents scénarios de déploiement.

YOLOE26 vs détecteurs à vocabulaire ouvert précédents : Les modèles à vocabulaire ouvert antérieurs (GLIP, OWL-ViT, YOLO-World) reposaient fortement sur des transformers vision-langage, ce qui entraînait une inférence lente. Sur LVIS, YOLOE26-S atteint 29,9 % de mAP (+11,4 AP par rapport à YOLO-World-S) et YOLOE26-L atteint 36,8 % de mAP (+10,0 AP par rapport à YOLO-World-L), tout en maintenant une inférence en temps réel à 161 FPS sur GPU T4. Comparé aux approches basées sur les transformers (par exemple, GLIP), YOLOE26 offre une inférence des ordres de grandeur plus rapide, comblant efficacement l'écart précision-efficacité dans la détection en ensemble ouvert.

En résumé, YOLOE et YOLOE26 maintiennent la vitesse et l'efficacité reconnues de YOLO, surpassent leurs prédécesseurs en précision, intègrent la segmentation et introduisent une puissante détection en monde ouvert. YOLOE26 fait progresser davantage l'architecture avec une inférence de bout en bout sans NMS issue de YOLO26, ce qui le rend idéal pour les applications à vocabulaire ouvert en temps réel.

Cas d'utilisation et applications

La détection et la segmentation à vocabulaire ouvert de YOLOE permettent diverses applications au-delà des modèles traditionnels à classes fixes :

Détection d’objets en monde ouvert : Idéal pour les scénarios dynamiques comme la robotique, où les robots reconnaissent des objets jamais vus auparavant à l’aide d’invites, ou les systèmes de sécurité s’adaptant rapidement aux nouvelles menaces (p. ex., les articles dangereux) sans réentraînement.

Détection Few-Shot et One-Shot : À l’aide d’invites visuelles (SAVPE), YOLOE apprend rapidement de nouveaux objets à partir d’images de référence uniques, ce qui est parfait pour l’inspection industrielle (identification instantanée des pièces ou des défauts) ou la surveillance personnalisée, permettant des recherches visuelles avec une configuration minimale.

Reconnaissance de vocabulaire étendu et de longue traîne : Doté d'un vocabulaire de plus de 1 000 classes, YOLOE excelle dans des tâches telles que la surveillance de la biodiversité (détection d'espèces rares), les collections de musées, l'inventaire de détail ou le commerce électronique, identifiant de manière fiable de nombreuses classes sans formation approfondie par classe.

Détection et segmentation interactives : YOLOE prend en charge les applications interactives en temps réel telles que la recherche de vidéos/images, la réalité augmentée (AR) et l'édition d'images intuitive, pilotées par des entrées naturelles (textes ou invites visuelles). Les utilisateurs peuvent isoler, identifier ou modifier dynamiquement des objets avec précision à l'aide de masques de segmentation.

Étiquetage automatisé des données et amorçage : YOLOE facilite la création rapide d'ensembles de données en fournissant des annotations initiales de boîtes englobantes et de segmentation, réduisant considérablement les efforts d'étiquetage humain. Particulièrement utile dans l'analyse de grandes collections de médias, où il peut auto-identifier les objets présents, aidant à construire des modèles spécialisés plus rapidement.

Segmentation pour tout objet : Étend les capacités de segmentation à des objets arbitraires via des invites—particulièrement bénéfique pour l'imagerie médicale, la microscopie ou l'analyse d'images satellites, identifiant et segmentant précisément les structures automatiquement sans modèles pré-entraînés spécialisés. Contrairement à des modèles comme SAM, YOLOE reconnaît et segmente simultanément les objets automatiquement, facilitant des tâches telles que la création de contenu ou la compréhension de scènes.

Dans tous ces cas d'utilisation, l'avantage principal de YOLOE est sa polyvalence, fournissant un modèle unifié pour la détection, la reconnaissance et la segmentation dans des scénarios dynamiques. Son efficacité assure des performances en temps réel sur les appareils aux ressources limitées, idéal pour la robotique, la conduite autonome, la défense et au-delà.

Astuce

Choisissez le mode de YOLOE en fonction de vos besoins :

- Mode à ensemble fermé : Pour les tâches à classes fixes (vitesse et précision maximales).

- Mode incité : Ajoutez rapidement de nouveaux objets via des invites textuelles ou visuelles.

- Mode open-set sans invite : Détection générale dans de nombreuses catégories (idéal pour le catalogage et la découverte).

Souvent, la combinaison de modes, tels que la découverte sans invite suivie d'invites ciblées, exploite tout le potentiel de YOLOE.

Entraînement et inférence

YOLOE s'intègre de manière transparente avec l'API Python Ultralytics et la CLI, de la même manière que les autres modèles YOLO (YOLOv8, YOLO-World). Voici comment démarrer rapidement :

Entraînement et inférence avec YOLOE

from ultralytics import YOLO

# Load pretrained YOLOE model and train on custom data

model = YOLO("yoloe-26s-seg.pt")

model.train(data="path/to/data.yaml", epochs=50, imgsz=640)

# Run inference using text prompts ("person", "bus")

model.set_classes(["person", "bus"])

results = model.predict(source="test_images/street.jpg")

results[0].save() # save annotated output

Ici, YOLOE se comporte comme un détecteur standard par défaut, mais passe facilement à la détection incitée en spécifiant des classes (set_classes). Les résultats contiennent des boîtes englobantes, des masques et des étiquettes.

# Training YOLOE on custom dataset

yolo train model=yoloe-26s-seg.pt data=path/to/data.yaml epochs=50 imgsz=640

# Inference with text prompts

yolo predict model=yoloe-26s-seg.pt source="test_images/street.jpg" classes="person,bus"

Invites de la CLI (classes) guide YOLOE de la même manière que set_classes. L'invite visuelle (requêtes basées sur des images) nécessite actuellement l'API Python.

Autres tâches prises en charge

- Validation : Évaluez facilement la précision avec

model.val()ouyolo val. - Exporter : Exporter les modèles YOLOE (

model.export()) vers ONNX, TensorRT, etc., facilitant le déploiement. - Suivi : YOLOE prend en charge le suivi d'objets (

yolo track) une fois intégré, utile pour suivre les classes demandées dans les vidéos.

Remarque

YOLOE inclut automatiquement masques de segmentation dans les résultats d'inférence (results[0].masks), simplifiant les tâches de précision au pixel près comme l'extraction ou la mesure d'objets sans avoir besoin de modèles distincts.

Démarrage

Configurez rapidement YOLOE avec Ultralytics en suivant ces étapes:

Installation : Installez ou mettez à jour le package Ultralytics :

pip install -U ultralyticsTélécharger les poids YOLOE: Les modèles YOLOE pré-entraînés (par exemple, YOLOE-v8-S/L, variantes YOLOE-11) sont disponibles dans les versions GitHub de YOLOE. Téléchargez simplement le modèle souhaité

.ptfichier à charger dans la classe Ultralytics YOLO.Configuration matérielle requise :

- Inférence : GPU recommandé (NVIDIA avec ≥4-8 Go de VRAM). Les petits modèles fonctionnent efficacement sur les GPU edge (par exemple, Jetson) ou les CPU à des résolutions inférieures. Pour une inférence haute performance sur des stations de travail compactes, consultez notre guide NVIDIA DGX Spark.

- Entraînement : L'ajustement précis de YOLOE sur des données personnalisées ne nécessite généralement qu'un seul GPU. La pré-formation étendue en vocabulaire ouvert (LVIS/Objects365) utilisée par les auteurs a nécessité une puissance de calcul considérable (8× GPU RTX 4090).

Configuration: Les configurations YOLOE utilisent des fichiers YAML Ultralytics standard. Les configurations par défaut (par exemple,

yoloe-26s-seg.yaml) suffisent généralement, mais vous pouvez modifier le backbone, les classes ou la taille de l'image selon vos besoins.Exécution de YOLOE :

- Inférence rapide (sans invite) :

yolo predict model=yoloe-26s-seg-pf.pt source="image.jpg" Détection incitée (exemple d'invite textuelle) :

from ultralytics import YOLO model = YOLO("yoloe-26s-seg.pt") model.set_classes(["bowl", "apple"]) results = model.predict("kitchen.jpg") results[0].save()

- Inférence rapide (sans invite) :

Conseils d'intégration :

- Noms des classes: Les sorties YOLOE par défaut utilisent les catégories LVIS ; utilisez

set_classes()pour spécifier vos propres étiquettes. - Vitesse : YOLOE n’a pas de surcharge, sauf si vous utilisez des invites. Les invites de texte ont un impact minimal ; les invites visuelles un peu plus.

- NMS: YOLOE utilise automatiquement

agnostic_nms=Truependant la prédiction, fusionner les boîtes qui se chevauchent entre les classes. Cela évite les détections en double lorsque le même objet correspond à plusieurs catégories dans le vaste vocabulaire de YOLOE (plus de 1 200 classes LVIS). Vous pouvez passer outre cette règle en transmettantagnostic_nms=Falseexplicitement. - Inférence par lots: Pris en charge directement (

model.predict([img1, img2])). Pour les invites spécifiques à l'image, exécutez les images individuellement.

- Noms des classes: Les sorties YOLOE par défaut utilisent les catégories LVIS ; utilisez

La documentation Ultralytics fournit des ressources supplémentaires. YOLOE vous permet d'explorer facilement de puissantes capacités open-world au sein de l'écosystème YOLO familier.

Astuce

Conseil de pro : Pour maximiser la précision zéro-shot de YOLOE, affinez à partir des points de contrôle fournis plutôt que d'entraîner à partir de zéro. Utilisez des mots-clés s'alignant sur les étiquettes d'entraînement courantes (voir les catégories LVIS) pour améliorer la précision de la détection.

Citations et remerciements

Si YOLOE a contribué à votre recherche ou projet, veuillez citer l'article original de Ao Wang, Lihao Liu, Hui Chen, Zijia Lin, Jungong Han, et Guiguang Ding de l'Université de Tsinghua :

@misc{wang2025yoloerealtimeseeing,

title={YOLOE: Real-Time Seeing Anything},

author={Ao Wang and Lihao Liu and Hui Chen and Zijia Lin and Jungong Han and Guiguang Ding},

year={2025},

eprint={2503.07465},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2503.07465},

}

Pour approfondir le sujet, l'article original de YOLOE est disponible sur arXiv. Le code source du projet et des ressources supplémentaires sont accessibles via leur dépôt GitHub.

FAQ

En quoi YOLOE diffère-t-il de YOLO-World ?

Bien que YOLOE et YOLO-World permettent tous deux la détection à vocabulaire ouvert, YOLOE offre plusieurs avantages. YOLOE atteint une précision supérieure de +3,5 AP sur LVIS tout en utilisant 3× moins de ressources d'entraînement et en s'exécutant 1,4× plus rapidement que YOLO-Worldv2. YOLOE prend également en charge trois modes d'invite (texte, visuel et vocabulaire interne), tandis que YOLO-World se concentre principalement sur les invites textuelles. De plus, YOLOE inclut des capacités de segmentation d'instances intégrées, fournissant des masques précis au pixel près pour les objets détectés sans surcharge supplémentaire.

Puis-je utiliser YOLOE comme un modèle YOLO standard ?

Oui, YOLOE peut fonctionner exactement comme un modèle YOLO standard sans perte de performance. Lorsqu'il est utilisé en mode ensemble fermé (sans invites), les modules de vocabulaire ouvert de YOLOE sont reparamétrés dans l'en-tête de détection standard, ce qui donne une vitesse et une précision identiques aux modèles YOLO11 équivalents. Cela rend YOLOE extrêmement polyvalent—vous pouvez l'utiliser comme un détecteur traditionnel pour une vitesse maximale, puis passer en mode vocabulaire ouvert uniquement lorsque cela est nécessaire.

Quels types de prompts puis-je utiliser avec YOLOE ?

YOLOE prend en charge trois types d'invites :

- Invites textuelles : Spécifiez les classes d’objets en utilisant le langage naturel (p. ex., « personne », « feu de circulation », « scooter d’oiseau »)

- Invites visuelles : Fournissez des images de référence des objets que vous souhaitez detect

- Vocabulaire interne : Utilisez le vocabulaire intégré de YOLOE de plus de 1 200 catégories sans invites externes

Cette flexibilité vous permet d'adapter YOLOE à divers scénarios sans réentraîner le modèle, ce qui le rend particulièrement utile pour les environnements dynamiques où les exigences de détection changent fréquemment.

Comment YOLOE gère-t-il la segmentation d'instances ?

YOLOE intègre la segmentation d'instance directement dans son architecture en étendant la tête de détection avec une branche de prédiction de masque. Cette approche est similaire à YOLOv8-Seg, mais fonctionne pour toute classe d'objet demandée. Les masques de segmentation sont automatiquement inclus dans les résultats d'inférence et sont accessibles via results[0].masks. Cette approche unifiée élimine le besoin de modèles de détection et de segmentation distincts, rationalisant ainsi les flux de travail pour les applications nécessitant des limites d'objets précises au pixel près.

Comment YOLOE gère-t-il l'inférence avec des invites personnalisées ?

Semblable à YOLO-World, YOLOE prend en charge une stratégie « prompt-then-detect » qui utilise un vocabulaire hors ligne pour améliorer l'efficacité. Les invites personnalisées telles que les légendes ou les catégories d'objets spécifiques sont pré-encodées et stockées sous forme d'intégrations de vocabulaire hors ligne. Cette approche rationalise le processus de détection sans nécessiter de réentraînement. Vous pouvez définir dynamiquement ces invites dans le modèle pour l'adapter à des tâches de détection spécifiques :

from ultralytics import YOLO

# Initialize a YOLOE model

model = YOLO("yoloe-26s-seg.pt")

# Define custom classes

model.set_classes(["person", "bus"])

# Execute prediction on an image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()