Ultralytics Platform

Ultralytics Platform è una piattaforma di visione artificiale end-to-end completa che ottimizza l'intero flusso di lavoro ML, dalla preparazione dei dati alla distribuzione del modello. Progettata per team e individui che necessitano di soluzioni di visione artificiale pronte per la produzione senza la complessità dell'infrastruttura.

Cos'è la piattaforma Ultralytics?

Ultralytics Platform è progettata per sostituire gli strumenti ML frammentati con una soluzione unificata. Combina le capacità di:

- Roboflow - Gestione e annotazione dei dati

- Weights & Biases - track degli esperimenti

- SageMaker - Addestramento su cloud

- HuggingFace - Deployment di modelli

- Arize - Monitoraggio

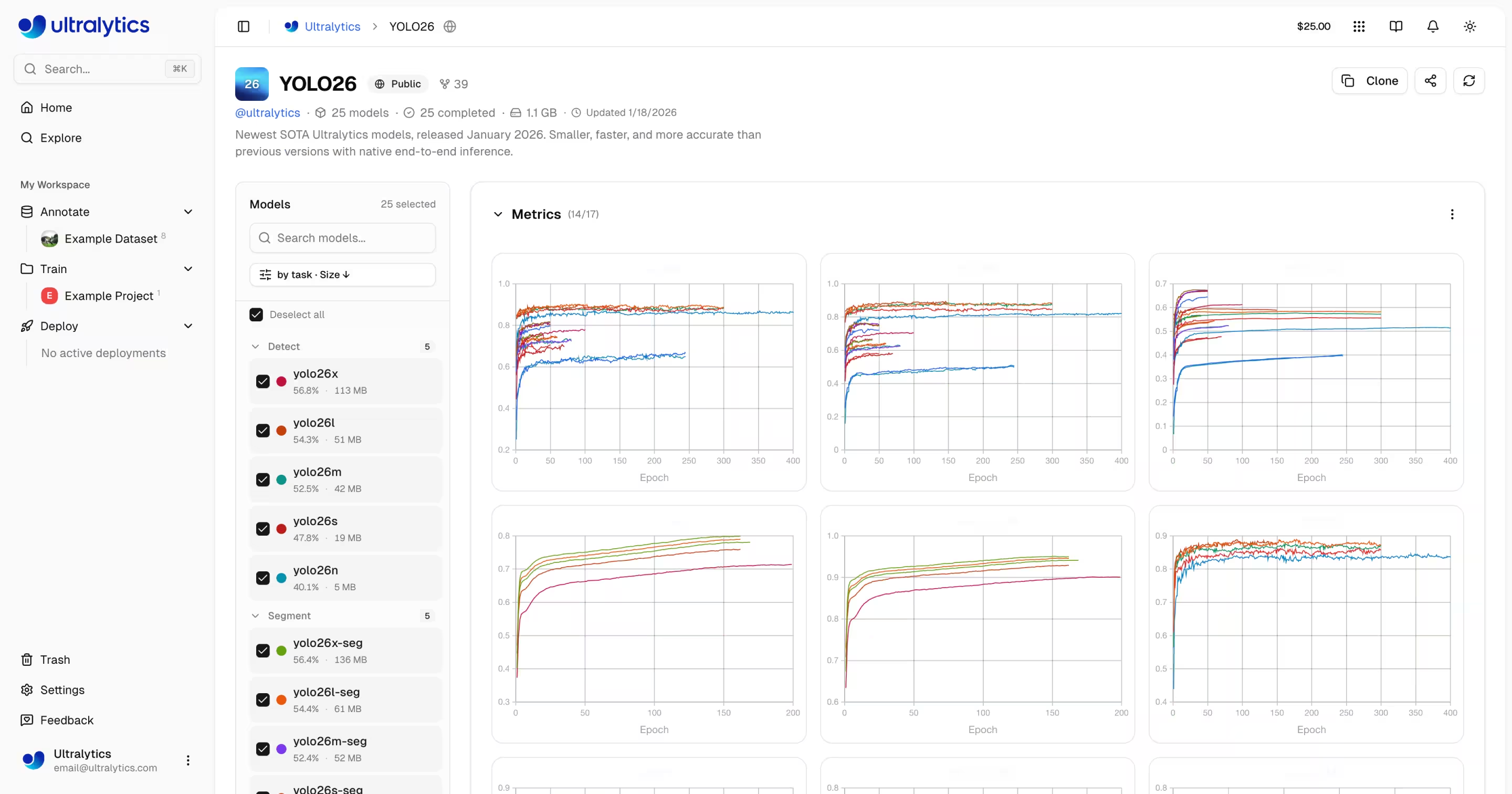

Piattaforma all-in-one con supporto nativo per YOLO11 YOLO26 e YOLO11 .

Flusso di lavoro: Carica → Annota → Addestra → Esporta → Distribuisci

La piattaforma offre un flusso di lavoro end-to-end:

graph LR

subgraph Data["📁 Data"]

A[Upload] --> B[Annotate]

B --> C[Analyze]

end

subgraph Train["🚀 Train"]

D[Configure] --> E[Train on GPU]

E --> F[View Metrics]

end

subgraph Deploy["🌐 Deploy"]

G[Export] --> H[Deploy Endpoint]

H --> I[Monitor]

end

Data --> Train --> Deploy| Fase | Funzionalità |

|---|---|

| Caricamento | Immagini (50 MB), video (1 GB), archivi ZIP (50 GB) con elaborazione automatica |

| Annota | Strumenti manuali, annotazione SAM , YOLO per tutti e 5 i tipi di attività |

| Addestramento | GPU cloud (da RTX 4090 a H200), metriche in tempo reale, organizzazione dei progetti |

| Esportazione | 17 formati di distribuzione (ONNX, TensorRT, CoreML, TFLite, ecc.) |

| Distribuisci | 43 regioni globali con endpoint dedicati, scalabilità automatica, monitoraggio |

Cosa puoi fare:

- Carica immagini, video e archivi ZIP per creare set di dati di addestramento

- Visualizza le annotazioni con sovrapposizioni interattive per tutti e 5 i tipi YOLO

- Addestra i modelli su GPU cloud (da RTX 4090 a H200) con metriche in tempo reale

- Esportazione in 17 formati di distribuzione (ONNX, TensorRT, CoreML, TFLite, ecc.)

- Distribuzione in 43 regioni globali con endpoint dedicati con un solo clic

- Monitorare i progressi della formazione, lo stato di implementazione e le metriche di utilizzo

- Collabora rendendo pubblici i progetti e i set di dati per la comunità

Infrastruttura Multi-Regione

I tuoi dati rimangono nella tua regione. La Piattaforma Ultralytics gestisce l'infrastruttura in tre regioni globali:

| Regione | Località | Ideale per |

|---|---|---|

| USA | Iowa, USA | Utenti delle Americhe, il più veloce per le Americhe |

| UE | Belgio, Europa | Utenti europei, conformità GDPR |

| AP | Taiwan, Asia-Pacifico | Utenti dell'area Asia-Pacifico, latenza APAC più bassa |

Selezioni la tua regione durante l'onboarding, e tutti i tuoi dati, modelli e deployment rimangono in quella regione.

Caratteristiche principali

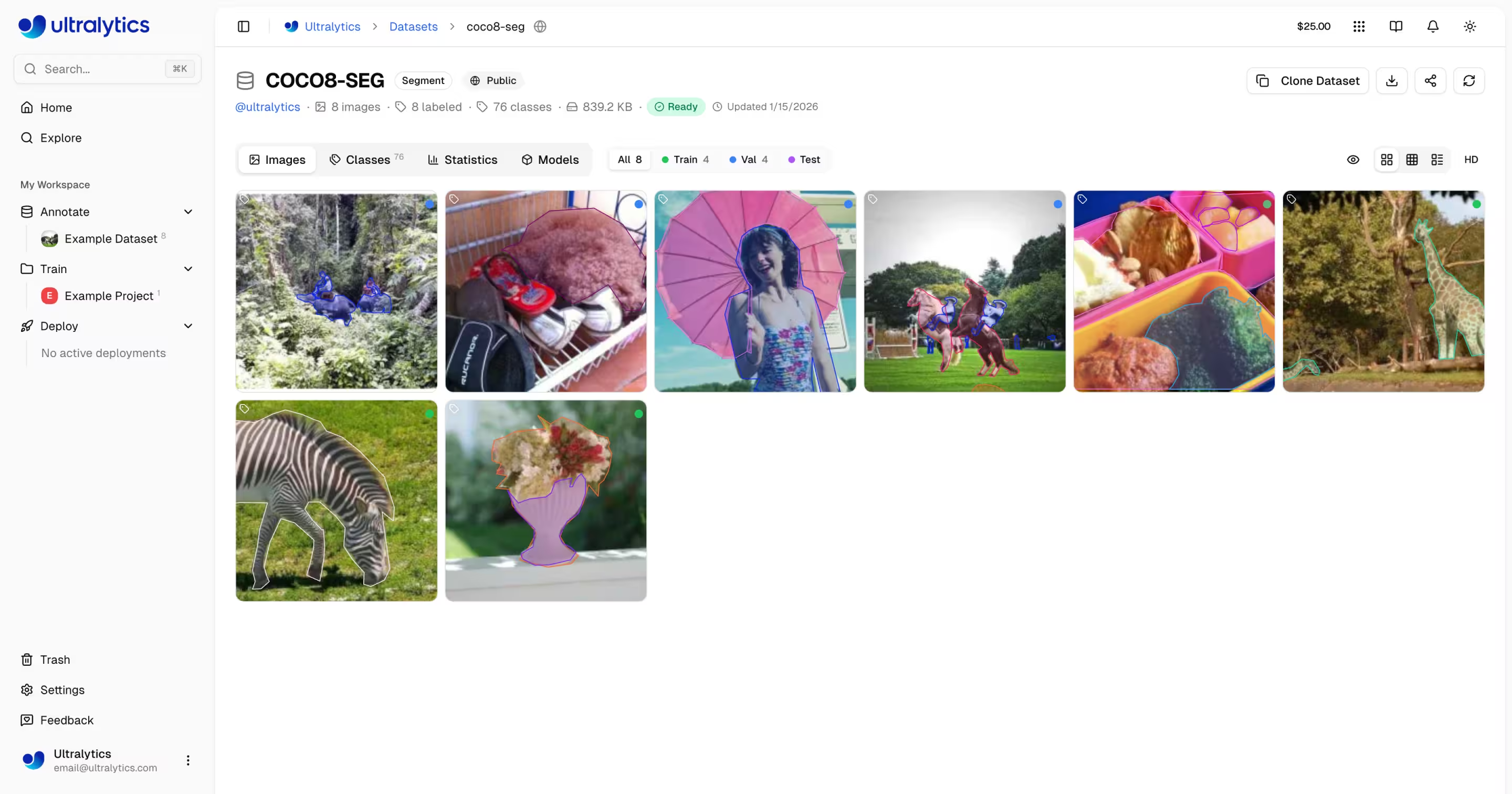

Preparazione dei Dati

- Gestione Dataset: Carica immagini, video o archivi ZIP con elaborazione automatica

- Editor di Annotazioni: Annotazione manuale per tutti i 5 tipi di task YOLO (detect, segment, pose, obb, classify)

- Annotazione Intelligente SAM: Annotazione intelligente basata su clic utilizzando il Segment Anything Model

- Auto-Annotazione: Usa modelli addestrati per pre-etichettare nuovi dati

- Statistiche: Distribuzione delle classi, heatmap di posizione e analisi delle dimensioni

Addestramento del Modello

- Addestramento su Cloud: Addestra su GPU cloud (RTX 4090, A100, H100) con metriche in tempo reale

- Addestramento Remoto: Addestra ovunque e trasmetti le metriche alla Piattaforma (stile W&B)

- Organizzazione dei Progetti: Raggruppare modelli correlati, confrontare esperimenti, monitorare l'attività

- 17 Formati di Esportazione: ONNX, TensorRT, CoreML, TFLite e altro ancora

Distribuzione

- Test di Inferenza: Testare i modelli direttamente nel browser con immagini personalizzate

- Endpoint Dedicati: Distribuire in 43 regioni globali con auto-scaling

- Monitoraggio: Metriche in tempo reale, log delle richieste e dashboard delle prestazioni

Gestione dell'Account

- Chiavi API: Gestione sicura delle chiavi per l'addestramento remoto e l'accesso API

- Crediti e Fatturazione: Addestramento pay-as-you-go con prezzi trasparenti

- Feed attività: tieni traccia di tutti gli eventi e le azioni dell'account

- Cestino e ripristino: eliminazione temporanea per 30 giorni con recupero degli elementi

- Conformità GDPR: Esportazione dei dati ed eliminazione dell'account

Link Rapidi

Inizia con queste risorse:

- Guida Rapida: Crea il tuo primo progetto e addestra un modello in pochi minuti

- Dataset: Carica e gestisci i tuoi dati di addestramento

- Annotazione: Etichetta i tuoi dati con strumenti manuali e assistiti dall'IA

- Progetti: Organizza i tuoi modelli e esperimenti

- Addestramento su Cloud: Addestra su GPU cloud

- Inferenza: Testa i tuoi modelli

- Endpoint: Distribuisci i modelli in produzione

- Monitoraggio: Monitora le prestazioni del deployment

- Chiavi API: Gestisci l'accesso API

- Fatturazione: Crediti e pagamenti

- Attività: Traccia gli eventi dell'account

- Cestino: Recupera gli elementi eliminati

- REST API: Riferimento API

FAQ

Come iniziare con la piattaforma Ultralytics?

Per iniziare con Ultralytics Platform:

- Registrati: Crea un account su platform.ultralytics.com

- Seleziona Regione: Scegli la tua regione dati (USA, UE o AP) durante l'onboarding

- Carica Dataset: Vai alla sezione Dataset per caricare i tuoi dati

- Addestra Modello: Crea un progetto e inizia l'addestramento su GPU cloud

- Deploy: Testa il tuo modello e distribuiscilo su un endpoint dedicato

Per una guida dettagliata, consulta la pagina Quickstart.

Quali sono i vantaggi della piattaforma Ultralytics?

Ultralytics Platform offre:

- Flusso di Lavoro Unificato: Dati, addestramento e deployment in un unico ambiente

- Multi-Regione: Residenza dei dati nelle regioni US, EU o AP

- Addestramento No-Code: Addestra modelli YOLO avanzati senza scrivere codice

- Metriche in Tempo Reale: Trasmetti in streaming l'avanzamento dell'addestramento e monitora i deployment

- 43 Regioni di Deployment: Distribuisci i modelli vicino ai tuoi utenti in tutto il mondo

- 5 Tipi di Task: Supporto per detection, segmentation, stima della posa, OBB e classificazione

- Annotazione Assistita da AI: SAM e auto-etichettatura per accelerare la preparazione dei dati

Quali opzioni GPU sono disponibili per l'addestramento in cloud?

Ultralytics Platform supporta diversi tipi di GPU per l'addestramento in cloud:

| Livello | GPU | VRAM | Costo/Ora | Ideale per |

|---|---|---|---|---|

| Bilancio | RTX A2000 | 6 GB | $0.12 | Piccoli set di dati, test |

| Bilancio | RTX 3080 | 10 GB | $0.25 | Set di dati medi |

| Bilancio | RTX 3080 Ti | 12 GB | $0.30 | Set di dati medi |

| Bilancio | A30 | 24 GB | $0.44 | Lotti di dimensioni maggiori |

| Mezzo | RTX 4090 | 24 GB | $0.60 | Ottimo rapporto qualità/prezzo |

| Mezzo | A6000 | 48 GB | $0.90 | Modelli di grandi dimensioni |

| Mezzo | L4 | 24 GB | $0.54 | Inferenza ottimizzata |

| Mezzo | L40S | 48 GB | $1.72 | Formazione su grandi lotti |

| Pro | A100 40GB | 40 GB | $2.78 | Formazione alla produzione |

| Pro | A100 80GB | 80 GB | $3.44 | Modelli molto grandi |

| Pro | H100 | 80 GB | $5.38 | Allenamento più veloce |

| Enterprise | H200 | 141 GB | $5.38 | Massime prestazioni |

| Enterprise | B200 | 192 GB | $10.38 | Modelli più grandi |

| Ultralytics | RTX PRO 6000 | 48 GB | $3.68 | Ultralytics |

Per informazioni complete sui prezzi e GPU , consultare la sezione Formazione sul cloud.

Come funziona l'addestramento remoto?

Puoi addestrare modelli ovunque e trasmettere le metriche alla Platform.

Requisiti di versione del pacchetto

L'integrazione della Piattaforma richiede Ultralytics>=8.4.0. Versioni precedenti NON funzioneranno con la Piattaforma.

pip install "ultralytics>=8.4.0"

# Set your API key

export ULTRALYTICS_API_KEY="your_api_key"

# Train with project/name to stream metrics

yolo train model=yolo26n.pt data=coco.yaml epochs=100 project=username/my-project name=exp1

Consulta Addestramento in Cloud per maggiori dettagli sull'addestramento remoto.

Quali strumenti di annotazione sono disponibili?

La Piattaforma include un editor di annotazioni completo che supporta:

- Strumenti Manuali: Bounding box, poligoni, punti chiave, bounding box orientate, classificazione

- SAM Smart Annotation: Clicca per generare maschere precise utilizzando il Segment Anything Model

- YOLO Auto-Annotazione: Usa modelli addestrati per pre-etichettare le immagini

- Scorciatoie da Tastiera: Flussi di lavoro efficienti con tasti di scelta rapida

Consulta Annotazione per la guida completa.

Risoluzione dei problemi

Problemi relativi al set di dati

| Problema | Soluzione |

|---|---|

| Il set di dati non verrà elaborato | Verifica che il formato del file sia supportato (JPEG, PNG, WebP, ecc.). Dimensione massima del file: immagini 50 MB, video 1 GB, ZIP 50 GB |

| Annotazioni mancanti | Verifica che le etichette siano in YOLO con .txt file corrispondenti ai nomi dei file immagine |

| "È necessario dividere il treno" | Aggiungere train/ cartella alla struttura del set di dati o creare divisioni nelle impostazioni del set di dati |

| Nomi delle classi non definiti | Aggiungi un data.yaml file con names: elenco, oppure definire classi nelle impostazioni del set di dati |

Questioni relative alla formazione

| Problema | Soluzione |

|---|---|

| La formazione non inizierà | Controlla il saldo del credito in Impostazioni > Fatturazione. È richiesto un minimo di 5,00 $. |

| Errore di memoria insufficiente | Riduci la dimensione del batch, utilizza un modello più piccolo (n/s) o seleziona GPU più VRAM. |

| Metriche inadeguate | Controllare la qualità del set di dati, aumentare il numero di epoche, provare l'aumento dei dati, verificare l'equilibrio delle classi. |

| Addestramento lento | Seleziona GPU più veloce, riduci le dimensioni dell'immagine, verifica che il set di dati non sia congestionato. |

Problemi di implementazione

| Problema | Soluzione |

|---|---|

| Endpoint non risponde | Controllare lo stato dell'endpoint (in esecuzione o arrestato). L'avvio a freddo può richiedere 2-5 secondi. |

| 401 Non autorizzato | Verifica che la chiave API sia corretta e abbia gli ambiti richiesti |

| Inferenza lenta | Controlla le dimensioni del modello, valuta TensorRT , seleziona una regione più vicina |

| Esportazione non riuscita | Alcuni formati richiedono architetture di modelli specifiche. Prova ONNX la massima compatibilità. |

Domande frequenti

Posso cambiare il mio nome utente dopo la registrazione?

No, i nomi utente sono permanenti e non possono essere modificati. Scegli con attenzione durante la registrazione.

Posso cambiare la regione dei miei dati?

No, la regione dei dati viene selezionata durante la registrazione e non può essere modificata. Per cambiare regione, crea un nuovo account e ricarica i tuoi dati.

Come posso ottenere più crediti?

Vai su Impostazioni > Fatturazione > Aggiungi crediti. Acquista crediti da 5 a 1000 dollari. I crediti acquistati non scadono mai.

Cosa succede se l'addestramento fallisce?

Ti verrà addebitato solo il tempo di elaborazione completato. I checkpoint vengono salvati e puoi riprendere l'addestramento.

Posso scaricare il mio modello addestrato?

Sì, clicca sull'icona di download in qualsiasi pagina del modello per scaricare il .pt file o formati esportati.

Come posso condividere pubblicamente il mio lavoro?

Modifica le impostazioni del tuo progetto o set di dati e imposta la visibilità su "Pubblico". I contenuti pubblici vengono visualizzati nella pagina Esplora.

Quali sono i limiti di dimensione dei file?

Immagini: 50 MB, video: 1 GB, archivi ZIP: 50 GB. Per file più grandi, suddividili in più caricamenti.

Per quanto tempo gli elementi eliminati vengono conservati nel Cestino?

30 giorni. Trascorso tale periodo, gli elementi vengono eliminati definitivamente e non possono essere recuperati.

Posso utilizzare i modelli della piattaforma a fini commerciali?

I piani Free e Pro utilizzano la licenza AGPL. Per un utilizzo commerciale senza i requisiti AGPL, contattareultralytics per ottenere una licenza Enterprise.