Intel OpenVINO Export

このガイドでは、YOLO26モデルをOpenVINO形式にエクスポートする方法について説明します。これにより、最大3倍のCPU高速化が実現するほか、Intel GPUおよびNPUハードウェアでのYOLO推論が加速されます。

OpenVINO(Open Visual Inference & Neural Network Optimization toolkitの略)は、AI推論モデルを最適化し、デプロイするための包括的なツールキットです。名前にはVisualとありますが、OpenVINOは言語、オーディオ、時系列など、さまざまな追加タスクもサポートしています。

見る: Ultralytics YOLO26をIntel OpenVINO形式にエクスポートして推論を高速化する方法 🚀

使用例

YOLO26nモデルをOpenVINO形式にエクスポートし、エクスポートされたモデルで推論を実行します。

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

エクスポート引数

| 引数 | 種類 | デフォルト | 説明 |

|---|---|---|---|

format | str | 'openvino' | エクスポートされたモデルのターゲット形式。さまざまなデプロイメント環境との互換性を定義します。 |

imgsz | int または tuple | 640 | モデル入力に必要な画像サイズ。正方形の画像の場合は整数、タプルの場合は (height, width) 特定の寸法の場合。 |

half | bool | False | FP16(半精度)量子化を有効にし、モデルサイズを縮小し、サポートされているハードウェアでの推論を高速化する可能性があります。 |

int8 | bool | False | INT8量子化を有効にすると、モデルがさらに圧縮され、精度の低下を最小限に抑えながら推論が高速化されます。主にエッジデバイス向けです。 |

dynamic | bool | False | 動的な入力サイズを許可し、さまざまな画像寸法を処理する際の柔軟性を高めます。 |

nms | bool | False | 正確かつ効率的なdetect後処理に不可欠なNon-Maximum Suppression (NMS)を追加します。 |

batch | int | 1 | エクスポートされたモデルのバッチ推論サイズ、またはエクスポートされたモデルが同時に処理する画像の最大数を指定します。 predict モードを参照してください。 |

data | str | 'coco8.yaml' | へのパス データセット 構成ファイル(デフォルト: coco8.yaml)は、量子化に不可欠です。 |

fraction | float | 1.0 | INT8量子化のキャリブレーションに使用するデータセットの割合を指定します。リソースが限られている場合や実験を行う場合に役立つ、データセットのサブセットでのキャリブレーションが可能です。INT8を有効にして指定しない場合、データセット全体が使用されます。 |

エクスポートプロセスの詳細については、エクスポートに関するUltralyticsドキュメントページをご覧ください。

警告

OpenVINO™はほとんどのIntel®プロセッサと互換性がありますが、最適なパフォーマンスを確保するには:

OpenVINO™のサポートを確認 お使いのIntel®チップがOpenVINO™によって公式にサポートされているか、Intelの互換性リストを使用して確認してください。

アクセラレータを特定 お使いのプロセッサに統合NPU (Neural Processing Unit) またはGPU (統合GPU) が含まれているか、Intelのハードウェアガイドを参照して判断してください。

最新のドライバーをインストール お使いのチップがNPUまたはGPUをサポートしているにもかかわらず、OpenVINO™がそれを検出しない場合、関連するドライバーをインストールまたは更新する必要があるかもしれません。完全なアクセラレーションを有効にするには、ドライバーのインストール手順に従ってください。

これらの3つのステップに従うことで、OpenVINO™がIntel®ハードウェア上で最適に動作することを保証できます。

OpenVINO の利点

- パフォーマンス: OpenVINOは、Intel CPU、統合およびディスクリートGPU、FPGAの能力を活用して、高性能な推論を提供します。

- 異種実行のサポート: OpenVINOは、一度記述してサポートされているすべてのIntelハードウェア(CPU、GPU、FPGA、VPUなど)にデプロイするためのAPIを提供します。

- Model Optimizer: OpenVINOは、PyTorch、TensorFlow、TensorFlow Lite、Keras、ONNX、PaddlePaddle、Caffeなどの一般的な深層学習フレームワークからモデルをインポート、変換、最適化するModel Optimizerを提供します。

- 使いやすさ: ツールキットには、ツールキットのさまざまな側面を教える80以上のチュートリアルノートブック(YOLOv8の最適化を含む)が付属しています。

OpenVINOエクスポート構造

モデルをOpenVINO形式にエクスポートすると、次のものが含まれるディレクトリが作成されます。

- XMLファイル: ネットワークトポロジを記述します。

- BINファイル: 重みとバイナリデータのバイアスが含まれています。

- マッピングファイル: 元のモデル出力tensorからOpenVINO tensor名へのマッピングを保持します。

これらのファイルを使用して、OpenVINO Inference Engineで推論を実行できます。

デプロイメントでOpenVINOエクスポートを使用

モデルがOpenVINO形式に正常にエクスポートされると、推論を実行するための主なオプションが2つあります。

以下を使用します

ultralyticsOpenVINO Runtimeをラップする高レベルAPIを提供するパッケージ。ネイティブの

openvino推論動作をより高度にまたはカスタマイズして制御するためのパッケージ。

Ultralyticsでの推論

Ultralytics パッケージを使用すると、エクスポートされた OpenVINO モデルを使用して、predict メソッドで簡単に推論を実行できます。ターゲットデバイス(例: intel:gpu, intel:npu, intel:cpu) は、device 引数を使用して行います。

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

このアプローチは、推論パイプラインを完全に制御する必要がない場合に、迅速なプロトタイピングまたはデプロイに最適です。

OpenVINO Runtimeでの推論

OpenVINO Runtimeは、サポートされているすべてのIntelハードウェアで推論を行うための統合APIを提供します。また、Intelハードウェア間での負荷分散や非同期実行などの高度な機能も提供します。推論の実行に関する詳細については、YOLO26ノートブックを参照してください。

Runtimeでモデルを正しくセットアップして使用するには、XMLファイルとBINファイル、および入力サイズ、正規化のスケールファクターなど、アプリケーション固有の設定が必要になることに注意してください。

デプロイメントアプリケーションでは、通常、次の手順を実行します。

- OpenVINOを初期化(作成による)

core = Core(). - を使用してモデルをロードします。

core.read_model()メソッド。 - を使用してモデルをコンパイルします

core.compile_model()関数。 - 入力(画像、テキスト、オーディオなど)を準備します。

- を使用して推論を実行します

compiled_model(input_data).

詳細な手順とコードスニペットについては、OpenVINOドキュメントまたはAPIチュートリアルを参照してください。

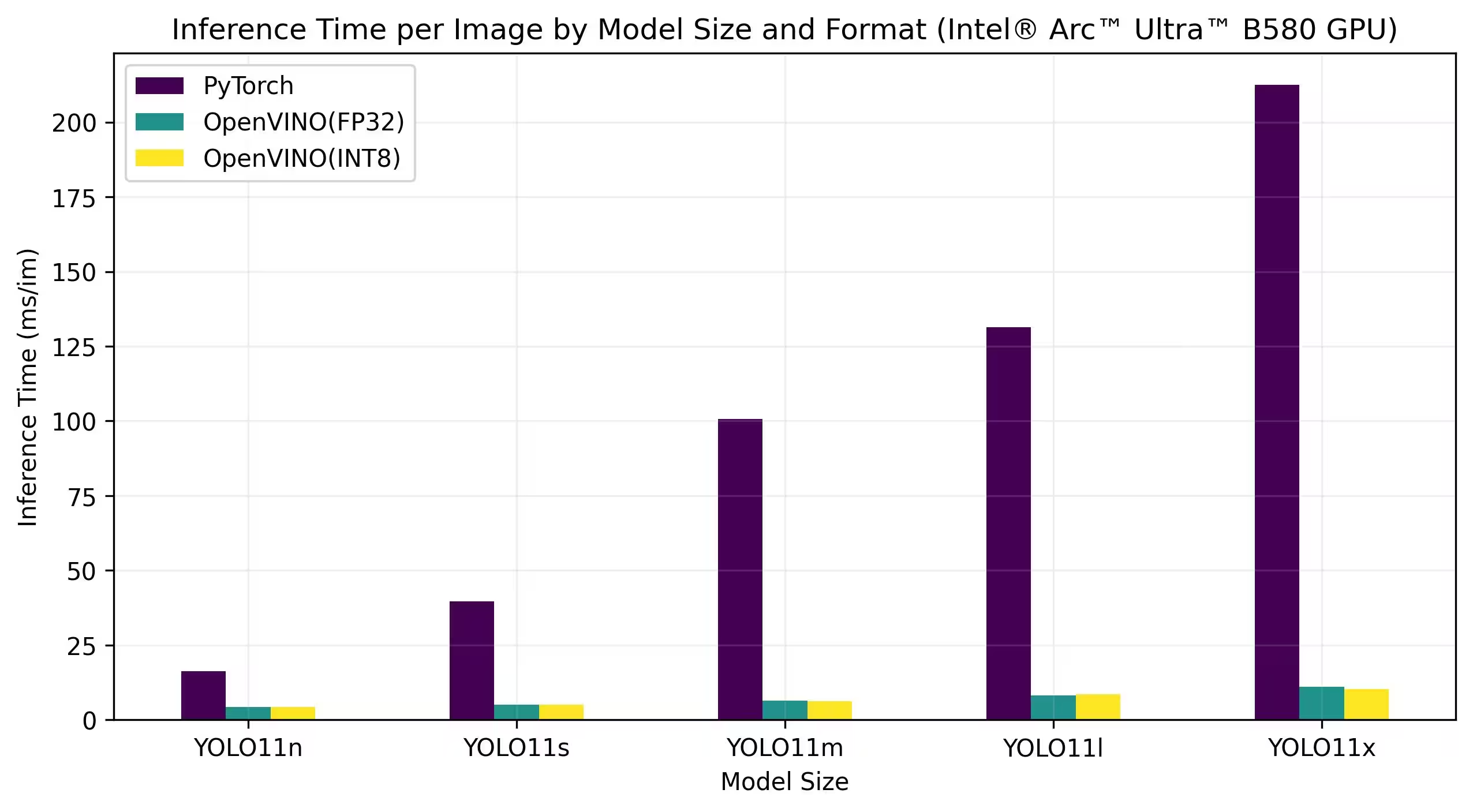

OpenVINO YOLO11ベンチマーク

Ultralytics チームは、さまざまなモデル形式と精度で YOLO11 のベンチマークを行い、OpenVINO と互換性のあるさまざまな Intel デバイスでの速度と精度を評価しました。

注

以下のベンチマーク結果は参考用であり、システムの正確なハードウェアおよびソフトウェア構成、ベンチマーク実行時のシステムの現在のワークロードによって異なる場合があります。

すべてのベンチマークは以下を使用して実行されます。 openvino pythonパッケージのバージョン 2025.1.0.

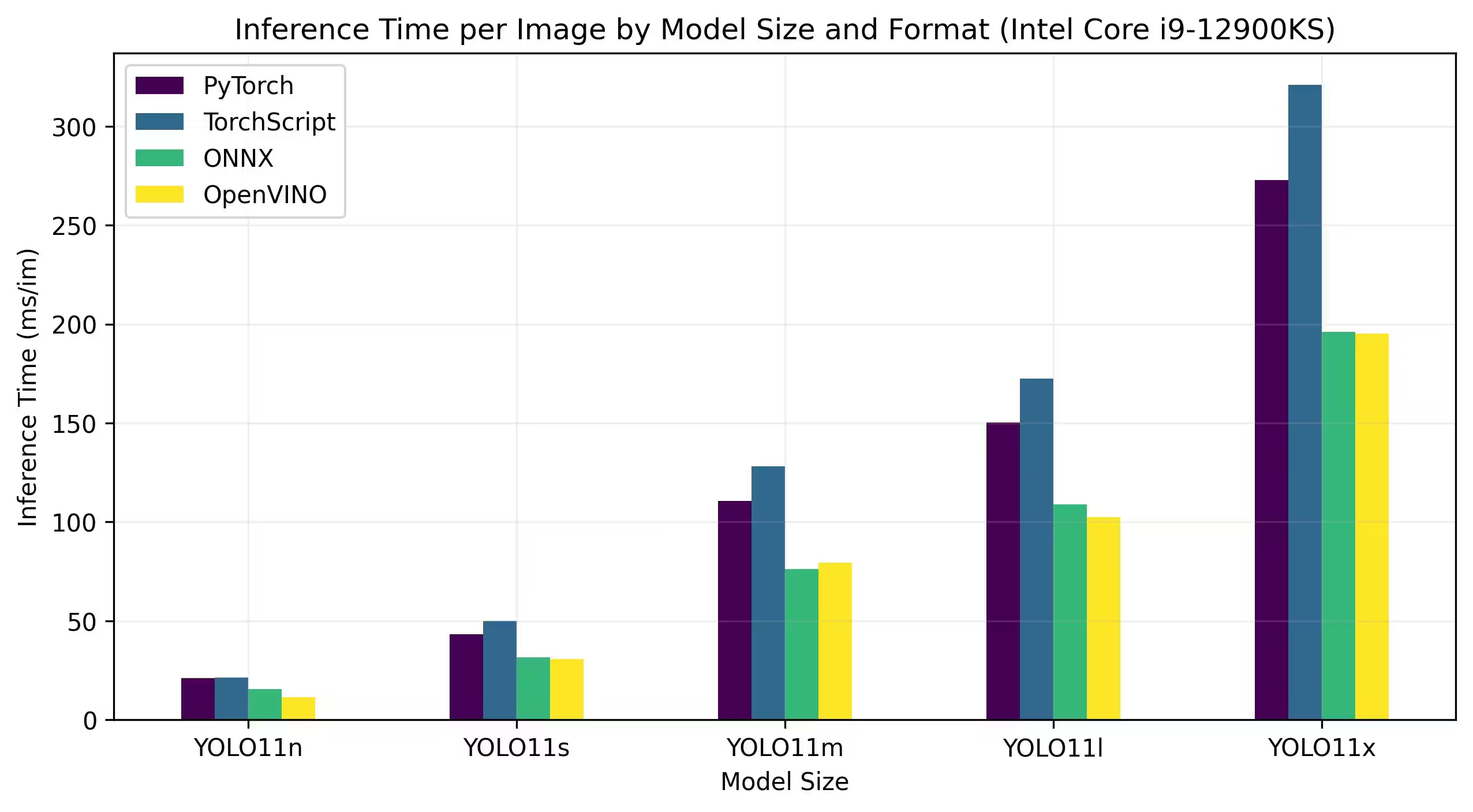

Intel Core CPU

Intel® Core® シリーズは、Intel製高性能プロセッサのシリーズです。Core i3(エントリーレベル)、Core i5(ミッドレンジ)、Core i7(ハイエンド)、Core i9(エクストリームパフォーマンス)が含まれます。各シリーズは、日常的なタスクから要求の厳しいプロフェッショナルなワークロードまで、さまざまなコンピューティングのニーズと予算に対応します。新しい世代ごとに、パフォーマンス、エネルギー効率、機能が改善されています。

以下のベンチマークは、FP32精度で第12世代Intel® Core® i9-12900KS CPU上で実行されています。

詳細なベンチマーク結果

| モデル | 形式 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

Intel® Core™ Ultra™シリーズは、ゲーマーやクリエイターからAIを活用する専門家まで、現代の進化するユーザーの要求に応えるように設計された、高性能コンピューティングにおける新しいベンチマークを表しています。この次世代ラインナップは、従来のCPUシリーズ以上のものです。強力なCPUコア、統合された高性能GPU機能、および専用のニューラルプロセッシングユニット(NPU)を1つのチップに組み合わせ、多様で集中的なコンピューティングワークロードに対応する統合ソリューションを提供します。

Intel® Core Ultra™アーキテクチャの中核となるのは、従来の処理タスク、GPUアクセラレーションされたワークロード、およびAI駆動のオペレーション全体で卓越したパフォーマンスを可能にするハイブリッド設計です。NPUの搭載により、オンデバイスAI推論が強化され、幅広いアプリケーションでより高速で効率的な機械学習とデータ処理が可能になります。

Core Ultra™ファミリーには、さまざまなパフォーマンスニーズに合わせて調整されたさまざまなモデルが含まれており、エネルギー効率の高い設計から、「H」の指定でマークされた高出力バリアントまで、さまざまなオプションがあります。これらは、本格的なコンピューティングパワーを必要とするラップトップやコンパクトなフォームファクターに最適です。ラインナップ全体で、ユーザーはCPU、GPU、およびNPUの統合による相乗効果の恩恵を受け、卓越した効率、応答性、およびマルチタスク機能を実現します。

Intelの継続的なイノベーションの一環として、Core Ultra™シリーズは、将来を見据えたコンピューティングの新たな基準を打ち立てます。複数のモデルが利用可能であり、今後も増える予定であるこのシリーズは、次世代のインテリジェントなAI強化デバイス向けに最先端のソリューションを提供するというIntelのコミットメントを強調しています。

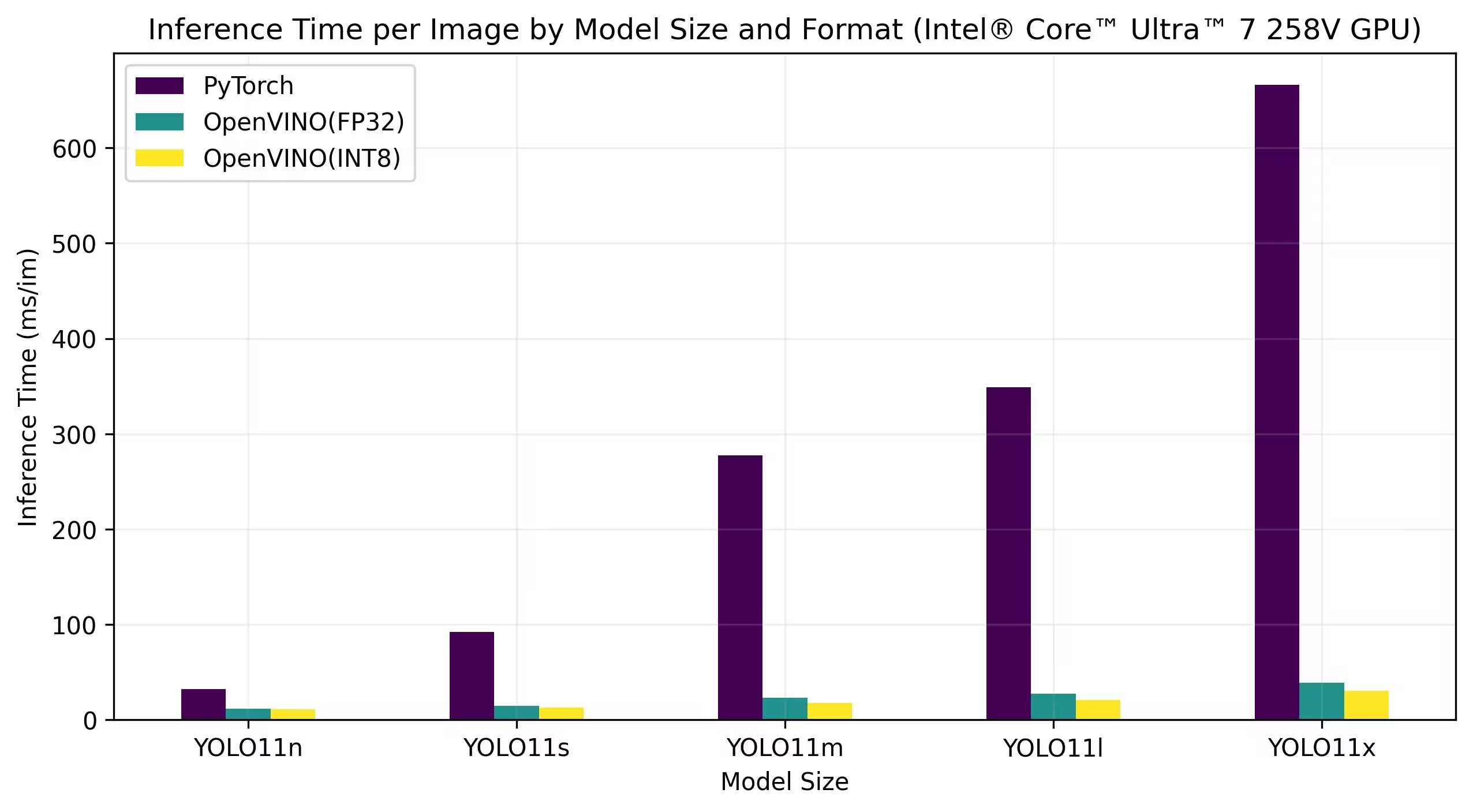

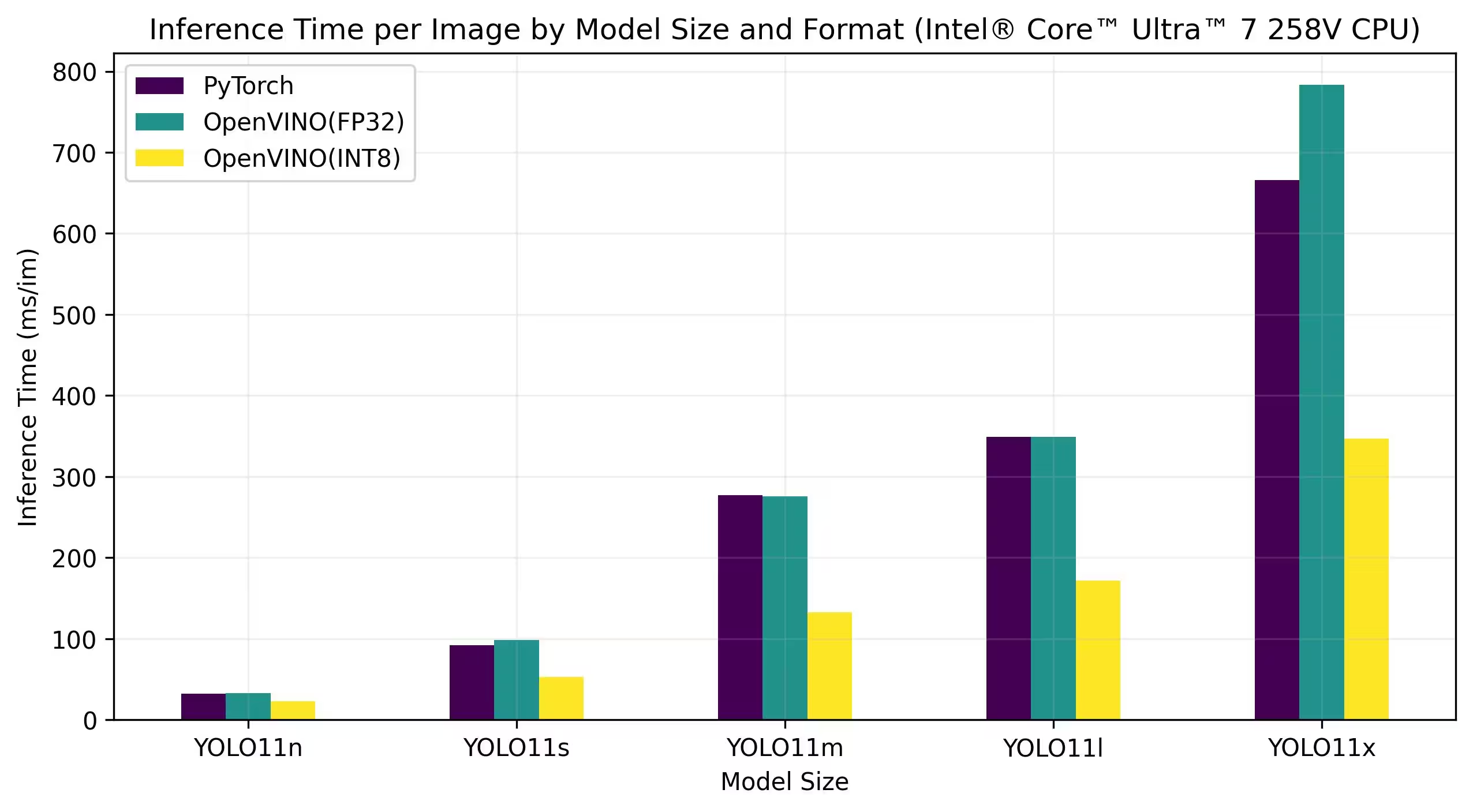

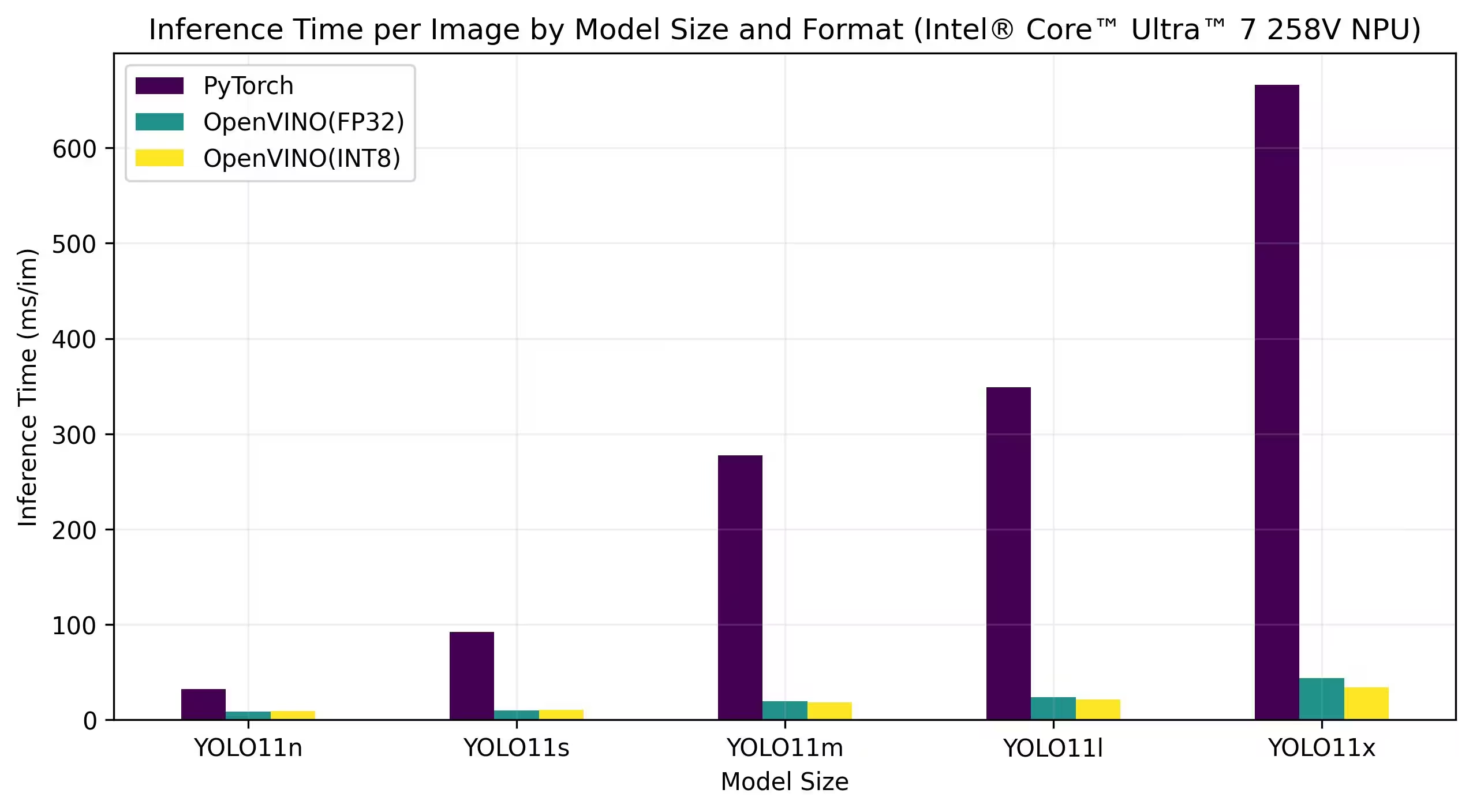

以下のベンチマークは、FP32およびINT8精度でIntel® Core™ Ultra™ 7 258VおよびIntel® Core™ Ultra™ 7 265K上で実行されています。

Intel® Core™ Ultra™ 7 258V

ベンチマーク

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

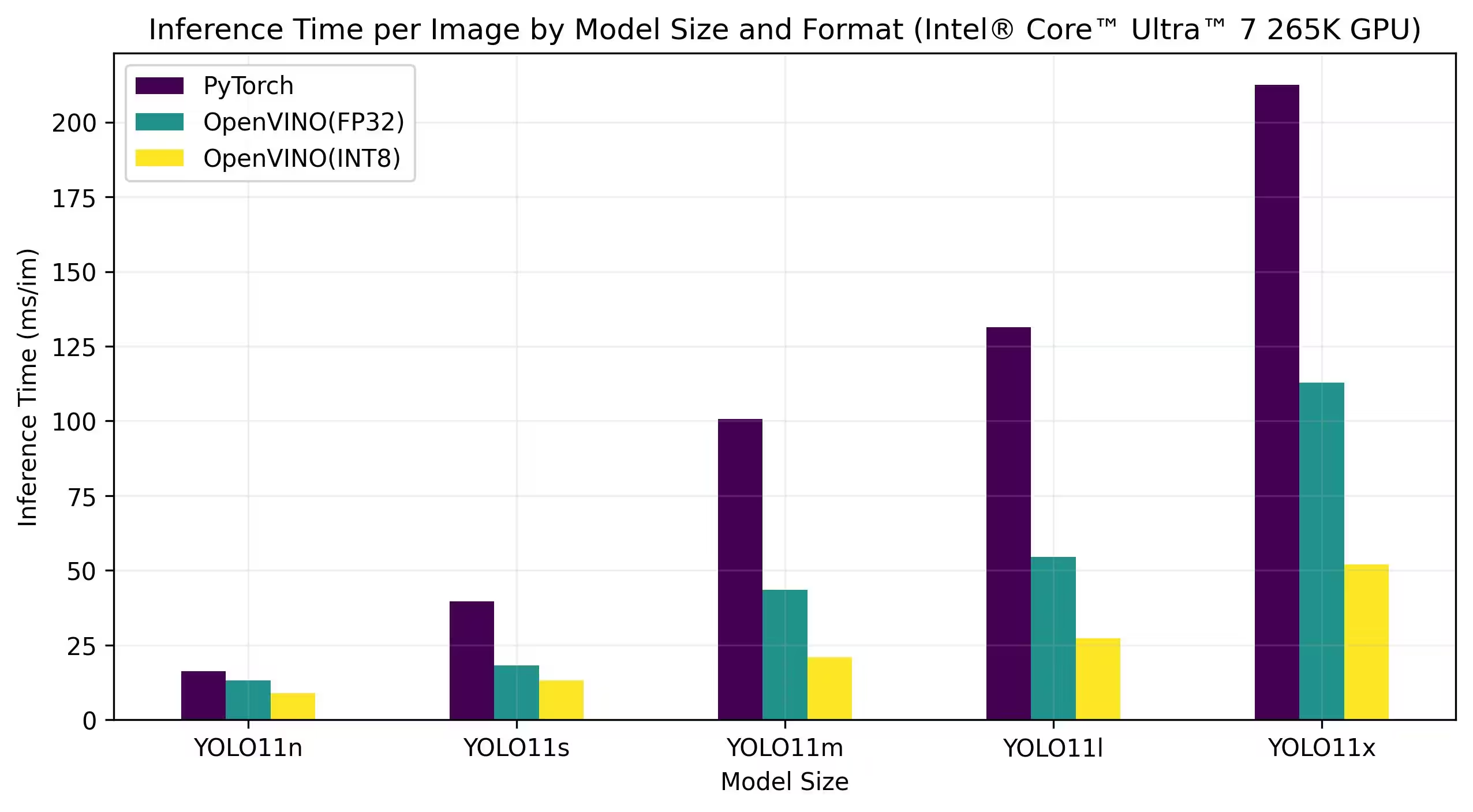

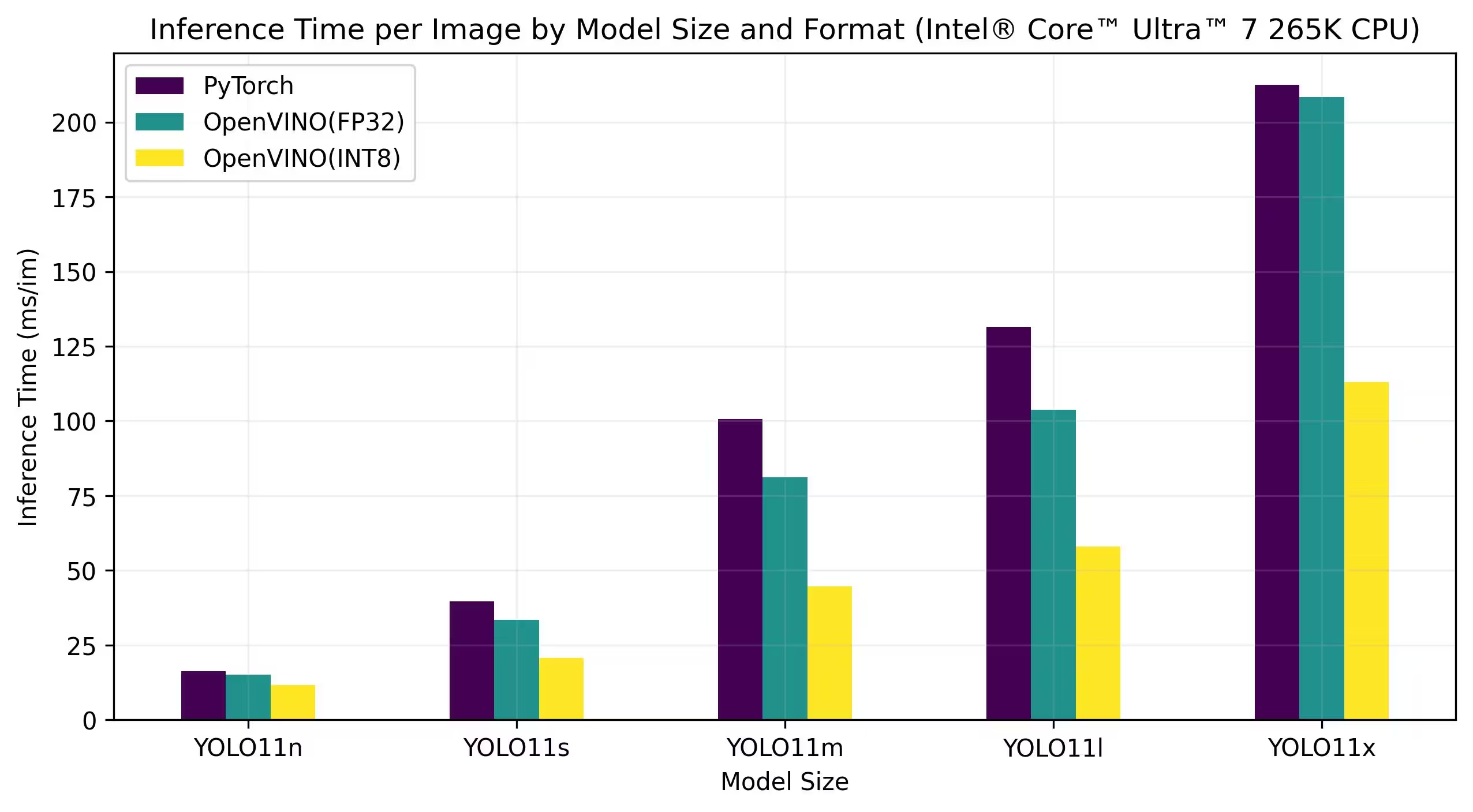

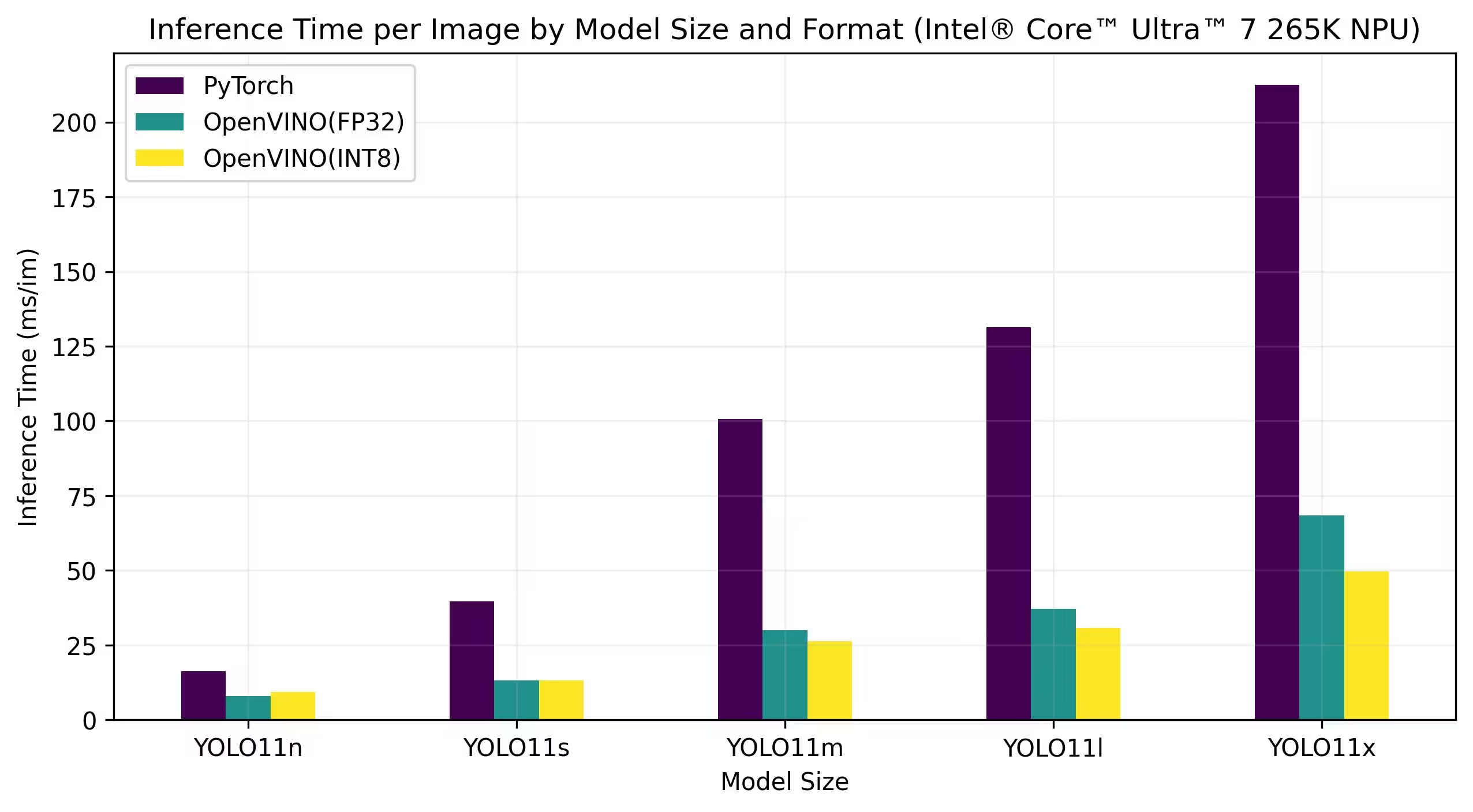

Intel® Core™ Ultra™ 7 265K

ベンチマーク

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

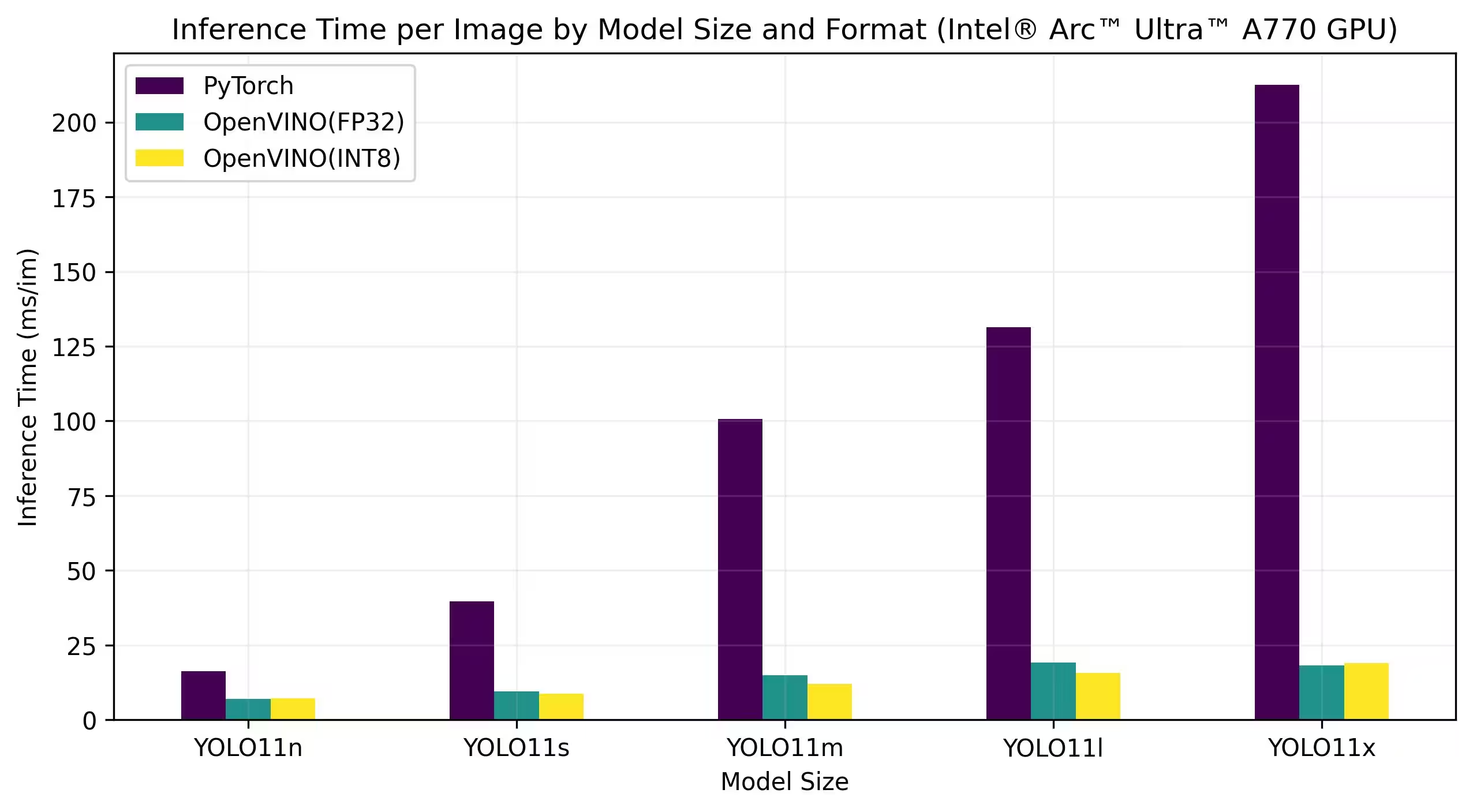

Intel® Arc GPU

Intel® Arc™は、ハイパフォーマンスなゲーム、コンテンツ制作、AIワークロード向けに設計された、Intelのディスクリート・グラフィックス・カードのラインです。Arcシリーズは、リアルタイム・レイ・トレーシング、AI拡張グラフィックス、高解像度ゲーミングをサポートする高度なGPUアーキテクチャを特徴としています。パフォーマンスと効率に重点を置き、Intel® Arc™は、ハードウェア・アクセラレーションによるAV1エンコードや最新のグラフィックスAPIのサポートといった独自の機能を提供しながら、他の主要なGPUブランドと競合することを目指しています。

以下のベンチマークは、FP32およびINT8精度でIntel Arc A770およびIntel Arc B580上で実行されています。

Intel Arc A770

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

詳細なベンチマーク結果

| モデル | 形式 | 適合率 | ステータス | サイズ(MB) | metrics/mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

結果の再現

上記のUltralyticsベンチマークをすべてのエクスポート形式で再現するには、次のコードを実行します:

例

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

ベンチマークの結果は、システムの正確なハードウェアおよびソフトウェア構成、ベンチマーク実行時のシステムの現在のワークロードによって異なる可能性があることに注意してください。最も信頼性の高い結果を得るには、多数の画像を含むデータセット(例:)を使用してください。 data='coco.yaml' (5000の検証画像)。

結論

ベンチマーク結果は、YOLO11モデルをOpenVINO形式にエクスポートすることの利点を明確に示しています。異なるモデルおよびハードウェアプラットフォームにおいて、OpenVINO形式は、同等の精度を維持しながら、推論速度の点で一貫して他の形式よりも優れています。

このベンチマークは、深層学習モデルをデプロイするためのツールとしてのOpenVINOの有効性を強調しています。モデルをOpenVINO形式に変換することで、開発者は大幅なパフォーマンス向上を達成でき、これらのモデルを実際のアプリケーションにデプロイすることが容易になります。

OpenVINOの使用に関する詳細な情報と手順については、OpenVINOの公式ドキュメントを参照してください。

よくある質問

YOLO26モデルをOpenVINO形式にエクスポートするにはどうすればよいですか?

YOLO26モデルをOpenVINO形式にエクスポートすることで、CPU速度を大幅に向上させ、IntelハードウェアでのGPUおよびNPUアクセラレーションを可能にします。エクスポートするには、以下に示すようにPythonまたはCLIを使用できます。

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

詳細については、エクスポート形式のドキュメントを参照してください。

YOLO26モデルでOpenVINOを使用する利点は何ですか?

IntelのOpenVINOツールキットをYOLO26モデルと併用すると、いくつかの利点があります。

- パフォーマンス: CPU推論で最大3倍の高速化を達成し、Intel GPUおよびNPUを活用して高速化を実現します。

- Model Optimizer: PyTorch、TensorFlow、ONNXなどの一般的なフレームワークのモデルを変換、最適化、および実行します。

- 使いやすさ: ユーザーが開始するのに役立つ80以上のチュートリアルノートブックが利用可能で、YOLO26用のものも含まれています。

- 異種実行:統合されたAPIを使用して、さまざまなIntelハードウェアにモデルをデプロイします。

詳細なパフォーマンス比較については、ベンチマークセクションをご覧ください。

OpenVINOにエクスポートされたYOLO26モデルを使用して推論を実行するにはどうすればよいですか?

YOLO26nモデルをOpenVINO形式にエクスポートした後、PythonまたはCLIを使用して推論を実行できます。

例

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

詳細については、predictモードのドキュメントを参照してください。

OpenVINOエクスポートにおいて、他のモデルではなくUltralytics YOLO26を選択すべき理由は何ですか?

Ultralytics YOLO26は、高い精度と速度でリアルタイム物体detectに最適化されています。特に、OpenVINOと組み合わせることで、YOLO26は以下の機能を提供します。

- Intel CPUで最大3倍の高速化

- Intel GPUとNPUへのシームレスなデプロイ

- さまざまなエクスポート形式で一貫性があり、比較可能な精度

詳細なパフォーマンス分析については、さまざまなハードウェアでの詳細なYOLO11ベンチマークをご覧ください。

PyTorch、ONNX、OpenVINO、異なるフォーマットでYOLO26モデルのベンチマークを実行できますか?

はい、PyTorch、TorchScript、ONNX、OpenVINOなど、様々な形式のYOLO26モデルをベンチマークできます。以下のコードスニペットを使用して、選択したデータセットでベンチマークを実行してください:

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

詳細なベンチマーク結果については、ベンチマークセクションとエクスポート形式のドキュメントを参照してください。