빠른 시작 가이드: Ultralytics YOLO26와 함께하는 NVIDIA DGX Spark

이 종합 가이드는 NVIDIA의 소형 데스크톱 AI 슈퍼컴퓨터인 NVIDIA DGX Spark에 Ultralytics YOLO26를 배포하는 자세한 안내를 제공합니다. 또한, 이 강력한 시스템에서 YOLO26의 기능을 보여주기 위한 성능 벤치마크를 제시합니다.

참고

이 가이드는 Ubuntu 기반의 DGX OS를 실행하는 NVIDIA DGX Spark Founders Edition으로 테스트되었습니다. 최신 DGX OS 릴리스에서도 작동할 것으로 예상됩니다.

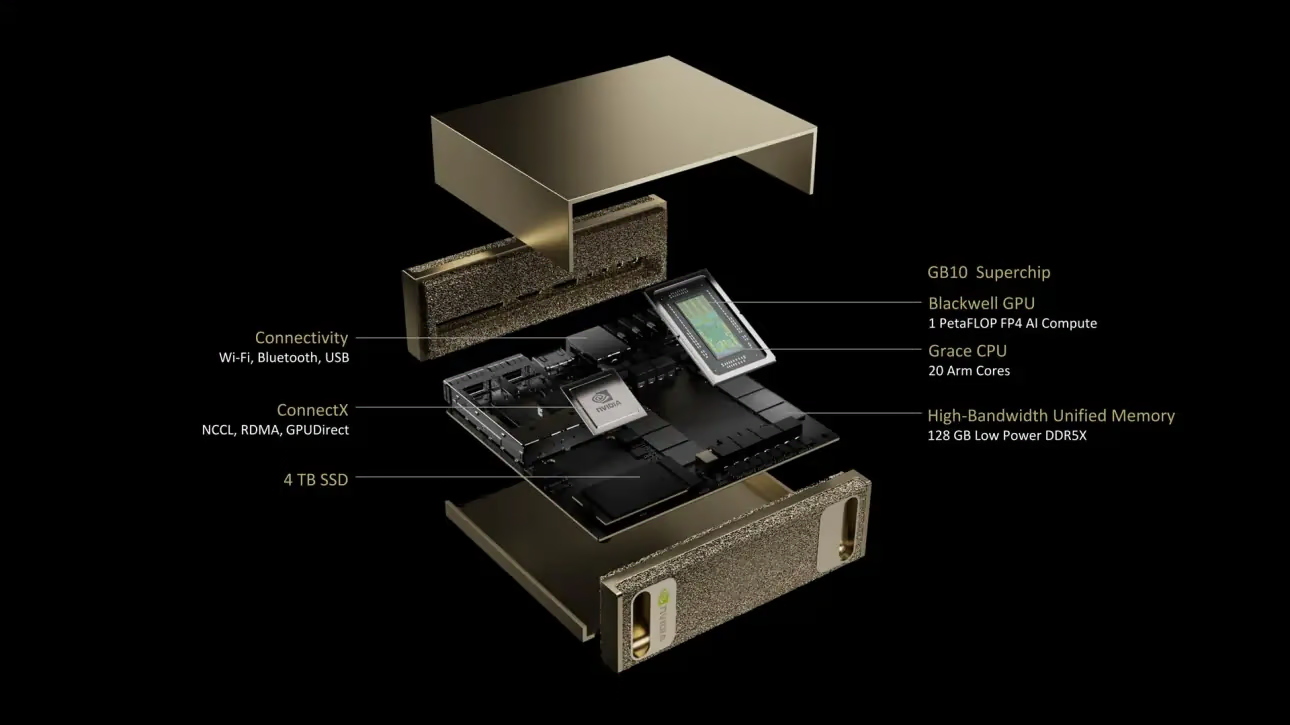

NVIDIA DGX Spark란 무엇입니까?

NVIDIA DGX Spark는 NVIDIA GB10 Grace Blackwell Superchip으로 구동되는 소형 데스크톱 AI 슈퍼컴퓨터입니다. FP4 정밀도로 최대 1 petaFLOP의 AI 컴퓨팅 성능을 제공하여 데스크톱 폼 팩터에서 강력한 AI 기능이 필요한 개발자, 연구원 및 데이터 과학자에게 이상적입니다.

주요 사양

| 사양 | 세부 정보 |

|---|---|

| AI 성능 | 최대 1 PFLOP (FP4) |

| GPU | 5세대 Tensor 코어, 4세대 RT 코어를 갖춘 NVIDIA Blackwell 아키텍처 |

| CPU | 20코어 Arm 프로세서 (10 Cortex-X925 + 10 Cortex-A725) |

| 메모리 | 128GB LPDDR5x 통합 시스템 메모리, 256비트 인터페이스, 4266MHz, 273GB/s 대역폭 |

| 스토리지 | 자체 암호화 기능이 있는 1TB 또는 4TB NVMe M.2 |

| 네트워크 | 1x RJ-45 (10GbE), ConnectX-7 Smart NIC, Wi-Fi 7, Bluetooth 5.4 |

| 연결성 | 4x USB Type-C, 1x HDMI 2.1a, HDMI 다채널 오디오 |

| 비디오 처리 | 1x NVENC, 1x NVDEC |

DGX OS

NVIDIA DGX OS는 DGX 시스템에서 AI, 머신러닝 및 분석 애플리케이션을 실행하기 위한 안정적이고, 테스트되었으며, 지원되는 운영 체제 기반을 제공하는 맞춤형 Linux 배포판입니다. 포함 내역:

- AI 워크로드에 최적화된 견고한 Linux 기반

- NVIDIA 하드웨어용 사전 구성된 드라이버 및 시스템 설정

- 보안 업데이트 및 시스템 유지 관리 기능

- 광범위한 NVIDIA 소프트웨어 생태계와의 호환성

DGX OS는 정기적인 릴리스 일정을 따르며, 일반적으로 연 2회(2월과 8월경) 업데이트가 제공되고, 주요 릴리스 사이에 추가 보안 패치가 제공됩니다.

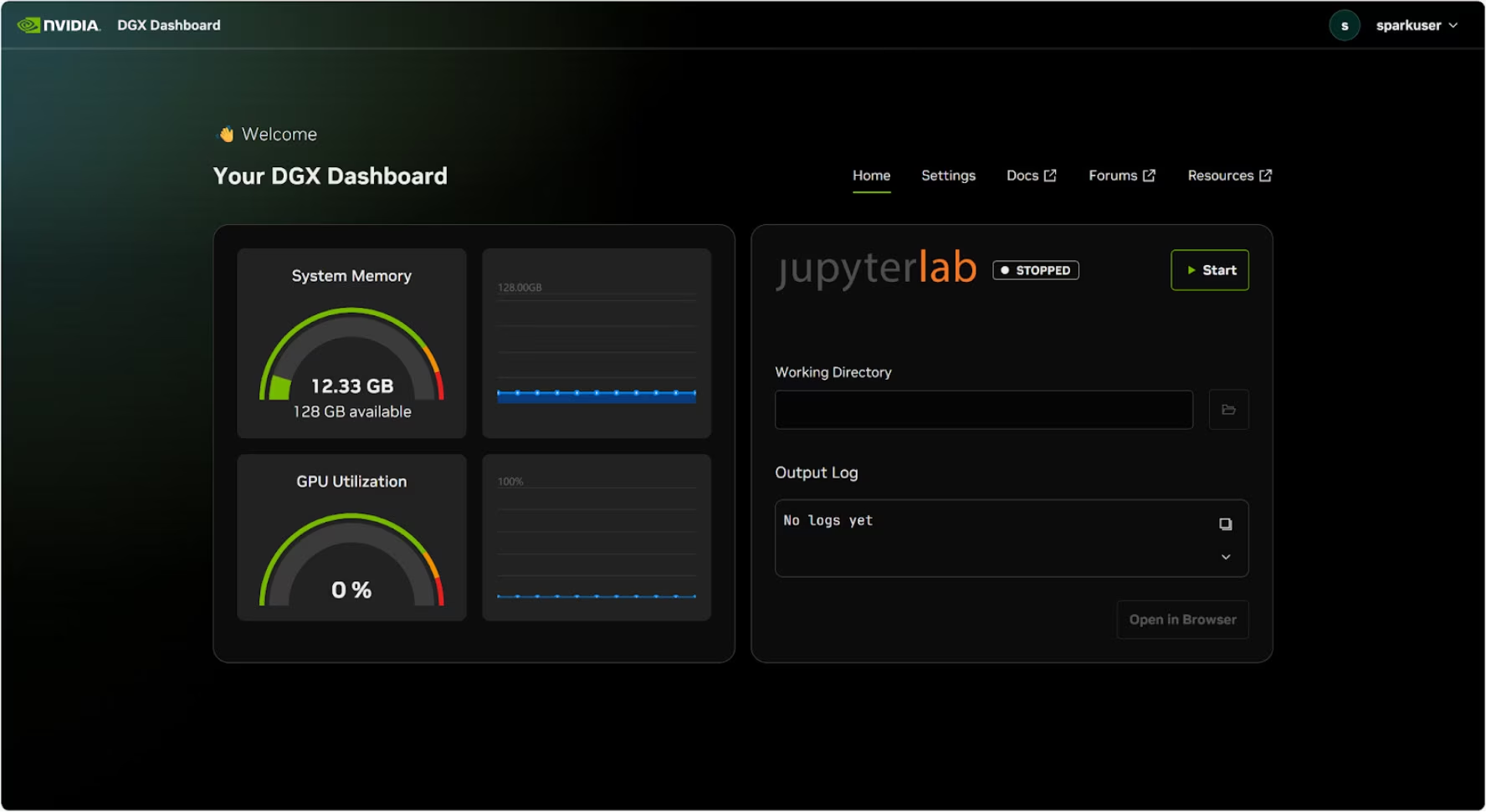

DGX 대시보드

DGX Spark에는 다음을 제공하는 내장 DGX Dashboard가 함께 제공됩니다:

- 실시간 시스템 모니터링: 시스템의 현재 운영 지표 개요

- 시스템 업데이트: 대시보드에서 직접 업데이트를 적용하는 기능

- 시스템 설정: 장치 이름 및 기타 구성 변경

- 통합 JupyterLab: 개발을 위한 로컬 Jupyter Notebook 액세스

대시보드 액세스

Ubuntu 데스크톱의 왼쪽 하단 모서리에 있는 "Show Apps" 버튼을 클릭한 다음, "DGX Dashboard"를 선택하여 브라우저에서 엽니다.

# Open an SSH tunnel

ssh -L 11000:localhost:11000 username@spark-abcd.local

# Then open in browser

# http://localhost:11000

NVIDIA Sync에 연결한 후, "DGX Dashboard" 버튼을 클릭하여 대시보드를 엽니다. http://localhost:11000.

통합 JupyterLab

대시보드에는 통합 JupyterLab 인스턴스가 포함되어 있으며, 이 인스턴스는 시작 시 가상 환경을 자동으로 생성하고 권장 패키지를 설치합니다. 각 사용자 계정에는 JupyterLab 액세스를 위한 전용 포트가 할당됩니다.

Docker로 빠른 시작

NVIDIA DGX Spark에서 Ultralytics YOLO26를 가장 빠르게 시작하는 방법은 사전 구축된 Docker 이미지로 실행하는 것입니다. Jetson AGX Thor (JetPack 7.0)를 지원하는 동일한 Docker 이미지가 DGX OS와 함께 DGX Spark에서도 작동합니다.

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia --gpus all $t

이 작업이 완료되면 NVIDIA DGX Spark에서 TensorRT 사용 섹션으로 건너뛰십시오.

네이티브 설치로 시작하기

Docker 없이 네이티브로 설치하려면 다음 단계를 따르십시오.

Ultralytics 패키지 설치

여기서는 DGX Spark에 Ultralytics 패키지를 선택적 종속성과 함께 설치하여 PyTorch 모델을 다른 다양한 형식으로 내보낼 수 있도록 할 것입니다. TensorRT는 DGX Spark에서 최대 성능을 얻을 수 있도록 보장하므로, 주로 NVIDIA TensorRT 내보내기에 중점을 둘 것입니다.

패키지 목록을 업데이트하고, pip를 설치하고, 최신 버전으로 업그레이드합니다.

sudo apt update sudo apt install python3-pip -y pip install -U pip설치

ultralytics선택적 종속성이 있는 pip 패키지pip install ultralytics[export]장치를 재부팅합니다.

sudo reboot

PyTorch 및 Torchvision 설치

위의 Ultralytics 설치는 Torch와 Torchvision을 설치합니다. 그러나 pip를 통해 설치된 이 패키지들은 CUDA 13이 적용된 DGX Spark의 ARM64 아키텍처에 완전히 최적화되지 않을 수 있습니다. 따라서 CUDA 13 호환 버전을 설치하는 것을 권장합니다.

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

정보

NVIDIA DGX Spark에서 PyTorch 2.9.1을 실행할 때 다음과 같은 문제가 발생할 수 있습니다. UserWarning CUDA를 초기화할 때 (예: 실행 중) yolo checks, yolo predict, 등):

UserWarning: Found GPU0 NVIDIA GB10 which is of cuda capability 12.1.

Minimum and Maximum cuda capability supported by this version of PyTorch is (8.0) - (12.0)

이 경고는 안전하게 무시할 수 있습니다. 이 문제를 영구적으로 해결하기 위해 PyTorch PR #164590에 수정 사항이 제출되었으며, 이는 PyTorch 2.10 릴리스에 포함될 예정입니다.

설치 onnxruntime-gpu

에 지정되어 있습니다. onnxruntime-gpu PyPI에 호스팅된 패키지에는 없습니다. aarch64 ARM64 시스템용 바이너리입니다. 따라서 이 패키지를 수동으로 설치해야 합니다. 이 패키지는 일부 내보내기에 필요합니다.

여기에서 다운로드하여 설치합니다. onnxruntime-gpu 1.24.0 와 함께 Python3.12 지원합니다.

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

NVIDIA DGX Spark에서 TensorRT 사용

Ultralytics가 지원하는 모든 모델 내보내기 형식 중에서 TensorRT는 NVIDIA DGX Spark에서 가장 높은 추론 성능을 제공하므로, 배포를 위한 최우선 권장 사항입니다. 설치 지침 및 고급 사용법은 당사의 전용 TensorRT 통합 가이드를 참조하십시오.

모델을 TensorRT로 변환하고 추론 실행

PyTorch 형식의 YOLO26n 모델은 내보낸 모델로 추론을 실행하기 위해 TensorRT로 변환됩니다.

예시

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

참고

모델을 다른 모델 형식으로 내보낼 때 추가 인수에 액세스하려면 내보내기 페이지를 방문하십시오.

NVIDIA DGX Spark YOLO11 벤치마크

Ultralytics 팀은 속도와 정확도를 측정하기 위해 PyTorch, TorchScript, ONNX, OpenVINO, TensorRT, TF SavedModel, TF GraphDef, TF Lite, MNN, NCNN, ExecuTorch 등 여러 모델 형식에서 YOLO11 벤치마크를 실행했습니다. 벤치마크는 NVIDIA DGX Spark에서 기본 입력 이미지 크기 640으로 FP32 정밀도로 실행되었습니다.

자세한 비교 표

아래 표는 다섯 가지 다른 모델(YOLO11n, YOLO11s, YOLO11m, YOLO11l, YOLO11x)에 대한 여러 형식의 벤치마크 결과를 나타내며, 각 조합에 대한 상태, 크기, mAP50-95(B) 지표 및 추론 시간을 제공합니다.

성능

| 형식 | 상태 | 디스크 크기(MB) | mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5071 | 2.67 |

| TorchScript | ✅ | 10.5 | 0.5083 | 2.62 |

| ONNX | ✅ | 10.2 | 0.5074 | 5.92 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 14.95 |

| TensorRT (FP32) | ✅ | 12.8 | 0.5085 | 1.95 |

| TensorRT (FP16) | ✅ | 7.0 | 0.5068 | 1.01 |

| TensorRT (INT8) | ✅ | 18.6 | 0.4880 | 1.62 |

| TF SavedModel | ✅ | 25.7 | 0.5076 | 36.39 |

| TF GraphDef | ✅ | 10.3 | 0.5076 | 41.06 |

| TF Lite | ✅ | 10.3 | 0.5075 | 64.36 |

| MNN | ✅ | 10.1 | 0.5075 | 12.14 |

| NCNN | ✅ | 10.2 | 0.5041 | 12.31 |

| ExecuTorch | ✅ | 10.2 | 0.5075 | 27.61 |

| 형식 | 상태 | 디스크 크기(MB) | mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5767 | 5.38 |

| TorchScript | ✅ | 36.5 | 0.5781 | 5.48 |

| ONNX | ✅ | 36.3 | 0.5784 | 8.17 |

| OpenVINO | ✅ | 36.4 | 0.5809 | 27.12 |

| TensorRT (FP32) | ✅ | 39.8 | 0.5783 | 3.59 |

| TensorRT (FP16) | ✅ | 20.1 | 0.5800 | 1.85 |

| TensorRT (INT8) | ✅ | 17.5 | 0.5664 | 1.88 |

| TF SavedModel | ✅ | 90.8 | 0.5782 | 66.63 |

| TF GraphDef | ✅ | 36.3 | 0.5782 | 71.67 |

| TF Lite | ✅ | 36.3 | 0.5782 | 187.36 |

| MNN | ✅ | 36.2 | 0.5775 | 27.05 |

| NCNN | ✅ | 36.2 | 0.5806 | 26.26 |

| ExecuTorch | ✅ | 36.2 | 0.5782 | 54.73 |

| 형식 | 상태 | 디스크 크기(MB) | mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6254 | 11.14 |

| TorchScript | ✅ | 77.3 | 0.6304 | 12.00 |

| ONNX | ✅ | 76.9 | 0.6304 | 13.83 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 62.44 |

| TensorRT (FP32) | ✅ | 79.9 | 0.6305 | 6.96 |

| TensorRT (FP16) | ✅ | 40.6 | 0.6313 | 3.14 |

| TensorRT (INT8) | ✅ | 26.6 | 0.6204 | 3.30 |

| TF SavedModel | ✅ | 192.4 | 0.6306 | 139.85 |

| TF GraphDef | ✅ | 76.9 | 0.6306 | 146.76 |

| TF Lite | ✅ | 76.9 | 0.6306 | 568.18 |

| MNN | ✅ | 76.8 | 0.6306 | 67.67 |

| NCNN | ✅ | 76.8 | 0.6308 | 60.49 |

| ExecuTorch | ✅ | 76.9 | 0.6306 | 120.37 |

| 형식 | 상태 | 디스크 크기(MB) | mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6366 | 13.95 |

| TorchScript | ✅ | 97.6 | 0.6399 | 15.67 |

| ONNX | ✅ | 97.0 | 0.6399 | 16.62 |

| OpenVINO | ✅ | 97.3 | 0.6377 | 78.80 |

| TensorRT (FP32) | ✅ | 99.2 | 0.6407 | 8.86 |

| TensorRT (FP16) | ✅ | 50.8 | 0.6350 | 3.85 |

| TensorRT (INT8) | ✅ | 32.5 | 0.6224 | 4.52 |

| TF SavedModel | ✅ | 242.7 | 0.6409 | 187.45 |

| TF GraphDef | ✅ | 97.0 | 0.6409 | 193.92 |

| TF Lite | ✅ | 97.0 | 0.6409 | 728.61 |

| MNN | ✅ | 96.9 | 0.6369 | 85.21 |

| NCNN | ✅ | 96.9 | 0.6373 | 77.62 |

| ExecuTorch | ✅ | 97.0 | 0.6409 | 153.56 |

| 형식 | 상태 | 디스크 크기(MB) | mAP50-95(B) | 추론 시간 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.6992 | 23.19 |

| TorchScript | ✅ | 218.1 | 0.6900 | 25.75 |

| ONNX | ✅ | 217.5 | 0.6900 | 27.43 |

| OpenVINO | ✅ | 217.8 | 0.6872 | 149.44 |

| TensorRT (FP32) | ✅ | 222.7 | 0.6902 | 13.87 |

| TensorRT (FP16) | ✅ | 111.1 | 0.6883 | 6.19 |

| TensorRT (INT8) | ✅ | 62.9 | 0.6793 | 6.62 |

| TF SavedModel | ✅ | 543.9 | 0.6900 | 335.10 |

| TF GraphDef | ✅ | 217.5 | 0.6900 | 348.86 |

| TF Lite | ✅ | 217.5 | 0.6900 | 1578.66 |

| MNN | ✅ | 217.3 | 0.6874 | 168.95 |

| NCNN | ✅ | 217.4 | 0.6901 | 132.13 |

| ExecuTorch | ✅ | 217.4 | 0.6900 | 297.17 |

Ultralytics 8.3.249로 벤치마크됨

결과 재현하기

모든 내보내기 형식에서 위의 Ultralytics 벤치마크를 재현하려면 다음 코드를 실행하십시오.

예시

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO26n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco128.yaml imgsz=640

벤치마킹 결과는 시스템의 정확한 하드웨어 및 소프트웨어 구성과 벤치마크 실행 시점의 시스템 현재 작업 부하에 따라 달라질 수 있습니다. 가장 신뢰할 수 있는 결과를 얻으려면 많은 수의 이미지가 포함된 데이터셋을 사용하십시오. 예를 들어, data='coco.yaml' (5000개의 검증 이미지).

NVIDIA DGX Spark를 위한 모범 사례

NVIDIA DGX Spark를 사용할 때 YOLO26 실행 시 최대 성능을 구현하기 위해 따라야 할 몇 가지 모범 사례가 있습니다.

시스템 성능 모니터링

NVIDIA의 모니터링 도구를 사용하여 GPU 및 CPU 사용률을 track하십시오.

nvidia-smi메모리 사용량 최적화

128GB의 통합 메모리를 통해 DGX Spark는 대규모 배치 크기와 모델을 처리할 수 있습니다. 처리량 향상을 위해 배치 크기를 늘리는 것을 고려하십시오.

from ultralytics import YOLO model = YOLO("yolo26n.engine") results = model.predict(source="path/to/images", batch=16)FP16 또는 INT8과 함께 TensorRT 사용

최적의 성능을 위해 모델을 FP16 또는 INT8 정밀도로 내보내십시오:

yolo export model=yolo26n.pt format=engine half=True # FP16 yolo export model=yolo26n.pt format=engine int8=True # INT8

시스템 업데이트 (Founders Edition)

DGX Spark Founders Edition을 최신 상태로 유지하는 것은 성능 및 보안에 매우 중요합니다. NVIDIA는 시스템 OS, 드라이버 및 펌웨어를 업데이트하기 위한 두 가지 주요 방법을 제공합니다.

DGX 대시보드 사용 (권장)

DGX Dashboard는 호환성을 보장하면서 시스템 업데이트를 수행하는 권장 방법입니다. 이를 통해 다음을 수행할 수 있습니다:

- 사용 가능한 시스템 업데이트 보기

- 보안 패치 및 시스템 업데이트 설치

- NVIDIA 드라이버 및 펌웨어 업데이트 관리

수동 시스템 업데이트

고급 사용자의 경우 터미널을 통해 수동으로 업데이트를 수행할 수 있습니다:

sudo apt update

sudo apt dist-upgrade

sudo fwupdmgr refresh

sudo fwupdmgr upgrade

sudo reboot

경고

업데이트를 수행하기 전에 시스템이 안정적인 전원에 연결되어 있고 중요한 데이터를 백업했는지 확인하십시오.

다음 단계

추가 학습 및 지원을 위해서는 Ultralytics YOLO26 문서를 참조하십시오.

FAQ

NVIDIA DGX Spark에 Ultralytics YOLO26를 배포하려면 어떻게 해야 합니까?

NVIDIA DGX Spark에 Ultralytics YOLO26를 배포하는 것은 간단합니다. 빠른 설정을 위해 사전 구축된 Docker 이미지를 사용하거나 필요한 패키지를 수동으로 설치할 수 있습니다. 각 접근 방식에 대한 자세한 단계는 Docker로 빠른 시작 및 네이티브 설치로 시작 섹션에서 확인할 수 있습니다.

NVIDIA DGX Spark에서 YOLO26의 어떤 성능을 기대할 수 있습니까?

YOLO26 모델은 GB10 Grace Blackwell 슈퍼칩 덕분에 DGX Spark에서 뛰어난 성능을 제공합니다. TensorRT 형식은 최고의 추론 성능을 제공합니다. 다양한 모델 크기 및 형식에 대한 특정 벤치마크 결과는 상세 비교표 섹션을 확인하십시오.

DGX Spark에서 YOLO26에 TensorRT를 사용해야 하는 이유는 무엇입니까?

TensorRT는 최적의 성능으로 인해 DGX Spark에 YOLO26 모델을 배포하는 데 강력히 권장됩니다. Blackwell GPU의 기능을 활용하여 추론 속도를 가속화하고 최대 효율과 속도를 보장합니다. 자세한 내용은 NVIDIA DGX Spark에서 TensorRT 사용 섹션을 참조하십시오.

YOLO26의 경우 DGX Spark는 Jetson 장치와 비교하여 어떻습니까?

DGX Spark는 최대 1 PFLOP의 AI 성능과 128GB 통합 메모리를 제공하여 Jetson AGX Thor의 2070 TFLOPS 및 128GB 메모리에 비해 Jetson 장치보다 훨씬 더 많은 컴퓨팅 성능을 제공합니다. DGX Spark는 데스크톱 AI 슈퍼컴퓨터로 설계되었으며, Jetson 장치는 엣지 배포에 최적화된 임베디드 시스템입니다.

DGX Spark와 Jetson AGX Thor에 동일한 Docker 이미지를 사용할 수 있습니까?

예! ultralytics/ultralytics:latest-nvidia-arm64 Docker 이미지는 NVIDIA DGX Spark (DGX OS 포함)와 Jetson AGX Thor (JetPack 7.0 포함)를 모두 지원합니다. 둘 다 CUDA 13 및 유사한 소프트웨어 스택을 갖춘 ARM64 아키텍처를 사용하기 때문입니다.