Model Değerlendirmesi ve İnce Ayarı Hakkında Bilgiler

Giriş

Bilgisayar görüşü modelinizi eğittikten sonra, optimum şekilde performans göstermesi için onu değerlendirmek ve iyileştirmek çok önemlidir. Sadece modelinizi eğitmek yeterli değildir. Modelinizin doğru, verimli olduğundan ve bilgisayar görüşü projenizin amacını yerine getirdiğinden emin olmanız gerekir. Modelinizi değerlendirerek ve ince ayar yaparak, zayıflıkları belirleyebilir, doğruluğunu artırabilir ve genel performansı yükseltebilirsiniz.

İzle: Model Değerlendirmesi ve İnce Ayarına İlişkin İçgörüler | Ortalama Kesinlik Değerini İyileştirmeye Yönelik İpuçları

Bu kılavuzda, bir bilgisayar görüşü projesinin bu adımını daha erişilebilir kılmak için model değerlendirme ve ince ayar hakkında bilgiler paylaşıyoruz. Değerlendirme metriklerini nasıl anlayacağınızı ve ince ayar tekniklerini nasıl uygulayacağınızı tartışarak, modelinizin yeteneklerini yükseltmek için size bilgi sağlıyoruz.

Metrikleri Kullanarak Model Performansını Değerlendirme

Bir modelin ne kadar iyi performans gösterdiğini değerlendirmek, ne kadar etkili çalıştığını anlamamıza yardımcı olur. Performansı ölçmek için çeşitli metrikler kullanılır. Bu performans metrikleri, modelin amaçlanan hedeflere ulaştığından emin olmak için iyileştirmelere rehberlik edebilecek net, sayısal bilgiler sağlar. Şimdi birkaç temel metriğe daha yakından bakalım.

Güven Puanı

Güvenilirlik skoru, modelin algılanan bir nesnenin belirli bir sınıfa ait olduğundan ne kadar emin olduğunu temsil eder. 0 ile 1 arasında değişir; daha yüksek skorlar daha fazla güveni gösterir. Güvenilirlik skoru, tahminleri filtrelemeye yardımcı olur; yalnızca belirtilen bir eşiğin üzerindeki güvenilirlik skorlarına sahip algılamalar geçerli kabul edilir.

Hızlı İpucu: Çıkarımlar yaparken, herhangi bir tahmin göremiyorsanız ve diğer her şeyi kontrol ettiyseniz, güven skorunu düşürmeyi deneyin. Bazen, eşik çok yüksek olduğundan model geçerli tahminleri göz ardı eder. Skoru düşürmek, modelin daha fazla olasılığı değerlendirmesine olanak tanır. Bu, proje hedeflerinizi karşılamayabilir, ancak modelin neler yapabileceğini görmek ve ince ayar yapmaya nasıl karar vereceğiniz için iyi bir yoldur.

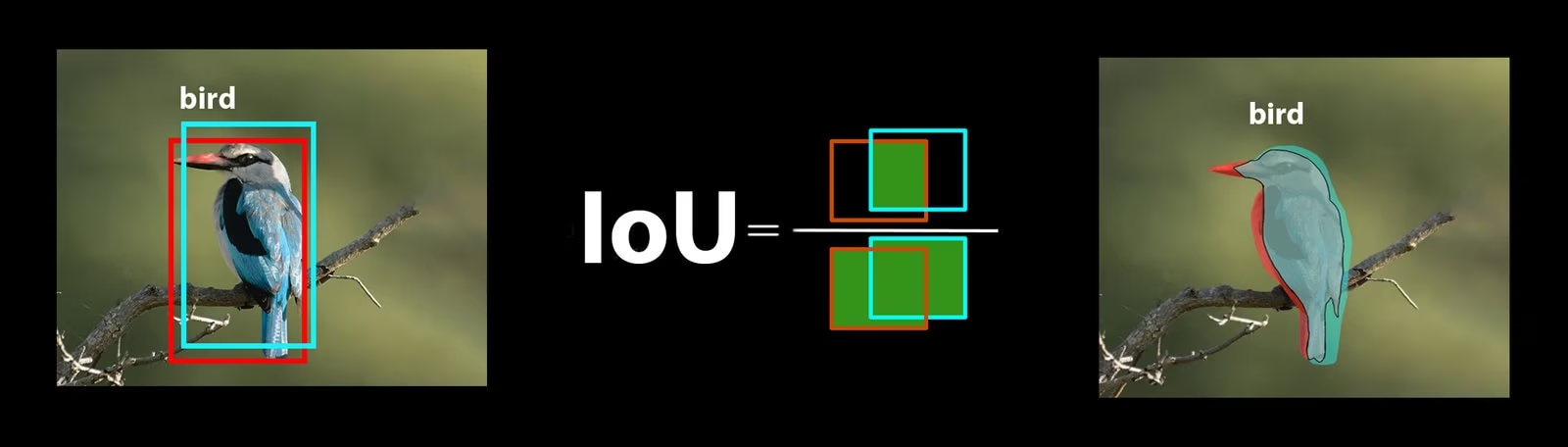

Kesişim Üzerinden Birleşim (Intersection over Union)

Kesişim Üzerinden Birleşim (IoU), tahmin edilen sınırlayıcı kutunun gerçek sınırlayıcı kutu ile ne kadar iyi örtüştüğünü ölçen bir nesne algılama metriğidir. IoU değerleri 0 ile 1 arasında değişir; burada bir, mükemmel bir eşleşmeyi temsil eder. IoU, tahmin edilen sınırların gerçek nesne sınırlarıyla ne kadar yakından eşleştiğini ölçtüğü için önemlidir.

Ortalama Ortalama Hassasiyet

Ortalama Kesinlik Değeri (mAP), bir nesne tespit modelinin ne kadar iyi performans gösterdiğini ölçmenin bir yoludur. Her nesne sınıfını tespit etme kesinliğine bakar, bu skorların ortalamasını alır ve modelin nesneleri ne kadar doğru bir şekilde tanımlayıp sınıflandırabildiğini gösteren genel bir sayı verir.

Şimdi iki belirli mAP metriğine odaklanalım:

- mAP@.5: 0,5'lik tek bir IoU (Kesişim Alanı) eşiğinde ortalama hassasiyeti ölçer. Bu metrik, modelin daha gevşek bir doğruluk gereksinimiyle nesneleri doğru bir şekilde bulup bulamadığını kontrol eder. Mükemmel yerleşime ihtiyaç duymadan nesnenin kabaca doğru yerde olup olmadığına odaklanır. Modelin nesneleri tespit etmede genel olarak iyi olup olmadığını görmeye yardımcı olur.

- mAP@.5:.95: mAP değerlerinin 0,05'lik artışlarla 0,5'ten 0,95'e kadar birden fazla IoU eşiğinde hesaplanmasının ortalamasıdır. Bu metrik daha ayrıntılı ve katıdır. Modelin farklı katılık düzeylerinde nesneleri ne kadar doğru bulabildiğinin daha eksiksiz bir resmini verir ve özellikle hassas nesne tespiti gerektiren uygulamalar için kullanışlıdır.

Diğer mAP ölçütleri arasında, 0,75'lik daha katı bir IoU eşiği kullanan mAP@0.75 ve farklı boyutlardaki nesneler genelinde hassasiyeti değerlendiren mAP@small, medium ve large bulunur.

YOLO26 Model Performansını Değerlendirme

YOLO26 ile ilgili olarak, modeli değerlendirmek için doğrulama modunu kullanabilirsiniz. Ayrıca, YOLO26 performans metriklerini ve bunların nasıl yorumlanabileceğini derinlemesine inceleyen rehberimize göz atmayı unutmayın.

Toplulukta Sıkça Sorulan Sorular

YOLO26 modelinizi değerlendirirken bazı aksaklıklarla karşılaşabilirsiniz. Ortak topluluk sorularına dayanarak, YOLO26 modelinizden en iyi şekilde yararlanmanıza yardımcı olacak bazı ipuçları şunlardır:

Değişken Görüntü Boyutlarını İşleme

YOLO26 modelinizi farklı boyutlardaki görüntülerle değerlendirmek, çeşitli veri kümelerindeki performansını anlamanıza yardımcı olabilir. Şunu kullanarak: rect=true doğrulama parametresi, YOLO26 ağın adımını her parti için görüntü boyutlarına göre ayarlar ve modelin dikdörtgen görüntüleri tek bir boyuta zorlamadan işlemesine olanak tanır.

imgsz validation parametresi, görüntü yeniden boyutlandırma için maksimum boyutu ayarlar ve bu varsayılan olarak 640'tır. Bunu, veri kümenizin maksimum boyutlarına ve mevcut GPU belleğine göre ayarlayabilirsiniz. Şununla bile imgsz ayarla, rect=true modelin adımı dinamik olarak ayarlayarak değişen görüntü boyutlarını etkili bir şekilde yönetmesini sağlar.

YOLO26 Metriklerine Erişim

YOLO26 modelinizin performansına dair daha derinlemesine bir anlayış elde etmek istiyorsanız, birkaç satır Python koduyla belirli değerlendirme metriklerine kolayca erişebilirsiniz. Aşağıdaki kod parçacığı, modelinizi yüklemenize, bir değerlendirme çalıştırmanıza ve modelinizin ne kadar iyi performans gösterdiğini gösteren çeşitli metrikleri yazdırmanıza olanak tanır.

Kullanım

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Run the evaluation

results = model.val(data="coco8.yaml")

# Print specific metrics

print("Class indices with average precision:", results.ap_class_index)

print("Average precision for all classes:", results.box.all_ap)

print("Average precision:", results.box.ap)

print("Average precision at IoU=0.50:", results.box.ap50)

print("Class indices for average precision:", results.box.ap_class_index)

print("Class-specific results:", results.box.class_result)

print("F1 score:", results.box.f1)

print("F1 score curve:", results.box.f1_curve)

print("Overall fitness score:", results.box.fitness)

print("Mean average precision:", results.box.map)

print("Mean average precision at IoU=0.50:", results.box.map50)

print("Mean average precision at IoU=0.75:", results.box.map75)

print("Mean average precision for different IoU thresholds:", results.box.maps)

print("Mean results for different metrics:", results.box.mean_results)

print("Mean precision:", results.box.mp)

print("Mean recall:", results.box.mr)

print("Precision:", results.box.p)

print("Precision curve:", results.box.p_curve)

print("Precision values:", results.box.prec_values)

print("Specific precision metrics:", results.box.px)

print("Recall:", results.box.r)

print("Recall curve:", results.box.r_curve)

Sonuçlar nesnesi ayrıca ön işleme süresi, çıkarım süresi, kayıp ve son işleme süresi gibi hız metriklerini de içerir. Bu metrikleri analiz ederek, YOLO26 modelinizi daha iyi performans için ince ayar yapabilir ve optimize edebilir, böylece belirli kullanım durumunuz için daha etkili hale getirebilirsiniz.

İnce Ayar Nasıl Çalışır?

İnce ayar, önceden eğitilmiş bir modeli alıp belirli bir görev veya veri kümesi üzerindeki performansı artırmak için parametrelerini ayarlamayı içerir. Model yeniden eğitimi olarak da bilinen bu süreç, modelin gerçek dünya uygulamalarında karşılaşacağı belirli veriler için sonuçları daha iyi anlamasını ve tahmin etmesini sağlar. Optimum sonuçlar elde etmek için modelinizi model değerlendirmenize göre yeniden eğitebilirsiniz.

Modelinizi İyileştirmek İçin İpuçları

Bir modeli ince ayar yapmak, optimum performansı elde etmek için çeşitli önemli parametrelere ve tekniklere yakından dikkat etmek anlamına gelir. Süreç boyunca size yol gösterecek bazı temel ipuçları şunlardır.

Daha Yüksek Bir Öğrenme Oranı ile Başlamak

Genellikle, ilk eğitim evrelerinde, öğrenme oranı düşük başlar ve eğitim sürecini stabilize etmek için kademeli olarak artar. Ancak, modeliniz önceki veri kümesinden bazı özellikleri zaten öğrendiğinden, daha yüksek bir öğrenme oranıyla başlamak daha faydalı olabilir.

YOLO26 modelinizi değerlendirirken şunu ayarlayabilirsiniz: warmup_epochs validation parametresini warmup_epochs=0 öğrenme oranının çok düşük başlamasını önlemek için. Bu işlemi takip ederek, eğitim sağlanan ağırlıklardan devam edecek ve yeni verilerinizin nüanslarına göre ayarlanacaktır.

Küçük Nesneler İçin Görüntü Döşemesi

Görüntü döşeme, küçük nesneler için tespit doğruluğunu artırabilir. Daha büyük görüntüleri, örneğin 1280x1280 görüntüleri birden çok 640x640 segmente ayırmak gibi, daha küçük segmentlere bölerek orijinal çözünürlüğü korursunuz ve model yüksek çözünürlüklü parçalardan öğrenebilir. YOLO26 kullanırken, bu yeni segmentler için etiketlerinizi doğru şekilde ayarladığınızdan emin olun.

Toplulukla Etkileşim Kurun

Fikirlerinizi ve sorularınızı diğer bilgisayar görüşü meraklılarıyla paylaşmak, projelerinizdeki engellere yaratıcı çözümler bulmanıza ilham verebilir. İşte öğrenmek, sorun gidermek ve bağlantı kurmak için bazı mükemmel yollar.

Yardım ve Destek Bulma

- GitHub Sorunları: YOLO26 GitHub deposunu keşfedin ve soru sormak, hata bildirmek ve özellik önermek için Sorunlar sekmesini kullanın. Topluluk ve sürdürücüler, karşılaştığınız her türlü sorunda yardımcı olmaya hazırdır.

- Ultralytics Discord Sunucusu: Diğer kullanıcılar ve geliştiricilerle bağlantı kurmak, destek almak, bilgi paylaşmak ve fikir alışverişinde bulunmak için Ultralytics Discord sunucusuna katılın.

Resmi Belgelendirme

- Ultralytics YOLO26 Dokümantasyonu: Çeşitli bilgisayar görüşü görevleri ve projeleri hakkında kapsamlı rehberler ve değerli bilgiler için resmi YOLO26 dokümantasyonuna göz atın.

Son Düşünceler

Bilgisayar görüşü modelinizi değerlendirmek ve ince ayar yapmak, başarılı model dağıtımı için önemli adımlardır. Bu adımlar, modelinizin doğru, verimli ve genel uygulamanıza uygun olduğundan emin olmanıza yardımcı olur. Mümkün olan en iyi modeli eğitmenin anahtarı, sürekli deney yapmak ve öğrenmektir. Parametreleri değiştirmekten, yeni teknikler denemekten ve farklı veri kümelerini keşfetmekten çekinmeyin. Denemeye devam edin ve olasılıkların sınırlarını zorlayın!

SSS

YOLO26 model performansını değerlendirmek için ana metrikler nelerdir?

YOLO26 model performansını değerlendirmek için önemli metrikler arasında Güven Skoru, Kesişim Üzeri Birleşim (IoU) ve Ortalama Kesinlik (mAP) bulunur. Güven Skoru, modelin tespit edilen her nesne sınıfı için kesinliğini ölçer. IoU, tahmini sınırlayıcı kutunun gerçek doğrulukla ne kadar iyi örtüştüğünü değerlendirir. Ortalama Kesinlik (mAP), sınıflar arası kesinlik skorlarını birleştirir; mAP@.5 ve mAP@.5:.95, değişen IoU eşikleri için iki yaygın türdür. Bu metrikler hakkında daha fazla bilgiyi YOLO26 performans metrikleri rehberimizde bulabilirsiniz.

Belirli veri kümem için önceden eğitilmiş bir YOLO26 modeline nasıl ince ayar yapabilirim?

Önceden eğitilmiş bir YOLO26 modeline ince ayar yapmak, belirli bir görev veya veri kümesinde performansı iyileştirmek için parametrelerini ayarlamayı içerir. Modelinizi metrikler kullanarak değerlendirerek başlayın, ardından şunu ayarlayarak daha yüksek bir başlangıç öğrenme oranı belirleyin: warmup_epochs parametresini anında kararlılık için 0'a ayarlayın. Şu parametreleri kullanın: rect=true değişken görüntü boyutlarını etkili bir şekilde işlemek için. Daha ayrıntılı rehberlik için, bölümümüze bakın: YOLO26 modellerine ince ayar yapma.

YOLO26 modelimi değerlendirirken değişken görüntü boyutlarını nasıl ele alabilirim?

Değerlendirme sırasında değişken görüntü boyutlarını işlemek için şunu kullanın: rect=true YOLO26'daki parametre, ağın adımını görüntü boyutlarına göre her parti için ayarlar. Şunu: imgsz parametresi, görüntü yeniden boyutlandırma için maksimum boyutu ayarlar ve varsayılan olarak 640'tır. Şunu ayarlayın: imgsz veri kümenize ve GPU belleğinize uyacak şekilde. Daha fazla ayrıntı için, değişken görüntü boyutlarını işleme bölümü.

YOLO26 modelimin ortalama kesinliğini (mAP) iyileştirmek için hangi pratik adımları atabilirim?

Bir YOLO26 modeli için ortalama hassasiyeti (mAP) iyileştirmek birkaç adım içerir:

- Hiperparametreleri Ayarlama: Farklı öğrenme oranları, batch boyutları ve görsel zenginleştirmeleri ile deneyler yapın.

- Veri Artırma: Çeşitli eğitim örnekleri oluşturmak için Mozaik ve MixUp gibi teknikleri kullanın.

- Görüntü Döşemeleme: Küçük nesneler için detect doğruluğunu artırmak için daha büyük görüntüleri daha küçük döşemelere bölün. Belirli stratejiler için model ince ayarı hakkındaki ayrıntılı kılavuzumuza başvurun.

Python'da YOLO26 model değerlendirme metriklerine nasıl erişirim?

YOLO26 model değerlendirme metriklerine aşağıdaki adımlarla Python kullanarak erişebilirsiniz:

Kullanım

from ultralytics import YOLO

# Load the model

model = YOLO("yolo26n.pt")

# Run the evaluation

results = model.val(data="coco8.yaml")

# Print specific metrics

print("Class indices with average precision:", results.ap_class_index)

print("Average precision for all classes:", results.box.all_ap)

print("Mean average precision at IoU=0.50:", results.box.map50)

print("Mean recall:", results.box.mr)

Bu metrikleri analiz etmek, YOLO26 modelinizi ince ayar yapmaya ve optimize etmeye yardımcı olur. Daha derinlemesine bir inceleme için, YOLO26 metrikleri hakkındaki rehberimize göz atın.