Ultralytics Platform

Ultralytics Platform 是一个全面的端到端计算机视觉平台,它简化了从数据准备到模型部署的整个机器学习工作流程。它专为需要生产级计算机视觉解决方案但又不想处理复杂基础设施的团队和个人而设计。

什么是 Ultralytics Platform?

Ultralytics Platform 旨在用统一的解决方案取代分散的机器学习工具。它结合了以下功能:

- Roboflow - 数据管理和标注

- Weights & Biases - 实验跟踪

- SageMaker - 云训练

- HuggingFace - 模型部署

- Arize - 监控

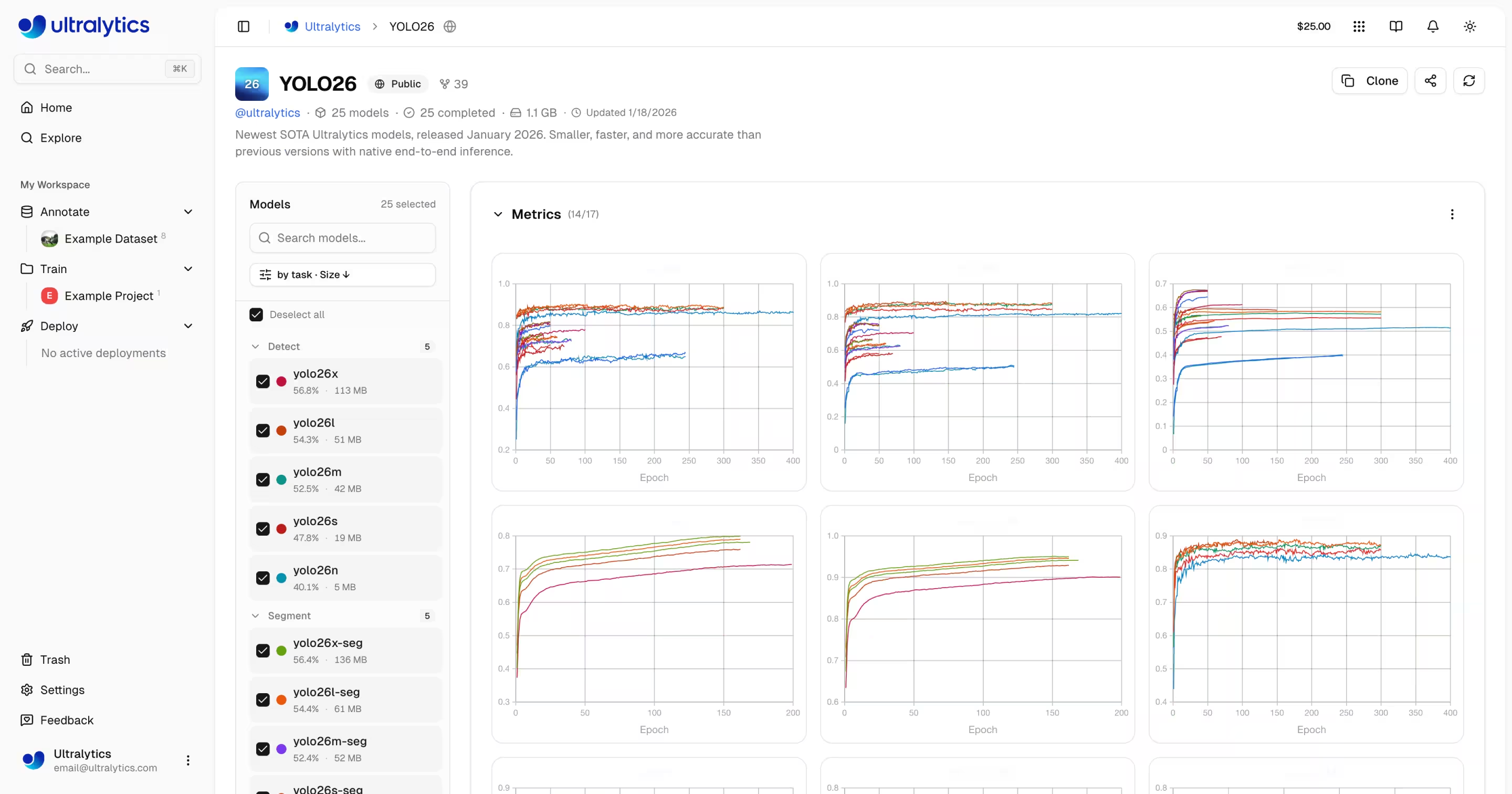

一体化平台,原生支持YOLO26和YOLO11 。

工作流:上传 → 标注 → 训练 → 导出 → 部署

该平台提供端到端的工作流:

graph LR

subgraph Data["📁 Data"]

A[Upload] --> B[Annotate]

B --> C[Analyze]

end

subgraph Train["🚀 Train"]

D[Configure] --> E[Train on GPU]

E --> F[View Metrics]

end

subgraph Deploy["🌐 Deploy"]

G[Export] --> H[Deploy Endpoint]

H --> I[Monitor]

end

Data --> Train --> Deploy| 阶段 | 功能 |

|---|---|

| 上传 | 图片(50MB)、视频(1GB)、ZIP压缩包(50GB)支持自动处理 |

| 标注 | 手动标注工具、SAM 标注、YOLO (适用于全部5种任务类型) |

| 训练 | 云端GPU(RTX 4090至H200)、实时指标、项目组织 |

| 导出 | 17种部署格式(ONNX、TensorRT、CoreML、TFLite) |

| 部署 | 43个全球区域配备专用端点、自动扩展和监控功能 |

你可以做些什么:

- 上传图像、视频和ZIP压缩包以创建训练数据集

- 通过交互式叠加层可视化 YOLO 类型的注释

- 在云端GPU(RTX 4090至H200)上训练模型,并提供实时指标

- 导出至17种部署格式(ONNX、TensorRT、CoreML、TFLite)

- 一键部署至全球43个区域的专用端点

- 监控培训进度、部署健康状况和使用指标

- 通过将项目和数据集公开给社区来促进协作

多区域基础设施

您的数据保留在您所在的区域。Ultralytics Platform 在全球三个区域运营基础设施:

| 区域 | 位置 | 最适合 |

|---|---|---|

| 美国 | 爱荷华州,美国 | 美洲用户,美洲最快 |

| 欧盟 | 比利时,欧洲 | 欧洲用户,符合 GDPR 规定 |

| AP | 台湾,亚太地区 | 亚太地区用户,最低亚太延迟 |

您在入职时选择您的区域,所有数据、模型和部署都将保留在该区域。

主要功能

数据准备

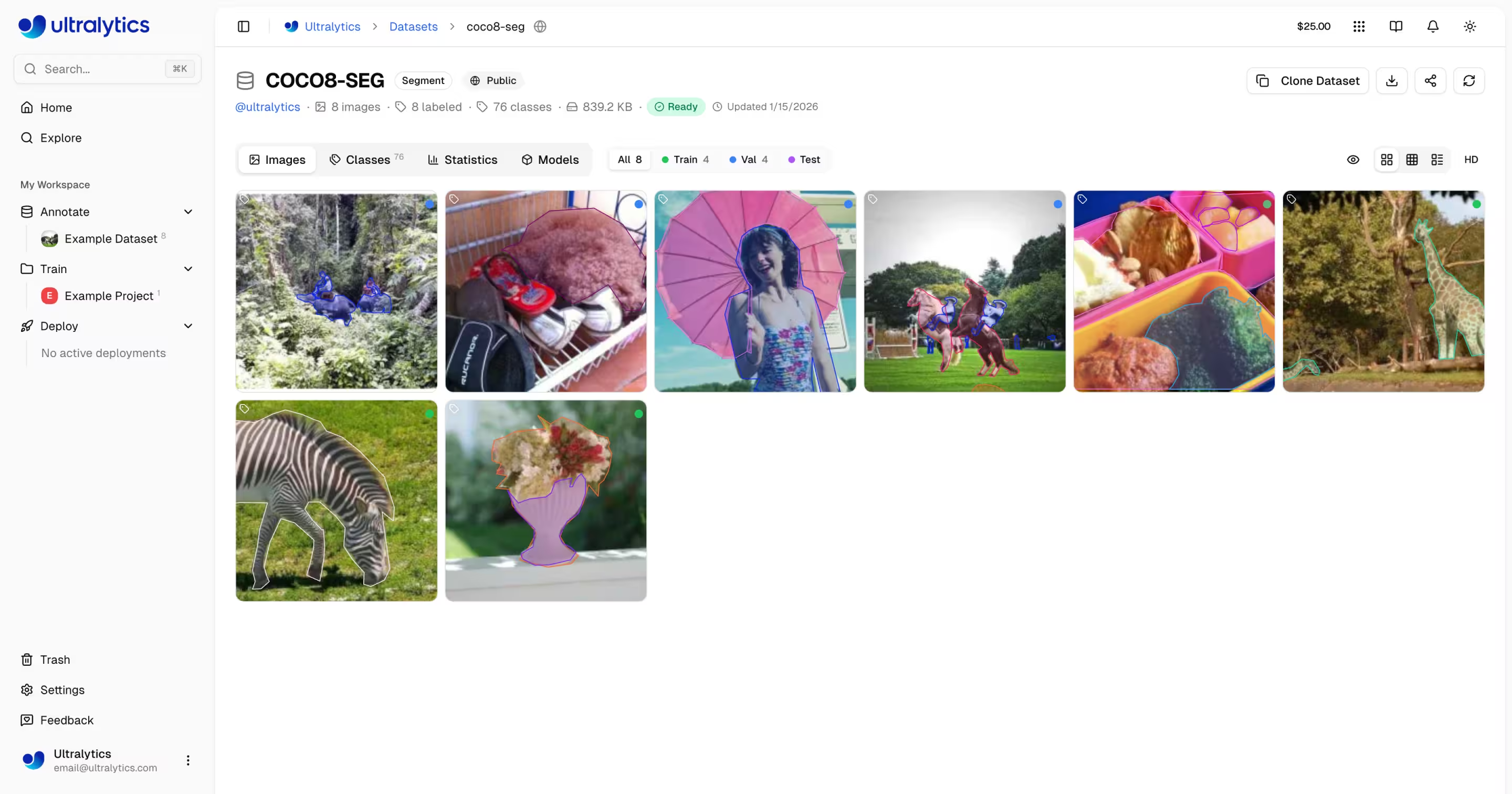

- 数据集管理: 上传图像、视频或ZIP压缩包,并进行自动处理

- 标注编辑器: 对所有5种YOLO任务类型(detect、segment、姿势估计、旋转框检测、classify)进行手动标注

- SAM智能标注: 使用Segment Anything Model进行基于点击的智能标注

- 自动标注: 使用训练好的模型预标注新数据

- 统计数据: 类别分布、位置热图和维度分析

模型训练

- 云端训练: 在云端GPU(RTX 4090、A100、H100)上进行训练,并提供实时指标

- 远程训练: 在任何地方进行训练,并将指标流式传输到平台(W&B风格)

- 项目组织: 对相关模型进行分组、比较实验、跟踪活动

- 17种导出格式: ONNX、TensorRT、CoreML、TFLite等

部署

- 推理测试: 直接在浏览器中使用自定义图像测试模型

- 专用端点: 部署到全球43个区域,支持自动扩缩容

- 监控: 实时指标、请求日志和性能仪表板

账户管理

- API密钥: 用于远程训练和API访问的安全密钥管理

- 积分与计费: 按需付费训练,价格透明

- 活动动态:追踪所有账户事件和操作

- 垃圾箱与恢复:30天软删除,支持项目恢复

- GDPR合规性: 数据导出和账户删除

快速链接

通过以下资源开始使用:

- 快速入门: 在几分钟内创建您的第一个项目并训练模型

- 数据集: 上传和管理您的训练数据

- 标注: 使用手动和AI辅助工具标注您的数据

- 项目: 组织您的模型和实验

- 云端训练: 在云端GPU上进行训练

- 推理: 测试您的模型

- 端点: 将模型部署到生产环境

- 监控:跟踪部署性能

- API 密钥:管理 API 访问

- 计费:积分与支付

- 活动: 追踪账户事件

- 垃圾: 恢复已删除项目

- REST API:API 参考

常见问题

如何开始使用 Ultralytics Platform?

开始使用Ultralytics Platform:

- 注册:在platform.ultralytics.com创建账户

- 选择区域:在入职过程中选择您的数据区域(美国、欧盟或亚太地区)

- 上传数据集:导航到数据集部分上传您的数据

- 训练模型:创建项目并在云 GPU 上开始训练

- 部署:测试您的模型并部署到专用端点

有关详细指南,请参阅快速入门页面。

Ultralytics Platform 有哪些优势?

- 统一工作流:数据、训练和部署一站式完成

- 多区域支持:数据驻留在美国、欧盟或亚太地区

- 无代码训练:无需编写代码即可训练高级 YOLO 模型

- 实时指标:实时传输训练进度并监控部署

- 43 个部署区域:在全球范围内将模型部署到靠近用户的位置

- 5 种任务类型:支持 detect、segment、姿势估计、obb 和分类

- AI 辅助标注:SAM 和自动标注以加快数据准备

云训练有哪些 GPU 选项可用?

Ultralytics Platform 支持多种 GPU 类型用于云训练:

| 层级 | GPU | 显存 | 每小时费用 | 最适合 |

|---|---|---|---|---|

| 预算 | RTX A2000 | 6 GB | $0.12 | 小数据集,测试 |

| 预算 | RTX 3080 | 10 GB | $0.25 | 中等规模的数据集 |

| 预算 | RTX 3080 Ti | 12 GB | $0.30 | 中等规模的数据集 |

| 预算 | A30 | 24 GB | $0.44 | 更大的批量 |

| 中 | RTX 4090 | 24 GB | $0.60 | 极佳性价比 |

| 中 | A6000 | 48 GB | $0.90 | 大型模型 |

| 中 | L4 | 24 GB | $0.54 | 推理优化 |

| 中 | L40S | 48 GB | $1.72 | 大规模批量训练 |

| Pro | A100 40GB | 40 GB | $2.78 | 生产培训 |

| Pro | A100 80GB | 80 GB | $3.44 | 超大型模型 |

| Pro | H100 | 80 GB | $5.38 | 最快的训练 |

| 企业版 | H200 | 141 GB | $5.38 | 最高性能 |

| 企业版 | B200 | 192 GB | $10.38 | 最大模型 |

| Ultralytics | RTX PRO 6000 | 48 GB | $3.68 | Ultralytics |

有关完整定价和GPU ,请参阅云端培训。

远程训练如何运作?

您可以在任何地方训练模型,并将指标流式传输到平台。

软件包版本要求

平台集成需要ultralytics>=8.4.0。较低版本将无法与平台配合使用。

pip install "ultralytics>=8.4.0"

# Set your API key

export ULTRALYTICS_API_KEY="your_api_key"

# Train with project/name to stream metrics

yolo train model=yolo26n.pt data=coco.yaml epochs=100 project=username/my-project name=exp1

有关远程训练的更多详细信息,请参阅云训练。

有哪些标注工具可用?

平台包含一个功能齐全的标注编辑器,支持:

- 手动工具:边界框、多边形、关键点、定向框、分类

- SAM 智能标注:点击使用 Segment Anything Model 生成精确掩码

- YOLO 自动标注:使用训练好的模型预标注图像

- 键盘快捷键:通过热键实现高效工作流

有关完整指南,请参阅标注。

故障排除

数据集问题

| 问题 | 解决方案 |

|---|---|

| 数据集无法处理 | 检查文件格式是否受支持(JPEG、PNG、WebP等)。最大文件大小:图片50MB,视频1GB,ZIP压缩包50GB。 |

| 缺失的注释 | 验证标签是否采用YOLO .txt 匹配图像文件名的文件 |

| 需要列车分段运行 | 添加 train/ 将文件夹添加到数据集结构中,或在数据集设置中创建分割 |

| 类名未定义 | 添加一个 data.yaml 文件与 names: 在数据集设置中列出或定义类 |

培训问题

| 问题 | 解决方案 |

|---|---|

| 培训不会开始 | 在“设置”>“账单”中查看信用余额。最低余额要求为5.00美元。 |

| 内存不足错误 | 减少批量大小,使用较小的模型(n/s),或选择GPU 更大显存GPU 。 |

| 糟糕的指标 | 检查数据集质量,增加训练周期数,尝试数据增强,验证类别平衡性 |

| 训练缓慢 | 选择更快的GPU,缩小图像尺寸,检查数据集是否存在瓶颈 |

部署问题

| 问题 | 解决方案 |

|---|---|

| 端点未响应 | 检查端点状态(运行中 vs 已停止)。冷启动可能需要2-5秒。 |

| 401 未授权 | 验证API密钥是否正确且具有所需权限范围 |

| 缓慢推理 | 检查模型大小,考虑TensorRT ,选择更近的区域 |

| 导出失败 | 某些格式需要特定的模型架构。ONNX 最广泛的兼容性。 |

常见问题

注册后可以更改用户名吗?

不,用户名是永久性的,无法更改。注册时请谨慎选择。

我可以更改我的数据区域吗?

不,数据区域在注册时选定后无法更改。若需切换区域,请创建新账户并重新上传您的数据。

如何获得更多学分?

前往设置 > 账单 > 添加点数。购买点数金额范围为5美元至1000美元。已购买点数永不过期。

如果训练失败怎么办?

您仅需为已完成的计算时间付费。检查点会被保存,您可以继续训练。

我可以下载我训练好的模型吗?

是的,点击任意模型页面的下载图标即可下载。 .pt 文件或导出格式。

如何公开分享我的作品?

编辑项目或数据集设置,并将可见性切换为"公开"。公开内容将显示在探索页面上。

文件大小限制是多少?

图片:50MB,视频:1GB,ZIP压缩包:50GB。若文件更大,请拆分多次上传。

已删除的项目在废纸篓中保留多长时间?

30天。此后,项目将被永久删除且无法恢复。

我能否将平台模型用于商业用途?

免费版和专业版采用AGPL许可证。如需商业用途且不适用AGPL要求,请联系ultralytics获取企业版授权。