SAM 3: segment أي شيء باستخدام المفاهيم

متوفر الآن في Ultralytics

تم دمج SAM 3 بالكامل في حزمة Ultralytics اعتبارًا من الإصدار 8.3.237 (PR #22897). قم بالتثبيت أو الترقية باستخدام pip install -U ultralytics للوصول إلى جميع ميزات SAM 3 بما في ذلك تجزئة المفاهيم المستندة إلى النص، ومطالبات أمثلة الصور، وتتبع الفيديو.

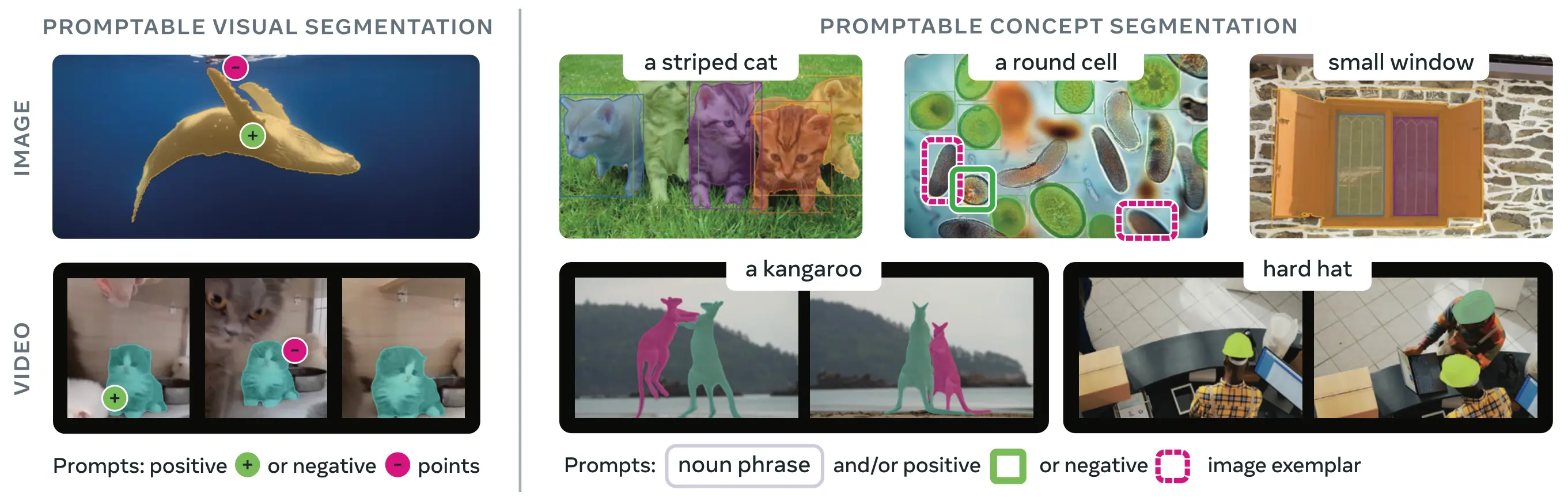

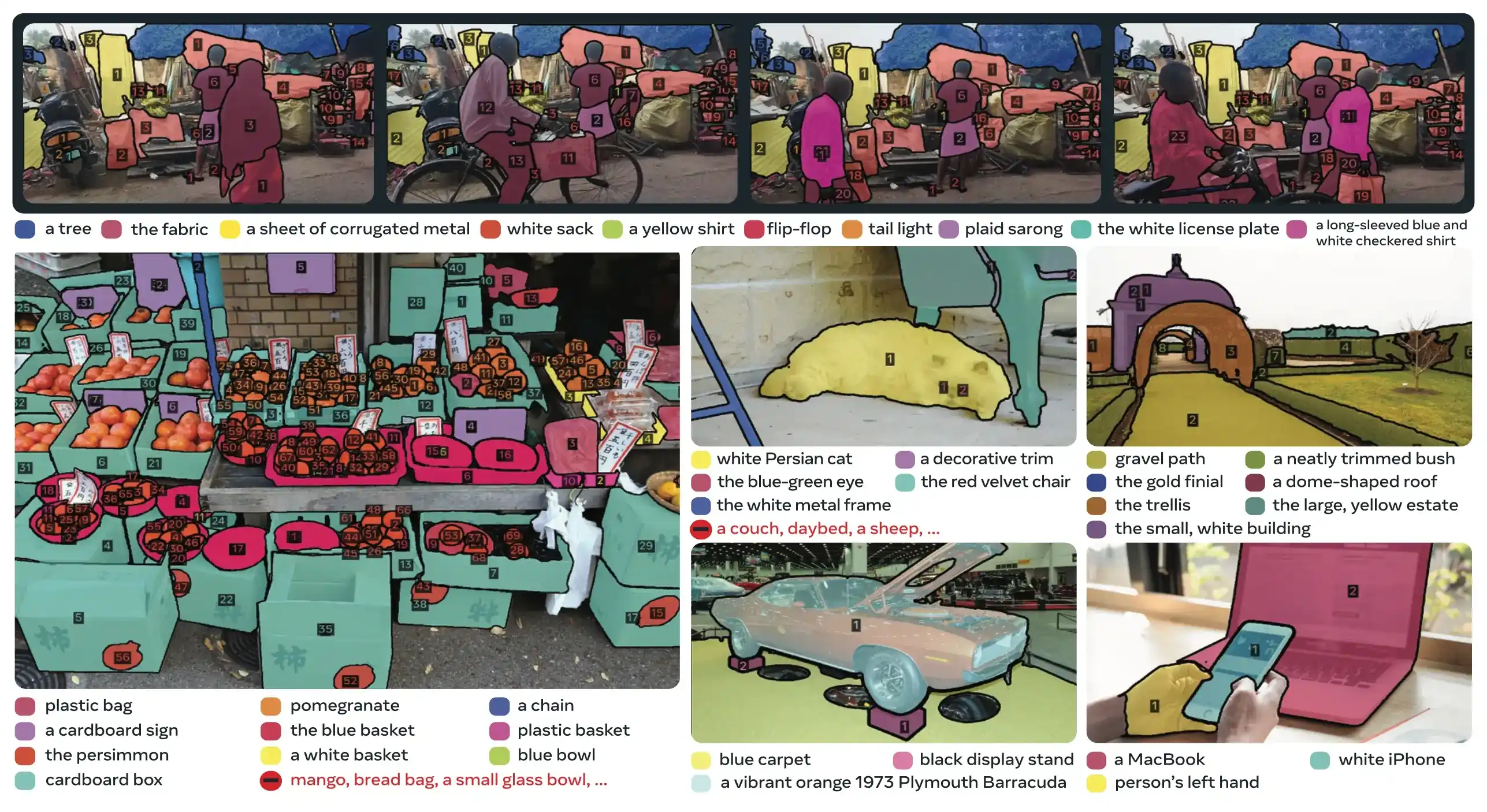

SAM 3 (نموذج تجزئة أي شيء 3) هو النموذج الأساسي الذي أصدرته Meta لـ تجزئة المفاهيم القابلة للتوجيه (PCS). بناءً على SAM 2، يقدم SAM 3 قدرة جديدة جوهرية: detect، segment، وtrack جميع حالات المفهوم البصري المحدد بواسطة مطالبات نصية، أو أمثلة صور، أو كليهما. على عكس إصدارات SAM السابقة التي تقوم بتجزئة كائنات فردية لكل مطالبة، يمكن لـ SAM 3 العثور على كل تكرار لمفهوم يظهر في أي مكان في الصور أو مقاطع الفيديو وتجزئته، بما يتماشى مع أهداف المفردات المفتوحة في تجزئة الحالات الحديثة.

شاهد: كيفية استخدام Meta Segment Anything 3 مع Ultralytics | تجزئة الصور ومقاطع الفيديو بناءً على المطالبات النصية

تم دمج SAM 3 الآن بالكامل في ultralytics الحزمة، مما يوفر دعمًا أصليًا لتجزئة المفاهيم باستخدام المطالبات النصية، ومطالبات أمثلة الصور، وقدرات تتبع الفيديو.

نظرة عامة

يحقق SAM 3 مكسبًا في الأداء بمقدار الضعف مقارنة بالأنظمة الحالية في تقسيم المفاهيم القابلة للمطالبة مع الحفاظ على قدرات SAM 2 وتحسينها للـ تقسيم المرئي التفاعلي. يتفوق النموذج في تقسيم المفردات المفتوحة، مما يسمح للمستخدمين بتحديد المفاهيم باستخدام عبارات اسمية بسيطة (مثل "حافلة مدرسية صفراء"، "قطة مخططة") أو عن طريق تقديم أمثلة لصور الجسم المستهدف. تكمل هذه القدرات خطوط الإنتاج الجاهزة التي تعتمد على التنبؤ و تتبع سير العمل المبسط.

ما هو تجزئة المفهوم القابل للتوجيه (PCS)؟

تأخذ مهمة PCS موجه مفهوم كمدخل وتعيد أقنعة تجزئة بهويات فريدة لـ جميع مثيلات الكائنات المطابقة. يمكن أن تكون مطالبات المفهوم:

- نص: عبارات اسمية بسيطة مثل "تفاحة حمراء" أو "شخص يرتدي قبعة"، على غرار التعلم الصفري

- أمثلة الصور: مربعات إحاطة حول أمثلة للكائنات (إيجابية أو سلبية) لتعميم سريع

- مدمج: كل من النصوص والنماذج التصويرية معًا لتحكم دقيق.

يختلف هذا عن المطالبات المرئية التقليدية (النقاط والمربعات والأقنعة) التي تقوم بتقسيم مثيل كائن معين واحد فقط، كما هو شائع في عائلة SAM الأصلية.

مقاييس الأداء الرئيسية

| مقياس (Metric) | إنجاز SAM 3 |

|---|---|

| LVIS Zero-Shot Mask AP | 47.0 (مقابل أفضل رقم سابق 38.5، تحسن +22%) |

| معيار SA-Co | أفضل بمرتين من الأنظمة الحالية |

| سرعة الاستدلال (H200 GPU) | 30 مللي ثانية لكل صورة مع الكشف عن 100+ كائن |

| أداء الفيديو | شبه فوري لما يقرب من 5 كائنات متزامنة |

| MOSEv2 VOS Benchmark | 60.1 J&F (+25.5% مقارنة بـ SAM 2.1، +17% مقارنة بـ SOTA السابق) |

| التحسين التفاعلي | تحسين +18.6 CGF1 بعد 3 مطالبات نموذجية |

| فجوة الأداء البشري | تحقق 88% من الحد الأدنى المقدر على SA-Co/Gold |

للاطلاع على سياق حول مقاييس النموذج والمفاضلات في الإنتاج، راجع رؤى تقييم النموذج و مقاييس أداء YOLO.

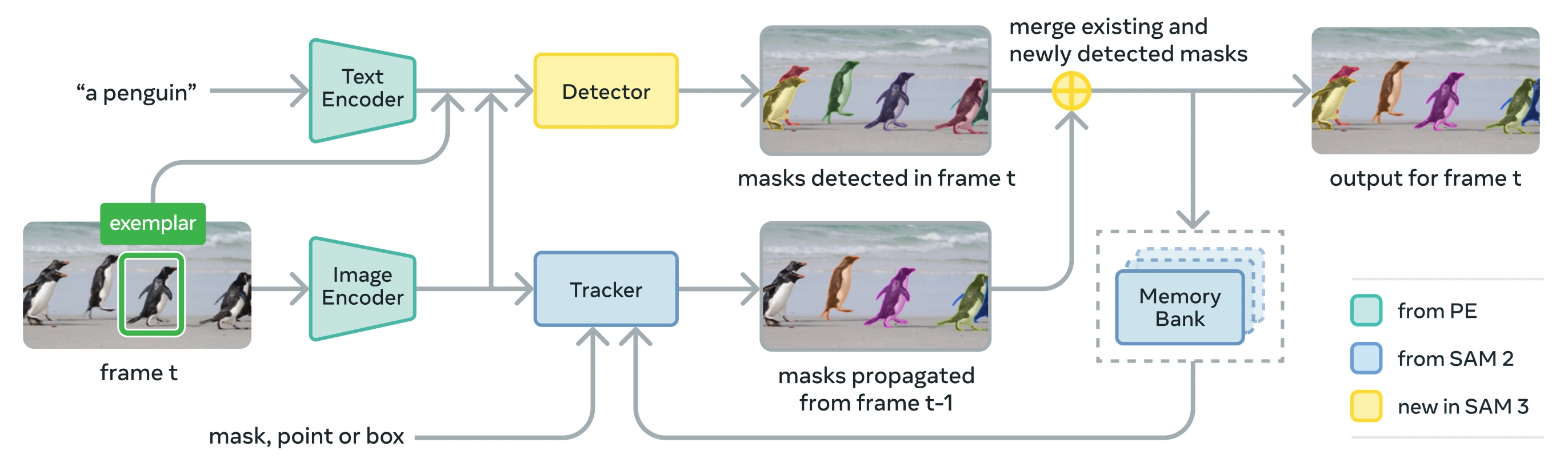

البنية

يتكون SAM 3 من detector و tracker يشتركان في العمود الفقري للرؤية Perception Encoder (PE). يتجنب هذا التصميم المنفصل تعارضات المهام مع تمكين كل من الكشف على مستوى الصورة وتتبع الفيديو على مستوى الفيديو، مع واجهة متوافقة مع استخدام python و استخدام CLI من Ultralytics.

المكونات الأساسية

الكاشف: بنية تعتمد على DETR للكشف عن المفاهيم على مستوى الصورة

- ترميز النص لمطالبات العبارات الاسمية

- ترميز نموذجي للمطالبات المستندة إلى الصور

- ترميز الاندماج لتهيئة ميزات الصورة على المطالبات

- رأس وجود جديد يفصل التعرف ("ماذا") عن التوطين ("أين")

- رأس القناع لتوليد أقنعة تجزئة المثيلات

أداة التتبع: تجزئة الفيديو المستندة إلى الذاكرة والموروثة من SAM 2

- ترميز المطالبة، فك ترميز القناع، ترميز الذاكرة

- بنك الذاكرة لتخزين مظهر الكائن عبر الإطارات

- إزالة الغموض الزمني بمساعدة تقنيات مثل مرشح كالمان (Kalman filter) في إعدادات الكائنات المتعددة

رمز الحضور: رمز عام مُدرَّب يتنبأ بما إذا كان المفهوم المستهدف موجودًا في الصورة/الإطار، مما يحسن الـ detect عن طريق فصل التعرف على الموقع.

الابتكارات الرئيسية

- التعرف والتوطين غير المقترنين: يتوقع رأس الوجود وجود المفهوم عالميًا، بينما تركز استعلامات الاقتراح فقط على التوطين، وتتجنب الأهداف المتضاربة.

- مطالبات مرئية ومفهومية موحدة: يدعم كلاً من PCS (مطالبات المفهوم) و PVS (مطالبات مرئية مثل نقرات / مربعات SAM 2) في نموذج واحد.

- تحسين المثال التفاعلي: يمكن للمستخدمين إضافة أمثلة صور إيجابية أو سلبية لتحسين النتائج بشكل متكرر، مع تعميم النموذج على كائنات مماثلة بدلاً من مجرد تصحيح الحالات الفردية.

- إزالة الغموض الزمني: يستخدم درجات اكتشاف masklet وإعادة المطالبة الدورية للتعامل مع الانسدادات والمشاهد المزدحمة وإخفاقات التتبع في الفيديو، بما يتماشى مع أفضل الممارسات في تقسيم وتتبع المثيلات.

مجموعة بيانات SA-Co

تم تدريب SAM 3 على Segment Anything with Concepts (SA-Co)، وهي أكبر مجموعة بيانات تجزئة وأكثرها تنوعًا حتى الآن من Meta، والتي تتوسع لتتجاوز المعايير الشائعة مثل COCO و LVIS.

بيانات التدريب

| مكون مجموعة البيانات | الوصف | مقياس |

|---|---|---|

| SA-Co/HQ | بيانات صور عالية الجودة مُعلّمة يدويًا من محرك بيانات رباعي المراحل | 5.2 مليون صورة، 4 ملايين عبارة اسمية فريدة |

| SA-Co/SYN | مجموعة بيانات اصطناعية مصنفة بواسطة الذكاء الاصطناعي دون تدخل بشري | 38 مليون عبارة اسمية، 1.4 مليار قناع |

| SA-Co/EXT | 15 مجموعة بيانات خارجية مُثرية بسلبيات صعبة | يختلف حسب المصدر |

| SA-Co/VIDEO | شروحات الفيديو مع التتبع الزمني | 52.5 ألف مقطع فيديو، 24.8 ألف عبارة اسمية فريدة |

بيانات مرجعية

يحتوي معيار التقييم SA-Co على 214 ألف عبارة فريدة عبر 126 ألف صورة ومقطع فيديو، مما يوفر أكثر من 50 ضعفًا من المفاهيم مقارنة بالمعايير الحالية. ويشمل:

- SA-Co/Gold: 7 نطاقات، مشروحة ثلاثياً لقياس حدود الأداء البشري

- SA-Co/Silver: 10 نطاقات، شرح بشري واحد

- SA-Co/Bronze وSA-Co/Bio: 9 مجموعات بيانات موجودة مُكيّفة لتجزئة المفاهيم

- SA-Co/VEval: معيار أداء للفيديو يضم 3 نطاقات (SA-V، YT-Temporal-1B، SmartGlasses)

ابتكارات محرك البيانات

محرك بيانات SAM 3 القابل للتطوير الذي يعتمد على الإنسان والنموذج في الحلقة يحقق إنتاجية تعليقات توضيحية مضاعفة من خلال:

- أدوات الشرح بالذكاء الاصطناعي: تقترح النماذج المستندة إلى Llama عبارات اسمية متنوعة بما في ذلك السلبيات الصعبة.

- أدوات التحقق بالذكاء الاصطناعي: تقوم نماذج اللغة الكبيرة متعددة الوسائط المدربة تدريبًا دقيقًا بالتحقق من جودة الإخفاء والاكتمال بأداء قريب من أداء الإنسان.

- تعدين نشط: يركز الجهد البشري على حالات الفشل الصعبة حيث يعاني الذكاء الاصطناعي

- مدفوعة بعلم الوجود: تستفيد من علم الوجود الكبير المرتكز على Wikidata لتغطية المفهوم

التثبيت

يتوفر SAM 3 في Ultralytics الإصدار 8.3.237 والإصدارات الأحدث. قم بالتثبيت أو الترقية باستخدام:

pip install -U ultralytics

أوزان نموذج SAM 3 مطلوبة

على عكس نماذج Ultralytics الأخرى، أوزان SAM 3 (sam3.pt) لا يتم تنزيلها تلقائيًا. يجب عليك أولاً طلب الوصول إلى أوزان النموذج على صفحة نموذج SAM 3 على Hugging Face ثم، بمجرد الموافقة، قم بتنزيل sam3.pt ملف. ضع الملف الذي تم تنزيله sam3.pt في دليل العمل الخاص بك أو حدد المسار الكامل عند تحميل النموذج.

TypeError: 'SimpleTokenizer' object is not callable

إذا ظهرت لك الرسالة أعلاه أثناء التنبؤ، فهذا يعني أن لديك clip الحزمة المثبتة. قم بتثبيت clip الحزمة عن طريق تشغيل ما يلي:

pip uninstall clip -y

pip install git+https://github.com/ultralytics/CLIP.git

كيفية استخدام SAM 3: تعدد الاستخدامات في تقسيم المفاهيم

يدعم SAM 3 كلاً من مهام تجزئة المفاهيم القابلة للتوجيه (PCS) وتجزئة المرئيات القابلة للتوجيه (PVS) من خلال واجهات تنبؤ مختلفة:

المهام والنماذج المدعومة

| نوع المهمة | أنواع المطالبات | الناتج |

|---|---|---|

| تجزئة المفاهيم (PCS) | نص (عبارات اسمية)، أمثلة صور | جميع الحالات المطابقة للمفهوم |

| التقسيم المرئي (PVS) | النقاط، الصناديق، الأقنعة | مثيل كائن واحد (نمط SAM 2) |

| التحسين التفاعلي | إضافة/إزالة الأمثلة أو النقرات بشكل متكرر | تحسين التجزئة بدقة محسنة |

أمثلة على تجزئة المفاهيم

التقسيم باستخدام مطالبات نصية

تقسيم المفاهيم المستندة إلى النصوص

ابحث و سيجمنت جميع حالات المفهوم باستخدام وصف نصي. تتطلب المطالبات النصية SAM3SemanticPredictor الواجهة.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor with configuration

overrides = dict(

conf=0.25,

task="segment",

mode="predict",

model="sam3.pt",

half=True, # Use FP16 for faster inference

save=True,

)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image once for multiple queries

predictor.set_image("path/to/image.jpg")

# Query with multiple text prompts

results = predictor(text=["person", "bus", "glasses"])

# Works with descriptive phrases

results = predictor(text=["person with red cloth", "person with blue cloth"])

# Query with a single concept

results = predictor(text=["a person"])

التقسيم باستخدام نماذج صور

تقطيع قائم على نموذج الصورة

استخدم مربعات الإحاطة كموجهات بصرية للعثور على جميع الكائنات المتشابهة. يتطلب هذا أيضًا SAM3SemanticPredictor للمطابقة القائمة على المفاهيم.

from ultralytics.models.sam import SAM3SemanticPredictor

# Initialize predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True, save=True)

predictor = SAM3SemanticPredictor(overrides=overrides)

# Set image

predictor.set_image("path/to/image.jpg")

# Provide bounding box examples to segment similar objects

results = predictor(bboxes=[[480.0, 290.0, 590.0, 650.0]])

# Multiple bounding boxes for different concepts

results = predictor(bboxes=[[539, 599, 589, 639], [343, 267, 499, 662]])

الاستدلال القائم على الميزات لتحقيق الكفاءة

إعادة استخدام ميزات الصورة لاستعلامات متعددة

استخرج ميزات الصورة مرة واحدة وأعد استخدامها لاستعلامات segment متعددة لتحسين الكفاءة.

import cv2

from ultralytics.models.sam import SAM3SemanticPredictor

from ultralytics.utils.plotting import Annotator, colors

# Initialize predictors

overrides = dict(conf=0.50, task="segment", mode="predict", model="sam3.pt", verbose=False)

predictor = SAM3SemanticPredictor(overrides=overrides)

predictor2 = SAM3SemanticPredictor(overrides=overrides)

# Extract features from the first predictor

source = "path/to/image.jpg"

predictor.set_image(source)

src_shape = cv2.imread(source).shape[:2]

# Setup second predictor and reuse features

predictor2.setup_model()

# Perform inference using shared features with text prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, text=["person"])

# Perform inference using shared features with bounding box prompt

masks, boxes = predictor2.inference_features(predictor.features, src_shape=src_shape, bboxes=[[439, 437, 524, 709]])

# Visualize results

if masks is not None:

masks, boxes = masks.cpu().numpy(), boxes.cpu().numpy()

im = cv2.imread(source)

annotator = Annotator(im, pil=False)

annotator.masks(masks, [colors(x, True) for x in range(len(masks))])

cv2.imshow("result", annotator.result())

cv2.waitKey(0)

تقسيم مفاهيم الفيديو

تراك المفاهيم عبر الفيديو باستخدام مربعات الإحاطة

تتبع الفيديو باستخدام الموجهات البصرية

detect و track كائنات عبر إطارات الفيديو باستخدام موجهات مربعات الإحاطة.

from ultralytics.models.sam import SAM3VideoPredictor

# Create video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", model="sam3.pt", half=True)

predictor = SAM3VideoPredictor(overrides=overrides)

# Track objects using bounding box prompts

results = predictor(source="path/to/video.mp4", bboxes=[[706.5, 442.5, 905.25, 555], [598, 635, 725, 750]], stream=True)

# Process and display results

for r in results:

r.show() # Display frame with segmentation masks

تراك المفاهيم باستخدام مطالبات نصية

تتبع الفيديو باستعلامات دلالية

track جميع كائنات المفاهيم المحددة بالنص عبر إطارات الفيديو.

from ultralytics.models.sam import SAM3VideoSemanticPredictor

# Initialize semantic video predictor

overrides = dict(conf=0.25, task="segment", mode="predict", imgsz=640, model="sam3.pt", half=True, save=True)

predictor = SAM3VideoSemanticPredictor(overrides=overrides)

# Track concepts using text prompts

results = predictor(source="path/to/video.mp4", text=["person", "bicycle"], stream=True)

# Process results

for r in results:

r.show() # Display frame with tracked objects

# Alternative: Track with bounding box prompts

results = predictor(

source="path/to/video.mp4",

bboxes=[[864, 383, 975, 620], [705, 229, 782, 402]],

labels=[1, 1], # Positive labels

stream=True,

)

الموجهات المرئية (توافق SAM 2)

يحافظ SAM 3 على التوافق الكامل مع الإصدارات السابقة مع التوجيه البصري لـ SAM 2 لـ segment الكائن الواحد:

مطالبات مرئية بنمط SAM 2

الواجهة الأساسية SAM تتصرف تمامًا مثل SAM 2، حيث تقوم بـ segment المنطقة المحددة فقط المشار إليها بواسطة الموجهات البصرية (النقاط، المربعات، أو الأقنعة).

from ultralytics import SAM

model = SAM("sam3.pt")

# Single point prompt - segments object at specific location

results = model.predict(source="path/to/image.jpg", points=[900, 370], labels=[1])

results[0].show()

# Multiple points - segments single object with multiple point hints

results = model.predict(source="path/to/image.jpg", points=[[400, 370], [900, 370]], labels=[1, 1])

# Box prompt - segments object within bounding box

results = model.predict(source="path/to/image.jpg", bboxes=[100, 150, 300, 400])

results[0].show()

الموجهات البصرية مقابل segment المفاهيم

استخدام SAM("sam3.pt") باستخدام الموجهات البصرية (النقاط/المربعات/الأقنعة) ستقوم بـ segment الكائن المحدد فقط في ذلك الموقع، تمامًا مثل SAM 2. لـ segment جميع كائنات المفهوم، استخدم SAM3SemanticPredictor باستخدام موجهات نصية أو أمثلة كما هو موضح أعلاه.

معايير الأداء

تقطيع الصور

يحقق SAM 3 نتائج متطورة عبر معايير متعددة، بما في ذلك مجموعات البيانات الواقعية مثل LVIS و COCO للتقسيم:

| قياس الأداء | مقياس (Metric) | SAM 3 | الأفضل سابقًا | تحسين |

|---|---|---|---|---|

| LVIS (لقطة صفرية) | قناع AP | 47.0 | 38.5 | +22.1% |

| SA-Co/Gold | CGF1 | 65.0 | 34.3 (OWLv2) | +89.5% |

| COCO (بدون تدريب مسبق) | مربع AP | 53.5 | 52.2 (T-Rex2) | +2.5% |

| ADE-847 (تقسيم دلالي) | mIoU | 14.7 | 9.2 (APE-D) | +59.8% |

| PascalConcept-59 | mIoU | 59.4 | 58.5 (APE-D) | +1.5% |

| Cityscapes (تقسيم دلالي) | mIoU | 65.1 | 44.2 (APE-D) | +47.3% |

استكشف خيارات مجموعة البيانات للتجربة السريعة في مجموعات بيانات Ultralytics.

أداء تقسيم الفيديو

يُظهر SAM 3 تحسينات كبيرة مقارنة بـ SAM 2 وأحدث التقنيات عبر معايير الفيديو مثل DAVIS 2017 و YouTube-VOS:

| قياس الأداء | مقياس (Metric) | SAM 3 | SAM 2.1 L | تحسين |

|---|---|---|---|---|

| MOSEv2 | J&F | 60.1 | 47.9 | +25.5% |

| DAVIS 2017 | J&F | 92.0 | 90.7 | +1.4% |

| LVOSv2 | J&F | 88.2 | 79.6 | +10.8% |

| SA-V | J&F | 84.6 | 78.4 | +7.9% |

| YTVOS19 | J&F | 89.6 | 89.3 | +0.3% |

تكييف قليل الطلقات

يتفوق SAM 3 في التكيف مع المجالات الجديدة بأقل عدد ممكن من الأمثلة، وهو أمر ذو صلة بسير عمل الذكاء الاصطناعي المرتكز على البيانات:

| قياس الأداء | 0-shot AP | 10-shot AP | الأفضل سابقًا (10 لقطات) |

|---|---|---|---|

| ODinW13 | 59.9 | 71.6 | 67.9 (gDino1.5-Pro) |

| RF100-VL | 14.3 | 35.7 | 33.7 (gDino-T) |

فعالية التحسين التفاعلي

التحفيز المفهومي في SAM 3 مع النماذج يتقارب بسرعة أكبر بكثير من التحفيز البصري:

| تمت إضافة مطالبات | نتيجة CGF1 | الكسب مقابل النص فقط | الكسب مقابل خط الأساس PVS |

|---|---|---|---|

| نص فقط | 46.4 | خط الأساس | خط الأساس |

| +1 مثال | 57.6 | +11.2 | +6.7 |

| +2 مثال | 62.2 | +15.8 | +9.7 |

| +3 أمثلة | 65.0 | +18.6 | +11.2 |

| +4 أمثلة | 65.7 | +19.3 | +11.5 (هضبة) |

دقة عد الكائنات

يوفر SAM 3 عدًا دقيقًا عن طريق تقسيم جميع الحالات، وهو مطلب شائع في عد الكائنات:

| قياس الأداء | الدقة | MAE | مقابل أفضل MLLM |

|---|---|---|---|

| CountBench | 95.6% | 0.11 | 92.4% (Gemini 2.5) |

| PixMo-Count | 87.3% | 0.22 | 88.8% (Molmo-72B) |

مقارنة SAM 3 مقابل SAM 2 مقابل YOLO

هنا نقارن قدرات SAM 3 مع SAM 2 ونماذج YOLO11:

| القدرة | SAM 3 | SAM 2 | YOLO11n-seg |

|---|---|---|---|

| تجزئة المفاهيم | ✅ كل النسخ من نص / أمثلة | ❌ غير مدعوم | ❌ غير مدعوم |

| التقسيم المرئي | ✅ نسخة واحدة (SAM 2 متوافقة) | ✅ نسخة واحدة | ✅ كل النسخ |

| القدرة على التصوير الصفري | ✅ مفردات مفتوحة | ✅ موجهات هندسية | ❌ مجموعة مغلقة |

| التحسين التفاعلي | ✅ أمثلة + نقرات | ✅ نقرات فقط | ❌ غير مدعوم |

| تتبع الفيديو | ✅ متعدد الكائن مع هويات | ✅ متعدد الكائن | ✅ متعدد الكائن |

| LVIS Mask AP (لقطة صفرية) | 47.0 | غير متاح | غير متاح |

| MOSEv2 J&F | 60.1 | 47.9 | غير متاح |

| سرعة الاستدلال (H200) | 30 مللي ثانية (100+ كائن) | ~23 مللي ثانية (لكل كائن) | 2-3 مللي ثانية (صورة) |

| حجم النموذج | 3.4 جيجابايت | 162 ميجابايت (الأساسي) | 5.9 ميجابايت |

النقاط الرئيسية:

- SAM 3: الأفضل لتجزئة المفاهيم ذات المفردات المفتوحة، والعثور على جميع حالات المفهوم باستخدام موجهات نصية أو أمثلة

- SAM 2: الأفضل لتجزئة الكائن الواحد التفاعلية في الصور ومقاطع الفيديو باستخدام موجهات هندسية

- YOLO11: الأفضل للتقطيع عالي السرعة في الوقت الفعلي في عمليات النشر ذات الموارد المحدودة باستخدام خطوط أنابيب التصدير الفعالة مثل ONNX و TensorRT

مقاييس التقييم

يقدم SAM 3 مقاييس جديدة مصممة لمهمة PCS، تكمل المقاييس المألوفة مثل F1 score و precision و recall.

تصنيف-Gated F1 (CGF1)

المقياس الأساسي الذي يجمع بين التوطين والتصنيف:

CGF1 = 100 × pmF1 × IL_MCC

حيث:

- pmF1 (إيجابي Macro F1): يقيس جودة تحديد الموقع على أمثلة إيجابية

- IL_MCC (معامل ارتباط ماثيوز على مستوى الصورة): يقيس دقة التصنيف الثنائي ("هل المفهوم موجود؟")

لماذا هذه المقاييس؟

لا تأخذ مقاييس AP التقليدية في الاعتبار المعايرة، مما يجعل استخدام النماذج صعبًا في الممارسة العملية. من خلال تقييم التوقعات التي تزيد عن 0.5 من الثقة فقط، تفرض مقاييس SAM 3 معايرة جيدة وتحاكي أنماط الاستخدام الواقعية في حلقات predict و track التفاعلية.

الاستئصال والرؤى الرئيسية

تأثير وجود الرأس

يفصل رأس التواجد بين التعرف والتموضع، مما يوفر تحسينات كبيرة:

| التكوين | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| بدون وجود | 57.6 | 0.77 | 74.7 |

| مع وجود | 63.3 | 0.82 | 77.1 |

يوفر رأس التواجد +5.7 CGF1 boost (+9.9%)، مما يحسن بشكل أساسي قدرة التعرف (IL_MCC +6.5%).

تأثير السلبيات الصعبة

| السلبيات الصعبة / الصورة | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| 0 | 31.8 | 0.44 | 70.2 |

| 5 | 44.8 | 0.62 | 71.9 |

| 30 | 49.2 | 0.68 | 72.3 |

تعتبر السلبيات الصعبة ضرورية للتعرف على المفردات المفتوحة، مما يحسن IL_MCC بنسبة 54.5% (0.44 → 0.68).

توسيع نطاق بيانات التدريب

| مصادر البيانات | CGF1 | IL_MCC | pmF1 |

|---|---|---|---|

| خارجي فقط | 30.9 | 0.46 | 66.3 |

| خارجي + اصطناعي | 39.7 | 0.57 | 70.6 |

| خارجي + HQ | 51.8 | 0.71 | 73.2 |

| جميع الثلاثة | 54.3 | 0.74 | 73.5 |

توفر التعليقات التوضيحية البشرية عالية الجودة مكاسب كبيرة مقارنة بالبيانات الاصطناعية أو الخارجية وحدها. للحصول على معلومات أساسية حول ممارسات جودة البيانات، راجع جمع البيانات والتعليق عليها.

التطبيقات

تتيح إمكانية تجزئة المفاهيم في SAM 3 حالات استخدام جديدة:

- الإشراف على المحتوى: البحث عن جميع مثيلات أنواع محتوى معينة عبر مكتبات الوسائط

- التجارة الإلكترونية: segment جميع منتجات نوع معين في صور الكتالوج، ودعم الترميز التلقائي

- التصوير الطبي: تحديد جميع حالات أنواع الأنسجة أو التشوهات المحددة

- الأنظمة الذاتية: track جميع مثيلات إشارات المرور أو المشاة أو المركبات حسب الفئة

- تحليلات الفيديو: عد وتتبع جميع الأشخاص الذين يرتدون ملابس معينة أو يقومون بأفعال معينة

- شرح مجموعة البيانات: شرح سريع لجميع مثيلات فئات الكائنات النادرة

- البحث العلمي: تحديد كمية جميع العينات وتحليلها التي تطابق معايير محددة

وكيل SAM 3: استدلال لغوي موسع

يمكن دمج SAM 3 مع نماذج اللغة الكبيرة متعددة الوسائط (MLLMs) للتعامل مع الاستعلامات المعقدة التي تتطلب الاستدلال، على غرار الأنظمة مفتوحة المفردات مثل OWLv2 و T-Rex.

الأداء في مهام الاستدلال

| قياس الأداء | مقياس (Metric) | وكيل SAM 3 (Gemini 2.5 Pro) | الأفضل سابقًا |

|---|---|---|---|

| ReasonSeg (التحقق) | gIoU | 76.0 | 65.0 (SoTA) |

| ReasonSeg (اختبار) | gIoU | 73.8 | 61.3 (SoTA) |

| OmniLabel (التحقق) | AP | 46.7 | 36.5 (REAL) |

| RefCOCO+ | تسريع | 91.2 | 89.3 (LISA) |

أمثلة على الاستعلامات المعقدة

يمكن لوكيل SAM 3 التعامل مع الاستعلامات التي تتطلب الاستدلال:

- "أشخاص يجلسون ولكن لا يحملون صندوق هدايا في أيديهم"

- "الكلب الأقرب إلى الكاميرا الذي لا يرتدي طوقًا"

- "أشياء حمراء أكبر من يد الشخص"

يقترح MLLM استعلامات بسيطة للعبارة الاسمية إلى SAM 3، ويحلل الأقنعة التي تم إرجاعها، ويكرر حتى يتم تحقيق الرضا.

القيود

في حين أن SAM 3 يمثل تقدمًا كبيرًا، إلا أن لديه بعض القيود:

- تعقيد العبارة: الأنسب لعبارات اسمية بسيطة؛ قد تتطلب التعبيرات المرجعية الطويلة أو الاستدلال المعقد تكامل MLLM

- التعامل مع الغموض: تظل بعض المفاهيم غامضة بطبيعتها (مثل "نافذة صغيرة"، "غرفة مريحة")

- المتطلبات الحسابية: أكبر وأبطأ من نماذج الكشف المتخصصة مثل YOLO

- نطاق المفردات: يركز على المفاهيم المرئية الذرية؛ الاستدلال التركيبي محدود بدون مساعدة MLLM

- المفاهيم النادرة: قد يتدهور الأداء في المفاهيم النادرة للغاية أو الدقيقة التي لا يتم تمثيلها بشكل جيد في بيانات التدريب

اقتباس

@inproceedings{sam3_2025,

title = {SAM 3: Segment Anything with Concepts},

author = {Anonymous authors},

booktitle = {Submitted to ICLR 2026},

year = {2025},

url = {https://openreview.net/forum?id=r35clVtGzw},

note = {Paper ID: 4183, under double-blind review}

}

الأسئلة الشائعة

متى تم إصدار SAM 3؟

تم إصدار SAM 3 بواسطة ميتا في 20 نوفمبر 2025 وتم دمجه بالكامل في Ultralytics اعتبارًا من الإصدار 8.3.237 (PR #22897). يتوفر الدعم الكامل لـ وضع التنبؤ ووضع التتبع.

هل تم دمج SAM 3 في Ultralytics؟

نعم! تم دمج SAM 3 بالكامل في حزمة Ultralytics python، بما في ذلك تجزئة المفاهيم، والمطالبات المرئية على غرار SAM 2، و track الفيديو متعدد الكائنات.

ما هو تجزئة المفهوم القابل للتوجيه (PCS)؟

PCS هي مهمة جديدة تم تقديمها في SAM 3 والتي تقوم بعملية segment لـ جميع الحالات لمفهوم مرئي في صورة أو مقطع فيديو. على عكس عملية segmentation التقليدية التي تستهدف مثيل كائن معين، تجد PCS كل تكرار لفئة. على سبيل المثال:

- نص موجه: "حافلة مدرسية صفراء" → يقسم جميع الحافلات المدرسية الصفراء في المشهد

- مثال الصورة: مربع حول كلب واحد → يحدد جميع الكلاب في الصورة

- مدمج: "قط مخطط" + مربع نموذجي → يقوم بتقطيع جميع القطط المخططة المطابقة للمثال

اطلع على معلومات أساسية ذات صلة حول الكشف عن الأجسام و تقسيم المثيلات.

كيف يختلف SAM 3 عن SAM 2؟

| ميزة | SAM 2 | SAM 3 |

|---|---|---|

| المهمة | كائن واحد لكل مطالبة | جميع حالات المفهوم |

| أنواع المطالبات | النقاط، الصناديق، الأقنعة | + عبارات نصية، أمثلة صور |

| إمكانية الكشف | يتطلب كاشف خارجي | كاشف مدمج للمفردات المفتوحة |

| التعرف | يعتمد على الهندسة فقط | التعرف على النصوص والمرئيات |

| البنية | متتبع فقط | كاشف + متتبع مع رأس تواجد |

| أداء التصوير الصفري | غير متاح (يتطلب مطالبات مرئية) | 47.0 AP على LVIS، أفضل بـ 2× على SA-Co |

| التحسين التفاعلي | نقرات فقط | نقرات + تعميم نموذجي |

يحافظ SAM 3 على التوافق مع الإصدارات السابقة مع المطالبة المرئية SAM 2 مع إضافة إمكانات قائمة على المفهوم.

ما هي مجموعات البيانات المستخدمة لتدريب SAM 3؟

تم تدريب SAM 3 على مجموعة البيانات Segment Anything with Concepts (SA-Co):

بيانات التدريب:

- 5.2 مليون صورة مع 4 ملايين عبارة اسمية فريدة (SA-Co/HQ) - تعليقات توضيحية بشرية عالية الجودة

- 52.5 ألف مقطع فيديو مع 24.8 ألف عبارة اسمية فريدة (SA-Co/VIDEO)

- 1.4 مليار قناع اصطناعي عبر 38 مليون عبارة اسمية (SA-Co/SYN)

- 15 مجموعة بيانات خارجية مُثرية بسلبيات صعبة (SA-Co/EXT)

بيانات القياس:

- 214 ألف مفهوم فريد عبر 126 ألف صورة/فيديو

- مفاهيم أكثر بـ 50 مرة من المعايير الحالية (على سبيل المثال، لدى LVIS ~4 آلاف مفهوم)

- تعليق توضيحي ثلاثي على SA-Co/Gold لقياس حدود الأداء البشري

يمكّن هذا الحجم والتنوع الهائلان التعميم الصفري الفائق لـ SAM 3 عبر مفاهيم المفردات المفتوحة.

كيف تتم مقارنة SAM 3 بـ YOLO11 لـ segmentation؟

يخدم SAM 3 و YOLO11 حالات استخدام مختلفة:

مزايا SAM 3:

- مفردات مفتوحة: يقوم بتقسيم أي مفهوم عبر مطالبات نصية دون تدريب

- Zero-shot: يعمل على فئات جديدة على الفور

- تفاعلي: التعزيز القائم على المثال يعمم على كائنات مماثلة

- قائم على المفهوم: يعثر تلقائيًا على جميع مثيلات الفئة

- الدقة: 47.0 AP في تجزئة مثيلات LVIS بدون تدريب مسبق

مزايا YOLO11:

- السرعة: استدلال أسرع بـ 10-15 مرة (2-3 مللي ثانية مقابل 30 مللي ثانية لكل صورة)

- الكفاءة: نماذج أصغر بـ 576 مرة (5.9 ميجابايت مقابل 3.4 جيجابايت)

- صديقة للموارد: تعمل على الأجهزة الطرفية والهواتف المحمولة

- آني: مُحسَّن لعمليات النشر في بيئات الإنتاج

توصية:

- استخدم SAM 3 لتقطيع مرن ومفتوح المفردات حيث تحتاج إلى العثور على جميع مثيلات المفاهيم الموصوفة بالنص أو الأمثلة.

- استخدم YOLO11 لعمليات النشر عالية السرعة والإنتاج حيث تكون الفئات معروفة مسبقًا.

- استخدم SAM 2 لتقطيع الأجسام المفردة بشكل تفاعلي باستخدام مطالبات هندسية.

هل يمكن لـ SAM 3 التعامل مع استعلامات اللغة المعقدة؟

تم تصميم SAM 3 لعبارات اسمية بسيطة (مثل "تفاحة حمراء"، "شخص يرتدي قبعة"). للاستعلامات المعقدة التي تتطلب الاستدلال، ادمج SAM 3 مع MLLM كـ SAM 3 Agent:

استعلامات بسيطة (SAM 3 الأصلي):

- "حافلة مدرسية صفراء"

- "قط مخطط"

- "شخص يرتدي قبعة حمراء"

استعلامات معقدة (SAM 3 Agent مع MLLM):

- "أشخاص يجلسون ولكن لا يحملون صندوق هدايا"

- "الكلب الأقرب إلى الكاميرا بدون طوق"

- "أشياء حمراء أكبر من يد الشخص"

يحقق وكيل SAM 3 76.0 gIoU في التحقق من صحة ReasonSeg (مقابل 65.0 الأفضل سابقًا، تحسن بنسبة +16.9٪) من خلال الجمع بين تقسيم SAM 3 وقدرات الاستدلال MLLM.

ما مدى دقة SAM 3 مقارنة بالأداء البشري؟

في معيار SA-Co/Gold مع التعليقات التوضيحية البشرية الثلاثية:

- الحد الأدنى البشري: 74.2 CGF1 (أكثر المعلقين تحفظًا)

- أداء SAM 3: 65.0 CGF1

- الإنجاز: 88% من الحد الأدنى البشري المقدر

- الحد الأعلى البشري: 81.4 CGF1 (أكثر المعلقين تحررًا)

يحقق SAM 3 أداءً قويًا يقترب من دقة المستوى البشري في تقسيم المفاهيم ذات المفردات المفتوحة، مع وجود فجوة في المقام الأول في المفاهيم الغامضة أو الذاتية (مثل "نافذة صغيرة"، "غرفة مريحة").