Ultralytics YOLO26

نظرة عامة

Ultralytics YOLO26 هو أحدث تطور في سلسلة YOLO لكاشفات الأجسام في الوقت الفعلي، وقد تم تصميمه من الألف إلى الياء من أجل الأجهزة الطرفية والأجهزة منخفضة الطاقة. يقدم تصميمًا مبسطًا يزيل التعقيد غير الضروري مع دمج الابتكارات المستهدفة لتقديم نشر أسرع وأخف وزنًا وأكثر سهولة.

جرب Ultralytics

استكشف ونفذ نماذج YOLO26 مباشرة على Ultralytics .

تسترشد بنية YOLO26 بثلاثة مبادئ أساسية:

- البساطة: YOLO26 هو نموذج أصلي شامل، ينتج تنبؤات مباشرة دون الحاجة إلى منع التداخل الأقصى (NMS). من خلال التخلص من خطوة المعالجة اللاحقة هذه، يصبح الاستدلال أسرع وأخف وأسهل في النشر في الأنظمة الواقعية. تم ريادة هذا النهج прорыв لأول مرة في YOLOv10 بواسطة Ao Wang في جامعة Tsinghua وتم تطويره بشكل أكبر في YOLO26.

- كفاءة النشر: يقلل التصميم الشامل من مرحلة كاملة من خط الأنابيب، مما يبسط التكامل بشكل كبير، ويقلل زمن الوصول، ويجعل النشر أكثر قوة عبر البيئات المتنوعة.

- ابتكار التدريب: يقدم YOLO26 مُحسِّن MuSGD، وهو مزيج من SGD و Muon — مُستوحى من اختراقات Kimi K2 من Moonshot AI في تدريب LLM. يجلب هذا المحسن استقرارًا مُحسَّنًا وتقاربًا أسرع، وينقل تحسينات التحسين من النماذج اللغوية إلى رؤية الكمبيوتر.

- تحسينات خاصة بالمهام: يقدم YOLO26 تحسينات مستهدفة للمهام المتخصصة، بما في ذلك فقدان التجزئة الدلالية ووحدات البروتو متعددة المقاييس لـ Segmentation، وتقدير الاحتمالية اللوغاريتمية المتبقية (RLE) لتقدير Pose عالي الدقة، وفك تشفير مُحسّن مع فقدان الزاوية لحل مشكلات الحدود في OBB.

تجتمع هذه الابتكارات لتقديم عائلة نماذج تحقق دقة أعلى على الكائنات الصغيرة، وتوفر نشرًا سلسًا، وتعمل بسرعة أكبر بنسبة تصل إلى 43٪ على وحدات المعالجة المركزية (CPUs) - مما يجعل YOLO26 أحد نماذج YOLO الأكثر عملية وقابلية للنشر حتى الآن للبيئات ذات الموارد المحدودة.

الميزات الرئيسية

إزالة DFL

في حين أن وحدة Distribution Focal Loss (DFL) فعالة، إلا أنها غالبًا ما تعقد عملية التصدير وتحد من توافق الأجهزة. يزيل YOLO26 وحدة DFL تمامًا، مما يبسط الاستدلال ويوسع الدعم لـ الأجهزة الطرفية ومنخفضة الطاقة.الاستدلال الشامل الخالي من NMS

على عكس الكاشفات التقليدية التي تعتمد على NMS كخطوة معالجة لاحقة منفصلة، فإن YOLO26 شامل أصليًا. يتم إنشاء التنبؤات مباشرةً، مما يقلل من زمن الوصول ويجعل التكامل في أنظمة الإنتاج أسرع وأخف وزنًا وأكثر موثوقية.ProgLoss + STAL

تحسين وظائف الخسارة يزيد من دقة الـ detect، مع تحسينات ملحوظة في التعرف على الأجسام الصغيرة، وهو مطلب حاسم لتطبيقات إنترنت الأشياء والروبوتات والتصوير الجوي وغيرها من التطبيقات الطرفية.محسن MuSGD

مُحسِّن هجين جديد يجمع بين SGD و Muon. مُستوحى من Kimi K2 من Moonshot AI، يُدخل MuSGD طرق تحسين متقدمة من تدريب LLM في رؤية الكمبيوتر، مما يُمكّن تدريبًا أكثر استقرارًا وتقاربًا أسرع.استدلال أسرع لوحدة المعالجة المركزية CPU بنسبة تصل إلى 43٪

تم تحسين YOLO26 خصيصًا للحوسبة الطرفية، ويوفر استدلالًا أسرع لوحدة المعالجة المركزية CPU بشكل ملحوظ، مما يضمن أداءً في الوقت الفعلي على الأجهزة التي لا تحتوي على وحدات معالجة الرسوميات GPUs.تحسينات تجزئة الكائنات

يقدم فقدان التجزئة الدلالية لتحسين تقارب النموذج ووحدة بروتو مطورة تستفيد من المعلومات متعددة المقاييس لجودة قناع فائقة.تقدير الوضعية الدقيق

يدمج تقدير الاحتمالية اللوغاريتمية المتبقية (RLE) لتحديد مواقع النقاط الرئيسية بدقة أكبر ويحسن عملية فك التشفير لزيادة سرعة الاستدلال.فك تشفير OBB المحسن

يقدم خسارة زاوية متخصصة لتحسين دقة detect الكائنات مربعة الشكل ويحسن فك تشفير OBB لحل مشكلات عدم استمرارية الحدود.

المهام والأوضاع المدعومة

يعتمد YOLO26 على مجموعة النماذج المتنوعة التي أرستها إصدارات Ultralytics YOLO السابقة، مقدمًا دعمًا معززًا عبر مهام رؤية الكمبيوتر المختلفة:

| النموذج | أسماء الملفات | المهمة | الاستدلال | التحقق | التدريب | تصدير |

|---|---|---|---|---|---|---|

| YOLO26 | yolo26n.pt yolo26s.pt yolo26m.pt yolo26l.pt yolo26x.pt | اكتشاف | ✅ | ✅ | ✅ | ✅ |

| YOLO26-seg | yolo26n-seg.pt yolo26s-seg.pt yolo26m-seg.pt yolo26l-seg.pt yolo26x-seg.pt | تجزئة المثيل | ✅ | ✅ | ✅ | ✅ |

| YOLO26-pose | yolo26n-pose.pt yolo26s-pose.pt yolo26m-pose.pt yolo26l-pose.pt yolo26x-pose.pt | الوضع/النقاط الرئيسية | ✅ | ✅ | ✅ | ✅ |

| YOLO26-obb | yolo26n-obb.pt yolo26s-obb.pt yolo26m-obb.pt yolo26l-obb.pt yolo26x-obb.pt | الكشف الموجه | ✅ | ✅ | ✅ | ✅ |

| YOLO26-cls | yolo26n-cls.pt yolo26s-cls.pt yolo26m-cls.pt yolo26l-cls.pt yolo26x-cls.pt | التصنيف | ✅ | ✅ | ✅ | ✅ |

يضمن هذا الإطار الموحد أن يكون YOLO26 قابلاً للتطبيق عبر الكشف في الوقت الفعلي، و segmentation، و classification، و pose estimation، و oriented object detection — كل ذلك مع دعم التدريب والتحقق والاستدلال والتصدير.

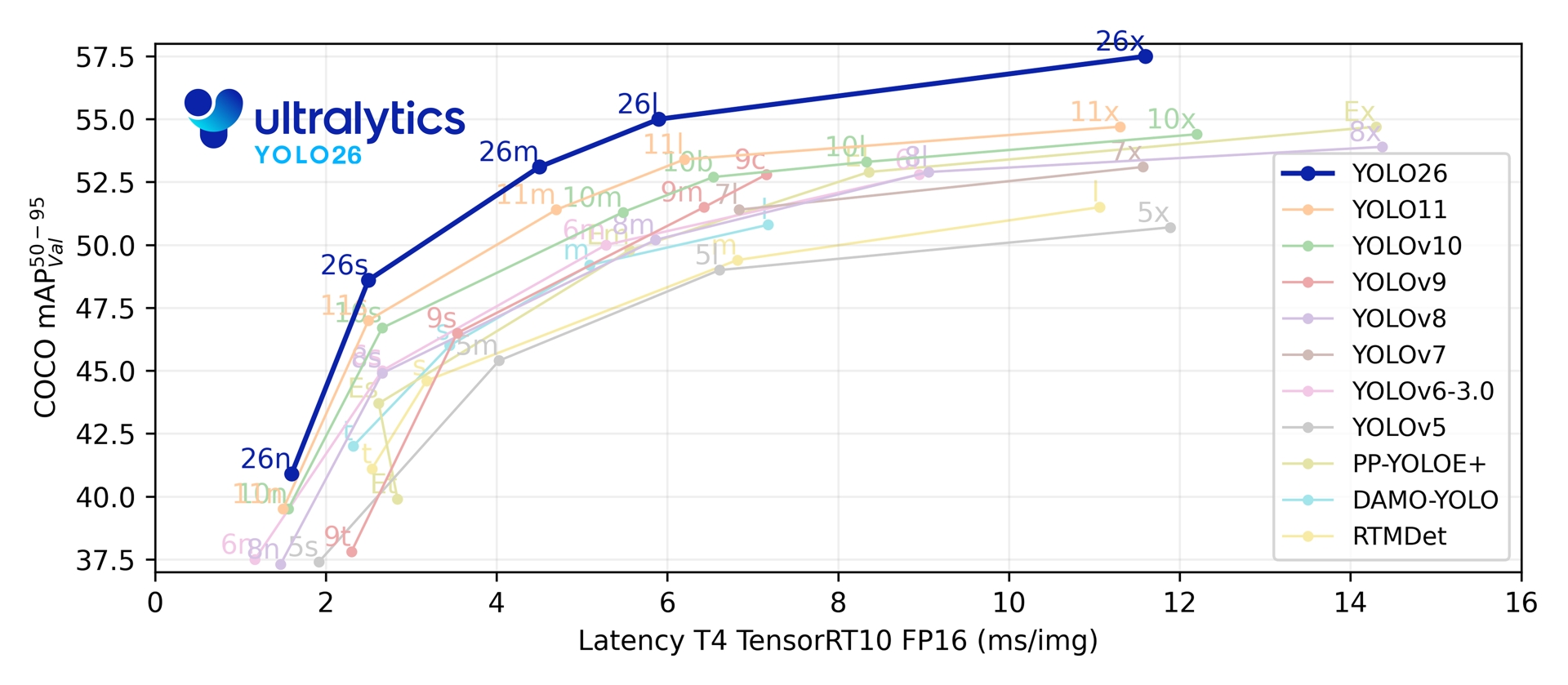

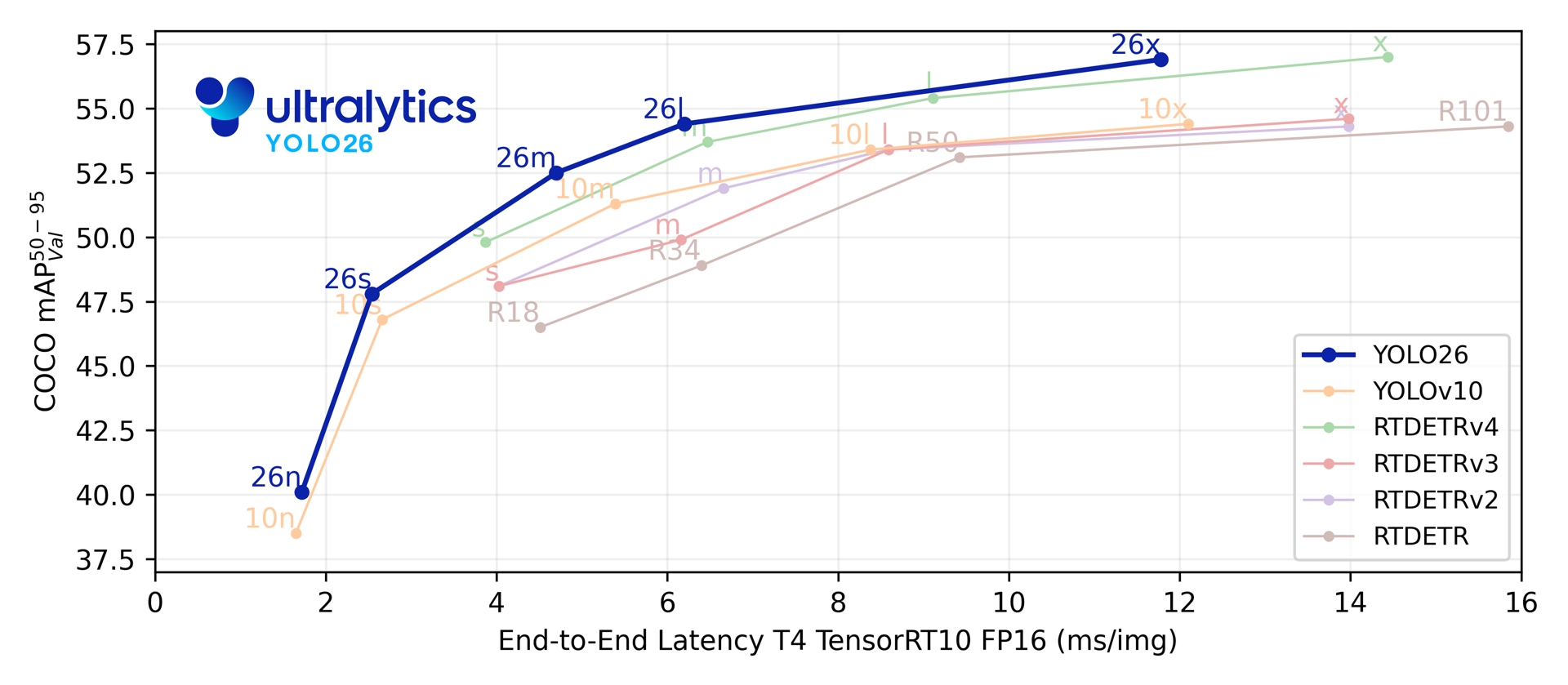

مقاييس الأداء

الأداء

راجع وثائق الكشف لأمثلة الاستخدام مع هذه النماذج المدربة على COCO، والتي تتضمن 80 فئة مدربة مسبقًا.

| النموذج | الحجم (بالبكسل) | mAPval 50-95 | mAPval 50-95(e2e) | السرعة وحدة المعالجة المركزية CPU ONNX (بالمللي ثانية) | السرعة T4 TensorRT10 (بالمللي ثانية) | المعلمات (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

راجع وثائق التجزئة لأمثلة الاستخدام مع هذه النماذج المدربة على COCO، والتي تتضمن 80 فئة مدربة مسبقًا.

| النموذج | الحجم (بالبكسل) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | السرعة وحدة المعالجة المركزية CPU ONNX (بالمللي ثانية) | السرعة T4 TensorRT10 (بالمللي ثانية) | المعلمات (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

راجع وثائق التصنيف لأمثلة الاستخدام مع هذه النماذج المدربة على ImageNet، والتي تتضمن 1000 فئة مدربة مسبقًا.

| النموذج | الحجم (بالبكسل) | acc top1 | acc top5 | السرعة وحدة المعالجة المركزية CPU ONNX (بالمللي ثانية) | السرعة T4 TensorRT10 (بالمللي ثانية) | المعلمات (M) | FLOPs (B) عند 224 |

|---|---|---|---|---|---|---|---|

| YOLO26n-cls | 224 | 71.4 | 90.1 | 5.0 ± 0.3 | 1.1 ± 0.0 | 2.8 | 0.5 |

| YOLO26s-cls | 224 | 76.0 | 92.9 | 7.9 ± 0.2 | 1.3 ± 0.0 | 6.7 | 1.6 |

| YOLO26m-cls | 224 | 78.1 | 94.2 | 17.2 ± 0.4 | 2.0 ± 0.0 | 11.6 | 4.9 |

| YOLO26l-cls | 224 | 79.0 | 94.6 | 23.2 ± 0.3 | 2.8 ± 0.0 | 14.1 | 6.2 |

| YOLO26x-cls | 224 | 79.9 | 95.0 | 41.4 ± 0.9 | 3.8 ± 0.0 | 29.6 | 13.6 |

راجع وثائق تقدير الوضعيات لأمثلة الاستخدام مع هذه النماذج المدربة على COCO، والتي تتضمن فئة واحدة مدربة مسبقًا، وهي 'شخص'.

| النموذج | الحجم (بالبكسل) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | السرعة وحدة المعالجة المركزية CPU ONNX (بالمللي ثانية) | السرعة T4 TensorRT10 (بالمللي ثانية) | المعلمات (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

راجع وثائق الكشف الموجه لأمثلة الاستخدام مع هذه النماذج المدربة على DOTAv1، والتي تتضمن 15 فئة مدربة مسبقًا.

| النموذج | الحجم (بالبكسل) | mAPtest 50-95(e2e) | mAPtest 50(e2e) | السرعة وحدة المعالجة المركزية CPU ONNX (بالمللي ثانية) | السرعة T4 TensorRT10 (بالمللي ثانية) | المعلمات (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-obb | 1024 | 52.4 | 78.9 | 97.7 ± 0.9 | 2.8 ± 0.0 | 2.5 | 14.0 |

| YOLO26s-obb | 1024 | 54.8 | 80.9 | 218.0 ± 1.4 | 4.9 ± 0.1 | 9.8 | 55.1 |

| YOLO26m-obb | 1024 | 55.3 | 81.0 | 579.2 ± 3.8 | 10.2 ± 0.3 | 21.2 | 183.3 |

| YOLO26l-obb | 1024 | 56.2 | 81.6 | 735.6 ± 3.1 | 13.0 ± 0.2 | 25.6 | 230.0 |

| YOLO26x-obb | 1024 | 56.7 | 81.7 | 1485.7 ± 11.5 | 30.5 ± 0.9 | 57.6 | 516.5 |

قيم Params و FLOPs هي للنموذج المدمج بعد model.fuse()، الذي يدمج طبقات Conv و BatchNorm ويزيل رأس الكشف الإضافي من واحد إلى العديد. تحتفظ نقاط الفحص المعدة مسبقًا بهيكل التدريب الكامل وقد تظهر أعدادًا أعلى.

أمثلة الاستخدام

يقدم هذا القسم أمثلة بسيطة لتدريب YOLO26 والاستدلال. للاطلاع على الوثائق الكاملة حول هذه الأنماط وغيرها، راجع صفحات وثائق Predict وTrain وVal وExport.

لاحظ أن المثال أدناه هو لنماذج YOLO26 Detect لـ object detection. للمهام المدعومة الإضافية، راجع وثائق Segment وClassify وOBB وPose.

مثال

PyTorch مدربة مسبقًا *.pt بالإضافة إلى نماذج التهيئة *.yaml يمكن تمرير الملفات إلى YOLO() class لإنشاء مثيل نموذج في Python:

from ultralytics import YOLO

# Load a COCO-pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on the COCO8 example dataset for 100 epochs

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Run inference with the YOLO26n model on the 'bus.jpg' image

results = model("path/to/bus.jpg")

تتوفر أوامر CLI لتشغيل النماذج مباشرة:

# Load a COCO-pretrained YOLO26n model and train it on the COCO8 example dataset for 100 epochs

yolo train model=yolo26n.pt data=coco8.yaml epochs=100 imgsz=640

# Load a COCO-pretrained YOLO26n model and run inference on the 'bus.jpg' image

yolo predict model=yolo26n.pt source=path/to/bus.jpg

بنية ثنائية الرأس

يتميز YOLO26 بهيكل ثنائي الرأس يوفر المرونة لمختلف سيناريوهات النشر:

- رأس واحد لواحد (افتراضي): ينتج تنبؤات شاملة بدون NMS ويقوم بإخراج

(N, 300, 6)بحد أقصى 300 عملية كشف لكل صورة. تم تحسين هذا الرأس للاستدلال السريع والنشر المبسط. - رأس واحد إلى عدة: يولد YOLO التقليدية التي تتطلب NMS ويخرج

(N, nc + 4, 8400)حيثncهو عدد الفئات. عادةً ما يحقق هذا الرأس دقة أعلى قليلاً على حساب معالجة إضافية.

يمكنك التبديل بين الرؤوس أثناء التصدير أو التنبؤ أو التحقق:

from ultralytics import YOLO

model = YOLO("yolo26n.pt")

# Use one-to-one head (default, no NMS required)

results = model.predict("image.jpg") # inference

metrics = model.val(data="coco.yaml") # validation

model.export(format="onnx") # export

# Use one-to-many head (requires NMS)

results = model.predict("image.jpg", end2end=False) # inference

metrics = model.val(data="coco.yaml", end2end=False) # validation

model.export(format="onnx", end2end=False) # export

# Use one-to-one head (default, no NMS required)

yolo predict model=yolo26n.pt source=image.jpg

yolo val model=yolo26n.pt data=coco.yaml

yolo export model=yolo26n.pt format=onnx

# Use one-to-many head (requires NMS)

yolo predict model=yolo26n.pt source=image.jpg end2end=False

yolo val model=yolo26n.pt data=coco.yaml end2end=False

yolo export model=yolo26n.pt format=onnx end2end=False

يعتمد الاختيار على متطلبات النشر لديك: استخدم الرأس الفردي للحصول على أقصى سرعة وبساطة، أو الرأس المتعدد عندما تكون الدقة هي الأولوية القصوى.

YOLOE-26: تجزئة الكائنات ذات المفردات المفتوحة

يدمج YOLOE-26 بنية YOLO26 عالية الأداء مع قدرات المفردات المفتوحة لسلسلة YOLOE. إنه يتيح الكشف والتجزئة في الوقت الفعلي لأي فئة كائن باستخدام المطالبات النصية، أو المطالبات المرئية، أو وضع خالٍ من المطالبات للاستدلال بدون تدريب مسبق، مما يزيل بشكل فعال قيود التدريب على فئات ثابتة.

من خلال الاستفادة من تصميم YOLO26 الشامل والخالي من NMS، يقدم YOLOE-26 استدلالًا سريعًا للعالم المفتوح. وهذا يجعله حلاً قويًا لتطبيقات الحافة في البيئات الديناميكية حيث تمثل الكائنات محل الاهتمام مفردات واسعة ومتطورة.

الأداء

راجع وثائق YOLOE لأمثلة الاستخدام مع هذه النماذج المدربة على مجموعات بيانات Objects365v1 وGQA وFlickr30k.

| النموذج | الحجم (بالبكسل) | نوع المطالبة | mAPminival 50-95(e2e) | mAPminival 50-95 | mAPr | mAPc | mAPf | المعلمات (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|---|---|

| YOLOE-26n-seg | 640 | نصي/مرئي | 23.7 / 20.9 | 24.7 / 21.9 | 20.5 / 17.6 | 24.1 / 22.3 | 26.1 / 22.4 | 4.8 | 6.0 |

| YOLOE-26s-seg | 640 | نصي/مرئي | 29.9 / 27.1 | 30.8 / 28.6 | 23.9 / 25.1 | 29.6 / 27.8 | 33.0 / 29.9 | 13.1 | 21.7 |

| YOLOE-26m-seg | 640 | نصي/مرئي | 35.4 / 31.3 | 35.4 / 33.9 | 31.1 / 33.4 | 34.7 / 34.0 | 36.9 / 33.8 | 27.9 | 70.1 |

| YOLOE-26l-seg | 640 | نصي/مرئي | 36.8 / 33.7 | 37.8 / 36.3 | 35.1 / 37.6 | 37.6 / 36.2 | 38.5 / 36.1 | 32.3 | 88.3 |

| YOLOE-26x-seg | 640 | نصي/مرئي | 39.5 / 36.2 | 40.6 / 38.5 | 37.4 / 35.3 | 40.9 / 38.8 | 41.0 / 38.8 | 69.9 | 196.7 |

راجع وثائق YOLOE لأمثلة الاستخدام مع هذه النماذج المدربة على مجموعات بيانات Objects365v1 وGQA وFlickr30k.

| النموذج | الحجم (بالبكسل) | mAPminival 50-95(e2e) | mAPminival 50(e2e) | المعلمات (M) | FLOPs (B) |

|---|---|---|---|---|---|

| YOLOE-26n-seg-pf | 640 | 16.6 | 22.7 | 6.5 | 15.8 |

| YOLOE-26s-seg-pf | 640 | 21.4 | 28.6 | 16.2 | 35.5 |

| YOLOE-26m-seg-pf | 640 | 25.7 | 33.6 | 36.2 | 122.1 |

| YOLOE-26l-seg-pf | 640 | 27.2 | 35.4 | 40.6 | 140.4 |

| YOLOE-26x-seg-pf | 640 | 29.9 | 38.7 | 86.3 | 314.4 |

مثال على الاستخدام

يدعم YOLOE-26 كلًا من التوجيه النصي والمرئي. يُعد استخدام الموجهات أمرًا مباشرًا—فقط قم بتمريرها عبر predict الطريقة كما هو موضح أدناه:

مثال

تتيح لك الموجهات النصية تحديد الفئات التي ترغب في detectها من خلال الأوصاف النصية. يوضح الكود التالي كيف يمكنك استخدام YOLOE-26 لـ detect الأشخاص والحافلات في صورة:

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg.pt") # or select yoloe-26s/m-seg.pt for different sizes

# Set text prompt to detect person and bus. You only need to do this once after you load the model.

model.set_classes(["person", "bus"])

# Run detection on the given image

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

تتيح لك المطالبات المرئية توجيه النموذج عن طريق عرض أمثلة مرئية للفئات المستهدفة، بدلاً من وصفها بالنص.

import numpy as np

from ultralytics import YOLO

from ultralytics.models.yolo.yoloe import YOLOEVPSegPredictor

# Initialize model

model = YOLO("yoloe-26l-seg.pt")

# Define visual prompts using bounding boxes and their corresponding class IDs.

# Each box highlights an example of the object you want the model to detect.

visual_prompts = dict(

bboxes=np.array(

[

[221.52, 405.8, 344.98, 857.54], # Box enclosing person

[120, 425, 160, 445], # Box enclosing glasses

],

),

cls=np.array(

[

0, # ID to be assigned for person

1, # ID to be assigned for glasses

]

),

)

# Run inference on an image, using the provided visual prompts as guidance

results = model.predict(

"ultralytics/assets/bus.jpg",

visual_prompts=visual_prompts,

predictor=YOLOEVPSegPredictor,

)

# Show results

results[0].show()

يتضمن YOLOE-26 إصدارات خالية من الموجهات تأتي مع مفردات مدمجة. لا تتطلب هذه النماذج أي موجهات وتعمل مثل نماذج YOLO التقليدية. بدلاً من الاعتماد على التسميات المقدمة من المستخدم أو الأمثلة المرئية، فإنها detect الكائنات من قائمة محددة مسبقًا تضم 4,585 فئة بناءً على مجموعة العلامات المستخدمة بواسطة Recognize Anything Model Plus (RAM++).

from ultralytics import YOLO

# Initialize model

model = YOLO("yoloe-26l-seg-pf.pt")

# Run prediction. No prompts required.

results = model.predict("path/to/image.jpg")

# Show results

results[0].show()

للاطلاع المتعمق على تقنيات التوجيه، والتدريب من الصفر، وأمثلة الاستخدام الكاملة، قم بزيارة وثائق YOLOE.

الاقتباسات والإقرارات

منشور Ultralytics YOLO26

لم تنشر Ultralytics ورقة بحثية رسمية لـ YOLO26 نظرًا للطبيعة سريعة التطور للنماذج. بدلاً من ذلك، نركز على تقديم نماذج متطورة وتسهيل استخدامها. للحصول على آخر التحديثات حول ميزات وهياكل واستخدام YOLO، تفضل بزيارة مستودع GitHub الخاص بنا و الوثائق.

إذا كنت تستخدم YOLO26 أو برامج Ultralytics أخرى في عملك، فيرجى الاستشهاد بها على النحو التالي:

@software{yolo26_ultralytics,

author = {Glenn Jocher and Jing Qiu},

title = {Ultralytics YOLO26},

version = {26.0.0},

year = {2026},

url = {https://github.com/ultralytics/ultralytics},

orcid = {0000-0001-5950-6979, 0000-0003-3783-7069},

license = {AGPL-3.0}

}

DOI معلق. يتوفر YOLO26 بموجب تراخيص AGPL-3.0 و Enterprise.

الأسئلة الشائعة

ما هي التحسينات الرئيسية في YOLO26 مقارنة بـ YOLO11؟

- إزالة DFL: يبسط التصدير ويوسع توافق الحافة

- الاستدلال الشامل الخالي من NMS: يزيل NMS لنشر أسرع وأبسط

- ProgLoss + STAL: يعزز الدقة، خاصة على الأجسام الصغيرة

- محسن MuSGD: يجمع بين SGD و Muon (مستوحى من Kimi K2 من Moonshot) لتدريب أكثر استقرارًا وكفاءة

- استدلال أسرع لوحدة المعالجة المركزية CPU بنسبة تصل إلى 43٪: مكاسب كبيرة في الأداء للأجهزة التي تعمل بوحدة المعالجة المركزية CPU فقط

ما المهام التي يدعمها YOLO26؟

YOLO26 هي عائلة نماذج موحدة، توفر دعمًا شاملاً لمهام رؤية الكمبيوتر المتعددة:

يدعم كل متغير حجم (n, s, m, l, x) جميع المهام، بالإضافة إلى إصدارات المفردات المفتوحة عبر YOLOE-26.

لماذا تم تحسين YOLO26 للنشر على الحافة؟

يوفر YOLO26 أداءً متطورًا على الحافة من خلال:

- استدلال أسرع لوحدة المعالجة المركزية CPU بنسبة تصل إلى 43٪

- تقليل حجم النموذج والبصمة الذاكرة

- تبسيط الهيكلة لتحقيق التوافق (بدون DFL، بدون NMS)

- تنسيقات تصدير مرنة بما في ذلك TensorRT و ONNX و CoreML و TFLite و OpenVINO

كيف أبدأ باستخدام YOLO26؟

تم إصدار نماذج YOLO26 في 14 يناير 2026، وهي متاحة للتنزيل. قم بتثبيت أو تحديث ultralytics الحزمة وقم بتحميل نموذج:

from ultralytics import YOLO

# Load a pretrained YOLO26 nano model

model = YOLO("yolo26n.pt")

# Run inference on an image

results = model("image.jpg")

راجع قسم أمثلة الاستخدام للحصول على تعليمات التدريب والتحقق والتصدير.