Conjunto de datos COCO-Pose

El conjunto de datos COCO-Pose es una versión especializada del conjunto de datos COCO (Objetos Comunes en Contexto), diseñado para tareas de estimación de pose. Aprovecha las imágenes y etiquetas de COCO Keypoints 2017 para permitir el entrenamiento de modelos como YOLO para tareas de estimación de pose.

Modelos preentrenados de COCO-Pose

| Modelo | tamaño (píxeles) | mAPpose 50-95(e2e) | mAPpose 50(e2e) | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-pose | 640 | 57.2 | 83.3 | 40.3 ± 0.5 | 1.8 ± 0.0 | 2.9 | 7.5 |

| YOLO26s-pose | 640 | 63.0 | 86.6 | 85.3 ± 0.9 | 2.7 ± 0.0 | 10.4 | 23.9 |

| YOLO26m-pose | 640 | 68.8 | 89.6 | 218.0 ± 1.5 | 5.0 ± 0.1 | 21.5 | 73.1 |

| YOLO26l-pose | 640 | 70.4 | 90.5 | 275.4 ± 2.4 | 6.5 ± 0.1 | 25.9 | 91.3 |

| YOLO26x-pose | 640 | 71.6 | 91.6 | 565.4 ± 3.0 | 12.2 ± 0.2 | 57.6 | 201.7 |

Características clave

- COCO-Pose se basa en el conjunto de datos COCO Keypoints 2017, que contiene 200 000 imágenes etiquetadas con puntos clave para tareas de estimación de la pose.

- El conjunto de datos admite 17 puntos clave para figuras humanas, lo que facilita la estimación detallada de la pose.

- Al igual que COCO, proporciona métricas de evaluación estandarizadas, incluido el Object Keypoint Similarity (OKS) para tareas de estimación de la pose, lo que lo hace adecuado para comparar el rendimiento del modelo.

Estructura del conjunto de datos

El dataset COCO-Pose se divide en tres subconjuntos:

- Train2017: Este subconjunto contiene 56599 imágenes del conjunto de datos COCO, anotadas para el entrenamiento de modelos de estimación de pose.

- Val2017: Este subconjunto tiene 2346 imágenes utilizadas para fines de validación durante el entrenamiento del modelo.

- Test2017: Este subconjunto consta de imágenes utilizadas para probar y evaluar los modelos entrenados. Las anotaciones de ground truth para este subconjunto no están disponibles públicamente, y los resultados se envían al servidor de evaluación COCO para la evaluación del rendimiento.

Aplicaciones

El dataset COCO-Pose se utiliza específicamente para entrenar y evaluar modelos de aprendizaje profundo en tareas de detección de puntos clave y estimación de la pose, como OpenPose. El gran número de imágenes anotadas del dataset y las métricas de evaluación estandarizadas lo convierten en un recurso esencial para los investigadores y profesionales de la visión artificial centrados en la estimación de la pose.

YAML del conjunto de datos

Se utiliza un archivo YAML (Yet Another Markup Language) para definir la configuración del dataset. Contiene información sobre las rutas, las clases y otra información relevante del dataset. En el caso del dataset COCO-Pose, el coco-pose.yaml archivo se mantiene en https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco-pose.yaml.

ultralytics/cfg/datasets/coco-pose.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 Keypoints dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/pose/coco/

# Example usage: yolo train data=coco-pose.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco-pose ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco-pose # dataset root dir

train: train2017.txt # train images (relative to 'path') 56599 images

val: val2017.txt # val images (relative to 'path') 2346 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://codalab.lisn.upsaclay.fr/competitions/7403

# Keypoints

kpt_shape: [17, 3] # number of keypoints, number of dims (2 for x,y or 3 for x,y,visible)

flip_idx: [0, 2, 1, 4, 3, 6, 5, 8, 7, 10, 9, 12, 11, 14, 13, 16, 15]

# Classes

names:

0: person

# Keypoint names per class

kpt_names:

0:

- nose

- left_eye

- right_eye

- left_ear

- right_ear

- left_shoulder

- right_shoulder

- left_elbow

- right_elbow

- left_wrist

- right_wrist

- left_hip

- right_hip

- left_knee

- right_knee

- left_ankle

- right_ankle

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

dir = Path(yaml["path"]) # dataset root dir

urls = [f"{ASSETS_URL}/coco2017labels-pose.zip"]

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Uso

Para entrenar un modelo YOLO26n-pose en el conjunto de datos COCO-Pose durante 100 épocas con un tamaño de imagen de 640, puede utilizar los siguientes fragmentos de código. Para obtener una lista completa de los argumentos disponibles, consulte la página de Entrenamiento del modelo.

Ejemplo de entrenamiento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-pose.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco-pose.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo pose train data=coco-pose.yaml model=yolo26n-pose.pt epochs=100 imgsz=640

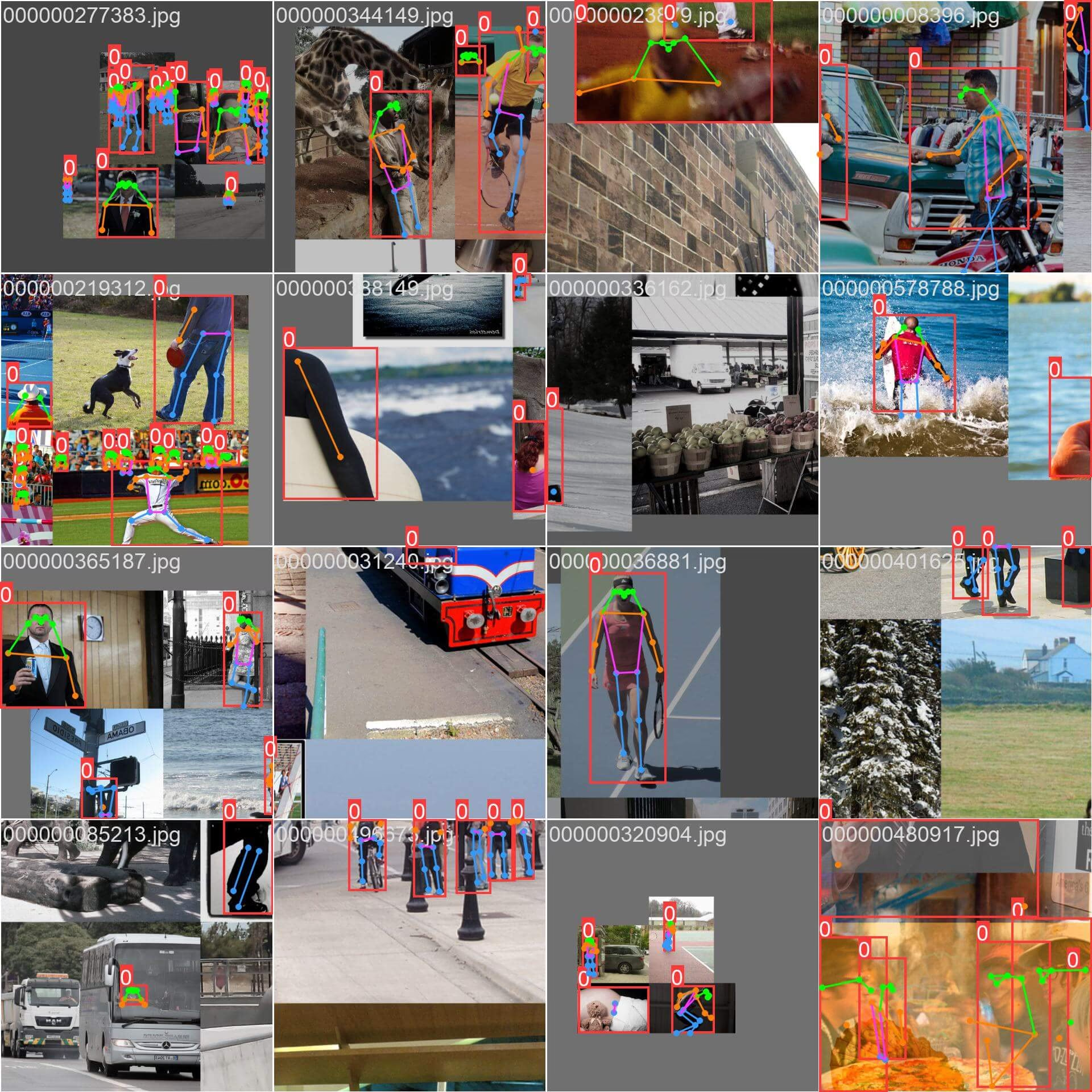

sample_images y anotaciones

El dataset COCO-Pose contiene un conjunto diverso de imágenes con figuras humanas anotadas con puntos clave. Aquí hay algunos ejemplos de imágenes del dataset, junto con sus correspondientes anotaciones:

- Imagen en mosaico: Esta imagen muestra un lote de entrenamiento compuesto por imágenes en mosaico del conjunto de datos. El mosaico es una técnica utilizada durante el entrenamiento que combina varias imágenes en una sola imagen para aumentar la variedad de objetos y escenas dentro de cada lote de entrenamiento. Esto ayuda a mejorar la capacidad del modelo para generalizar a diferentes tamaños de objetos, relaciones de aspecto y contextos.

El ejemplo muestra la variedad y complejidad de las imágenes en el conjunto de datos COCO-Pose y los beneficios de utilizar el mosaico durante el proceso de entrenamiento.

Citas y agradecimientos

Si utiliza el dataset COCO-Pose en su trabajo de investigación o desarrollo, cite el siguiente artículo:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Nos gustaría agradecer al Consorcio COCO por crear y mantener este valioso recurso para la comunidad de visión artificial. Para obtener más información sobre el conjunto de datos COCO-Pose y sus creadores, visite el sitio web del conjunto de datos COCO.

Preguntas frecuentes

¿Qué es el conjunto de datos COCO-Pose y cómo se utiliza con Ultralytics YOLO para la estimación de poses?

El conjunto de datos COCO-Pose es una versión especializada del conjunto de datos COCO (Common Objects in Context) diseñado para tareas de estimación de pose. Se basa en las imágenes y anotaciones de COCO Keypoints 2017, lo que permite el entrenamiento de modelos como Ultralytics YOLO para una estimación de pose detallada. Por ejemplo, puede utilizar el conjunto de datos COCO-Pose para entrenar un modelo YOLO26n-pose cargando un modelo preentrenado y entrenándolo con una configuración YAML. Para ver ejemplos de entrenamiento, consulte la documentación de Entrenamiento.

¿Cómo puedo entrenar un modelo YOLO26 en el conjunto de datos COCO-Pose?

El entrenamiento de un modelo YOLO26 en el conjunto de datos COCO-Pose se puede realizar utilizando comandos Python o CLI. Por ejemplo, para entrenar un modelo YOLO26n-pose durante 100 épocas con un tamaño de imagen de 640, puede seguir los pasos que se indican a continuación:

Ejemplo de entrenamiento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-pose.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco-pose.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo pose train data=coco-pose.yaml model=yolo26n-pose.pt epochs=100 imgsz=640

Para obtener más detalles sobre el proceso de entrenamiento y los argumentos disponibles, consulta la página de entrenamiento.

¿Cuáles son las diferentes métricas proporcionadas por el conjunto de datos COCO-Pose para evaluar el rendimiento del modelo?

El conjunto de datos COCO-Pose proporciona varias métricas de evaluación estandarizadas para tareas de estimación de pose, similares al conjunto de datos COCO original. Las métricas clave incluyen la similitud de puntos clave de objetos (OKS), que evalúa la precisión de los puntos clave predichos frente a las anotaciones de verdad fundamental. Estas métricas permiten comparaciones exhaustivas del rendimiento entre diferentes modelos. Por ejemplo, los modelos preentrenados de COCO-Pose como YOLO26n-pose, YOLO26s-pose y otros tienen métricas de rendimiento específicas enumeradas en la documentación, como mAPpose50-95 y mAPpose50.

¿Cómo se estructura y divide el conjunto de datos para el conjunto de datos COCO-Pose?

El dataset COCO-Pose se divide en tres subconjuntos:

- Train2017: Contiene 56599 imágenes COCO, anotadas para el entrenamiento de modelos de estimación de pose.

- Val2017: 2346 imágenes para fines de validación durante el entrenamiento del modelo.

- Test2017: Imágenes utilizadas para probar y evaluar modelos entrenados. Las anotaciones de ground truth para este subconjunto no están disponibles públicamente; los resultados se envían al servidor de evaluación COCO para la evaluación del rendimiento.

Estos subconjuntos ayudan a organizar eficazmente las fases de entrenamiento, validación y prueba. Para obtener detalles de configuración, explore el coco-pose.yaml archivo disponible en GitHub.

¿Cuáles son las características clave y las aplicaciones del conjunto de datos COCO-Pose?

El conjunto de datos COCO-Pose amplía las anotaciones de COCO Keypoints 2017 para incluir 17 puntos clave para figuras humanas, lo que permite una estimación de pose detallada. Las métricas de evaluación estandarizadas (por ejemplo, OKS) facilitan las comparaciones entre diferentes modelos. Las aplicaciones del conjunto de datos COCO-Pose abarcan varios dominios, como el análisis deportivo, la atención médica y la interacción persona-ordenador, dondequiera que se requiera una estimación detallada de la pose de figuras humanas. Para un uso práctico, el aprovechamiento de modelos preentrenados como los proporcionados en la documentación (por ejemplo, YOLO26n-pose) puede agilizar significativamente el proceso (Características clave).

Si utiliza el dataset COCO-Pose en su trabajo de investigación o desarrollo, cite el artículo con la siguiente entrada BibTeX.