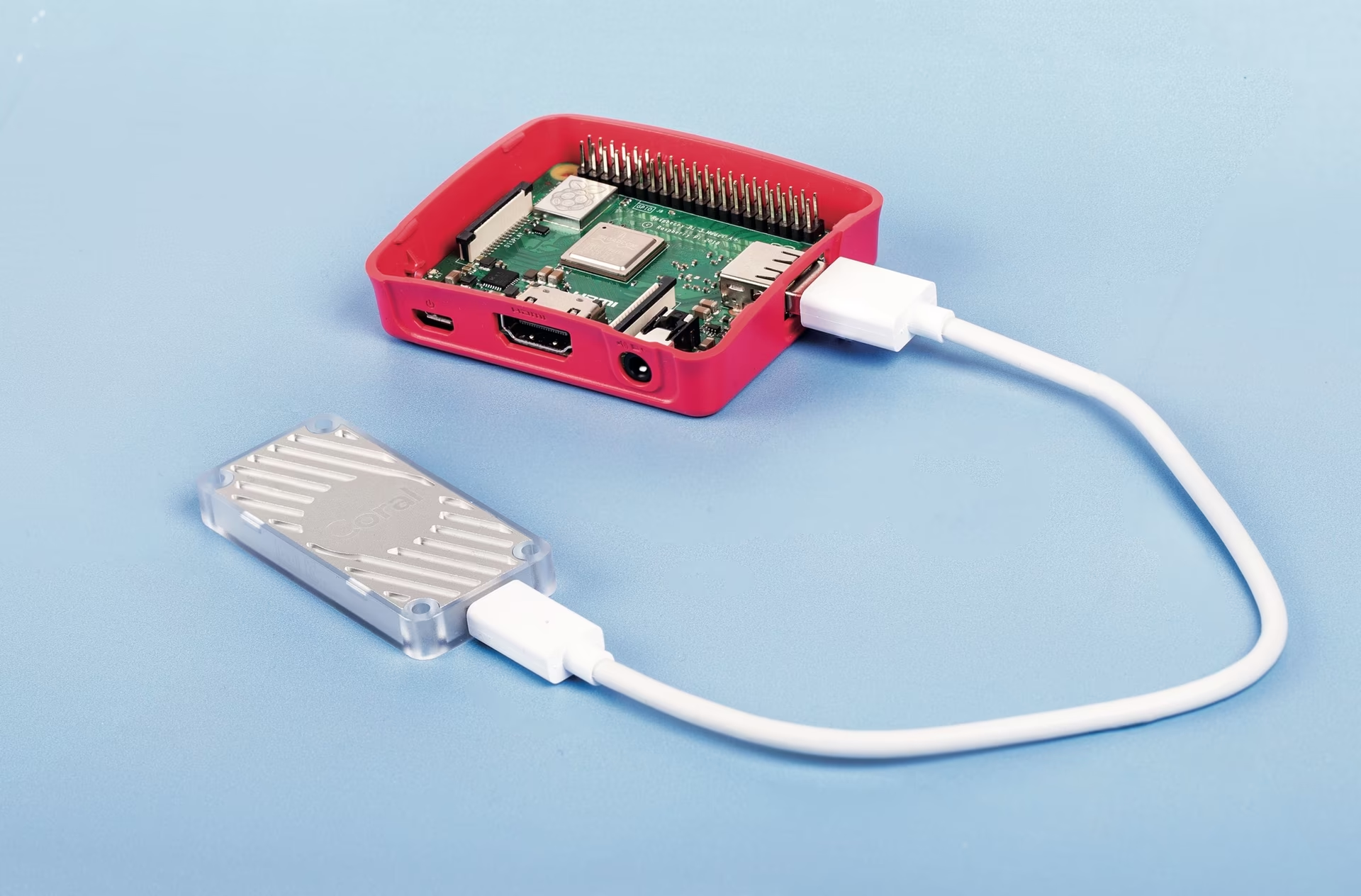

Coral Edge TPU sur un Raspberry Pi avec Ultralytics YOLO26 🚀

Qu'est-ce qu'un Coral Edge TPU ?

Le Coral Edge TPU est un appareil compact qui ajoute un coprocesseur Edge TPU à votre système. Il permet une inférence ML à faible consommation d'énergie et à haute performance pour les modèles TensorFlow Lite. Pour en savoir plus, consultez la page d'accueil de Coral Edge TPU.

Regarder : Comment exécuter l'inférence sur Raspberry Pi à l'aide de Google Coral Edge TPU

Améliorer les performances du modèle Raspberry Pi avec Coral Edge TPU

Beaucoup de gens veulent exécuter leurs modèles sur un appareil embarqué ou mobile tel qu'un Raspberry Pi, car ils sont très économes en énergie et peuvent être utilisés dans de nombreuses applications différentes. Cependant, les performances d'inférence sur ces appareils sont généralement médiocres, même en utilisant des formats comme ONNX ou OpenVINO. Le Coral Edge TPU est une excellente solution à ce problème, car il peut être utilisé avec un Raspberry Pi et accélérer considérablement les performances d'inférence.

Edge TPU sur Raspberry Pi avec TensorFlow Lite (Nouveau)⭐

Le guide existant de Coral sur l'utilisation de l'Edge TPU avec un Raspberry Pi est obsolète, et les versions actuelles de l'exécution Coral Edge TPU ne fonctionnent plus avec les versions actuelles de l'exécution TensorFlow Lite. De plus, Google semble avoir complètement abandonné le projet Coral, et il n'y a eu aucune mise à jour entre 2021 et 2025. Ce guide vous montrera comment faire fonctionner l'Edge TPU avec les dernières versions de l'exécution TensorFlow Lite et une exécution Coral Edge TPU mise à jour sur un ordinateur monocarte Raspberry Pi (SBC).

Prérequis

- Raspberry Pi 4B (2 Go ou plus recommandé) ou Raspberry Pi 5 (Recommandé)

- Raspberry Pi OS Bullseye/Bookworm (64 bits) avec bureau (Recommandé)

- Accélérateur USB Coral

- Une plateforme non basée sur ARM pour exporter un modèle PyTorch Ultralytics

Procédure d'installation

Ce guide suppose que vous avez déjà une installation fonctionnelle de Raspberry Pi OS et que vous avez installé ultralytics et toutes les dépendances. Pour obtenir ultralytics installé, consultez la guide de démarrage rapide pour vous installer avant de continuer ici.

Installation de l'environnement d'exécution Edge TPU

Tout d'abord, nous devons installer le runtime Edge TPU. De nombreuses versions différentes sont disponibles, vous devez donc choisir la bonne version pour votre système d'exploitation. La version haute fréquence fait fonctionner l'Edge TPU à une vitesse d'horloge plus élevée, ce qui améliore les performances. Cependant, cela pourrait entraîner un étranglement thermique de l'Edge TPU, il est donc recommandé de prévoir un mécanisme de refroidissement.

| Raspberry Pi OS | Mode haute fréquence | Version à télécharger |

|---|---|---|

| Bullseye 32bit | Non | libedgetpu1-std_ ... .bullseye_armhf.deb |

| Bullseye 64bit | Non | libedgetpu1-std_ ... .bullseye_arm64.deb |

| Bullseye 32bit | Oui | libedgetpu1-max_ ... .bullseye_armhf.deb |

| Bullseye 64bit | Oui | libedgetpu1-max_ ... .bullseye_arm64.deb |

| Bookworm 32bit | Non | libedgetpu1-std_ ... .bookworm_armhf.deb |

| Bookworm 64bit | Non | libedgetpu1-std_ ... .bookworm_arm64.deb |

| Bookworm 32bit | Oui | libedgetpu1-max_ ... .bookworm_armhf.deb |

| Bookworm 64bit | Oui | libedgetpu1-max_ ... .bookworm_arm64.deb |

Téléchargez la dernière version ici.

Après avoir téléchargé le fichier, vous pouvez l'installer avec la commande suivante :

sudo dpkg -i path/to/package.deb

Après avoir installé le runtime, branchez votre Coral Edge TPU dans un port USB 3.0 sur le Raspberry Pi afin que le nouveau udev la règle peut prendre effet.

Important

Si vous avez déjà installé le runtime Coral Edge TPU, désinstallez-le à l'aide de la commande suivante.

# If you installed the standard version

sudo apt remove libedgetpu1-std

# If you installed the high-frequency version

sudo apt remove libedgetpu1-max

Exporter vers Edge TPU

Pour utiliser l'Edge TPU, vous devez convertir votre modèle dans un format compatible. Il est recommandé d'effectuer l'exportation sur Google Colab, une machine Linux x86_64, en utilisant le conteneur Docker officiel d'Ultralytics, ou en utilisant Ultralytics Platform, car le compilateur Edge TPU n'est pas disponible sur ARM. Consultez le mode d'exportation pour les arguments disponibles.

Exporter le modèle

from ultralytics import YOLO

# Load a model

model = YOLO("path/to/model.pt") # Load an official model or custom model

# Export the model

model.export(format="edgetpu")

yolo export model=path/to/model.pt format=edgetpu # Export an official model or custom model

Le modèle exporté sera enregistré dans le <model_name>_saved_model/ dossier portant le nom <model_name>_full_integer_quant_edgetpu.tflite. Assurez-vous que le nom du fichier se termine par le _edgetpu.tflite suffixe ; sinon, Ultralytics ne détectera pas que vous utilisez un modèle Edge TPU.

Exécution du modèle

Avant de pouvoir réellement exécuter le modèle, vous devrez installer les bibliothèques appropriées.

Si TensorFlow est déjà installé, désinstallez-le avec la commande suivante :

pip uninstall tensorflow tensorflow-aarch64

Ensuite, installez ou mettez à jour tflite-runtime:

pip install -U tflite-runtime

Vous pouvez maintenant exécuter l'inférence en utilisant le code suivant :

Exécution du modèle

from ultralytics import YOLO

# Load a model

model = YOLO("path/to/<model_name>_full_integer_quant_edgetpu.tflite") # Load an official model or custom model

# Run Prediction

model.predict("path/to/source.png")

yolo predict model=path/to/MODEL_NAME_full_integer_quant_edgetpu.tflite source=path/to/source.png # Load an official model or custom model

Trouvez des informations complètes sur la page Predict pour tous les détails sur le mode de prédiction.

Inférence avec plusieurs Edge TPU

Si vous avez plusieurs Edge TPU, vous pouvez utiliser le code suivant pour sélectionner une TPU spécifique.

from ultralytics import YOLO

# Load a model

model = YOLO("path/to/<model_name>_full_integer_quant_edgetpu.tflite") # Load an official model or custom model

# Run Prediction

model.predict("path/to/source.png") # Inference defaults to the first TPU

model.predict("path/to/source.png", device="tpu:0") # Select the first TPU

model.predict("path/to/source.png", device="tpu:1") # Select the second TPU

Bancs d'essai

Bancs d'essai

Testé avec Raspberry Pi OS Bookworm 64 bits et un USB Coral Edge TPU.

Remarque

Le temps d'inférence est indiqué, le pré-/post-traitement n'est pas inclus.

| Taille de l'image | Modèle | Temps d'inférence standard (ms) | Temps d'inférence haute fréquence (ms) |

|---|---|---|---|

| 320 | YOLOv8n | 32.2 | 26.7 |

| 320 | YOLOv8s | 47.1 | 39.8 |

| 512 | YOLOv8n | 73.5 | 60.7 |

| 512 | YOLOv8s | 149.6 | 125.3 |

| Taille de l'image | Modèle | Temps d'inférence standard (ms) | Temps d'inférence à haute fréquence (ms) |

|---|---|---|---|

| 320 | YOLOv8n | 22.2 | 16.7 |

| 320 | YOLOv8s | 40.1 | 32.2 |

| 512 | YOLOv8n | 53.5 | 41.6 |

| 512 | YOLOv8s | 132.0 | 103.3 |

En moyenne :

- Le Raspberry Pi 5 est 22 % plus rapide en mode standard que le Raspberry Pi 4B.

- Le Raspberry Pi 5 est 30,2 % plus rapide en mode haute fréquence que le Raspberry Pi 4B.

- Le mode haute fréquence est 28,4 % plus rapide que le mode standard.

FAQ

Qu'est-ce qu'un Coral Edge TPU et comment améliore-t-il les performances du Raspberry Pi avec Ultralytics YOLO26 ?

Le Coral Edge TPU est un appareil compact conçu pour ajouter un coprocesseur Edge TPU à votre système. Ce coprocesseur permet une inférence de machine learning à faible consommation et haute performance, particulièrement optimisée pour les modèles TensorFlow Lite. Lors de l'utilisation d'un Raspberry Pi, l'Edge TPU accélère l'inférence des modèles ML, augmentant considérablement les performances, en particulier pour les modèles Ultralytics YOLO26. Vous pouvez en savoir plus sur le Coral Edge TPU sur leur page d'accueil.

Comment installer l’environnement d’exécution Coral Edge TPU sur un Raspberry Pi ?

Pour installer l'environnement d'exécution Coral Edge TPU sur votre Raspberry Pi, téléchargez le .deb paquet pour votre version de Raspberry Pi OS à partir de ce lien. Une fois téléchargé, utilisez la commande suivante pour l'installer :

sudo dpkg -i path/to/package.deb

Assurez-vous de désinstaller toutes les versions précédentes du runtime Coral Edge TPU en suivant les étapes décrites dans la section Procédure d'installation.

Puis-je exporter mon modèle Ultralytics YOLO26 pour qu'il soit compatible avec le Coral Edge TPU ?

Oui, vous pouvez exporter votre modèle Ultralytics YOLO26 pour qu'il soit compatible avec le Coral Edge TPU. Il est recommandé d'effectuer l'exportation sur Google Colab, une machine Linux x86_64, ou en utilisant le conteneur Docker Ultralytics. Vous pouvez également utiliser Ultralytics Platform pour l'exportation. Voici comment vous pouvez exporter votre modèle en utilisant python et la CLI :

Exporter le modèle

from ultralytics import YOLO

# Load a model

model = YOLO("path/to/model.pt") # Load an official model or custom model

# Export the model

model.export(format="edgetpu")

yolo export model=path/to/model.pt format=edgetpu # Export an official model or custom model

Pour plus d'informations, consultez la documentation sur le Mode d'exportation.

Que dois-je faire si TensorFlow est déjà installé sur mon Raspberry Pi, mais que je souhaite utiliser tflite-runtime à la place ?

Si TensorFlow est installé sur votre Raspberry Pi et que vous devez passer à tflite-runtime, vous devrez d'abord désinstaller TensorFlow en utilisant :

pip uninstall tensorflow tensorflow-aarch64

Ensuite, installez ou mettez à jour tflite-runtime avec la commande suivante :

pip install -U tflite-runtime

Pour des instructions détaillées, consultez la section Exécution du modèle.

Comment exécuter l'inférence avec un modèle YOLO26 exporté sur un Raspberry Pi à l'aide du Coral Edge TPU ?

Après avoir exporté votre modèle YOLO26 vers un format compatible Edge TPU, vous pouvez exécuter l'inférence à l'aide des extraits de code suivants :

Exécution du modèle

from ultralytics import YOLO

# Load a model

model = YOLO("path/to/edgetpu_model.tflite") # Load an official model or custom model

# Run Prediction

model.predict("path/to/source.png")

yolo predict model=path/to/edgetpu_model.tflite source=path/to/source.png # Load an official model or custom model

Vous trouverez des informations complètes sur les fonctionnalités du mode de prédiction complète sur la page Prédiction.