Comprendre les étapes clés d'un projet de vision par ordinateur

Introduction

La vision par ordinateur est un sous-domaine de l’intelligence artificielle (IA) qui aide les ordinateurs à voir et à comprendre le monde comme le font les humains. Elle traite et analyse des images ou des vidéos pour extraire des informations, reconnaître des motifs et prendre des décisions basées sur ces données.

Regarder : Comment faire Vision par ordinateur Projets | Un guide étape par étape

Les techniques de vision par ordinateur telles que la détection d’objets, la classification d’images et la segmentation d’instances peuvent être appliquées dans divers secteurs, de la conduite autonome à l’imagerie médicale, afin d’obtenir des informations précieuses.

Travailler sur vos propres projets de vision par ordinateur est un excellent moyen de mieux comprendre et d'apprendre la vision par ordinateur. Cependant, un projet de vision par ordinateur peut comporter de nombreuses étapes, et cela peut sembler déroutant au début. À la fin de ce guide, vous serez familiarisé avec les étapes impliquées dans un projet de vision par ordinateur. Nous passerons en revue toutes les étapes, du début à la fin d'un projet, en expliquant l'importance de chaque partie.

Présentation d'un projet de vision par ordinateur

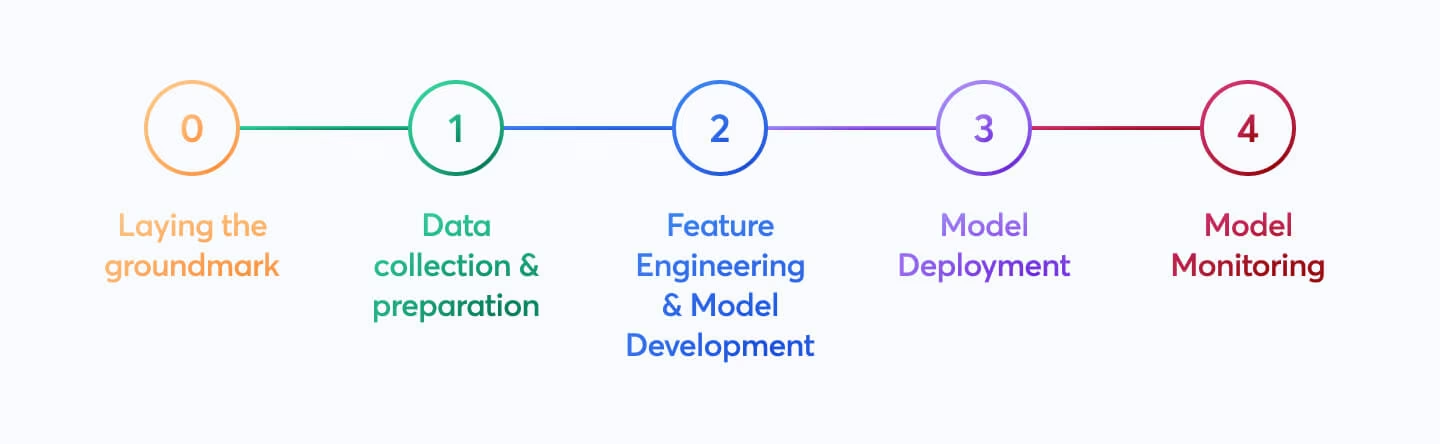

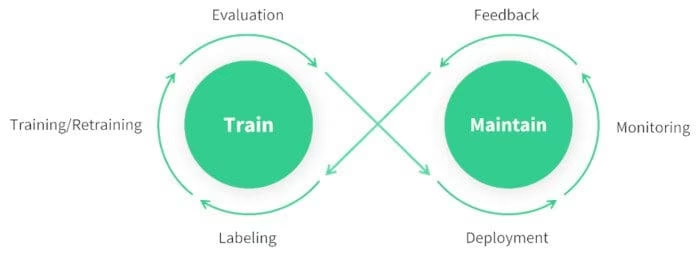

Avant de discuter des détails de chaque étape impliquée dans un projet de vision par ordinateur, examinons le processus global. Si vous démarriez un projet de vision par ordinateur aujourd'hui, vous suivriez les étapes suivantes :

- Votre première priorité serait de comprendre les exigences de votre projet.

- Ensuite, vous collecterez et étiqueterez avec précision les images qui aideront à entraîner votre modèle.

- Ensuite, vous nettoierez vos données et appliquerez des techniques d'augmentation pour les préparer à l'entraînement du modèle.

- Après l'entraînement du modèle, vous devez tester et évaluer minutieusement votre modèle pour vous assurer qu'il fonctionne de manière cohérente dans différentes conditions.

- Enfin, vous déploieriez votre modèle dans le monde réel et le mettriez à jour en fonction de nouvelles perspectives et de commentaires.

Maintenant que nous savons à quoi nous attendre, plongeons directement dans les étapes et faisons avancer votre projet.

Étape 1 : Définir les objectifs de votre projet

La première étape de tout projet de vision par ordinateur consiste à définir clairement le problème que vous essayez de résoudre. Connaître l'objectif final vous aide à commencer à construire une solution. Cela est particulièrement vrai en matière de vision par ordinateur, car l'objectif de votre projet aura une incidence directe sur la tâche de vision par ordinateur sur laquelle vous devez vous concentrer.

Voici quelques exemples d'objectifs de projet et des tâches de vision par ordinateur qui peuvent être utilisées pour atteindre ces objectifs :

Objectif : Développer un système capable de surveiller et de gérer le flux de différents types de véhicules sur les autoroutes, améliorant ainsi la gestion du trafic et la sécurité.

- Tâche de vision par ordinateur : La détection d’objets est idéale pour la surveillance du trafic, car elle localise et identifie efficacement plusieurs véhicules. Elle est moins exigeante en calcul que la segmentation d’images, qui fournit des détails inutiles pour cette tâche, assurant ainsi une analyse plus rapide en temps réel.

Objectif : Développer un outil qui aide les radiologues en fournissant des contours précis, au niveau du pixel, des tumeurs dans les images médicales.

- Tâche de vision par ordinateur : La segmentation d’images convient à l’imagerie médicale, car elle fournit des limites précises et détaillées des tumeurs qui sont essentielles pour évaluer la taille, la forme et la planification du traitement.

Objectif : Créer un système numérique qui catégorise divers documents (par exemple, factures, reçus, documents juridiques) afin d'améliorer l'efficacité organisationnelle et la récupération des documents.

- Tâche de vision par ordinateur :La classification d’images est idéale ici, car elle traite un document à la fois, sans avoir à tenir compte de la position du document dans l’image. Cette approche simplifie et accélère le processus de tri.

Étape 1.5 : Sélection du bon modèle et de l'approche d'entraînement

Après avoir compris l'objectif du projet et les tâches de vision par ordinateur appropriées, une partie essentielle de la définition de l'objectif du projet est de sélectionner le bon modèle et l'approche d'entraînement.

Selon l'objectif, vous pouvez choisir de sélectionner le modèle en premier ou après avoir vu quelles données vous êtes en mesure de collecter à l'étape 2. Par exemple, supposons que votre projet dépende fortement de la disponibilité de types de données spécifiques. Dans ce cas, il peut être plus pratique de collecter et d'analyser les données d'abord avant de sélectionner un modèle. D'un autre côté, si vous avez une compréhension claire des exigences du modèle, vous pouvez choisir le modèle en premier, puis collecter les données qui correspondent à ces spécifications.

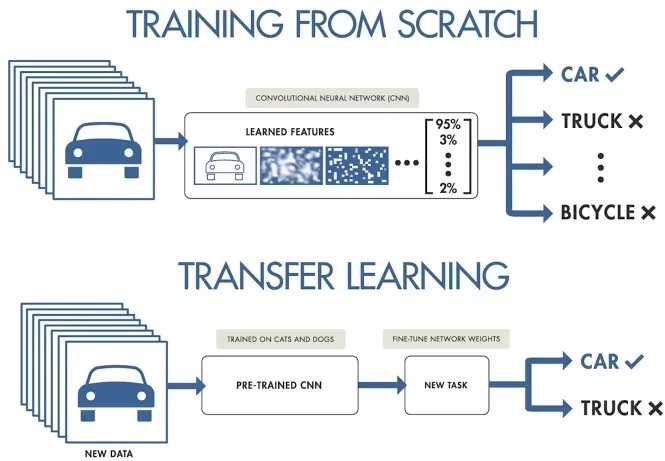

Le choix entre un entraînement à partir de zéro ou l'utilisation du transfert d'apprentissage affecte la manière dont vous préparez vos données. L'entraînement à partir de zéro nécessite un jeu de données diversifié pour construire la compréhension du modèle dès le départ. Le transfert d'apprentissage, en revanche, vous permet d'utiliser un modèle pré-entraîné et de l'adapter avec un jeu de données plus petit et plus spécifique. De plus, le choix d'un modèle spécifique à entraîner déterminera la manière dont vous devrez préparer vos données, comme le redimensionnement des images ou l'ajout d'annotations, en fonction des exigences spécifiques du modèle.

Remarque : lors du choix d'un modèle, tenez compte de son déploiement pour garantir la compatibilité et les performances. Par exemple, les modèles légers sont idéaux pour l'edge computing en raison de leur efficacité sur les appareils aux ressources limitées. Pour en savoir plus sur les points clés liés à la définition de votre projet, consultez notre guide sur la définition des objectifs de votre projet et la sélection du bon modèle.

Avant de se lancer dans le travail pratique d'un projet de vision par ordinateur, il est important d'avoir une compréhension claire de ces détails. Vérifiez que vous avez bien pris en compte les points suivants avant de passer à l'étape 2:

- Définissez clairement le problème que vous essayez de résoudre.

- Déterminez l'objectif final de votre projet.

- Identifier la tâche de vision par ordinateur spécifique requise (par exemple, la détection d'objets, la classification d'images, la segmentation d'images).

- Décidez s'il faut entraîner un modèle à partir de zéro ou utiliser l'apprentissage par transfert.

- Sélectionnez le modèle approprié en fonction de votre tâche et de vos besoins de déploiement.

Étape 2 : Collecte et annotation des données

La qualité de vos modèles de vision par ordinateur dépend de la qualité de votre jeu de données. Vous pouvez soit collecter des images sur Internet, prendre vos propres photos, ou utiliser des jeux de données préexistants. Voici quelques excellentes ressources pour télécharger des jeux de données de haute qualité : Moteur de recherche de jeux de données Google, Référentiel d'apprentissage automatique de l'UC Irvine et Kaggle Datasets.

Certaines bibliothèques, comme Ultralytics, offrent une prise en charge intégrée de divers ensembles de données, ce qui facilite la prise en main de données de haute qualité. Ces bibliothèques incluent souvent des utilitaires permettant d'utiliser de manière transparente les ensembles de données populaires, ce qui peut vous faire gagner beaucoup de temps et d'efforts dans les premières étapes de votre projet.

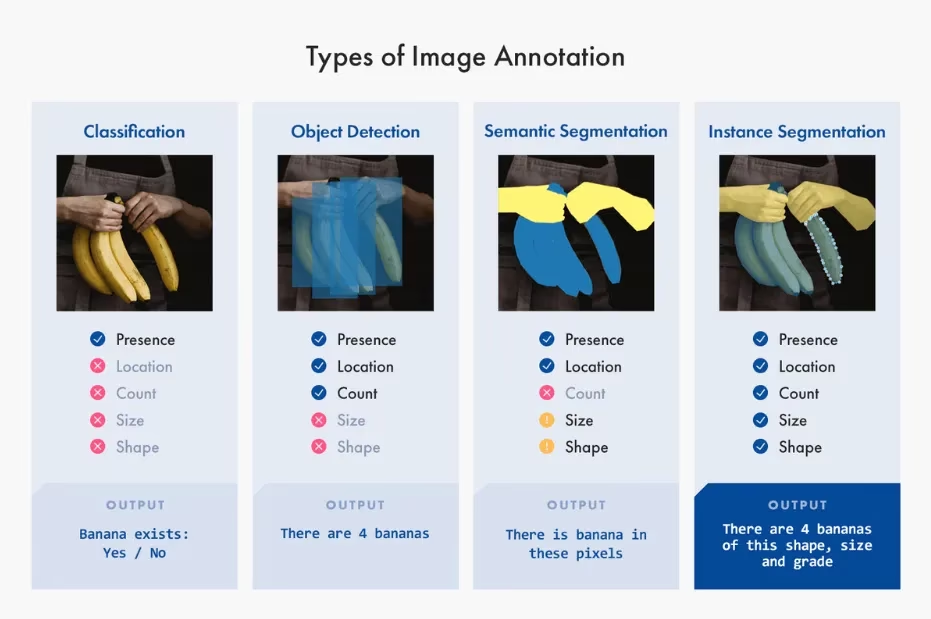

Cependant, si vous choisissez de collecter des images ou de prendre vos propres photos, vous devrez annoter vos données. L'annotation de données est le processus de labellisation de vos données pour transmettre des connaissances à votre modèle. Le type d'annotation de données avec lequel vous travaillerez dépend de votre technique de vision par ordinateur spécifique. Voici quelques exemples :

- Classification d'images : Vous étiqueterez l'image entière comme une seule classe.

- Détection d'objets: Vous dessinerez des cadres de délimitation autour de chaque objet dans l'image et étiquetterez chaque cadre.

- Segmentation d'image: Vous étiquetterez chaque pixel de l'image en fonction de l'objet auquel il appartient, créant ainsi des limites d'objet détaillées.

La collecte et l'annotation des données peuvent être un effort manuel chronophage. Les outils d'annotation peuvent faciliter ce processus. Voici quelques outils d'annotation open source utiles : LabeI Studio, CVAT et Labelme.

Étape 3 : Augmentation des données et division de votre jeu de données

Après avoir collecté et annoté vos données d'image, il est important de d'abord diviser votre ensemble de données en ensembles d'entraînement, de validation et de test avant d'effectuer l'augmentation de données. La division de votre ensemble de données avant l'augmentation est essentielle pour tester et valider votre modèle sur des données originales et non modifiées. Cela permet d'évaluer avec précision la façon dont le modèle se généralise à de nouvelles données non vues.

Voici comment diviser vos données :

- Ensemble d’entraînement : Il s’agit de la plus grande partie de vos données, généralement 70 à 80 % du total, utilisée pour entraîner votre modèle.

- Ensemble de validation : Généralement environ 10 à 15 % de vos données ; cet ensemble est utilisé pour ajuster les hyperparamètres et valider le modèle pendant l’entraînement, ce qui aide à prévenir le surapprentissage.

- Ensemble de test : Les 10 à 15 % restants de vos données sont mis de côté en tant qu’ensemble de test. Il est utilisé pour évaluer les performances du modèle sur des données invisibles une fois l’apprentissage terminé.

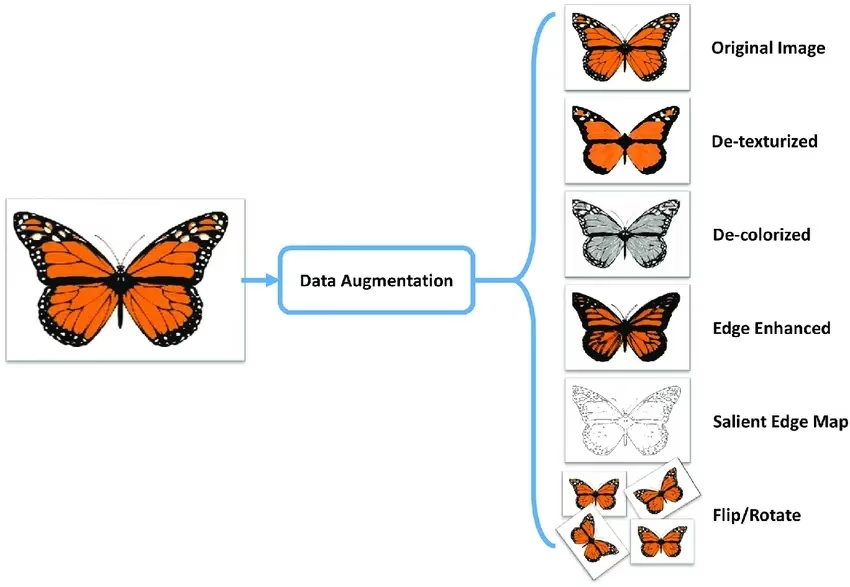

Après avoir divisé vos données, vous pouvez effectuer une augmentation des données en appliquant des transformations telles que la rotation, la mise à l'échelle et le retournement des images pour augmenter artificiellement la taille de votre ensemble de données. L'augmentation des données rend votre modèle plus robuste aux variations et améliore ses performances sur les images invisibles.

Des bibliothèques comme OpenCV, Albumentations et TensorFlow offrent des fonctions d'augmentation flexibles que vous pouvez utiliser. De plus, certaines bibliothèques, telles que Ultralytics, ont des paramètres d'augmentation intégrés directement dans leur fonction d'entraînement de modèle, ce qui simplifie le processus.

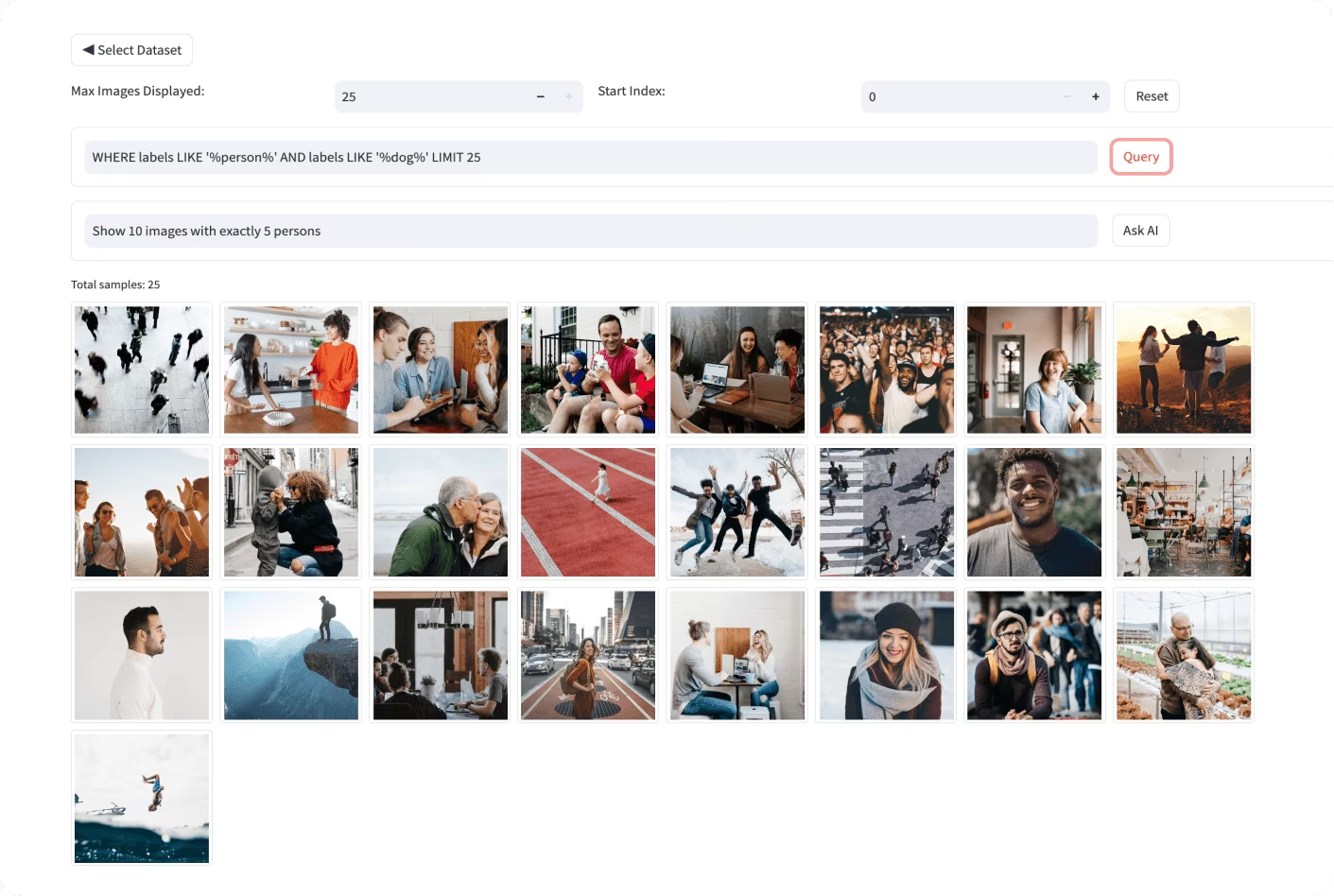

Pour mieux comprendre vos données, vous pouvez utiliser des outils tels que Matplotlib ou Seaborn pour visualiser les images et analyser leur distribution et leurs caractéristiques. La visualisation de vos données permet d'identifier les tendances, les anomalies et l'efficacité de vos techniques d'augmentation. Vous pouvez également utiliser Ultralytics Explorer, un outil permettant d'explorer les ensembles de données de vision par ordinateur avec la recherche sémantique, les requêtes SQL et la recherche de similarité vectorielle.

En comprenant, divisant et augmentant correctement vos données, vous pouvez développer un modèle bien entraîné, validé et testé qui fonctionne bien dans les applications du monde réel.

Étape 4 : Entraînement du modèle

Une fois que votre jeu de données est prêt pour l'entraînement, vous pouvez vous concentrer sur la configuration de l'environnement nécessaire, la gestion de vos jeux de données et l'entraînement de votre modèle.

Tout d'abord, vous devez vous assurer que votre environnement est correctement configuré. En général, cela comprend les éléments suivants :

- Installation des bibliothèques et frameworks essentiels tels que TensorFlow, PyTorch ou Ultralytics.

- Si vous utilisez un GPU, l'installation de bibliothèques telles que CUDA et cuDNN contribuera à activer l'accélération GPU et à accélérer le processus d'entraînement.

Ensuite, vous pouvez charger vos ensembles de données d'entraînement et de validation dans votre environnement. Normalisez et prétraitez les données en redimensionnant, en convertissant le format ou en augmentant les données. Une fois votre modèle sélectionné, configurez les couches et spécifiez les hyperparamètres. Compilez le modèle en définissant la fonction de perte, l'optimiseur et les métriques de performance.

Les bibliothèques comme Ultralytics simplifient le processus d'entraînement. Vous pouvez commencer l'entraînement en alimentant le modèle avec des données avec un minimum de code. Ces bibliothèques gèrent automatiquement les ajustements de poids, la rétropropagation et la validation. Elles offrent également des outils pour surveiller la progression et ajuster facilement les hyperparamètres. Après l'entraînement, enregistrez le modèle et ses poids avec quelques commandes.

Il est important de garder à l'esprit qu'une gestion appropriée des ensembles de données est essentielle pour un entraînement efficace. Utilisez le contrôle de version pour les ensembles de données afin de suivre les modifications et de garantir la reproductibilité. Des outils tels que DVC (Data Version Control) peuvent vous aider à gérer les grands ensembles de données.

Étape 5 : Évaluation du modèle et ajustement précis du modèle

Il est important d'évaluer les performances de votre modèle à l'aide de diverses métriques et de l'affiner pour améliorer la précision. L'évaluation permet d'identifier les domaines dans lesquels le modèle excelle et ceux dans lesquels il peut nécessiter des améliorations. Le réglage fin garantit que le modèle est optimisé pour les meilleures performances possibles.

- Mesures de performance: Utilisez des mesures telles que la précision, la précision, le rappel et le score F1 pour évaluer les performances de votre modèle. Ces mesures donnent un aperçu de la qualité des prédictions de votre modèle.

- Réglage des hyperparamètres: Ajustez les hyperparamètres pour optimiser les performances du modèle. Des techniques telles que la recherche sur grille ou la recherche aléatoire peuvent aider à trouver les meilleures valeurs d'hyperparamètres.

- Ajustement fin : Apportez de petites modifications à l’architecture du modèle ou au processus de formation pour améliorer les performances. Cela peut impliquer de modifier les taux d’apprentissage, les tailles de lots ou d’autres paramètres du modèle.

Pour une compréhension plus approfondie de l'évaluation des modèles et des techniques de réglage fin, consultez notre guide sur l'analyse de l'évaluation des modèles.

Étape 6 : Test du modèle

Au cours de cette étape, vous pouvez vous assurer que votre modèle fonctionne correctement sur des données totalement inédites, ce qui confirme qu'il est prêt à être déployé. La différence entre le test et l'évaluation du modèle réside dans le fait qu'il se concentre sur la vérification des performances du modèle final plutôt que sur son amélioration itérative.

Il est important de tester et de déboguer minutieusement tout problème courant qui pourrait survenir. Testez votre modèle sur un ensemble de données de test distinct qui n'a pas été utilisé pendant l'entraînement ou la validation. Cet ensemble de données doit représenter des scénarios réels afin de garantir que les performances du modèle sont cohérentes et fiables.

De plus, corrigez les problèmes courants tels que le surapprentissage, le sous-apprentissage et la fuite de données. Utilisez des techniques telles que la validation croisée et la détection d'anomalies pour identifier et corriger ces problèmes. Pour des stratégies de test complètes, consultez notre guide de test de modèle.

Étape 7 : Déploiement du modèle

Une fois que votre modèle a été testé de manière approfondie, il est temps de le déployer. Le déploiement du modèle consiste à rendre votre modèle disponible pour une utilisation dans un environnement de production. Voici les étapes à suivre pour déployer un modèle de vision par ordinateur :

- Configuration de l’environnement : Configurez l’infrastructure nécessaire pour l’option de déploiement choisie, qu’elle soit basée sur le cloud (AWS, Google Cloud, Azure) ou sur la périphérie (appareils locaux, IoT).

- Exportation du modèle : Exportez votre modèle au format approprié (par exemple, ONNX, TensorRT, CoreML pour YOLO26) pour assurer la compatibilité avec votre plateforme de déploiement.

- Déploiement du modèle : Déployez le modèle en configurant des API ou des points de terminaison et en l’intégrant à votre application.

- Assurer l'évolutivité : Mettez en œuvre des équilibreurs de charge, des groupes de mise à l'échelle automatique et des outils de surveillance pour gérer les ressources et traiter les demandes croissantes de données et d'utilisateurs.

Pour des conseils plus détaillés sur les stratégies de déploiement et les meilleures pratiques, consultez notre guide des pratiques de déploiement de modèles.

Étape 8 : Surveillance, maintenance et documentation

Une fois votre modèle déployé, il est important de surveiller en permanence ses performances, de le maintenir pour résoudre tout problème et de documenter l'ensemble du processus pour référence et améliorations futures.

Les outils de surveillance peuvent vous aider à suivre les indicateurs clés de performance (KPI) et à détecter les anomalies ou les baisses de précision. En surveillant le modèle, vous pouvez être conscient de la dérive du modèle, où les performances du modèle diminuent avec le temps en raison de changements dans les données d'entrée. Réentraînez périodiquement le modèle avec des données mises à jour pour maintenir la précision et la pertinence.

En plus de la surveillance et de la maintenance, la documentation est également essentielle. Documentez minutieusement l'ensemble du processus, y compris l'architecture du modèle, les procédures d'entraînement, les hyperparamètres, les étapes de prétraitement des données et toute modification apportée lors du déploiement et de la maintenance. Une bonne documentation garantit la reproductibilité et facilite les futures mises à jour ou le dépannage. En surveillant, maintenant et documentant efficacement votre modèle, vous pouvez vous assurer qu'il reste précis, fiable et facile à gérer tout au long de son cycle de vie.

Interagir avec la communauté

Se connecter avec une communauté de passionnés de vision par ordinateur peut vous aider à résoudre avec confiance tous les problèmes que vous rencontrez lorsque vous travaillez sur votre projet de vision par ordinateur. Voici quelques façons d'apprendre, de dépanner et de réseauter efficacement.

Ressources communautaires

- Problèmes GitHub : Consultez le dépôt GitHub de YOLO26 et utilisez l'onglet Problèmes pour poser des questions, signaler des bugs et suggérer de nouvelles fonctionnalités. La communauté active et les mainteneurs sont là pour vous aider avec des problèmes spécifiques.

- Serveur Discord Ultralytics : Rejoignez le serveur Discord Ultralytics pour interagir avec d’autres utilisateurs et développeurs, obtenir de l’aide et partager des informations.

Documentation officielle

- Documentation Ultralytics YOLO26 : Explorez la documentation officielle de YOLO26 pour des guides détaillés avec des conseils utiles sur différentes tâches et projets de vision par ordinateur.

L'utilisation de ces ressources vous aidera à surmonter les défis et à rester informé des dernières tendances et des meilleures pratiques de la communauté de la vision par ordinateur.

Prochaines étapes

Entreprendre un projet de vision par ordinateur peut être passionnant et gratifiant. En suivant les étapes de ce guide, vous pouvez construire une base solide pour le succès. Chaque étape est cruciale pour développer une solution qui répond à vos objectifs et fonctionne bien dans des scénarios réels. À mesure que vous acquérez de l'expérience, vous découvrirez des techniques et des outils avancés pour améliorer vos projets.

FAQ

Comment choisir la tâche de vision par ordinateur adaptée à mon projet ?

Le choix de la tâche de vision par ordinateur appropriée dépend de l'objectif final de votre projet. Par exemple, si vous souhaitez surveiller le trafic, la détection d'objets est appropriée car elle peut localiser et identifier plusieurs types de véhicules en temps réel. Pour l'imagerie médicale, la segmentation d'image est idéale pour fournir des contours détaillés des tumeurs, ce qui facilite le diagnostic et la planification du traitement. Apprenez-en davantage sur des tâches spécifiques telles que la détection d'objets, la classification d'images et la segmentation d'instance.

Pourquoi l'annotation des données est-elle cruciale dans les projets de vision par ordinateur ?

L'annotation des données est essentielle pour apprendre à votre modèle à reconnaître des motifs. Le type d'annotation varie selon la tâche :

- Classification d'images : Image entière étiquetée comme une seule classe.

- Détection d'objets: Boîtes englobantes dessinées autour des objets.

- Segmentation d'images : Chaque pixel est étiqueté en fonction de l'objet auquel il appartient.

Des outils tels que Label Studio, CVAT et Labelme peuvent vous aider dans ce processus. Pour plus de détails, consultez notre guide de collecte et d'annotation de données.

Quelles étapes dois-je suivre pour augmenter et diviser efficacement mon ensemble de données ?

Diviser votre jeu de données avant l'augmentation permet de valider les performances du modèle sur des données originales et non modifiées. Suivez ces étapes :

- Ensemble d’entraînement: 70 à 80 % de vos données.

- Ensemble de validation : 10 à 15 % pour le réglage des hyperparamètres.

- Ensemble de test : Les 10 à 15 % restants pour l’évaluation finale.

Après la division, appliquez des techniques d’augmentation des données telles que la rotation, la mise à l’échelle et le retournement pour accroître la diversité de l’ensemble de données. Des bibliothèques telles que Albumentations et OpenCV peuvent vous aider. Ultralytics propose également des paramètres d’augmentation intégrés pour plus de commodité.

Comment puis-je exporter mon modèle de vision par ordinateur entraîné pour le déploiement ?

L'exportation de votre modèle assure la compatibilité avec différentes plateformes de déploiement. Ultralytics propose plusieurs formats, notamment ONNX, TensorRT et CoreML. Pour exporter votre modèle YOLO26, suivez ce guide :

- Utilisez la

exportfonction avec le paramètre de format souhaité. - Assurez-vous que le modèle exporté correspond aux spécifications de votre environnement de déploiement (par exemple, appareils périphériques, cloud).

Pour plus d'informations, consultez le guide d'exportation de modèles.

Quelles sont les meilleures pratiques pour surveiller et maintenir un modèle de vision par ordinateur déployé ?

Une surveillance et une maintenance continues sont essentielles au succès à long terme d'un modèle. Mettez en œuvre des outils pour suivre les indicateurs clés de performance (KPI) et détecter les anomalies. Réentraînez régulièrement le modèle avec des données mises à jour pour contrer la dérive du modèle. Documentez l'ensemble du processus, y compris l'architecture du modèle, les hyperparamètres et les modifications, afin de garantir la reproductibilité et de faciliter les mises à jour futures. Pour en savoir plus, consultez notre guide de surveillance et de maintenance.