Stratégies de collecte et d'annotation de données pour la vision par ordinateur

Introduction

La clé du succès dans tout projet de vision par ordinateur commence par des stratégies efficaces de collecte et d'annotation des données. La qualité des données a un impact direct sur les performances du modèle, il est donc important de comprendre les meilleures pratiques liées à la collecte et à l'annotation des données.

Regarder : Comment élaborer des stratégies efficaces de collecte et d'annotation de données pour la vision artificielle 🚀

Chaque considération concernant les données doit être étroitement alignée sur les objectifs de votre projet. Les modifications apportées à vos stratégies d'annotation pourraient modifier l'orientation ou l'efficacité du projet, et vice versa. Dans cette optique, examinons de plus près les meilleures façons d'aborder la collecte et l'annotation des données.

Mise en place des classes et collecte des données

La collecte d'images et de vidéos pour un projet de vision par ordinateur implique de définir le nombre de classes, de trouver des sources de données et de tenir compte des implications éthiques. Avant de commencer à collecter vos données, vous devez avoir une idée claire de :

Choisir les bonnes classes pour votre projet

L'une des premières questions à se poser au démarrage d'un projet de vision par ordinateur est de savoir combien de classes inclure. Vous devez déterminer l'appartenance aux classes, ce qui implique les différentes catégories ou étiquettes que vous souhaitez que votre modèle reconnaisse et différencie. Le nombre de classes doit être déterminé par les objectifs spécifiques de votre projet.

Par exemple, si vous souhaitez surveiller le trafic, vos classes peuvent inclure « voiture », « camion », « bus », « moto » et « vélo ». D'autre part, pour le suivi des articles dans un magasin, vos classes pourraient être « fruits », « légumes », « boissons » et « collations ». Définir des classes en fonction des objectifs de votre projet permet de garder votre ensemble de données pertinent et ciblé.

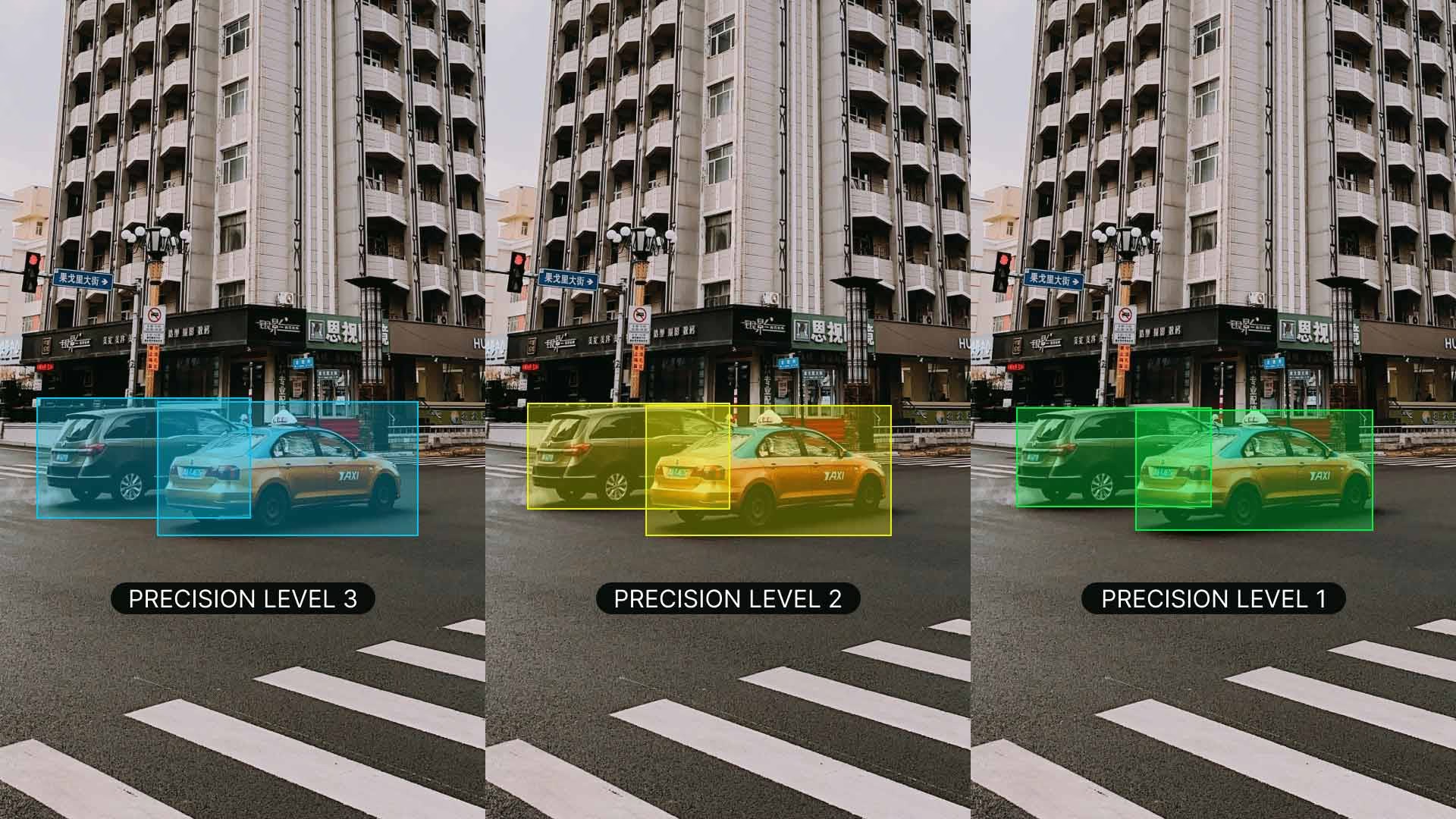

Lorsque vous définissez vos classes, une autre distinction importante à faire est de choisir entre un nombre de classes grossier ou précis. Le terme « Nombre » fait référence au nombre de classes distinctes qui vous intéressent. Cette décision influence la granularité de vos données et la complexité de votre modèle. Voici les considérations pour chaque approche :

- Nombre de classes grossières : Il s’agit de catégories plus larges et plus inclusives, telles que « véhicule » et « non-véhicule ». Elles simplifient l’annotation et nécessitent moins de ressources de calcul, mais fournissent des informations moins détaillées, ce qui peut limiter l’efficacité du modèle dans des scénarios complexes.

- Nombre de classes précis : Plus de catégories avec des distinctions plus fines, telles que « berline », « SUV », « camionnette » et « moto ». Elles capturent des informations plus détaillées, améliorant la précision et les performances du modèle. Cependant, elles sont plus longues et plus coûteuses à annoter et nécessitent plus de ressources de calcul.

Commencer par des classes plus spécifiques peut être très utile, en particulier dans les projets complexes où les détails sont importants. Des classes plus spécifiques vous permettent de collecter des données plus détaillées, d’acquérir des connaissances plus approfondies et d’établir des distinctions plus claires entre les catégories. Non seulement cela améliore la précision du modèle, mais cela facilite également l’ajustement du modèle ultérieurement si nécessaire, ce qui permet d’économiser du temps et des ressources.

Sources de données

Vous pouvez utiliser des jeux de données publics ou collecter vos propres données personnalisées. Les jeux de données publics comme ceux sur Kaggle et Google Dataset Search Engine offrent des données bien annotées et standardisées, ce qui en fait d'excellents points de départ pour l'entraînement et la validation de modèles.

La collecte de données personnalisées, quant à elle, vous permet d'adapter votre ensemble de données à vos besoins spécifiques. Vous pouvez capturer des images et des vidéos avec des caméras ou des drones, extraire des images du web ou utiliser des données internes existantes de votre organisation. Les données personnalisées vous donnent plus de contrôle sur leur qualité et leur pertinence. La combinaison de sources de données publiques et personnalisées permet de créer un ensemble de données diversifié et complet.

Éviter les biais dans la collecte de données

Un biais se produit lorsque certains groupes ou scénarios sont sous-représentés ou surreprésentés dans votre ensemble de données. Cela conduit à un modèle qui fonctionne bien sur certaines données mais mal sur d'autres. Il est essentiel d'éviter les biais dans l'IA afin que votre modèle de vision par ordinateur puisse bien fonctionner dans divers scénarios.

Voici comment éviter les biais lors de la collecte de données :

- Sources diverses : Collectez des données provenant de nombreuses sources afin de capturer différentes perspectives et différents scénarios.

- Représentation équilibrée : Inclure une représentation équilibrée de tous les groupes pertinents. Par exemple, tenez compte des différents âges, sexes et ethnies.

- Surveillance continue : Examinez et mettez à jour régulièrement votre ensemble de données pour identifier et corriger tout biais émergent.

- Techniques d'atténuation des biais : Utilisez des méthodes telles que le suréchantillonnage des classes sous-représentées, l'augmentation des données et les algorithmes tenant compte de l'équité.

Le respect de ces pratiques contribue à créer un modèle plus robuste et plus juste, capable de bien se généraliser dans les applications du monde réel.

Qu'est-ce que l'annotation de données ?

L'annotation de données est le processus de marquage des données pour les rendre utilisables pour l'entraînement de modèles d'apprentissage automatique. En vision par ordinateur, cela signifie étiqueter des images ou des vidéos avec les informations dont un modèle a besoin pour apprendre. Sans données correctement annotées, les modèles ne peuvent pas apprendre avec précision les relations entre les entrées et les sorties.

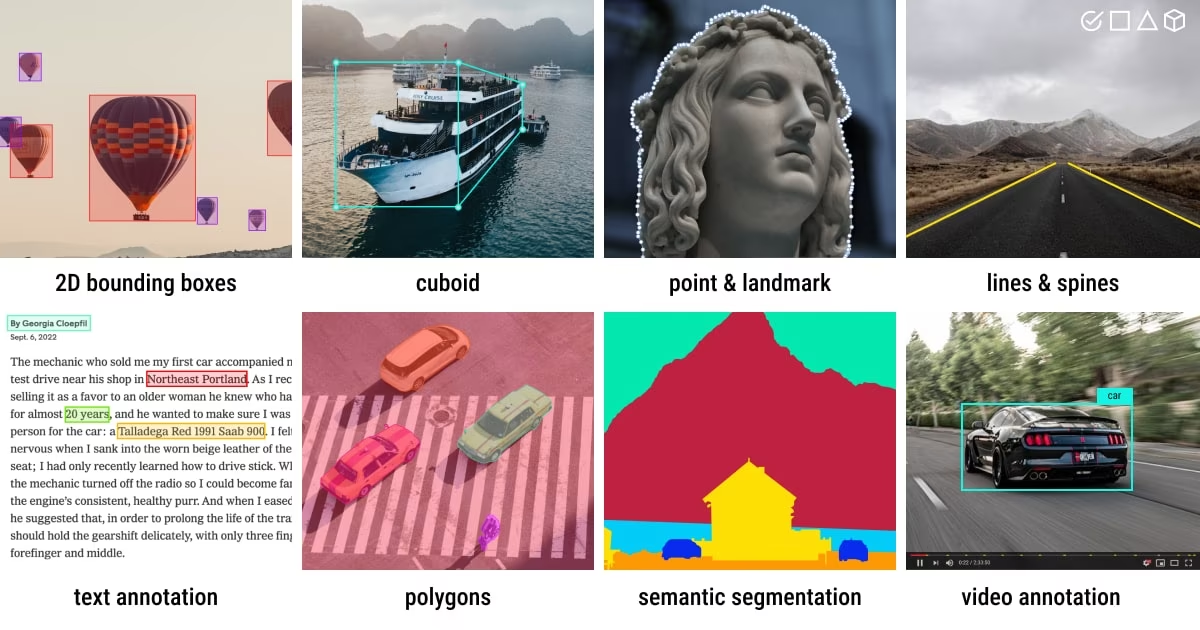

Types d'annotation de données

Selon les exigences spécifiques d'une tâche de vision par ordinateur, il existe différents types d'annotation de données. Voici quelques exemples :

- Boîtes englobantes : Boîtes rectangulaires dessinées autour des objets dans une image, utilisées principalement pour les tâches de détection d'objets. Ces boîtes sont définies par leurs coordonnées supérieures gauche et inférieures droite.

- Polygones : Contours détaillés des objets, permettant une annotation plus précise que les boîtes englobantes. Les polygones sont utilisés dans des tâches telles que la segmentation d'instance, où la forme de l'objet est importante.

- Masques : Masques binaires où chaque pixel fait partie d'un objet ou de l'arrière-plan. Les masques sont utilisés dans les tâches de segmentation sémantique pour fournir des détails au niveau des pixels.

- Points clés : Points spécifiques marqués dans une image pour identifier les emplacements d'intérêt. Les points clés sont utilisés dans des tâches telles que l'estimation de pose et la détection de points de repère faciaux.

Formats d'annotation courants

Après avoir sélectionné un type d'annotation, il est important de choisir le format approprié pour stocker et partager les annotations.

Les formats couramment utilisés incluent COCO, qui prend en charge différents types d'annotations comme la détection d'objets, la détection de points clés, la segmentation de contenu, la segmentation panoptique et la légende d'images, stockées au format JSON. Pascal VOC utilise des fichiers XML et est populaire pour les tâches de détection d'objets. YOLO, d'autre part, crée un fichier .txt pour chaque image, contenant des annotations telles que la classe d'objet, les coordonnées, la hauteur et la largeur, ce qui le rend adapté à la détection d'objets.

Techniques d'annotation

Maintenant, en supposant que vous ayez choisi un type d'annotation et un format, il est temps d'établir des règles d'étiquetage claires et objectives. Ces règles sont comme une feuille de route pour la cohérence et la précision tout au long du processus d'annotation. Les aspects clés de ces règles comprennent :

- Clarté et détail : Assurez-vous que vos instructions sont claires. Utilisez des exemples et des illustrations pour montrer ce qui est attendu.

- Cohérence : Assurez l'uniformité de vos annotations. Définissez des critères standard pour l'annotation des différents types de données, afin que toutes les annotations suivent les mêmes règles.

- Réduire les biais : Restez neutre. Entraînez-vous à être objectif et minimisez les biais personnels pour garantir des annotations équitables.

- Efficacité : Travaillez plus intelligemment, pas plus dur. Utilisez des outils et des flux de travail qui automatisent les tâches répétitives, rendant le processus d'annotation plus rapide et plus efficace.

L'examen et la mise à jour réguliers de vos règles d'étiquetage vous aideront à maintenir vos annotations précises, cohérentes et alignées sur les objectifs de votre projet.

Outils d'annotation populaires

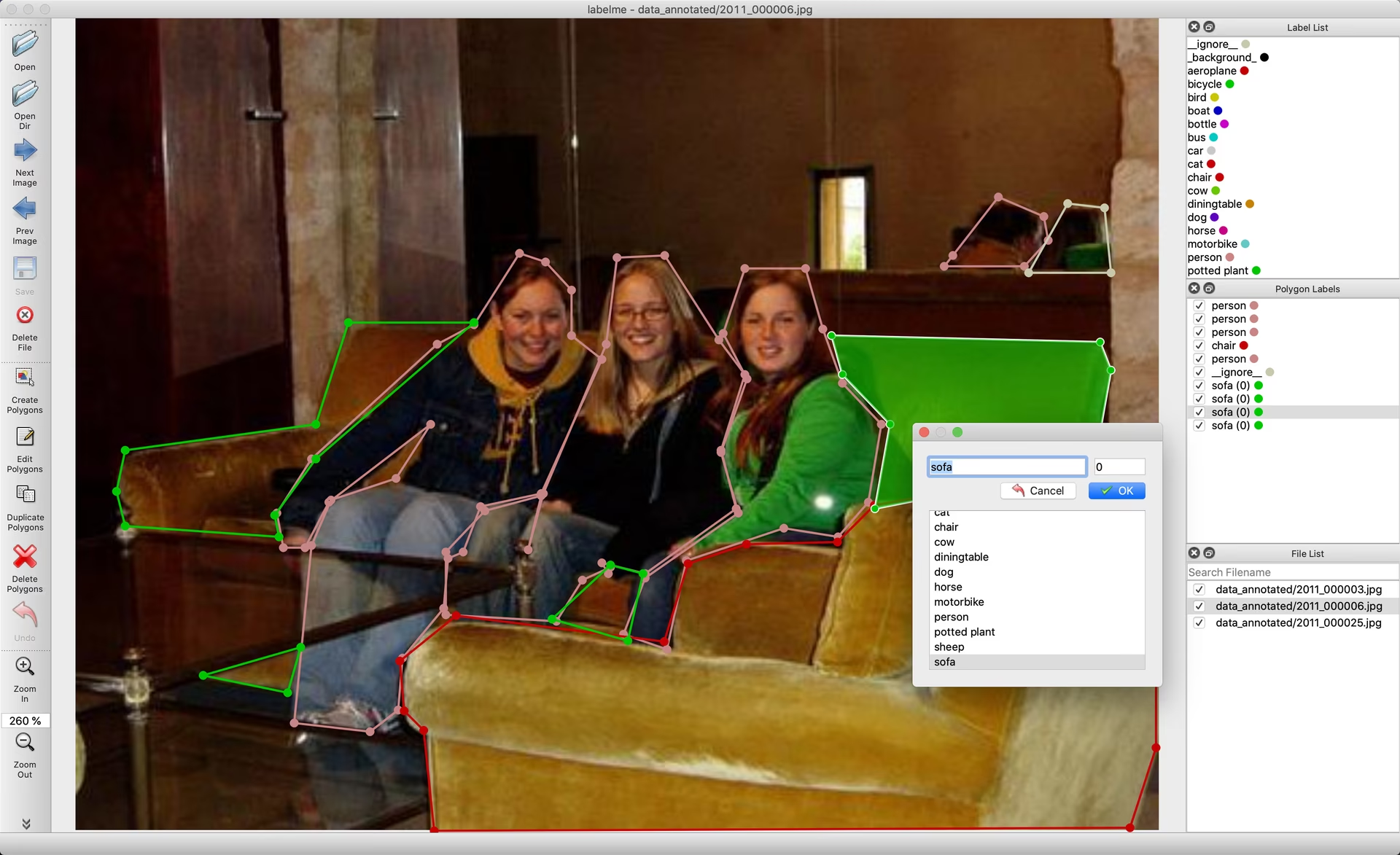

Disons que vous êtes prêt à annoter maintenant. Il existe plusieurs outils open source disponibles pour aider à rationaliser le processus d'annotation des données. Voici quelques outils d'annotation ouverts utiles :

- Label Studio : Un outil flexible qui prend en charge un large éventail de tâches d'annotation et comprend des fonctionnalités de gestion de projet et de contrôle de la qualité.

- CVAT : Un outil puissant qui prend en charge divers formats d'annotation et des flux de travail personnalisables, ce qui le rend adapté aux projets complexes.

- Labelme : Un outil simple et facile à utiliser qui permet une annotation rapide des images avec des polygones, ce qui le rend idéal pour les tâches simples.

- LabelImg : Un outil d'annotation d'images graphique facile à utiliser, particulièrement adapté à la création d'annotations de boîtes englobantes au format YOLO.

Ces outils open source sont économiques et offrent une gamme de fonctionnalités pour répondre à différents besoins d'annotation.

Autres éléments à prendre en compte avant d'annoter les données

Avant de vous lancer dans l'annotation de vos données, il y a quelques éléments supplémentaires à garder à l'esprit. Vous devez être conscient de la précision (accuracy), de la précision (precision), des valeurs aberrantes et du contrôle qualité afin d'éviter d'étiqueter vos données de manière contre-productive.

Comprendre la précision et le rappel

Il est important de comprendre la différence entre l'exactitude et la précision, et leur lien avec l'annotation. L'exactitude fait référence à la proximité des données annotées par rapport aux valeurs réelles. Elle nous aide à mesurer dans quelle mesure les étiquettes reflètent des scénarios réels. La précision indique la cohérence des annotations. Elle vérifie si vous donnez la même étiquette au même objet ou à la même caractéristique dans l'ensemble de données. Une exactitude et une précision élevées permettent d'obtenir des modèles mieux entraînés en réduisant le bruit et en améliorant la capacité du modèle à généraliser à partir des données d'entraînement.

Identification des valeurs aberrantes

Les valeurs aberrantes sont des points de données qui s'écartent considérablement des autres observations dans l'ensemble de données. En ce qui concerne les annotations, une valeur aberrante pourrait être une image mal étiquetée ou une annotation qui ne correspond pas au reste de l'ensemble de données. Les valeurs aberrantes sont préoccupantes car elles peuvent fausser le processus d'apprentissage du modèle, entraînant des prédictions inexactes et une mauvaise généralisation.

Vous pouvez utiliser diverses méthodes pour détecter et corriger les valeurs aberrantes :

- Techniques statistiques : Pour détecter les valeurs aberrantes dans les caractéristiques numériques telles que les valeurs de pixels, les coordonnées des boîtes englobantes ou les tailles d'objets, vous pouvez utiliser des méthodes telles que les diagrammes en boîte, les histogrammes ou les scores z.

- Techniques visuelles : Pour repérer les anomalies dans les caractéristiques catégorielles comme les classes d'objets, les couleurs ou les formes, utilisez des méthodes visuelles comme le traçage d'images, d'étiquettes ou de cartes thermiques.

- Méthodes algorithmiques : Utilisez des outils tels que le clustering (par exemple, le clustering K-means, DBSCAN) et les algorithmes de détection d’anomalies pour identifier les valeurs aberrantes en fonction des modèles de distribution des données.

Contrôle qualité des données annotées

Tout comme pour les autres projets techniques, le contrôle qualité est indispensable pour les données annotées. Il est conseillé de vérifier régulièrement les annotations pour s'assurer qu'elles sont exactes et cohérentes. Cela peut se faire de différentes manières :

- Examen d’échantillons de données annotées

- Utilisation d'outils automatisés pour repérer les erreurs courantes

- Demander à une autre personne de vérifier les annotations

Si vous travaillez avec plusieurs personnes, la cohérence entre les différents annotateurs est importante. Un bon accord inter-annotateurs signifie que les directives sont claires et que chacun les suit de la même manière. Cela permet à chacun d'être sur la même longueur d'onde et de garantir la cohérence des annotations.

Lors de la révision, si vous trouvez des erreurs, corrigez-les et mettez à jour les directives pour éviter de futures erreurs. Fournissez des commentaires aux annotateurs et offrez une formation régulière pour aider à réduire les erreurs. Avoir un processus solide pour gérer les erreurs maintient votre ensemble de données précis et fiable.

Stratégies efficaces d'étiquetage des données

Pour rendre le processus d'étiquetage des données plus fluide et plus efficace, envisagez de mettre en œuvre ces stratégies :

- Directives d'annotation claires : Fournir des instructions détaillées avec des exemples pour s’assurer que tous les annotateurs interprètent les tâches de manière cohérente. Par exemple, lors de l’étiquetage des oiseaux, précisez s’il faut inclure l’oiseau entier ou seulement des parties spécifiques.

- Contrôles de qualité réguliers : Définir des critères de référence et utiliser des mesures spécifiques pour examiner le travail, en maintenant des normes élevées grâce à un retour d'information continu.

- Utiliser des outils de pré-annotation : De nombreuses plateformes d'annotation modernes offrent des fonctionnalités de pré-annotation assistée par l'IA qui peuvent accélérer considérablement le processus en générant automatiquement des annotations initiales que les humains peuvent ensuite affiner.

- Implémenter l'apprentissage actif : Cette approche priorise l'étiquetage des échantillons les plus informatifs en premier, ce qui peut réduire le nombre total d'annotations nécessaires tout en maintenant les performances du modèle.

- Traitement par lots : Regroupez des images similaires pour l’annotation afin de maintenir la cohérence et d’améliorer l’efficacité.

Ces stratégies peuvent aider à maintenir des annotations de haute qualité tout en réduisant le temps et les ressources nécessaires au processus d'étiquetage.

Partagez vos réflexions avec la communauté

Le fait de confronter vos idées et vos questions à d'autres passionnés de vision par ordinateur peut contribuer à accélérer vos projets. Voici d'excellents moyens d'apprendre, de dépanner et de réseauter :

Où trouver de l'aide et de l'assistance

- Problèmes GitHub : Visitez le dépôt GitHub de YOLO26 et utilisez l'onglet Problèmes pour poser des questions, signaler des bugs et suggérer des fonctionnalités. La communauté et les mainteneurs sont là pour vous aider avec tous les problèmes que vous rencontrez.

- Serveur Discord Ultralytics : Rejoignez le serveur Discord Ultralytics pour vous connecter avec d'autres utilisateurs et développeurs, obtenir de l'aide, partager des connaissances et échanger des idées.

Documentation officielle

- Documentation Ultralytics YOLO26 : Référez-vous à la documentation officielle de YOLO26 pour des guides complets et des informations précieuses sur de nombreuses tâches et projets de vision par ordinateur.

Conclusion

En suivant les meilleures pratiques pour la collecte et l'annotation des données, en évitant les biais et en utilisant les bons outils et techniques, vous pouvez améliorer considérablement les performances de votre modèle. L'engagement avec la communauté et l'utilisation des ressources disponibles vous tiendront informé et vous aideront à résoudre efficacement les problèmes. N'oubliez pas que des données de qualité sont le fondement d'un projet réussi, et que les bonnes stratégies vous aideront à construire des modèles robustes et fiables.

FAQ

Quelle est la meilleure façon d'éviter les biais dans la collecte de données pour les projets de vision par ordinateur ?

Éviter les biais dans la collecte de données garantit que votre modèle de vision par ordinateur fonctionne correctement dans divers scénarios. Pour minimiser les biais, envisagez de collecter des données provenant de diverses sources afin de capturer différentes perspectives et différents scénarios. Assurez une représentation équilibrée entre tous les groupes pertinents, tels que les différents âges, sexes et ethnies. Examinez et mettez à jour régulièrement votre ensemble de données afin d'identifier et de corriger tout biais émergent. Des techniques telles que le suréchantillonnage des classes sous-représentées, l'augmentation des données et les algorithmes tenant compte de l'équité peuvent également contribuer à atténuer les biais. En employant ces stratégies, vous maintenez un ensemble de données robuste et équitable qui améliore la capacité de généralisation de votre modèle.

Comment puis-je garantir une cohérence et une précision élevées dans l'annotation des données ?

Garantir une cohérence et une précision élevées dans l'annotation des données implique l'établissement de directives d'étiquetage claires et objectives. Vos instructions doivent être détaillées, avec des exemples et des illustrations pour clarifier les attentes. La cohérence est obtenue en définissant des critères standard pour l'annotation de divers types de données, en veillant à ce que toutes les annotations suivent les mêmes règles. Pour réduire les biais personnels, formez les annotateurs à rester neutres et objectifs. Des examens et des mises à jour réguliers des règles d'étiquetage aident à maintenir la précision et l'alignement avec les objectifs du projet. L'utilisation d'outils automatisés pour vérifier la cohérence et l'obtention de commentaires d'autres annotateurs contribuent également au maintien d'annotations de haute qualité.

Combien d'images ai-je besoin pour entraîner les modèles Ultralytics YOLO ?

Pour un apprentissage par transfert et une détection d'objets efficaces avec les modèles Ultralytics YOLO, commencez avec un minimum de quelques centaines d'objets annotés par classe. Si vous entraînez pour une seule classe, commencez avec au moins 100 images annotées et entraînez pendant environ 100 époques. Des tâches plus complexes pourraient nécessiter des milliers d'images par classe pour atteindre une fiabilité et des performances élevées. Des annotations de qualité sont cruciales, alors assurez-vous que vos processus de collecte et d'annotation de données sont rigoureux et alignés sur les objectifs spécifiques de votre projet. Explorez les stratégies d'entraînement détaillées dans le guide d'entraînement YOLO26.

Quels sont les outils populaires pour l'annotation de données ?

Plusieurs outils open source populaires peuvent simplifier le processus d'annotation des données :

- Label Studio : Un outil flexible prenant en charge diverses tâches d'annotation, la gestion de projet et les fonctionnalités de contrôle de la qualité.

- CVAT : Offre plusieurs formats d'annotation et des flux de travail personnalisables, ce qui le rend adapté aux projets complexes.

- Labelme : Idéal pour l'annotation d'images rapide et simple avec des polygones.

- LabelImg : Parfait pour créer des annotations de boîtes englobantes au format YOLO grâce à une interface simple.

Ces outils peuvent aider à améliorer l'efficacité et la précision de vos flux de travail d'annotation. Pour des listes de fonctionnalités et des guides détaillés, consultez notre documentation sur les outils d'annotation de données.

Quels types d’annotations de données sont couramment utilisés dans la vision par ordinateur ?

Différents types d'annotation de données répondent à diverses tâches de vision par ordinateur :

- Boîtes englobantes : Principalement utilisées pour la détection d'objets, ce sont des boîtes rectangulaires autour des objets dans une image.

- Polygones : Fournissent des contours d'objets plus précis, adaptés aux tâches de segmentation d'instance.

- Masques : Offrent des détails au niveau des pixels, utilisés dans la segmentation sémantique pour différencier les objets de l'arrière-plan.

- Points clés : Identifiez des points d’intérêt spécifiques dans une image, ce qui est utile pour des tâches comme l’estimation de pose et la détection de points de repère faciaux.

Le choix du type d'annotation approprié dépend des exigences de votre projet. Apprenez-en davantage sur la manière de mettre en œuvre ces annotations et leurs formats dans notre guide d'annotation de données.