Un guide sur les tests de modèles

Introduction

Après avoir entraîné et évalué votre modèle, il est temps de le tester. Le test du modèle consiste à évaluer ses performances dans des scénarios réels. Les tests prennent en compte des facteurs tels que la précision, la fiabilité, l'équité et la facilité de compréhension des décisions du modèle. L'objectif est de s'assurer que le modèle fonctionne comme prévu, fournit les résultats attendus et s'intègre à l'objectif global de votre application ou de votre projet.

Regarder : Comment tester les modèles d'apprentissage automatique | Éviter la fuite de données dans la vision par ordinateur 🚀

Le test de modèle est assez similaire à l'évaluation de modèle, mais ce sont deux étapes distinctes dans un projet de vision par ordinateur. L'évaluation de modèle implique des métriques et des graphiques pour évaluer la précision du modèle. D'autre part, le test de modèle vérifie si le comportement appris du modèle est le même que prévu. Dans ce guide, nous explorerons des stratégies pour tester vos modèles de vision par ordinateur.

Tests de modèles vs. Évaluation de modèles

Tout d'abord, comprenons la différence entre l'évaluation et le test d'un modèle avec un exemple.

Supposons que vous ayez entraîné un modèle de vision par ordinateur pour reconnaître les chats et les chiens, et que vous souhaitiez déployer ce modèle dans une animalerie pour surveiller les animaux. Pendant la phase d'évaluation du modèle, vous utilisez un ensemble de données étiqueté pour calculer des métriques telles que la précision, la précision, le rappel et le score F1. Par exemple, le modèle peut avoir une précision de 98 % pour distinguer les chats et les chiens dans un ensemble de données donné.

Après l'évaluation, vous testez le modèle en utilisant des images d'une animalerie pour voir dans quelle mesure il identifie les chats et les chiens dans des conditions plus variées et réalistes. Vous vérifiez s'il peut correctement étiqueter les chats et les chiens lorsqu'ils sont en mouvement, dans différentes conditions d'éclairage ou partiellement masqués par des objets tels que des jouets ou des meubles. Les tests du modèle vérifient que le modèle se comporte comme prévu en dehors de l'environnement d'évaluation contrôlé.

Préparation des tests de modèle

Les modèles de vision par ordinateur apprennent à partir d’ensembles de données en détectant des motifs, en faisant des prédictions et en évaluant leurs performances. Ces ensembles de données sont généralement divisés en ensembles d’entraînement et de test pour simuler les conditions du monde réel. Les données d’entraînement enseignent au modèle tandis que les données de test vérifient sa précision.

Voici deux points à garder à l'esprit avant de tester votre modèle :

- Représentation réaliste : Les données de test, jamais vues auparavant, doivent être similaires aux données que le modèle devra traiter une fois déployé. Cela permet d'obtenir une compréhension réaliste des capacités du modèle.

- Taille suffisante : La taille de l'ensemble de données de test doit être suffisamment grande pour fournir des informations fiables sur les performances du modèle.

Tester votre modèle de vision par ordinateur

Voici les principales étapes à suivre pour tester votre modèle de vision par ordinateur et comprendre ses performances.

- Exécuter des prédictions : Utilisez le modèle pour faire des prédictions sur l'ensemble de données de test.

- Comparer les prédictions : Vérifiez si les prédictions du modèle correspondent aux étiquettes réelles (vérité de terrain).

- Calculer les mesures de performance : Calculer les mesures telles que la précision, le rappel et le score F1 pour comprendre les forces et les faiblesses du modèle. Les tests se concentrent sur la façon dont ces mesures reflètent les performances dans le monde réel.

- Visualiser les résultats : Créez des aides visuelles comme des matrices de confusion et des courbes ROC. Elles vous aident à repérer les domaines spécifiques où le modèle pourrait ne pas fonctionner correctement dans les applications pratiques.

Ensuite, les résultats des tests peuvent être analysés :

- Images mal classées: Identifiez et examinez les images que le modèle a mal classées afin de comprendre où il se trompe.

- Analyse des Erreurs : Effectuez une analyse approfondie des erreurs pour comprendre les types d'erreurs (par exemple, faux positifs vs faux négatifs) et leurs causes potentielles.

- Biais et équité : Vérifiez s'il existe des biais dans les prédictions du modèle. Assurez-vous que le modèle fonctionne aussi bien sur différents sous-ensembles de données, en particulier s'il inclut des attributs sensibles comme la race, le sexe ou l'âge.

Tester votre modèle YOLO26

Pour tester votre modèle YOLO26, vous pouvez utiliser le mode validation. C'est un moyen simple de comprendre les forces du modèle et les domaines qui nécessitent des améliorations. De plus, vous devrez formater correctement votre jeu de données de test pour YOLO26. Pour plus de détails sur l'utilisation du mode validation, consultez la page de documentation Validation du modèle.

Utiliser YOLO26 pour prédire sur plusieurs images de test

Si vous souhaitez tester votre modèle YOLO26 entraîné sur plusieurs images stockées dans un dossier, vous pouvez le faire facilement en une seule fois. Au lieu d'utiliser le mode validation, qui est généralement utilisé pour évaluer les performances du modèle sur un ensemble de validation et fournir des métriques détaillées, vous pourriez simplement vouloir voir les prédictions sur toutes les images de votre ensemble de test. Pour cela, vous pouvez utiliser le mode prédiction.

Différence entre les modes de validation et de prédiction

- Mode de validation : Utilisé pour évaluer les performances du modèle en comparant les prédictions aux étiquettes connues (vérité de terrain). Il fournit des mesures détaillées telles que la précision, le rappel et le score F1.

- Mode de prédiction: Utilisé pour exécuter le modèle sur des données nouvelles et invisibles afin de générer des prédictions. Il ne fournit pas de mesures de performance détaillées, mais vous permet de voir comment le modèle se comporte sur des images du monde réel.

Exécuter des prédictions YOLO26 sans entraînement personnalisé

Si vous souhaitez tester le modèle YOLO26 de base pour comprendre s'il peut être utilisé pour votre application sans entraînement personnalisé, vous pouvez utiliser le mode prédiction. Bien que le modèle soit pré-entraîné sur des jeux de données comme COCO, l'exécution de prédictions sur votre propre jeu de données peut vous donner un aperçu rapide de ses performances potentielles dans votre contexte spécifique.

Surapprentissage et Sous-apprentissage en Apprentissage automatique

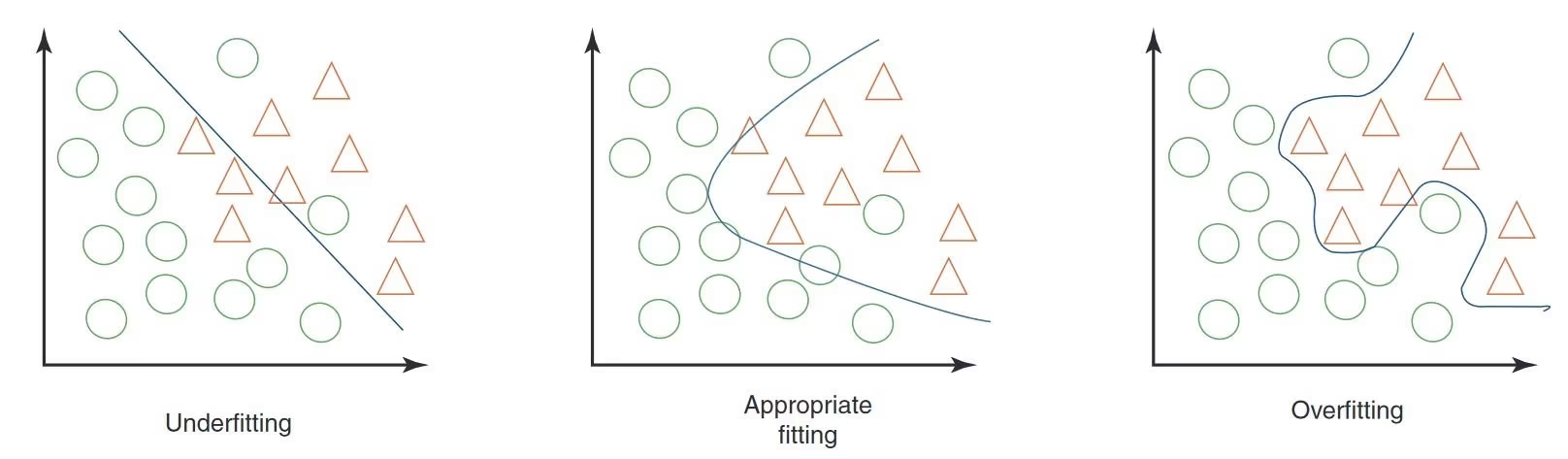

Lors du test d'un modèle d'apprentissage automatique, en particulier dans la vision par ordinateur, il est important de faire attention au surapprentissage et au sous-apprentissage. Ces problèmes peuvent affecter considérablement le fonctionnement de votre modèle avec de nouvelles données.

Surapprentissage

Le surapprentissage se produit lorsque votre modèle apprend trop bien les données d'entraînement, y compris le bruit et les détails qui ne se généralisent pas aux nouvelles données. En vision par ordinateur, cela signifie que votre modèle peut très bien fonctionner avec les images d'entraînement, mais avoir des difficultés avec les nouvelles.

Signes de surapprentissage

- Haute Précision d'Entraînement, Faible Précision de Validation : Si votre modèle fonctionne très bien sur les données d'entraînement mais mal sur les données de validation ou de test, il est probable qu'il y ait un surapprentissage.

- Inspection visuelle : Parfois, vous pouvez constater un surapprentissage si votre modèle est trop sensible aux changements mineurs ou aux détails non pertinents des images.

Sous-apprentissage

Le sous-apprentissage se produit lorsque votre modèle ne parvient pas à capturer les tendances sous-jacentes dans les données. En vision par ordinateur, un modèle sous-ajusté pourrait même ne pas reconnaître correctement les objets dans les images d'entraînement.

Signes de sous-apprentissage

- Faible précision de l'entraînement : Si votre modèle ne parvient pas à atteindre une précision élevée sur l'ensemble d'entraînement, il pourrait être en sous-apprentissage.

- Mauvaise classification visuelle : L'incapacité constante à reconnaître des caractéristiques ou des objets évidents suggère un sous-apprentissage.

Équilibrer le surapprentissage et le sous-apprentissage

L'essentiel est de trouver un équilibre entre le surapprentissage et le sous-apprentissage. Idéalement, un modèle devrait bien fonctionner à la fois sur les ensembles de données d'entraînement et de validation. La surveillance régulière des performances de votre modèle à l'aide de métriques et d'inspections visuelles, ainsi que l'application des bonnes stratégies, peuvent vous aider à obtenir les meilleurs résultats.

Fuite de données en vision par ordinateur et comment l'éviter

Lors du test de votre modèle, il est important de garder à l'esprit la fuite de données. La fuite de données se produit lorsque des informations provenant de l'extérieur de l'ensemble de données d'entraînement sont accidentellement utilisées pour entraîner le modèle. Le modèle peut sembler très précis pendant l'entraînement, mais il ne fonctionnera pas bien sur de nouvelles données invisibles lorsque la fuite de données se produit.

Pourquoi une fuite de données se produit-elle ?

La fuite de données peut être difficile à repérer et provient souvent de biais cachés dans les données d'entraînement. Voici quelques façons courantes dont cela peut se produire dans la vision par ordinateur :

- Biais de la caméra : Différents angles, l'éclairage, les ombres et les mouvements de la caméra peuvent introduire des motifs indésirables.

- Biais de superposition : Les logos, les horodatages ou autres superpositions dans les images peuvent induire le modèle en erreur.

- Biais de police et d’objet : Les polices ou les objets spécifiques qui apparaissent fréquemment dans certaines classes peuvent fausser l’apprentissage du modèle.

- Biais spatial : Les déséquilibres dans l’avant-plan-arrière-plan, les distributions de boîtes englobantes et les emplacements des objets peuvent affecter l’entraînement.

- Biais d’étiquette et de domaine : Des étiquettes incorrectes ou des changements dans les types de données peuvent entraîner des fuites.

Détection des fuites de données

Pour détecter une fuite de données, vous pouvez :

- Vérifier les performances: Si les résultats du modèle sont étonnamment bons, il pourrait y avoir une fuite.

- Examinez l'importance des caractéristiques : Si une caractéristique est beaucoup plus importante que les autres, cela pourrait indiquer une fuite.

- Inspection visuelle : Vérifiez que les décisions du modèle sont intuitives.

- Vérifier la séparation des données : Assurez-vous que les données ont été correctement divisées avant tout traitement.

Éviter les fuites de données

Pour éviter les fuites de données, utilisez un ensemble de données diversifié avec des images ou des vidéos provenant de différentes caméras et environnements. Examinez attentivement vos données et vérifiez qu'il n'y a pas de biais cachés, par exemple que tous les échantillons positifs sont prélevés à un moment précis de la journée. Éviter les fuites de données aidera à rendre vos modèles de vision par ordinateur plus fiables et efficaces dans des situations réelles.

Ce qui vient après le test du modèle

Après avoir testé votre modèle, les prochaines étapes dépendent des résultats. Si votre modèle fonctionne bien, vous pouvez le déployer dans un environnement réel. Si les résultats ne sont pas satisfaisants, vous devrez apporter des améliorations. Cela pourrait impliquer l'analyse des erreurs, la collecte de plus de données, l'amélioration de la qualité des données, l'ajustement des hyperparamètres et le réentraînement du modèle.

Participez à la conversation sur l'IA

Faire partie d'une communauté de passionnés de vision par ordinateur peut aider à résoudre des problèmes et à apprendre plus efficacement. Voici quelques façons de se connecter, de demander de l'aide et de partager vos idées.

Ressources communautaires

- Problèmes GitHub : Explorez le dépôt GitHub de YOLO26 et utilisez l'onglet Issues pour poser des questions, signaler des bugs et suggérer de nouvelles fonctionnalités. La communauté et les mainteneurs sont très actifs et prêts à aider.

- Serveur Discord Ultralytics : Rejoignez le serveur Discord Ultralytics pour discuter avec d’autres utilisateurs et développeurs, obtenir de l’aide et partager vos expériences.

Documentation officielle

- Documentation Ultralytics YOLO26 : Consultez la documentation officielle de YOLO26 pour des guides détaillés et des conseils utiles sur divers projets de vision par ordinateur.

Ces ressources vous aideront à surmonter les défis et à rester informé des dernières tendances et pratiques au sein de la communauté de la vision par ordinateur.

En résumé

La construction de modèles de vision par ordinateur fiables repose sur des tests rigoureux. En testant le modèle avec des données jamais vues auparavant, nous pouvons l'analyser et identifier les faiblesses telles que le surapprentissage et la fuite de données. La résolution de ces problèmes avant le déploiement permet au modèle de bien fonctionner dans des applications réelles. Il est important de se rappeler que les tests de modèles sont tout aussi cruciaux que l'évaluation des modèles pour garantir le succès et l'efficacité à long terme du modèle.

FAQ

Quelles sont les principales différences entre l'évaluation et le test de modèles en vision par ordinateur ?

L'évaluation et le test de modèles sont des étapes distinctes dans un projet de vision par ordinateur. L'évaluation de modèle implique l'utilisation d'un ensemble de données étiquetées pour calculer des métriques telles que l'accuracy, la justesse, le rappel et le score F1, fournissant des informations sur les performances du modèle avec un ensemble de données contrôlé. Le test de modèle, d'autre part, évalue les performances du modèle dans des scénarios réels en l'appliquant à de nouvelles données non vues, garantissant que le comportement appris du modèle correspond aux attentes en dehors de l'environnement d'évaluation. Pour un guide détaillé, consultez les étapes d'un projet de vision par ordinateur.

Comment puis-je tester mon modèle Ultralytics YOLO26 sur plusieurs images ?

Pour tester votre modèle Ultralytics YOLO26 sur plusieurs images, vous pouvez utiliser le mode prédiction. Ce mode vous permet d'exécuter le modèle sur de nouvelles données, non vues, pour générer des prédictions sans fournir de métriques détaillées. C'est idéal pour les tests de performance en conditions réelles sur des ensembles d'images plus grands stockés dans un dossier. Pour évaluer les métriques de performance, utilisez plutôt le mode validation.

Que dois-je faire si mon modèle de vision par ordinateur montre des signes de surapprentissage ou de sous-apprentissage ?

Pour contrer le surapprentissage :

- Techniques de régularisation comme le dropout.

- Augmenter la taille de l'ensemble de données d'entraînement.

- Simplifier l'architecture du modèle.

Pour contrer le sous-apprentissage :

- Utiliser un modèle plus complexe.

- Fournissez des fonctionnalités plus pertinentes.

- Augmenter le nombre d'itérations d'entraînement ou les epochs.

Examinez les images mal classées, effectuez une analyse approfondie des erreurs et suivez régulièrement les indicateurs de performance pour maintenir un équilibre. Pour plus d'informations sur ces concepts, explorez notre section sur le Surapprentissage et le Sous-apprentissage.

Comment puis-je détecter et éviter les fuites de données dans la vision par ordinateur ?

Pour détecter la fuite de données :

- Vérifiez que les performances des tests ne sont pas anormalement élevées.

- Vérifiez l'importance des caractéristiques pour des informations inattendues.

- Passez en revue intuitivement les décisions du modèle.

- Assurez-vous d'une division correcte des données avant le traitement.

Pour éviter la fuite de données :

- Utiliser des ensembles de données diversifiés avec différents environnements.

- Examiner attentivement les données pour détecter les biais cachés.

- Assurez-vous qu'il n'y a pas de chevauchement d'informations entre les ensembles d'entraînement et de test.

Pour des stratégies détaillées sur la prévention des fuites de données, consultez notre section sur les Fuites de données en vision par ordinateur.

Quelles mesures dois-je prendre après avoir testé mon modèle de vision par ordinateur ?

Après les tests, si les performances du modèle répondent aux objectifs du projet, passez au déploiement. Si les résultats ne sont pas satisfaisants, envisagez de :

- Analyse des erreurs.

- Collecte de données plus diversifiées et de meilleure qualité.

- Réglage des hyperparamètres.

- Réentraînement du modèle.

Tirez des enseignements de la section Test de modèle vs. Évaluation de modèle pour affiner et améliorer l'efficacité du modèle dans les applications du monde réel.

Comment exécuter des prédictions YOLO26 sans entraînement personnalisé ?

Vous pouvez exécuter des prédictions en utilisant le modèle YOLO26 pré-entraîné sur votre jeu de données pour voir s'il répond à vos besoins applicatifs. Utilisez le mode prédiction pour avoir un aperçu rapide des résultats de performance sans vous lancer dans un entraînement personnalisé.