Una guida sul test del modello

Introduzione

Dopo aver addestrato e valutato il tuo modello, è il momento di testarlo. Il test del modello implica la valutazione delle sue prestazioni in scenari reali. Il test considera fattori come l'accuratezza, l'affidabilità, l'imparzialità e la facilità di comprensione delle decisioni del modello. L'obiettivo è assicurarsi che il modello funzioni come previsto, fornisca i risultati attesi e si adatti all'obiettivo generale della tua applicazione o progetto.

Guarda: Come testare i modelli di machine learning | Evitare la perdita di dati nella computer vision 🚀

Il testing del modello è abbastanza simile alla valutazione del modello, ma sono due fasi distinte in un progetto di computer vision. La valutazione del modello prevede metriche e grafici per valutare l'accuratezza del modello. D'altra parte, il testing del modello verifica se il comportamento appreso dal modello è lo stesso delle aspettative. In questa guida, esploreremo le strategie per testare i tuoi modelli di computer vision.

Testing del modello vs. Valutazione del modello

Innanzitutto, cerchiamo di capire la differenza tra la valutazione e il test del modello con un esempio.

Supponiamo di aver addestrato un modello di computer vision per riconoscere cani e gatti e di voler distribuire questo modello in un negozio di animali domestici per monitorare gli animali. Durante la fase di valutazione del modello, si utilizza un dataset etichettato per calcolare metriche come accuratezza, precisione, richiamo e punteggio F1. Ad esempio, il modello potrebbe avere un'accuratezza del 98% nel distinguere tra cani e gatti in un determinato dataset.

Dopo la valutazione, si testa il modello utilizzando immagini provenienti da un negozio di animali per vedere come identifica gatti e cani in condizioni più varie e realistiche. Si verifica se è in grado di etichettare correttamente gatti e cani quando sono in movimento, in diverse condizioni di illuminazione o parzialmente oscurati da oggetti come giocattoli o mobili. Il test del modello verifica che il modello si comporti come previsto al di fuori dell'ambiente di valutazione controllato.

Preparazione per il test del modello

I modelli di visione artificiale apprendono dai set di dati rilevando modelli, facendo previsioni e valutando le loro prestazioni. Questi set di dati sono solitamente suddivisi in set di training e di test per simulare le condizioni del mondo reale. I dati di training insegnano al modello mentre i dati di test ne verificano l'accuratezza.

Ecco due punti da tenere a mente prima di testare il tuo modello:

- Rappresentazione realistica: I dati di test precedentemente non visualizzati devono essere simili ai dati che il modello dovrà gestire una volta implementato. Questo aiuta a ottenere una comprensione realistica delle capacità del modello.

- Dimensione Sufficiente: La dimensione del dataset di test deve essere sufficientemente grande da fornire informazioni affidabili su quanto bene il modello si comporta.

Testare il tuo modello di computer vision

Ecco i passaggi chiave da seguire per testare il tuo modello di computer vision e comprenderne le prestazioni.

- Esegui previsioni: Utilizza il modello per fare previsioni sul set di dati di test.

- Confronta le previsioni: Verifica quanto bene le previsioni del modello corrispondono alle etichette effettive (ground truth).

- Calcola le metriche di performance:Calcola metriche come accuratezza, precisione, recall e punteggio F1 per comprendere i punti di forza e di debolezza del modello. Il testing si concentra su come queste metriche riflettono le performance nel mondo reale.

- Visualizza i risultati: Crea ausili visivi come matrici di confusione e curve ROC. Questi ti aiutano a individuare aree specifiche in cui il modello potrebbe non funzionare bene nelle applicazioni pratiche.

Successivamente, i risultati dei test possono essere analizzati:

- Immagini classificate erroneamente: Identifica e rivedi le immagini che il modello ha classificato erroneamente per capire dove sta sbagliando.

- Analisi degli errori: Eseguire un'analisi approfondita degli errori per comprendere i tipi di errori (ad esempio, falsi positivi vs. falsi negativi) e le loro potenziali cause.

- Bias ed equità: Verificare eventuali bias nelle previsioni del modello. Assicurarsi che il modello funzioni ugualmente bene in diversi sottoinsiemi dei dati, soprattutto se include attributi sensibili come razza, genere o età.

Testare il tuo modello YOLO26

Per testare il tuo modello YOLO26, puoi utilizzare la modalità di validazione. È un modo semplice per comprendere i punti di forza del modello e le aree che necessitano di miglioramento. Inoltre, dovrai formattare correttamente il tuo dataset di test per YOLO26. Per maggiori dettagli su come utilizzare la modalità di validazione, consulta la pagina della documentazione Validazione del Modello.

Utilizzare YOLO26 per prevedere su più immagini di test

Se desideri testare il tuo modello YOLO26 addestrato su più immagini archiviate in una cartella, puoi farlo facilmente in una sola volta. Invece di utilizzare la modalità di validazione, che è tipicamente usata per valutare le prestazioni del modello su un set di validazione e fornire metriche dettagliate, potresti voler semplicemente vedere le previsioni su tutte le immagini nel tuo set di test. Per questo, puoi utilizzare la modalità di previsione.

Differenza tra modalità di validazione e previsione

- Modalità di convalida: Utilizzata per valutare le prestazioni del modello confrontando le previsioni con le etichette note (verità di base). Fornisce metriche dettagliate come accuratezza, precisione, richiamo e punteggio F1.

- Modalità di previsione: Utilizzata per eseguire il modello su dati nuovi e non visti per generare previsioni. Non fornisce metriche di performance dettagliate, ma ti consente di vedere come si comporta il modello su immagini del mondo reale.

Eseguire previsioni YOLO26 senza addestramento personalizzato

Se sei interessato a testare il modello YOLO26 di base per capire se può essere utilizzato per la tua applicazione senza addestramento personalizzato, puoi utilizzare la modalità di previsione. Mentre il modello è pre-addestrato su dataset come COCO, eseguire previsioni sul tuo dataset può darti un'idea rapida di quanto bene potrebbe funzionare nel tuo contesto specifico.

Sovradattamento e Sottodattamento nel Machine Learning

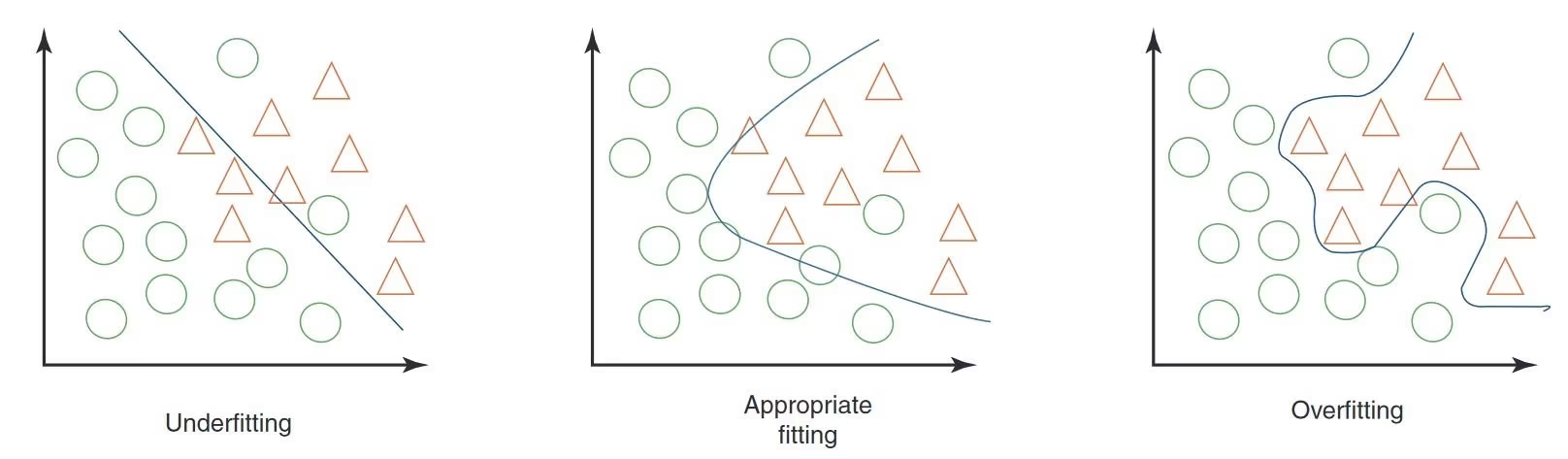

Quando si testa un modello di machine learning, specialmente nella computer vision, è importante fare attenzione all'overfitting e all'underfitting. Questi problemi possono influire significativamente sul funzionamento del modello con nuovi dati.

Sovradattamento

Il sovradattamento si verifica quando il modello apprende troppo bene i dati di addestramento, inclusi il rumore e i dettagli che non si generalizzano a nuovi dati. Nella computer vision, questo significa che il modello potrebbe funzionare benissimo con le immagini di addestramento, ma avere difficoltà con quelle nuove.

Segnali di Overfitting

- Elevata precisione di addestramento, bassa precisione di convalida: Se il tuo modello funziona molto bene sui dati di addestramento ma male sui dati di convalida o di test, è probabile che si verifichi un overfitting.

- Ispezione visiva: A volte, puoi vedere l'overfitting se il tuo modello è troppo sensibile a piccoli cambiamenti o dettagli irrilevanti nelle immagini.

Underfitting

L'underfitting si verifica quando il modello non riesce a catturare i modelli sottostanti nei dati. Nella computer vision, un modello con underfitting potrebbe non riconoscere correttamente gli oggetti nelle immagini di training.

Segnali di Underfitting

- Accuratezza di training bassa: Se il tuo modello non riesce a raggiungere un'elevata accuratezza sul set di training, potrebbe essere sotto-adattato.

- Errata classificazione visiva: L'incapacità costante di riconoscere caratteristiche o oggetti ovvi suggerisce un underfitting.

Bilanciare Overfitting e Underfitting

La chiave è trovare un equilibrio tra overfitting e underfitting. Idealmente, un modello dovrebbe funzionare bene sia sui dataset di addestramento che di convalida. Monitorare regolarmente le prestazioni del tuo modello attraverso metriche e ispezioni visive, insieme all'applicazione delle giuste strategie, può aiutarti a ottenere i migliori risultati.

Perdita di dati nella Computer Vision e come evitarla

Durante il test del modello, è importante tenere presente il data leakage. Il data leakage si verifica quando informazioni esterne al dataset di addestramento vengono accidentalmente utilizzate per addestrare il modello. Il modello può sembrare molto preciso durante l'addestramento, ma non funzionerà bene su dati nuovi e non visti quando si verifica il data leakage.

Perché si verifica il Data Leakage

La perdita di dati può essere difficile da individuare e spesso deriva da pregiudizi nascosti nei dati di addestramento. Ecco alcuni modi comuni in cui può verificarsi nella computer vision:

- Bias della fotocamera: Angolazioni, illuminazione, ombre e movimenti della fotocamera diversi possono introdurre pattern indesiderati.

- Bias di Sovrapposizione: Loghi, timestamp o altre sovrapposizioni nelle immagini possono indurre in errore il modello.

- Bias di font e oggetti: Font specifici o oggetti che appaiono frequentemente in determinate classi possono distorcere l'apprendimento del modello.

- Bias Spaziale: Gli squilibri nel rapporto foreground-background, nelle distribuzioni delle bounding box e nelle posizioni degli oggetti possono influire sul training.

- Bias di etichetta e di dominio: etichette errate o cambiamenti nei tipi di dati possono causare leakage.

Rilevamento della perdita di dati

Per trovare data leakage, puoi:

- Verifica le prestazioni: Se i risultati del modello sono sorprendentemente buoni, potrebbe esserci una perdita di informazioni.

- Osserva l'importanza delle feature: se una feature è molto più importante delle altre, potrebbe indicare una perdita.

- Ispezione visiva: Ricontrolla che le decisioni del modello abbiano un senso intuitivo.

- Verifica della separazione dei dati: Assicurati che i dati siano stati divisi correttamente prima di qualsiasi elaborazione.

Evitare la perdita di dati

Per prevenire la perdita di dati, utilizzare un set di dati diversificato con immagini o video provenienti da diverse telecamere e ambienti. Esaminare attentamente i dati e verificare che non vi siano distorsioni nascoste, come ad esempio tutti i campioni positivi acquisiti in un momento specifico della giornata. Evitare la perdita di dati contribuirà a rendere i modelli di computer vision più affidabili ed efficaci in situazioni reali.

Cosa viene dopo il testing del modello

Dopo aver testato il modello, i passaggi successivi dipendono dai risultati. Se il modello funziona bene, puoi implementarlo in un ambiente reale. Se i risultati non sono soddisfacenti, dovrai apportare dei miglioramenti. Ciò potrebbe comportare l'analisi degli errori, la raccolta di più dati, il miglioramento della qualità dei dati, la regolazione degli iperparametri e il riaddestramento del modello.

Partecipa alla conversazione sull'AI

Entrare a far parte di una comunità di appassionati di computer vision può aiutare a risolvere i problemi e a imparare in modo più efficiente. Ecco alcuni modi per connettersi, chiedere aiuto e condividere le tue idee.

Risorse della community

- GitHub Issues: Esplora il repository GitHub di YOLO26 e usa la scheda Issues per porre domande, segnalare bug e suggerire nuove funzionalità. La community e i manutentori sono molto attivi e pronti ad aiutare.

- Server Discord di Ultralytics: Unisciti al server Discord di Ultralytics per chattare con altri utenti e sviluppatori, ottenere supporto e condividere le tue esperienze.

Documentazione ufficiale

- Documentazione Ultralytics YOLO26: Consulta la documentazione ufficiale di YOLO26 per guide dettagliate e consigli utili su vari progetti di visione artificiale.

Queste risorse ti aiuteranno a superare le sfide e a rimanere aggiornato sulle ultime tendenze e pratiche all'interno della comunità della computer vision.

In sintesi

La costruzione di modelli di computer vision affidabili si basa su test rigorosi del modello. Testando il modello con dati precedentemente non visti, possiamo analizzarlo e individuare debolezze come l'overfitting e la perdita di dati. Affrontare questi problemi prima del deployment aiuta il modello a funzionare bene nelle applicazioni del mondo reale. È importante ricordare che il test del modello è altrettanto cruciale quanto la valutazione del modello nel garantire il successo e l'efficacia a lungo termine del modello.

FAQ

Quali sono le principali differenze tra la valutazione e il testing di un modello nella computer vision?

La valutazione del modello e il test del modello sono fasi distinte in un progetto di computer vision. La valutazione del modello prevede l'utilizzo di un set di dati etichettato per calcolare metriche come accuratezza, precisione, richiamo e punteggio F1, fornendo informazioni sulle prestazioni del modello con un set di dati controllato. Il test del modello, d'altra parte, valuta le prestazioni del modello in scenari del mondo reale applicandolo a dati nuovi e non visti, garantendo che il comportamento appreso del modello sia in linea con le aspettative al di fuori dell'ambiente di valutazione. Per una guida dettagliata, fare riferimento ai passaggi in un progetto di computer vision.

Come posso testare il mio modello Ultralytics YOLO26 su più immagini?

Per testare il tuo modello Ultralytics YOLO26 su più immagini, puoi utilizzare la modalità di previsione. Questa modalità ti permette di eseguire il modello su dati nuovi e non visti per generare previsioni senza fornire metriche dettagliate. Questo è l'ideale per testare le prestazioni nel mondo reale su set di immagini più grandi archiviati in una cartella. Per valutare le metriche di performance, utilizza invece la modalità di validazione.

Cosa devo fare se il mio modello di computer vision mostra segni di overfitting o underfitting?

Per affrontare il sovradattamento:

- Tecniche di regolarizzazione come il dropout.

- Aumenta le dimensioni del set di dati di training.

- Semplifica l'architettura del modello.

Per affrontare il sottodattamento:

- Utilizza un modello più complesso.

- Fornire funzionalità più rilevanti.

- Aumenta le iterazioni di training o le epoche.

Rivedere le immagini classificate in modo errato, eseguire un'analisi approfondita degli errori e monitorare regolarmente le metriche di performance per mantenere un equilibrio. Per maggiori informazioni su questi concetti, esplora la nostra sezione su Overfitting e Underfitting.

Come posso rilevare ed evitare la perdita di dati nella computer vision?

Per detect la perdita di dati:

- Verificare che le prestazioni di test non siano insolitamente elevate.

- Verifica l'importanza delle caratteristiche per ottenere informazioni inaspettate.

- Rivedi intuitivamente le decisioni del modello.

- Assicurati una corretta divisione dei dati prima dell'elaborazione.

Per evitare la perdita di dati:

- Utilizza dataset diversificati con vari ambienti.

- Esamina attentamente i dati per individuare eventuali distorsioni nascoste.

- Assicurati che non ci siano informazioni sovrapposte tra i set di training e di test.

Per strategie dettagliate sulla prevenzione della perdita di dati, consultare la nostra sezione sulla Perdita di dati nella computer vision.

Quali passaggi devo intraprendere dopo aver testato il mio modello di computer vision?

Dopo i test, se le prestazioni del modello soddisfano gli obiettivi del progetto, procedere con la distribuzione. Se i risultati non sono soddisfacenti, considerare quanto segue:

- Analisi degli errori.

- Raccolta di dati più diversificati e di alta qualità.

- Tuning degli iperparametri.

- Riavvio dell'addestramento del modello.

Consulta la sezione Test del modello contro valutazione del modello per ottenere informazioni utili per perfezionare e migliorare l'efficacia del modello nelle applicazioni reali.

Come si eseguono le previsioni YOLO26 senza addestramento personalizzato?

Puoi eseguire previsioni utilizzando il modello YOLO26 pre-addestrato sul tuo dataset per vedere se si adatta alle tue esigenze applicative. Utilizza la modalità di previsione per avere un'idea rapida dei risultati delle prestazioni senza addentrarti nell'addestramento personalizzato.