SAM 2: Segment Anything Model 2

SAM 진화

SAM 2는 오리지널 SAM을 기반으로 하며 비디오 segment 기능을 추가했습니다. 텍스트 및 이미지 예시 프롬프트를 사용한 프롬프트 가능한 개념 segment에 대해서는 SAM 3을 참조하십시오.

Meta의 Segment Anything Model (SAM)의 후속 모델인 SAM 2는 이미지와 비디오 모두에서 포괄적인 객체 분할을 위해 설계된 최첨단 도구입니다. 실시간 처리 및 제로샷 일반화를 지원하는 통합된 프롬프트 기반 모델 아키텍처를 통해 복잡한 시각적 데이터를 훌륭하게 처리합니다.

주요 기능

참고: Ultralytics를 사용하여 Meta의 SAM2로 추론을 실행하는 방법 | 단계별 가이드 🎉

통합 모델 아키텍처

SAM 2는 단일 모델에서 이미지 및 비디오 분할 기능을 결합합니다. 이러한 통합은 배포를 간소화하고 다양한 미디어 유형에서 일관된 성능을 제공합니다. 또한 포인트, 경계 상자 또는 마스크와 같은 다양한 프롬프트 유형을 통해 사용자가 관심 객체를 지정할 수 있도록 유연한 프롬프트 기반 인터페이스를 활용합니다.

실시간 성능

이 모델은 초당 약 44프레임을 처리하여 실시간 추론 속도를 달성합니다. 따라서 SAM 2는 비디오 편집 및 증강 현실과 같이 즉각적인 피드백이 필요한 애플리케이션에 적합합니다.

제로샷 일반화

SAM 2는 이전에 접하지 못했던 객체를 segment할 수 있으며, 강력한 제로샷 일반화 능력을 보여줍니다. 이는 사전 정의된 카테고리가 모든 가능한 객체를 포괄하지 못할 수 있는 다양하거나 변화하는 시각적 도메인에서 특히 유용합니다.

대화형 개선

사용자는 추가 프롬프트를 제공하여 분할 결과를 반복적으로 개선할 수 있으므로 출력에 대한 정밀한 제어가 가능합니다. 이러한 상호 작용성은 비디오 주석 또는 의료 영상과 같은 애플리케이션에서 결과를 미세 조정하는 데 필수적입니다.

시각적 문제에 대한 고급 처리

SAM 2는 객체 가려짐 및 재등장과 같은 일반적인 비디오 segment 문제를 관리하는 메커니즘을 포함합니다. 이는 정교한 메모리 메커니즘을 사용하여 프레임 전반에 걸쳐 객체를 track하며, 객체가 일시적으로 가려지거나 장면을 벗어났다가 다시 진입하는 경우에도 연속성을 보장합니다.

SAM 2의 아키텍처 및 기능에 대한 자세한 내용은 SAM 2 연구 논문을 참조하십시오.

성능 및 기술 세부 정보

SAM 2는 다양한 지표에서 이전 모델보다 뛰어난 성능을 보여주며 이 분야에서 새로운 기준을 제시합니다.

| 지표 | SAM 2 | 이전 SOTA |

|---|---|---|

| 대화형 비디오 분할 | 최고 | - |

| 필요한 사용자 상호 작용 | 3배 더 적음 | 기준선 |

| 이미지 분할 정확도 | 향상됨 | SAM |

| 추론 속도 | 6배 더 빠름 | SAM |

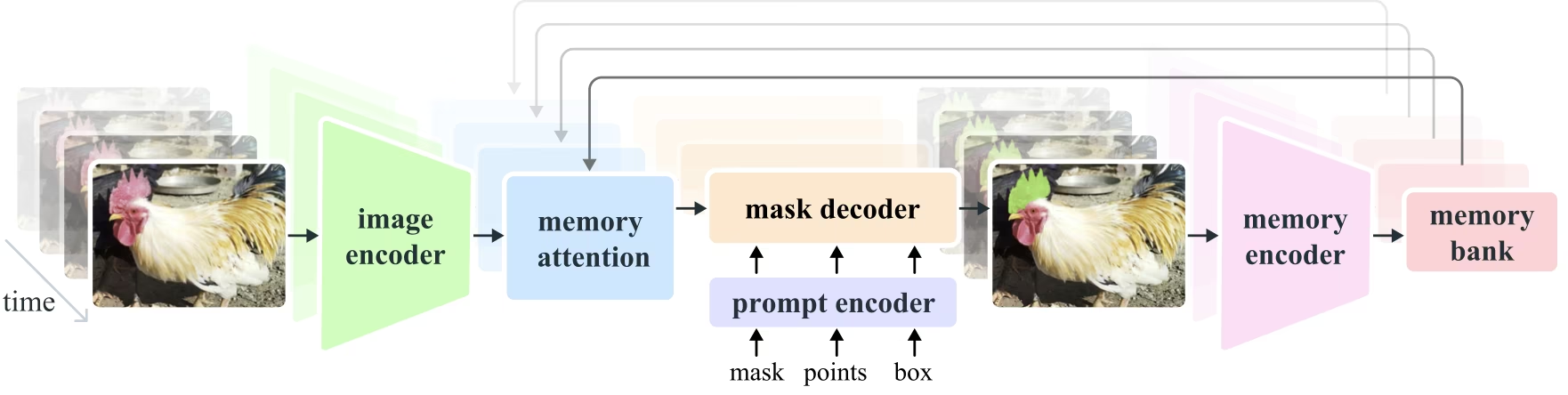

모델 아키텍처

핵심 구성 요소

- 이미지 및 비디오 인코더: 이미지와 비디오 프레임 모두에서 고수준 특징을 추출하기 위해 Transformer 기반 아키텍처를 활용합니다. 이 구성 요소는 각 타임스텝에서 시각적 콘텐츠를 이해하는 역할을 합니다.

- 프롬프트 인코더: 분할 작업을 안내하기 위해 사용자가 제공한 프롬프트(점, 상자, 마스크)를 처리합니다. 이를 통해 SAM 2는 사용자 입력에 적응하고 장면 내 특정 객체를 타겟팅할 수 있습니다.

- 메모리 메커니즘: 메모리 인코더, 메모리 뱅크 및 메모리 어텐션 모듈을 포함합니다. 이러한 구성 요소는 과거 프레임의 정보를 집단적으로 저장하고 활용하여 모델이 시간이 지남에 따라 일관된 객체 추적을 유지할 수 있도록 합니다.

- 마스크 디코더: 인코딩된 이미지 특징 및 프롬프트를 기반으로 최종 분할 마스크를 생성합니다. 비디오에서는 메모리 컨텍스트를 사용하여 프레임 간 정확한 추적을 보장합니다.

메모리 메커니즘 및 폐색 처리

메모리 메커니즘을 통해 SAM 2는 비디오 데이터에서 시간적 종속성 및 폐색을 처리할 수 있습니다. 객체가 움직이고 상호 작용할 때 SAM 2는 해당 특징을 메모리 뱅크에 기록합니다. 객체가 가려지면 모델은 이 메모리에 의존하여 다시 나타날 때 위치와 모양을 예측할 수 있습니다. 폐색 헤드는 객체가 보이지 않는 시나리오를 특별히 처리하여 객체가 가려질 가능성을 예측합니다.

다중 마스크 모호성 해결

모호한 상황(예: 겹치는 객체)에서 SAM 2는 여러 마스크 예측을 생성할 수 있습니다. 이 기능은 단일 마스크로 장면의 뉘앙스를 충분히 설명할 수 없는 복잡한 장면을 정확하게 표현하는 데 중요합니다.

SA-V 데이터 세트

SAM 2의 학습을 위해 개발된 SA-V 데이터 세트는 현재 사용 가능한 비디오 분할 데이터 세트 중 가장 크고 다양한 데이터 세트 중 하나입니다. 포함 내역:

- 51,000개 이상의 비디오: 47개국에서 캡처되어 광범위한 실제 시나리오를 제공합니다.

- 600,000개 이상의 마스크 어노테이션: 전체 객체 및 부분을 포함하는 "masklet"이라고 하는 상세한 시공간 마스크 어노테이션입니다.

- 데이터 세트 규모: 이전 최대 데이터 세트보다 4.5배 더 많은 비디오와 53배 더 많은 어노테이션을 제공하여 전례 없는 다양성과 복잡성을 제공합니다.

벤치마크

비디오 객체 분할

SAM 2는 주요 비디오 분할 벤치마크에서 뛰어난 성능을 입증했습니다.

| 데이터세트 | J&F | J | F |

|---|---|---|---|

| DAVIS 2017 | 82.5 | 79.8 | 85.2 |

| YouTube-VOS | 81.2 | 78.9 | 83.5 |

대화형 분할

대화형 분할 작업에서 SAM 2는 상당한 효율성과 정확성을 보여줍니다.

| 데이터세트 | NoC@90 | AUC |

|---|---|---|

| DAVIS Interactive | 1.54 | 0.872 |

설치

SAM 2를 설치하려면 다음 명령을 사용하십시오. 모든 SAM 2 모델은 처음 사용할 때 자동으로 다운로드됩니다.

pip install ultralytics

SAM 2 사용법: 이미지 및 비디오 분할의 다양성

다음 표는 사용 가능한 SAM 2 모델, 사전 훈련된 가중치, 지원되는 작업, 그리고 추론, 검증, 훈련 및 내보내기와 같은 다양한 작동 모드와의 호환성에 대한 세부 정보를 제공합니다.

| 모델 유형 | 사전 훈련된 가중치 | 지원되는 작업 | 추론 | 검증 | 훈련 | 내보내기 |

|---|---|---|---|---|---|---|

| SAM 2 tiny | sam2_t.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2 small | sam2_s.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2 base | sam2_b.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2 large | sam2_l.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 tiny | sam2.1_t.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 small | sam2.1_s.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 base | sam2.1_b.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

| SAM 2.1 large | sam2.1_l.pt | 인스턴스 분할 | ✅ | ❌ | ❌ | ❌ |

SAM 2 예측 예시

SAM 2는 실시간 비디오 편집, 의료 영상 및 자율 시스템을 포함하여 광범위한 작업에 활용될 수 있습니다. 정적 및 동적 시각 데이터를 모두 segment하는 능력은 연구원과 개발자에게 다재다능한 도구가 됩니다.

프롬프트로 분할

프롬프트로 분할

프롬프트를 사용하여 이미지 또는 비디오에서 특정 객체를 segment합니다.

from ultralytics import SAM

# Load a model

model = SAM("sam2.1_b.pt")

# Display model information (optional)

model.info()

# Run inference with bboxes prompt

results = model("path/to/image.jpg", bboxes=[100, 100, 200, 200])

# Run inference with single point

results = model(points=[900, 370], labels=[1])

# Run inference with multiple points

results = model(points=[[400, 370], [900, 370]], labels=[1, 1])

# Run inference with multiple points prompt per object

results = model(points=[[[400, 370], [900, 370]]], labels=[[1, 1]])

# Run inference with negative points prompt

results = model(points=[[[400, 370], [900, 370]]], labels=[[1, 0]])

전체 분할

전체 분할

특정 프롬프트 없이 전체 이미지 또는 비디오 콘텐츠를 분할합니다.

from ultralytics import SAM

# Load a model

model = SAM("sam2.1_b.pt")

# Display model information (optional)

model.info()

# Run inference

model("path/to/video.mp4")

# Run inference with a SAM 2 model

yolo predict model=sam2.1_b.pt source=path/to/video.mp4

비디오 분할 및 객체 추적

비디오 분할

특정 프롬프트로 전체 비디오 콘텐츠를 segment하고 객체를 track합니다.

from ultralytics.models.sam import SAM2VideoPredictor

# Create SAM2VideoPredictor

overrides = dict(conf=0.25, task="segment", mode="predict", imgsz=1024, model="sam2_b.pt")

predictor = SAM2VideoPredictor(overrides=overrides)

# Run inference with single point

results = predictor(source="test.mp4", points=[920, 470], labels=[1])

# Run inference with multiple points

results = predictor(source="test.mp4", points=[[920, 470], [909, 138]], labels=[1, 1])

# Run inference with multiple points prompt per object

results = predictor(source="test.mp4", points=[[[920, 470], [909, 138]]], labels=[[1, 1]])

# Run inference with negative points prompt

results = predictor(source="test.mp4", points=[[[920, 470], [909, 138]]], labels=[[1, 0]])

- 이 예시는 프롬프트(bboxes/점/마스크)가 제공되지 않는 경우 SAM 2를 사용하여 이미지 또는 비디오의 전체 콘텐츠를 segment하는 방법을 보여줍니다.

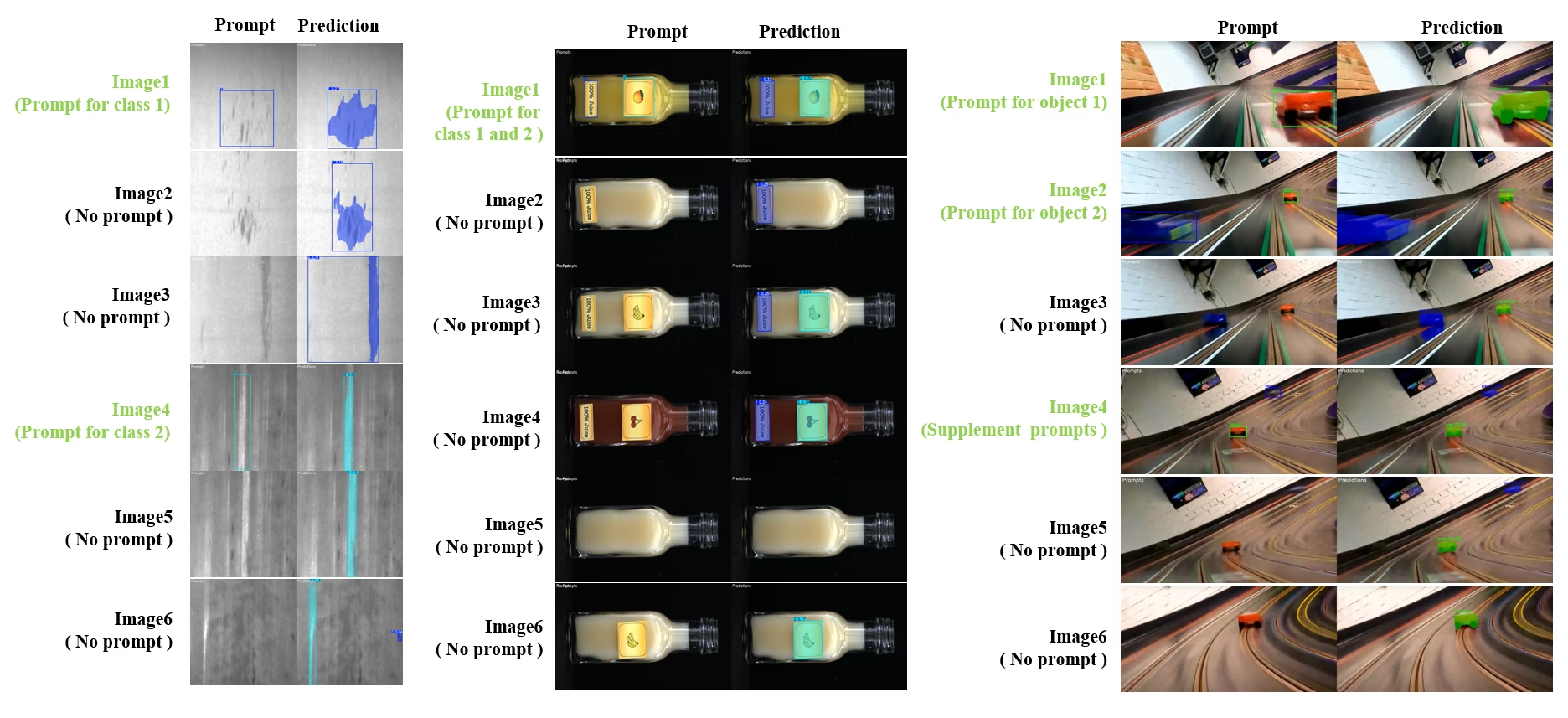

동적 인터랙티브 세그먼트 및 트랙

SAM2DynamicInteractivePredictor는 여러 프레임과의 동적 상호 작용 및 지속적인 학습 기능을 가능하게 하는 SAM2의 고급 훈련 없는 확장 기능입니다. 이 예측기는 실시간 프롬프트 업데이트 및 메모리 관리를 지원하여 일련의 이미지에서 향상된 track 성능을 제공합니다. 오리지널 SAM2와 비교하여, SAM2DynamicInteractivePredictor는 추가 훈련 없이 사전 훈련된 SAM2 모델을 최대한 활용하도록 추론 흐름을 재구성합니다.

주요 기능

다음과 같은 세 가지 중요한 개선 사항을 제공합니다.

- 동적 상호 작용: 비디오 처리 중 언제든지 후속 프레임에서 병합/추적되지 않은 새 인스턴스에 대한 새 프롬프트 추가

- 지속적인 학습: 기존 인스턴스에 대한 새 프롬프트를 추가하여 시간이 지남에 따라 모델 성능 향상

- 독립적인 다중 이미지 지원: 메모리 공유 및 이미지 간 객체 추적을 통해 여러 독립적인 이미지(반드시 비디오 시퀀스에서 가져온 이미지가 아니어도 됨) 처리

핵심 기능

- 프롬프트 유연성: 경계 상자, 점 및 마스크를 프롬프트로 허용

- 메모리 뱅크 관리: 프레임 간 객체 상태를 저장하기 위해 동적 메모리 뱅크 유지 관리

- 다중 객체 추적: 개별 객체 ID를 사용하여 여러 객체를 동시에 추적 지원

- 실시간 업데이트: 이전 프레임을 다시 처리하지 않고 추론 중에 새 프롬프트 추가 허용

- 독립적인 이미지 처리: 이미지 간 객체 일관성을 위해 공유 메모리 컨텍스트를 사용하여 독립 실행형 이미지 처리

동적 객체 추가

from ultralytics.models.sam import SAM2DynamicInteractivePredictor

# Create SAM2DynamicInteractivePredictor

overrides = dict(conf=0.01, task="segment", mode="predict", imgsz=1024, model="sam2_t.pt", save=False)

predictor = SAM2DynamicInteractivePredictor(overrides=overrides, max_obj_num=10)

# Define a category by box prompt

predictor(source="image1.jpg", bboxes=[[100, 100, 200, 200]], obj_ids=[0], update_memory=True)

# Detect this particular object in a new image

results = predictor(source="image2.jpg")

# Add new category with a new object ID

results = predictor(

source="image4.jpg",

bboxes=[[300, 300, 400, 400]], # New object

obj_ids=[1], # New object ID

update_memory=True, # Add to memory

)

# Perform inference

results = predictor(source="image5.jpg")

# Add refinement prompts to the same category to boost performance

# This helps when object appearance changes significantly

results = predictor(

source="image6.jpg",

points=[[150, 150]], # Refinement point

labels=[1], # Positive point

obj_ids=[1], # Same object ID

update_memory=True, # Update memory with new information

)

# Perform inference on new image

results = predictor(source="image7.jpg")

참고

에 지정되어 있습니다. SAM2DynamicInteractivePredictor SAM2 모델과 함께 작동하도록 설계되었으며, 모든 ~에 의해 카테고리 추가/정제를 지원합니다. box/point/mask 프롬프트 SAM2가 기본적으로 지원하는 방식입니다. 이는 비디오 주석 또는 대화형 편집 작업과 같이 객체가 시간이 지남에 따라 나타나거나 변경되는 시나리오에 특히 유용합니다.

인수

| 이름 | 기본값 | 데이터 유형 | 설명 |

|---|---|---|---|

max_obj_num | 3 | int | 사전 설정된 최대 카테고리 수 |

update_memory | False | bool | 새 프롬프트로 메모리를 업데이트할지 여부 |

obj_ids | None | List[int] | 프롬프트에 해당하는 객체 ID 목록 |

사용 사례

SAM2DynamicInteractivePredictor 다음에 이상적입니다.

- 시퀀스 중에 새 객체가 나타나는 비디오 어노테이션 워크플로

- 실시간 객체 추가 및 구체화가 필요한 대화형 비디오 편집

- 동적 객체 추적 요구 사항이 있는 감시 애플리케이션

- 시계열에서 해부학적 구조를 추적하기 위한 의료 영상

- 적응형 객체 감지 및 추적이 필요한 자율 시스템

- 독립적인 이미지에서 일관된 객체 분할을 위한 다중 이미지 데이터 세트

- 서로 다른 장면에서 객체를 추적해야 하는 이미지 컬렉션 분석

- 다양한 이미지 컨텍스트의 메모리를 활용하는 교차 도메인 분할

- 최소한의 수동 개입으로 효율적인 데이터 세트 생성을 위한 반자동 어노테이션

SAM 2 대 YOLO 비교

여기서는 Meta의 SAM2 모델(가장 작은 SAM2-t 변형 포함)과 Ultralytics의 가장 작은 분할 모델인 YOLO11n-seg를 비교합니다.

| 모델 | 크기 (MB) | 파라미터 (M) | 속도 (CPU) (ms/im) |

|---|---|---|---|

| Meta SAM-b | 375 | 93.7 | 49401 |

| Meta SAM2-b | 162 | 80.8 | 31901 |

| Meta SAM2-t | 78.1 | 38.9 | 25997 |

| MobileSAM | 40.7 | 10.1 | 25381 |

| YOLOv8 백본을 사용하는 FastSAM-s | 23.7 | 11.8 | 55.9 |

| Ultralytics YOLOv8n-seg | 6.7 (11.7배 더 작음) | 3.4 (11.4배 적음) | 24.5 (1061배 빠름) |

| Ultralytics YOLO11n-seg | 5.9 (13.2배 작음) | 2.9 (13.4배 적음) | 30.1 (864배 빠름) |

이 비교는 SAM 변형과 YOLO 분할 모델 간의 모델 크기 및 속도에서 상당한 차이를 보여줍니다. SAM은 고유한 자동 분할 기능을 제공하지만, YOLO 모델, 특히 YOLOv8n-seg 및 YOLO11n-seg는 훨씬 작고 빠르며 계산 효율성이 뛰어납니다.

24GB RAM을 갖춘 2025 Apple M4 Pro에서 실행되는 테스트 (사용) torch==2.6.0 및 ultralytics==8.3.90를 사용했습니다. 이 테스트를 재현하려면:

예시

from ultralytics import ASSETS, SAM, YOLO, FastSAM

# Profile SAM2-t, SAM2-b, SAM-b, MobileSAM

for file in ["sam_b.pt", "sam2_b.pt", "sam2_t.pt", "mobile_sam.pt"]:

model = SAM(file)

model.info()

model(ASSETS)

# Profile FastSAM-s

model = FastSAM("FastSAM-s.pt")

model.info()

model(ASSETS)

# Profile YOLO models

for file_name in ["yolov8n-seg.pt", "yolo11n-seg.pt"]:

model = YOLO(file_name)

model.info()

model(ASSETS)

자동 어노테이션: 효율적인 데이터 세트 생성

자동 주석은 SAM 2의 강력한 기능으로, 사용자가 사전 훈련된 모델을 활용하여 segment 데이터셋을 빠르고 정확하게 생성할 수 있도록 합니다. 이 기능은 광범위한 수동 작업 없이 대규모의 고품질 데이터셋을 생성하는 데 특히 유용합니다.

SAM 2로 자동 어노테이션하는 방법

참고: Ultralytics를 사용한 Meta의 Segment Anything 2 모델을 이용한 자동 어노테이션 | 데이터 라벨링

SAM2를 사용하여 데이터 세트를 자동 어노테이션하려면 다음 예제를 따르세요.

자동 어노테이션 예제

from ultralytics.data.annotator import auto_annotate

auto_annotate(data="path/to/images", det_model="yolo11x.pt", sam_model="sam2_b.pt")

| 인수 | 유형 | 기본값 | 설명 |

|---|---|---|---|

data | str | 필수 | 어노테이션 또는 세분화를 위한 대상 이미지가 포함된 디렉토리 경로입니다. |

det_model | str | 'yolo26x.pt' | 초기 객체 탐지를 위한 YOLO 탐지 모델 경로입니다. |

sam_model | str | 'sam_b.pt' | segmentation을 위한 SAM 모델 경로 (SAM, SAM2 변형 및 MobileSAM 모델 지원). |

device | str | '' | 계산 장치(예: 'cuda:0', 'cpu' 또는 자동 장치 감지를 위한 '') |

conf | float | 0.25 | 미약한 탐지를 필터링하기 위한 YOLO 탐지 신뢰도 임계값입니다. |

iou | float | 0.45 | 겹치는 상자를 필터링하기 위한 비최대 억제(Non-Maximum Suppression)의 IoU 임계값. |

imgsz | int | 640 | 이미지 크기 조정을 위한 입력 크기 (32의 배수여야 함). |

max_det | int | 300 | 메모리 효율성을 위해 이미지당 최대 감지 횟수입니다. |

classes | list[int] | None | detect할 클래스 인덱스 목록 (예: [0, 1] 사람 및 자전거용). |

output_dir | str | None | 주석 저장 디렉토리 (데이터 경로를 기준으로 './labels'가 기본값). |

이 기능은 프로젝트 가속화를 목표로 하는 연구원과 개발자에게 이상적인 고품질 분할 데이터 세트의 빠른 생성을 용이하게 합니다.

제한 사항

강점에도 불구하고 SAM2에는 몇 가지 제한 사항이 있습니다.

- track 안정성: SAM 2는 긴 시퀀스 또는 상당한 시점 변화 중에 객체를 track하는 능력을 잃을 수 있습니다.

- 객체 혼동: 모델은 특히 혼잡한 장면에서 유사하게 보이는 객체를 혼동할 수 있습니다.

- 다중 객체 효율성: 객체 간 통신 부족으로 인해 여러 객체를 동시에 처리할 때 분할 효율성이 감소합니다.

- 세부 정확도: 특히 빠르게 움직이는 객체의 경우 미세한 세부 사항을 놓칠 수 있습니다. 추가 프롬프트로 이 문제를 부분적으로 해결할 수 있지만 시간적 부드러움은 보장되지 않습니다.

인용 및 감사의 말씀

SAM2가 연구 또는 개발 작업의 중요한 부분인 경우 다음 참조를 사용하여 인용해 주십시오.

@article{ravi2024sam2,

title={SAM 2: Segment Anything in Images and Videos},

author={Ravi, Nikhila and Gabeur, Valentin and Hu, Yuan-Ting and Hu, Ronghang and Ryali, Chaitanya and Ma, Tengyu and Khedr, Haitham and R{\"a}dle, Roman and Rolland, Chloe and Gustafson, Laura and Mintun, Eric and Pan, Junting and Alwala, Kalyan Vasudev and Carion, Nicolas and Wu, Chao-Yuan and Girshick, Ross and Doll{\'a}r, Piotr and Feichtenhofer, Christoph},

journal={arXiv preprint},

year={2024}

}

이 획기적인 모델 및 데이터 세트로 AI 커뮤니티에 기여한 Meta AI에 감사를 표합니다.

FAQ

SAM 2는 무엇이며, 기존의 Segment Anything Model (SAM)에 비해 어떻게 개선되었습니까?

Meta의 Segment Anything Model (SAM)의 후속 제품인 SAM2는 이미지와 비디오 모두에서 포괄적인 객체 분할을 위해 설계된 최첨단 도구입니다. 실시간 처리 및 제로샷 일반화를 지원하는 통합된 프롬프트 가능한 모델 아키텍처를 통해 복잡한 시각적 데이터를 처리하는 데 탁월합니다. SAM2는 원래 SAM에 비해 다음과 같은 여러 개선 사항을 제공합니다.

- 통합 모델 아키텍처: 이미지 및 비디오 분할 기능을 단일 모델로 결합합니다.

- 실시간 성능: 초당 약 44프레임을 처리하여 즉각적인 피드백이 필요한 애플리케이션에 적합합니다.

- Zero-Shot 일반화: 이전에 접하지 못한 객체를 분할하여 다양한 시각적 영역에서 유용합니다.

- 대화형 개선: 사용자가 추가 프롬프트를 제공하여 분할 결과를 반복적으로 개선할 수 있습니다.

- 시각적 문제에 대한 고급 처리: 객체 가림 및 재출현과 같은 일반적인 비디오 분할 문제를 관리합니다.

SAM 2의 아키텍처 및 기능에 대한 자세한 내용은 SAM 2 연구 논문을 참조하십시오.

실시간 비디오 분할에 SAM 2를 어떻게 사용할 수 있습니까?

SAM 2는 프롬프트 가능한 인터페이스와 실시간 추론 기능을 활용하여 실시간 비디오 분할에 활용할 수 있습니다. 다음은 기본적인 예제입니다.

프롬프트로 분할

프롬프트를 사용하여 이미지 또는 비디오에서 특정 객체를 segment합니다.

from ultralytics import SAM

# Load a model

model = SAM("sam2_b.pt")

# Display model information (optional)

model.info()

# Segment with bounding box prompt

results = model("path/to/image.jpg", bboxes=[100, 100, 200, 200])

# Segment with point prompt

results = model("path/to/image.jpg", points=[150, 150], labels=[1])

보다 포괄적인 사용법은 SAM 2 사용 방법 섹션을 참조하십시오.

SAM 2를 훈련하는 데 사용된 데이터 세트는 무엇이며, 이러한 데이터 세트가 성능을 어떻게 향상시키나요?

SAM 2는 사용 가능한 가장 크고 다양한 비디오 분할 데이터 세트 중 하나인 SA-V 데이터 세트에서 훈련되었습니다. SA-V 데이터 세트는 다음을 포함합니다.

- 51,000개 이상의 비디오: 47개국에서 캡처되어 광범위한 실제 시나리오를 제공합니다.

- 600,000개 이상의 마스크 어노테이션: 전체 객체 및 부분을 포함하는 "masklet"이라고 하는 상세한 시공간 마스크 어노테이션입니다.

- 데이터 세트 규모: 이전 최대 데이터 세트보다 4.5배 더 많은 비디오와 53배 더 많은 주석을 제공하여 전례 없는 다양성과 복잡성을 제공합니다.

이 광범위한 데이터 세트를 통해 SAM 2는 주요 비디오 분할 벤치마크에서 뛰어난 성능을 달성하고 zero-shot 일반화 기능을 향상시킵니다. 자세한 내용은 SA-V 데이터 세트 섹션을 참조하십시오.

SAM 2는 비디오 분할에서 가려짐 및 객체 재등장 문제를 어떻게 처리합니까?

SAM 2에는 비디오 데이터의 시간적 종속성 및 가림을 관리하는 정교한 메모리 메커니즘이 포함되어 있습니다. 메모리 메커니즘은 다음으로 구성됩니다.

- 메모리 인코더 및 메모리 뱅크: 과거 프레임의 특징을 저장합니다.

- 메모리 어텐션 모듈: 저장된 정보를 활용하여 시간이 지남에 따라 일관된 객체 추적을 유지합니다.

- 가림 헤드: 객체가 보이지 않는 시나리오를 특별히 처리하여 객체가 가려질 가능성을 예측합니다.

이 메커니즘은 객체가 일시적으로 가려지거나 장면에서 나가서 다시 들어올 때에도 연속성을 보장합니다. 자세한 내용은 메모리 메커니즘 및 가림 처리 섹션을 참조하십시오.

SAM 2는 YOLO11과 같은 다른 분할 모델과 어떻게 비교되나요?

Meta의 SAM2-t 및 SAM2-b와 같은 SAM 2 모델은 강력한 제로샷 segment 기능을 제공하지만 YOLO11 모델에 비해 훨씬 크고 느립니다. 예를 들어, YOLO11n-seg는 SAM2-b보다 약 13배 작고 860배 이상 빠릅니다. SAM 2가 다재다능하고 프롬프트 기반의 제로샷 segment 시나리오에서 탁월한 반면, YOLO11은 속도, 효율성 및 실시간 애플리케이션에 최적화되어 있어 리소스가 제한된 환경에 배포하기에 더 적합합니다.