Các mẹo và phương pháp hay nhất về học máy để huấn luyện mô hình

Giới thiệu

Một trong những bước quan trọng nhất khi thực hiện một dự án thị giác máy tính là huấn luyện mô hình. Trước khi đạt đến bước này, bạn cần xác định mục tiêu của mình và thu thập và chú thích dữ liệu của bạn. Sau khi xử lý trước dữ liệu để đảm bảo nó sạch và nhất quán, bạn có thể chuyển sang huấn luyện mô hình của mình.

Xem: Mẹo huấn luyện mô hình | Cách xử lý bộ dữ liệu lớn | Kích thước lô, sử dụng GPU và Độ chính xác hỗn hợp

Vậy, huấn luyện mô hình là gì? Huấn luyện mô hình là quá trình dạy mô hình của bạn nhận diện các mẫu trực quan và đưa ra dự đoán dựa trên dữ liệu của bạn. Nó ảnh hưởng trực tiếp đến hiệu suất và độ chính xác của ứng dụng của bạn. Trong hướng dẫn này, chúng ta sẽ đề cập đến các phương pháp hay nhất, kỹ thuật tối ưu hóa và các mẹo khắc phục sự cố để giúp bạn huấn luyện các mô hình thị giác máy tính của mình một cách hiệu quả.

Cách Huấn Luyện một Mô Hình Học Máy

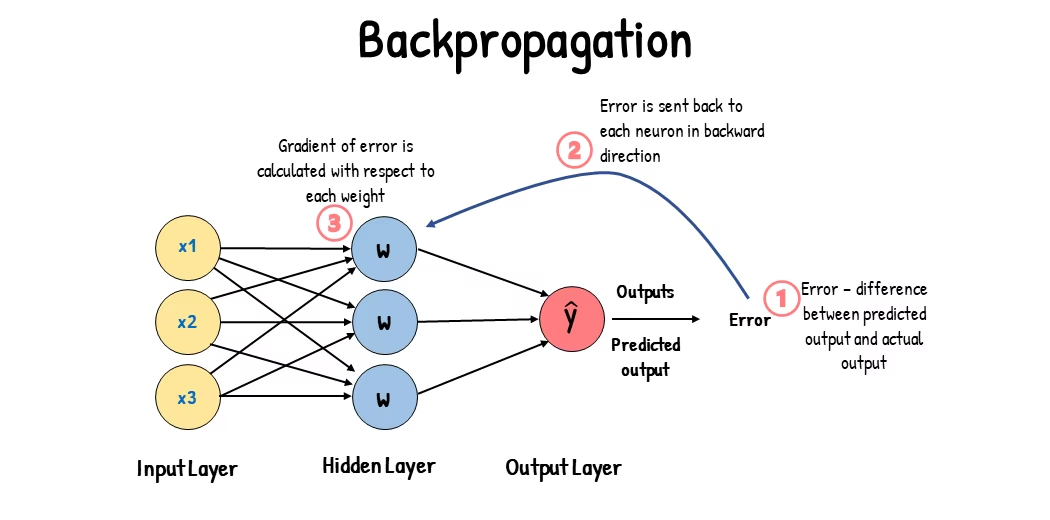

Một mô hình thị giác máy tính được huấn luyện bằng cách điều chỉnh các tham số bên trong của nó để giảm thiểu lỗi. Ban đầu, mô hình được cung cấp một tập hợp lớn các hình ảnh được gắn nhãn. Nó đưa ra các dự đoán về nội dung trong những hình ảnh này và các dự đoán được so sánh với các nhãn hoặc nội dung thực tế để tính toán lỗi. Những lỗi này cho thấy các dự đoán của mô hình khác xa so với các giá trị thực tế như thế nào.

Trong quá trình huấn luyện, mô hình lặp đi lặp lại các dự đoán, tính toán lỗi và cập nhật các tham số của nó thông qua một quy trình gọi là lan truyền ngược. Trong quy trình này, mô hình điều chỉnh các tham số bên trong của nó (trọng số và độ lệch) để giảm lỗi. Bằng cách lặp lại chu kỳ này nhiều lần, mô hình dần dần cải thiện độ chính xác của nó. Theo thời gian, nó học cách nhận biết các mẫu phức tạp như hình dạng, màu sắc và kết cấu.

Quá trình học tập này giúp mô hình thị giác máy tính có thể thực hiện nhiều nhiệm vụ khác nhau, bao gồm phát hiện đối tượng, phân đoạn thể hiện và phân loại hình ảnh. Mục tiêu cuối cùng là tạo ra một mô hình có thể khái quát hóa khả năng học của nó cho các hình ảnh mới, chưa từng thấy để nó có thể hiểu chính xác dữ liệu trực quan trong các ứng dụng thực tế.

Bây giờ chúng ta đã biết điều gì đang xảy ra đằng sau hậu trường khi chúng ta huấn luyện một mô hình, hãy xem xét các điểm cần xem xét khi huấn luyện một mô hình.

Huấn luyện trên bộ dữ liệu lớn

Có một vài khía cạnh khác nhau cần suy nghĩ khi bạn dự định sử dụng một bộ dữ liệu lớn để huấn luyện mô hình. Ví dụ: bạn có thể điều chỉnh kích thước batch, kiểm soát mức sử dụng GPU, chọn sử dụng huấn luyện đa tỷ lệ, v.v. Hãy cùng xem xét chi tiết từng tùy chọn này.

Kích thước lô và mức sử dụng GPU

Khi huấn luyện mô hình trên các tập dữ liệu lớn, việc sử dụng hiệu quả GPU của bạn là rất quan trọng. Kích thước batch là một yếu tố quan trọng. Nó là số lượng mẫu dữ liệu mà một mô hình học máy xử lý trong một lần lặp huấn luyện duy nhất. Sử dụng kích thước batch tối đa được GPU của bạn hỗ trợ, bạn có thể tận dụng tối đa khả năng của nó và giảm thời gian huấn luyện mô hình. Tuy nhiên, bạn nên tránh hết bộ nhớ GPU. Nếu bạn gặp lỗi bộ nhớ, hãy giảm dần kích thước batch cho đến khi mô hình huấn luyện trơn tru.

Xem: Cách sử dụng suy luận theo lô với Ultralytics YOLO26 | Tăng tốc detect đối tượng trong python 🎉

Đối với YOLO26, bạn có thể đặt batch_size tham số trong cấu hình huấn luyện để phù hợp với dung lượng GPU của bạn. Ngoài ra, cài đặt batch=-1 trong tập lệnh huấn luyện của bạn sẽ tự động xác định kích thước lô có thể được xử lý hiệu quả dựa trên khả năng của thiết bị. Bằng cách tinh chỉnh kích thước batch, bạn có thể tận dụng tối đa tài nguyên GPU và cải thiện quy trình huấn luyện tổng thể.

Huấn luyện tập con

Huấn luyện tập con là một chiến lược thông minh, bao gồm huấn luyện mô hình của bạn trên một tập dữ liệu nhỏ hơn đại diện cho tập dữ liệu lớn hơn. Nó có thể tiết kiệm thời gian và tài nguyên, đặc biệt là trong quá trình phát triển và thử nghiệm mô hình ban đầu. Nếu bạn đang thiếu thời gian hoặc thử nghiệm với các cấu hình mô hình khác nhau, thì huấn luyện tập con là một lựa chọn tốt.

Khi nói đến YOLO26, bạn có thể dễ dàng triển khai huấn luyện tập con bằng cách sử dụng fraction tham số. Tham số này cho phép bạn chỉ định tỷ lệ tập dữ liệu của bạn sẽ sử dụng để huấn luyện. Ví dụ: cài đặt fraction=0.1 sẽ huấn luyện mô hình của bạn trên 10% dữ liệu. Bạn có thể sử dụng kỹ thuật này để lặp lại nhanh chóng và điều chỉnh mô hình của mình trước khi cam kết huấn luyện mô hình bằng toàn bộ tập dữ liệu. Huấn luyện tập hợp con giúp bạn đạt được tiến bộ nhanh chóng và xác định các vấn đề tiềm ẩn sớm.

Huấn luyện đa tỷ lệ

Huấn luyện đa tỷ lệ là một kỹ thuật giúp cải thiện khả năng tổng quát hóa của mô hình bằng cách huấn luyện nó trên các hình ảnh có kích thước khác nhau. Mô hình của bạn có thể học cách detect các đối tượng ở các tỷ lệ và khoảng cách khác nhau, từ đó trở nên mạnh mẽ hơn.

Ví dụ, khi bạn huấn luyện YOLO26, bạn có thể bật huấn luyện đa tỷ lệ bằng cách đặt scale tham số. Tham số này điều chỉnh kích thước của hình ảnh huấn luyện theo một hệ số được chỉ định, mô phỏng các đối tượng ở các khoảng cách khác nhau. Ví dụ: cài đặt scale=0.5 tự động thu phóng hình ảnh huấn luyện theo hệ số từ 0.5 đến 1.5 trong quá trình huấn luyện. Việc định cấu hình tham số này cho phép mô hình của bạn trải nghiệm nhiều tỷ lệ hình ảnh khác nhau và cải thiện khả năng phát hiện của nó trên các kích thước và tình huống đối tượng khác nhau.

Ultralytics Ngoài ra, nó còn hỗ trợ huấn luyện đa tỷ lệ kích thước hình ảnh thông qua... multi_scale tham số. Không giống như scale, thao tác này phóng to hình ảnh rồi thêm/cắt xén lại. imgsz, multi_scale thay đổi imgsz Mỗi lô dữ liệu được tính toán riêng lẻ (làm tròn đến bước nhảy của mô hình). Ví dụ, với imgsz=640 và multi_scale=0.25, kích thước huấn luyện được lấy mẫu từ 480 đến 800 theo từng bước (ví dụ: 480, 512, 544, ..., 800), trong khi multi_scale=0.0 Giữ nguyên kích thước.

Bộ nhớ đệm

Bộ nhớ đệm là một kỹ thuật quan trọng để cải thiện hiệu quả huấn luyện các mô hình machine learning. Bằng cách lưu trữ hình ảnh đã được xử lý trước trong bộ nhớ, bộ nhớ đệm làm giảm thời gian GPU chờ dữ liệu được tải từ ổ đĩa. Mô hình có thể liên tục nhận dữ liệu mà không bị chậm trễ do các hoạt động I/O của ổ đĩa.

Việc lưu vào bộ nhớ cache có thể được kiểm soát khi huấn luyện YOLO26 bằng cách sử dụng cache tham số:

cache=True: Lưu trữ hình ảnh bộ dữ liệu trong RAM, cung cấp tốc độ truy cập nhanh nhất nhưng phải trả giá bằng việc tăng mức sử dụng bộ nhớ.cache='disk': Lưu trữ hình ảnh trên đĩa, chậm hơn RAM nhưng nhanh hơn việc tải dữ liệu mới mỗi lần.cache=False: Vô hiệu hóa bộ nhớ đệm, hoàn toàn dựa vào I/O đĩa, đây là tùy chọn chậm nhất.

Huấn luyện Độ chính xác Hỗn hợp

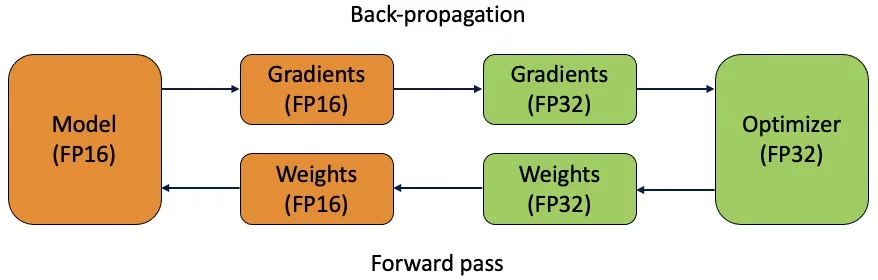

Huấn luyện độ chính xác hỗn hợp sử dụng cả kiểu dấu phẩy động 16-bit (FP16) và 32-bit (FP32). Điểm mạnh của cả FP16 và FP32 được tận dụng bằng cách sử dụng FP16 để tính toán nhanh hơn và FP32 để duy trì độ chính xác khi cần thiết. Hầu hết các hoạt động của mạng nơ-ron được thực hiện ở FP16 để hưởng lợi từ tính toán nhanh hơn và sử dụng bộ nhớ thấp hơn. Tuy nhiên, một bản sao chính của trọng số của mô hình được giữ ở FP32 để đảm bảo độ chính xác trong các bước cập nhật trọng số. Bạn có thể xử lý các mô hình lớn hơn hoặc kích thước lô lớn hơn trong cùng một ràng buộc phần cứng.

Để triển khai huấn luyện độ chính xác hỗn hợp, bạn cần sửa đổi các tập lệnh huấn luyện và đảm bảo phần cứng của bạn (chẳng hạn như GPU) hỗ trợ nó. Nhiều framework học sâu hiện đại, như PyTorch và TensorFlow, cung cấp hỗ trợ tích hợp cho độ chính xác hỗn hợp.

Huấn luyện độ chính xác hỗn hợp rất đơn giản khi làm việc với YOLO26. Bạn có thể sử dụng amp flag trong cấu hình huấn luyện của bạn. Cài đặt amp=True cho phép huấn luyện Automatic Mixed Precision (AMP). Huấn luyện Mixed Precision là một cách đơn giản nhưng hiệu quả để tối ưu hóa quá trình huấn luyện mô hình của bạn.

Trọng số đã huấn luyện trước

Sử dụng trọng số được huấn luyện trước là một cách thông minh để tăng tốc quá trình huấn luyện mô hình của bạn. Trọng số được huấn luyện trước đến từ các mô hình đã được huấn luyện trên các tập dữ liệu lớn, giúp mô hình của bạn có một khởi đầu thuận lợi. Học chuyển giao điều chỉnh các mô hình được huấn luyện trước cho các tác vụ mới, có liên quan. Tinh chỉnh một mô hình được huấn luyện trước bao gồm việc bắt đầu với các trọng số này và sau đó tiếp tục huấn luyện trên tập dữ liệu cụ thể của bạn. Phương pháp huấn luyện này giúp giảm thời gian huấn luyện và thường mang lại hiệu suất tốt hơn vì mô hình bắt đầu với sự hiểu biết vững chắc về các đặc trưng cơ bản.

Hàm pretrained tham số giúp học chuyển giao dễ dàng với YOLO26. Đặt pretrained=True sẽ sử dụng trọng số được huấn luyện trước mặc định, hoặc bạn có thể chỉ định đường dẫn đến một mô hình được huấn luyện trước tùy chỉnh. Việc sử dụng trọng số được huấn luyện trước và học chuyển giao giúp tăng cường đáng kể khả năng của mô hình và giảm chi phí huấn luyện.

Các kỹ thuật khác cần xem xét khi xử lý một tập dữ liệu lớn

Có một vài kỹ thuật khác cần xem xét khi xử lý một bộ dữ liệu lớn:

- Bộ điều chỉnh Learning Rate: Việc triển khai các bộ lập lịch tốc độ học sẽ điều chỉnh động tốc độ học trong quá trình huấn luyện. Tốc độ học được điều chỉnh tốt có thể ngăn mô hình vượt quá các điểm cực tiểu và cải thiện độ ổn định. Khi huấn luyện YOLO26,

lrftham số giúp quản lý việc lên lịch tốc độ học bằng cách đặt tốc độ học cuối cùng thành một phần nhỏ của tốc độ ban đầu. - Huấn luyện phân tán: Để xử lý các bộ dữ liệu lớn, huấn luyện phân tán có thể là một yếu tố thay đổi cuộc chơi. Bạn có thể giảm thời gian huấn luyện bằng cách phân tán khối lượng công việc huấn luyện trên nhiều GPU hoặc máy. Phương pháp này đặc biệt có giá trị đối với các dự án quy mô doanh nghiệp với nguồn tài nguyên tính toán đáng kể.

Số Lượng Epochs Để Huấn Luyện

Khi huấn luyện một mô hình, epoch đề cập đến một lần duyệt đầy đủ qua toàn bộ tập dữ liệu huấn luyện. Trong một epoch, mô hình xử lý từng ví dụ trong tập huấn luyện một lần và cập nhật các tham số của nó dựa trên thuật toán học. Thông thường, cần nhiều epoch để cho phép mô hình học và tinh chỉnh các tham số của nó theo thời gian.

Một câu hỏi thường gặp là làm thế nào để xác định số lượng epoch để huấn luyện mô hình. Một điểm khởi đầu tốt là 300 epoch. Nếu mô hình bị overfitting sớm, bạn có thể giảm số lượng epoch. Nếu overfitting không xảy ra sau 300 epoch, bạn có thể kéo dài quá trình huấn luyện lên 600, 1200 hoặc nhiều epoch hơn.

Tuy nhiên, số epoch lý tưởng có thể thay đổi tùy thuộc vào kích thước tập dữ liệu và mục tiêu dự án của bạn. Các tập dữ liệu lớn hơn có thể yêu cầu nhiều epoch hơn để mô hình học hiệu quả, trong khi các tập dữ liệu nhỏ hơn có thể cần ít epoch hơn để tránh overfitting. Đối với YOLO26, bạn có thể đặt epochs tham số trong tập lệnh huấn luyện của bạn.

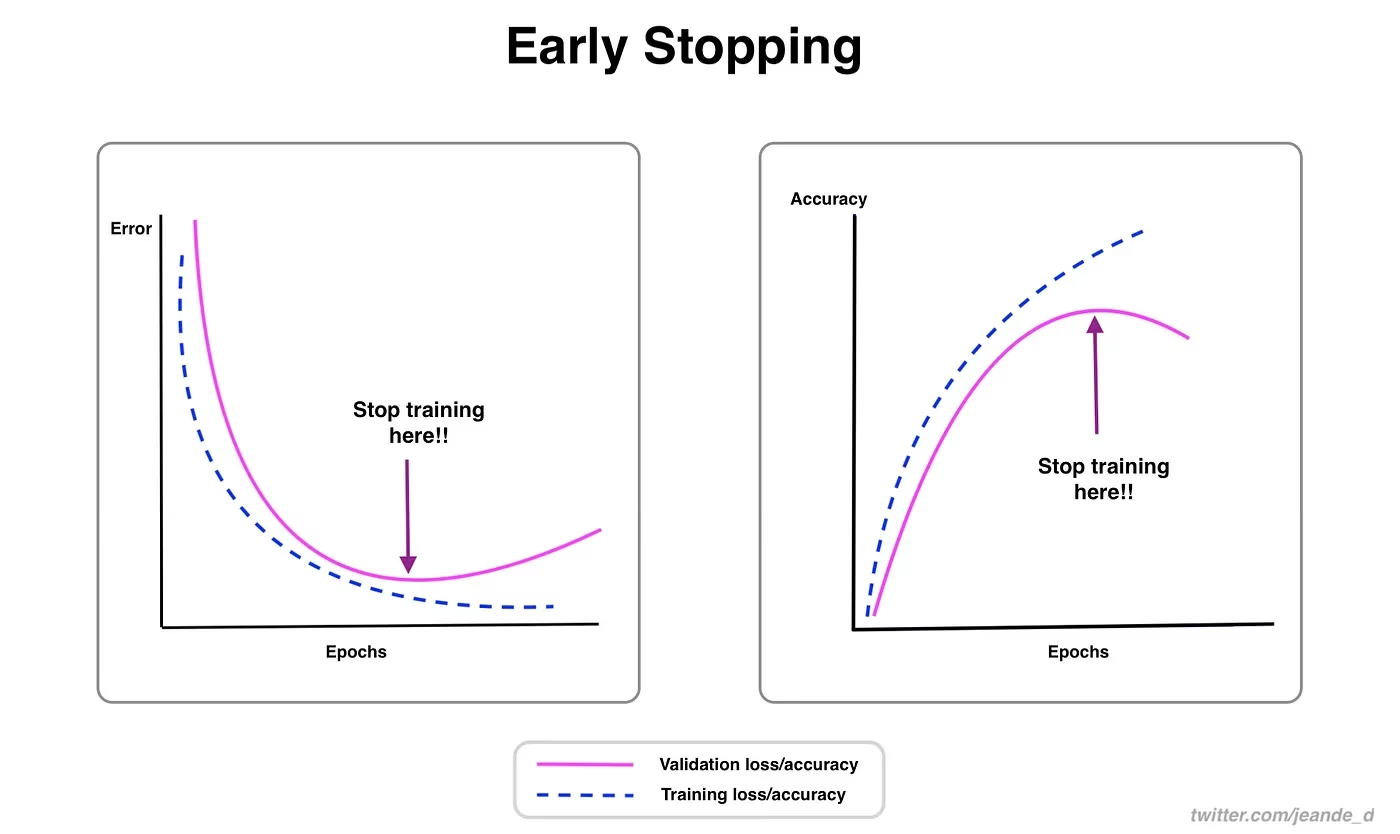

Dừng Sớm

Dừng sớm là một kỹ thuật có giá trị để tối ưu hóa quá trình huấn luyện mô hình. Bằng cách theo dõi hiệu suất xác thực, bạn có thể dừng huấn luyện khi mô hình ngừng cải thiện. Bạn có thể tiết kiệm tài nguyên tính toán và ngăn ngừa tình trạng quá khớp (overfitting).

Quá trình này bao gồm việc thiết lập một tham số kiên nhẫn xác định số lượng kỷ nguyên để chờ đợi sự cải thiện trong các số liệu xác thực trước khi dừng huấn luyện. Nếu hiệu suất của mô hình không được cải thiện trong các kỷ nguyên này, quá trình huấn luyện sẽ dừng lại để tránh lãng phí thời gian và tài nguyên.

Đối với YOLO26, bạn có thể bật dừng sớm bằng cách đặt tham số patience trong cấu hình huấn luyện của bạn. Ví dụ, patience=5 có nghĩa là quá trình huấn luyện sẽ dừng lại nếu không có sự cải thiện nào về các số liệu xác thực trong 5 epoch liên tiếp. Sử dụng phương pháp này đảm bảo quá trình huấn luyện vẫn hiệu quả và đạt được hiệu suất tối ưu mà không cần tính toán quá mức.

Lựa chọn giữa Đào tạo trên Cloud và Đào tạo cục bộ

Có hai tùy chọn để huấn luyện mô hình của bạn: huấn luyện trên cloud và huấn luyện cục bộ.

Đào tạo trên nền tảng đám mây mang lại khả năng mở rộng và phần cứng mạnh mẽ, lý tưởng để xử lý các bộ dữ liệu lớn và các mô hình phức tạp. Các nền tảng như Google Cloud, AWS và Azure cung cấp quyền truy cập theo yêu cầu vào GPU và TPU hiệu suất cao, tăng tốc thời gian đào tạo và cho phép thử nghiệm với các mô hình lớn hơn. Tuy nhiên, đào tạo trên nền tảng đám mây có thể tốn kém, đặc biệt là trong thời gian dài và việc truyền dữ liệu có thể làm tăng chi phí và độ trễ.

Huấn luyện cục bộ cung cấp khả năng kiểm soát và tùy chỉnh cao hơn, cho phép bạn điều chỉnh môi trường của mình theo các nhu cầu cụ thể và tránh các chi phí đám mây liên tục. Nó có thể kinh tế hơn cho các dự án dài hạn và vì dữ liệu của bạn luôn ở tại chỗ nên nó an toàn hơn. Tuy nhiên, phần cứng cục bộ có thể có những hạn chế về tài nguyên và yêu cầu bảo trì, điều này có thể dẫn đến thời gian huấn luyện lâu hơn cho các mô hình lớn.

Chọn một trình tối ưu hóa

Bộ tối ưu hóa là một thuật toán điều chỉnh trọng số của mạng nơ-ron để giảm thiểu hàm mất mát (loss function), đo lường mức độ hoạt động của mô hình. Nói một cách đơn giản, bộ tối ưu hóa giúp mô hình học bằng cách tinh chỉnh các tham số của nó để giảm lỗi. Việc chọn đúng bộ tối ưu hóa ảnh hưởng trực tiếp đến tốc độ và độ chính xác học của mô hình.

Bạn cũng có thể tinh chỉnh các tham số trình tối ưu hóa để cải thiện hiệu suất mô hình. Điều chỉnh tốc độ học đặt kích thước của các bước khi cập nhật tham số. Để ổn định, bạn có thể bắt đầu với tốc độ học vừa phải và giảm dần nó theo thời gian để cải thiện khả năng học tập lâu dài. Ngoài ra, việc đặt quán tính xác định mức độ ảnh hưởng của các bản cập nhật trước đây đến các bản cập nhật hiện tại. Một giá trị phổ biến cho quán tính là khoảng 0,9. Nó thường cung cấp một sự cân bằng tốt.

Các trình tối ưu hóa phổ biến

Các trình tối ưu hóa khác nhau có những điểm mạnh và điểm yếu khác nhau. Hãy cùng xem xét một vài trình tối ưu hóa phổ biến.

SGD (Stochastic Gradient Descent):

- Cập nhật các tham số mô hình bằng cách sử dụng gradient của hàm mất mát (loss function) đối với các tham số.

- Đơn giản và hiệu quả nhưng có thể hội tụ chậm và có thể bị mắc kẹt trong các cực tiểu cục bộ.

Adam (Adaptive Moment Estimation):

- Kết hợp lợi ích của cả SGD với momentum và RMSProp.

- Điều chỉnh tốc độ học cho từng tham số dựa trên ước tính của các moment thứ nhất và thứ hai của gradient.

- Rất phù hợp với dữ liệu nhiễu và độ dốc thưa thớt.

- Hiệu quả và thường yêu cầu ít tinh chỉnh hơn, khiến nó trở thành trình tối ưu hóa được khuyến nghị cho YOLO26.

RMSProp (Root Mean Square Propagation):

- Điều chỉnh tốc độ học cho từng tham số bằng cách chia gradient cho trung bình động của độ lớn của các gradient gần đây.

- Giúp xử lý vấn đề biến mất gradient và hiệu quả cho mạng nơ-ron tái phát.

Đối với YOLO26, optimizer tham số cho phép bạn chọn từ nhiều bộ tối ưu hóa khác nhau, bao gồm SGD, Adam, AdamW, NAdam, RAdam và RMSProp, hoặc bạn có thể đặt nó thành auto để tự động lựa chọn dựa trên cấu hình mô hình.

Kết Nối với Cộng Đồng

Tham gia vào một cộng đồng những người đam mê thị giác máy tính có thể giúp bạn giải quyết vấn đề và học hỏi nhanh hơn. Dưới đây là một số cách để kết nối, nhận trợ giúp và chia sẻ ý tưởng.

Tài nguyên Cộng đồng

- GitHub Issues: Truy cập kho lưu trữ GitHub của YOLO26 và sử dụng tab Issues để đặt câu hỏi, báo cáo lỗi và đề xuất các tính năng mới. Cộng đồng và những người duy trì rất tích cực và sẵn sàng trợ giúp.

- Máy chủ Ultralytics Discord: Tham gia máy chủ Ultralytics Discord để trò chuyện với những người dùng và nhà phát triển khác, nhận hỗ trợ và chia sẻ kinh nghiệm của bạn.

Tài liệu Chính thức

- Tài liệu Ultralytics YOLO26: Hãy xem tài liệu YOLO26 chính thức để biết các hướng dẫn chi tiết và mẹo hữu ích cho nhiều dự án thị giác máy tính khác nhau.

Sử dụng các tài nguyên này sẽ giúp bạn giải quyết các thách thức và luôn cập nhật các xu hướng và phương pháp mới nhất trong cộng đồng thị giác máy tính.

Những Điểm Chính

Huấn luyện các mô hình thị giác máy tính đòi hỏi phải tuân thủ các thực hành tốt, tối ưu hóa chiến lược và giải quyết các vấn đề phát sinh. Các kỹ thuật như điều chỉnh kích thước batch, huấn luyện độ chính xác hỗn hợp và bắt đầu với trọng số được huấn luyện trước có thể giúp mô hình của bạn hoạt động tốt hơn và huấn luyện nhanh hơn. Các phương pháp như huấn luyện trên tập con và dừng sớm giúp bạn tiết kiệm thời gian và tài nguyên. Luôn kết nối với cộng đồng và cập nhật các xu hướng mới sẽ giúp bạn không ngừng cải thiện kỹ năng huấn luyện mô hình của mình.

Câu hỏi thường gặp

Làm thế nào để cải thiện việc sử dụng GPU khi huấn luyện một bộ dữ liệu lớn với Ultralytics YOLO?

Để cải thiện việc sử dụng GPU, hãy đặt batch_size tham số trong cấu hình huấn luyện của bạn thành kích thước tối đa được GPU của bạn hỗ trợ. Điều này đảm bảo bạn tận dụng tối đa khả năng của GPU, giảm thời gian huấn luyện. Nếu gặp lỗi bộ nhớ, hãy giảm dần kích thước lô cho đến khi quá trình huấn luyện diễn ra suôn sẻ. Đối với YOLO26, việc thiết lập batch=-1 trong tập lệnh huấn luyện của bạn sẽ tự động xác định kích thước lô tối ưu để xử lý hiệu quả. Để biết thêm thông tin, hãy tham khảo cấu hình huấn luyện.

Huấn luyện độ chính xác hỗn hợp là gì và làm thế nào để bật nó trong YOLO26?

Huấn luyện độ chính xác hỗn hợp sử dụng cả kiểu dấu phẩy động 16-bit (FP16) và 32-bit (FP32) để cân bằng giữa tốc độ tính toán và độ chính xác. Phương pháp này tăng tốc quá trình huấn luyện và giảm mức sử dụng bộ nhớ mà không làm giảm mô hình độ chính xác. Để bật huấn luyện độ chính xác hỗn hợp trong YOLO26, hãy đặt amp tham số thành True trong cấu hình huấn luyện của bạn. Điều này kích hoạt huấn luyện Automatic Mixed Precision (AMP). Để biết thêm chi tiết về kỹ thuật tối ưu hóa này, hãy xem cấu hình huấn luyện.

Huấn luyện đa tỷ lệ nâng cao hiệu suất mô hình YOLO26 như thế nào?

Huấn luyện đa tỷ lệ (multiscale training) nâng cao hiệu suất mô hình bằng cách huấn luyện trên các hình ảnh có kích thước khác nhau, cho phép mô hình tổng quát hóa tốt hơn trên các tỷ lệ và khoảng cách khác nhau. Trong YOLO26, bạn có thể bật huấn luyện đa tỷ lệ bằng cách đặt scale tham số trong cấu hình huấn luyện. Ví dụ: scale=0.5 Lấy mẫu với hệ số phóng đại từ 0,5 đến 1,5, sau đó điều chỉnh/cắt xén lại. imgszKỹ thuật này mô phỏng các đối tượng ở các khoảng cách khác nhau, giúp mô hình hoạt động ổn định hơn trong nhiều tình huống khác nhau. Để biết cài đặt và thông tin chi tiết hơn, hãy xem phần [liên kết]. cấu hình huấn luyện.

Làm thế nào tôi có thể sử dụng trọng số tiền huấn luyện để tăng tốc quá trình huấn luyện trong YOLO26?

Sử dụng trọng số tiền huấn luyện (pretrained weights) có thể tăng tốc đáng kể quá trình huấn luyện và nâng cao độ chính xác của mô hình bằng cách tận dụng một mô hình đã quen thuộc với các đặc trưng hình ảnh cơ bản. Trong YOLO26, chỉ cần đặt pretrained tham số thành True hoặc cung cấp đường dẫn đến trọng số được huấn luyện trước tùy chỉnh của bạn trong cấu hình huấn luyện. Phương pháp này, được gọi là học chuyển giao, cho phép các mô hình được huấn luyện trên các tập dữ liệu lớn được điều chỉnh hiệu quả cho ứng dụng cụ thể của bạn. Tìm hiểu thêm về cách sử dụng trọng số được huấn luyện trước và lợi ích của chúng trong hướng dẫn cấu hình đào tạo.

Số epoch được khuyến nghị để huấn luyện một mô hình là bao nhiêu và làm thế nào để đặt giá trị này trong YOLO26?

Số lượng epoch đề cập đến số lần hoàn thành toàn bộ tập dữ liệu huấn luyện trong quá trình huấn luyện mô hình. Điểm khởi đầu điển hình là 300 epoch. Nếu mô hình của bạn bị overfitting sớm, bạn có thể giảm số lượng này. Ngược lại, nếu không quan sát thấy overfitting, bạn có thể kéo dài quá trình huấn luyện lên 600, 1200 hoặc nhiều epoch hơn. Để thiết lập điều này trong YOLO26, hãy sử dụng epochs tham số trong tập lệnh huấn luyện của bạn. Để biết thêm lời khuyên về cách xác định số lượng kỷ nguyên lý tưởng, hãy tham khảo phần này về số lượng epochs.