Ensemble de données COCO8

Introduction

Le dataset Ultralytics COCO8 est un dataset de object detection compact mais puissant, composé des 8 premières images de l'ensemble COCO train 2017, soit 4 pour l'entraînement et 4 pour la validation. Ce dataset est spécialement conçu pour les tests rapides, le débogage et l'expérimentation avec les modèles YOLO et les pipelines d'entraînement. Sa petite taille le rend très facile à gérer, tandis que sa diversité garantit qu'il sert de contrôle de cohérence efficace avant de passer à des datasets plus volumineux.

Regarder : Présentation de l'ensemble de données Ultralytics COCO

COCO8 est entièrement compatible avec Ultralytics Platform et YOLO26, permettant une intégration transparente dans vos flux de travail de vision par ordinateur.

YAML du jeu de données

La configuration du jeu de données COCO8 est définie dans un fichier YAML (Yet Another Markup Language), qui spécifie les chemins d'accès aux données, les noms de classes et d'autres métadonnées essentielles. Vous pouvez consulter le fichier officiel coco8.yaml fichier dans le dépôt GitHub Ultralytics.

ultralytics/cfg/datasets/coco8.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO8 dataset (first 8 images from COCO train2017) by Ultralytics

# Documentation: https://docs.ultralytics.com/datasets/detect/coco8/

# Example usage: yolo train data=coco8.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco8 ← downloads here (1 MB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco8 # dataset root dir

train: images/train # train images (relative to 'path') 4 images

val: images/val # val images (relative to 'path') 4 images

test: # test images (optional)

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: https://github.com/ultralytics/assets/releases/download/v0.0.0/coco8.zip

Utilisation

Pour entraîner un modèle YOLO26n sur le jeu de données COCO8 pendant 100 epochs avec une taille d'image de 640, utilisez les exemples suivants. Pour une liste complète des options d'entraînement, consultez la documentation sur l'entraînement YOLO.

Exemple d'entraînement

from ultralytics import YOLO

# Load a pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on COCO8

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

# Train YOLO26n on COCO8 using the command line

yolo detect train data=coco8.yaml model=yolo26n.pt epochs=100 imgsz=640

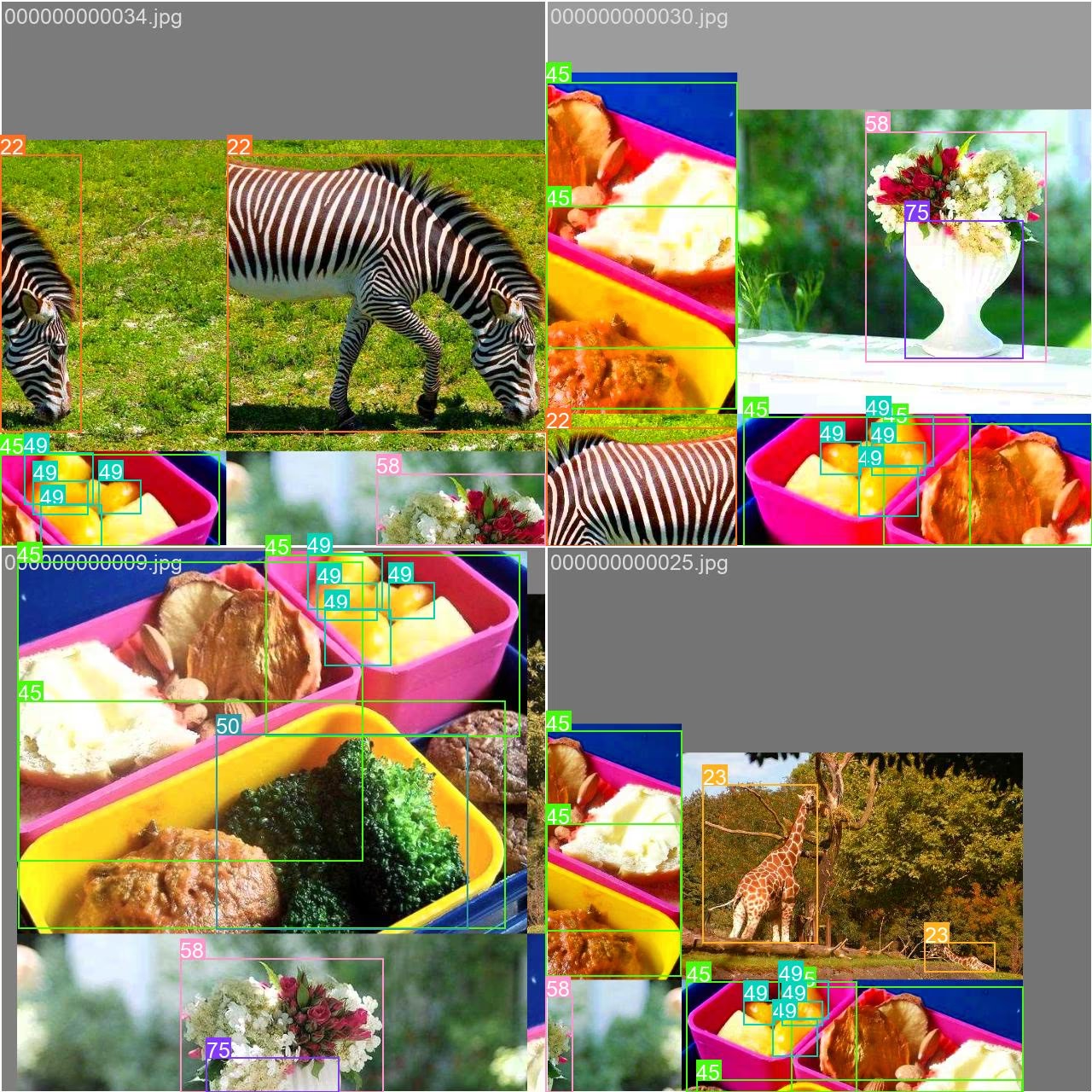

Images et annotations d'exemple

Voici un exemple de lot d'entraînement en mosaïque provenant de l'ensemble de données COCO8:

- Image en mosaïque : Cette image illustre un lot d'entraînement où plusieurs images de l'ensemble de données sont combinées à l'aide de l'augmentation en mosaïque. L'augmentation en mosaïque accroît la diversité des objets et des scènes au sein de chaque lot, ce qui aide le modèle à mieux généraliser à diverses tailles d'objets, rapports d'aspect et arrière-plans.

Cette technique est particulièrement utile pour les petits ensembles de données comme COCO8, car elle maximise la valeur de chaque image pendant l'entraînement.

Citations et remerciements

Si vous utilisez l'ensemble de données COCO dans votre recherche ou développement, veuillez citer l'article suivant :

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Un merci spécial au COCO Consortium pour ses contributions continues à la communauté de la vision par ordinateur.

FAQ

À quoi sert l'ensemble de données Ultralytics COCO8 ?

L'ensemble de données Ultralytics COCO8 est conçu pour tester et déboguer rapidement les modèles de détection d'objets. Avec seulement 8 images (4 pour l'entraînement, 4 pour la validation), il est idéal pour vérifier vos pipelines d'entraînement YOLO et s'assurer que tout fonctionne comme prévu avant de passer à des ensembles de données plus volumineux. Explorez la configuration COCO8 YAML pour plus de détails.

Comment entraîner un modèle YOLO26 en utilisant le jeu de données COCO8 ?

Vous pouvez entraîner un modèle YOLO26 sur COCO8 en utilisant Python ou la CLI :

Exemple d'entraînement

from ultralytics import YOLO

# Load a pretrained YOLO26n model

model = YOLO("yolo26n.pt")

# Train the model on COCO8

results = model.train(data="coco8.yaml", epochs=100, imgsz=640)

yolo detect train data=coco8.yaml model=yolo26n.pt epochs=100 imgsz=640

Pour des options d'entraînement supplémentaires, consultez la documentation sur l'entraînement YOLO.

Pourquoi devrais-je utiliser Ultralytics Platform pour gérer mon entraînement COCO8 ?

La plateforme Ultralytics simplifie la gestion des jeux de données, l'entraînement et le déploiement des modèles YOLO, y compris COCO8. Grâce à des fonctionnalités telles que l'entraînement dans le cloud, la surveillance en temps réel et une gestion intuitive des jeux de données, HUB vous permet de lancer des expériences en un seul clic et élimine les tracas de la configuration manuelle. Apprenez-en davantage sur la plateforme Ultralytics et comment elle peut accélérer vos projets de vision par ordinateur.

Quels sont les avantages de l'utilisation de l'augmentation mosaïque dans l'entraînement avec le jeu de données COCO8 ?

L'augmentation mosaïque, telle qu'utilisée dans l'entraînement COCO8, combine plusieurs images en une seule lors de chaque lot. Cela augmente la diversité des objets et des arrière-plans, aidant votre YOLO modèle à mieux généraliser à de nouveaux scénarios. L'augmentation mosaïque est particulièrement précieuse pour les petits jeux de données, car elle maximise les informations disponibles à chaque étape d'entraînement. Pour en savoir plus, consultez le guide d'entraînement.

Comment puis-je valider mon modèle YOLO26 entraîné sur le jeu de données COCO8 ?

Pour valider votre modèle YOLO26 après l'entraînement sur COCO8, utilisez les commandes de validation du modèle en Python ou en CLI. Cela évalue les performances de votre modèle à l'aide de métriques standard. Pour des instructions étape par étape, consultez la documentation sur la validation YOLO.