クイックスタートガイド:NVIDIA JetsonとUltralytics YOLO26

この包括的なガイドでは、NVIDIA JetsonデバイスへのUltralytics YOLO26のデプロイに関する詳細なウォークスルーを提供します。さらに、これらの小型で強力なデバイスでのYOLO26の機能を実証するためのパフォーマンスベンチマークも紹介しています。

新製品のサポート

このガイドは、最新のNVIDIA Jetson AGX Thor Developer Kitで更新されました。このキットは、最大2070 FP4 TFLOPSのAI演算性能と128 GBのメモリを提供し、電力は40 Wから130 Wの間で設定可能です。NVIDIA Jetson AGX Orinよりも7.5倍以上のAI演算性能と3.5倍優れたエネルギー効率を実現し、最も人気のあるAIモデルをシームレスに実行できます。

見る: NVIDIA JetsonデバイスでUltralytics YOLO26を使用する方法

注

このガイドは、NVIDIA Jetson AGX Thor Developer Kit (Jetson T5000)(最新の安定版JetPackリリースJP7.0を実行)、NVIDIA Jetson AGX Orin Developer Kit (64GB)(JetPackリリースJP6.2を実行)、NVIDIA Jetson Orin Nano Super Developer Kit(JetPackリリースJP6.1を実行)、NVIDIA Jetson Orin NX 16GBをベースとするSeeed Studio reComputer J4012(JetPackリリースJP6.0/JetPackリリースJP5.1.3を実行)、およびNVIDIA Jetson Nano 4GBをベースとするSeeed Studio reComputer J1020 v2(JetPackリリースJP4.6.1を実行)でテストされています。最新デバイスからレガシーデバイスまで、すべてのNVIDIA Jetsonハードウェアラインナップで動作することが期待されます。

NVIDIA Jetsonとは何ですか?

NVIDIA Jetsonは、AI(人工知能)コンピューティングをエッジデバイスに加速させるために設計された組み込みコンピューティングボードのシリーズです。これらのコンパクトで強力なデバイスは、NVIDIAのGPUアーキテクチャを中心に構築されており、クラウドコンピューティングリソースに依存することなく、複雑なAIアルゴリズムやディープラーニングモデルをデバイス上で直接実行できます。Jetsonボードは、ロボット工学、自動運転車、産業オートメーション、その他AI推論を低レイテンシかつ高効率でローカルに実行する必要があるアプリケーションでよく使用されます。さらに、これらのボードはARM64アーキテクチャに基づいており、従来のGPUコンピューティングデバイスと比較して低消費電力で動作します。

NVIDIA Jetsonシリーズ比較

NVIDIA Jetson AGX Thorは、NVIDIA Blackwellアーキテクチャに基づくNVIDIA Jetsonファミリの最新のイテレーションであり、以前の世代と比較してAIパフォーマンスが大幅に向上しています。以下の表は、エコシステム内のいくつかのJetsonデバイスを比較したものです。

| Jetson AGX Thor(T5000) | Jetson AGX Orin 64GB | Jetson Orin NX 16GB | Jetson Orin Nano Super | Jetson AGX Xavier | Jetson Xavier NX | Jetson Nano | |

|---|---|---|---|---|---|---|---|

| AIパフォーマンス | 2070 TFLOPS | 275 TOPS | 100 TOPS | 67 TOPS | 32 TOPS | 21 TOPS | 472 GFLOPS |

| GPU | 96 Tensor Coreを搭載した2560-core NVIDIA BlackwellアーキテクチャGPU | 64 Tensor Coreを搭載した2048コアのNVIDIA AmpereアーキテクチャGPU | 1024-core NVIDIA Ampere アーキテクチャ GPU (32 Tensor Cores 搭載) | 1024-core NVIDIA Ampere アーキテクチャ GPU (32 Tensor Cores 搭載) | 64のTensor Coreを搭載した512-core NVIDIA Voltaアーキテクチャ GPU | 48 Tensor Coreを搭載した384コアのNVIDIA Volta™アーキテクチャGPU | 128コア NVIDIA Maxwell™アーキテクチャ GPU |

| GPU 最大周波数 | 1.57 GHz | 1.3 GHz | 918 MHz | 1020 MHz | 1377 MHz | 1100 MHz | 921MHz |

| CPU | 14-core Arm® Neoverse®-V3AE 64-bit CPU 1MB L2 + 16MB L3 | 12コア NVIDIA Arm® Cortex A78AE v8.2 64ビット CPU 3MB L2 + 6MB L3 | 8コア NVIDIA Arm® Cortex A78AE v8.2 64-bit CPU 2MB L2 + 4MB L3 | 6-core Arm® Cortex®-A78AE v8.2 64-bit CPU 1.5MB L2 + 4MB L3 | 8コア NVIDIA Carmel Arm®v8.2 64-bit CPU 8MB L2 + 4MB L3 | 6-core NVIDIA Carmel Arm®v8.2 64-bit CPU 6MB L2 + 4MB L3 | クアッドコア Arm® Cortex®-A57 MPCoreプロセッサ |

| CPU 最大周波数 | 2.6 GHz | 2.2 GHz | 2.0 GHz | 1.7 GHz | 2.2 GHz | 1.9 GHz | 1.43GHz |

| メモリ | 128GB 256-bit LPDDR5X 273GB/s | 64GB 256-bit LPDDR5 204.8GB/秒 | 16GB 128ビット LPDDR5 102.4GB/秒 | 8GB 128-bit LPDDR5 102 GB/秒 | 32GB 256-bit LPDDR4x 136.5GB/秒 | 8GB 128-bit LPDDR4x 59.7GB/秒 | 4GB 64-bit LPDDR4 25.6GB/s |

より詳細な比較表については、NVIDIA Jetson公式ページの仕様比較セクションをご覧ください。

NVIDIA JetPackとは何ですか?

Jetsonモジュールを強化するNVIDIA JetPack SDKは、最も包括的なソリューションであり、エンドツーエンドの高速化されたAIアプリケーションを構築するための完全な開発環境を提供し、市場投入までの時間を短縮します。JetPackには、ブートローダー、Linuxカーネル、Ubuntuデスクトップ環境、およびGPUコンピューティング、マルチメディア、グラフィックス、コンピュータビジョンの高速化のための完全なライブラリセットを備えたJetson Linuxが含まれています。また、ホストコンピュータと開発キットの両方に対応したサンプル、ドキュメント、および開発者ツールも含まれており、ストリーミングビデオ分析用のDeepStream、ロボティクス用のIsaac、会話型AI用のRivaなどの高レベルSDKをサポートしています。

NVIDIA JetsonへのJetPackのフラッシュ

NVIDIA Jetsonデバイスを入手した後の最初のステップは、NVIDIA JetPackをデバイスにフラッシュすることです。NVIDIA Jetsonデバイスをフラッシュするにはいくつかの異なる方法があります。

- Jetson AGX Thor Developer Kitのような公式のNVIDIA開発キットをお持ちの場合、イメージをダウンロードし、ブータブルUSBスティックを準備して、付属のSSDにJetPackをフラッシュできます。

- Jetson Orin Nano Developer Kit などの NVIDIA 公式開発キットをお持ちの場合は、イメージをダウンロードし、JetPack を使用してデバイスを起動するための SD カードを準備することができます。

- その他の NVIDIA 開発キットをお持ちの場合は、SDK Manager を使用して JetPack をデバイスに書き込むことができます。

- Seeed Studio reComputer J4012 デバイスをお持ちの場合は、JetPack を付属の SSD に書き込むことができます。また、Seeed Studio reComputer J1020 v2 デバイスをお持ちの場合は、JetPack を eMMC/SSD に書き込むことができます。

- NVIDIA Jetsonモジュールを搭載した他のサードパーティ製デバイスをお持ちの場合は、コマンドラインフラッシングに従うことをお勧めします。

注

上記のメソッド1、4、5の場合、システムをフラッシュし、デバイスを起動した後、デバイスのターミナルで「sudo apt update && sudo apt install nvidia-jetpack -y」と入力して、必要な残りのJetPackコンポーネントをすべてインストールしてください。

Jetsonデバイスに基づくJetPackのサポート

以下の表は、さまざまなNVIDIA JetsonデバイスでサポートされているNVIDIA JetPackのバージョンをまとめたものです。

| JetPack 4 | JetPack 5 | JetPack 6 | JetPack 7 | |

|---|---|---|---|---|

| Jetson Nano | ✅ | ❌ | ❌ | ❌ |

| Jetson TX2 | ✅ | ❌ | ❌ | ❌ |

| Jetson Xavier NX | ✅ | ✅ | ❌ | ❌ |

| Jetson AGX Xavier | ✅ | ✅ | ❌ | ❌ |

| Jetson AGX Orin | ❌ | ✅ | ✅ | ❌ |

| Jetson Orin NX | ❌ | ✅ | ✅ | ❌ |

| Jetson Orin Nano | ❌ | ✅ | ✅ | ❌ |

| Jetson AGX Thor | ❌ | ❌ | ❌ | ✅ |

Dockerを使ったクイックスタート

NVIDIA JetsonでUltralytics YOLO26を始める最も速い方法は、Jetson用の事前構築済みdockerイメージで実行することです。上記の表を参照し、お持ちのJetsonデバイスに応じてJetPackバージョンを選択してください。

t=ultralytics/ultralytics:latest-jetson-jetpack4

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-jetson-jetpack5

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-jetson-jetpack6

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

t=ultralytics/ultralytics:latest-nvidia-arm64

sudo docker pull $t && sudo docker run -it --ipc=host --runtime=nvidia $t

完了したら、NVIDIA JetsonでTensorRTを使用するセクションに進んでください。

ネイティブインストールから開始

Dockerを使用しないネイティブインストールについては、以下の手順を参照してください。

JetPack 7.0で実行

Ultralyticsパッケージのインストール

ここでは、PyTorchモデルを他のさまざまな形式でエクスポートできるように、オプションの依存関係とともにUltralyticsパッケージをJetsonにインストールします。ここでは主にNVIDIA TensorRTエクスポートに焦点を当てます。これは、TensorRTがJetsonデバイスから最大限のパフォーマンスを引き出すことを保証するためです。

パッケージリストの更新、pipのインストール、および最新バージョンへのアップグレード

sudo apt update sudo apt install python3-pip -y pip install -U pipインストール

ultralyticsオプションの依存関係を含む pip パッケージpip install ultralytics[export]デバイスを再起動

sudo reboot

PyTorchとTorchvisionのインストール

上記のUltralyticsインストールでは、torchとTorchvisionがインストールされます。しかし、pip経由でインストールされたこれら2つのパッケージは、JetPack 7.0とCUDA 13が付属するJetson AGX Thorでは実行互換性がありません。したがって、手動でインストールする必要があります。

インストール torch および torchvision JP7.0によると

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu130

インストール onnxruntime-gpu

The onnxruntime-gpu PyPIでホストされているパッケージには aarch64 Jetson用のバイナリ。したがって、このパッケージを手動でインストールする必要があります。このパッケージは、一部のエクスポートに必要です。

ここでは、ダウンロードしてインストールします onnxruntime-gpu 1.24.0 with Python3.12 サポート。

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.24.0-cp312-cp312-linux_aarch64.whl

JetPack 6.1 で実行

Ultralyticsパッケージのインストール

ここでは、PyTorchモデルを他のさまざまな形式でエクスポートできるように、オプションの依存関係とともにUltralyticsパッケージをJetsonにインストールします。ここでは主にNVIDIA TensorRTエクスポートに焦点を当てます。これは、TensorRTがJetsonデバイスから最大限のパフォーマンスを引き出すことを保証するためです。

パッケージリストの更新、pipのインストール、および最新バージョンへのアップグレード

sudo apt update sudo apt install python3-pip -y pip install -U pipインストール

ultralyticsオプションの依存関係を含む pip パッケージpip install ultralytics[export]デバイスを再起動

sudo reboot

PyTorchとTorchvisionのインストール

上記のUltralyticsのインストールでは、TorchとTorchvisionがインストールされます。しかし、pip経由でインストールされるこれら2つのパッケージは、ARM64アーキテクチャをベースとするJetsonプラットフォームとは互換性がありません。そのため、事前にビルドされたPyTorch pipホイールを手動でインストールし、Torchvisionをソースからコンパイルまたはインストールする必要があります。

インストール torch 2.5.0 および torchvision 0.20 JP6.1に準拠

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torch-2.5.0a0+872d972e41.nv24.08-cp310-cp310-linux_aarch64.whl

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torchvision-0.20.0a0+afc54f7-cp310-cp310-linux_aarch64.whl

注

JetPackのバージョンに対応したさまざまなバージョンのPyTorchにアクセスするには、Jetson用PyTorchのページをご覧ください。PyTorch、Torchvisionの互換性に関するより詳細なリストについては、PyTorchとTorchvisionの互換性ページをご覧ください。

インストール cuSPARSELt の依存関係の問題を修正するには、 torch 2.5.0

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/arm64/cuda-keyring_1.1-1_all.deb

sudo dpkg -i cuda-keyring_1.1-1_all.deb

sudo apt-get update

sudo apt-get -y install libcusparselt0 libcusparselt-dev

インストール onnxruntime-gpu

The onnxruntime-gpu PyPIでホストされているパッケージには aarch64 Jetson用のバイナリ。したがって、このパッケージを手動でインストールする必要があります。このパッケージは、一部のエクスポートに必要です。

利用可能なすべての onnxruntime-gpu JetPackバージョン、Pythonバージョン、およびその他の互換性の詳細ごとに整理されたパッケージを Jetson Zoo ONNX Runtime 互換性マトリックス.

次の場合 JetPack 6 with Python 3.10 サポートがあるため、インストールできます onnxruntime-gpu 1.23.0:

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.23.0-cp310-cp310-linux_aarch64.whl

あるいは、 onnxruntime-gpu 1.20.0:

pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/onnxruntime_gpu-1.20.0-cp310-cp310-linux_aarch64.whl

JetPack 5.1.2 で実行

Ultralyticsパッケージのインストール

ここでは、PyTorchモデルを他のさまざまな形式でエクスポートできるように、オプションの依存関係とともにUltralyticsパッケージをJetsonにインストールします。ここでは主にNVIDIA TensorRTエクスポートに焦点を当てます。これは、TensorRTがJetsonデバイスから最大限のパフォーマンスを引き出すことを保証するためです。

パッケージリストの更新、pipのインストール、および最新バージョンへのアップグレード

sudo apt update sudo apt install python3-pip -y pip install -U pipインストール

ultralyticsオプションの依存関係を含む pip パッケージpip install ultralytics[export]デバイスを再起動

sudo reboot

PyTorchとTorchvisionのインストール

上記のUltralyticsのインストールでは、TorchとTorchvisionがインストールされます。しかし、pip経由でインストールされるこれら2つのパッケージは、ARM64アーキテクチャをベースとするJetsonプラットフォームとは互換性がありません。そのため、事前にビルドされたPyTorch pipホイールを手動でインストールし、Torchvisionをソースからコンパイルまたはインストールする必要があります。

現在インストールされているPyTorchおよびTorchvisionをアンインストールする

pip uninstall torch torchvisionインストール

torch 2.2.0およびtorchvision 0.17.2JP5.1.2に準拠pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torch-2.2.0-cp38-cp38-linux_aarch64.whl pip install https://github.com/ultralytics/assets/releases/download/v0.0.0/torchvision-0.17.2+c1d70fe-cp38-cp38-linux_aarch64.whl

注

JetPackのバージョンに対応したさまざまなバージョンのPyTorchにアクセスするには、Jetson用PyTorchのページをご覧ください。PyTorch、Torchvisionの互換性に関するより詳細なリストについては、PyTorchとTorchvisionの互換性ページをご覧ください。

インストール onnxruntime-gpu

The onnxruntime-gpu PyPIでホストされているパッケージには aarch64 Jetson用のバイナリ。したがって、このパッケージを手動でインストールする必要があります。このパッケージは、一部のエクスポートに必要です。

利用可能なすべての onnxruntime-gpu JetPackバージョン、Pythonバージョン、およびその他の互換性の詳細ごとに整理されたパッケージを Jetson Zoo ONNX Runtime 互換性マトリックス。ここでは、をダウンロードしてインストールします。 onnxruntime-gpu 1.17.0 with Python3.8 サポート。

wget https://nvidia.box.com/shared/static/zostg6agm00fb6t5uisw51qi6kpcuwzd.whl -O onnxruntime_gpu-1.17.0-cp38-cp38-linux_aarch64.whl

pip install onnxruntime_gpu-1.17.0-cp38-cp38-linux_aarch64.whl

注

onnxruntime-gpu numpyのバージョンが自動的に最新版に戻ります。そのため、numpyを再インストールする必要があります。 1.23.5 問題を修正するには、以下を実行します。

pip install numpy==1.23.5

NVIDIA JetsonでTensorRTを使用する

Ultralyticsがサポートするすべてのモデルエクスポート形式の中で、TensorRTはNVIDIA Jetsonデバイスで最高の推論パフォーマンスを提供するため、Jetsonデプロイメントに最適な推奨事項です。セットアップ手順と高度な使用法については、専用のTensorRT統合ガイドを参照してください。

モデルをTensorRTに変換して推論を実行

PyTorch形式のYOLO26nモデルは、エクスポートされたモデルで推論を実行するためにTensorRTに変換されます。

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT

model.export(format="engine") # creates 'yolo26n.engine'

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format

yolo export model=yolo26n.pt format=engine # creates 'yolo26n.engine'

# Run inference with the exported model

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

注

モデルを異なる形式でエクスポートする際の追加引数にアクセスするには、エクスポートページをご覧ください。

NVIDIA Deep Learning Accelerator (DLA) を使用する

NVIDIA Deep Learning Accelerator (DLA)は、NVIDIA Jetsonデバイスに組み込まれた特殊なハードウェアコンポーネントであり、エネルギー効率とパフォーマンスのために深層学習推論を最適化します。GPUからタスクをオフロードすることにより(より集中的なプロセスのためにGPUを解放します)、DLAは、組み込みシステムおよびリアルタイムAIアプリケーションに最適な、高いスループットを維持しながら、より低い消費電力でモデルを実行できるようにします。

以下のJetsonデバイスには、DLAハードウェアが搭載されています。

| Jetsonデバイス | DLAコア | DLA最大周波数 |

|---|---|---|

| Jetson AGX Orinシリーズ | 2 | 1.6 GHz |

| Jetson Orin NX 16GB | 2 | 614 MHz |

| Jetson Orin NX 8GB | 1 | 614 MHz |

| Jetson AGX Xavierシリーズ | 2 | 1.4 GHz |

| Jetson Xavier NXシリーズ | 2 | 1.1 GHz |

例

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model to TensorRT with DLA enabled (only works with FP16 or INT8)

model.export(format="engine", device="dla:0", half=True) # dla:0 or dla:1 corresponds to the DLA cores

# Load the exported TensorRT model

trt_model = YOLO("yolo26n.engine")

# Run inference

results = trt_model("https://ultralytics.com/images/bus.jpg")

# Export a YOLO26n PyTorch model to TensorRT format with DLA enabled (only works with FP16 or INT8)

# Once DLA core number is specified at export, it will use the same core at inference

yolo export model=yolo26n.pt format=engine device="dla:0" half=True # dla:0 or dla:1 corresponds to the DLA cores

# Run inference with the exported model on the DLA

yolo predict model=yolo26n.engine source='https://ultralytics.com/images/bus.jpg'

注

DLAエクスポートを使用する場合、一部のレイヤーはDLAでの実行がサポートされず、GPUにフォールバックすることがあります。このフォールバックにより、追加のレイテンシが発生し、全体的な推論パフォーマンスに影響を与える可能性があります。したがって、DLAは主に、GPUで完全に実行されるTensorRTと比較して、推論レイテンシを削減するように設計されていません。代わりに、その主な目的は、スループットを向上させ、エネルギー効率を改善することです。

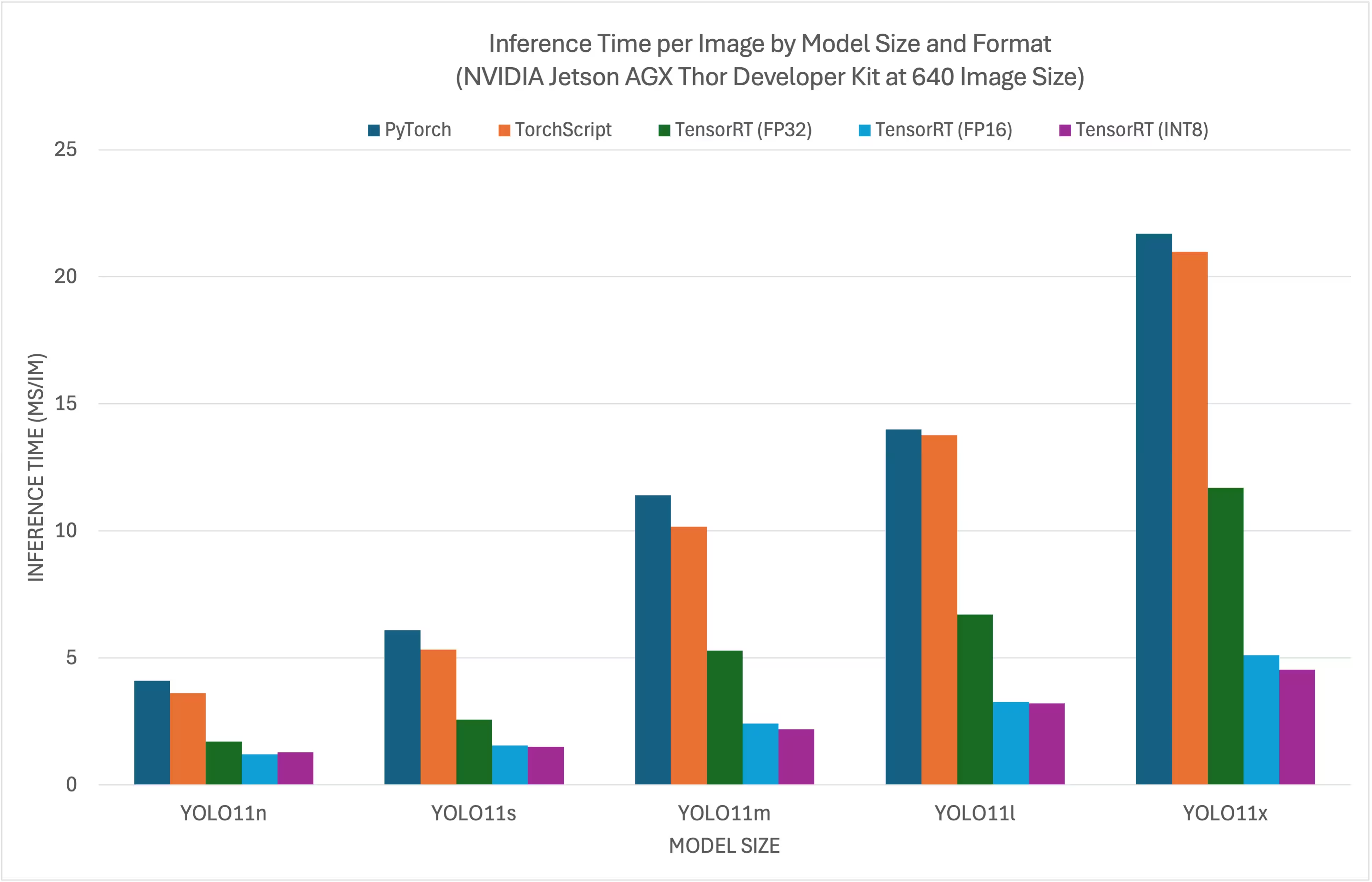

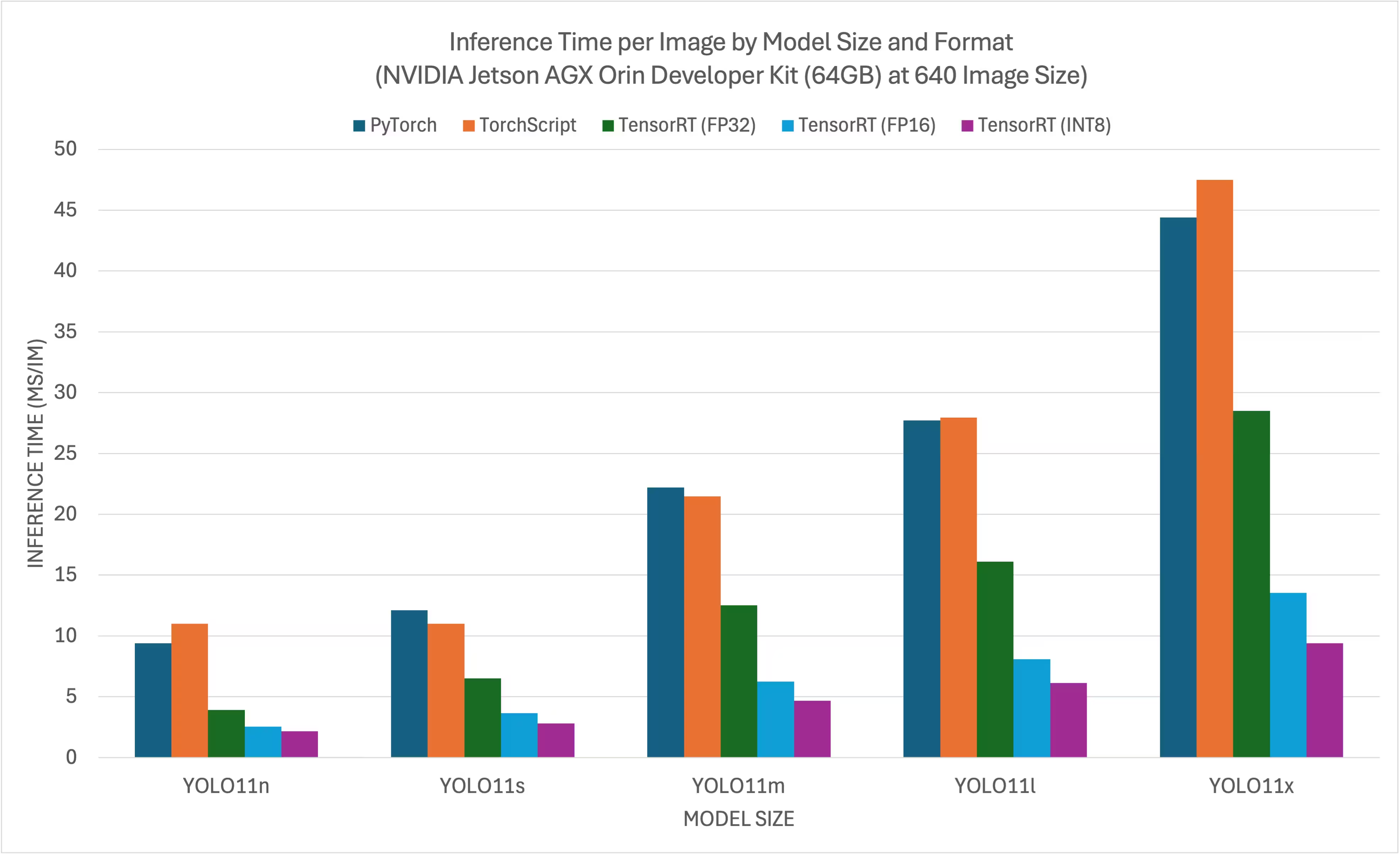

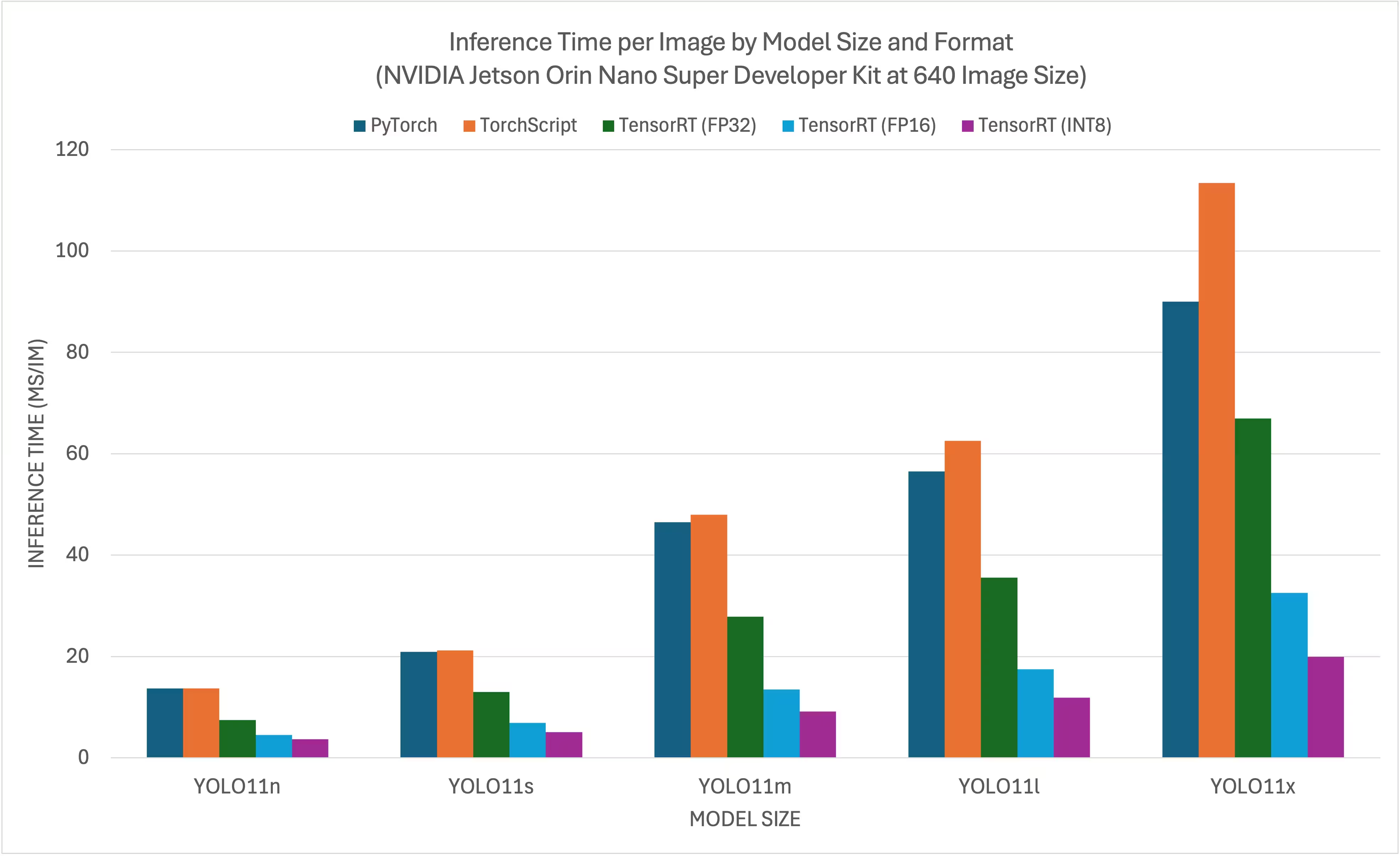

NVIDIA YOLO11 YOLO26 ベンチマーク

Ultralytics は、速度と精度を測定するため、11種類の異なるモデル形式(PyTorch、TorchScript、ONNX、OpenVINO、TensorRT、TF SavedModel、TF GraphDef、TF 、MNN、NCNN、ExecuTorch)YOLO11ベンチマークを実行しました。 ベンチマークは、NVIDIA AGX Thor開発者キット、NVIDIA AGX Orin開発者キット(64GB)、NVIDIA Orin Nano Super開発者キット、およびSeeed Studio reComputer J4012(Jetson Orin NX 16GB搭載)上で、FP32精度、デフォルト入力画像サイズ640ピクセルで実行されました。

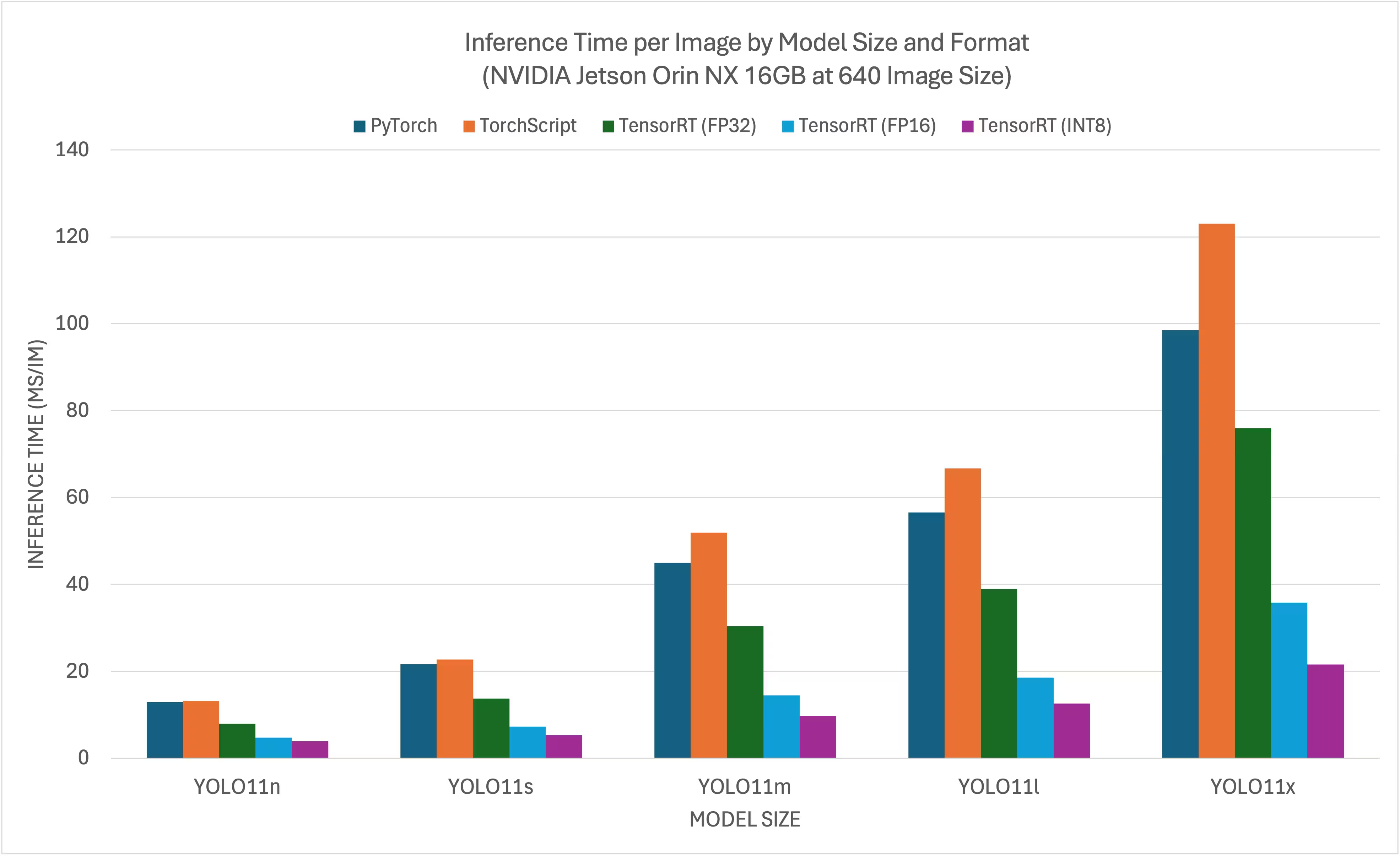

比較チャート

すべてのモデルエクスポートはNVIDIA Jetsonで動作しますが、以下の比較チャートにはPyTorch、TorchScript、TensorRTのみを含めました。これは、これらがJetsonのGPUを利用し、最良の結果を保証するためです。他のすべてのエクスポートはCPUのみを利用し、パフォーマンスは上記の3つほどではありません。すべてのエクスポートのベンチマークは、このチャートの後のセクションで確認できます。

NVIDIA Jetson AGX Thor Developer Kit

NVIDIA Jetson AGX Orin Developer Kit (64GB)

NVIDIA Jetson Orin Nano Super Developer Kit

NVIDIA Jetson Orin NX 16GB

詳細な比較表

以下の表は、5つの異なるモデル(YOLO11n、YOLO11s、YOLO11m、YOLO11l、YOLO11x)と11の異なる形式(PyTorch、TorchScript、ONNX、OpenVINO、TensorRT、TF SavedModel、TF GraphDef、TF Lite、MNN、NCNN、ExecuTorch)におけるベンチマーク結果を示しており、各組み合わせのステータス、サイズ、mAP50-95(B)メトリック、および推論時間を提供します。

NVIDIA Jetson AGX Thor Developer Kit

パフォーマンス

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.3 | 0.4798 | 7.39 |

| TorchScript | ✅ | 9.8 | 0.4789 | 4.21 |

| ONNX | ✅ | 9.5 | 0.4767 | 6.58 |

| OpenVINO | ✅ | 10.1 | 0.4794 | 17.50 |

| TensorRT(FP32) | ✅ | 13.9 | 0.4791 | 1.90 |

| TensorRT(FP16) | ✅ | 7.6 | 0.4797 | 1.39 |

| TensorRT(INT8) | ✅ | 6.5 | 0.4273 | 1.52 |

| TF SavedModel | ✅ | 25.7 | 0.4764 | 47.24 |

| TF GraphDef | ✅ | 9.5 | 0.4764 | 45.98 |

| TF Lite | ✅ | 9.9 | 0.4764 | 182.04 |

| MNN | ✅ | 9.4 | 0.4784 | 21.83 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 19.5 | 0.5738 | 7.99 |

| TorchScript | ✅ | 36.8 | 0.5664 | 6.01 |

| ONNX | ✅ | 36.5 | 0.5666 | 9.31 |

| OpenVINO | ✅ | 38.5 | 0.5656 | 35.56 |

| TensorRT(FP32) | ✅ | 38.9 | 0.5664 | 2.95 |

| TensorRT(FP16) | ✅ | 21.0 | 0.5650 | 1.77 |

| TensorRT(INT8) | ✅ | 13.5 | 0.5010 | 1.75 |

| TF SavedModel | ✅ | 96.6 | 0.5665 | 88.87 |

| TF GraphDef | ✅ | 36.5 | 0.5665 | 89.20 |

| TF Lite | ✅ | 36.9 | 0.5665 | 604.25 |

| MNN | ✅ | 36.4 | 0.5651 | 53.75 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 42.2 | 0.6237 | 10.76 |

| TorchScript | ✅ | 78.5 | 0.6217 | 10.57 |

| ONNX | ✅ | 78.2 | 0.6211 | 14.91 |

| OpenVINO | ✅ | 82.2 | 0.6204 | 86.27 |

| TensorRT(FP32) | ✅ | 82.2 | 0.6230 | 5.56 |

| TensorRT(FP16) | ✅ | 41.6 | 0.6209 | 2.58 |

| TensorRT(INT8) | ✅ | 24.3 | 0.5595 | 2.49 |

| TF SavedModel | ✅ | 205.8 | 0.6229 | 200.96 |

| TF GraphDef | ✅ | 78.2 | 0.6229 | 203.00 |

| TF Lite | ✅ | 78.6 | 0.6229 | 1867.12 |

| MNN | ✅ | 78.0 | 0.6176 | 142.00 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 50.7 | 0.6258 | 13.34 |

| TorchScript | ✅ | 95.5 | 0.6248 | 13.86 |

| ONNX | ✅ | 95.0 | 0.6247 | 18.44 |

| OpenVINO | ✅ | 99.9 | 0.6238 | 106.67 |

| TensorRT(FP32) | ✅ | 99.0 | 0.6249 | 6.74 |

| TensorRT(FP16) | ✅ | 50.3 | 0.6243 | 3.34 |

| TensorRT(INT8) | ✅ | 29.0 | 0.5708 | 3.24 |

| TF SavedModel | ✅ | 250.0 | 0.6245 | 259.74 |

| TF GraphDef | ✅ | 95.0 | 0.6245 | 263.42 |

| TF Lite | ✅ | 95.4 | 0.6245 | 2367.83 |

| MNN | ✅ | 94.8 | 0.6272 | 174.39 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 113.2 | 0.6565 | 20.92 |

| TorchScript | ✅ | 213.5 | 0.6595 | 21.76 |

| ONNX | ✅ | 212.9 | 0.6590 | 26.72 |

| OpenVINO | ✅ | 223.6 | 0.6620 | 205.27 |

| TensorRT(FP32) | ✅ | 217.2 | 0.6593 | 12.29 |

| TensorRT(FP16) | ✅ | 112.1 | 0.6611 | 5.16 |

| TensorRT(INT8) | ✅ | 58.9 | 0.5222 | 4.72 |

| TF SavedModel | ✅ | 559.2 | 0.6593 | 498.85 |

| TF GraphDef | ✅ | 213.0 | 0.6593 | 507.43 |

| TF Lite | ✅ | 213.3 | 0.6593 | 5134.22 |

| MNN | ✅ | 212.8 | 0.6625 | 347.84 |

Ultralytics .4.7 を用いてベンチマークを実施

注

推論時間には、プリ/ポスト処理は含まれていません。

NVIDIA Jetson AGX Orin Developer Kit (64GB)

パフォーマンス

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 9.40 |

| TorchScript | ✅ | 10.5 | 0.5083 | 11.00 |

| ONNX | ✅ | 10.2 | 0.5077 | 48.32 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 27.24 |

| TensorRT(FP32) | ✅ | 12.1 | 0.5085 | 3.93 |

| TensorRT(FP16) | ✅ | 8.3 | 0.5063 | 2.55 |

| TensorRT(INT8) | ✅ | 5.4 | 0.4719 | 2.18 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 66.87 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 65.68 |

| TF Lite | ✅ | 10.3 | 0.5077 | 272.92 |

| MNN | ✅ | 10.1 | 0.5059 | 36.33 |

| NCNN | ✅ | 10.2 | 0.5031 | 28.51 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5783 | 12.10 |

| TorchScript | ✅ | 36.5 | 0.5782 | 11.01 |

| ONNX | ✅ | 36.3 | 0.5782 | 107.54 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 55.03 |

| TensorRT(FP32) | ✅ | 38.1 | 0.5781 | 6.52 |

| TensorRT(FP16) | ✅ | 21.4 | 0.5803 | 3.65 |

| TensorRT(INT8) | ✅ | 12.1 | 0.5735 | 2.81 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 132.73 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 134.96 |

| TF Lite | ✅ | 36.3 | 0.5782 | 798.21 |

| MNN | ✅ | 36.2 | 0.5777 | 82.35 |

| NCNN | ✅ | 36.2 | 0.5784 | 56.07 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6265 | 22.20 |

| TorchScript | ✅ | 77.3 | 0.6307 | 21.47 |

| ONNX | ✅ | 76.9 | 0.6307 | 270.89 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 129.10 |

| TensorRT(FP32) | ✅ | 78.8 | 0.6306 | 12.53 |

| TensorRT(FP16) | ✅ | 41.9 | 0.6305 | 6.25 |

| TensorRT(INT8) | ✅ | 23.2 | 0.6291 | 4.69 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 299.95 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 310.58 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2400.54 |

| MNN | ✅ | 76.8 | 0.6308 | 213.56 |

| NCNN | ✅ | 76.8 | 0.6284 | 141.18 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 27.70 |

| TorchScript | ✅ | 97.6 | 0.6399 | 27.94 |

| ONNX | ✅ | 97.0 | 0.6409 | 345.47 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 161.93 |

| TensorRT(FP32) | ✅ | 99.1 | 0.6406 | 16.11 |

| TensorRT(FP16) | ✅ | 52.6 | 0.6376 | 8.08 |

| TensorRT(INT8) | ✅ | 30.8 | 0.6208 | 6.12 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 390.78 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 398.76 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3037.05 |

| MNN | ✅ | 96.9 | 0.6372 | 265.46 |

| NCNN | ✅ | 96.9 | 0.6364 | 179.68 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 44.40 |

| TorchScript | ✅ | 218.1 | 0.6898 | 47.49 |

| ONNX | ✅ | 217.5 | 0.6900 | 682.98 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 298.15 |

| TensorRT(FP32) | ✅ | 219.6 | 0.6904 | 28.50 |

| TensorRT(FP16) | ✅ | 112.2 | 0.6887 | 13.55 |

| TensorRT(INT8) | ✅ | 60.0 | 0.6574 | 9.40 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 749.85 |

| TF GraphDef | ✅ | 217.7 | 0.6900 | 753.86 |

| TF Lite | ✅ | 217.6 | 0.6900 | 6603.27 |

| MNN | ✅ | 217.3 | 0.6868 | 519.77 |

| NCNN | ✅ | 217.3 | 0.6849 | 298.58 |

Ultralytics 8.3.157でベンチマークを実施

注

推論時間には、プリ/ポスト処理は含まれていません。

NVIDIA Jetson Orin Nano Super Developer Kit

パフォーマンス

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 13.70 |

| TorchScript | ✅ | 10.5 | 0.5082 | 13.69 |

| ONNX | ✅ | 10.2 | 0.5081 | 14.47 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 56.66 |

| TensorRT(FP32) | ✅ | 12.0 | 0.5081 | 7.44 |

| TensorRT(FP16) | ✅ | 8.2 | 0.5061 | 4.53 |

| TensorRT(INT8) | ✅ | 5.4 | 0.4825 | 3.70 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 116.23 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 114.92 |

| TF Lite | ✅ | 10.3 | 0.5077 | 340.75 |

| MNN | ✅ | 10.1 | 0.5059 | 76.26 |

| NCNN | ✅ | 10.2 | 0.5031 | 45.03 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5790 | 20.90 |

| TorchScript | ✅ | 36.5 | 0.5781 | 21.22 |

| ONNX | ✅ | 36.3 | 0.5781 | 25.07 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 122.98 |

| TensorRT(FP32) | ✅ | 37.9 | 0.5783 | 13.02 |

| TensorRT(FP16) | ✅ | 21.8 | 0.5779 | 6.93 |

| TensorRT(INT8) | ✅ | 12.2 | 0.5735 | 5.08 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 250.65 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 252.69 |

| TF Lite | ✅ | 36.3 | 0.5782 | 998.68 |

| MNN | ✅ | 36.2 | 0.5781 | 188.01 |

| NCNN | ✅ | 36.2 | 0.5784 | 101.37 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6266 | 46.50 |

| TorchScript | ✅ | 77.3 | 0.6307 | 47.95 |

| ONNX | ✅ | 76.9 | 0.6307 | 53.06 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 301.63 |

| TensorRT(FP32) | ✅ | 78.8 | 0.6305 | 27.86 |

| TensorRT(FP16) | ✅ | 41.7 | 0.6309 | 13.50 |

| TensorRT(INT8) | ✅ | 23.2 | 0.6291 | 9.12 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 622.24 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 628.74 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2997.93 |

| MNN | ✅ | 76.8 | 0.6299 | 509.96 |

| NCNN | ✅ | 76.8 | 0.6284 | 292.99 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 56.50 |

| TorchScript | ✅ | 97.6 | 0.6409 | 62.51 |

| ONNX | ✅ | 97.0 | 0.6399 | 68.35 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 376.03 |

| TensorRT(FP32) | ✅ | 99.2 | 0.6396 | 35.59 |

| TensorRT(FP16) | ✅ | 52.1 | 0.6361 | 17.48 |

| TensorRT(INT8) | ✅ | 30.9 | 0.6207 | 11.87 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 807.47 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 822.88 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3792.23 |

| MNN | ✅ | 96.9 | 0.6372 | 631.16 |

| NCNN | ✅ | 96.9 | 0.6364 | 350.46 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 90.00 |

| TorchScript | ✅ | 218.1 | 0.6901 | 113.40 |

| ONNX | ✅ | 217.5 | 0.6901 | 122.94 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 713.1 |

| TensorRT(FP32) | ✅ | 219.5 | 0.6904 | 66.93 |

| TensorRT(FP16) | ✅ | 112.2 | 0.6892 | 32.58 |

| TensorRT(INT8) | ✅ | 61.5 | 0.6612 | 19.90 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 1605.4 |

| TF GraphDef | ✅ | 217.8 | 0.6900 | 2961.8 |

| TF Lite | ✅ | 217.6 | 0.6900 | 8234.86 |

| MNN | ✅ | 217.3 | 0.6893 | 1254.18 |

| NCNN | ✅ | 217.3 | 0.6849 | 725.50 |

Ultralytics 8.3.157でベンチマークを実施

注

推論時間には、プリ/ポスト処理は含まれていません。

NVIDIA Jetson Orin NX 16GB

パフォーマンス

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 5.4 | 0.5101 | 12.90 |

| TorchScript | ✅ | 10.5 | 0.5082 | 13.17 |

| ONNX | ✅ | 10.2 | 0.5081 | 15.43 |

| OpenVINO | ✅ | 10.4 | 0.5058 | 39.80 |

| TensorRT(FP32) | ✅ | 11.8 | 0.5081 | 7.94 |

| TensorRT(FP16) | ✅ | 8.1 | 0.5085 | 4.73 |

| TensorRT(INT8) | ✅ | 5.4 | 0.4786 | 3.90 |

| TF SavedModel | ✅ | 25.9 | 0.5077 | 88.48 |

| TF GraphDef | ✅ | 10.3 | 0.5077 | 86.67 |

| TF Lite | ✅ | 10.3 | 0.5077 | 302.55 |

| MNN | ✅ | 10.1 | 0.5059 | 52.73 |

| NCNN | ✅ | 10.2 | 0.5031 | 32.04 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 18.4 | 0.5790 | 21.70 |

| TorchScript | ✅ | 36.5 | 0.5781 | 22.71 |

| ONNX | ✅ | 36.3 | 0.5781 | 26.49 |

| OpenVINO | ✅ | 36.4 | 0.5810 | 84.73 |

| TensorRT(FP32) | ✅ | 37.8 | 0.5783 | 13.77 |

| TensorRT(FP16) | ✅ | 21.2 | 0.5796 | 7.31 |

| TensorRT(INT8) | ✅ | 12.0 | 0.5735 | 5.33 |

| TF SavedModel | ✅ | 91.0 | 0.5782 | 185.06 |

| TF GraphDef | ✅ | 36.4 | 0.5782 | 186.45 |

| TF Lite | ✅ | 36.3 | 0.5782 | 882.58 |

| MNN | ✅ | 36.2 | 0.5775 | 126.36 |

| NCNN | ✅ | 36.2 | 0.5784 | 66.73 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 38.8 | 0.6266 | 45.00 |

| TorchScript | ✅ | 77.3 | 0.6307 | 51.87 |

| ONNX | ✅ | 76.9 | 0.6307 | 56.00 |

| OpenVINO | ✅ | 77.1 | 0.6284 | 202.69 |

| TensorRT(FP32) | ✅ | 78.7 | 0.6305 | 30.38 |

| TensorRT(FP16) | ✅ | 41.8 | 0.6302 | 14.48 |

| TensorRT(INT8) | ✅ | 23.2 | 0.6291 | 9.74 |

| TF SavedModel | ✅ | 192.7 | 0.6307 | 445.58 |

| TF GraphDef | ✅ | 77.1 | 0.6307 | 460.94 |

| TF Lite | ✅ | 77.0 | 0.6307 | 2653.65 |

| MNN | ✅ | 76.8 | 0.6308 | 339.38 |

| NCNN | ✅ | 76.8 | 0.6284 | 187.64 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 49.0 | 0.6364 | 56.60 |

| TorchScript | ✅ | 97.6 | 0.6409 | 66.72 |

| ONNX | ✅ | 97.0 | 0.6399 | 71.92 |

| OpenVINO | ✅ | 97.3 | 0.6378 | 254.17 |

| TensorRT(FP32) | ✅ | 99.2 | 0.6406 | 38.89 |

| TensorRT(FP16) | ✅ | 51.9 | 0.6363 | 18.59 |

| TensorRT(INT8) | ✅ | 30.9 | 0.6207 | 12.60 |

| TF SavedModel | ✅ | 243.1 | 0.6409 | 575.98 |

| TF GraphDef | ✅ | 97.2 | 0.6409 | 583.79 |

| TF Lite | ✅ | 97.1 | 0.6409 | 3353.41 |

| MNN | ✅ | 96.9 | 0.6367 | 421.33 |

| NCNN | ✅ | 96.9 | 0.6364 | 228.26 |

| 形式 | ステータス | ディスク上のサイズ(MB) | mAP50-95(B) | 推論時間 (ms/im) |

|---|---|---|---|---|

| PyTorch | ✅ | 109.3 | 0.7005 | 98.50 |

| TorchScript | ✅ | 218.1 | 0.6901 | 123.03 |

| ONNX | ✅ | 217.5 | 0.6901 | 129.55 |

| OpenVINO | ✅ | 217.8 | 0.6876 | 483.44 |

| TensorRT(FP32) | ✅ | 219.6 | 0.6904 | 75.92 |

| TensorRT(FP16) | ✅ | 112.1 | 0.6885 | 35.78 |

| TensorRT(INT8) | ✅ | 61.6 | 0.6592 | 21.60 |

| TF SavedModel | ✅ | 544.3 | 0.6900 | 1120.43 |

| TF GraphDef | ✅ | 217.7 | 0.6900 | 1172.35 |

| TF Lite | ✅ | 217.6 | 0.6900 | 7283.63 |

| MNN | ✅ | 217.3 | 0.6877 | 840.16 |

| NCNN | ✅ | 217.3 | 0.6849 | 474.41 |

Ultralytics 8.3.157でベンチマークを実施

注

推論時間には、プリ/ポスト処理は含まれていません。

Seeed Studioによるベンチマークの取り組みの詳細はこちらをご覧ください。さまざまなバージョンのNVIDIA Jetsonハードウェアで実行されています。

結果の再現

上記Ultralyticsのベンチマークをすべてのエクスポート形式で再現するには、次のコードを実行します:

例

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml", imgsz=640)

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml imgsz=640

なお、ベンチマーク結果は、システムの正確なハードウェアおよびソフトウェア構成、ならびにベンチマーク実行時のシステムの現在のワークロードによって異なる場合があります。最も信頼性の高い結果を得るには、多数の画像を含むデータセットを使用してください (例: )。 data='coco.yaml' (5000の検証画像)。

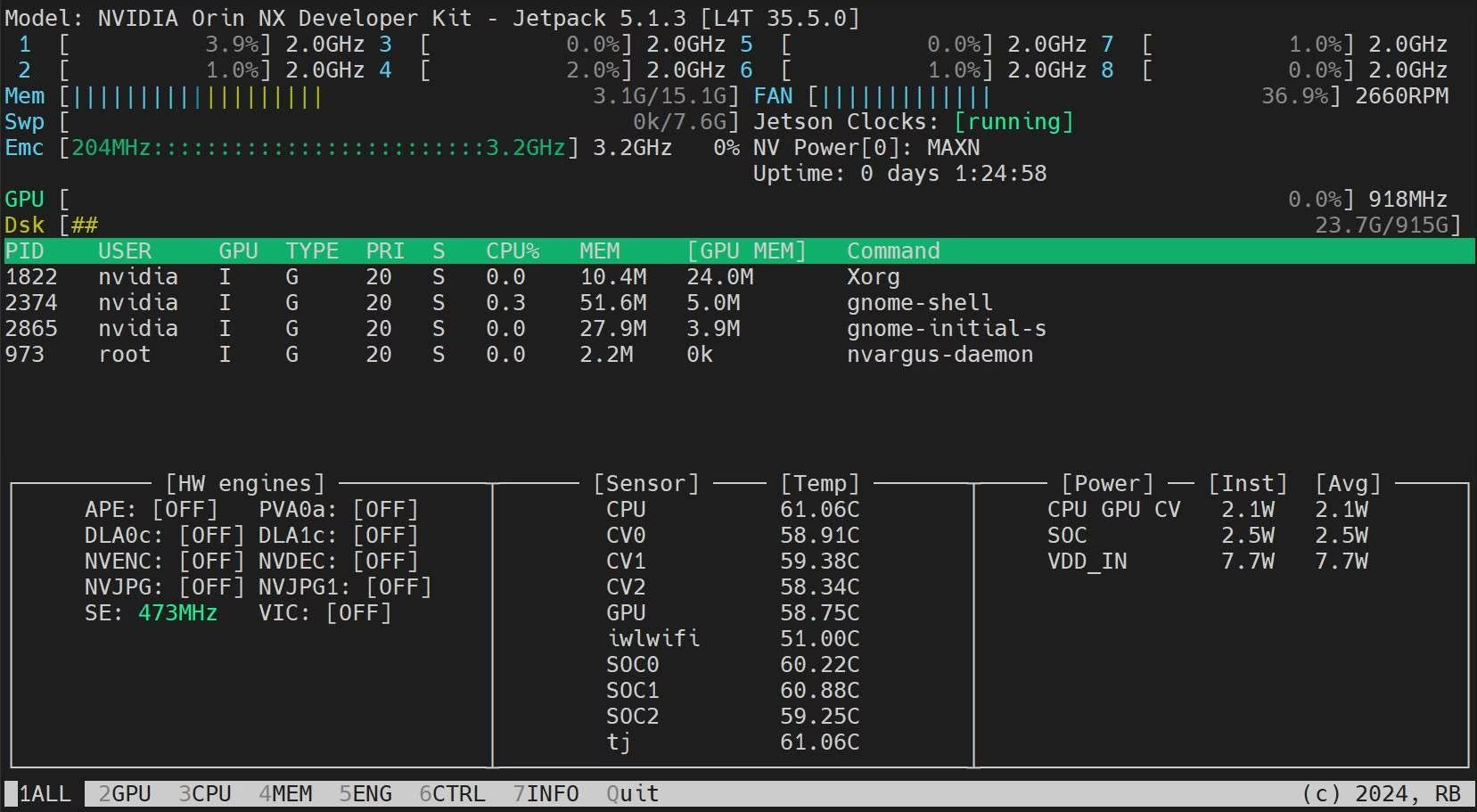

NVIDIA Jetson 使用時のベストプラクティス

NVIDIA Jetsonを使用する際、YOLO26を実行しているNVIDIA Jetsonで最大限のパフォーマンスを有効にするために、いくつかのベストプラクティスに従う必要があります。

最大電力モードを有効にする

Jetsonで最大電力モードを有効にすると、すべてのCPU、GPUコアがオンになります。

sudo nvpmodel -m 0Jetsonクロックを有効にする

Jetsonクロックを有効にすると、すべてのCPU、GPUコアが最大周波数でクロックされるようになります。

sudo jetson_clocksJetson Statsアプリケーションのインストール

jetson statsアプリケーションを使用して、システムコンポーネントの温度を監視し、CPU、GPU、RAMの使用率の表示、電力モードの変更、最大クロックの設定、JetPack情報などの他のシステム詳細を確認できます。

sudo apt update sudo pip install jetson-stats sudo reboot jtop

次のステップ

さらなる学習とサポートについては、Ultralytics YOLO26 ドキュメントを参照してください。

よくある質問

NVIDIA Jetson デバイスにUltralytics YOLO26をデプロイするにはどうすればよいですか?

NVIDIA Jetson デバイスへのUltralytics YOLO26のデプロイは、簡単なプロセスです。まず、NVIDIA JetPack SDKを使用してJetsonデバイスをフラッシュします。次に、迅速なセットアップのためにビルド済みのDockerイメージを使用するか、必要なパッケージを手動でインストールします。各アプローチの詳細な手順は、Dockerによるクイックスタートおよびネイティブインストールによる開始のセクションで確認できます。

NVIDIA Jetson デバイス上の YOLO11 モデルから、どのような性能ベンチマークが期待できますか?

YOLO11モデルは、さまざまなNVIDIA Jetsonデバイスでベンチマークされており、大幅な性能向上が示されています。例えば、TensorRT形式は最高の推論性能を提供します。詳細比較表セクションの表は、mAP50-95や推論時間など、異なるモデル形式間の性能指標を包括的に示しています。

NVIDIA JetsonでYOLO26をデプロイする際にTensorRTを使用すべき理由は何ですか?

TensorRTは、その最適なパフォーマンスにより、NVIDIA JetsonにYOLO26モデルをデプロイする際に強く推奨されます。JetsonのGPU機能を活用して推論を高速化し、最大の効率と速度を保証します。TensorRTへの変換方法と推論の実行方法については、NVIDIA JetsonでTensorRTを使用するセクションで詳しく説明しています。

NVIDIA JetsonにPyTorchとTorchvisionをインストールするにはどうすればよいですか?

NVIDIA JetsonにPyTorchとTorchvisionをインストールするには、まずpipでインストールされている既存のバージョンをアンインストールします。次に、JetsonのARM64アーキテクチャと互換性のあるPyTorchおよびTorchvisionバージョンを手動でインストールします。このプロセスの詳細な手順は、PyTorchとTorchvisionのインストールセクションに記載されています。

YOLO26を使用する際にNVIDIA Jetsonでパフォーマンスを最大化するための最適なプラクティスは何ですか?

YOLO26でNVIDIA Jetsonのパフォーマンスを最大化するには、以下のベストプラクティスに従ってください。

- 最大電力モードを有効にして、すべてのCPUおよびGPUコアを利用します。

- Jetsonクロックを有効にして、すべてのコアを最大周波数で実行します。

- システムメトリクスを監視するために、Jetson Statsアプリケーションをインストールします。

コマンドと詳細については、NVIDIA Jetson使用時のベストプラクティスセクションを参照してください。