Inferência Thread-Safe com Modelos YOLO

Executar modelos YOLO em um ambiente multithread requer consideração cuidadosa para garantir a segurança do thread. Python threading O módulo permite que você execute vários threads simultaneamente, mas quando se trata de usar modelos YOLO nesses threads, há importantes questões de segurança a serem observadas. Esta página irá guiá-lo através da criação de inferência de modelo YOLO thread-safe.

Assista: Como Realizar Inferência Thread Safe com Modelos Ultralytics YOLO em Python | Multi-Threading 🚀

Entendendo Threading em Python

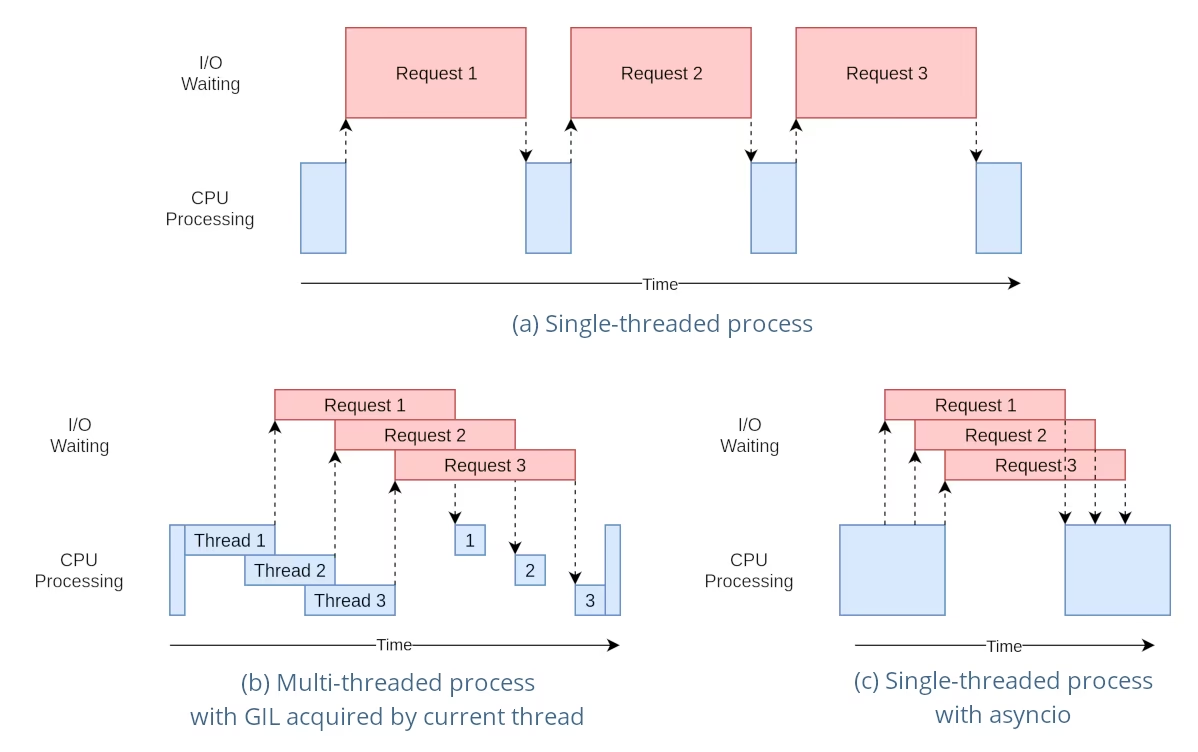

As threads Python são uma forma de paralelismo que permite que o seu programa execute várias operações ao mesmo tempo. No entanto, o Global Interpreter Lock (GIL) do Python significa que apenas uma thread pode executar bytecode Python de cada vez.

Embora isso possa parecer uma limitação, as threads ainda podem fornecer concorrência, especialmente para operações vinculadas a E/S ou ao usar operações que liberam o GIL, como as realizadas pelas bibliotecas C subjacentes do YOLO.

O Perigo de Instâncias de Modelo Compartilhadas

Instanciar um modelo YOLO fora de suas threads e compartilhar essa instância entre várias threads pode levar a condições de corrida, onde o estado interno do modelo é modificado de forma inconsistente devido a acessos simultâneos. Isso é particularmente problemático quando o modelo ou seus componentes mantêm um estado que não foi projetado para ser thread-safe.

Exemplo Não Thread-Safe: Instância de Modelo Único

Ao usar threads em Python, é importante reconhecer padrões que podem levar a problemas de concorrência. Aqui está o que você deve evitar: compartilhar uma única instância de modelo YOLO entre vários threads.

# Unsafe: Sharing a single model instance across threads

from threading import Thread

from ultralytics import YOLO

# Instantiate the model outside the thread

shared_model = YOLO("yolo26n.pt")

def predict(image_path):

"""Predicts objects in an image using a preloaded YOLO model, take path string to image as argument."""

results = shared_model.predict(image_path)

# Process results

# Starting threads that share the same model instance

Thread(target=predict, args=("image1.jpg",)).start()

Thread(target=predict, args=("image2.jpg",)).start()

No exemplo acima, o shared_model é usado por várias threads, o que pode levar a resultados imprevisíveis porque predict poderiam ser executados simultaneamente por múltiplas threads.

Exemplo Não Thread-Safe: Várias Instâncias de Modelo

Da mesma forma, aqui está um padrão inseguro com múltiplas instâncias de modelo YOLO:

# Unsafe: Sharing multiple model instances across threads can still lead to issues

from threading import Thread

from ultralytics import YOLO

# Instantiate multiple models outside the thread

shared_model_1 = YOLO("yolo26n_1.pt")

shared_model_2 = YOLO("yolo26n_2.pt")

def predict(model, image_path):

"""Runs prediction on an image using a specified YOLO model, returning the results."""

results = model.predict(image_path)

# Process results

# Starting threads with individual model instances

Thread(target=predict, args=(shared_model_1, "image1.jpg")).start()

Thread(target=predict, args=(shared_model_2, "image2.jpg")).start()

Mesmo que existam duas instâncias de modelo separadas, o risco de problemas de concorrência ainda existe. Se a implementação interna de YOLO não é thread-safe; usar instâncias separadas pode não impedir condições de corrida, especialmente se essas instâncias compartilharem quaisquer recursos ou estados subjacentes que não sejam thread-local.

Inferência Thread-Safe

Para realizar a inferência thread-safe, você deve instanciar um modelo YOLO separado dentro de cada thread. Isso garante que cada thread tenha sua própria instância de modelo isolada, eliminando o risco de condições de corrida.

Exemplo Thread-Safe

Veja como instanciar um modelo YOLO dentro de cada thread para inferência paralela segura:

# Safe: Instantiating a single model inside each thread

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image using a new YOLO model instance in a thread-safe manner; takes image path as input."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

# Starting threads that each have their own model instance

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Neste exemplo, cada thread cria seu próprio YOLO instância. Isso impede que qualquer thread interfira no estado do modelo de outro, garantindo assim que cada thread execute a inferência de forma segura e sem interações inesperadas com os outros threads.

Usando o Decorador ThreadingLocked

A Ultralytics fornece um ThreadingLocked decorador que pode ser usado para garantir a execução thread-safe de funções. Este decorador usa um bloqueio para garantir que apenas um thread por vez possa executar a função decorada.

from ultralytics import YOLO

from ultralytics.utils import ThreadingLocked

# Create a model instance

model = YOLO("yolo26n.pt")

# Decorate the predict method to make it thread-safe

@ThreadingLocked()

def thread_safe_predict(image_path):

"""Thread-safe prediction using a shared model instance."""

results = model.predict(image_path)

return results

# Now you can safely call this function from multiple threads

O ThreadingLocked O decorador é particularmente útil quando você precisa compartilhar uma instância de modelo entre threads, mas deseja garantir que apenas um thread possa acessá-la por vez. Essa abordagem pode economizar memória em comparação com a criação de uma nova instância de modelo para cada thread, mas pode reduzir a concorrência, pois os threads precisarão esperar que o bloqueio seja liberado.

Conclusão

Ao usar modelos YOLO com Python's threading, sempre instancie seus modelos dentro da thread que os utilizará para garantir a segurança da thread. Essa prática evita condições de corrida e garante que suas tarefas de inferência sejam executadas de forma confiável.

Para cenários mais avançados e para otimizar ainda mais o desempenho da sua inferência multi-threaded, considere usar o paralelismo baseado em processos com multiprocessing ou aproveitar uma fila de tarefas com processos de trabalho dedicados.

FAQ

Como posso evitar condições de corrida ao usar modelos YOLO em um ambiente Python multi-threaded?

Para evitar condições de corrida ao usar modelos Ultralytics YOLO em um ambiente Python multi-threaded, instancie um modelo YOLO separado dentro de cada thread. Isso garante que cada thread tenha sua própria instância de modelo isolada, evitando a modificação simultânea do estado do modelo.

Exemplo:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Predict on an image in a thread-safe manner."""

local_model = YOLO("yolo26n.pt")

results = local_model.predict(image_path)

# Process results

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Para obter mais informações sobre como garantir a segurança de threads, visite a página Inferência Thread-Safe com Modelos YOLO.

Quais são as melhores práticas para executar a inferência de modelo YOLO multi-threaded em Python?

Para executar a inferência do modelo YOLO multi-threaded com segurança em Python, siga estas práticas recomendadas:

- Instancie modelos YOLO dentro de cada thread, em vez de compartilhar uma única instância de modelo entre threads.

- Use o Python

multiprocessingmódulo para processamento paralelo para evitar problemas relacionados ao Global Interpreter Lock (GIL). - Libere o GIL usando operações realizadas pelas bibliotecas C subjacentes do YOLO.

- Considere usar o

ThreadingLockeddecorador para instâncias de modelo compartilhadas quando a memória é uma preocupação.

Exemplo para instanciação de modelo thread-safe:

from threading import Thread

from ultralytics import YOLO

def thread_safe_predict(image_path):

"""Runs inference in a thread-safe manner with a new YOLO model instance."""

model = YOLO("yolo26n.pt")

results = model.predict(image_path)

# Process results

# Initiate multiple threads

Thread(target=thread_safe_predict, args=("image1.jpg",)).start()

Thread(target=thread_safe_predict, args=("image2.jpg",)).start()

Para contexto adicional, consulte a seção sobre Inferência Thread-Safe.

Por que cada thread deve ter sua própria instância de modelo YOLO?

Cada thread deve ter sua própria instância de modelo YOLO para evitar condições de corrida. Quando uma única instância de modelo é compartilhada entre várias threads, acessos simultâneos podem levar a comportamentos imprevisíveis e modificações do estado interno do modelo. Ao usar instâncias separadas, você garante o isolamento de threads, tornando suas tarefas multi-threaded confiáveis e seguras.

Para obter orientação detalhada, consulte as seções Exemplo Não Thread-Safe: Instância de Modelo Único e Exemplo Thread-Safe.

Como o Global Interpreter Lock (GIL) do Python afeta a inferência do modelo YOLO?

O Global Interpreter Lock (GIL) do Python permite que apenas uma thread execute bytecode Python por vez, o que pode limitar o desempenho de tarefas multi-threading vinculadas à CPU. No entanto, para operações vinculadas a I/O ou processos que usam bibliotecas que liberam o GIL, como as bibliotecas C subjacentes do YOLO, você ainda pode obter concorrência. Para um desempenho aprimorado, considere usar o paralelismo baseado em processo com o multiprocessing módulo.

Para mais informações sobre threading em Python, consulte a seção Entendendo Python Threading.

É mais seguro usar paralelismo baseado em processos em vez de threading para a inferência do modelo YOLO?

Sim, usando o Python multiprocessing O módulo é mais seguro e geralmente mais eficiente para executar a inferência do modelo YOLO em paralelo. O paralelismo baseado em processos cria espaços de memória separados, evitando o Global Interpreter Lock (GIL) e reduzindo o risco de problemas de concorrência. Cada processo operará independentemente com sua própria instância do modelo YOLO.

Para obter mais detalhes sobre o paralelismo baseado em processos com modelos YOLO, consulte a página sobre Inferência Thread-Safe.