Cắt tỉa Mô hình và Độ thưa trong YOLOv5

📚 Hướng dẫn này giải thích cách áp dụng tỉa bớt cho các mô hình YOLOv5 🚀 để tạo ra các mạng hiệu quả hơn trong khi vẫn duy trì hiệu suất.

Tỉa thưa mô hình (Model Pruning) là gì?

Tỉa mô hình (Model pruning) là một kỹ thuật được sử dụng để giảm kích thước và độ phức tạp của mạng nơ-ron bằng cách loại bỏ các tham số (trọng số và kết nối) ít quan trọng hơn. Quá trình này tạo ra một mô hình hiệu quả hơn với một số lợi ích:

- Giảm kích thước mô hình để dễ dàng triển khai trên các thiết bị hạn chế về tài nguyên

- Tốc độ suy luận nhanh hơn với tác động tối thiểu đến độ chính xác

- Giảm mức sử dụng bộ nhớ và tiêu thụ năng lượng

- Cải thiện hiệu quả tổng thể cho các ứng dụng thời gian thực

Việc tỉa bớt (Pruning) hoạt động bằng cách xác định và loại bỏ các tham số đóng góp tối thiểu vào hiệu suất của mô hình, giúp tạo ra một mô hình nhẹ hơn với độ chính xác tương đương.

Trước Khi Bắt Đầu

Sao chép kho lưu trữ và cài đặt requirements.txt trong môi trường Python>=3.8.0, bao gồm PyTorch>=1.8. Mô hình và bộ dữ liệu được tải xuống tự động từ phiên bản phát hành YOLOv5 mới nhất.

git clone https://github.com/ultralytics/yolov5 # clone

cd yolov5

pip install -r requirements.txt # install

Kiểm tra hiệu suất cơ bản

Trước khi cắt tỉa, hãy thiết lập hiệu suất cơ sở để so sánh. Lệnh này kiểm tra YOLOv5x trên COCO val2017 với kích thước hình ảnh 640 pixel. yolov5x.pt là mô hình lớn nhất và chính xác nhất hiện có. Các tùy chọn khác là yolov5s.pt, yolov5m.pt và yolov5l.pt, hoặc checkpoint của riêng bạn từ việc huấn luyện một bộ dữ liệu tùy chỉnh ./weights/best.pt. Để biết chi tiết về tất cả các mô hình có sẵn, hãy xem README bảng.

python val.py --weights yolov5x.pt --data coco.yaml --img 640 --half

Đầu ra:

val: data=/content/yolov5/data/coco.yaml, weights=['yolov5x.pt'], batch_size=32, imgsz=640, conf_thres=0.001, iou_thres=0.65, task=val, device=, workers=8, single_cls=False, augment=False, verbose=False, save_txt=False, save_conf=False, save_json=True, project=runs/val, name=exp, exist_ok=False, half=True, dnn=False

YOLOv5 🚀 v6.0-224-g4c40933 torch 1.10.0+cu111 CUDA:0 (Tesla V100-SXM2-16GB, 16160MiB)

Fusing layers...

Model Summary: 444 layers, 86705005 parameters, 0 gradients

val: Scanning '/content/datasets/coco/val2017.cache' images and labels... 4952 found, 48 missing, 0 empty, 0 corrupt: 100% 5000/5000 [00:00<?, ?it/s]

Class Images Labels P R mAP@.5 mAP@.5:.95: 100% 157/157 [01:12<00:00, 2.16it/s]

all 5000 36335 0.732 0.628 0.683 0.496

Speed: 0.1ms pre-process, 5.2ms inference, 1.7ms NMS per image at shape (32, 3, 640, 640) # <--- base speed

Evaluating pycocotools mAP... saving runs/val/exp2/yolov5x_predictions.json...

...

Average Precision (AP) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.507 # <--- base mAP

Average Precision (AP) @[ IoU=0.50 | area= all | maxDets=100 ] = 0.689

Average Precision (AP) @[ IoU=0.75 | area= all | maxDets=100 ] = 0.552

Average Precision (AP) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.345

Average Precision (AP) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.559

Average Precision (AP) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.652

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 1 ] = 0.381

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 10 ] = 0.630

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.682

Average Recall (AR) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.526

Average Recall (AR) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.731

Average Recall (AR) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.829

Results saved to runs/val/exp

Áp dụng tỉa thưa cho YOLOv5x (Độ thưa 30%)

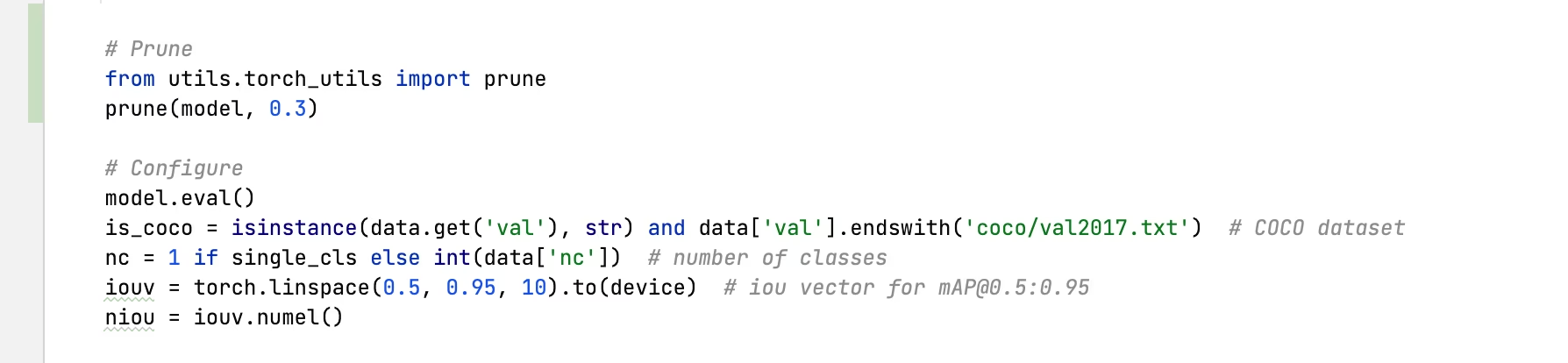

Chúng ta có thể áp dụng tỉa bớt cho mô hình bằng cách sử dụng torch_utils.prune() lệnh được định nghĩa trong utils/torch_utils.py. Để kiểm tra một mô hình được cắt tỉa, chúng tôi cập nhật val.py để tỉa thưa YOLOv5x đến độ thưa 0,3 (30% trọng số được đặt thành không):

Đầu ra sau tỉa thưa 30%:

val: data=/content/yolov5/data/coco.yaml, weights=['yolov5x.pt'], batch_size=32, imgsz=640, conf_thres=0.001, iou_thres=0.65, task=val, device=, workers=8, single_cls=False, augment=False, verbose=False, save_txt=False, save_conf=False, save_json=True, project=runs/val, name=exp, exist_ok=False, half=True, dnn=False

YOLOv5 🚀 v6.0-224-g4c40933 torch 1.10.0+cu111 CUDA:0 (Tesla V100-SXM2-16GB, 16160MiB)

Fusing layers...

Model Summary: 444 layers, 86705005 parameters, 0 gradients

Pruning model... 0.3 global sparsity

val: Scanning '/content/datasets/coco/val2017.cache' images and labels... 4952 found, 48 missing, 0 empty, 0 corrupt: 100% 5000/5000 [00:00<?, ?it/s]

Class Images Labels P R mAP@.5 mAP@.5:.95: 100% 157/157 [01:11<00:00, 2.19it/s]

all 5000 36335 0.724 0.614 0.671 0.478

Speed: 0.1ms pre-process, 5.2ms inference, 1.7ms NMS per image at shape (32, 3, 640, 640) # <--- prune speed

Evaluating pycocotools mAP... saving runs/val/exp3/yolov5x_predictions.json...

...

Average Precision (AP) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.489 # <--- prune mAP

Average Precision (AP) @[ IoU=0.50 | area= all | maxDets=100 ] = 0.677

Average Precision (AP) @[ IoU=0.75 | area= all | maxDets=100 ] = 0.537

Average Precision (AP) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.334

Average Precision (AP) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.542

Average Precision (AP) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.635

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 1 ] = 0.370

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets= 10 ] = 0.612

Average Recall (AR) @[ IoU=0.50:0.95 | area= all | maxDets=100 ] = 0.664

Average Recall (AR) @[ IoU=0.50:0.95 | area= small | maxDets=100 ] = 0.496

Average Recall (AR) @[ IoU=0.50:0.95 | area=medium | maxDets=100 ] = 0.722

Average Recall (AR) @[ IoU=0.50:0.95 | area= large | maxDets=100 ] = 0.803

Results saved to runs/val/exp3

Phân tích kết quả

Từ kết quả, chúng ta có thể thấy:

- Đạt được độ thưa 30%: 30% các tham số trọng số của mô hình trong

nn.Conv2dcác lớp hiện tại bằng không - Thời gian suy luận không đổi: Mặc dù đã cắt tỉa, tốc độ xử lý về cơ bản vẫn giống nhau

- Tác động hiệu suất tối thiểu: mAP giảm nhẹ từ 0.507 xuống 0.489 (chỉ giảm 3.6%)

- Giảm kích thước mô hình: Mô hình đã tỉa thưa yêu cầu ít bộ nhớ hơn để lưu trữ

Điều này chứng minh rằng việc tỉa bớt có thể giảm đáng kể độ phức tạp của mô hình mà chỉ ảnh hưởng nhỏ đến hiệu suất, khiến nó trở thành một kỹ thuật tối ưu hóa hiệu quả để triển khai trong các môi trường bị hạn chế về tài nguyên.

Tinh chỉnh các Mô hình đã Tỉa bớt

Để có kết quả tốt nhất, các mô hình đã tỉa nên được tinh chỉnh sau khi tỉa để phục hồi độ chính xác. Điều này có thể được thực hiện bằng cách:

- Áp dụng tỉa thưa với mức độ thưa mong muốn

- Huấn luyện mô hình đã được tỉa bớt trong một vài epoch với tốc độ học thấp hơn

- Đánh giá mô hình đã tỉa thưa được tinh chỉnh so với đường cơ sở

Quy trình này giúp các tham số còn lại thích ứng để bù đắp cho các kết nối đã bị loại bỏ, thường khôi phục hầu hết hoặc toàn bộ độ chính xác ban đầu.

Môi trường được hỗ trợ

Ultralytics cung cấp một loạt các môi trường sẵn sàng sử dụng, mỗi môi trường được cài đặt sẵn các phần phụ thuộc thiết yếu như CUDA, CUDNN, Python và PyTorch, để khởi động các dự án của bạn.

- Sổ tay GPU miễn phí:

- Google Cloud: Hướng dẫn Bắt đầu Nhanh GCP

- Amazon: Hướng dẫn Bắt đầu Nhanh AWS

- Azure: Hướng dẫn Bắt đầu Nhanh AzureML

- Docker: Hướng dẫn Bắt đầu Nhanh Docker

Trạng thái dự án

Huy hiệu này cho biết rằng tất cả các thử nghiệm Tích hợp Liên tục (CI) YOLOv5 GitHub Actions đều vượt qua thành công. Các thử nghiệm CI này kiểm tra nghiêm ngặt chức năng và hiệu suất của YOLOv5 trên nhiều khía cạnh chính: huấn luyện, xác thực, suy luận, xuất và điểm chuẩn. Chúng đảm bảo hoạt động nhất quán và đáng tin cậy trên macOS, Windows và Ubuntu, với các thử nghiệm được thực hiện sau mỗi 24 giờ và sau mỗi cam kết mới.