Caltech-101 Datensatz

Der Caltech-101-Datensatz ist ein weit verbreiteter Datensatz für Objekterkennungsaufgaben, der etwa 9.000 Bilder aus 101 Objektkategorien enthält. Die Kategorien wurden so gewählt, dass sie eine Vielzahl von realen Objekten widerspiegeln, und die Bilder selbst wurden sorgfältig ausgewählt und annotiert, um einen anspruchsvollen Benchmark für Objekterkennungsalgorithmen zu bieten.

Ansehen: Trainingsanleitung Bildklassifizierung Modellnutzung des Caltech-256-Datensatzes mit Ultralytics Platform

Automatische Datenaufteilung

Der Caltech-101-Datensatz wird, wie bereitgestellt, nicht mit vordefinierten Trainings-/Validierungsaufteilungen geliefert. Wenn Sie jedoch die in den folgenden Anwendungsbeispielen bereitgestellten Trainingsbefehle verwenden, teilt das Ultralytics-Framework den Datensatz automatisch für Sie auf. Die standardmäßig verwendete Aufteilung beträgt 80 % für den Trainingssatz und 20 % für den Validierungssatz.

Hauptmerkmale

- Der Caltech-101-Datensatz umfasst etwa 9.000 Farbbilder, die in 101 Kategorien unterteilt sind.

- Die Kategorien umfassen eine Vielzahl von Objekten, darunter Tiere, Fahrzeuge, Haushaltsgegenstände und Menschen.

- Die Anzahl der Bilder pro Kategorie variiert, wobei es etwa 40 bis 800 Bilder in jeder Kategorie gibt.

- Die Bilder haben unterschiedliche Größen, wobei die meisten Bilder eine mittlere Auflösung aufweisen.

- Caltech-101 wird häufig für das Training und Testen im Bereich des maschinellen Lernens verwendet, insbesondere für Objekterkennungsaufgaben.

Dataset-Struktur

Im Gegensatz zu vielen anderen Datensätzen ist der Caltech-101-Datensatz nicht formal in Trainings- und Testdatensätze aufgeteilt. Die Benutzer erstellen ihre eigenen Aufteilungen in der Regel auf der Grundlage ihrer spezifischen Bedürfnisse. Eine gängige Praxis ist jedoch die Verwendung einer zufälligen Teilmenge von Bildern für das Training (z. B. 30 Bilder pro Kategorie) und der restlichen Bilder für das Testen.

Anwendungen

Der Caltech-101-Datensatz wird häufig zum Trainieren und Evaluieren von Deep Learning-Modellen bei Objekterkennungsaufgaben verwendet, wie z. B. Convolutional Neural Networks (CNNs), Support Vector Machines (SVMs) und verschiedene andere Algorithmen für maschinelles Lernen. Seine große Vielfalt an Kategorien und hochwertigen Bildern machen ihn zu einem ausgezeichneten Datensatz für Forschung und Entwicklung auf dem Gebiet des maschinellen Lernens und der Computer Vision.

Nutzung

Um ein YOLO-Modell auf dem Caltech-101-Datensatz für 100 Epochen zu trainieren, können Sie die folgenden Code-Snippets verwenden. Eine umfassende Liste der verfügbaren Argumente finden Sie auf der Trainings-Seite des Modells.

Trainingsbeispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-cls.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="caltech101", epochs=100, imgsz=416)

# Start training from a pretrained *.pt model

yolo classify train data=caltech101 model=yolo26n-cls.pt epochs=100 imgsz=416

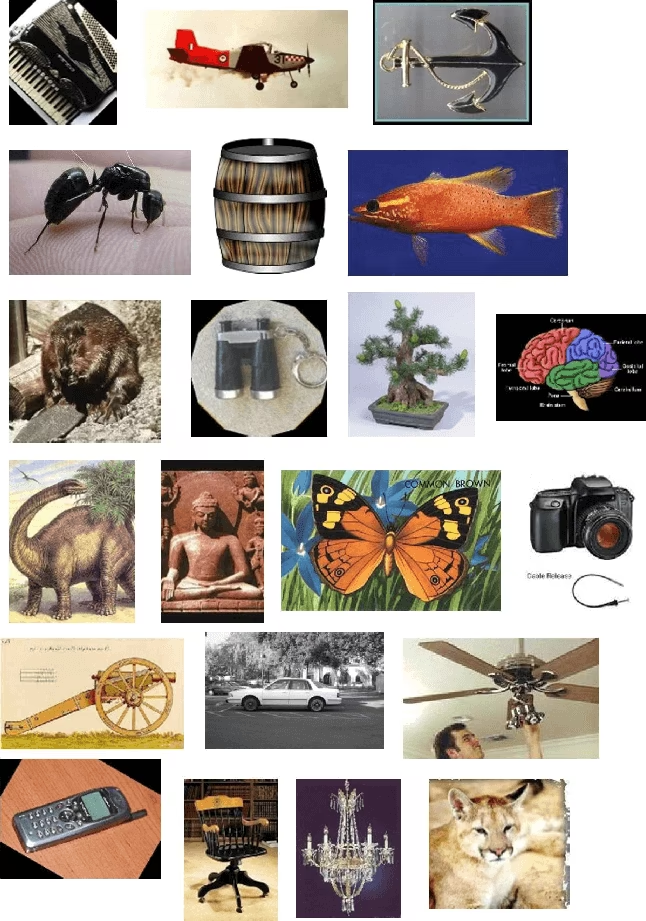

sample_images und Anmerkungen

Der Caltech-101-Datensatz enthält hochwertige Farbbilder verschiedener Objekte und bietet einen gut strukturierten Datensatz für Bildklassifizierungsaufgaben. Hier sind einige Beispiele für Bilder aus dem Datensatz:

Das Beispiel veranschaulicht die Vielfalt und Komplexität der Objekte im Caltech-101-Datensatz und unterstreicht die Bedeutung eines vielfältigen Datensatzes für das Training robuster Objekterkennungsmodelle.

Zitate und Danksagungen

Wenn Sie den Caltech-101-Datensatz in Ihrer Forschungs- oder Entwicklungsarbeit verwenden, zitieren Sie bitte das folgende Paper:

@article{fei2007learning,

title={Learning generative visual models from few training examples: An incremental Bayesian approach tested on 101 object categories},

author={Fei-Fei, Li and Fergus, Rob and Perona, Pietro},

journal={Computer vision and Image understanding},

volume={106},

number={1},

pages={59--70},

year={2007},

publisher={Elsevier}

}

Wir möchten Li Fei-Fei, Rob Fergus und Pietro Perona für die Erstellung und Pflege des Caltech-101-Datensatzes als wertvolle Ressource für die Forschungs-Community in den Bereichen maschinelles Lernen und Computer Vision danken. Weitere Informationen über den Caltech-101-Datensatz und seine Urheber finden Sie auf der Caltech-101-Datensatz-Website.

FAQ

Wofür wird der Caltech-101-Datensatz im maschinellen Lernen verwendet?

Der Datensatz Caltech-101 wird im maschinellen Lernen häufig für Objekterkennungsaufgaben verwendet. Er enthält rund 9.000 Bilder in 101 Kategorien und bietet einen anspruchsvollen Benchmark für die Bewertung von Objekterkennungsalgorithmen. Forscher nutzen ihn, um Modelle zu trainieren und zu testen, insbesondere Convolutional Neural Networks (CNNs) und Support Vector Machines (SVMs), im Bereich Computer Vision.

Wie kann ich ein Ultralytics YOLO-Modell mit dem Caltech-101-Datensatz trainieren?

Um ein Ultralytics YOLO-Modell auf dem Caltech-101-Datensatz zu trainieren, können Sie die bereitgestellten Code-Snippets verwenden. Zum Beispiel, um für 100 Epochen zu trainieren:

Trainingsbeispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-cls.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="caltech101", epochs=100, imgsz=416)

# Start training from a pretrained *.pt model

yolo classify train data=caltech101 model=yolo26n-cls.pt epochs=100 imgsz=416

Weitere detaillierte Argumente und Optionen finden Sie auf der Seite Training des Modells.

Was sind die wichtigsten Merkmale des Caltech-101-Datensatzes?

Der Caltech-101 Datensatz beinhaltet:

- Etwa 9.000 Farbbilder aus 101 Kategorien.

- Kategorien, die eine vielfältige Auswahl an Objekten abdecken, darunter Tiere, Fahrzeuge und Haushaltsgegenstände.

- Variable Anzahl von Bildern pro Kategorie, typischerweise zwischen 40 und 800.

- Variable Bildgrößen, wobei die meisten eine mittlere Auflösung haben.

Diese Eigenschaften machen es zu einer ausgezeichneten Wahl für das Trainieren und Evaluieren von Objekterkennungsmodellen im Bereich des maschinellen Lernens und der Computer Vision.

Warum sollte ich den Caltech-101-Datensatz in meiner Forschung zitieren?

Das Zitieren des Caltech-101-Datensatzes in Ihrer Forschung würdigt die Beiträge der Urheber und bietet eine Referenz für andere, die den Datensatz verwenden könnten. Die empfohlene Zitierweise ist:

@article{fei2007learning,

title={Learning generative visual models from few training examples: An incremental Bayesian approach tested on 101 object categories},

author={Fei-Fei, Li and Fergus, Rob and Perona, Pietro},

journal={Computer vision and Image understanding},

volume={106},

number={1},

pages={59--70},

year={2007},

publisher={Elsevier}

}

Das Zitieren trägt zur Wahrung der Integrität wissenschaftlicher Arbeit bei und hilft Kollegen, die ursprüngliche Quelle zu finden.

Kann ich die Ultralytics Platform für das Training von Modellen auf dem Caltech-101-Datensatz verwenden?

Ja, Sie können die Ultralytics Platform für das Training von Modellen auf dem Caltech-101-Datensatz verwenden. Die Ultralytics Platform bietet eine intuitive Plattform zur Verwaltung von Datensätzen, zum Training von Modellen und zu deren Bereitstellung ohne umfangreiche Programmierung. Eine detaillierte Anleitung finden Sie im Blogbeitrag „how to train your custom models with Ultralytics Platform“.