Tipps für beste YOLOv5 Trainingsergebnisse

📚 Dieser Leitfaden erklärt, wie Sie mit YOLOv5 🚀 die besten mAP- und Trainingsergebnisse erzielen.

Meistens lassen sich gute Ergebnisse erzielen, ohne Änderungen an den Modellen oder Trainingseinstellungen vorzunehmen, vorausgesetzt, Ihr Datensatz ist ausreichend groß und gut beschriftet. Sollten Sie zunächst keine guten Ergebnisse erzielen, gibt es Schritte, die Sie zur Verbesserung unternehmen können, aber wir empfehlen Benutzern immer, zuerst mit allen Standardeinstellungen zu trainieren, bevor sie Änderungen in Betracht ziehen. Dies hilft, eine Leistungs-Baseline zu etablieren und Bereiche für Verbesserungen zu identifizieren.

Wenn Sie Fragen zu Ihren Trainingsergebnissen haben Wir empfehlen Ihnen, so viele Informationen wie möglich anzugeben. wenn Sie eine hilfreiche Antwort erwarten, einschließlich Ergebnisplots (Trainingsverluste, Validierungsverluste, P, R, mAP), PR-Kurve, Konfusionsmatrix, Trainingsmosaike, Testergebnisse und Datensatzstatistikbilder wie labels.png. All diese befinden sich in Ihrem project/name Verzeichnis, typischerweise yolov5/runs/train/exp.

Wir haben einen umfassenden Leitfaden für Benutzer zusammengestellt, die die besten Ergebnisse bei ihren YOLOv5-Trainingsläufen erzielen möchten.

Datensatz

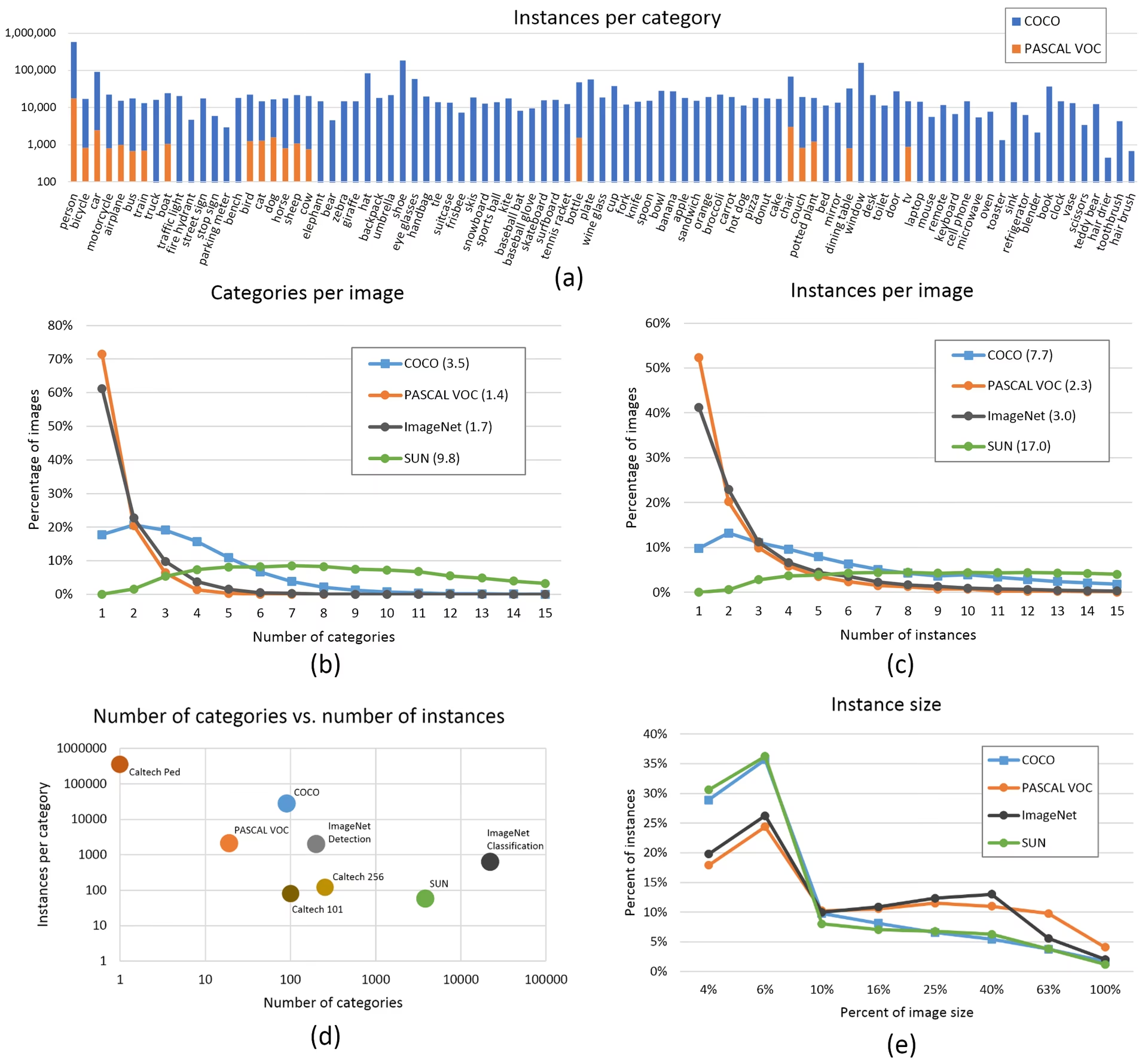

- Bilder pro Klasse. ≥ 1500 Bilder pro Klasse werden empfohlen

- Instanzen pro Klasse. ≥ 10000 Instanzen (beschriftete Objekte) pro Klasse werden empfohlen

- Bildvielfalt. Muss repräsentativ für die Einsatzumgebung sein. Für reale Anwendungsfälle empfehlen wir Bilder von verschiedenen Tageszeiten, verschiedenen Jahreszeiten, verschiedenen Wetterbedingungen, unterschiedlicher Beleuchtung, unterschiedlichen Winkeln, unterschiedlichen Quellen (online gescraped, lokal gesammelt, verschiedene Kameras) usw.

- Labelkonsistenz. Alle Instanzen aller Klassen in allen Bildern müssen gelabelt werden. Partielles Labeling funktioniert nicht.

- Label Genauigkeit. Labels müssen jedes Objekt eng umschließen. Es darf kein Abstand zwischen einem Objekt und seiner Bounding Box bestehen. Es dürfen keine Objekte ungelabelt bleiben.

- Disziplin bei der Aufteilung in Trainings-/Validierungsdaten. Stellen Sie sicher, dass Validierungs- und Testbilder niemals im Trainingssatz erscheinen, um übermäßig optimistische Metriken zu vermeiden. Halten Sie die Klassenverteilungen zwischen den Aufteilungen ähnlich.

- Label-Verifizierung. Ansicht

train_batch*.jpgbeim Trainingsstart, um zu überprüfen, ob Ihre Labels korrekt erscheinen, d. h. siehe Beispiel Mosaik. - Hintergrundbilder. Hintergrundbilder sind Bilder ohne Objekte, die einem Datensatz hinzugefügt werden, um falsch positive Ergebnisse (FP) zu reduzieren. Wir empfehlen etwa 0-10 % Hintergrundbilder, um FPs zu reduzieren (COCO enthält zum Vergleich 1000 Hintergrundbilder, 1 % der Gesamtmenge). Für Hintergrundbilder sind keine Labels erforderlich.

Modellauswahl

Größere Modelle wie YOLOv5x und YOLOv5x6 erzielen in fast allen Fällen bessere Ergebnisse, haben aber mehr Parameter, benötigen mehr CUDA-Speicher zum Trainieren und sind langsamer in der Ausführung. Für mobile Anwendungen empfehlen wir YOLOv5s/m, für Cloud Anwendungen empfehlen wir YOLOv5l/x. Eine vollständige Vergleichstabelle aller Modelle finden Sie in unserer README Tabelle.

Beginnen Sie mit vortrainierten Gewichten. Empfohlen für kleine bis mittelgroße Datensätze (d.h. VOC, VisDrone, GlobalWheat). Übergeben Sie den Namen des Modells an das

--weightsArgument genannt. Modelle werden automatisch von der neueste YOLOv5-Version.python train.py --data custom.yaml --weights yolov5s.pt python train.py --data custom.yaml --weights yolov5m.pt python train.py --data custom.yaml --weights yolov5l.pt python train.py --data custom.yaml --weights yolov5x.pt python train.py --data custom.yaml --weights custom_pretrained.ptVon Grund auf neu beginnen. Empfohlen für große Datensätze (d. h. COCO, Objects365, OIv6). Übergeben Sie die YAML-Datei der Modellarchitektur, an der Sie interessiert sind, zusammen mit einer leeren

--weights ''Argument:python train.py --data custom.yaml --weights '' --cfg yolov5s.yaml python train.py --data custom.yaml --weights '' --cfg yolov5m.yaml python train.py --data custom.yaml --weights '' --cfg yolov5l.yaml python train.py --data custom.yaml --weights '' --cfg yolov5x.yaml

Trainingseinstellungen

Bevor Sie etwas ändern, trainieren Sie zuerst mit den Standardeinstellungen, um eine Leistungsbasislinie festzulegen. Eine vollständige Liste der train.py-Einstellungen finden Sie im train.py Argparser.

- Epochen. Beginnen Sie mit 300 Epochen. Wenn dies frühzeitig zu Overfitting führt, können Sie die Anzahl der Epochen reduzieren. Wenn nach 300 Epochen kein Overfitting auftritt, trainieren Sie länger, d. h. 600, 1200 usw. Epochen.

- Bildgröße. COCO trainiert mit einer nativen Auflösung von

--img 640, profitiert jedoch aufgrund der hohen Anzahl kleiner Objekte im Datensatz von einem Training mit höheren Auflösungen wie--img 1280. Wenn es viele kleine Objekte gibt, profitieren benutzerdefinierte Datensätze vom Training mit nativer oder höherer Auflösung. Die besten Inferenz-Ergebnisse werden bei derselben--imgals das Training durchgeführt wurde, d.h. wenn Sie bei--img 1280Sie sollten auch testen und detect bei--img 1280. - Batch-Größe. Verwenden Sie die größte

--batch-sizedie Ihre Hardware zulässt. Kleine Batch-Größen führen zu schlechten Batch-Normalisierung Statistiken und sollte vermieden werden. Sie können--batch-size -1um automatisch die optimale Batch-Größe für Ihre GPU auszuwählen. - Lernrate. Der Standard-Lernratenplan funktioniert in den meisten Fällen gut. Für eine schnellere Konvergenz können Sie Folgendes ausprobieren:

--cos-lrum das Cosinus-Lernraten-Scheduling zu aktivieren, das die Lernrate schrittweise entlang einer Cosinuskurve über Epochen reduziert. - Datenaugmentierung. YOLOv5 beinhaltet verschiedene Augmentationstechniken wie Mosaic, das mehrere Trainingsbilder kombiniert. Für die letzten Epochen sollte man die Verwendung von

--close-mosaic 10um die Mosaic-Augmentierung zu deaktivieren, was zur Stabilisierung des Trainings beitragen kann. - Hyperparameter. Die Standard-Hyperparameter befinden sich in hyp.scratch-low.yaml. Wir empfehlen Ihnen, zuerst mit den Standard-Hyperparametern zu trainieren, bevor Sie daran denken, etwas zu ändern. Im Allgemeinen reduziert und verzögert die Erhöhung der Augmentations-Hyperparameter das Overfitting, was längere Trainings und ein höheres endgültiges mAP ermöglicht. Reduzierung der Verlustkomponenten-Verstärkungs-Hyperparameter wie

hyp['obj']wird helfen, Overfitting in diesen spezifischen Verlustkomponenten zu reduzieren. Für eine automatisierte Methode zur Optimierung dieser Hyperparameter, siehe unsere Tutorial zur Hyperparameter-Evolution. - Gemischte Präzision beim Training. Aktivieren Sie das Training mit gemischter Präzision mit

--ampum das Training zu beschleunigen und den Speicherverbrauch zu reduzieren, ohne die Modellgenauigkeit zu beeinträchtigen. - Multi-GPU-Training. Wenn Sie mehrere GPUs haben, verwenden Sie

--device 0,1,2,3um das Training auf diese zu verteilen, was die Trainingszeit erheblich verkürzen kann. - Vorzeitiges Stoppen. Verwenden Sie

--patience 50das Training zu stoppen, wenn sich die Validierungsmetriken über 50 Epochen nicht verbessern, wodurch Zeit gespart und Overfitting verhindert wird.

Fortgeschrittene Optimierungstechniken

- Transfer Learning. Beginnen Sie für spezielle Datensätze mit vortrainierten Gewichten und lösen Sie die Schichten während des Trainings schrittweise auf, um das Modell an Ihre spezifische Aufgabe anzupassen.

- Model Pruning. Erwägen Sie nach dem Training, Ihr Modell zu stutzen, um redundante Gewichtungen zu entfernen und die Modellgröße ohne wesentliche Leistungseinbußen zu reduzieren.

- Model Ensembling. Für kritische Anwendungen sollten Sie mehrere Modelle mit unterschiedlichen Konfigurationen trainieren und deren Vorhersagen kombinieren, um die Genauigkeit zu verbessern.

- Testzeit-Augmentierung. Aktivieren Sie TTA während der Inferenz mit

--augmentum die Vorhersagegenauigkeit zu verbessern, indem Ergebnisse von erweiterten Versionen des Eingangsbildes gemittelt werden.

Weiterführende Informationen

Wenn Sie mehr erfahren möchten, ist Karpathys 'Recipe for Training Neural Networks' ein guter Ausgangspunkt. Es enthält großartige Ideen für das Training, die allgemein für alle ML-Bereiche gelten: https://karpathy.github.io/2019/04/25/recipe/

Für detailliertere Informationen zu Trainingseinstellungen und -konfigurationen konsultieren Sie die Ultralytics Dokumentation zu Trainingseinstellungen, die umfassende Erklärungen aller verfügbaren Parameter bietet.

Viel Erfolg 🍀 und lassen Sie uns wissen, wenn Sie weitere Fragen haben!

FAQ

Woher weiß ich, ob mein Modell überangepasst ist (Overfitting)?

Ihr Modell könnte überangepasst sein, wenn der Trainingsverlust weiter sinkt, während der Validierungsverlust zu steigen beginnt. Überwachen Sie das Validierungs-mAP – wenn es stagniert oder sinkt, während der Trainingsverlust sich weiter verbessert, ist das ein Zeichen für Überanpassung. Lösungen umfassen das Hinzufügen weiterer Trainingsdaten, die Erhöhung der Datenaugmentation oder die Implementierung von Regularisierungstechniken.

Was ist die optimale Batch-Größe für das Training von YOLOv5?

Die optimale Batch-Größe hängt von Ihrem GPU-Speicher ab. Größere Batch-Größen bieten im Allgemeinen bessere Batch-Normalisierungsstatistiken und Trainingsstabilität. Verwenden Sie die größte Batch-Größe, die Ihre Hardware verarbeiten kann, ohne dass der Speicherplatz ausgeht. Sie können --batch-size -1 um automatisch die optimale Batch-Größe für Ihre Konfiguration zu bestimmen.

Wie kann ich das YOLOv5-Training beschleunigen?

Um das Training zu beschleunigen, versuchen Sie Folgendes: Aktivieren Sie das Training mit gemischter Präzision mit --amp, unter Verwendung mehrerer GPUs mit --device 0,1,2,3, Caching Ihres Datensatzes mit --cache, und optimieren Sie Ihre Batch-Größe. Erwägen Sie auch die Verwendung einer kleineren Modellvariante wie YOLOv5s, wenn absolute Genauigkeit nicht entscheidend ist.