Conjunto de datos COCO

El conjunto de datos COCO (Objetos Comunes en Contexto) es un conjunto de datos a gran escala de detección de objetos, segmentación y subtitulado. Está diseñado para fomentar la investigación en una amplia variedad de categorías de objetos y se utiliza comúnmente para la evaluación comparativa de modelos de visión artificial. Es un conjunto de datos esencial para investigadores y desarrolladores que trabajan en tareas de detección de objetos, segmentación y estimación de pose.

Ver: Descripción general del conjunto de datos COCO de Ultralytics

Modelos preentrenados de COCO

| Modelo | tamaño (píxeles) | mAPval 50-95 | mAPval 50-95(e2e) | Velocidad CPU ONNX (ms) | Velocidad T4 TensorRT10 (ms) | parámetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Características clave

- COCO contiene 330.000 imágenes, con 200.000 imágenes que tienen anotaciones para tareas de object detection, segmentación y subtitulado.

- El conjunto de datos comprende 80 categorías de objetos, incluyendo objetos comunes como coches, bicicletas y animales, así como categorías más específicas como paraguas, bolsos de mano y equipamiento deportivo.

- Las anotaciones incluyen cuadros delimitadores de objetos, máscaras de segmentación y leyendas para cada imagen.

- COCO proporciona métricas de evaluación estandarizadas como la precisión media promedio (mAP) para la object detection, y la recuperación media promedio (mAR) para las tareas de segmentación, lo que lo hace adecuado para comparar el rendimiento del modelo.

Estructura del conjunto de datos

El dataset COCO se divide en tres subconjuntos:

- Train2017: Este subconjunto contiene 118K imágenes para el entrenamiento de modelos de detección de objetos, segmentación y subtitulado.

- Val2017: Este subconjunto tiene 5K imágenes utilizadas para fines de validación durante el entrenamiento del modelo.

- Test2017: Este subconjunto consta de 20K imágenes utilizadas para probar y evaluar los modelos entrenados. Las anotaciones de ground truth para este subconjunto no están disponibles públicamente, y los resultados se envían al servidor de evaluación COCO para la evaluación del rendimiento.

Aplicaciones

El dataset COCO se utiliza ampliamente para entrenar y evaluar modelos de aprendizaje profundo en la detección de objetos (como Ultralytics YOLO, Faster R-CNN y SSD), la segmentación de instancias (como Mask R-CNN) y la detección de puntos clave (como OpenPose). El diverso conjunto de categorías de objetos del dataset, el gran número de imágenes anotadas y las métricas de evaluación estandarizadas lo convierten en un recurso esencial para los investigadores y profesionales de la visión artificial.

YAML del conjunto de datos

Se utiliza un archivo YAML (Yet Another Markup Language) para definir la configuración del dataset. Contiene información sobre las rutas, las clases y otra información relevante del dataset. En el caso del dataset COCO, el coco.yaml archivo se mantiene en https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

ultralytics/cfg/datasets/coco.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Uso

Para entrenar un modelo YOLO26n en el conjunto de datos COCO durante 100 épocas con un tamaño de imagen de 640, puede usar los siguientes fragmentos de código. Para una lista completa de los argumentos disponibles, consulte la página de Entrenamiento del modelo.

Ejemplo de entrenamiento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

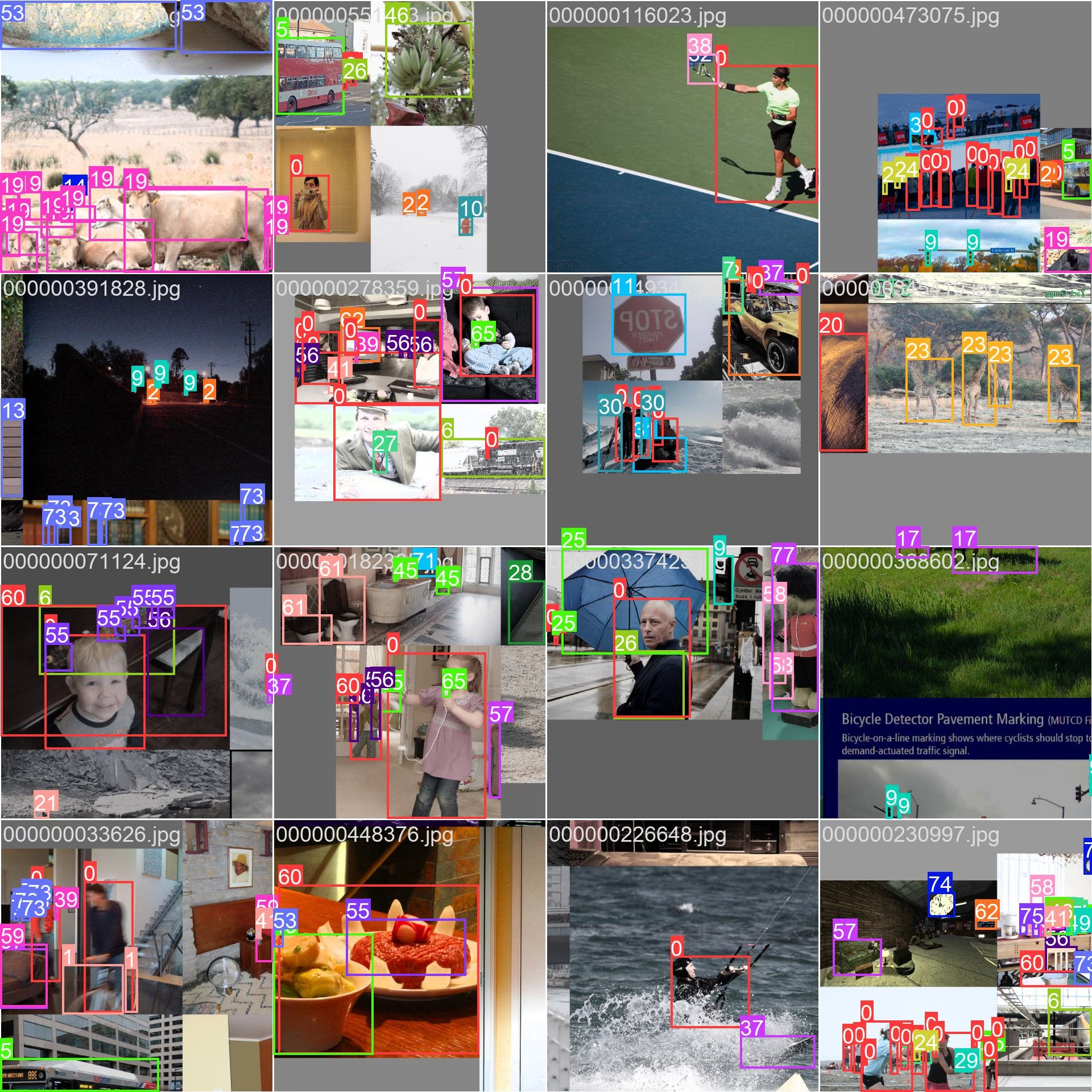

sample_images y anotaciones

El conjunto de datos COCO contiene un conjunto diverso de imágenes con varias categorías de objetos y escenas complejas. Aquí hay algunos ejemplos de imágenes del conjunto de datos, junto con sus anotaciones correspondientes:

- Imagen en mosaico: Esta imagen muestra un lote de entrenamiento compuesto por imágenes en mosaico del conjunto de datos. El mosaico es una técnica utilizada durante el entrenamiento que combina varias imágenes en una sola imagen para aumentar la variedad de objetos y escenas dentro de cada lote de entrenamiento. Esto ayuda a mejorar la capacidad del modelo para generalizar a diferentes tamaños de objetos, relaciones de aspecto y contextos.

El ejemplo muestra la variedad y complejidad de las imágenes en el conjunto de datos COCO y los beneficios de utilizar el mosaico durante el proceso de entrenamiento.

Citas y agradecimientos

Si utiliza el dataset COCO en su trabajo de investigación o desarrollo, cite el siguiente artículo:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Nos gustaría agradecer al Consorcio COCO por crear y mantener este valioso recurso para la comunidad de visión artificial. Para obtener más información sobre el conjunto de datos COCO y sus creadores, visite el sitio web del conjunto de datos COCO.

Preguntas frecuentes

¿Qué es el conjunto de datos COCO y por qué es importante para la visión artificial?

El conjunto de datos COCO (Objetos Comunes en Contexto) es un conjunto de datos a gran escala utilizado para la detección de objetos, la segmentación y el subtitulado. Contiene 330,000 imágenes con anotaciones detalladas para 80 categorías de objetos, lo que lo hace esencial para la evaluación comparativa y el entrenamiento de modelos de visión artificial. Los investigadores utilizan COCO debido a sus diversas categorías y métricas de evaluación estandarizadas, como la Precisión Media Promedio Precision (mAP).

¿Cómo puedo entrenar un modelo YOLO utilizando el dataset COCO?

Para entrenar un modelo YOLO26 utilizando el conjunto de datos COCO, puede usar los siguientes fragmentos de código:

Ejemplo de entrenamiento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

Consulte la página de entrenamiento para obtener más detalles sobre los argumentos disponibles.

¿Cuáles son las características clave del conjunto de datos COCO?

El dataset COCO incluye:

- 330K imágenes, con 200K anotadas para detección de objetos, segmentación y subtitulado.

- 80 categorías de objetos que van desde artículos comunes como automóviles y animales hasta otros específicos como bolsos y equipos deportivos.

- Métricas de evaluación estandarizadas para la detección de objetos (mAP) y la segmentación (media de Average Recall, mAR).

- Técnica de mosaicos en lotes de entrenamiento para mejorar la generalización del modelo en diversos tamaños y contextos de objetos.

¿Dónde puedo encontrar modelos YOLO26 preentrenados en el conjunto de datos COCO?

Los modelos YOLO26 preentrenados en el conjunto de datos COCO se pueden descargar desde los enlaces proporcionados en la documentación. Los ejemplos incluyen:

Estos modelos varían en tamaño, mAP y velocidad de inferencia, lo que ofrece opciones para diferentes requisitos de rendimiento y recursos.

¿Cómo está estructurado el conjunto de datos COCO y cómo lo uso?

El dataset COCO se divide en tres subconjuntos:

- Train2017: 118K imágenes para entrenamiento.

- Val2017: 5K imágenes para la validación durante el entrenamiento.

- Test2017: 20K imágenes para la evaluación comparativa de modelos entrenados. Los resultados deben enviarse al servidor de evaluación COCO para la evaluación del rendimiento.

El archivo de configuración yaml del conjunto de datos está disponible en coco.yaml, que define rutas, clases y detalles del conjunto de datos.