COCOデータセット

COCO(Common Objects in Context)データセットは、大規模な物体detect、segment、およびキャプション付けデータセットです。これは、多種多様な物体カテゴリに関する研究を促進するように設計されており、コンピュータービジョンモデルのベンチマークに一般的に使用されます。物体detect、segment、および姿勢推定タスクに取り組む研究者や開発者にとって不可欠なデータセットです。

見る: Ultralytics COCOデータセットの概要

COCO事前学習済みモデル

| モデル | サイズ (ピクセル) | mAPval 50-95 | mAPval 50-95(e2e) | 速度 CPU ONNX (ms) | 速度 T4 TensorRT10 (ms) | params (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

主な特徴

- COCOは33万枚の画像を含み、そのうち20万枚の画像にはobject detection、segmentation、およびキャプション生成タスク用のアノテーションが付与されています。

- このデータセットは、車、自転車、動物などの一般的なオブジェクトに加えて、傘、ハンドバッグ、スポーツ用品などのより具体的なカテゴリを含む、80のオブジェクトカテゴリで構成されています。

- アノテーションには、オブジェクトのバウンディングボックス、セグメンテーションマスク、および各画像のキャプションが含まれます。

- COCOは、object detection用の平均適合率 (mAP) や、segmentationタスク用の平均再現率 (mAR) といった標準化された評価指標を提供しており、モデル性能の比較に適しています。

データセットの構造

COCOデータセットは3つのサブセットに分割されています。

- Train2017: このサブセットには、オブジェクト検出、セグメンテーション、キャプション作成モデルのトレーニング用の118Kの画像が含まれています。

- Val2017: このサブセットには、モデルトレーニング中の検証を目的として使用される5,000枚の画像が含まれています。

- Test2017: このサブセットは、学習済みモデルのテストおよびベンチマークに使用される2万枚の画像で構成されています。このサブセットのグラウンドトゥルースアノテーションは公開されておらず、結果は性能評価のためにCOCO評価サーバーに提出されます。

アプリケーション

COCOデータセットは、object detection(Ultralytics YOLO、Faster R-CNN、SSDなど)、インスタンスセグメンテーション(Mask R-CNNなど)、およびキーポイント検出(OpenPoseなど)といったディープラーニングモデルの学習および評価に広く利用されています。このデータセットは、多様なオブジェクトカテゴリ、多数のアノテーション付き画像、および標準化された評価指標を備えており、コンピュータービジョン研究者や実務家にとって不可欠なリソースとなっています。

データセット YAML

データセットの設定を定義するために、YAML (Yet Another Markup Language) ファイルが使用されます。これには、データセットのパス、クラス、およびその他の関連情報が含まれています。COCOデータセットの場合、 coco.yaml fileは以下で管理されています: https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

ultralytics/cfg/datasets/coco.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

使用法

COCOデータセットでYOLO26nモデルを画像サイズ640で100 エポックトレーニングするには、以下のコードスニペットを使用できます。利用可能な引数の包括的なリストについては、モデルのトレーニングページを参照してください。

学習の例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

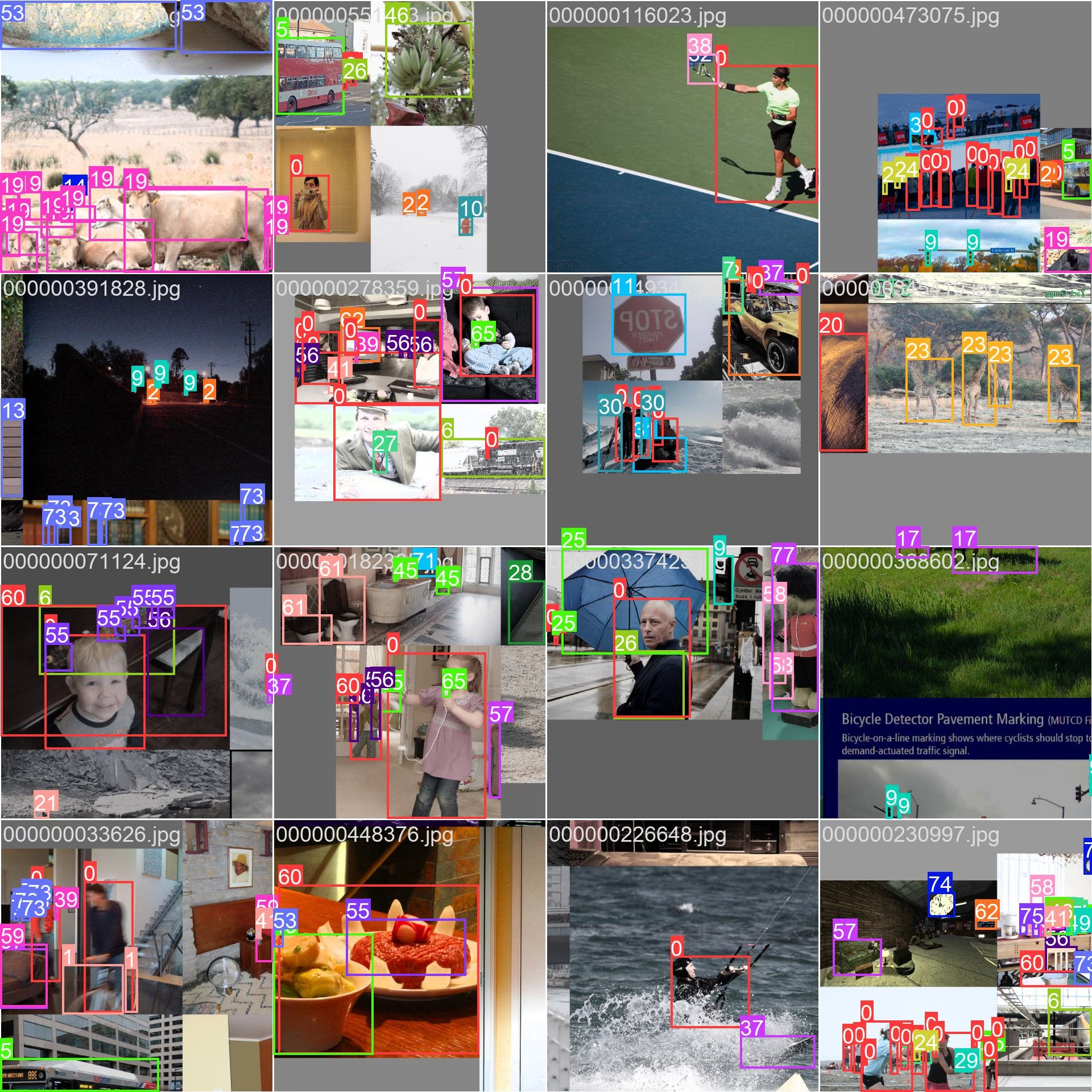

サンプル画像とアノテーション

COCOデータセットには、多様なオブジェクトカテゴリと複雑なシーンを含むさまざまな画像が含まれています。以下に、データセットからの画像とそれに対応するアノテーションの例を示します。

- モザイク化された画像: この画像は、モザイク化されたデータセット画像で構成されるトレーニングバッチを示しています。モザイキングは、各トレーニングバッチ内のオブジェクトとシーンの多様性を高めるために、複数の画像を1つの画像に結合するトレーニング中に使用される手法です。これにより、さまざまなオブジェクトのサイズ、アスペクト比、およびコンテキストに対するモデルの汎化能力が向上します。

この例は、COCOデータセット内の画像の多様性と複雑さ、および学習プロセス中にモザイク処理を使用することの利点を示しています。

引用と謝辞

研究または開発作業でCOCOデータセットを使用する場合は、以下の論文を引用してください。

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

コンピュータービジョンコミュニティのためにこの貴重なリソースを作成し、維持しているCOCOコンソーシアムに感謝いたします。COCOデータセットとその作成者に関する詳細については、COCOデータセットのウェブサイトをご覧ください。

よくある質問

COCOデータセットとは何ですか、そしてなぜコンピュータービジョンにとって重要なのでしょうか?

COCOデータセット(Common Objects in Context)は、object detection、segmentation、およびキャプション生成に利用される大規模なデータセットです。80のオブジェクトカテゴリに対して詳細なアノテーションが付与された33万枚の画像を含み、コンピュータービジョンモデルのベンチマークおよび学習に不可欠です。研究者は、その多様なカテゴリと、平均適合率 (mAP) のような標準化された評価指標のため、COCOを利用しています。

COCOデータセットを使用してYOLOモデルを学習させるにはどうすればよいですか?

COCOデータセットを使用してYOLO26モデルをトレーニングするには、以下のコードスニペットを使用できます。

学習の例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

利用可能な引数の詳細については、トレーニングページを参照してください。

COCOデータセットの主要な機能は何ですか?

COCOデータセットには以下が含まれます。

- 33万枚の画像と、物体検出、セグメンテーション、キャプション用にアノテーションされた20万枚の画像。

- 車や動物のような一般的なものから、ハンドバッグやスポーツ用品のような特定のものまで、80のオブジェクトカテゴリがあります。

- object detection用の標準化された評価指標 (mAP) およびsegmentation用の標準化された評価指標 (平均再現率、mAR)。

- モザイキングトレーニングバッチの手法により、さまざまなオブジェクトサイズとコンテキストにわたるモデルの汎化が向上します。

COCOデータセットでトレーニングされた事前学習済みYOLO26モデルはどこで入手できますか?

COCOデータセットで事前学習されたYOLO26モデルは、ドキュメントに記載されているリンクからダウンロードできます。例としては、

これらのモデルは、サイズ、mAP、および推論速度が異なり、さまざまな性能要件やリソース要件に対応するオプションを提供します。

COCOデータセットはどのように構造化されており、どのように使用しますか?

COCOデータセットは3つのサブセットに分割されています。

- Train2017:トレーニング用の118K画像。

- Val2017: トレーニング中の検証用として5,000枚の画像。

- Test2017: 学習済みモデルのベンチマーク用の2万枚の画像。性能評価のため、結果はCOCO評価サーバーに提出する必要があります。

データセットのYAML設定ファイルはcoco.yamlで入手でき、これにはパス、クラス、およびデータセットの詳細が定義されています。