Conjunto de Dados COCO

O COCO (Common Objects in Context) dataset é um dataset de grande escala para detecção de objetos, segmentação e legendagem. Ele é projetado para incentivar a pesquisa em uma ampla variedade de categorias de objetos e é comumente usado para benchmarking de modelos de visão computacional. É um dataset essencial para pesquisadores e desenvolvedores que trabalham em tarefas de detecção de objetos, segmentação e estimativa de pose.

Assista: Visão Geral do Conjunto de Dados COCO da Ultralytics

Modelos Pré-Treinados COCO

| Modelo | tamanho (pixels) | mAPval 50-95 | mAPval 50-95(e2e) | Velocidade CPU ONNX (ms) | Velocidade T4 TensorRT10 (ms) | parâmetros (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n | 640 | 40.9 | 40.1 | 38.9 ± 0.7 | 1.7 ± 0.0 | 2.4 | 5.4 |

| YOLO26s | 640 | 48.6 | 47.8 | 87.2 ± 0.9 | 2.5 ± 0.0 | 9.5 | 20.7 |

| YOLO26m | 640 | 53.1 | 52.5 | 220.0 ± 1.4 | 4.7 ± 0.1 | 20.4 | 68.2 |

| YOLO26l | 640 | 55.0 | 54.4 | 286.2 ± 2.0 | 6.2 ± 0.2 | 24.8 | 86.4 |

| YOLO26x | 640 | 57.5 | 56.9 | 525.8 ± 4.0 | 11.8 ± 0.2 | 55.7 | 193.9 |

Principais Características

- COCO contém 330 mil imagens, com 200 mil imagens tendo anotações para tarefas de object detection, segmentation e legendagem.

- O conjunto de dados compreende 80 categorias de objetos, incluindo objetos comuns como carros, bicicletas e animais, bem como categorias mais específicas, como guarda-chuvas, bolsas e equipamentos esportivos.

- As anotações incluem caixas delimitadoras de objetos, máscaras de segmentação e legendas para cada imagem.

- COCO fornece métricas de avaliação padronizadas como mean Average Precision (mAP) para object detection e mean Average Recall (mAR) para tarefas de segmentation, tornando-o adequado para comparar o desempenho do modelo.

Estrutura do Conjunto de Dados

O dataset COCO é dividido em três subconjuntos:

- Train2017: Este subconjunto contém 118 mil imagens para treinar modelos de detecção de objetos, segmentação e legendagem.

- Val2017: Este subconjunto tem 5 mil imagens usadas para fins de validação durante o treinamento do modelo.

- Test2017: Este subconjunto consiste em 20 mil imagens usadas para teste e benchmarking dos modelos treinados. As anotações de ground truth para este subconjunto não estão disponíveis publicamente, e os resultados são submetidos ao servidor de avaliação COCO para avaliação de desempenho.

Aplicações

O dataset COCO é amplamente utilizado para treinar e avaliar modelos de deep learning em object detect (como Ultralytics YOLO, Faster R-CNN e SSD), segmentação de instâncias (como Mask R-CNN) e detecção de pontos-chave (como OpenPose). O conjunto diversificado de categorias de objetos do dataset, o grande número de imagens anotadas e as métricas de avaliação padronizadas tornam-no um recurso essencial para pesquisadores e profissionais de visão computacional.

YAML do Conjunto de Dados

Um arquivo YAML (Yet Another Markup Language) é usado para definir a configuração do dataset. Ele contém informações sobre os caminhos, classes e outras informações relevantes do dataset. No caso do dataset COCO, o coco.yaml arquivo é mantido em https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

ultralytics/cfg/datasets/coco.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Utilização

Para treinar um modelo YOLO26n no conjunto de dados COCO por 100 epochs com um tamanho de imagem de 640, você pode usar os seguintes trechos de código. Para uma lista abrangente de argumentos disponíveis, consulte a página de Treinamento do modelo.

Exemplo de Treinamento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

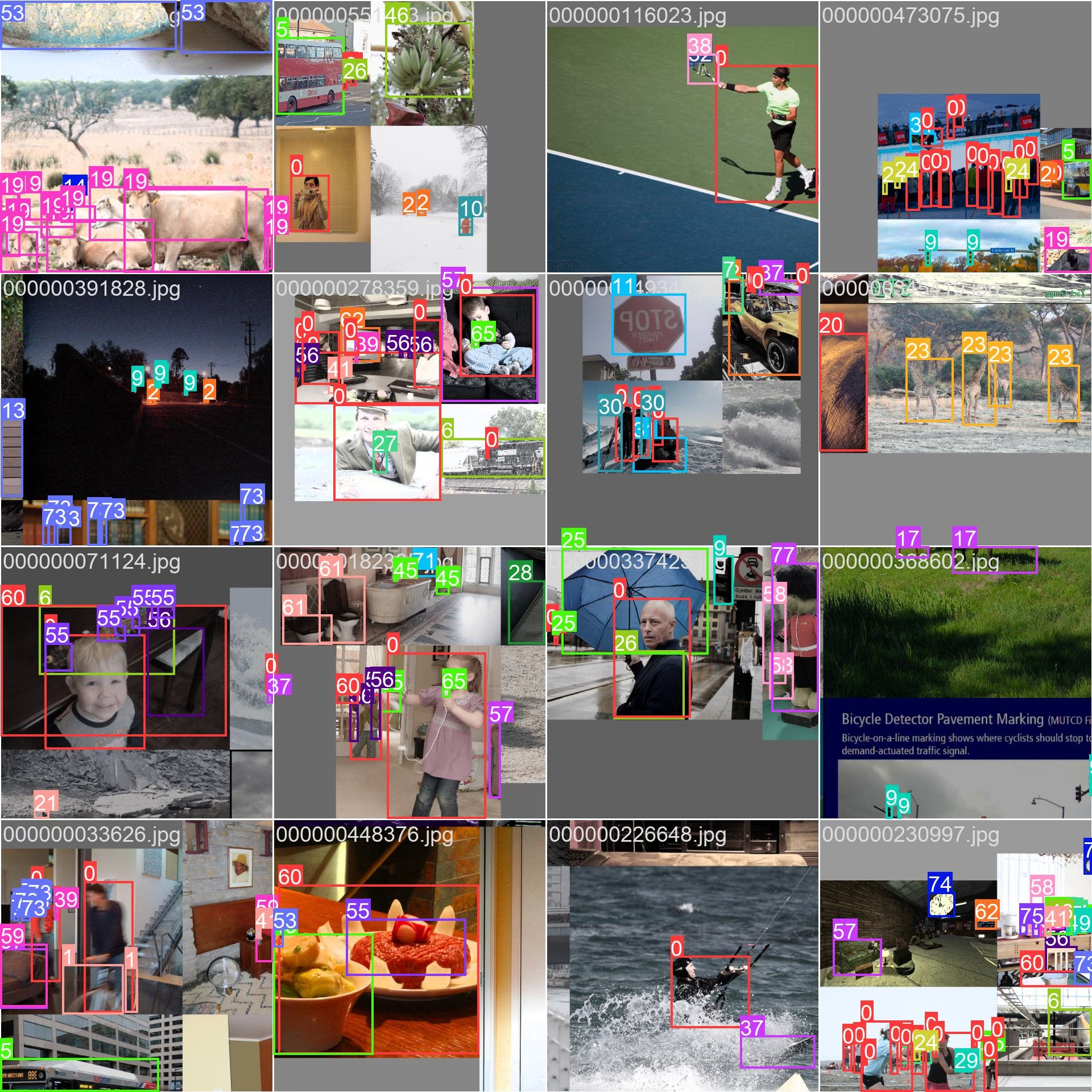

Amostras de Imagens e Anotações

O dataset COCO contém um conjunto diversificado de imagens com várias categorias de objetos e cenas complexas. Aqui estão alguns exemplos de imagens do dataset, juntamente com as suas anotações correspondentes:

- Imagem em Mosaico: Esta imagem demonstra um lote de treinamento composto por imagens de conjunto de dados em mosaico. O mosaico é uma técnica usada durante o treinamento que combina várias imagens em uma única imagem para aumentar a variedade de objetos e cenas dentro de cada lote de treinamento. Isso ajuda a melhorar a capacidade do modelo de generalizar para diferentes tamanhos de objetos, proporções e contextos.

O exemplo mostra a variedade e complexidade das imagens no dataset COCO e os benefícios de usar mosaicos durante o processo de treinamento.

Citações e Agradecimentos

Se você usar o dataset COCO em seu trabalho de pesquisa ou desenvolvimento, cite o seguinte artigo:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Gostaríamos de agradecer ao COCO Consortium por criar e manter este recurso valioso para a comunidade de visão computacional. Para mais informações sobre o conjunto de dados COCO e os seus criadores, visite o site do conjunto de dados COCO.

FAQ

O que é o conjunto de dados COCO e por que ele é importante para a visão computacional?

O dataset COCO (Common Objects in Context) é um dataset de grande escala usado para detecção de objetos, segmentação e legendagem. Ele contém 330 mil imagens com anotações detalhadas para 80 categorias de objetos, tornando-o essencial para benchmarking e treinamento de modelos de visão computacional. Pesquisadores usam o COCO devido às suas diversas categorias e métricas de avaliação padronizadas, como a precisão média (mAP).

Como posso treinar um modelo YOLO usando o conjunto de dados COCO?

Para treinar um modelo YOLO26 usando o conjunto de dados COCO, você pode usar os seguintes trechos de código:

Exemplo de Treinamento

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo detect train data=coco.yaml model=yolo26n.pt epochs=100 imgsz=640

Consulte a página de Treinamento para obter mais detalhes sobre os argumentos disponíveis.

Quais são os principais recursos do conjunto de dados COCO?

O dataset COCO inclui:

- 330 mil imagens, com 200 mil anotadas para detecção de objetos, segmentação e legendagem.

- 80 categorias de objetos, desde itens comuns como carros e animais até itens específicos como bolsas e equipamentos esportivos.

- Métricas de avaliação padronizadas para deteção de objetos (mAP) e segmentação (mean Average Recall, mAR).

- Técnica de Mosaico em lotes de treinamento para aprimorar a generalização do modelo em vários tamanhos e contextos de objetos.

Onde posso encontrar modelos YOLO26 pré-treinados no conjunto de dados COCO?

Modelos YOLO26 pré-treinados no conjunto de dados COCO podem ser baixados a partir dos links fornecidos na documentação. Exemplos incluem:

Esses modelos variam em tamanho, mAP e velocidade de inferência, oferecendo opções para diferentes requisitos de desempenho e recursos.

Como o dataset COCO é estruturado e como posso usá-lo?

O dataset COCO é dividido em três subconjuntos:

- Train2017: 118 mil imagens para treinamento.

- Val2017: 5 mil imagens para validação durante o treinamento.

- Test2017: 20 mil imagens para benchmarking de modelos treinados. Os resultados precisam ser submetidos ao servidor de avaliação COCO para avaliação de desempenho.

O arquivo de configuração YAML do conjunto de dados está disponível em coco.yaml, que define caminhos, classes e detalhes do conjunto de dados.