COCO-Seg Datensatz

Der COCO-Seg-Datensatz, eine Erweiterung des COCO-Datensatzes (Common Objects in Context), wurde speziell entwickelt, um die Forschung im Bereich der Objekt-Instanzsegmentierung zu unterstützen. Er verwendet dieselben Bilder wie COCO, führt aber detailliertere segment-Annotationen ein. Dieser Datensatz ist eine entscheidende Ressource für Forscher und Entwickler, die an Instanzsegmentierungsaufgaben arbeiten, insbesondere für das Training von Ultralytics YOLO-Modellen.

COCO-Seg Vortrainierte Modelle

| Modell | Größe (Pixel) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Hauptmerkmale

- COCO-Seg behält die ursprünglichen 330.000 Bilder von COCO bei.

- Der Datensatz besteht aus denselben 80 Objektkategorien, die im ursprünglichen COCO-Datensatz gefunden wurden.

- Annotationen enthalten jetzt detailliertere Instanzsegmentierungsmasken für jedes Objekt in den Bildern.

- COCO-Seg bietet standardisierte Bewertungsmetriken wie die mittlere durchschnittliche Präzision (mAP) für die Objekterkennung und die mittlere durchschnittliche Recall-Rate (mAR) für Instanzsegmentierungsaufgaben, was einen effektiven Vergleich der Modellleistung ermöglicht.

Dataset-Struktur

Der COCO-Seg-Datensatz ist in drei Untergruppen aufgeteilt:

- Train2017: 118.000 Bilder für das Training von Instanzsegmentierungsmodellen.

- Val2017: 5.000 Bilder, die zur Validierung während der Modellentwicklung verwendet werden.

- Test2017: 20.000 Bilder, die für das Benchmarking verwendet werden. Ground-Truth-Annotationen für diesen Teilsatz sind nicht öffentlich verfügbar, daher müssen Vorhersagen zur Bewertung an den COCO-Evaluierungsserver übermittelt werden.

Anwendungen

COCO-Seg wird häufig zum Training und zur Evaluierung von Deep-Learning-Modellen in der Instanzsegmentierung eingesetzt, wie den YOLO-Modellen. Die große Anzahl annotierter Bilder, die Vielfalt der Objektkategorien und die standardisierten Bewertungsmetriken machen es zu einer unverzichtbaren Ressource für Computer-Vision-Forschende und -Praktiker.

Datensatz-YAML

Eine YAML (Yet Another Markup Language)-Datei wird verwendet, um die Dataset-Konfiguration zu definieren. Sie enthält Informationen über die Pfade, Klassen und andere relevante Informationen des Datasets. Im Falle des COCO-Seg-Datasets, coco.yaml Datei wird verwaltet unter https://github.com/ultralytics/ultralytics/blob/main/ultralytics/cfg/datasets/coco.yaml.

Ultralytics/cfg/datasets/COCO.yaml

# Ultralytics 🚀 AGPL-3.0 License - https://ultralytics.com/license

# COCO 2017 dataset https://cocodataset.org by Microsoft

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco ← downloads here (20.1 GB)

# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # val images (relative to 'path') 5000 images

test: test-dev2017.txt # 20288 of 40670 images, submit to https://competitions.codalab.org/competitions/20794

# Classes

names:

0: person

1: bicycle

2: car

3: motorcycle

4: airplane

5: bus

6: train

7: truck

8: boat

9: traffic light

10: fire hydrant

11: stop sign

12: parking meter

13: bench

14: bird

15: cat

16: dog

17: horse

18: sheep

19: cow

20: elephant

21: bear

22: zebra

23: giraffe

24: backpack

25: umbrella

26: handbag

27: tie

28: suitcase

29: frisbee

30: skis

31: snowboard

32: sports ball

33: kite

34: baseball bat

35: baseball glove

36: skateboard

37: surfboard

38: tennis racket

39: bottle

40: wine glass

41: cup

42: fork

43: knife

44: spoon

45: bowl

46: banana

47: apple

48: sandwich

49: orange

50: broccoli

51: carrot

52: hot dog

53: pizza

54: donut

55: cake

56: chair

57: couch

58: potted plant

59: bed

60: dining table

61: toilet

62: tv

63: laptop

64: mouse

65: remote

66: keyboard

67: cell phone

68: microwave

69: oven

70: toaster

71: sink

72: refrigerator

73: book

74: clock

75: vase

76: scissors

77: teddy bear

78: hair drier

79: toothbrush

# Download script/URL (optional)

download: |

from pathlib import Path

from ultralytics.utils import ASSETS_URL

from ultralytics.utils.downloads import download

# Download labels

segments = True # segment or box labels

dir = Path(yaml["path"]) # dataset root dir

urls = [ASSETS_URL + ("/coco2017labels-segments.zip" if segments else "/coco2017labels.zip")] # labels

download(urls, dir=dir.parent)

# Download data

urls = [

"http://images.cocodataset.org/zips/train2017.zip", # 19G, 118k images

"http://images.cocodataset.org/zips/val2017.zip", # 1G, 5k images

"http://images.cocodataset.org/zips/test2017.zip", # 7G, 41k images (optional)

]

download(urls, dir=dir / "images", threads=3)

Nutzung

Um ein YOLO26n-seg-Modell auf dem COCO-Seg-Datensatz für 100 Epochen mit einer Bildgröße von 640 zu trainieren, können Sie die folgenden Code-Snippets verwenden. Eine umfassende Liste der verfügbaren Argumente finden Sie auf der Trainings-Seite des Modells.

Trainingsbeispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo segment train data=coco.yaml model=yolo26n-seg.pt epochs=100 imgsz=640

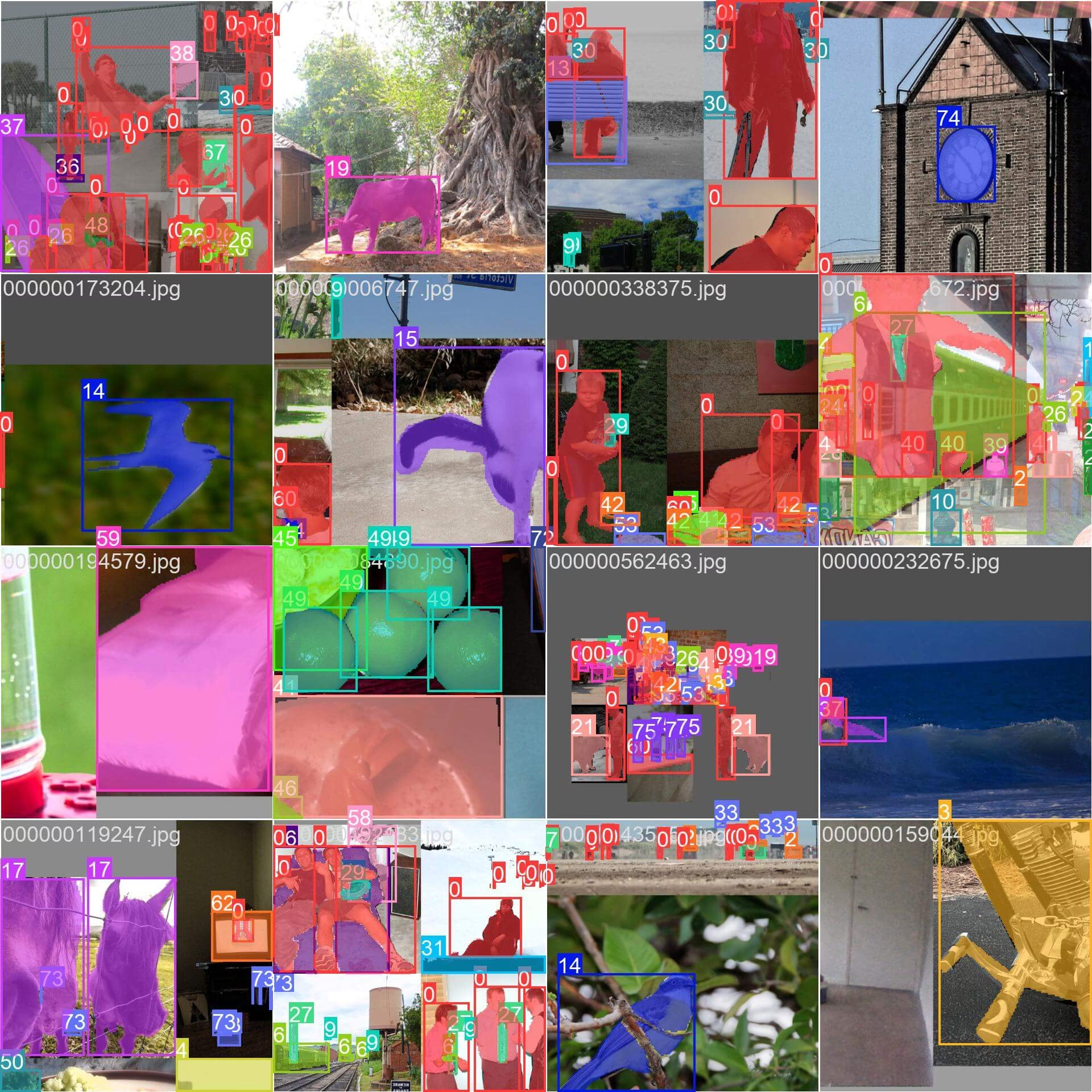

sample_images und Anmerkungen

COCO-Seg enthält, wie sein Vorgänger COCO, einen vielfältigen Satz von Bildern mit verschiedenen Objektkategorien und komplexen Szenen. COCO-Seg führt jedoch detailliertere Instanzsegmentierungsmasken für jedes Objekt in den Bildern ein. Hier sind einige Beispiele von Bildern aus dem Datensatz, zusammen mit ihren entsprechenden Instanzsegmentierungsmasken:

- Mosaikbild: Dieses Bild zeigt einen Trainings-Batch, der aus Mosaik-Datensatzbildern besteht. Mosaicing ist eine Technik, die während des Trainings verwendet wird und mehrere Bilder zu einem einzigen Bild kombiniert, um die Vielfalt der Objekte und Szenen innerhalb jedes Trainings-Batchs zu erhöhen. Dies unterstützt die Fähigkeit des Modells, auf verschiedene Objektgrößen, Seitenverhältnisse und Kontexte zu generalisieren.

Das Beispiel veranschaulicht die Vielfalt und Komplexität der Bilder im COCO-Seg-Datensatz sowie die Vorteile der Verwendung von Mosaicing während des Trainingsprozesses.

Zitate und Danksagungen

Wenn Sie den COCO-Seg-Datensatz in Ihrer Forschungs- oder Entwicklungsarbeit verwenden, zitieren Sie bitte das ursprüngliche COCO-Paper und anerkennen Sie die Erweiterung zu COCO-Seg:

@misc{lin2015microsoft,

title={Microsoft COCO: Common Objects in Context},

author={Tsung-Yi Lin and Michael Maire and Serge Belongie and Lubomir Bourdev and Ross Girshick and James Hays and Pietro Perona and Deva Ramanan and C. Lawrence Zitnick and Piotr Dollár},

year={2015},

eprint={1405.0312},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Wir danken dem COCO Consortium für die Erstellung und Pflege dieser unschätzbaren Ressource für die Computer-Vision-Community. Weitere Informationen zum COCO-Datensatz und seinen Erstellern finden Sie auf der COCO-Datensatz-Website.

FAQ

Was ist der COCO-Seg-Datensatz und wie unterscheidet er sich vom ursprünglichen COCO-Datensatz?

Der COCO-Seg-Datensatz ist eine Erweiterung des ursprünglichen COCO-Datensatzes (Common Objects in Context), der speziell für Instanzsegmentierungsaufgaben entwickelt wurde. Während er dieselben Bilder wie der COCO-Datensatz verwendet, enthält COCO-Seg detailliertere segment-Annotationen, was ihn zu einer leistungsstarken Ressource für Forscher und Entwickler macht, die sich auf die Objektinstanzsegmentierung konzentrieren.

Wie kann ich ein YOLO26 Modell mit dem COCO-Seg-Datensatz trainieren?

Um ein YOLO26n-seg-Modell auf dem COCO-Seg-Datensatz für 100 Epochen mit einer Bildgröße von 640 zu trainieren, können Sie die folgenden Code-Snippets verwenden. Eine detaillierte Liste der verfügbaren Argumente finden Sie auf der Trainings-Seite des Modells.

Trainingsbeispiel

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load a pretrained model (recommended for training)

# Train the model

results = model.train(data="coco.yaml", epochs=100, imgsz=640)

# Start training from a pretrained *.pt model

yolo segment train data=coco.yaml model=yolo26n-seg.pt epochs=100 imgsz=640

Welche Hauptmerkmale hat der COCO-Seg-Datensatz?

Der COCO-Seg-Datensatz umfasst mehrere Schlüsselmerkmale:

- Behält die ursprünglichen 330.000 Bilder aus dem COCO-Datensatz bei.

- Annotiert die gleichen 80 Objektkategorien, die im ursprünglichen COCO gefunden wurden.

- Bietet detailliertere Instanzsegmentierungsmasken für jedes Objekt.

- Verwendet standardisierte Bewertungsmetriken wie die mittlere Precision (mAP) für die Objekterkennung und den mittleren Average Recall (mAR) für Instanzsegmentierungsaufgaben.

Welche vortrainierten Modelle sind für COCO-Seg verfügbar und welche Leistungsmetriken weisen sie auf?

Der COCO-Seg-Datensatz unterstützt mehrere vortrainierte YOLO26-Segmentierungsmodelle mit unterschiedlichen Leistungsmetriken. Hier ist eine Zusammenfassung der verfügbaren Modelle und ihrer wichtigsten Metriken:

| Modell | Größe (Pixel) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | Geschwindigkeit CPU ONNX (ms) | Geschwindigkeit T4 TensorRT10 (ms) | Parameter (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

Diese Modelle reichen vom leichtgewichtigen YOLO26n-seg bis zum leistungsstärkeren YOLO26x-seg und bieten unterschiedliche Kompromisse zwischen Geschwindigkeit und Genauigkeit, um verschiedenen Anwendungsanforderungen gerecht zu werden. Weitere Informationen zur Modellauswahl finden Sie auf der Ultralytics-Modellseite.

Wie ist der COCO-Seg-Datensatz strukturiert und welche Untergruppen enthält er?

Der COCO-Seg-Datensatz ist in drei Untergruppen für spezifische Trainings- und Evaluierungsanforderungen aufgeteilt:

- Train2017: Enthält 118.000 Bilder, die hauptsächlich für das Training von Instanzsegmentierungsmodellen verwendet werden.

- Val2017: Umfasst 5.000 Bilder, die zur Validierung während des Trainingsprozesses verwendet werden.

- Test2017: Umfasst 20.000 Bilder, die für das Testen und Benchmarking trainierter Modelle reserviert sind. Beachten Sie, dass Ground-Truth-Annotationen für diesen Teilsatz nicht öffentlich verfügbar sind und Leistungsdaten zur Bewertung an den COCO-Evaluierungsserver übermittelt werden.

Für kleinere Experimente könnten Sie auch die Verwendung des COCO8-seg Datensatzes in Betracht ziehen, einer kompakten Version, die nur 8 Bilder aus dem COCO train 2017 Set enthält.