Exportation Intel OpenVINO

Dans ce guide, nous abordons l'exportation des modèles YOLO26 au format OpenVINO, ce qui peut fournir une accélération jusqu'à 3x du CPU, ainsi qu'accélérer l'inférence YOLO sur le matériel GPU et NPU d'Intel.

OpenVINO, abréviation de Open Visual Inference & Neural Network Optimization toolkit, est une boîte à outils complète pour l'optimisation et le déploiement de modèles d'inférence d'IA. Même si le nom contient Visual, OpenVINO prend également en charge diverses tâches supplémentaires, notamment le langage, l'audio, les séries chronologiques, etc.

Regarder : Comment exporter Ultralytics YOLO26 au format Intel OpenVINO pour une inférence plus rapide 🚀

Exemples d'utilisation

Exportez un modèle YOLO26n au format OpenVINO et exécutez l'inférence avec le modèle exporté.

Exemple

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

results = ov_model("https://ultralytics.com/images/bus.jpg", device="intel:gpu")

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

# Run inference with specified device, available devices: ["intel:gpu", "intel:npu", "intel:cpu"]

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg' device="intel:gpu"

Arguments d'exportation

| Argument | Type | Par défaut | Description |

|---|---|---|---|

format | str | 'openvino' | Format cible pour le modèle exporté, définissant la compatibilité avec divers environnements de déploiement. |

imgsz | int ou tuple | 640 | Taille d'image souhaitée pour l'entrée du modèle. Peut être un entier pour les images carrées ou un tuple (height, width) pour des dimensions spécifiques. |

half | bool | False | Active la quantification FP16 (demi-précision), réduisant la taille du modèle et accélérant potentiellement l'inférence sur le matériel pris en charge. |

int8 | bool | False | Active la quantification INT8, compressant davantage le modèle et accélérant l'inférence avec une perte de précision minimale, principalement pour les appareils périphériques. |

dynamic | bool | False | Permet des tailles d'entrée dynamiques, améliorant la flexibilité dans la gestion des différentes dimensions d'image. |

nms | bool | False | Ajoute la suppression non maximale (NMS), essentielle pour un post-traitement de détection précis et efficace. |

batch | int | 1 | Spécifie la taille du lot d'inférence du modèle d'exportation ou le nombre maximal d'images que le modèle exporté traitera simultanément en predict mode. |

data | str | 'coco8.yaml' | Chemin d'accès au ensemble de données fichier de configuration (par défaut : coco8.yaml), essentiel pour la quantification. |

fraction | float | 1.0 | Spécifie la fraction de l'ensemble de données à utiliser pour le calibrage de la quantification INT8. Permet de calibrer sur un sous-ensemble de l'ensemble de données complet, ce qui est utile pour les expériences ou lorsque les ressources sont limitées. S'il n'est pas spécifié avec INT8 activé, l'ensemble de données complet sera utilisé. |

Pour plus de détails sur le processus d'exportation, consultez la page de la documentation Ultralytics sur l'exportation.

Avertissement

OpenVINO™ est compatible avec la plupart des processeurs Intel®, mais pour garantir des performances optimales :

Vérifier la prise en charge d'OpenVINO™ Vérifiez si votre puce Intel® est officiellement prise en charge par OpenVINO™ à l'aide de la liste de compatibilité d'Intel.

Identifiez votre accélérateur. Déterminez si votre processeur comprend un NPU (Neural Processing Unit) ou un GPU intégré en consultant le guide matériel d'Intel.

Installez les derniers pilotes. Si votre puce prend en charge un NPU ou un GPU, mais qu'OpenVINO™ ne le détecte pas, vous devrez peut-être installer ou mettre à jour les pilotes associés. Suivez les instructions d'installation des pilotes pour activer l'accélération complète.

En suivant ces trois étapes, vous pouvez vous assurer qu'OpenVINO™ fonctionne de manière optimale sur votre matériel Intel®.

Avantages d'OpenVINO

- Performance : OpenVINO offre une inférence haute performance en utilisant la puissance des CPU Intel, des GPU intégrés et discrets, et des FPGA.

- Prise en charge de l'exécution hétérogène : OpenVINO fournit une API pour écrire une seule fois et déployer sur n'importe quel matériel Intel pris en charge (CPU, GPU, FPGA, VPU, etc.).

- Optimiseur de modèle : OpenVINO fournit un optimiseur de modèle qui importe, convertit et optimise les modèles à partir de frameworks populaires de deep learning tels que PyTorch, TensorFlow, TensorFlow Lite, Keras, ONNX, PaddlePaddle et Caffe.

- Facilité d'utilisation : La boîte à outils est livrée avec plus de 80 notebooks de tutoriel (y compris l'optimisation de YOLOv8) enseignant différents aspects de la boîte à outils.

Structure d'exportation OpenVINO

Lorsque vous exportez un modèle au format OpenVINO, cela génère un répertoire contenant les éléments suivants :

- Fichier XML : Décrit la topologie du réseau.

- Fichier BIN : Contient les données binaires des poids et des biais.

- Fichier de mappage : contient le mappage des tenseurs de sortie du modèle original aux noms des tenseurs OpenVINO.

Vous pouvez utiliser ces fichiers pour exécuter l'inférence avec le moteur d'inférence OpenVINO.

Utilisation de l'export OpenVINO dans le déploiement

Une fois que votre modèle est exporté avec succès au format OpenVINO, vous avez deux options principales pour exécuter l'inférence :

Utilisez la

ultralyticspackage, qui fournit une API de haut niveau et encapsule OpenVINO Runtime.Utiliser le natif

openvinopackage pour un contrôle plus avancé ou personnalisé du comportement d'inférence.

Inférence avec Ultralytics

Le package ultralytics vous permet d'exécuter facilement l'inférence à l'aide du modèle OpenVINO exporté via la méthode predict. Vous pouvez également spécifier le périphérique cible (par exemple, intel:gpu, intel:npu, intel:cpu) en utilisant l'argument device.

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/") # the path of your exported OpenVINO model

# Run inference with the exported model

ov_model.predict(device="intel:gpu") # specify the device you want to run inference on

Cette approche est idéale pour le prototypage rapide ou le déploiement lorsque vous n'avez pas besoin d'un contrôle total sur le pipeline d'inférence.

Inférence avec OpenVINO Runtime

Le runtime OpenVINO fournit une API unifiée pour l'inférence sur tout le matériel Intel pris en charge. Il offre également des capacités avancées telles que l'équilibrage de charge sur le matériel Intel et l'exécution asynchrone. Pour plus d'informations sur l'exécution de l'inférence, consultez les notebooks YOLO26.

N'oubliez pas que vous aurez besoin des fichiers XML et BIN, ainsi que des paramètres spécifiques à l'application, tels que la taille d'entrée, le facteur d'échelle pour la normalisation, etc., pour configurer et utiliser correctement le modèle avec le Runtime.

Dans votre application de déploiement, vous effectuerez généralement les étapes suivantes :

- Initialiser OpenVINO en créant

core = Core(). - Charger le modèle en utilisant le

core.read_model()méthode. - Compiler le modèle en utilisant le

core.compile_model()fonction. - Préparer l'entrée (image, texte, audio, etc.).

- Exécuter l'inférence en utilisant

compiled_model(input_data).

Pour des étapes plus détaillées et des extraits de code, consultez la documentation OpenVINO ou le tutoriel API.

Benchmarks OpenVINO YOLO11

L'équipe Ultralytics a comparé les performances de YOLO11 sur divers formats de modèles et précisions, en évaluant la vitesse et l'exactitude sur différents appareils Intel compatibles avec OpenVINO.

Remarque

Les résultats des benchmarks ci-dessous sont donnés à titre de référence et peuvent varier en fonction de la configuration matérielle et logicielle exacte d'un système, ainsi que de la charge de travail actuelle du système au moment de l'exécution des benchmarks.

Tous les benchmarks sont exécutés avec openvino Version du package Python 2025.1.0.

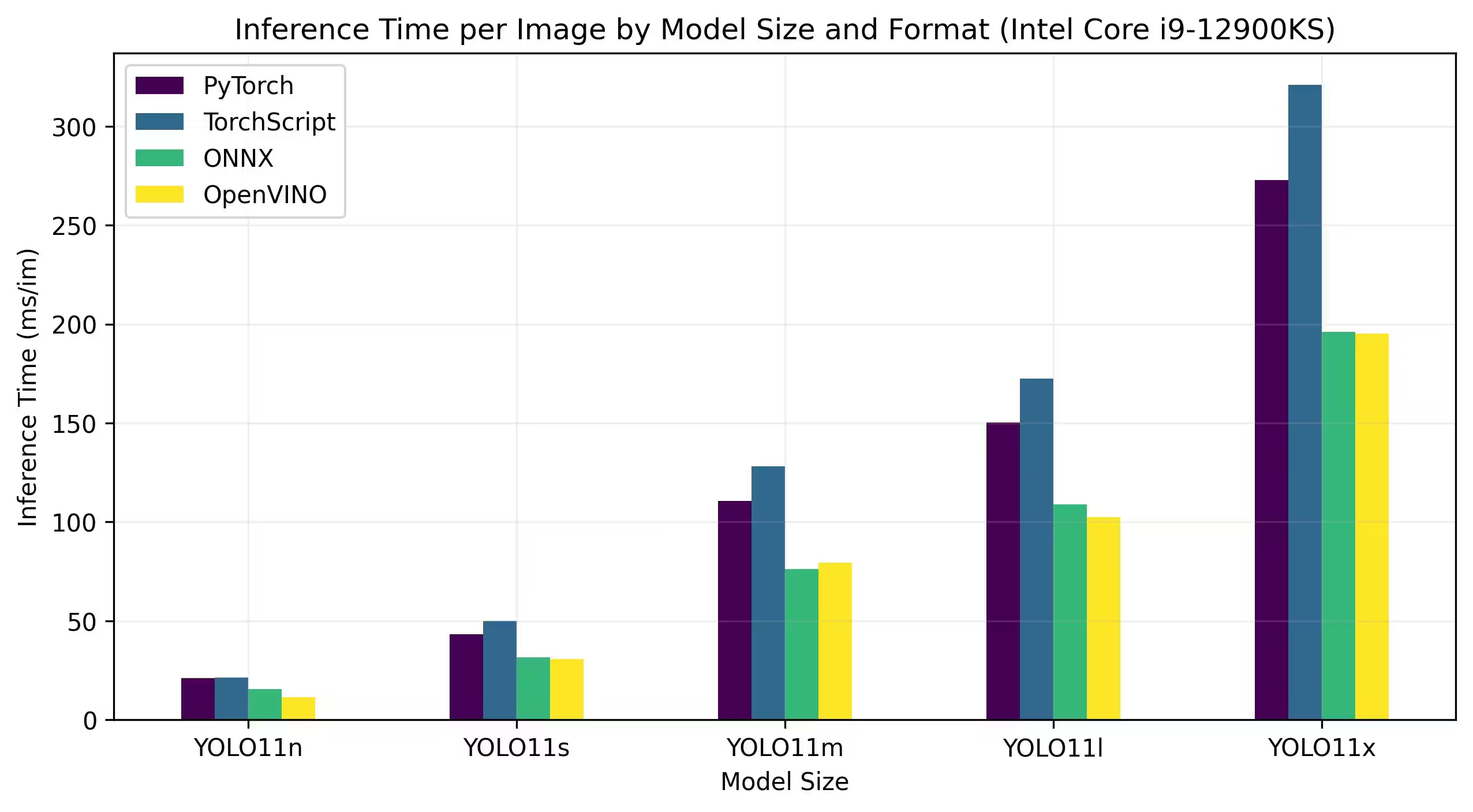

CPU Intel Core

La série Intel® Core® est une gamme de processeurs haute performance d'Intel. La gamme comprend les Core i3 (entrée de gamme), Core i5 (milieu de gamme), Core i7 (haut de gamme) et Core i9 (performances extrêmes). Chaque série répond à différents besoins informatiques et budgets, des tâches quotidiennes aux charges de travail professionnelles exigeantes. À chaque nouvelle génération, des améliorations sont apportées aux performances, à l'efficacité énergétique et aux fonctionnalités.

Les benchmarks ci-dessous sont exécutés sur un CPU Intel® Core® i9-12900KS de 12e génération avec une précision FP32.

Résultats détaillés des benchmarks

| Modèle | Format | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|

| YOLO11n | PyTorch | ✅ | 5.4 | 0.5071 | 21.00 |

| YOLO11n | TorchScript | ✅ | 10.5 | 0.5077 | 21.39 |

| YOLO11n | ONNX | ✅ | 10.2 | 0.5077 | 15.55 |

| YOLO11n | OpenVINO | ✅ | 10.4 | 0.5077 | 11.49 |

| YOLO11s | PyTorch | ✅ | 18.4 | 0.5770 | 43.16 |

| YOLO11s | TorchScript | ✅ | 36.6 | 0.5781 | 50.06 |

| YOLO11s | ONNX | ✅ | 36.3 | 0.5781 | 31.53 |

| YOLO11s | OpenVINO | ✅ | 36.4 | 0.5781 | 30.82 |

| YOLO11m | PyTorch | ✅ | 38.8 | 0.6257 | 110.60 |

| YOLO11m | TorchScript | ✅ | 77.3 | 0.6306 | 128.09 |

| YOLO11m | ONNX | ✅ | 76.9 | 0.6306 | 76.06 |

| YOLO11m | OpenVINO | ✅ | 77.1 | 0.6306 | 79.38 |

| YOLO11l | PyTorch | ✅ | 49.0 | 0.6367 | 150.38 |

| YOLO11l | TorchScript | ✅ | 97.7 | 0.6408 | 172.57 |

| YOLO11l | ONNX | ✅ | 97.0 | 0.6408 | 108.91 |

| YOLO11l | OpenVINO | ✅ | 97.3 | 0.6408 | 102.30 |

| YOLO11x | PyTorch | ✅ | 109.3 | 0.6989 | 272.72 |

| YOLO11x | TorchScript | ✅ | 218.1 | 0.6900 | 320.86 |

| YOLO11x | ONNX | ✅ | 217.5 | 0.6900 | 196.20 |

| YOLO11x | OpenVINO | ✅ | 217.8 | 0.6900 | 195.32 |

Intel® Core™ Ultra

La série Intel® Core™ Ultra™ représente une nouvelle référence en matière de calcul haute performance, conçue pour répondre aux demandes en constante évolution des utilisateurs modernes, des joueurs et des créateurs aux professionnels tirant parti de l'IA. Cette gamme de nouvelle génération est plus qu'une série de CPU traditionnelle ; elle combine de puissants cœurs de CPU, des capacités de GPU haute performance intégrées et une unité de traitement neuronal (NPU) dédiée au sein d'une seule puce, offrant une solution unifiée pour diverses charges de travail informatiques intensives.

Au cœur de l'architecture Intel® Core Ultra™ se trouve une conception hybride qui permet des performances exceptionnelles dans les tâches de traitement traditionnelles, les charges de travail accélérées par GPU et les opérations basées sur l'IA. L'inclusion du NPU améliore l'inférence de l'IA sur l'appareil, permettant un apprentissage automatique et un traitement des données plus rapides et plus efficaces dans un large éventail d'applications.

La famille Core Ultra™ comprend différents modèles adaptés aux différents besoins de performance, avec des options allant des conceptions écoénergétiques aux variantes haute puissance marquées par la désignation « H »—idéales pour les ordinateurs portables et les formats compacts qui exigent une puissance de calcul importante. Dans toute la gamme, les utilisateurs bénéficient de la synergie de l'intégration du CPU, du GPU et du NPU, offrant une efficacité, une réactivité et des capacités multitâches remarquables.

Dans le cadre de l'innovation continue d'Intel, la série Core Ultra™ établit une nouvelle norme pour l'informatique du futur. Avec de nombreux modèles disponibles et d'autres à venir, cette série souligne l'engagement d'Intel à fournir des solutions de pointe pour la prochaine génération d'appareils intelligents améliorés par l'IA.

Les benchmarks ci-dessous sont exécutés sur Intel® Core™ Ultra™ 7 258V et Intel® Core™ Ultra™ 7 265K avec une précision FP32 et INT8.

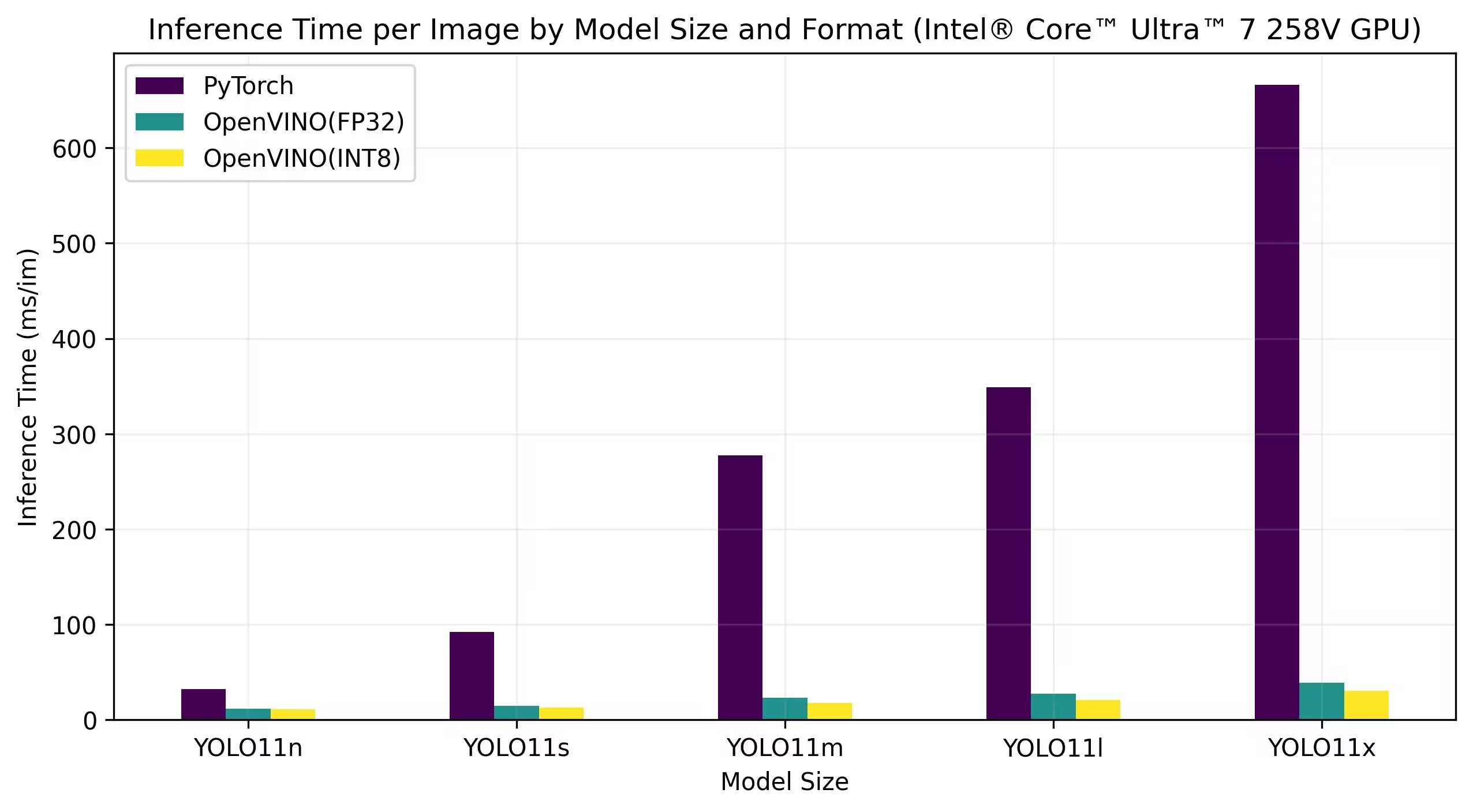

Intel® Core™ Ultra™ 7 258V

Bancs d'essai

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5068 | 11.84 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4969 | 11.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5797 | 14.82 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 12.88 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 22.94 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 17.85 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6365 | 27.34 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6242 | 20.83 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6890 | 39.09 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6856 | 30.60 |

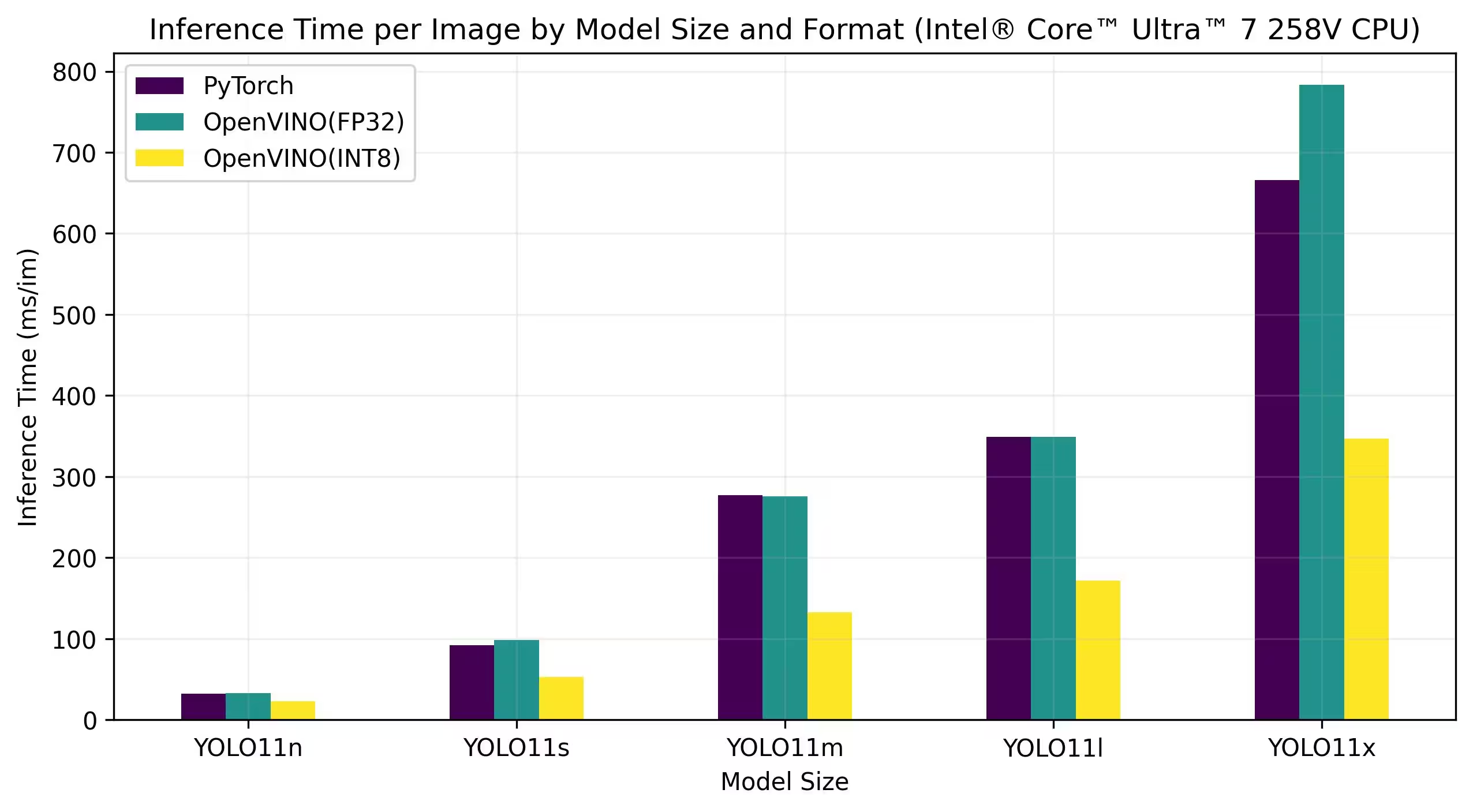

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 32.55 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 22.98 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 98.38 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 52.84 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 275.74 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 132.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 171.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 783.16 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 346.82 |

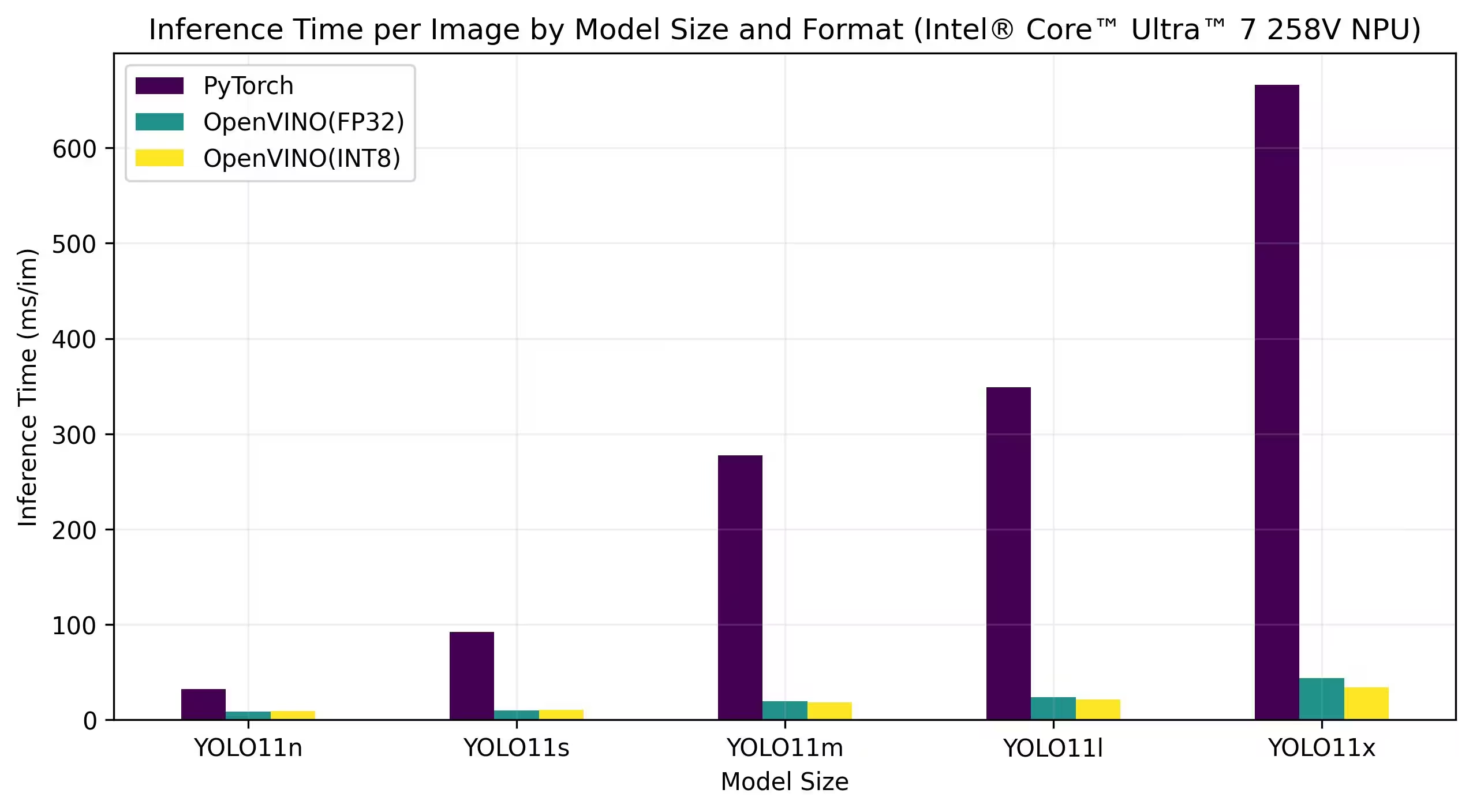

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5052 | 32.27 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5085 | 8.33 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.5019 | 8.91 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5776 | 92.09 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5788 | 9.72 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5710 | 10.58 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6262 | 277.24 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6301 | 19.41 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6124 | 18.26 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6361 | 348.97 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6362 | 23.70 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 21.40 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6984 | 666.07 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6892 | 43.91 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6890 | 34.04 |

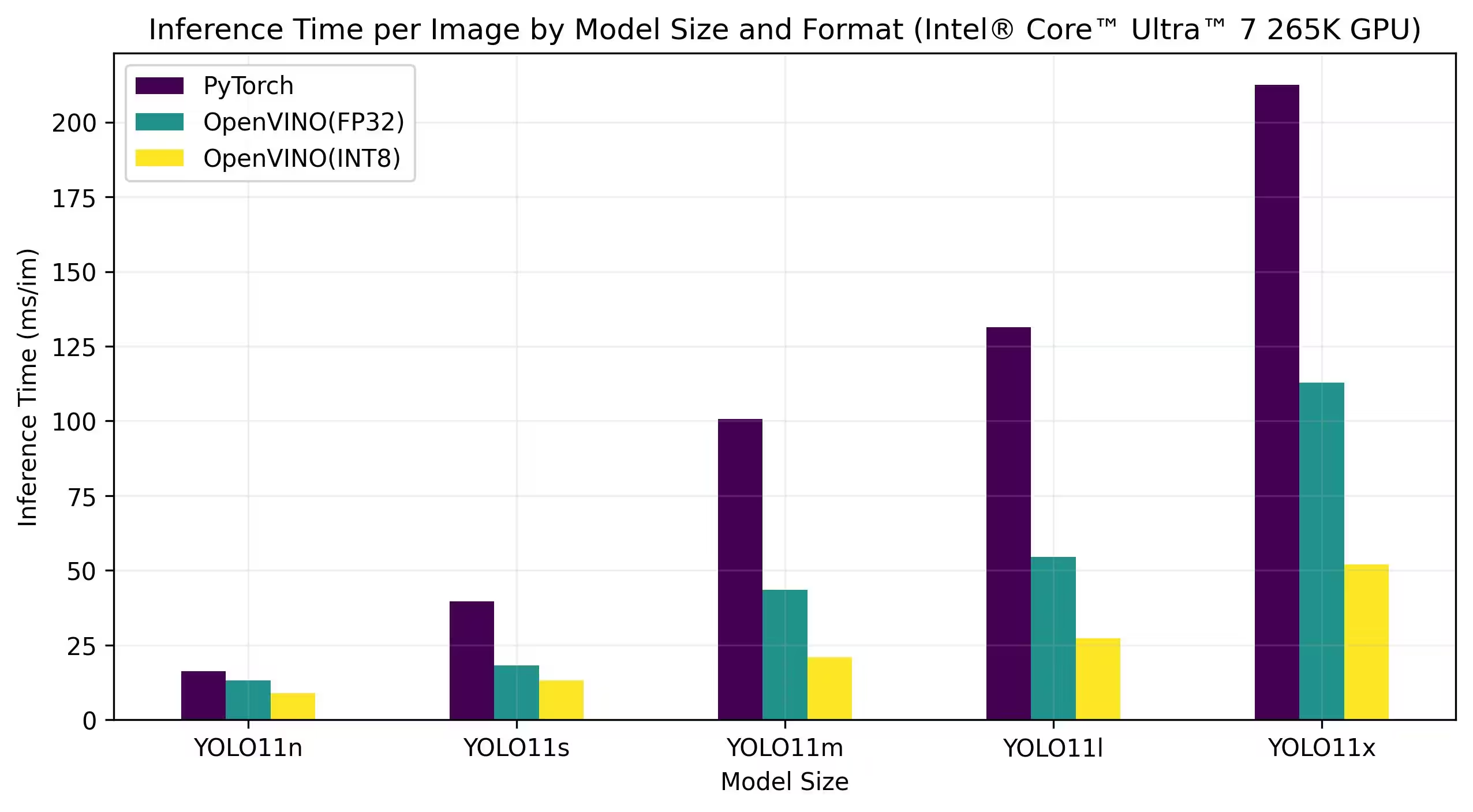

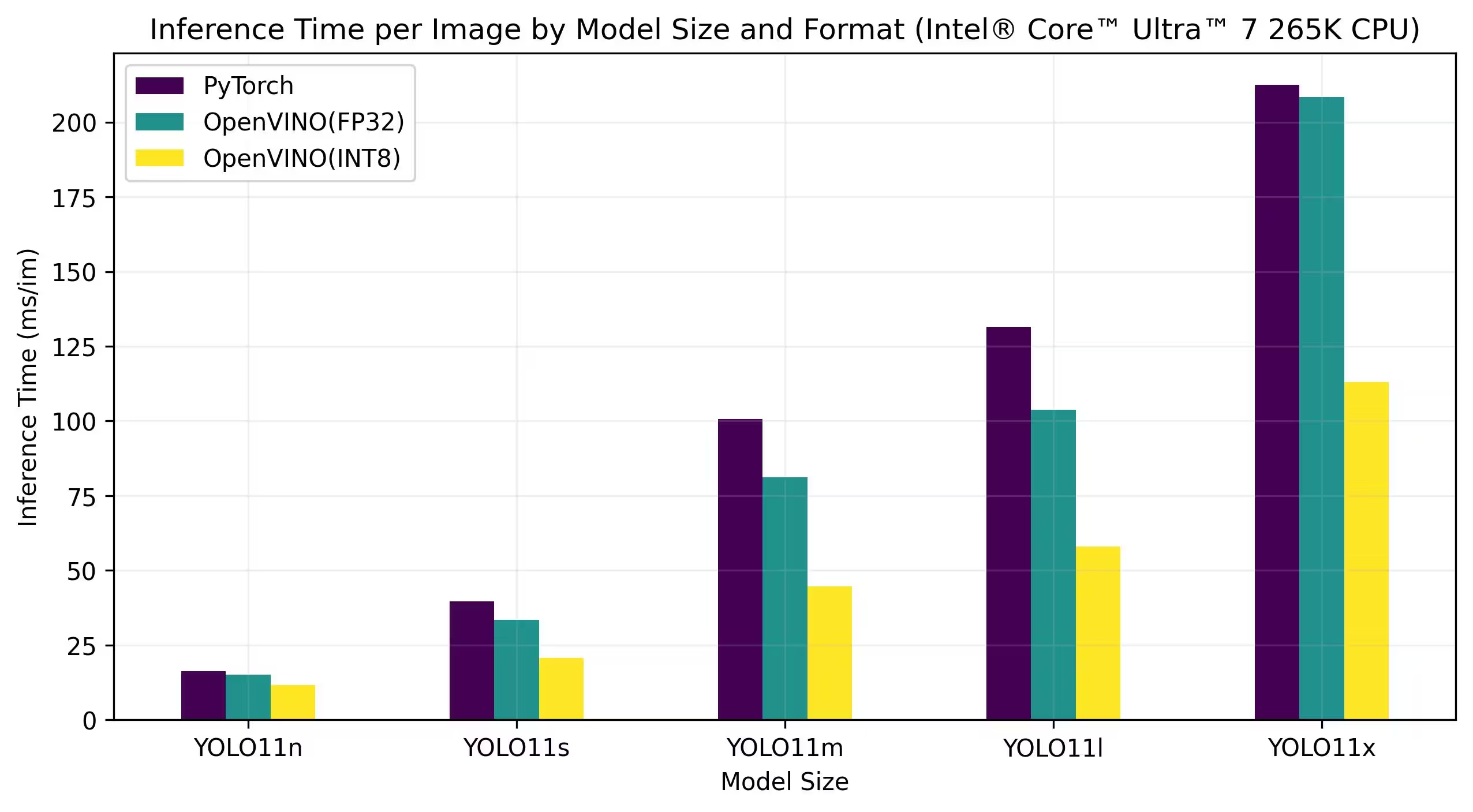

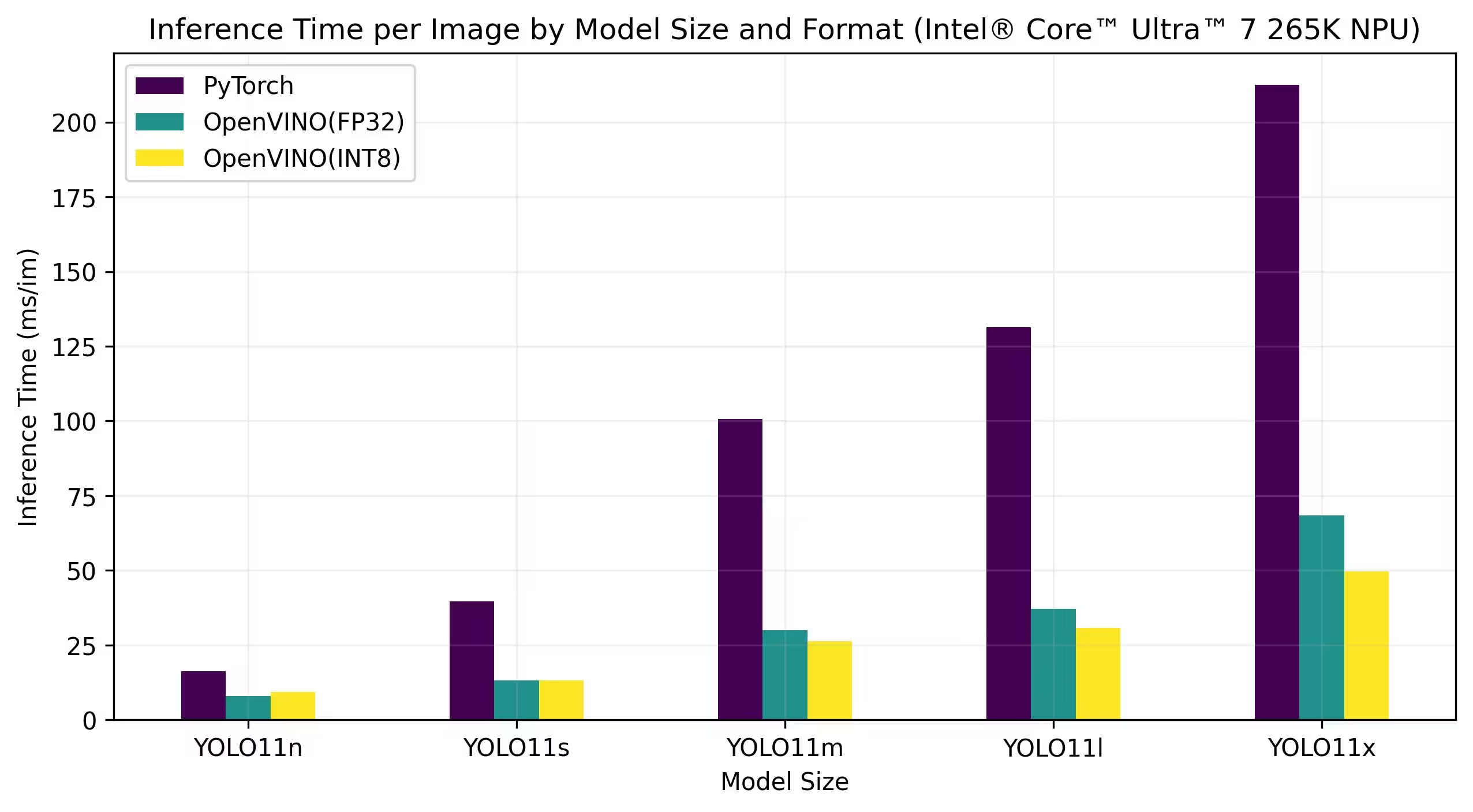

Intel® Core™ Ultra™ 7 265K

Bancs d'essai

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5079 | 13.13 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4976 | 8.86 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5808 | 18.26 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5726 | 13.24 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 43.50 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6137 | 20.90 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6371 | 54.52 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6226 | 27.36 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6884 | 112.76 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6900 | 52.06 |

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5077 | 15.04 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4980 | 11.60 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5782 | 33.45 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5745 | 20.64 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6307 | 81.15 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6172 | 44.63 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6409 | 103.77 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6240 | 58.00 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6900 | 208.37 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6897 | 113.04 |

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5075 | 8.02 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.3656 | 9.28 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5801 | 13.12 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5686 | 13.12 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6310 | 29.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6111 | 26.32 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6356 | 37.08 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6245 | 30.81 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6894 | 68.48 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6417 | 49.76 |

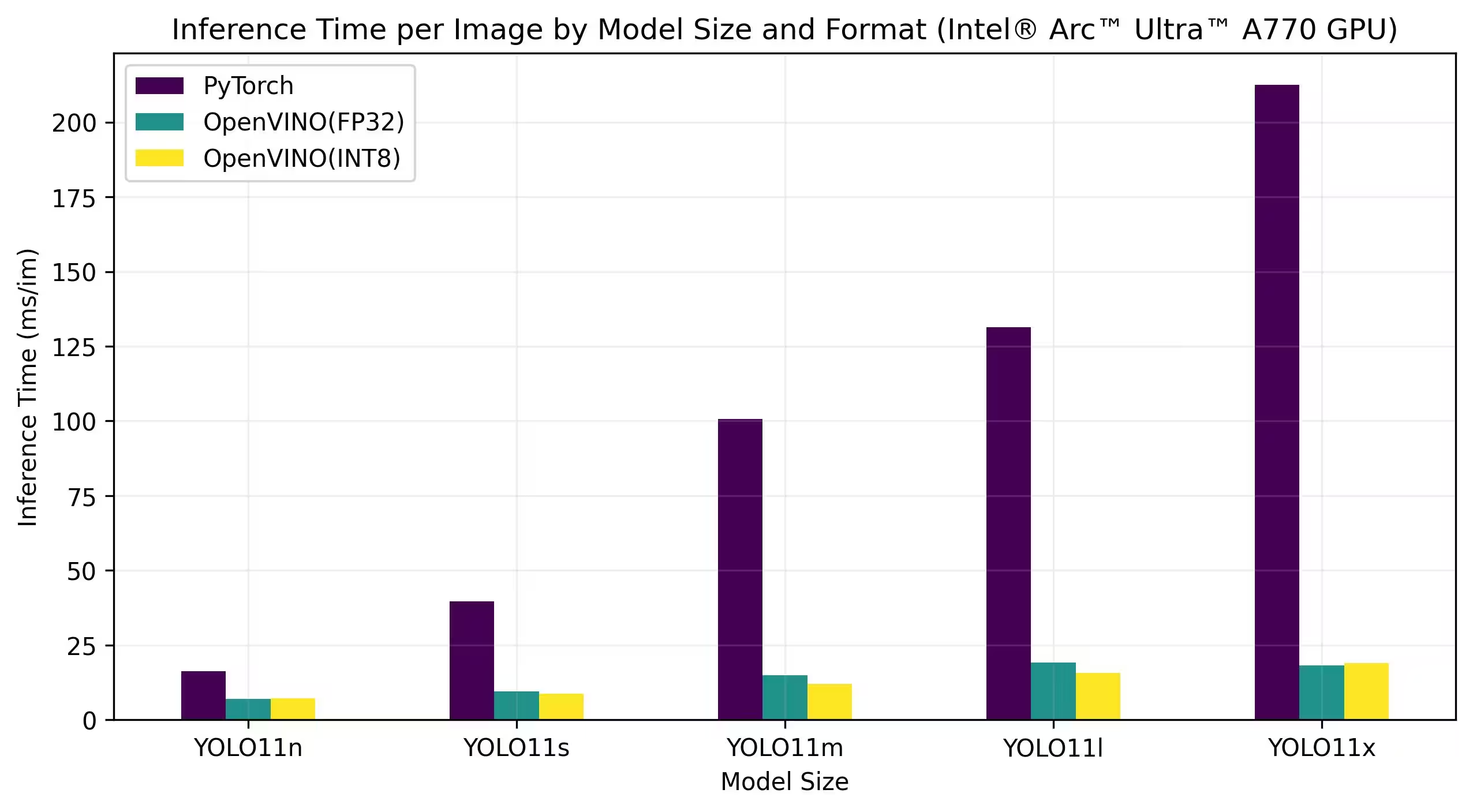

Intel® Arc GPU

Intel® Arc™ est la gamme de cartes graphiques discrètes d'Intel conçue pour les jeux à haute performance, la création de contenu et les charges de travail d'IA. La série Arc est dotée d'architectures GPU avancées qui prennent en charge le ray tracing en temps réel, les graphiques améliorés par l'IA et les jeux à haute résolution. En mettant l'accent sur la performance et l'efficacité, Intel® Arc™ vise à concurrencer d'autres grandes marques de GPU tout en offrant des fonctionnalités uniques comme l'encodage AV1 accéléré par le matériel et la prise en charge des dernières API graphiques.

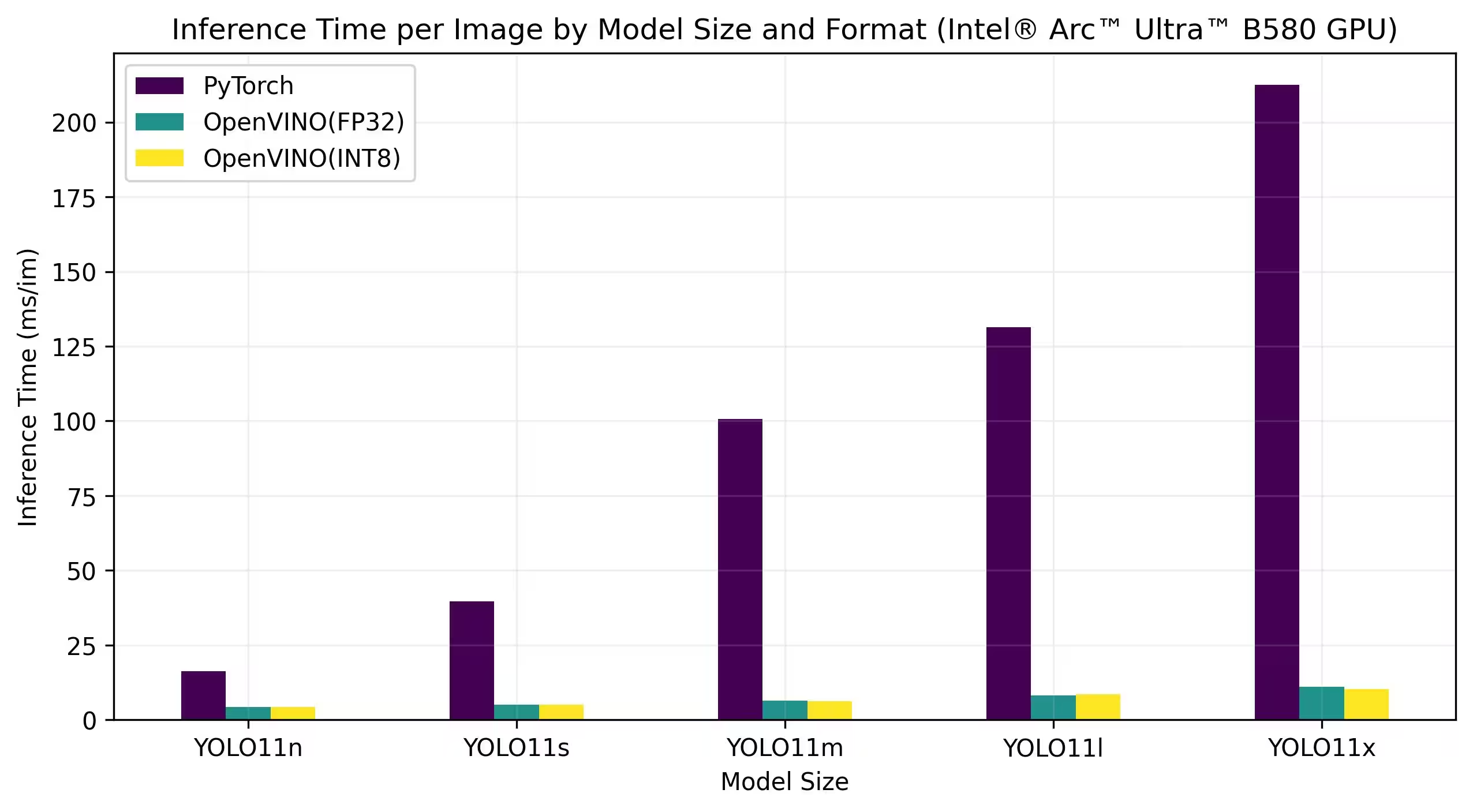

Les benchmarks ci-dessous sont exécutés sur Intel Arc A770 et Intel Arc B580 avec une précision FP32 et INT8.

Intel Arc A770

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5073 | 6.98 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4978 | 7.24 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5798 | 9.41 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5751 | 8.72 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6311 | 14.88 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6126 | 11.97 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6364 | 19.17 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6241 | 15.75 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6888 | 18.13 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6930 | 18.91 |

Intel Arc B580

Résultats détaillés des benchmarks

| Modèle | Format | Précision | Statut | Taille (Mo) | metrics/mAP50-95(B) | Temps d'inférence (ms/im) |

|---|---|---|---|---|---|---|

| YOLO11n | PyTorch | FP32 | ✅ | 5.4 | 0.5072 | 16.29 |

| YOLO11n | OpenVINO | FP32 | ✅ | 10.4 | 0.5072 | 4.27 |

| YOLO11n | OpenVINO | INT8 | ✅ | 3.3 | 0.4981 | 4.33 |

| YOLO11s | PyTorch | FP32 | ✅ | 18.4 | 0.5771 | 39.61 |

| YOLO11s | OpenVINO | FP32 | ✅ | 36.4 | 0.5789 | 5.04 |

| YOLO11s | OpenVINO | INT8 | ✅ | 9.8 | 0.5746 | 4.97 |

| YOLO11m | PyTorch | FP32 | ✅ | 38.8 | 0.6258 | 100.65 |

| YOLO11m | OpenVINO | FP32 | ✅ | 77.1 | 0.6306 | 6.45 |

| YOLO11m | OpenVINO | INT8 | ✅ | 20.2 | 0.6125 | 6.28 |

| YOLO11l | PyTorch | FP32 | ✅ | 49.0 | 0.6367 | 131.37 |

| YOLO11l | OpenVINO | FP32 | ✅ | 97.3 | 0.6360 | 8.23 |

| YOLO11l | OpenVINO | INT8 | ✅ | 25.7 | 0.6236 | 8.49 |

| YOLO11x | PyTorch | FP32 | ✅ | 109.3 | 0.6990 | 212.45 |

| YOLO11x | OpenVINO | FP32 | ✅ | 217.8 | 0.6889 | 11.10 |

| YOLO11x | OpenVINO | INT8 | ✅ | 55.9 | 0.6924 | 10.30 |

Reproduire nos résultats

Pour reproduire les benchmarks Ultralytics ci-dessus sur tous les formats d’exportation, exécutez ce code :

Exemple

from ultralytics import YOLO

# Load a YOLO11n PyTorch model

model = YOLO("yolo11n.pt")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

results = model.benchmark(data="coco128.yaml")

# Benchmark YOLO11n speed and accuracy on the COCO128 dataset for all export formats

yolo benchmark model=yolo11n.pt data=coco128.yaml

Notez que les résultats des benchmarks peuvent varier en fonction de la configuration matérielle et logicielle exacte d'un système, ainsi que de la charge de travail actuelle du système au moment où les benchmarks sont exécutés. Pour obtenir les résultats les plus fiables, utilisez un ensemble de données contenant un grand nombre d'images, c'est-à-dire data='coco.yaml' (5000 images de validation).

Conclusion

Les résultats d'analyse comparative démontrent clairement les avantages de l'exportation du modèle YOLO11 au format OpenVINO. Sur différents modèles et plateformes matérielles, le format OpenVINO surpasse systématiquement les autres formats en termes de vitesse d'inférence tout en conservant une précision comparable.

Les benchmarks soulignent l'efficacité d'OpenVINO en tant qu'outil de déploiement de modèles d'apprentissage profond. En convertissant les modèles au format OpenVINO, les développeurs peuvent obtenir des améliorations significatives des performances, ce qui facilite le déploiement de ces modèles dans des applications du monde réel.

Pour des informations et des instructions plus détaillées sur l'utilisation d'OpenVINO, consultez la documentation officielle d'OpenVINO.

FAQ

Comment exporter les modèles YOLO26 au format OpenVINO ?

L'exportation des modèles YOLO26 au format OpenVINO peut considérablement améliorer la vitesse du CPU et permettre des accélérations GPU et NPU sur le matériel Intel. Pour l'exportation, vous pouvez utiliser python ou la CLI comme indiqué ci-dessous :

Exemple

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Export the model

model.export(format="openvino") # creates 'yolo26n_openvino_model/'

# Export a YOLO26n PyTorch model to OpenVINO format

yolo export model=yolo26n.pt format=openvino # creates 'yolo26n_openvino_model/'

Pour plus d'informations, consultez la documentation sur les formats d'exportation.

Quels sont les avantages d'utiliser OpenVINO avec les modèles YOLO26 ?

L'utilisation du kit d'outils OpenVINO d'Intel avec les modèles YOLO26 offre plusieurs avantages :

- Performance : Obtenez une accélération jusqu'à 3x sur l'inférence CPU et exploitez les GPU et NPU Intel pour l'accélération.

- Optimiseur de modèle : Convertissez, optimisez et exécutez des modèles à partir de frameworks populaires tels que PyTorch, TensorFlow et ONNX.

- Facilité d'utilisation : Plus de 80 notebooks tutoriels sont disponibles pour aider les utilisateurs à démarrer, y compris ceux pour YOLO26.

- Exécution hétérogène : Déployez des modèles sur divers matériels Intel avec une API unifiée.

Pour des comparaisons de performances détaillées, consultez notre section benchmarks.

Comment exécuter l'inférence en utilisant un modèle YOLO26 exporté vers OpenVINO ?

Après avoir exporté un modèle YOLO26n au format OpenVINO, vous pouvez exécuter l'inférence en utilisant Python ou la CLI :

Exemple

from ultralytics import YOLO

# Load the exported OpenVINO model

ov_model = YOLO("yolo26n_openvino_model/")

# Run inference

results = ov_model("https://ultralytics.com/images/bus.jpg")

# Run inference with the exported model

yolo predict model=yolo26n_openvino_model source='https://ultralytics.com/images/bus.jpg'

Consultez notre documentation sur le mode predict pour plus de détails.

Pourquoi devrais-je choisir Ultralytics YOLO26 plutôt que d'autres modèles pour l'exportation OpenVINO ?

Ultralytics YOLO26 est optimisé pour la détection d'objets en temps réel avec une grande précision et rapidité. Plus précisément, lorsqu'il est combiné avec OpenVINO, YOLO26 offre :

- Jusqu'à 3x d'accélération sur les CPU Intel

- Déploiement transparent sur les GPU et NPU Intel

- Précision cohérente et comparable dans différents formats d'exportation

Pour une analyse approfondie des performances, consultez nos benchmarks YOLO11 détaillés sur différents matériels.

Puis-je comparer les modèles YOLO26 sur différents formats tels que PyTorch, ONNX et OpenVINO?

Oui, vous pouvez comparer les modèles YOLO26 dans différents formats, notamment PyTorch, TorchScript, ONNX et OpenVINO. Utilisez l'extrait de code suivant pour exécuter des tests de performance sur l'ensemble de données de votre choix :

Exemple

from ultralytics import YOLO

# Load a YOLO26n PyTorch model

model = YOLO("yolo26n.pt")

# Benchmark YOLO26n speed and [accuracy](https://www.ultralytics.com/glossary/accuracy) on the COCO8 dataset for all export formats

results = model.benchmark(data="coco8.yaml")

# Benchmark YOLO26n speed and accuracy on the COCO8 dataset for all export formats

yolo benchmark model=yolo26n.pt data=coco8.yaml

Pour des résultats de benchmark détaillés, consultez notre section benchmarks et la documentation sur les formats d'exportation.