Plataforma Ultralytics

A Ultralytics Platform é uma plataforma abrangente de visão computacional de ponta a ponta que otimiza todo o fluxo de trabalho de ML, desde a preparação de dados até a implementação do modelo. Desenvolvida para equipes e indivíduos que precisam de soluções de visão computacional prontas para produção, sem a complexidade da infraestrutura.

O que é a Ultralytics Platform?

A Ultralytics Platform foi projetada para substituir ferramentas de ML fragmentadas por uma solução unificada. Ela combina as capacidades de:

- Roboflow - Gerenciamento de dados e anotação

- Weights & Biases - Rastreamento de experimentos

- SageMaker - Treinamento em nuvem

- HuggingFace - Implementação de modelos

- Arize - Monitoramento

Plataforma completa com suporte nativo para YOLO11 YOLO26 e YOLO11 .

Fluxo de trabalho: Carregar → Anotar → Treinar → Exportar → Implementar

A Plataforma oferece um fluxo de trabalho completo:

graph LR

subgraph Data["📁 Data"]

A[Upload] --> B[Annotate]

B --> C[Analyze]

end

subgraph Train["🚀 Train"]

D[Configure] --> E[Train on GPU]

E --> F[View Metrics]

end

subgraph Deploy["🌐 Deploy"]

G[Export] --> H[Deploy Endpoint]

H --> I[Monitor]

end

Data --> Train --> Deploy| Etapa | Recursos |

|---|---|

| Carregar | Imagens (50 MB), vídeos (1 GB), arquivos ZIP (50 GB) com processamento automático |

| Anotar | Ferramentas manuais, anotação SAM , YOLO para todos os 5 tipos de tarefas |

| Treinar | GPUs na nuvem (RTX 4090 a H200), métricas em tempo real, organização de projetos |

| Exportar | 17 formatos de implementação (ONNX, TensorRT, CoreML, TFLite, etc.) |

| Implantação | 43 regiões globais com pontos finais dedicados, dimensionamento automático e monitorização |

O que pode fazer:

- Carregue imagens, vídeos e arquivos ZIP para criar conjuntos de dados de treino

- Visualize anotações com sobreposições interativas para todos os 5 tipos YOLO

- Treine modelos em GPUs na nuvem (RTX 4090 a H200) com métricas em tempo real

- Exportar para 17 formatos de implementação (ONNX, TensorRT, CoreML, TFLite, etc.)

- Implemente em 43 regiões globais com terminais dedicados com um clique

- Monitorize o progresso da formação, a integridade da implementação e as métricas de utilização

- Colabore tornando projetos e conjuntos de dados públicos para a comunidade

Infraestrutura Multirregional

Seus dados permanecem na sua região. A Ultralytics Platform opera sua infraestrutura em três regiões globais:

| Região | Localização | Ideal Para |

|---|---|---|

| EUA | Iowa, EUA | Utilizadores das Américas, mais rápido para as Américas |

| UE | Bélgica, Europa | Usuários europeus, conformidade com GDPR |

| AP | Taiwan, Ásia-Pacífico | Utilizadores da Ásia-Pacífico, menor latência na região APAC |

Você seleciona sua região durante o processo de integração, e todos os seus dados, modelos e implementações permanecem nessa região.

Principais Características

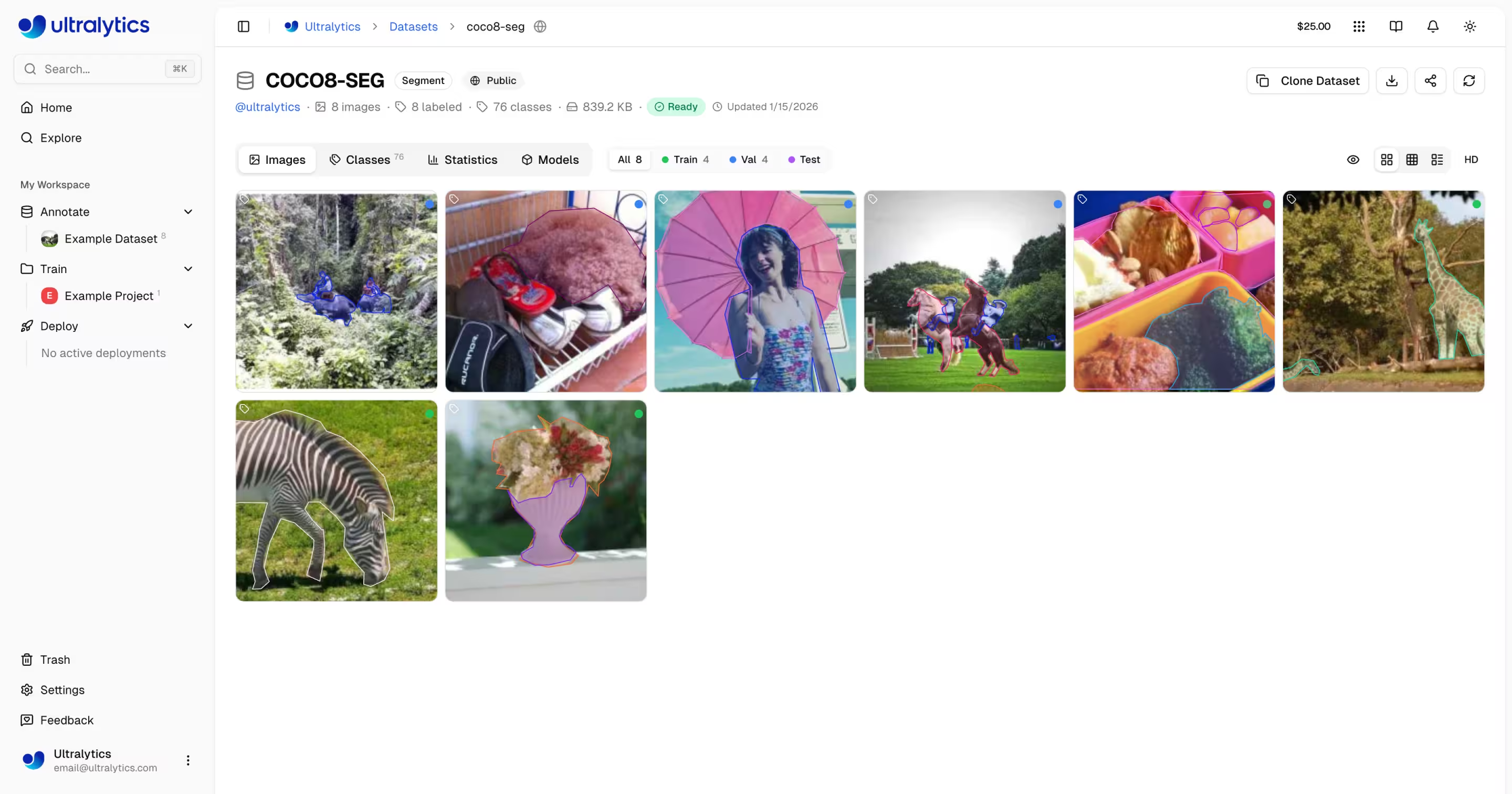

Preparação de Dados

- Gerenciamento de Dataset: Upload de imagens, vídeos ou arquivos ZIP com processamento automático

- Editor de Anotação: Anotação manual para todos os 5 tipos de tarefas YOLO (detect, segment, pose, obb, classify)

- Anotação Inteligente SAM: Anotação inteligente baseada em cliques usando o Segment Anything Model

- Autoanotação: Use modelos treinados para pré-rotular novos dados

- Estatísticas: Distribuição de classes, mapas de calor de localização e análise de dimensões

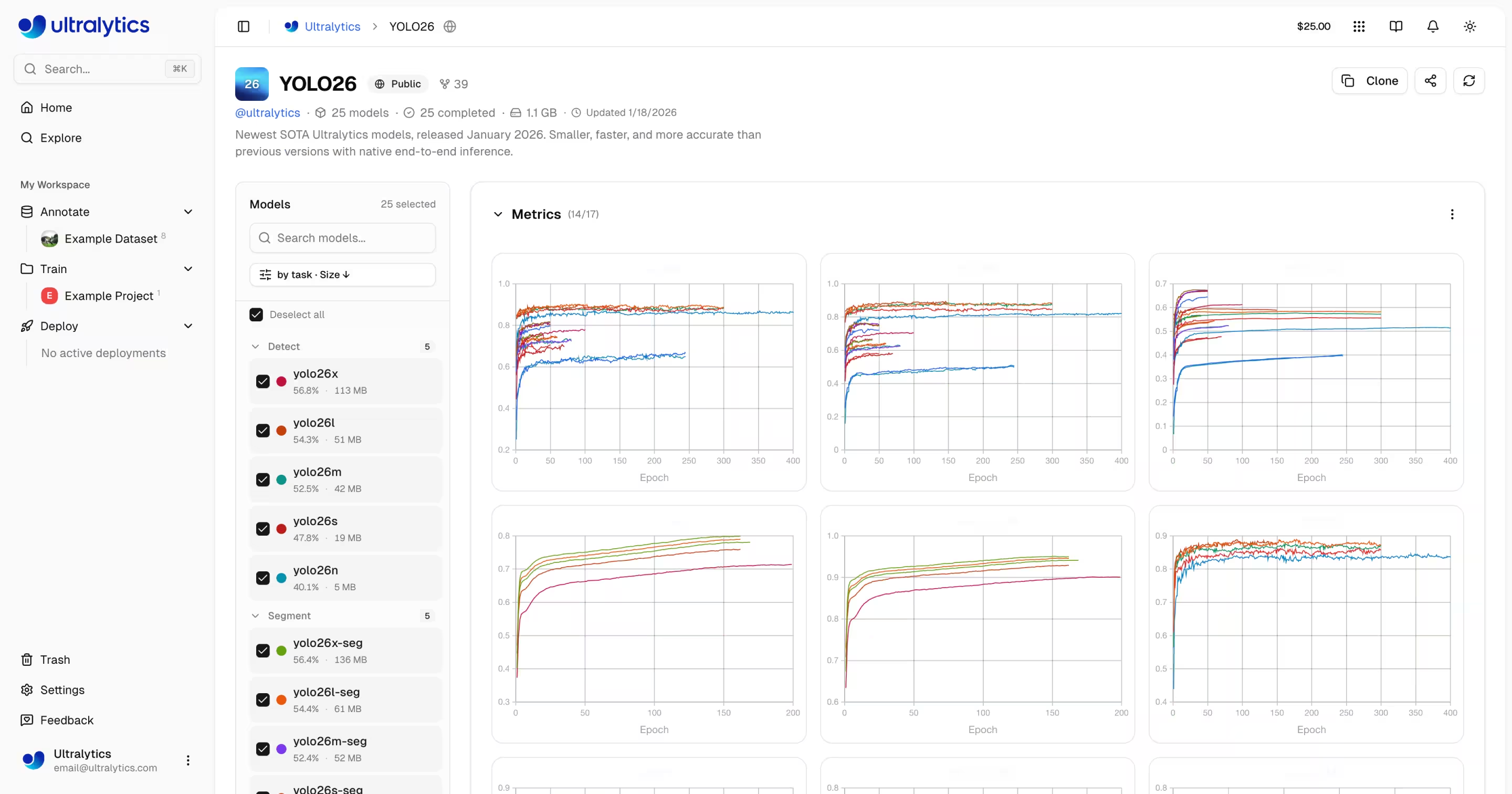

Treinamento de Modelos

- Treinamento em Nuvem: Treine em GPUs de nuvem (RTX 4090, A100, H100) com métricas em tempo real

- Treinamento Remoto: Treine em qualquer lugar e transmita métricas para a Plataforma (estilo W&B)

- Organização de Projetos: Agrupe modelos relacionados, compare experimentos e track atividades

- 17 Formatos de Exportação: ONNX, TensorRT, CoreML, TFLite e mais

Implantação

- Teste de Inferência: Teste modelos diretamente no navegador com imagens personalizadas

- Endpoints Dedicados: Implante em 43 regiões globais com autoescalabilidade

- Monitoramento: Métricas em tempo real, logs de requisição e painéis de desempenho

Gerenciamento de Conta

- Chaves de API: Gerenciamento seguro de chaves para treinamento remoto e acesso à API

- Créditos e Faturamento: Treinamento pay-as-you-go com preços transparentes

- Feed de atividades: acompanhe todos os eventos e ações da conta

- Lixeira e restauração: exclusão temporária por 30 dias com recuperação de itens

- Conformidade com GDPR: Exportação de dados e exclusão de conta

Links Rápidos

Comece com estes recursos:

- Início Rápido: Crie seu primeiro projeto e treine um modelo em minutos

- Conjuntos de Dados: Carregue e gerencie seus dados de treinamento

- Anotação: Rotule seus dados com ferramentas manuais e assistidas por IA

- Projetos: Organize seus modelos e experimentos

- Treinamento na Nuvem: Treine em GPUs na nuvem

- Inferência: Teste seus modelos

- Endpoints: Implante modelos em produção

- Monitoramento: Acompanhar o desempenho da implantação

- Chaves de API: Gerencie o acesso à API

- Faturamento: Créditos e pagamento

- Atividade: Acompanhar eventos da conta

- Lixo: Recuperar itens eliminados

- REST API: Referência da API

FAQ

Como começar com a Ultralytics Platform?

Para começar com a Plataforma Ultralytics:

- Cadastre-se: Crie uma conta em platform.ultralytics.com

- Selecione a Região: Escolha sua região de dados (EUA, UE ou AP) durante o processo de integração

- Carregar Conjunto de Dados: Navegue até a seção Conjuntos de Dados para carregar seus dados

- Treinar Modelo: Crie um projeto e comece a treinar em GPUs na nuvem

- Implementar: Teste seu modelo e implemente em um endpoint dedicado

Para um guia detalhado, consulte a página Início Rápido.

Quais são os benefícios da Ultralytics Platform?

Plataforma Ultralytics oferece:

- Fluxo de Trabalho Unificado: Dados, treinamento e implementação em um só lugar

- Multirregião: Residência de dados nas regiões dos EUA, UE ou AP

- Treinamento Sem Código: Treine modelos YOLO avançados sem escrever código

- Métricas em Tempo Real: Transmita o progresso do treinamento e monitore as implementações

- 43 Regiões de Implementação: Implemente modelos perto de seus usuários em todo o mundo

- 5 Tipos de Tarefa: Suporte para detect, segment, pose, obb e classificação

- Anotação Assistida por IA: SAM e rotulagem automática para acelerar a preparação de dados

Quais opções de GPU estão disponíveis para treinamento em nuvem?

A Plataforma Ultralytics suporta vários tipos de GPU para treinamento em nuvem:

| Nível | GPU | VRAM | Custo/Hora | Ideal Para |

|---|---|---|---|---|

| Orçamento | RTX A2000 | 6 GB | $0.12 | Pequenos conjuntos de dados, testes |

| Orçamento | RTX 3080 | 10 GB | $0.25 | Conjuntos de dados médios |

| Orçamento | RTX 3080 Ti | 12 GB | $0.30 | Conjuntos de dados médios |

| Orçamento | A30 | 24 GB | $0.44 | Lotes maiores |

| Meio | RTX 4090 | 24 GB | $0.60 | Excelente relação preço/desempenho |

| Meio | A6000 | 48 GB | $0.90 | Modelos grandes |

| Meio | L4 | 24 GB | $0.54 | Inferência otimizada |

| Meio | L40S | 48 GB | $1.72 | Treinamento em grandes lotes |

| Pro | A100 40GB | 40 GB | $2.78 | Formação em produção |

| Pro | A100 80GB | 80 GB | $3.44 | Modelos muito grandes |

| Pro | H100 | 80 GB | $5.38 | Treino mais rápido |

| Empresarial | H200 | 141 GB | $5.38 | Desempenho máximo |

| Empresarial | B200 | 192 GB | $10.38 | Modelos maiores |

| Ultralytics | RTX PRO 6000 | 48 GB | $3.68 | Ultralytics |

Consulte Formação em nuvem para obter informações completas sobre preços e GPU .

Como funciona o treinamento remoto?

Você pode treinar modelos em qualquer lugar e transmitir métricas para a Plataforma.

Requisito de Versão do Pacote

A integração da plataforma requer ultralytics>=8.4.0. Versões anteriores NÃO funcionarão com a Plataforma.

pip install "ultralytics>=8.4.0"

# Set your API key

export ULTRALYTICS_API_KEY="your_api_key"

# Train with project/name to stream metrics

yolo train model=yolo26n.pt data=coco.yaml epochs=100 project=username/my-project name=exp1

Consulte Treinamento em Nuvem para mais detalhes sobre treinamento remoto.

Quais ferramentas de anotação estão disponíveis?

A Plataforma inclui um editor de anotação completo com suporte para:

- Ferramentas Manuais: Caixas delimitadoras, polígonos, pontos-chave, caixas orientadas, classificação

- Anotação Inteligente SAM: Clique para gerar máscaras precisas usando o Segment Anything Model

- YOLO Autoanotação: Utilize modelos treinados para pré-rotular imagens

- Atalhos de Teclado: Fluxos de trabalho eficientes com teclas de atalho

Consulte Anotação para o guia completo.

Resolução de Problemas

Problemas com conjuntos de dados

| Problema | Solução |

|---|---|

| O conjunto de dados não será processado | Verifique se o formato do ficheiro é compatível (JPEG, PNG, WebP, etc.). Tamanho máximo do ficheiro: imagens 50 MB, vídeos 1 GB, ZIP 50 GB |

| Anotações em falta | Verifique se as etiquetas estão no YOLO com .txt ficheiros correspondentes aos nomes dos ficheiros de imagem |

| "É necessário dividir o comboio" | Adicionar train/ pasta à estrutura do seu conjunto de dados ou crie divisões nas definições do conjunto de dados |

| Nomes de classes indefinidos | Adicionar um data.yaml arquivo com names: listar ou definir classes nas configurações do conjunto de dados |

Questões relacionadas com a formação

| Problema | Solução |

|---|---|

| O treino não vai começar | Verifique o saldo de crédito em Configurações > Faturação. É necessário um saldo mínimo de US$ 5,00. |

| Erro de memória insuficiente | Reduza o tamanho do lote, use um modelo menor (n/s) ou selecione GPU mais VRAM |

| Métricas deficientes | Verifique a qualidade do conjunto de dados, aumente os períodos, tente aumentar os dados, verifique o equilíbrio das classes |

| Treinamento lento | Selecione GPU mais rápida, reduza o tamanho da imagem, verifique se o conjunto de dados não está sobrecarregado |

Problemas de implementação

| Problema | Solução |

|---|---|

| Terminal não responde | Verifique o estado do ponto final (em execução ou parado). O arranque a frio pode demorar de 2 a 5 segundos. |

| 401 Não autorizado | Verifique se a chave API está correta e possui os escopos necessários |

| Inferência lenta | Verifique o tamanho do modelo, considere TensorRT , selecione uma região mais próxima |

| Falha na exportação | Alguns formatos requerem arquiteturas de modelo específicas. Experimente ONNX obter a mais ampla compatibilidade. |

Perguntas frequentes

Posso alterar o meu nome de utilizador após o registo?

Não, os nomes de utilizador são permanentes e não podem ser alterados. Escolha com cuidado durante o registo.

Posso alterar a minha região de dados?

Não, a região dos dados é selecionada durante a inscrição e não pode ser alterada. Para mudar de região, crie uma nova conta e reenvie os seus dados.

Como posso obter mais créditos?

Vá para Configurações > Faturamento > Adicionar créditos. Compre créditos de US$ 5 a US$ 1000. Os créditos comprados nunca expiram.

O que acontece se o treinamento falhar?

Você só é cobrado pelo tempo de computação concluído. Os pontos de verificação são salvos e você pode retomar o treinamento.

Posso baixar meu modelo treinado?

Sim, clique no ícone de download em qualquer página de modelo para fazer o download do .pt arquivo ou formatos exportados.

Como posso partilhar o meu trabalho publicamente?

Edite as configurações do seu projeto ou conjunto de dados e altere a visibilidade para «Público». O conteúdo público aparece na página Explorar.

Quais são os limites de tamanho dos ficheiros?

Imagens: 50 MB, vídeos: 1 GB, arquivos ZIP: 50 GB. Para ficheiros maiores, divida em vários uploads.

Por quanto tempo os itens eliminados ficam na Lixeira?

30 dias. Depois disso, os itens são eliminados permanentemente e não podem ser recuperados.

Posso usar os modelos da Plataforma comercialmente?

Os planos Free e Pro utilizam a licença AGPL. Para uso comercial sem os requisitos da AGPL, entre em contacto comultralytics para obter uma licença Enterprise.