实例分割

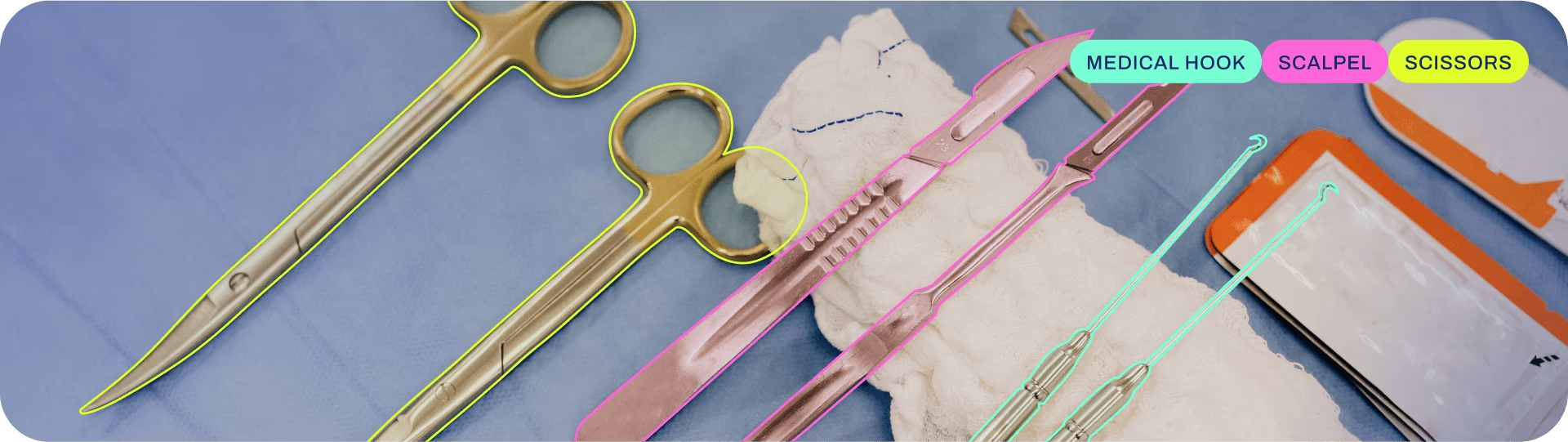

实例分割比对象检测更进一步,包括识别图像中的各个对象并将它们与图像的其余部分分割开来。

实例分割模型的输出是一组掩码或轮廓,它们勾勒出图像中每个对象,以及每个对象的类别标签和置信度分数。 当您不仅需要知道对象在图像中的位置,还需要知道它们的精确形状时,实例分割非常有用。

观看: 使用预训练的Ultralytics YOLO模型在Python中运行分割。

提示

YOLO26 Segment模型使用 -seg 后缀,即 yolo26n-seg.pt,并在...上进行预训练 COCO.

模型

此处显示YOLO26预训练的Segment模型。Detect、Segment和姿势估计模型在COCO数据集上进行了预训练,而Classify模型在ImageNet数据集上进行了预训练。

模型 首次使用时会自动从最新的 Ultralytics 版本 下载。

| 模型 | 尺寸 (像素) | mAPbox 50-95(e2e) | mAPmask 50-95(e2e) | 速度 CPU ONNX (毫秒) | 速度 T4 TensorRT10 (毫秒) | 参数 (M) | FLOPs (B) |

|---|---|---|---|---|---|---|---|

| YOLO26n-seg | 640 | 39.6 | 33.9 | 53.3 ± 0.5 | 2.1 ± 0.0 | 2.7 | 9.1 |

| YOLO26s-seg | 640 | 47.3 | 40.0 | 118.4 ± 0.9 | 3.3 ± 0.0 | 10.4 | 34.2 |

| YOLO26m-seg | 640 | 52.5 | 44.1 | 328.2 ± 2.4 | 6.7 ± 0.1 | 23.6 | 121.5 |

| YOLO26l-seg | 640 | 54.4 | 45.5 | 387.0 ± 3.7 | 8.0 ± 0.1 | 28.0 | 139.8 |

| YOLO26x-seg | 640 | 56.5 | 47.0 | 787.0 ± 6.8 | 16.4 ± 0.1 | 62.8 | 313.5 |

- mAPval 数值为单模型单尺度下的结果,基于 COCO val2017 数据集上单模型多尺度测试的结果。

如需重现结果,请通过yolo val segment data=coco.yaml device=0 - 速度 在 COCO 验证图像上平均,使用一个 Amazon EC2 P4d 实例进行平均计算得出的。

如需重现结果,请通过yolo val segment data=coco.yaml batch=1 device=0|cpu - 参数 和 FLOPs 值适用于融合后的模型

model.fuse()该架构融合了Conv层与BatchNorm层,并针对端到端模型移除了辅助的一对多检测头。预训练检查点保留了完整的训练架构,可能显示更高的计数值。

训练

在 COCO8-seg 数据集上,以 640 的图像尺寸训练 YOLO26n-seg 模型 100 个 epoch。有关可用参数的完整列表,请参阅配置页面。

示例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.yaml") # build a new model from YAML

model = YOLO("yolo26n-seg.pt") # load a pretrained model (recommended for training)

model = YOLO("yolo26n-seg.yaml").load("yolo26n.pt") # build from YAML and transfer weights

# Train the model

results = model.train(data="coco8-seg.yaml", epochs=100, imgsz=640)

# Build a new model from YAML and start training from scratch

yolo segment train data=coco8-seg.yaml model=yolo26n-seg.yaml epochs=100 imgsz=640

# Start training from a pretrained *.pt model

yolo segment train data=coco8-seg.yaml model=yolo26n-seg.pt epochs=100 imgsz=640

# Build a new model from YAML, transfer pretrained weights to it and start training

yolo segment train data=coco8-seg.yaml model=yolo26n-seg.yaml pretrained=yolo26n-seg.pt epochs=100 imgsz=640

数据集格式

YOLO segment 数据集格式的详细信息可在数据集指南中找到。要将您现有的数据集从其他格式(如 COCO 等)转换为 YOLO 格式,请使用 Ultralytics 提供的JSON2YOLO工具。

验证

验证训练好的 YOLO26n-seg 模型 准确性 在 COCO8 segment 数据集上。无需任何参数,因为 model 保留其训练 data 和参数作为模型属性,因此无需任何参数。

示例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom model

# Validate the model

metrics = model.val() # no arguments needed, dataset and settings remembered

metrics.box.map # map50-95(B)

metrics.box.map50 # map50(B)

metrics.box.map75 # map75(B)

metrics.box.maps # a list containing mAP50-95(B) for each category

metrics.seg.map # map50-95(M)

metrics.seg.map50 # map50(M)

metrics.seg.map75 # map75(M)

metrics.seg.maps # a list containing mAP50-95(M) for each category

yolo segment val model=yolo26n-seg.pt # val official model

yolo segment val model=path/to/best.pt # val custom model

预测

使用训练好的 YOLO26n-seg 模型对图像运行预测。

示例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom model

# Predict with the model

results = model("https://ultralytics.com/images/bus.jpg") # predict on an image

# Access the results

for result in results:

xy = result.masks.xy # mask in polygon format

xyn = result.masks.xyn # normalized

masks = result.masks.data # mask in matrix format (num_objects x H x W)

yolo segment predict model=yolo26n-seg.pt source='https://ultralytics.com/images/bus.jpg' # predict with official model

yolo segment predict model=path/to/best.pt source='https://ultralytics.com/images/bus.jpg' # predict with custom model

查看完整 predict 模式的详细信息,请参阅 预测 页面。

导出

将 YOLO26n-seg 模型导出为 ONNX、CoreML 等不同格式。

示例

from ultralytics import YOLO

# Load a model

model = YOLO("yolo26n-seg.pt") # load an official model

model = YOLO("path/to/best.pt") # load a custom-trained model

# Export the model

model.export(format="onnx")

yolo export model=yolo26n-seg.pt format=onnx # export official model

yolo export model=path/to/best.pt format=onnx # export custom-trained model

可用的 YOLO26-seg 导出格式如下表所示。您可以使用以下方式导出为任何格式 format 参数,即 format='onnx' 或 format='engine'。您可以直接在导出模型上进行预测或验证,即 yolo predict model=yolo26n-seg.onnx。导出完成后,将显示您的模型的使用示例。

| 格式 | format 参数 | 模型 | 元数据 | 参数 |

|---|---|---|---|---|

| PyTorch | - | yolo26n-seg.pt | ✅ | - |

| TorchScript | torchscript | yolo26n-seg.torchscript | ✅ | imgsz, half, dynamic, optimize, nms, batch, device |

| ONNX | onnx | yolo26n-seg.onnx | ✅ | imgsz, half, dynamic, simplify, opset, nms, batch, device |

| OpenVINO | openvino | yolo26n-seg_openvino_model/ | ✅ | imgsz, half, dynamic, int8, nms, batch, data, fraction, device |

| TensorRT | engine | yolo26n-seg.engine | ✅ | imgsz, half, dynamic, simplify, workspace, int8, nms, batch, data, fraction, device |

| CoreML | coreml | yolo26n-seg.mlpackage | ✅ | imgsz, dynamic, half, int8, nms, batch, device |

| TF SavedModel | saved_model | yolo26n-seg_saved_model/ | ✅ | imgsz, keras, int8, nms, batch, device |

| TF GraphDef | pb | yolo26n-seg.pb | ❌ | imgsz, batch, device |

| TF Lite | tflite | yolo26n-seg.tflite | ✅ | imgsz, half, int8, nms, batch, data, fraction, device |

| TF Edge TPU | edgetpu | yolo26n-seg_edgetpu.tflite | ✅ | imgsz, device |

| TF.js | tfjs | yolo26n-seg_web_model/ | ✅ | imgsz, half, int8, nms, batch, device |

| PaddlePaddle | paddle | yolo26n-seg_paddle_model/ | ✅ | imgsz, batch, device |

| MNN | mnn | yolo26n-seg.mnn | ✅ | imgsz, batch, int8, half, device |

| NCNN | ncnn | yolo26n-seg_ncnn_model/ | ✅ | imgsz, half, batch, device |

| IMX500 | imx | yolo26n-seg_imx_model/ | ✅ | imgsz, int8, data, fraction, device |

| RKNN | rknn | yolo26n-seg_rknn_model/ | ✅ | imgsz, batch, name, device |

| ExecuTorch | executorch | yolo26n-seg_executorch_model/ | ✅ | imgsz, device |

| Axelera | axelera | yolo26n-seg_axelera_model/ | ✅ | imgsz, int8, data, fraction, device |

查看完整 export 详情请参见 导出 页面。

常见问题

如何在自定义数据集上训练YOLO26分割模型?

要在自定义数据集上训练 YOLO26 分割模型,您首先需要将数据集准备为 YOLO 分割格式。您可以使用 JSON2YOLO 等工具从其他格式转换数据集。数据集准备好后,您可以使用 python 或 CLI 命令训练模型:

示例

from ultralytics import YOLO

# Load a pretrained YOLO26 segment model

model = YOLO("yolo26n-seg.pt")

# Train the model

results = model.train(data="path/to/your_dataset.yaml", epochs=100, imgsz=640)

yolo segment train data=path/to/your_dataset.yaml model=yolo26n-seg.pt epochs=100 imgsz=640

请查看配置页面以获取更多可用参数。

YOLO26 中 目标检测 和实例分割有什么区别?

目标检测通过在图像中绘制边界框来识别和定位对象,而实例分割不仅识别边界框,还描绘出每个对象的精确形状。YOLO26实例分割模型提供掩码或轮廓,勾勒出每个detect到的对象,这对于需要了解对象精确形状的任务(例如医学成像或自动驾驶)特别有用。

为什么使用YOLO26进行实例分割?

Ultralytics YOLO26 是一种最先进的模型,以其高精度和实时性能而闻名,使其成为实例分割任务的理想选择。YOLO26 Segment 模型在 COCO 数据集上进行了预训练,确保在各种对象上都具有强大的性能。此外,YOLO 支持训练、验证、预测和导出功能,并实现无缝集成,使其在研究和工业应用中都具有高度的通用性。

如何加载和验证预训练的 YOLO 分割模型?

加载和验证预训练的 YOLO 分割模型非常简单。以下是使用 Python 和 CLI 执行此操作的方法:

示例

from ultralytics import YOLO

# Load a pretrained model

model = YOLO("yolo26n-seg.pt")

# Validate the model

metrics = model.val()

print("Mean Average Precision for boxes:", metrics.box.map)

print("Mean Average Precision for masks:", metrics.seg.map)

yolo segment val model=yolo26n-seg.pt

这些步骤将为您提供验证指标,例如平均精度均值 (mAP),这对于评估模型性能至关重要。

如何将 YOLO 分割模型导出为 ONNX 格式?

将 YOLO 分割模型导出为 ONNX 格式非常简单,可以使用 Python 或 CLI 命令完成:

示例

from ultralytics import YOLO

# Load a pretrained model

model = YOLO("yolo26n-seg.pt")

# Export the model to ONNX format

model.export(format="onnx")

yolo export model=yolo26n-seg.pt format=onnx

有关导出为各种格式的更多详细信息,请参阅导出页面。