Ultralytics Plattform

Ultralytics Platform ist eine umfassende End-to-End-Plattform für Computer Vision, die den gesamten ML-Workflow von der Datenvorbereitung bis zur Modellbereitstellung optimiert. Entwickelt für Teams und Einzelpersonen, die produktionsreife Computer-Vision-Lösungen ohne die Komplexität der Infrastruktur benötigen.

Was ist die Ultralytics Platform?

Die Ultralytics Platform wurde entwickelt, um fragmentierte ML-Tools durch eine einheitliche Lösung zu ersetzen. Sie vereint die Funktionen von:

- Roboflow – Datenmanagement und -annotation

- Weights & Biases – Experiment-Tracking

- SageMaker – Cloud-Training

- HuggingFace – Modell-Deployment

- Arize – Monitoring

Eine All-in-One-Plattform mit nativer Unterstützung für YOLO26- und YOLO11 .

Workflow: Hochladen → Kommentieren → Trainieren → Exportieren → Bereitstellen

Die Plattform bietet einen durchgängigen Workflow:

graph LR

subgraph Data["📁 Data"]

A[Upload] --> B[Annotate]

B --> C[Analyze]

end

subgraph Train["🚀 Train"]

D[Configure] --> E[Train on GPU]

E --> F[View Metrics]

end

subgraph Deploy["🌐 Deploy"]

G[Export] --> H[Deploy Endpoint]

H --> I[Monitor]

end

Data --> Train --> Deploy| Phase | Funktionen |

|---|---|

| Hochladen | Bilder (50 MB), Videos (1 GB), ZIP-Archive (50 GB) mit automatischer Verarbeitung |

| Annotieren | Manuelle Tools, SAM -Annotation, YOLO für alle 5 Aufgabentypen |

| Trainieren | Cloud-GPUs (RTX 4090 bis H200), Echtzeit-Metriken, Projektorganisation |

| Export | 17 Bereitstellungsformate (ONNX, TensorRT, CoreML, TFLite usw.) |

| Bereitstellung | 43 globale Regionen mit dedizierten Endpunkten, automatischer Skalierung und Überwachung |

Was Sie tun können:

- Laden Sie Bilder, Videos und ZIP-Archive hoch, um Trainingsdatensätze zu erstellen.

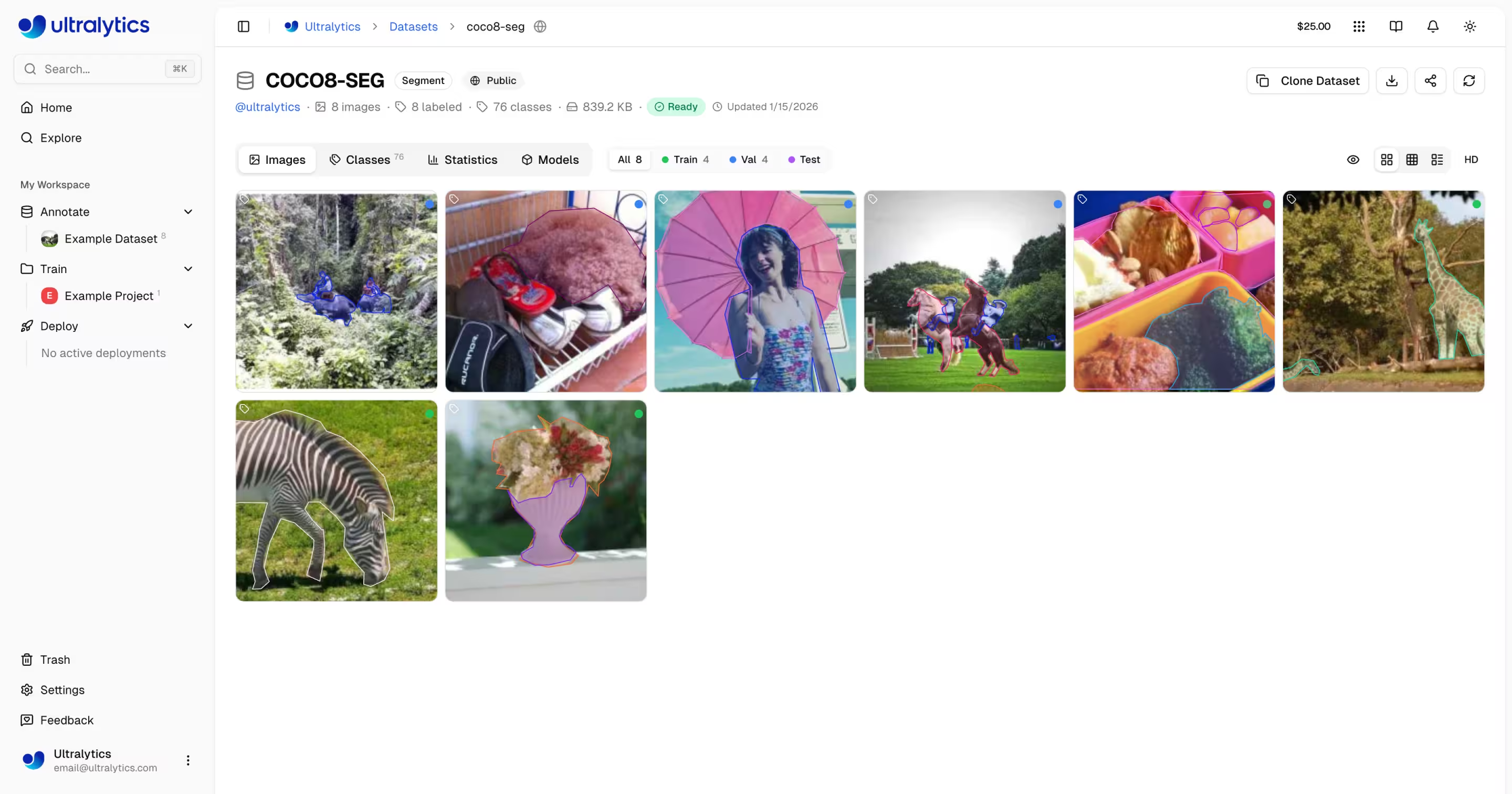

- Visualisieren Sie Anmerkungen mit interaktiven Overlays für alle 5 YOLO .

- Trainieren Sie Modelle auf Cloud-GPUs (RTX 4090 bis H200) mit Echtzeit-Metriken.

- Exportieren in 17 Bereitstellungsformate (ONNX, TensorRT, CoreML, TFLite usw.)

- Bereitstellung in 43 Regionen weltweit mit dedizierten Endpunkten per Mausklick

- Überwachen Sie den Schulungsfortschritt, den Einsatzzustand und die Nutzungsmetriken.

- Arbeiten Sie zusammen, indem Sie Projekte und Datensätze für die Community öffentlich zugänglich machen.

Multi-Region-Infrastruktur

Ihre Daten bleiben in Ihrer Region. Die Ultralytics Platform betreibt Infrastruktur in drei globalen Regionen:

| Region | Standort | Am besten geeignet für |

|---|---|---|

| USA | Iowa, USA | Nutzer in Amerika, am schnellsten für Amerika |

| EU | Belgien, Europa | Europäische Nutzer, DSGVO-Konformität |

| AP | Taiwan, Asien-Pazifik | Benutzer im asiatisch-pazifischen Raum, niedrigste Latenz in der APAC-Region |

Sie wählen Ihre Region während des Onboardings, und all Ihre Daten, Modelle und Deployments verbleiben in dieser Region.

Hauptmerkmale

Datenvorbereitung

- Dataset-Management: Hochladen von Bildern, Videos oder ZIP-Archiven mit automatischer Verarbeitung

- Annotationseditor: Manuelle Annotation für alle 5 YOLO-Aufgabentypen (detect, segment, pose, OBB, classify)

- Intelligente SAM-Annotation: Klickbasierte intelligente Annotation unter Verwendung des Segment Anything Model

- Auto-Annotation: Verwenden Sie trainierte Modelle, um neue Daten vorab zu labeln

- Statistiken: Klassenverteilung, Standort-Heatmaps und Dimensionsanalyse

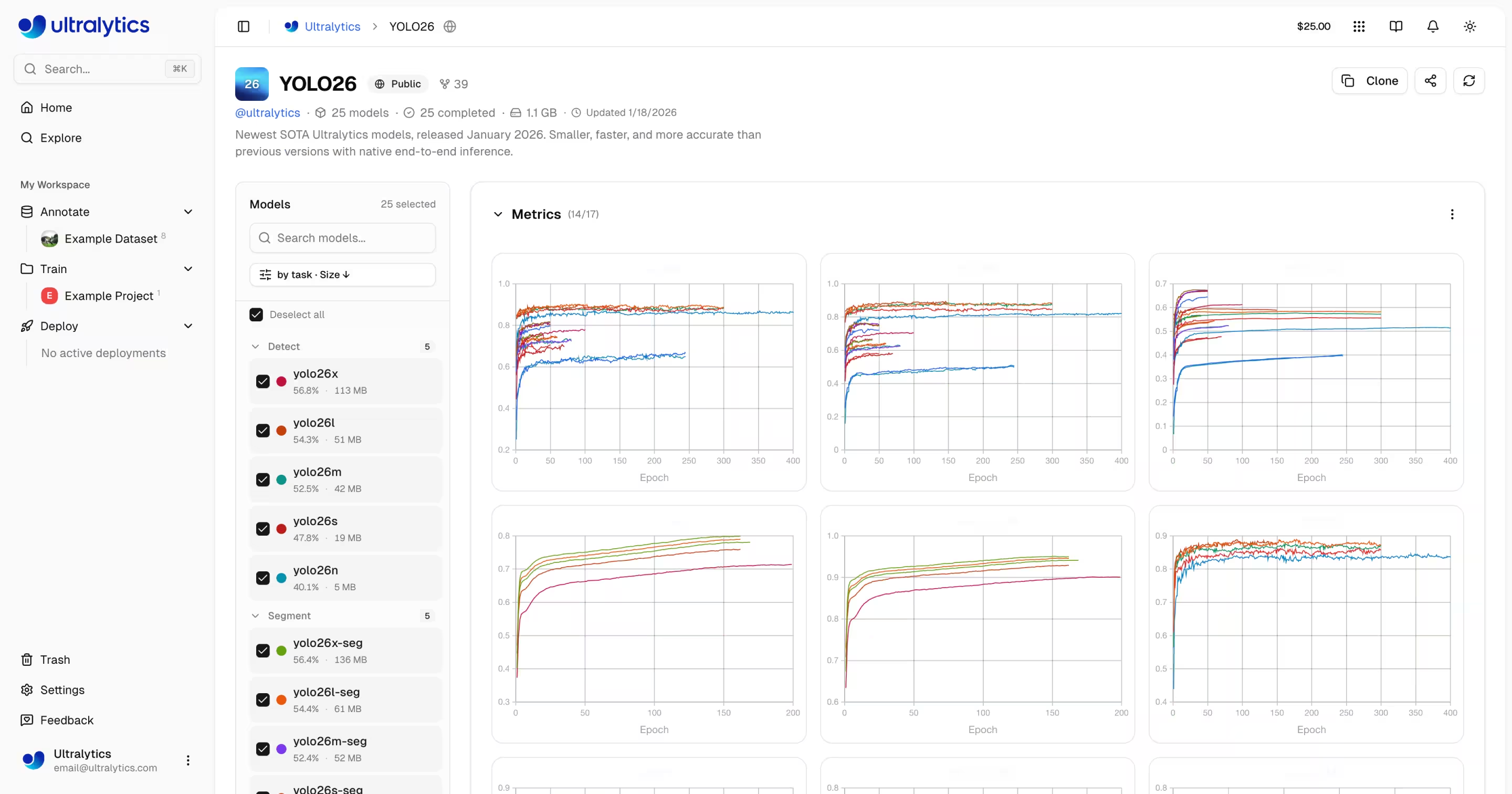

Modelltraining

- Cloud-Training: Trainieren Sie auf Cloud-GPUs (RTX 4090, A100, H100) mit Echtzeit-Metriken

- Remote-Training: Trainieren Sie überall und streamen Sie Metriken zur Plattform (im W&B-Stil)

- Projektorganisation: Gruppieren Sie verwandte Modelle, vergleichen Sie Experimente, tracken Sie Aktivitäten

- 17 Exportformate: ONNX, TensorRT, CoreML, TFLite und mehr

Bereitstellung

- Inferenz-Tests: Testen Sie Modelle direkt im Browser mit benutzerdefinierten Bildern

- Dedizierte Endpunkte: Bereitstellung in 43 globalen Regionen mit Auto-Scaling

- Monitoring: Echtzeit-Metriken, Anfrageprotokolle und Performance-Dashboards

Kontoverwaltung

- API-Schlüssel: Sichere Schlüsselverwaltung für Remote-Training und API-Zugriff

- Guthaben & Abrechnung: Pay-as-you-go-Training mit transparenter Preisgestaltung

- Aktivitätsfeed: Verfolgen Sie alle Kontoereignisse und Aktionen

- Trash & Restore: 30-tägige vorläufige Löschung mit Wiederherstellung von Elementen

- DSGVO-Konformität: Datenexport und Kontolöschung

Schnellzugriffe

Beginnen Sie mit diesen Ressourcen:

- Schnellstart: Erstellen Sie Ihr erstes Projekt und trainieren Sie ein Modell in wenigen Minuten

- Datensätze: Laden Sie Ihre Trainingsdaten hoch und verwalten Sie sie

- Annotation: Labeln Sie Ihre Daten mit manuellen und KI-gestützten Tools

- Projekte: Organisieren Sie Ihre Modelle und Experimente

- Cloud-Training: Trainieren Sie auf Cloud-GPUs

- Inferenz: Testen Sie Ihre Modelle

- Endpunkte: Stellen Sie Modelle in der Produktion bereit

- Monitoring: Tracken Sie die Bereitstellungs-Performance

- API-Schlüssel: Verwalten Sie den API-Zugriff

- Abrechnung: Guthaben und Zahlung

- Aktivität: Kontoereignisse verfolgen

- Papierkorb: Gelöschte Elemente wiederherstellen

- REST API: API-Referenz

FAQ

Wie fange ich mit der Ultralytics Platform an?

Um mit Ultralytics Platform zu beginnen:

- Registrieren: Erstellen Sie ein Konto unter platform.ultralytics.com

- Region auswählen: Wählen Sie Ihre Datenregion (USA, EU oder AP) während des Onboardings

- Datensatz hochladen: Navigieren Sie zum Bereich Datensätze, um Ihre Daten hochzuladen

- Modell trainieren: Erstellen Sie ein Projekt und beginnen Sie mit dem Training auf Cloud-GPUs

- Bereitstellen: Testen Sie Ihr Modell und stellen Sie es auf einem dedizierten Endpunkt bereit

Eine detaillierte Anleitung finden Sie auf der Quickstart-Seite.

Welche Vorteile bietet die Ultralytics Platform?

Ultralytics Platform bietet:

- Vereinheitlichter Workflow: Daten, Training und Bereitstellung an einem Ort

- Multi-Region: Datenresidenz in den Regionen USA, EU oder AP

- No-Code-Training: Trainieren Sie fortschrittliche YOLO-Modelle ohne Code zu schreiben

- Echtzeit-Metriken: Streamen Sie den Trainingsfortschritt und überwachen Sie Bereitstellungen

- 43 Bereitstellungsregionen: Stellen Sie Modelle weltweit nah an Ihren Nutzern bereit

- 5 Aufgabentypen: Unterstützung für detect, segment, Pose, obb und Klassifizierung

- KI-gestützte Annotation: SAM und automatische Beschriftung zur Beschleunigung der Datenvorbereitung

Welche GPU-Optionen stehen für das Cloud-Training zur Verfügung?

Ultralytics Platform unterstützt verschiedene GPU-Typen für das Cloud-Training:

| Stufe | GPU | VRAM | Kosten/Stunde | Am besten geeignet für |

|---|---|---|---|---|

| Budget | RTX A2000 | 6 GB | $0.12 | Kleine Datensätze, Testen |

| Budget | RTX 3080 | 10 GB | $0.25 | Mittlere Datensätze |

| Budget | RTX 3080 Ti | 12 GB | $0.30 | Mittlere Datensätze |

| Budget | A30 | 24 GB | $0.44 | Größere Losgrößen |

| Mitte | RTX 4090 | 24 GB | $0.60 | Hervorragendes Preis-Leistungs-Verhältnis |

| Mitte | A6000 | 48 GB | $0.90 | Große Modelle |

| Mitte | L4 | 24 GB | $0.54 | Optimierte Schlussfolgerung |

| Mitte | L40S | 48 GB | $1.72 | Großes Batch-Training |

| Pro | A100 40GB | 40 GB | $2.78 | Produktionsschulung |

| Pro | A100 80GB | 80 GB | $3.44 | Sehr große Modelle |

| Pro | H100 | 80 GB | $5.38 | Schnellstes Training |

| Enterprise | H200 | 141 GB | $5.38 | Maximale Leistung |

| Enterprise | B200 | 192 GB | $10.38 | Größte Modelle |

| Ultralytics | RTX PRO 6000 | 48 GB | $3.68 | Ultralytics |

Die vollständigen Preise und GPU finden Sie unter Cloud-Schulungen.

Wie funktioniert Remote-Training?

Sie können Modelle überall trainieren und Metriken an die Plattform streamen.

Anforderung an die Paketversion

Die Plattform-Integration erfordert ultralytics>=8.4.0. Ältere Versionen funktionieren NICHT mit der Plattform.

pip install "ultralytics>=8.4.0"

# Set your API key

export ULTRALYTICS_API_KEY="your_api_key"

# Train with project/name to stream metrics

yolo train model=yolo26n.pt data=coco.yaml epochs=100 project=username/my-project name=exp1

Weitere Details zum Remote-Training finden Sie unter Cloud Training.

Welche Annotationstools stehen zur Verfügung?

Die Plattform umfasst einen voll ausgestatteten Annotationseditor, der Folgendes unterstützt:

- Manuelle Werkzeuge: Bounding Boxes, Polygone, Keypoints, orientierte Boxen, Klassifizierung

- SAM Smart Annotation: Klicken Sie, um präzise Masken mit dem Segment Anything Model zu generieren.

- YOLO Auto-Annotation: Verwenden Sie trainierte Modelle zur Vorab-Beschriftung von Bildern.

- Tastenkombinationen: Effiziente Workflows mit Hotkeys

Die vollständige Anleitung finden Sie unter Annotation.

Fehlerbehebung

Probleme mit Datensätzen

| Problem | Lösung |

|---|---|

| Datensatz wird nicht verarbeitet | Überprüfen Sie, ob das Dateiformat unterstützt wird (JPEG, PNG, WebP usw.). Maximale Dateigröße: Bilder 50 MB, Videos 1 GB, ZIP-Dateien 50 GB |

| Fehlende Anmerkungen | Überprüfen Sie, ob die Etiketten im YOLO vorliegen, mit .txt Dateien, die mit Bilddateinamen übereinstimmen |

| "Zugteilung erforderlich" | Hinzufügen train/ Ordner zu Ihrer Datensatzstruktur hinzufügen oder Aufteilungen in den Datensatzeinstellungen erstellen |

| Klassennamen nicht definiert | Fügen Sie ein data.yaml Datei mit names: Liste oder Klassen in den Datensatz-Einstellungen definieren |

Ausbildungsfragen

| Problem | Lösung |

|---|---|

| Das Training beginnt nicht. | Überprüfen Sie Ihr Guthaben unter „Einstellungen“ > „Abrechnung“. Mindestens 5,00 $ erforderlich. |

| Speicherfehler | Reduzieren Sie die Stapelgröße, verwenden Sie ein kleineres Modell (n/s) oder wählen Sie GPU mehr VRAM. |

| Schlechte Kennzahlen | Überprüfen Sie die Qualität des Datensatzes, erhöhen Sie die Epochen, versuchen Sie eine Datenvergrößerung, überprüfen Sie die Klassenbalance. |

| Training langsam | Wählen Sie GPU schnellere GPU, reduzieren Sie die Bildgröße und überprüfen Sie, ob der Datensatz nicht zu einem Engpass führt. |

Bereitstellungsprobleme

| Problem | Lösung |

|---|---|

| Endpunkt reagiert nicht | Überprüfen Sie den Endpunktstatus (läuft vs. gestoppt). Der Kaltstart kann 2–5 Sekunden dauern. |

| 401 Nicht autorisiert | Überprüfen Sie, ob der API-Schlüssel korrekt ist und über die erforderlichen Berechtigungen verfügt. |

| Langsame Schlussfolgerung | Überprüfen Sie die Modellgröße, erwägen Sie TensorRT und wählen Sie eine näher gelegene Region aus. |

| Export fehlgeschlagen | Einige Formate erfordern bestimmte Modellarchitekturen. Probieren Sie ONNX umfassendste Kompatibilität aus. |

Häufig gestellte Fragen

Kann ich meinen Benutzernamen nach der Anmeldung ändern?

Nein, Benutzernamen sind dauerhaft und können nicht geändert werden. Wählen Sie bei der Anmeldung sorgfältig aus.

Kann ich meine Datenregion ändern?

Nein, die Datenregion wird bei der Anmeldung ausgewählt und kann nicht geändert werden. Um die Region zu wechseln, erstellen Sie ein neues Konto und laden Sie Ihre Daten erneut hoch.

Wie bekomme ich mehr Credits?

Gehen Sie zu Einstellungen > Abrechnung > Guthaben hinzufügen. Kaufen Sie Guthaben im Wert von 5 bis 1000 US-Dollar. Gekauftes Guthaben verfällt nie.

Was passiert, wenn das Training fehlschlägt?

Es wird nur die tatsächlich genutzte Rechenzeit berechnet. Checkpoints werden gespeichert, sodass Sie das Training fortsetzen können.

Kann ich mein trainiertes Modell herunterladen?

Ja, klicken Sie auf das Download-Symbol auf einer beliebigen Modellseite, um die Datei herunterzuladen. .pt Datei oder exportierte Formate.

Wie kann ich meine Arbeit öffentlich teilen?

Bearbeiten Sie Ihre Projekt- oder Datensatzeinstellungen und schalten Sie die Sichtbarkeit auf „Öffentlich“ um. Öffentliche Inhalte werden auf der Seite „Entdecken“ angezeigt.

Was sind die Dateigrößenbeschränkungen?

Bilder: 50 MB, Videos: 1 GB, ZIP-Archive: 50 GB. Größere Dateien bitte in mehrere Uploads aufteilen.

Wie lange werden gelöschte Elemente im Papierkorb aufbewahrt?

30 Tage. Danach werden die Elemente endgültig gelöscht und können nicht wiederhergestellt werden.

Kann ich Plattformmodelle kommerziell nutzen?

Die Free- und Pro-Tarife verwenden die AGPL-Lizenz. Für die kommerzielle Nutzung ohne AGPL-Anforderungen wenden Sie sich bitte anultralytics, um eine Enterprise-Lizenz zu erhalten.