Evoluzione degli iperparametri per YOLOv5

📚 Questa guida spiega l'evoluzione degli iperparametri per YOLOv5 🚀. L'evoluzione degli iperparametri è un metodo di Ottimizzazione degli iperparametri che utilizza un Algoritmo Genetico (GA) per l'ottimizzazione.

Gli iperparametri nel machine learning controllano vari aspetti dell'addestramento e trovare valori ottimali per essi può essere una sfida. I metodi tradizionali come le ricerche a griglia possono rapidamente diventare intrattabili a causa di:

- Lo spazio di ricerca ad alta dimensionalità

- Correlazioni sconosciute tra le dimensioni

- Natura costosa della valutazione della fitness in ogni punto

Questo rende gli algoritmi genetici un candidato adatto per la ricerca di iperparametri.

Prima di iniziare

Clona il repository e installa i requirements.txt in un ambiente Python>=3.8.0, incluso PyTorch>=1.8. I modelli e i dataset vengono scaricati automaticamente dall'ultima release di YOLOv5.

git clone https://github.com/ultralytics/yolov5 # clone

cd yolov5

pip install -r requirements.txt # install

1. Inizializza gli iperparametri

YOLOv5 ha circa 30 iperparametri utilizzati per varie impostazioni di training. Questi sono definiti in *.yaml file nel /data/hyps directory. Stime iniziali migliori produrranno risultati finali migliori, quindi è importante inizializzare correttamente questi valori prima di farli evolvere. In caso di dubbio, è sufficiente utilizzare i valori predefiniti, ottimizzati per il training YOLOv5 COCO da zero.

# YOLOv5 🚀 by Ultralytics, AGPL-3.0 license

# Hyperparameters for low-augmentation COCO training from scratch

# python train.py --batch 64 --cfg yolov5n6.yaml --weights '' --data coco.yaml --img 640 --epochs 300 --linear

# See tutorials for hyperparameter evolution https://github.com/ultralytics/yolov5#tutorials

lr0: 0.01 # initial learning rate (SGD=1E-2, Adam=1E-3)

lrf: 0.01 # final OneCycleLR learning rate (lr0 * lrf)

momentum: 0.937 # SGD momentum/Adam beta1

weight_decay: 0.0005 # optimizer weight decay 5e-4

warmup_epochs: 3.0 # warmup epochs (fractions ok)

warmup_momentum: 0.8 # warmup initial momentum

warmup_bias_lr: 0.1 # warmup initial bias lr

box: 0.05 # box loss gain

cls: 0.5 # cls loss gain

cls_pw: 1.0 # cls BCELoss positive_weight

obj: 1.0 # obj loss gain (scale with pixels)

obj_pw: 1.0 # obj BCELoss positive_weight

iou_t: 0.20 # IoU training threshold

anchor_t: 4.0 # anchor-multiple threshold

# anchors: 3 # anchors per output layer (0 to ignore)

fl_gamma: 0.0 # focal loss gamma (efficientDet default gamma=1.5)

hsv_h: 0.015 # image HSV-Hue augmentation (fraction)

hsv_s: 0.7 # image HSV-Saturation augmentation (fraction)

hsv_v: 0.4 # image HSV-Value augmentation (fraction)

degrees: 0.0 # image rotation (+/- deg)

translate: 0.1 # image translation (+/- fraction)

scale: 0.5 # image scale (+/- gain)

shear: 0.0 # image shear (+/- deg)

perspective: 0.0 # image perspective (+/- fraction), range 0-0.001

flipud: 0.0 # image flip up-down (probability)

fliplr: 0.5 # image flip left-right (probability)

mosaic: 1.0 # image mosaic (probability)

mixup: 0.0 # image mixup (probability)

copy_paste: 0.0 # segment copy-paste (probability)

2. Definisci l'idoneità

Il fitness è il valore che cerchiamo di massimizzare. In YOLOv5 definiamo una funzione di fitness predefinita come combinazione ponderata di metriche: mAP@0.5 contribuisce per il 10% al peso e mAP@0.5:0.95 contribuisce per il restante 90%, con precisione (P) e recall (R) assente. Puoi modificarli a tuo piacimento o utilizzare la definizione di fitness predefinita in utils/metrics.py (consigliato).

def fitness(x):

"""Return model fitness as the sum of weighted metrics [P, R, mAP@0.5, mAP@0.5:0.95]."""

w = [0.0, 0.0, 0.1, 0.9] # weights for [P, R, mAP@0.5, mAP@0.5:0.95]

return (x[:, :4] * w).sum(1)

3. Evoluzione

L'evoluzione viene eseguita su uno scenario di base che cerchiamo di migliorare. Lo scenario di base in questo esempio è il fine-tuning di COCO128 per 10 epoche utilizzando YOLOv5s pre-addestrato. Il comando di addestramento dello scenario di base è:

python train.py --epochs 10 --data coco128.yaml --weights yolov5s.pt --cache

Per sviluppare gli iperparametri specifico per questo scenario, a partire dai nostri valori iniziali definiti in Sezione 1., e massimizzando la fitness definita in Sezione 2., aggiungi --evolve:

# Single-GPU

python train.py --epochs 10 --data coco128.yaml --weights yolov5s.pt --cache --evolve

# Multi-GPU with delay

for i in {0..7}; do

sleep $((30 * i)) # 30-second delay (optional)

echo "Starting GPU $i..."

nohup python train.py --epochs 10 --data coco128.yaml --weights yolov5s.pt --cache --device $i --evolve > "evolve_gpu_$i.log" &

done

# Continuous training (use with caution)

# for i in {0..7}; do

# sleep $((30 * i)) # 30-second delay (optional)

# echo "Starting continuous training on GPU $i..."

# (

# while true; do

# python train.py --epochs 10 --data coco128.yaml --weights yolov5s.pt --cache --device $i --evolve > "evolve_gpu_$i.log"

# done

# ) &

# done

Le impostazioni di evoluzione predefinite eseguiranno lo scenario di base 300 volte, ovvero per 300 generazioni. Puoi modificare le generazioni tramite --evolve argomento, ad esempio python train.py --evolve 1000.

Gli operatori genetici principali sono crossover e mutazione. In questo lavoro viene utilizzata la mutazione, con una probabilità dell'80% e una varianza di 0,04 per creare nuova prole basata su una combinazione dei migliori genitori di tutte le generazioni precedenti. I risultati vengono registrati in runs/evolve/exp/evolve.csv, e la prole con la fitness più alta viene salvata ad ogni generazione come runs/evolve/hyp_evolved.yaml:

# YOLOv5 Hyperparameter Evolution Results

# Best generation: 287

# Last generation: 300

# metrics/precision, metrics/recall, metrics/mAP_0.5, metrics/mAP_0.5:0.95, val/box_loss, val/obj_loss, val/cls_loss

# 0.54634, 0.55625, 0.58201, 0.33665, 0.056451, 0.042892, 0.013441

lr0: 0.01 # initial learning rate (SGD=1E-2, Adam=1E-3)

lrf: 0.2 # final OneCycleLR learning rate (lr0 * lrf)

momentum: 0.937 # SGD momentum/Adam beta1

weight_decay: 0.0005 # optimizer weight decay 5e-4

warmup_epochs: 3.0 # warmup epochs (fractions ok)

warmup_momentum: 0.8 # warmup initial momentum

warmup_bias_lr: 0.1 # warmup initial bias lr

box: 0.05 # box loss gain

cls: 0.5 # cls loss gain

cls_pw: 1.0 # cls BCELoss positive_weight

obj: 1.0 # obj loss gain (scale with pixels)

obj_pw: 1.0 # obj BCELoss positive_weight

iou_t: 0.20 # IoU training threshold

anchor_t: 4.0 # anchor-multiple threshold

# anchors: 3 # anchors per output layer (0 to ignore)

fl_gamma: 0.0 # focal loss gamma (efficientDet default gamma=1.5)

hsv_h: 0.015 # image HSV-Hue augmentation (fraction)

hsv_s: 0.7 # image HSV-Saturation augmentation (fraction)

hsv_v: 0.4 # image HSV-Value augmentation (fraction)

degrees: 0.0 # image rotation (+/- deg)

translate: 0.1 # image translation (+/- fraction)

scale: 0.5 # image scale (+/- gain)

shear: 0.0 # image shear (+/- deg)

perspective: 0.0 # image perspective (+/- fraction), range 0-0.001

flipud: 0.0 # image flip up-down (probability)

fliplr: 0.5 # image flip left-right (probability)

mosaic: 1.0 # image mosaic (probability)

mixup: 0.0 # image mixup (probability)

copy_paste: 0.0 # segment copy-paste (probability)

Raccomandiamo un minimo di 300 generazioni di evoluzione per ottenere risultati ottimali. Si noti che l'evoluzione è generalmente costosa e richiede molto tempo, poiché lo scenario di base viene addestrato centinaia di volte, il che potrebbe richiedere centinaia o migliaia di ore di GPU.

Al termine dell'evoluzione, riutilizzare le impostazioni scoperte puntando l'addestramento al file salvato, ad esempio python train.py --hyp runs/evolve/hyp_evolved.yaml --data your.yaml --weights yolov5s.pt.

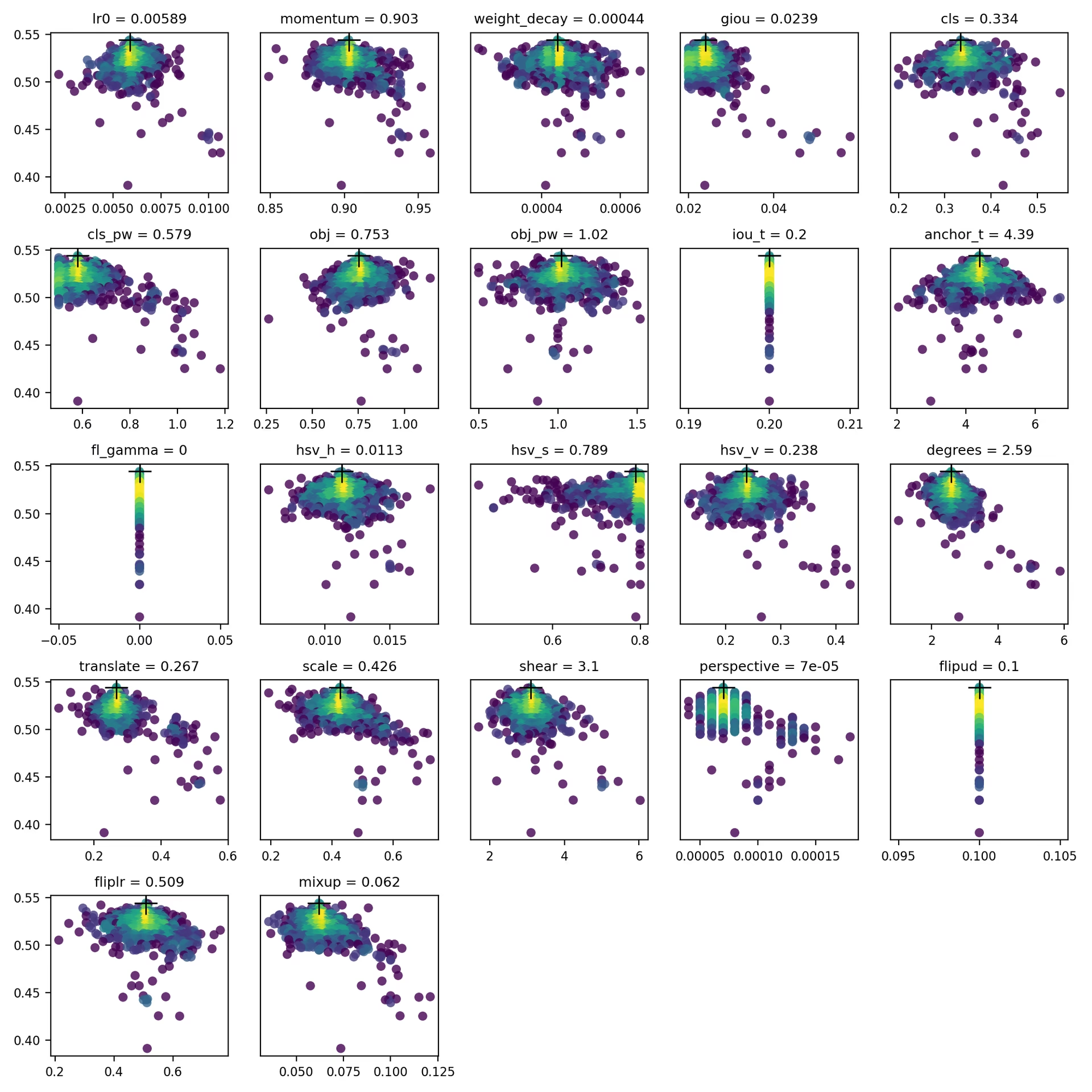

4. Visualizza

evolve.csv è tracciato come evolve.png by utils.plots.plot_evolve() al termine dell'evoluzione, viene visualizzato un sottografico per ogni iperparametro che mostra l'accuratezza (asse y) rispetto ai valori dell'iperparametro (asse x). Il giallo indica concentrazioni più elevate. Le distribuzioni verticali indicano che un parametro è stato disabilitato e non subisce mutazioni. Questo è selezionabile dall'utente nel meta dizionario in train.py ed è utile per correggere i parametri e impedirne l'evoluzione.

Ambienti supportati

Ultralytics fornisce una gamma di ambienti pronti all'uso, ciascuno preinstallato con dipendenze essenziali come CUDA, CUDNN, Python e PyTorch, per avviare i tuoi progetti.

- Notebook GPU gratuiti:

- Google Cloud: Guida rapida GCP

- Amazon: Guida rapida AWS

- Azure: Guida rapida ad AzureML

- Docker: Guida rapida a Docker

Stato del progetto

Questo badge indica che tutti i test di Integrazione Continua (CI) di YOLOv5 GitHub Actions vengono superati con successo. Questi test CI verificano rigorosamente la funzionalità e le prestazioni di YOLOv5 attraverso vari aspetti chiave: training, validation, inference, export e benchmarks. Garantiscono un funzionamento coerente e affidabile su macOS, Windows e Ubuntu, con test eseguiti ogni 24 ore e ad ogni nuovo commit.